LVS-DR直接路由模式

DR模式:直接路由(direct routing)模式,采用半开放式的网络结构,与TUN模式的结构类似,但各节点并不是分散在各地,而是与调度器位于同一个物理网络。负载调度器与各节点服务器通过本地网络连接,不需要建立专用的IP隧道。

在DR模式的群集中,LVS负载调度器作为群集的访问入口,但不作为网关使用;服务器池中的所有节点都各自接入internet,发送给客户端的WEB响应数据包不需要经过LVS负载调度器。

这种方式入站,出站访问数据被分别处理,因此LVS负载调度器和所有的节点服务器都需要配置有VIP地址,以便响应对整个群集的访问。考虚到数据存储的安全性,共享存储设备会放在内部的专用网络中。

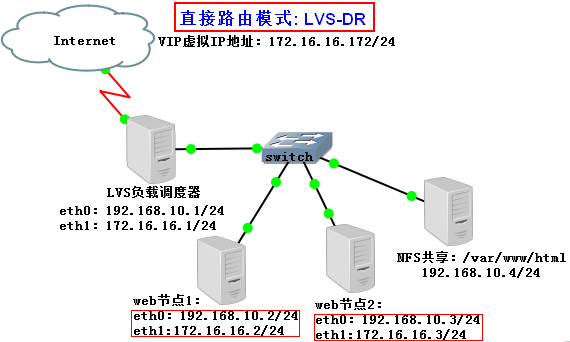

实验拓扑如下:

VIP(虚拟IP地址):172.16.16.172/24

LVS调度器:eth0: 192.168.10.1/24 eth1:172.16.16.1/24

WEB节点1:eth0: 192.168.10.2/24 eth1:192.16.16.2/24

WEB节点2:eth0: 192.168.10.3/24 eth1:192.16.16.3/24

NFS共享存储:eth0: 192.168.10.4/24

在负载调度器主机上配置负载调度器,具体操作如下:

1)配置虚拟IP地址(VIP)

采用虚拟接口的方式(eth1:0),为网卡eth1绑定VIP地址,以便响应群集访问。配置结果为:eth1:172.16.16.1/24、eth1:0 :172.16.16.172/24:

重启network脚本使修改后的IP生效:

修改sysctl.conf文件,开启路由转发功能并使修改生效:

2)调整/proc响应参数:

对于DR群集模式来说,由于LVS负载调度器和各节点需要共用VIP地址,为了避免网络内的ARP解析出现异常,应该关闭linux内核的ICMP重定向参数响应。

注解:ICMP重定向报文是ICMP控制报文中的一种。在特定的情况下,当路由器检测到一台机器使用非优化路由的时候,它会向该主机发送一个ICMP重定向报文,请求主机改变路由。此类报文有可能用以***,所以系统应该拒绝接受ICMP重定向。

[root@LVS ~]# vim /etc/sysctl.conf

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.eth0.send_redirects = 0

net.ipv4.conf.eth1.send_redirects = 0

注解:

上图中参数的含义是发送重定向,0表示关闭此项功能。

此处修改是为了安全考虑关闭重定向功能。

如果具有 eth1、eth2 等多个接口,必须对所有接口执行该操作。

执行sysctl -p使修改生效:

3)配置负载分配策略:

加载ip_vs模块并安装ipvsadm软件包,使用ipvsadm创建负载分配策略:

[root@LVS ~]# ipvsadm -A -t 172.16.16.172:80 -s rr

[root@LVS ~]# ipvsadm -a -t 172.16.16.172:80 -r 172.16.16.2 -g -w 1

[root@LVS ~]# ipvsadm -a -t 172.16.16.172:80 -r 172.16.16.3 -g -w 1

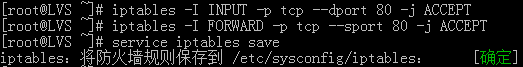

LVS负载调度器若开启iptables防火墙,要在防火墙上的INPUT、FORWARD链上创建允许http数据流的规则。

iptables-I INPUT –p tcp - -dport 80 –j ACCEPT

iptables-I FORWARD-p tcp- -sport 80 –j ACCEPT

在共享存储设备主机上配置共享存储服务(这里使用NFS发布共享服务),具体操作如下:

NFS服务的实现依赖于RPC(remoteprocesscall,远程过程调用)机制,以完成远程到本地的映射过程。在RHEL6系统中,需要安装 nfs-utils、rpcbind软件包来提供NFS共享服务,前者用于NFS共享发布和访问,后者用于RPC支持。

将NFS服务器上的/opt/wwwroot目录共享给群集中服务器节点:

其中客户机地址可以是主机名、IP地址、网段地址,允许使用*或?通配符;权限选项中的rw表示允许读写(ro为只读),sync表示同步写入,no_root_squash表示当客户机以root身份访问时赋予本地root权限(默认是root_squash,将作为nfsnobody用户降权对侍)

启动相关服务:

rhel5系统中RPC服务脚本是portmap而rhel6系统中RPC服务脚本是rpcbind。

注意防火墙规则的设置,要不就将iptables服务停止。

在节点服务器主机上配置节点服务器,具体操作如下:

使用DR模式时,节点服务器也需要配置VIP地址,并调整内核的ARP响应参数以阻止更新VIP的MAC地址,避免发生冲突。除此之外,WEB服务的配置与NAT方式类似。

1.调整/proc响应参数:

[root@web1 ~]# vim /etc/sysctl.conf

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.lo.arp_ignore = 1

arp_ignore:定义了网卡在响应外部ARP请求时候的响应级别

0:默认值,不管哪块网卡接收到了ARP请求,只要发现本机有这个MAC都给与响应

1:总是使用最合适的网卡来响应,一个主机有多块网卡,其中一块网卡接收到了ARP请求,发现所请求的MAC是本机另一块网卡的,这个时候接收到ARP请求的这块网卡就一定不响应,只有发现请求的MAC是自己的才给与响应。

net.ipv4.conf.default.arp_announce =2

net.ipv4.conf.all.arp_announce =2

net.ipv4.conf.lo.arp_announce = 2

定义了网卡在向外宣告自己的MAC-IP时候的限制级别

有三个值:

0:默认值,不管哪块网卡接收到了ARP请求,只要发现本机有这个MAC都给与响应

1:尽量避免响应ARP请求中MAC不是本网卡的,一个主机有多块网卡,其中一块网卡接收到了ARP请求,发现所请求的MAC是本机另一块网卡的,这个时候接收到ARP请求的这块网卡就尽量避免响应

2:总是使用最合适的网卡来响应,一个主机有多块网卡,其中一块网卡接收到了ARP请求,发现所请求的MAC是本机另一块网卡的,这个时候接收到ARP请求的这块网卡就一定不响应,只有发现请求的MAC是自己的才给与响应。

执行sysctl-p使修改生效:

2.配置虚拟IP地址(VIP)——节点服务器1的配置:

在每个节点服务器,同样需要具有VIP地址172.16.16.172,但此地址仅用作发送WEB响应数据包的源地址,并不需要监听客户机的访问请求(改由调度器监听并分发)。因此使用虚拟接口lo:0来承载VIP地址,并为本机添加一条路由记录,将访问VIP的数据限制在本地以避免通信紊乱:

注意:子网掩码必须为全1

重启network脚本使修改后的IP生效:

3.添加VIP本地访问路由:

[root@web1 ~]# route add -host 172.16.16.172 dev lo:0

[root@web1 ~]# echo "/sbin/route add -host 172.16.16.172 dev lo:0" >> /etc/rc.local

4.安装httpd,创建测试页,启用httpd服务程序(安装httpd软件包,创建测试网页):

修改/etc/fstab文件,实现自动挂载:

其他服务器节点的配置相同。

在其他节点上只要挂载上就可以看到在节点1新建的index.html:

测试LVS群集:

安排多台测试机,从internet中直接访问http://172.16.16.172,将能够看到由真实服务器提供的网面内容:

在LVS负载调度器中,通过查看节点状态可以观察当前的负载分配情况,对于轮询算法来说,每个节点所获得的连接负载应大致相当:

至此有关LVS负载均衡群集配置完毕:

注意:如果在客户端访问有问题的话,请检测防火墙iptables规则。

欢迎关注微信公众号:小温研习社