1. 背景:

1.1 最早是由 Vladimir N. Vapnik 和 Alexey Ya. Chervonenkis 在1963年提出

1.2 目前的版本(soft margin)是由Corinna Cortes 和 Vapnik在1993年提出,并在1995年发表

1.3 深度学习(2012)出现之前,SVM被认为机器学习中近十几年来最成功,表现最好的算法

2. 机器学习的一般框架:

训练集 => 提取特征向量 => 结合一定的算法(分类器:比如决策树,KNN)=>得到结果

3. 介绍:

3.1 例子:

两类?哪条线最好?

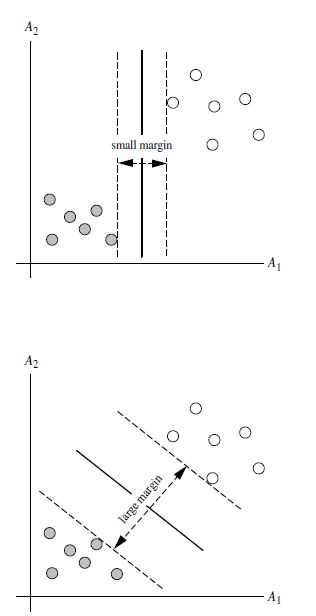

3.2 SVM寻找区分两类的超平面(hyper plane), 使边际(margin)最大

总共可以有多少个可能的超平面?无数条

如何选取使边际(margin)最大的超平面 (Max Margin Hyperplane)?

超平面到一侧最近点的距离等于到另一侧最近点的距离,两侧的两个超平面平行

3. 线性可区分(linear separable) 和 线性不可区分 (linear inseparable)

4. 定义与公式建立

超平面可以定义为:

W: weight vectot, n 是特征值的个数

X: 训练实例

b: bias

4.1 假设2维特征向量:X = (x1, X2)

把 b 想象为额外的 wight

超平面方程变为:

所有超平面右上方的点满足:

所有超平面左下方的点满足:

调整weight,使超平面定义边际的两边:

所有坐落在边际的两边的的超平面上的被称作”支持向量(support vectors)"

分界的超平面和H1或H2上任意一点的距离为 [图片上传失败...(image-3d5ae2-1513601715828)]

(i.e.: 其中||W||是向量的范数(norm))

[图片上传失败...(image-565e4d-1513601715828)]

所以,最大边际距离为: [图片上传失败...(image-4a7112-1513601715828)]

5. 求解

5.1 SVM如何找出最大边际的超平面呢(MMH)?

利用一些数学推倒,以上公式 (1)可变为有限制的凸优化问题(convex quadratic optimization)

利用 Karush-Kuhn-Tucker (KKT)条件和拉格朗日公式,可以推出MMH可以被表示为以下“决定边

界 (decision boundary)”

[图片上传失败...(image-788aa2-1513601715828)]

其中,

[图片上传中...(image-a5bb31-1513601715828-6)]

是支持向量点[图片上传中...(image-fa7106-1513601715828-5)]

(support vector)的类别标记(class label)

[图片上传中...(image-c09f97-1513601715828-4)]

是要测试的实例

[图片上传中...(image-1e7b3c-1513601715828-3)]

和 [图片上传中...(image-802948-1513601715828-2)]

都是单一数值型参数,由以上提到的最有算法得出

[图片上传中...(image-43057-1513601715828-1)]

是支持向量点的个数

5.2 对于任何测试(要归类的)实例,带入以上公式,得出的符号是正还是负决定

6. 例子:

[图片上传失败...(image-7be259-1513601715827)] 1\. 背景:

1.1 最早是由 Vladimir N. Vapnik 和 Alexey Ya. Chervonenkis 在1963年提出

1.2 目前的版本(soft margin)是由Corinna Cortes 和 Vapnik在1993年提出,并在1995年发表

1.3 深度学习(2012)出现之前,SVM被认为机器学习中近十几年来最成功,表现最好的算法

2. 机器学习的一般框架:

训练集 => 提取特征向量 => 结合一定的算法(分类器:比如决策树,KNN)=>得到结果

3. 介绍:

3.1 例子:

[图片上传失败...(image-d2cb45-1513601715828)]

两类?哪条线最好?

3.2 SVM寻找区分两类的超平面(hyper plane), 使边际(margin)最大

[图片上传失败...(image-d3b8ab-1513601715828)]

总共可以有多少个可能的超平面?无数条

如何选取使边际(margin)最大的超平面 (Max Margin Hyperplane)?

超平面到一侧最近点的距离等于到另一侧最近点的距离,两侧的两个超平面平行

3. 线性可区分(linear separable) 和 线性不可区分 (linear inseparable)

[图片上传失败...(image-a1909f-1513601715828)]

[图片上传失败...(image-1c90b0-1513601715828)]

[图片上传失败...(image-1fa4e1-1513601715828)]

4. 定义与公式建立

超平面可以定义为:[图片上传失败...(image-e1dfc5-1513601715828)]

W: weight vectot, [图片上传失败...(image-9f878d-1513601715828)]

, n 是特征值的个数

X: 训练实例

b: bias

[图片上传失败...(image-e63c2c-1513601715828)]

4.1 假设2维特征向量:X = (x1, X2)

把 b 想象为额外的 wight

超平面方程变为: [图片上传失败...(image-69abb3-1513601715828)]

所有超平面右上方的点满足:[图片上传失败...(image-23b251-1513601715828)]

所有超平面左下方的点满足: [图片上传失败...(image-28c149-1513601715828)]

调整weight,使超平面定义边际的两边:

[图片上传失败...(image-6defd6-1513601715828)]

综合以上两式,得到: (1)

[图片上传失败...(image-bb8918-1513601715828)]

所有坐落在边际的两边的的超平面上的被称作”支持向量(support vectors)"

分界的超平面和H1或H2上任意一点的距离为 [图片上传失败...(image-3d5ae2-1513601715828)]

(i.e.: 其中||W||是向量的范数(norm))

[图片上传失败...(image-565e4d-1513601715828)]

所以,最大边际距离为: [图片上传失败...(image-4a7112-1513601715828)]

5. 求解

5.1 SVM如何找出最大边际的超平面呢(MMH)?

利用一些数学推倒,以上公式 (1)可变为有限制的凸优化问题(convex quadratic optimization)

利用 Karush-Kuhn-Tucker (KKT)条件和拉格朗日公式,可以推出MMH可以被表示为以下“决定边

界 (decision boundary)”

[图片上传失败...(image-788aa2-1513601715828)]

其中,

[图片上传失败...(image-a5bb31-1513601715828)]

是支持向量点[图片上传中...(image-fa7106-1513601715828-5)]

(support vector)的类别标记(class label)

[图片上传中...(image-c09f97-1513601715828-4)]

是要测试的实例

[图片上传中...(image-1e7b3c-1513601715828-3)]

和 [图片上传中...(image-802948-1513601715828-2)]

都是单一数值型参数,由以上提到的最有算法得出

[图片上传中...(image-43057-1513601715828-1)]

是支持向量点的个数

5.2 对于任何测试(要归类的)实例,带入以上公式,得出的符号是正还是负决定

6. 例子:

[图片上传失败...(image-7be259-1513601715827)]

1.1 最早是由 Vladimir N. Vapnik 和 Alexey Ya. Chervonenkis 在1963年提出

1.2 目前的版本(soft margin)是由Corinna Cortes 和 Vapnik在1993年提出,并在1995年发表

1.3 深度学习(2012)出现之前,SVM被认为机器学习中近十几年来最成功,表现最好的算法

2. 机器学习的一般框架:

训练集 => 提取特征向量 => 结合一定的算法(分类器:比如决策树,KNN)=>得到结果

3. 介绍:

3.1 例子:

[图片上传失败...(image-d2cb45-1513601715828)]

两类?哪条线最好?

3.2 SVM寻找区分两类的超平面(hyper plane), 使边际(margin)最大

[图片上传失败...(image-d3b8ab-1513601715828)]

总共可以有多少个可能的超平面?无数条

如何选取使边际(margin)最大的超平面 (Max Margin Hyperplane)?

超平面到一侧最近点的距离等于到另一侧最近点的距离,两侧的两个超平面平行

3. 线性可区分(linear separable) 和 线性不可区分 (linear inseparable)

[图片上传失败...(image-a1909f-1513601715828)]

[图片上传失败...(image-1c90b0-1513601715828)]

[图片上传失败...(image-1fa4e1-1513601715828)]

4. 定义与公式建立

超平面可以定义为:[图片上传失败...(image-e1dfc5-1513601715828)]

W: weight vectot, [图片上传失败...(image-9f878d-1513601715828)]

, n 是特征值的个数

X: 训练实例

b: bias

[图片上传失败...(image-e63c2c-1513601715828)]

4.1 假设2维特征向量:X = (x1, X2)

把 b 想象为额外的 wight

超平面方程变为: [图片上传失败...(image-69abb3-1513601715828)]

所有超平面右上方的点满足:[图片上传失败...(image-23b251-1513601715828)]

所有超平面左下方的点满足: [图片上传失败...(image-28c149-1513601715828)]

调整weight,使超平面定义边际的两边:

[图片上传失败...(image-6defd6-1513601715828)]

综合以上两式,得到: (1)

[图片上传失败...(image-bb8918-1513601715828)]

所有坐落在边际的两边的的超平面上的被称作”支持向量(support vectors)"

分界的超平面和H1或H2上任意一点的距离为 [图片上传失败...(image-3d5ae2-1513601715828)]

(i.e.: 其中||W||是向量的范数(norm))

[图片上传失败...(image-565e4d-1513601715828)]

所以,最大边际距离为: [图片上传失败...(image-4a7112-1513601715828)]

5. 求解

5.1 SVM如何找出最大边际的超平面呢(MMH)?

利用一些数学推倒,以上公式 (1)可变为有限制的凸优化问题(convex quadratic optimization)

利用 Karush-Kuhn-Tucker (KKT)条件和拉格朗日公式,可以推出MMH可以被表示为以下“决定边

界 (decision boundary)”

[图片上传失败...(image-788aa2-1513601715828)]

其中,

[图片上传中...(image-a5bb31-1513601715828-6)]

是支持向量点[图片上传中...(image-fa7106-1513601715828-5)]

(support vector)的类别标记(class label)

[图片上传失败...(image-c09f97-1513601715828)]

是要测试的实例

[图片上传中...(image-1e7b3c-1513601715828-3)]

和 [图片上传中...(image-802948-1513601715828-2)]

都是单一数值型参数,由以上提到的最有算法得出

[图片上传中...(image-43057-1513601715828-1)]

是支持向量点的个数

5.2 对于任何测试(要归类的)实例,带入以上公式,得出的符号是正还是负决定

6. 例子:

[图片上传失败...(image-7be259-1513601715827)]

1.1 最早是由 Vladimir N. Vapnik 和 Alexey Ya. Chervonenkis 在1963年提出

1.2 目前的版本(soft margin)是由Corinna Cortes 和 Vapnik在1993年提出,并在1995年发表

1.3 深度学习(2012)出现之前,SVM被认为机器学习中近十几年来最成功,表现最好的算法

2. 机器学习的一般框架:

训练集 => 提取特征向量 => 结合一定的算法(分类器:比如决策树,KNN)=>得到结果

3. 介绍:

3.1 例子:

[图片上传失败...(image-d2cb45-1513601715828)]

两类?哪条线最好?

3.2 SVM寻找区分两类的超平面(hyper plane), 使边际(margin)最大

[图片上传失败...(image-d3b8ab-1513601715828)]

总共可以有多少个可能的超平面?无数条

如何选取使边际(margin)最大的超平面 (Max Margin Hyperplane)?

超平面到一侧最近点的距离等于到另一侧最近点的距离,两侧的两个超平面平行

3. 线性可区分(linear separable) 和 线性不可区分 (linear inseparable)

[图片上传失败...(image-a1909f-1513601715828)]

[图片上传失败...(image-1c90b0-1513601715828)]

[图片上传失败...(image-1fa4e1-1513601715828)]

4. 定义与公式建立

超平面可以定义为:[图片上传失败...(image-e1dfc5-1513601715828)]

W: weight vectot, [图片上传失败...(image-9f878d-1513601715828)]

, n 是特征值的个数

X: 训练实例

b: bias

[图片上传失败...(image-e63c2c-1513601715828)]

4.1 假设2维特征向量:X = (x1, X2)

把 b 想象为额外的 wight

超平面方程变为: [图片上传失败...(image-69abb3-1513601715828)]

所有超平面右上方的点满足:[图片上传失败...(image-23b251-1513601715828)]

所有超平面左下方的点满足: [图片上传失败...(image-28c149-1513601715828)]

调整weight,使超平面定义边际的两边:

[图片上传失败...(image-6defd6-1513601715828)]

综合以上两式,得到: (1)

[图片上传失败...(image-bb8918-1513601715828)]

所有坐落在边际的两边的的超平面上的被称作”支持向量(support vectors)"

分界的超平面和H1或H2上任意一点的距离为 [图片上传失败...(image-3d5ae2-1513601715828)]

(i.e.: 其中||W||是向量的范数(norm))

[图片上传失败...(image-565e4d-1513601715828)]

所以,最大边际距离为: [图片上传失败...(image-4a7112-1513601715828)]

5. 求解

5.1 SVM如何找出最大边际的超平面呢(MMH)?

利用一些数学推倒,以上公式 (1)可变为有限制的凸优化问题(convex quadratic optimization)

利用 Karush-Kuhn-Tucker (KKT)条件和拉格朗日公式,可以推出MMH可以被表示为以下“决定边

界 (decision boundary)”

[图片上传失败...(image-788aa2-1513601715828)]

其中,

[图片上传中...(image-a5bb31-1513601715828-6)]

是支持向量点[图片上传中...(image-fa7106-1513601715828-5)]

(support vector)的类别标记(class label)

[图片上传中...(image-c09f97-1513601715828-4)]

是要测试的实例

[图片上传中...(image-1e7b3c-1513601715828-3)]

和 [图片上传中...(image-802948-1513601715828-2)]

都是单一数值型参数,由以上提到的最有算法得出

[图片上传失败...(image-43057-1513601715828)]

是支持向量点的个数

5.2 对于任何测试(要归类的)实例,带入以上公式,得出的符号是正还是负决定

6. 例子:

[图片上传失败...(image-7be259-1513601715827)]

1.1 最早是由 Vladimir N. Vapnik 和 Alexey Ya. Chervonenkis 在1963年提出

1.2 目前的版本(soft margin)是由Corinna Cortes 和 Vapnik在1993年提出,并在1995年发表

1.3 深度学习(2012)出现之前,SVM被认为机器学习中近十几年来最成功,表现最好的算法

2. 机器学习的一般框架:

训练集 => 提取特征向量 => 结合一定的算法(分类器:比如决策树,KNN)=>得到结果

3. 介绍:

3.1 例子:

[图片上传失败...(image-d2cb45-1513601715828)]

两类?哪条线最好?

3.2 SVM寻找区分两类的超平面(hyper plane), 使边际(margin)最大

[图片上传失败...(image-d3b8ab-1513601715828)]

总共可以有多少个可能的超平面?无数条

如何选取使边际(margin)最大的超平面 (Max Margin Hyperplane)?

超平面到一侧最近点的距离等于到另一侧最近点的距离,两侧的两个超平面平行

3. 线性可区分(linear separable) 和 线性不可区分 (linear inseparable)

[图片上传失败...(image-a1909f-1513601715828)]

[图片上传失败...(image-1c90b0-1513601715828)]

[图片上传失败...(image-1fa4e1-1513601715828)]

4. 定义与公式建立

超平面可以定义为:[图片上传失败...(image-e1dfc5-1513601715828)]

W: weight vectot, [图片上传失败...(image-9f878d-1513601715828)]

, n 是特征值的个数

X: 训练实例

b: bias

[图片上传失败...(image-e63c2c-1513601715828)]

4.1 假设2维特征向量:X = (x1, X2)

把 b 想象为额外的 wight

超平面方程变为: [图片上传失败...(image-69abb3-1513601715828)]

所有超平面右上方的点满足:[图片上传失败...(image-23b251-1513601715828)]

所有超平面左下方的点满足: [图片上传失败...(image-28c149-1513601715828)]

调整weight,使超平面定义边际的两边:

[图片上传失败...(image-6defd6-1513601715828)]

综合以上两式,得到: (1)

[图片上传失败...(image-bb8918-1513601715828)]

所有坐落在边际的两边的的超平面上的被称作”支持向量(support vectors)"

分界的超平面和H1或H2上任意一点的距离为 [图片上传失败...(image-3d5ae2-1513601715828)]

(i.e.: 其中||W||是向量的范数(norm))

[图片上传失败...(image-565e4d-1513601715828)]

所以,最大边际距离为: [图片上传失败...(image-4a7112-1513601715828)]

5. 求解

5.1 SVM如何找出最大边际的超平面呢(MMH)?

利用一些数学推倒,以上公式 (1)可变为有限制的凸优化问题(convex quadratic optimization)

利用 Karush-Kuhn-Tucker (KKT)条件和拉格朗日公式,可以推出MMH可以被表示为以下“决定边

界 (decision boundary)”

[图片上传失败...(image-788aa2-1513601715828)]

其中,

[图片上传中...(image-a5bb31-1513601715828-6)]

是支持向量点[图片上传中...(image-fa7106-1513601715828-5)]

(support vector)的类别标记(class label)

[图片上传中...(image-c09f97-1513601715828-4)]

是要测试的实例

[图片上传失败...(image-1e7b3c-1513601715828)]

和 [图片上传中...(image-802948-1513601715828-2)]

都是单一数值型参数,由以上提到的最有算法得出

[图片上传中...(image-43057-1513601715828-1)]

是支持向量点的个数

5.2 对于任何测试(要归类的)实例,带入以上公式,得出的符号是正还是负决定

6. 例子:

[图片上传失败...(image-7be259-1513601715827)]

1.1 最早是由 Vladimir N. Vapnik 和 Alexey Ya. Chervonenkis 在1963年提出

1.2 目前的版本(soft margin)是由Corinna Cortes 和 Vapnik在1993年提出,并在1995年发表

1.3 深度学习(2012)出现之前,SVM被认为机器学习中近十几年来最成功,表现最好的算法

2. 机器学习的一般框架:

训练集 => 提取特征向量 => 结合一定的算法(分类器:比如决策树,KNN)=>得到结果

3. 介绍:

3.1 例子:

[图片上传失败...(image-d2cb45-1513601715828)]

两类?哪条线最好?

3.2 SVM寻找区分两类的超平面(hyper plane), 使边际(margin)最大

[图片上传失败...(image-d3b8ab-1513601715828)]

总共可以有多少个可能的超平面?无数条

如何选取使边际(margin)最大的超平面 (Max Margin Hyperplane)?

超平面到一侧最近点的距离等于到另一侧最近点的距离,两侧的两个超平面平行

3. 线性可区分(linear separable) 和 线性不可区分 (linear inseparable)

[图片上传失败...(image-a1909f-1513601715828)]

[图片上传失败...(image-1c90b0-1513601715828)]

[图片上传失败...(image-1fa4e1-1513601715828)]

4. 定义与公式建立

超平面可以定义为:[图片上传失败...(image-e1dfc5-1513601715828)]

W: weight vectot, [图片上传失败...(image-9f878d-1513601715828)]

, n 是特征值的个数

X: 训练实例

b: bias

[图片上传失败...(image-e63c2c-1513601715828)]

4.1 假设2维特征向量:X = (x1, X2)

把 b 想象为额外的 wight

超平面方程变为: [图片上传失败...(image-69abb3-1513601715828)]

所有超平面右上方的点满足:[图片上传失败...(image-23b251-1513601715828)]

所有超平面左下方的点满足: [图片上传失败...(image-28c149-1513601715828)]

调整weight,使超平面定义边际的两边:

[图片上传失败...(image-6defd6-1513601715828)]

综合以上两式,得到: (1)

[图片上传失败...(image-bb8918-1513601715828)]

所有坐落在边际的两边的的超平面上的被称作”支持向量(support vectors)"

分界的超平面和H1或H2上任意一点的距离为 [图片上传失败...(image-3d5ae2-1513601715828)]

(i.e.: 其中||W||是向量的范数(norm))

[图片上传失败...(image-565e4d-1513601715828)]

所以,最大边际距离为: [图片上传失败...(image-4a7112-1513601715828)]

5. 求解

5.1 SVM如何找出最大边际的超平面呢(MMH)?

利用一些数学推倒,以上公式 (1)可变为有限制的凸优化问题(convex quadratic optimization)

利用 Karush-Kuhn-Tucker (KKT)条件和拉格朗日公式,可以推出MMH可以被表示为以下“决定边

界 (decision boundary)”

[图片上传失败...(image-788aa2-1513601715828)]

其中,

[图片上传中...(image-a5bb31-1513601715828-6)]

是支持向量点[图片上传失败...(image-fa7106-1513601715828)]

(support vector)的类别标记(class label)

[图片上传中...(image-c09f97-1513601715828-4)]

是要测试的实例

[图片上传中...(image-1e7b3c-1513601715828-3)]

和 [图片上传中...(image-802948-1513601715828-2)]

都是单一数值型参数,由以上提到的最有算法得出

[图片上传中...(image-43057-1513601715828-1)]

是支持向量点的个数

5.2 对于任何测试(要归类的)实例,带入以上公式,得出的符号是正还是负决定

6. 例子:

[图片上传失败...(image-7be259-1513601715827)]

1.1 最早是由 Vladimir N. Vapnik 和 Alexey Ya. Chervonenkis 在1963年提出

1.2 目前的版本(soft margin)是由Corinna Cortes 和 Vapnik在1993年提出,并在1995年发表

1.3 深度学习(2012)出现之前,SVM被认为机器学习中近十几年来最成功,表现最好的算法

2. 机器学习的一般框架:

训练集 => 提取特征向量 => 结合一定的算法(分类器:比如决策树,KNN)=>得到结果

3. 介绍:

3.1 例子:

[图片上传失败...(image-d2cb45-1513601715828)]

两类?哪条线最好?

3.2 SVM寻找区分两类的超平面(hyper plane), 使边际(margin)最大

[图片上传失败...(image-d3b8ab-1513601715828)]

总共可以有多少个可能的超平面?无数条

如何选取使边际(margin)最大的超平面 (Max Margin Hyperplane)?

超平面到一侧最近点的距离等于到另一侧最近点的距离,两侧的两个超平面平行

3. 线性可区分(linear separable) 和 线性不可区分 (linear inseparable)

[图片上传失败...(image-a1909f-1513601715828)]

[图片上传失败...(image-1c90b0-1513601715828)]

[图片上传失败...(image-1fa4e1-1513601715828)]

4. 定义与公式建立

超平面可以定义为:[图片上传失败...(image-e1dfc5-1513601715828)]

W: weight vectot, [图片上传失败...(image-9f878d-1513601715828)]

, n 是特征值的个数

X: 训练实例

b: bias

[图片上传失败...(image-e63c2c-1513601715828)]

4.1 假设2维特征向量:X = (x1, X2)

把 b 想象为额外的 wight

超平面方程变为: [图片上传失败...(image-69abb3-1513601715828)]

所有超平面右上方的点满足:[图片上传失败...(image-23b251-1513601715828)]

所有超平面左下方的点满足: [图片上传失败...(image-28c149-1513601715828)]

调整weight,使超平面定义边际的两边:

[图片上传失败...(image-6defd6-1513601715828)]

综合以上两式,得到: (1)

[图片上传失败...(image-bb8918-1513601715828)]

所有坐落在边际的两边的的超平面上的被称作”支持向量(support vectors)"

分界的超平面和H1或H2上任意一点的距离为 [图片上传失败...(image-3d5ae2-1513601715828)]

(i.e.: 其中||W||是向量的范数(norm))

[图片上传失败...(image-565e4d-1513601715828)]

所以,最大边际距离为: [图片上传失败...(image-4a7112-1513601715828)]

5. 求解

5.1 SVM如何找出最大边际的超平面呢(MMH)?

利用一些数学推倒,以上公式 (1)可变为有限制的凸优化问题(convex quadratic optimization)

利用 Karush-Kuhn-Tucker (KKT)条件和拉格朗日公式,可以推出MMH可以被表示为以下“决定边

界 (decision boundary)”

[图片上传失败...(image-788aa2-1513601715828)]

其中,

[图片上传中...(image-a5bb31-1513601715828-6)]

是支持向量点[图片上传中...(image-fa7106-1513601715828-5)]

(support vector)的类别标记(class label)

[图片上传中...(image-c09f97-1513601715828-4)]

是要测试的实例

[图片上传中...(image-1e7b3c-1513601715828-3)]

和 [图片上传失败...(image-802948-1513601715828)]

都是单一数值型参数,由以上提到的最有算法得出

[图片上传中...(image-43057-1513601715828-1)]

是支持向量点的个数

5.2 对于任何测试(要归类的)实例,带入以上公式,得出的符号是正还是负决定

6. 例子:

[图片上传失败...(image-7be259-1513601715827)]