节点最好为基数个

先安装vi /etc/profile

更改ip对应系统用户

如果遇到想更改系统用户名,参考Vmware克隆操作里的更改用户名

把zookeeper安装包上传指定位置,如/home/zookeeper/,解压出来的目录重命名为node-01

找到对应文件/home/zookeeper/node-1/conf/里的zoo_sample.cfg复制一份并重命名为zoo.cfg

zookeeper/node-01的配置如下:

#客户端与服务端维持心跳时间

tickTime=2000

#是Zookeeper 服务器集群中连接到 Leader 的 Follower 服务器)初始化连接时最长 能忍受多少个心跳时间间隔数。当已经超过10个心跳的时间(也就是 tickTime)长度后

Zookeeper 服务器还没有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是 10*2000=20 秒。

initLimit=10

#这个配置项标识 Leader与Follower之间发送消息,请求和应答时间长度,最长不能超过多少个tickTime 的时间长度,总的时间长度就是 5*2000=10 秒。

syncLimit=5

#指定数据和日志目录

dataDir=/home/zookeeper/node-01/data

dataLogDir=/home/zookeeper/node-01/logs

#此机器连接zookeeper的端口,监控与客户端的请求

clientPort=2181

#server.A=B:C:D

#A 是一个数字,表示这个是第几号服务器;

#B 是这个服务器的 IP 地址(或者是与 IP 地址做了映射的主机名);

#C 第一个端口用来集群成员的信息交换,表示这个服务器与集群中的 Leader 服务器交换信息的端口;

#D 是在 leader 挂掉时专门用来进行选举 leader 所用的端口。 注意:如果是伪集群的配置方式,不同的 Zookeeper 实例通信端口号不能一样,所以要给它们分配不同的端口号。

server.1(这里的这个1指的是myid中配置的数字)=主机的名字:2881:3881

server.2=主机的名字:2882:3882

server.3=主机的名字:2883:3883

创建数据和日志目录

创建对应的myid文件在/home/zookeeper/node-01/data/myid写入对应数字,选举规则会根据里面的数据进行选举,如果数字一样会根据文件夹的名字

这里不小心写入数字的时候我输入了一个1后面接了一个回车键,造成了启动的时候始终报找不到myid,直到发现了此情况

开防火墙,配置端口

启动运行,如果启动不起来记得查看相关的日志文件

验证是否启动

可以用sh zkServer.sh status

jps 或者 jps -vm

启动

sh zkCli.sh -server 192.168.x.x:xxxx,其他ip配端口

docker搭集群

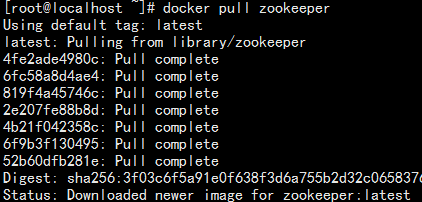

·docker pull zookeeper·

在/opt目录下建立/zookeeper/docker-compose.yml

version: '2'

services:

zoo1:

image: zookeeper

restart: always

container_name: zoo1

ports:

- "2181:2181"

environment:

ZOO_MY_ID: 1

ZOO_SERVERS: server.1=zoo1:2888:3888 server.2=zoo2:2888:3888 server.3=zoo3:2888:3888

zoo2:

image: zookeeper

restart: always

container_name: zoo2

ports:

- "2182:2181"

environment:

ZOO_MY_ID: 2

ZOO_SERVERS: server.1=zoo1:2888:3888 server.2=zoo2:2888:3888 server.3=zoo3:2888:3888

zoo3:

image: zookeeper

restart: always

container_name: zoo3

ports:

- "2183:2181"

environment:

ZOO_MY_ID: 3

ZOO_SERVERS: server.1=zoo1:2888:3888 server.2=zoo2:2888:3888 server.3=zoo3:2888:3888

这个配置文件会告诉 Docker 分别运行三个 zookeeper 镜像, 并分别将本地的 2181, 2182, 2183 端口绑定到对应的容器的2181端口上.

ZOO_MY_ID 和 ZOO_SERVERS 是搭建 ZK 集群需要设置的两个环境变量, 其中 ZOO_MY_ID 表示 ZK 服务的 id, 它是1-255 之间的整数, 必须在集群中唯一. ZOO_SERVERS 是ZK 集群的主机列表.

接着我们在 docker-compose.yml 当前目录下运行:

COMPOSE_PROJECT_NAME=zk_test docker-compose up

-bash: docker-compose: command not found

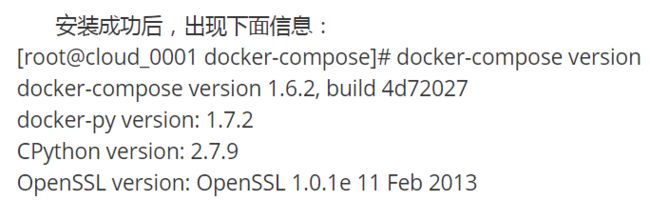

方案1输入

curl -L https://github.com/docker/compose/releases/download/1.6.2/docker-compose-`uname -s`-`uname -m` > /usr/local/bin/docker-compose

chmod +x /usr/local/bin/docker-compose

sudo pip install -U docker-compose

方案2输入

yum -y install epel-release

yum -y install python-pip

pip install docker-compose

docker-compose version

You are using pip version 18.0, however version 18.1 is available.

python -m pip install --upgrade pip

出现错误

ERROR: Failed to Setup IP tables: Unable to enable SKIP DNAT rule: (iptables failed: iptables --wait -t nat -I DOCKER -i br-6111be397ec5 -j RETURN: iptables: No chain/target/match by that name. (exit status 1))

service docker restart

即可启动 ZK 集群了.

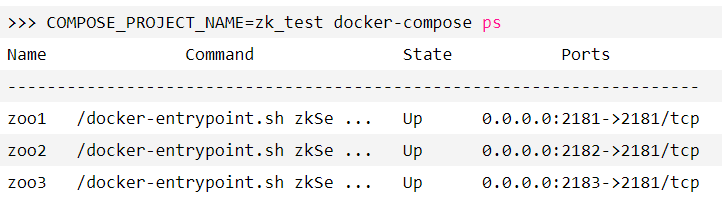

执行上述命令成功后, 接着在另一个终端中运行 docker-compose ps 命令可以查看启动的 ZK 容器:

注意, 我们在 "docker-compose up" 和 "docker-compose ps" 前都添加了 COMPOSE_PROJECT_NAME=zk_test 这个环境变量, 这是为我们的 compose 工程起一个名字, 以免与其他的 compose 混淆.

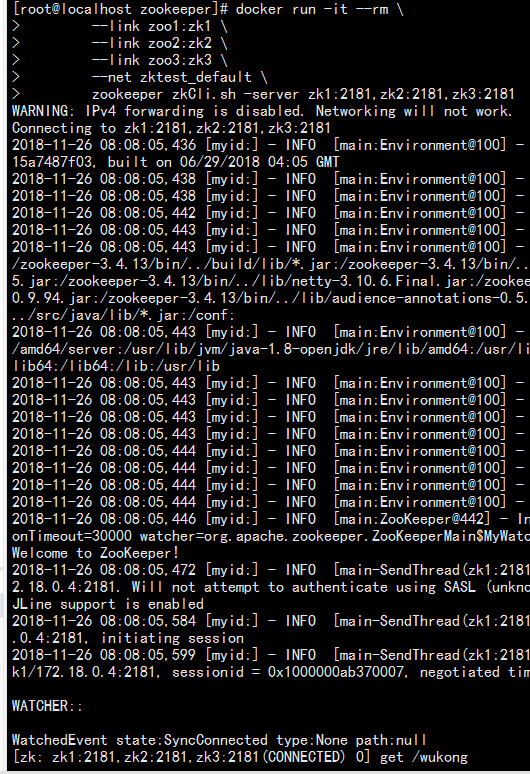

本地关联容器

通过 docker-compose ps 命令, 我们知道启动的 ZK 集群的三个主机名分别是 zoo1, zoo2, zoo3, 因此我们分别 link 它们即可:

`

docker run -it --rm

--link zoo1:zk1

--link zoo2:zk2

--link zoo3:zk3

--net zktest_default

zookeeper zkCli.sh -server zk1:2181,zk2:2181,zk3:2181

`

因为我们分别将 zoo1, zoo2, zoo3 的 2181 端口映射到了 本地主机的2181, 2182, 2183 端口上, 因此我们使用如下命令即可连接 ZK 集群了:

zkCli.sh -server localhost:2181,localhost:2182,localhost:2183

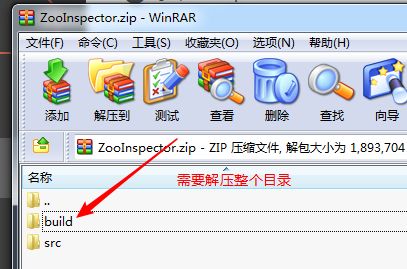

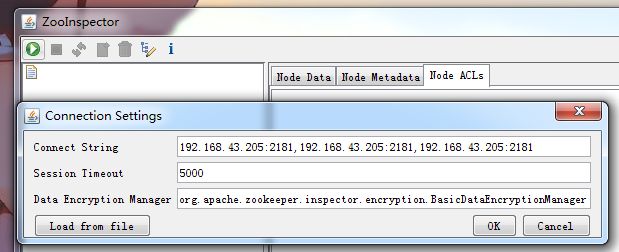

图形化界面

https://issues.apache.org/jira/secure/attachment/12436620/ZooInspector.zip

需要解压

搭建集群session如何解决

session sticky

利用的策略是ip_hash

有两个弊端,一个是一旦服务器断电session就不存在,一个是同路由器的情况ip_hash是一个(会导致错乱)。

session

利用tomcat策略

用户登录服务器,服务器会把session广播通知到所有服务器

弊端:有一个主播服务器占用带宽。每台服务器存储所有的登录用户信息

cookie base

就是把session进行一定规则加密存到客户端cookie。

弊端不安全

session center

阿里用这种策略

数据库

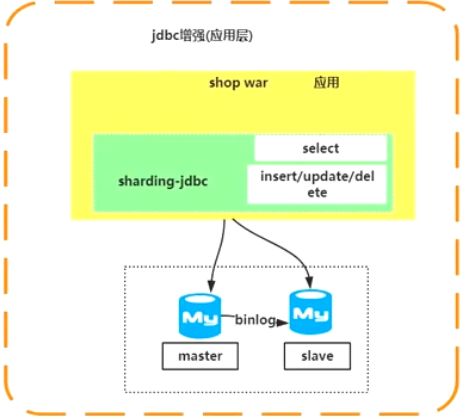

读写分离

proxy:mycat,altas,mysql-proxy(业务扩展性低可以用)

jdbc:tddl,sharding-jdbc

分库分表

垂直,水平

一般结合读写分离用

云数据库(TIDB pingcap)

服务化

前提是应用被模块化拆解。

涉及到了服务化调用

RPC:dubbo,motan

Q&A

dubbo用的是zk临时还是永久节点

用的是临时节点特性

意味着每次连接获取的是节点znode在不在

create -e

节点的创建是唯一名字(同一目录下)

zookeeper可以存对象吗 可以(字节数组)

可以存图片文件吗 可以(字节数组)

Curator的操作方式可以支持创建getData("/wukong/abc/ccc/d/d/daew/ew/ewew/")子节点,如果/wukong/abc存在,下面的是否会继续创建。链式创建。

watcher

用户修改分布式配置中心的配置,其他系统利用watcher也能同步更新

get /你的节点 watcher

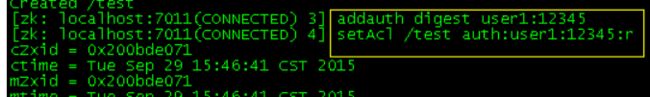

ACL

zk的权限管理

设置节点权限

setAcl /test digest:用户名:密码:权限

获取

getAcl /你的节点

在同一个session中创建权限之后访问是不需要密码验证

ACL(Access Control List)

内置的 ACL schemes:

world:默认方式,相当于全世界都能访问

auth:代表已经认证通过的用户(cli中可以通过addauth digest user:pwd 来添加当前上下文中的授权用户,给"上下文"增加了一个认证用户,即对应刚才setAcl的设置)

setAcl /path digest这种方式,必须输入密码加密后的值,这在cli控制台上很不方便

先用addauth digest user1:12345 增加一个认证用户,然后用 setAcl /test auth:user1:12345:r 设置权限,跟刚才的效果一样,但是密码这里输入的是明文,控制台模式下手动输入更方便。

digest:即用户名:密码这种方式认证,这也是业务系统中最常用的

ip:使用Ip地址认证