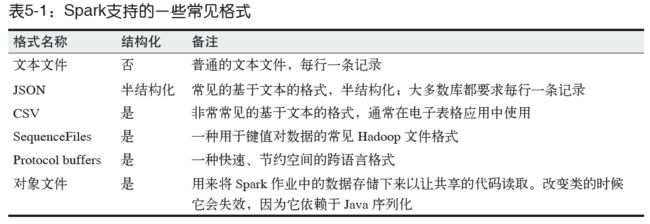

1. 常见数据源

文件格式与文件系统

对于存储在本地文件系统或分布式文件系统(比如NFS、HDFS、Amazon S3 等)中的数据,Spark 可以访问很多种不同的文件格式,包括文本文件、JSON、SequenceFile,以及protocol buffer。Spark SQL中的结构化数据源

Spark SQL 模块,它针对包括JSON 和Apache Hive 在内的结构化数据源,为我们提供了一套更加简洁高效的API。数据库与键值存储

Spark 自带的库和一些第三方库,可以用来连接Cassandra、HBase、Elasticsearch 以及JDBC 源。

2.文件格式

2.1 文本文件

将一个文本文件读取为RDD 时,输入的每一行都会成为RDD 的一个元素。

将多个完整的文本文件一次性读取为一个pair RDD,其中键是文件名,值是文件内容。

2.1.1 读取本地文件

- 读取单个文件:textFile(fileName,minPartitions) ,如果要控制分区数的话,可以指定minPartitions。

注意:textFile()方法也可以读取文件夹,将目录作为参数,会将目录中的数据都读入到RDD中。

//在Scala中读取一个文件

val input = sc.textFile("file:///home/holden/repos/spark/README.md")

//在Java中读取一个文件

JavaRDD input = sc.textFile("file:///home/holden/repos/spark/README.md")

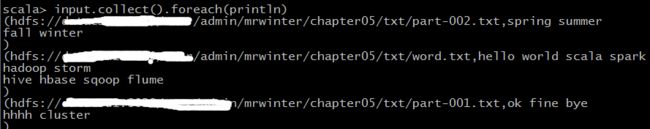

- 读取一个目录中的文件:wholeTextFiles(),方法会返回一个pair RDD,其中键是输入文件的文件名。

Spark 支持读取给定目录中的所有文件,以及在输入路径中使用通配字符(如part-*.txt)。

//使用wholeTextFiles读取文件夹

val input = sc.wholeTextFiles("/user/admin/mrwinter/chapter05/txt/")

input.collect().foreach(println)

使用textFile读取文件夹

val input = sc.textFile("/user/admin/mrwinter/chapter05/txt/")

input.collect().foreach(println)

//在Scala 中求每个文件的平均值

val input = sc.wholeTextFiles("file://home/holden/salesFiles")

val result = input.mapValues{y =>

val nums = y.split(" ").map(x => x.toDouble)

nums.sum / nums.size.toDouble

}

2.1.2 保存本地文件

saveAsTextFile() 方法接收一个路径,并将RDD 中的内容都输入到路径对应的文件中。Spark 将传入的路径作为目录对待,会在那个目录下输出多个文件。

//在Scala中将数据保存为文本文件

inputRDD.saveAsTextFile(outputFile)

2.2 JSON文件

- 读取JSON 数据的最简单的方式是将数据作为文本文件读取,然后使用JSON 解析器来对RDD 中的值进行映射操作。

- 也可以使用JSON 序列化库来将数据转为字符串,然后将其写出去。

- 在Java 和Scala 中也可以使用一个自定义Hadoop 格式来操作JSON 数据。

- 还可以使用Spark SQL 读取JSON 数据。

测试json文件:

{"name":"王阳","age":32}

{"name":"李伟","age":22}

{"name":"刘涵","age":41}

{"name":"张丽","age":23}

{"name":"杨梅","age":34}

读取JSON文件

使用Jackson来解析JSON文件

import org.json4s.ShortTypeHints

import org.json4s.jackson.JsonMethods._

import org.json4s.jackson.Serialization

case class Person(name:String,age:Int)

implicit val formats = Serialization.formats(ShortTypeHints(List()))

val input = sc.textFile("/user/admin/mrwinter/chapter05/person.json")

val result = input.collect().map(x => parse(x).extract[Person])

//保存JSON文件用saveASTextFile(outputFile)即可

val save_json = sc.parallelize(result)

save_json.saveAsTextFile("/user/admin/mrwinter/chapter05/save_person.json")

2.3 逗号分隔值与制表符分隔值

逗号分隔值(CSV)文件每行都有固定数目的字段,字段间用逗号隔开(在制表符分隔值文件,即TSV 文件中用制表符隔开)。

2.3.1 读取CSV

读取CSV/TSV 数据和读取JSON 数据相似,都需要先把文件当作普通文本文件来读取数据,再对数据进行处理。

//CSV文件

holden,panda

hotholden,notpanda

spark,bear

//在Scala 中使用textFile() 读取CSV

import java.io.StringReader

import au.com.bytecode.opencsv.CSVReader

val input = sc.textFile("/user/admin/mrwinter/chapter05/animal.csv")

val result = input.map{ line =>

val reader = new CSVReader(new StringReader(line))

reader.readNext()

}

result.collect().foreach(x => println(x(0), x(1)))

//在Java 中使用textFile() 读取CSV

import au.com.bytecode.opencsv.CSVReader;

import Java.io.StringReader;

JavaRDD csvFile1 = sc.textFile("/user/admin/mrwinter/chapter05/animal.csv");

JavaPairRDD csvData = csvFile1.map(line ->

new CSVReader(new StringReader(line)).readNext();

);

如果在字段中嵌有换行符,就需要完整读入每个文件,然后解析各段。如果每个文件都很大,读取和解析的过程可能会很不幸地成为性能瓶颈。

2.3.2 保存CSV文件

saveAsTextFile(outputFile)