import cv2

import numpy as np

net = cv2.dnn.readNet('yolov3.weights','yolov3.cfg')

可以在 dartnet 下载提供训练好的模型 yolov3.weights 和 yolov3.cfg

classes = []

with open("coco.names","r") as f:

classes =[line.strip() for line in f.readlines()]

print(classes)

coco.names 是分类文件名称文件,我们可以通过打印输出 cooc.names 名称来了解通过模型我们能够识别出的物体种类。

['person', 'bicycle', 'car', 'motorbike', 'aeroplane', 'bus', 'train', 'truck', 'boat',

layers_names = net.getLayerNames()

output_layers = [layers_names[i[0] - 1] for i in net.getUnconnectedOutLayers()]

blob = cv2.dnn.blobFromImage(img,0.00392,(416,416),(0,0,0),True,crop=False)

for b in blob:

for n, img_blob in enumerate(b):

cv2.imshow(str(n),img_blob)

将通过 blobFromImage 读取图片作为神经网络的输入,

def blobFromImage(image, scalefactor, size, mean, swapRB, crop, ddepth)

- 读取的图片

- 对图片值会乘以该指定数据 0.00392

- 输出图片的大小,也就是宽高

- 从通道中减去平均值的平均标量。

- swapRB 表示是否交互第一个或最后一个通道

- ddepth 表示输出带有景深通道,读取图片需要选择 CV_32F 或者 CV_8U

- crop: true 表示对比图片进行裁剪,false 表示是否裁剪和保持原有宽高比

- 返回值为一个 4 维矩阵(NCHW)

returns 4-dimensional Mat with NCHW dimensions order.

net.setInput(blob)

outs = net.forward(output_layers)

将 blob 作为神经网络的输入,然后 outs 接收向前传播作为输出

# print(outs)

# showing informations on the screen

for out in outs:

for detection in out:

scores = detection[5:]

class_id = np.argmax(scores)

confidence = scores[class_id]

if confidence > 0.5:

# objecte detected

center_x = int(detection[0] * width)

center_y = int(detection[1] * height)

w = int(detection[2] * width)

h = int(detection[3] * height)

net.setInput(blob)

outs = net.forward(output_layers)

print(outs)

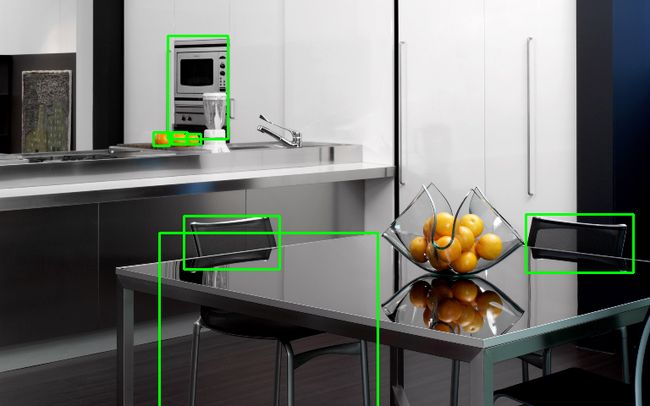

从输出结果来看,输出 outs 是一个 list 前 4 位值分别为识别出物体中心坐标 x 和y 以及识别物体的大小也就是 w 和 h,不过这些都是比例值需要换算。

然后从第 5 开始就是检测物体对应每一个分类概率,我们可以通过 np.argmax 取最大也就是检测物体最可能类的概率值。从而得到该物体是什么物体。

cv2.circle(img,(center_x,center_y),10,(0,255,0),2)

接下来做的事就是把这些物体在图片中表示出来。

boxes.append([x,y,w,h])

confidences.append(float(confidence))

class_ids.append(class_id)

print(len(boxes))

7

number_objects_detected = len(boxes)

for i in range(len(boxes)):

x, y, w, h = boxes[i]

label = classes[class_ids[i]]

print(label)

chair

oven

chair

chair

orange

orange

orange

font = cv2.FONT_HERSHEY_SIMPLEX

number_objects_detected = len(boxes)

for i in range(len(boxes)):

x, y, w, h = boxes[i]

label = str(classes[class_ids[i]])

cv2.rectangle(img,(x,y),(x + w, y + h),(0,255,0),2)

cv2.putText(img,label,(x,y + 30), font, 1, (255,255,252),2)

print(label)