1.基本环境:

操作系统:

Centos 7.2.1511

三台虚机:

192.168.163.224 master

192.168.163.225 node1

192.168.163.226 node2

软件包

hadoop-2.7.2.tar.gz

jdk-7u79-linux-x64.tar.gz

2.配置系统环境

配置ntp时间同步

参考http://bigtrash.blog.51cto.com/8966424/1826481

修改hostname

192.168.163.224主机:

echo "master" > /etc/hostname

192.168.163.225主机:

echo "node1" > /etc/hostname

192.168.163.226主机:

echo "node2" > /etc/hostname

master上修改hosts文件

echo "192.168.163.224 master" >>/etc/hosts echo "192.168.163.225 node1" >>/etc/hosts echo "192.168.163.225 node2" >>/etc/hosts

同步到node1,node2上的主机

scp /etc/hosts node1:/etc/ scp /etc/hosts node2:/etc/

各台主机上相互ping,测试是否可以通过host连通

ping master ping node1 ping node2

master,node1,node2上关闭防火墙

systemctl stop firewalld systemctl disable firewalld

3.配置hadoop环境

master,node1,node2上安装jdk

rpm -qa|grep openjdk #检查openjdk,存在则删除

yum remove *-openjdk-* ####删除openjdk#####

安装sunjdk

###yum install glibc.i686 64位系统安装32位包,需要安装

tar -zxvf jdk-7u79-linux-x64.tar.gz

mv ./jdk1.7.0_79 /usr/

master,node1,node2上创建hadoop用户

useradd hadoop #增加hadoop用户,用户组、home目录、终端使用默认

passwd hadoop #修改密码

建议在学习阶段将hadoop用户加入sudo权限管理,简单方法如下

1.执行visudo命令

2.在root ALL=(ALL) ALL 后加入

hadoop ALL=(ALL) ALL

master,node1,node2上进入hadoop用户:

su - hadoop

master,node1,node2上无密钥连接:

master上的hadoop用户通过rsa算法生成非对称密钥对:

ssh-keygen -t rsa cd /home/hadoop/.ssh/ cp id_rsa.pub authorized_keys chmod go-wx authorized_keys

master上的公钥authorized_keys拷贝到node1,node2上的hadoop用户

scp authorized_keys node1:/home/hadoop/.ssh/ scp authorized_keys node2:/home/hadoop/.ssh/

可通过如下命令测试

ssh node1

ssh node2

为方便node1,node2中hadoop用户可以同时登录master,这里我们集群中的所有用户共用一个密钥(仅仅为了方便,实际环境一定不要这样用)

scp ~/.ssh/id_rsa node1:/home/hadoop/.ssh/ scp ~/.ssh/id_rsa node2:/home/hadoop/.ssh/

master,node1,node2上修改环境变量

vi /etc/profile JAVA_HOME=/usr/jdk1.7.0_79 HADOOP_HOME=/usr/local/hadoop export PATH=$JAVA_HOME/bin:$HADOOP_HOME/sbin:$HADOOP_HOME/bin:$PATH su - hadoop #重新读取环境变量

master,node1,node2上创建相关目录

sudo mkdir -p /usr/local/hadoop sudo chown -R hadoop:hadoop /usr/local/hadoop sudo mkdir -p /data/hadoop/ #创建 hadoop 数据目录结构 sudo chown -R hadoop:hadoop /data/hadoop/ mkdir -p /data/hadoop/tmp/ #创建 tmp mkdir -p /data/hadoop/hdfs/ #创建hdfs mkdir -p /data/hadoop/hdfs/data #创建datanode目录 mkdir -p /data/hadoop/hdfs/name #创建namenode目录 mkdir -p /data/hadoop/hdfs/namesecondary

安装hadoop

wget http://mirror.bit.edu.cn/apache/hadoop/common/hadoop-2.7.2/hadoop-2.7.2.tar.gz tar -zxvf hadoop-2.7.2.tar.gz mv hadoop-2.7.2 /usr/local/hadoop chown -R hadoop:hadoop /usr/local/hadoop/

/usr/local/hadoop目录结构分析:

bin:存放基本的管理脚本和使用脚本

etc:所有配置文件的存放文件

include:对外提供的c++编程库头文件

lib :对外提供的c++编程库动态库和静态库

libexec:各个服务对应的shell配置文件所在目录

logs:存放日志文件

sbin:存放管理脚本,主要包含HDFS及YARN中各类服务的启动与停止脚本

share:各个模块编译后的jar包所在目录

4.修改配置文件

配置文件相关变量详细解释可查看官网:

http://hadoop.apache.org/docs/r2.7.2/hadoop-project-dist/

cd $HADOOP_HOME/etc/hadoop

4.1 vi hadoop-env.sh

export HADOOP_HEAPSIZE=128 #默认为1000M,这里我们修改为128M

4.2 vi core-site.xml #全局配置

fs.defaultFS hdfs://master:9000 dfs.namenode.checkpoint.period 1800 fs.checkpoint.size 67108864 fs.trash.interval 1440 hadoop.tmp.dir /data/hadoop/tmp io.file.buffer.size 131702

4.3 vi hdfs-site.xml #hdfs中NameNode,DataNode局部配置

dfs.namenode.name.dir /data/hadoop/hdfs/name dfs.datanode.data.dir /data/hadoop/hdfs/data dfs.namenode.http-address master:50070 dfs.namenode.secondary.http-address node1:50090 dfs.webhdfs.enabled true dfs.replication 3 dfs.datanode.du.reserved 1073741824 dfs.block.size 134217728 dfs.permissions.enabled false

4.4 vi etc/hadoop/mapred-site.xml.template #配置MapReduce,使用yarn框架、jobhistory使用地址以及web地址

cp etc/hadoop/mapred-site.xml.template etc/hadoop/mapred-site.xml mapreduce.framework.name yarn mapreduce.jobtracker.http.address master:50030 mapreduce.jobtracker.address http://master:9001 mapreduce.jobhistory.address master:10020 mapreduce.jobhistory.webapp.address master:19888

4.5 vi etc/hadoop/yarn-site.xml 配置yarn-site.xml文件

mapreduce.framework.name yarn yarn.resourcemanager.address master:8032 yarn.resourcemanager.scheduler.address master:8030 yarn.resourcemanager.resource-tracker.address master:8031 yarn.resourcemanager.admin.address master:8033 yarn.resourcemanager.webapp.address master:8088

4.6 vi hadoop-env.sh及vi yarn-env.sh

将其中的${JAVA_HOME}用/usr/jdk1.7.0_79代替

5.检查单机版Hadoop

测试hdfs中的namenode与datanode:

hadoop-daemon.sh start namenode chmod go-w /data/hadoop/hdfs/data/ hadoop-daemon.sh start datanode

测试resourcemanager:

yarn-daemon.sh start resourcemanager

测试nodemanager:

yarn-daemon.sh start nodemanager

测试historyserver:

mr-jobhistory-daemon.sh start historyserver

执行jps:

99297 Jps 99244 DataNode 98956 JobHistoryServer 98820 NodeManager 98118 NameNode 98555 ResourceManager

上述表明单机版hadoop安装成功

6.集群搭建

scp -r $HADOOP_HOME/ node1:/usr/local/ scp -r $HADOOP_HOME/ node2:/usr/local/

在master上进行配置

vi $HADOOP_HOME/etc/hadoop/slaves #这里指定里副本数为2,这里指定node1,node2

删除localhost

添加

master

node1

node2

vi $HADOOP_HOME/etc/hadoop/masters

删除localhost

添加

node1 #目的是为了在node1节点上存放secondnamenode

2.xx版本不再有master这个文件了,在hdfs-site.xml这个配置文件中的dfs.namenode.secondary.http-address项中已经指定node1为secondary namenode

7.测试集群是否搭建成功

$HADOOP_HOME/bin/hdfs namenode -format

master上

开启所有节点:start-all.sh(或start-dfs及start-yarn.sh代替)

各节点执行jps

master: 98820 NodeManager 118806 Jps 118176 NameNode 118540 ResourceManager

node1: 106408 SecondaryNameNode 106602 Jps 106301 DataNode 106496 NodeManager

node2: 105932 Jps 105812 NodeManager 105700 DataNode

存在上述状态,说明集群搭建成功

关闭所有节点:stop-all.sh(或stop-dfs.sh及stop-yarn.sh代替)

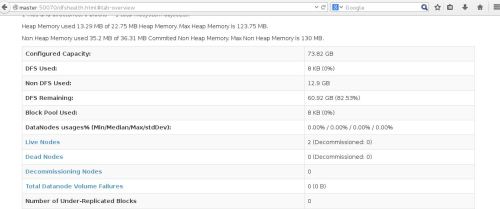

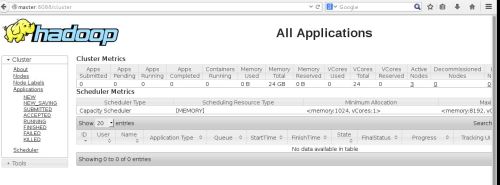

同时可以访问网页进行查看:

http://master:50070/

http://master:8088/