关于分词工具包的体验:分词练习2——分词体验

现有的分词工具包

(1)NLPIR

NLPIR汉语分词系统,又名ICTCLAS。

一套专门针对原始文本集进行处理和加工的软件,提供了中间件处理效果的可视化展示,也可以作为小规模数据的处理加工工具。用户可以使用该软件对自己的数据进行处理。

全部采用C/C++编写,支持Linux、FreeBSD及Windows系列操作系统,支持C/C++/C#/Delphi/Java等主流的开发语言

支持GBK编码(Guo-BiaoKuozhan,简体中文)分词,同时支持UTF-8编码和Big5编码(大五码,繁体中文)分词;支持繁体中文分词;支持多线程分词。

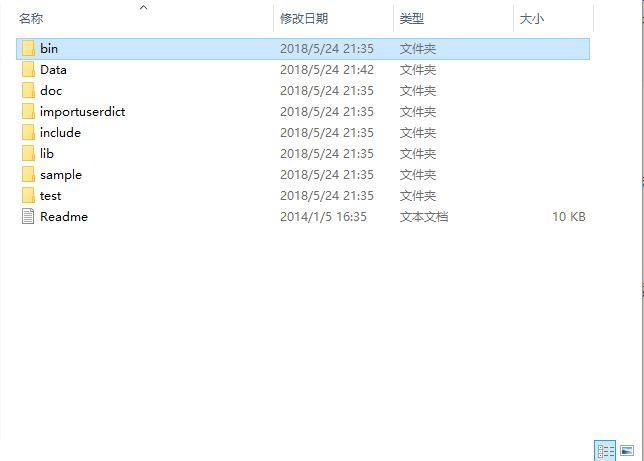

另外,该系统支持Java/C++/C#/C/Delphi等主流开发语言,可以将NLPIR分词系统下载包下载到电脑上,在编写程序时使用,压缩包所含内容如下图所示:

主页:http://ictclas.nlpir.org/

在线演示:http://ictclas.nlpir.org/nlpir/

开源中国社区: 中科院中文分词 ICTCLAS

(2)Ansj

一款纯Java的、主要应用于自然语言处理的、高精度的中文分词工具,目标是“准确、高效、自由地进行中文分词”,可用于人名识别、地名识别、组织机构名识别、多级词性标注、关键词提取、指纹提取等领域,支持行业词典、用户自定义词典。

项目网址:https://github.com/NLPchina/ansj_seg

在线演示:http://www.ansj.org/

一个比较详细的关于Ansj的介绍:开源 Java 中文分词器 Ansj 作者孙健专访

官方文档:http://nlpchina.github.io/ansj_seg/

开源中国社区: 中文分词 Ansj

(3)IKAnalyzer

一个开源的,基于java语言开发的轻量级的中文分词工具包。从2006年12月推出1.0版开始,IKAnalyzer已经推出 了3个大版本。最初,它是以开源项目 Lucene为应用主体的,结合词典分词和文法分析算法的中文分词组件。新版本的IKAnalyzer3.0则发展为 面向Java的公用分词组件,独立于Lucene项目,同时提供了对Lucene的默认优化实现。

下载地址: https://pan.baidu.com/s/17-W5jOYoNOBH2H_8EwIymw 密码: x3wy

有关教程:中文分词工具-IKAnalyzer下载及使用;IKAnalyzer总结;solr7.3 环境搭建 配置中文分词器 ik-analyzer-solr7 详细步骤

中国开源社区: 中文分词库 IKAnalyzer

(4)HanLP

由一系列模型与算法组成的Java工具包,目标是普及自然语言处理在生产环境中的应用。不仅仅是分词,而是提供词法分析、句法分析、语义理解等完备的功能。HanLP具备功能完善、性能高效、架构清晰、语料时新、可自定义的特点。

主页:http://hanlp.linrunsoft.com/

文档:http://hanlp.linrunsoft.com/doc/_build/html/index.html

下载:http://hanlp.linrunsoft.com/services.html

Github:https://github.com/hankcs/HanLP

开源中国社区: 自然语言处理 HanLP

(5)FudanNLP

由复旦大学自然语言处理组开发的一套中文自然语言处理工具包,包括中文分词、词性标注、命名实体识别、依存句法分析、关键词抽取、时间短语识别、文本分类、新闻聚类、层次分类、在线学习等功能,该项目使用LGPL3.0许可证。

主页:https://code.google.com/archive/p/fudannlp/

下载:https://code.google.com/archive/p/fudannlp/downloads

文档:https://wenku.baidu.com/view/d9c21a74f18583d04864595e.html

开放知识图谱:FudanNLP: 中文自然语言处理工具包

GitHub:https://github.com/FudanNLP/fnlp

教程:https://github.com/FudanNLP/fnlp/wiki

开源中国社区: 中文自然语言处理工具包 FudanNLP

(6)Jcseg

使用Java开发的一个开源的中文分词器,使用流行的mmseg算法实现。是一款独立的分词组件,不是针对lucene而开发,但是提供了最新版本的lucene和solr分词接口。

首页:https://code.google.com/archive/p/jcseg/

开发帮助文档:https://wenku.baidu.com/view/8612a64d87c24028905fc30a.html

下载:https://code.google.com/archive/p/jcseg/downloads

开源中国社区:https://www.oschina.net/p/jcseg

(7)庖丁解牛分词器

一个使用Java开发的,可结合到Lucene应用中的,为互联网、企业内部网使用的中文搜索引擎分词组件。Paoding填补了国内中文分词方面开源组件的空白,致力于此并希翼成为互联网网站首选的中文分词开源组件。

主页:https://code.google.com/archive/p/paoding/

下载:https://code.google.com/archive/p/paoding/downloads

开源中国社区: 中文分词库 Paoding

一个教程:庖丁解牛"中文分词包

(8)盘古分词

盘古分词是一个中英文分词组件。作者eaglet 曾经开发过KTDictSeg 中文分词组件,拥有大量用户。作者基于之前分词组件的开发经验,结合最新的开发技术重新编写了盘古分词组件。主要有以下功能:

1、中文未登陆词识别

2、词频优先

3、一元分词,多元分词

4、中文人名分词

5、繁体中文分词

6、英文分词

7、用户自定义规则(字典管理,动态加载字典,关键词高亮)

主页:https://archive.codeplex.com/?p=pangusegment

开源中国社区: 盘古分词

使用手册:https://wenku.baidu.com/view/92543952c281e53a5802ff50.html

(9)MMSEG4J

mmseg4j用Chih-Hao Tsai 的MMSeg算法实现的中文分词器,并实现lucene的analyzer和solr的TokenizerFactory以方便在Lucene和Solr中使用。 MMSeg 算法有两种分词方法:Simple和Complex,都是基于正向最大匹配。Complex加了四个规则过虑。

首页:https://code.google.com/archive/p/mmseg4j/

下载:https://github.com/chenlb/mmseg4j-solr

开源中国社区: 中文分词器 mmseg4j

(10)jieba分词器

做最好的Python中文分词组件 "Jieba"

支持三种分词模式:

精确模式,试图将句子最精确地切开,适合文本分析;

全模式,把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义;

搜索引擎模式,在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词。

支持繁体分词

支持自定义词典

首页:https://pypi.org/project/jieba/

开源中国社区: Python中文分词组件 jieba

Github:https://github.com/fxsjy/jieba

下转分词练习2——分词体验