一、服务器环境

LINUX:centOS 6.5

JAVA:1.8.0_171

二、安装配置

1、安装配置ZooKeeper集群

(1)创建zookeeper目录,快照日志存放目录dataDir、事务日志存放目录dataLogDir

[root@wzq ~]# cd /opt

[root@wzq opt]# mkdir zookeeper

[root@wzq zookeeper]# mkdir -p dataDir

[root@wzq zookeeper]# mkdir dataLogDir

(2)下载解压zookeeper

[root@wzq opt]# wget http://mirrors.cnnic.cn/apache/zookeeper/zookeeper-3.4.12/zookeeper-3.4.12.tar.gz

[root@wzq opt]# tar zxf zookeeper-3.4.12.tar.gz

(3)修改配置文件

[root@wzq opt]# cd /zookeeper-3.4.12/conf/

[root@wzq conf]# mv zoo_sample.cfg zoo.cfg

[root@console conf]# vim zoo.cfg

# 存放数据文件

dataDir=/opt/zookeeper/dataDir

# 存放日志文件

dataLogDir=/opt/zookeeper/dataLogDir

clientPort=2181

initLimit=5

syncLimit=2

# zookeeper cluster,2888为选举端口,3888为心跳端口

server.1=192.168.2.128:2888:3888

server.2=192.168.2.129:2888:3888

server.3=192.168.2.133:2888:3888

在dataDir指定的目录下面,创建一个myid文件,里面内容为一个数字,用来标识当前主机,conf/zoo.cfg文件中配置的server.X中X为什么数字,则myid文件中就输入这个数字。

(4)启动和关闭zk

[root@console bin]# ./zkServer.sh start

[root@console bin]# ./zkServer.sh stop

(5)查看zookeeper启动状态,包括集群中各个结点的角色(leader、follower)

[root@wzq bin]# ./zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /opt/zookeeper/zookeeper-3.4.12/bin/../conf/zoo.cfg

Mode: leader

其它主机同理设置。

2、安装配置kafka集群

(1)创建消息持久化目录

[root@wzq ~]# cd /opt

[root@wzq opt]# mkdir kafka

[root@wzq opt]# mkdir /kafkaLogs

(2)下载解压kafka

[root@wzq kafka]# wget http://mirrors.cnnic.cn/apache/kafka/1.1.0/ kafka_2.12-1.1.0.tgz

[root@wzq kafka]# tar zxf kafka_2.12-1.1.0

(3)修改配置

[root@wzq kafka]# cd kafka_2.12-1.1.0/config/

[root@wzq config]# vim server.properties

auto.create.topics.enable=false #关闭自动创建topic

delete.topic.enable=true #添加启用删除topic配置

其它主机同理设置。

(4)启动集群

[root@wzq bin]# ./kafka-server-start.sh -daemon ../config/server.properties

(5)测试集群

创建topic

为Topic创建分区时,--partitions(分区数)最好是broker数量的整数倍,这样才能使一个Topic的分区均匀的分布在整个Kafka集群中。

[root@wzq kafka_2.12-1.1.0]# ./bin/kafka-topics.sh --create --zookeeper 192.168.2.128:2181,192.168.2.129:2181,192.168.2.133 --replication-factor 1 --partitions 1 --topic TEST1

创建一个producer程序

[root@wzq bin]# ./kafka-console-producer.sh --broker-list 192.168.2.129:9092 --topic TEST1

创建consumer程序

[root@wzq kafka_2.12-1.1.0]# bin/kafka-console-consumer.sh --bootstrap-server 192.168.2.129:9092 --topic TEST1 --from-beginning

producer发送消息,consumer接收,至此,KAFKA搭建完成。

PS:

(1)单纯的kafka broker集群没有意义,一台宕机照样出错,必须带上zookeeper集群一起。

(2)broker和zookeeper都至少要三台服务器,奇数台。

(3)每次打开consumer都会收到历史消息,消息保存在kafkaLogs/TEST1-0/00000000000000000000.log

(4)broker的server.properties参数解释

broker.id=0 #当前机器在集群中的唯一标识,和zookeeper的myid性质一样

port=19092 #当前kafka对外提供服务的端口默认是9092

host.name=192.168.7.100 #这个参数默认是关闭的,在0.8.1有个bug,DNS解析问题,失败率的问题。

num.network.threads=3 #这个是borker进行网络处理的线程数

num.io.threads=8 #这个是borker进行I/O处理的线程数

log.dirs=/opt/kafka/kafkalogs/ #消息存放的目录,这个目录可以配置为“,”逗号分割的表达式,上面的num.io.threads要大于这个目录的个数这个目录,如果配置多个目录,新创建的topic他把消息持久化的地方是,当前以逗号分割的目录中,那个分区数最少就放那一个

socket.send.buffer.bytes=102400 #发送缓冲区buffer大小,数据不是一下子就发送的,先回存储到缓冲区了到达一定的大小后在发送,能提高性能

socket.receive.buffer.bytes=102400 #kafka接收缓冲区大小,当数据到达一定大小后在序列化到磁盘

socket.request.max.bytes=104857600 #这个参数是向kafka请求消息或者向kafka发送消息的请请求的最大数,这个值不能超过java的堆栈大小

num.partitions=1 #默认的分区数,一个topic默认1个分区数

log.retention.hours=168 #默认消息的最大持久化时间,168小时,7天

message.max.byte=5242880 #消息保存的最大值5M

default.replication.factor=2 #kafka保存消息的副本数,如果一个副本失效了,另一个还可以继续提供服务

replica.fetch.max.bytes=5242880 #取消息的最大直接数

log.segment.bytes=1073741824 #这个参数是:因为kafka的消息是以追加的形式落地到文件,当超过这个值的时候,kafka会新起一个文件

log.retention.check.interval.ms=300000 #每隔300000毫秒去检查上面配置的log失效时间(log.retention.hours=168 ),到目录查看是否有过期的消息如果有,删除

log.cleaner.enable=false #是否启用log压缩,一般不用启用,启用的话可以提高性能

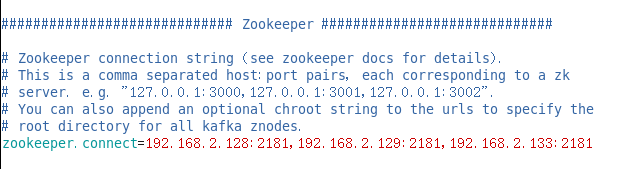

zookeeper.connect=192.168.7.100:12181,192.168.7.101:12181,192.168.7.107:1218 #设置zookeeper的连接端口