安装环境(VMware12 , centos6.4)

1.安装JDK

检测已经安装jdk : rpm -qa|grep jdk

查到什么删什么:rpm -e --nodeps java-1.6.0-openjdk-1.6.0.0-1.45.1.11.1.el6.i686

--------------------------------------------------------------分割线--------------------------------------------------------------------

-①-- 在CentOS下安装JDK8

安装JDK8

1.去http://www.Oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html中下载JDK的安装文件jdk-8u60-linux-x64.tar.gz。

2.新建/usr/java文件夹,将jdk-8u60-linux-x64.tar.gz放到该文件夹下,并切换到/usr/java目录下。

3.执行命令tar zxvf jdk-8u60-linux-x64.tar.gz进行解压缩,解压后/usr/java目录下多了jdk1.8.0_60文件夹。

4.通过以上步骤,JDK安装完毕。下面开始配置环境变量。

配置环境变量

1.执行命令vim /etc/profile编辑profile文件。

2.在/etc/profile底部加入如下内容:

JAVA_HOME=/usr/java/jdk1.8.0_60

PATH=$JAVA_HOME/bin:$PATH

CLASSPATH=$JAVA_HOME/jre/lib/ext:$JAVA_HOME/lib/tools.jar

export PATH JAVA_HOME CLASSPATH

3.以上,环境变量配置完成。需要注意的是,PATH在配置的时候,一定要把$JAVA_HOME/bin放在前面,不然使用java命令时,系统会找到以前 的java,再不往下找了。这样java这个可执行文件运行的目录其实不在$JAVA_HOME/bin下,而在其它目录下,会造成很大的问题。

4.执行命令source /etc/profile让profile文件立即生效。

命令测试

1.使用javac命令,不会出现command not found错误。

2.使用java -version,出现版本为java version "1.8.0_60"。

3.看看自己的配置是否都正确。

echo $JAVA_HOME

echo $CLASSPATH

echo $PATH

-----------------------------------------------------------------------分割线----------------------------------------------------------------

tar -zvxf jdk-7u79-linux-x64.tar.gz -C ~/app:将jdk解压到根目录下的app文件夹之下。

②配置环境变量:

--cd ~/app /jdk1.7.0_79

--pwd 得到目录/home/hadoop/app/jdk1.7.0_79

--cd 回到原来目录

--vi ~/.bash_profile 写入环境变量

if [ -f ~/.bashrc ]; then

. ~/.bashrc

fi

# User specific environment and startup programs

export JAVA_HOME=/home/hadoop/app/jdk1.7.0_79

export PATH=$JAVA_HOME/bin:$PATH

export SCALA_HOME=/home/hadoop/app/scala-2.11.8

export PATH=$SCALA_HOME/bin:$PATH

export MAVEN_HOME=/home/hadoop/app/apache-maven-3.3.9

export PATH=$MAVEN_HOME/bin:$PATH

--source ~/.bash_profile 使环境变量生效

echo $JAVA_HOME查看环境变量

2.安装ssh

---sudo yum install ssh

---ssh-keygen -t rsa

----cp ~/.ssh/id_rsa.pub ~/.ssh/authorized_keys

测试:

ssh -localhost 注意:一般情况下localhost是127.0.0.1;如果localhost不行就用ip地址

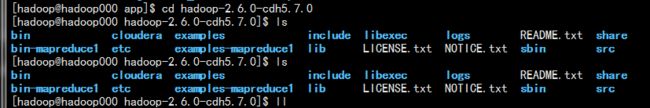

3.安装hadoop:

第一步:到cdh网站上下载并解压文件到根目录下面的app目录下

bin:中是客户端

第二步:修改配置文件,配置java路径

/home/hadoop/app/hadoop-2.6.0-cdh5.7.0/etc/hadoop修改hadoop-env.sh文件 中的路径为下列路径:

[hadoop@hadoop000 Desktop]$ echo $JAVA_HOME

/home/hadoop/app/jdk1.7.0_79

4.配置xml文档 core-site.xml ; hdfs-site.xml; slaves

5.启动hdfs

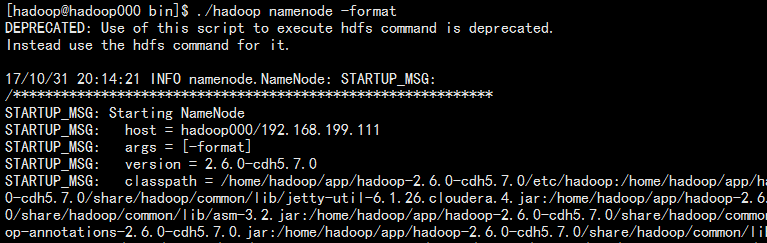

格式化文件系统(仅第一次执行,不可重复)bin/hadoop namnode -format (过时的方法,请使用hdfs/hadoop namnode -format)

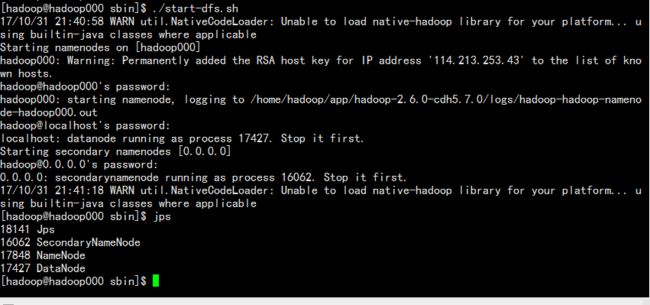

启动hdfs:sbin/start-dfs.sh

验证是否启动成功:①jps ② 虚拟机的浏览器验证http://hadoop000:50070 【主机名+端口号】

6.停止hdfs

sbin/stop-dfs.sh

报错解决:ip a ; cat /etc/hosts 修改host ip地址和ip a 中出现的一样