1.参考资料

https://github.com/HikoQiu/kubeadm-install-k8s

https://kubernetes.io/docs/setup/independent/high-availability/

http://blog.51cto.com/nosmoking/2062887

2.基础环境准备

参照 https://my.oschina.net/baobao/blog/3029145 配置基础环境

三台服务器上安装kubelet、kubeadm、kubectl,并确保kubelet开机启动###

修改三台服务的 /etc/hosts 文件,服务器的名称和解析的保持一致,例如 node1 node2 node3.加上apiServer的解析域名,可以自己定义,记得下面的步骤也要修改成相同的解析域名###

使用hosts代替了HA的解析功能,比较简单,也可用三台服务器使用nginx实现,每台服务器也要做别名映射.###

3.初始化kubeadm配置文件

kubeadm init 的配置文件 kubeadm-config.yaml ,拷贝到三台服务器###

apiVersion: kubeadm.k8s.io/v1beta2

kind: ClusterConfiguration

###指定k8s的版本###

kubernetesVersion: v1.15.0

### 指定微软云镜像仓库###

imageRepository: gcr.azk8s.cn/google_containers

### apiServerCertSANs 填所有的masterip,lbip其它可能需要通过它访问apiserver的地址,域名或主机名等 ###

### 如阿里fip,证书中会允许这些ip ###

### 这里填一个自定义的域名 ###

### 用于访问APIServer的LB,一般通过nginx或者haproxy做集群解析.可以在每台服务器做hosts映射到127.0.0.1 然后每台服务器上都安装nginx,做upstream,用于健康检查. ###

### 这里我为了方便,修改三台服务器上的 /etc/hosts ,把有三个master的IP都解析到 domain 的域名,hosts好像做了健康检查,代替了DNS的功能 ###

apiServer:

###添加域名的SSL证书###

certSANs:

- "api.k8s.mzywx.com"

###apiServer的集群访问地址###

controlPlaneEndpoint: "api.k8s.mzywx.com:6443"

### calico 网络插件的子网 ###

networking:

podSubnet: "192.168.0.0/16"

dnsDomain: cluster.local

serviceSubnet: "10.96.0.0/12"

把需要的镜像下载到本地,这样安装过程会比较平稳###

kubeadm config images pull --config kubeadm-config.yaml

4.安装node1

我们目标是要搭建一个高可用的 master集群,node2 node3需要依赖node1初始化产生的证书文件,所以需要先在node1初始化.

kubeadm init --config kubeadm-config.yaml

记下加入的命令,例如:

kubeadm join api.k8s.mzywx.com:6443 --token 39tdfod --discovery-token-ca-cert-hash sha256:4270dsf6f7

安装网络插件###

wget https://docs.projectcalico.org/v3.7/manifests/calico.yaml

可以修改文件中的 192.168.0.0/16,和kubeadm init中的 --pod-network-cidr=192.168.0.0/16 保持一致###

kubectl apply -f calico.yaml

master同时也做work节点###

kubectl taint nodes --all node-role.kubernetes.io/master-

node/master untainted

同步证书文件,使用shell脚本,把node1上产生的证书拷贝到node2和node3####

#!/bin/sh

vhost="node2 node3"

usr=root

who=`whoami`

if [[ "$who" != "$usr" ]];then

echo "请使用 root 用户执行或者 sudo ./sync.master.ca.sh"

exit 1

fi

echo $who

# 需要从 node1 拷贝的 ca 文件

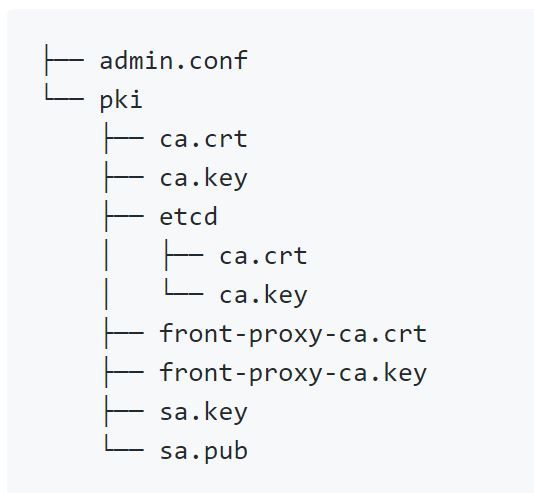

caFiles=(

/etc/kubernetes/pki/ca.crt

/etc/kubernetes/pki/ca.key

/etc/kubernetes/pki/sa.key

/etc/kubernetes/pki/sa.pub

/etc/kubernetes/pki/front-proxy-ca.crt

/etc/kubernetes/pki/front-proxy-ca.key

/etc/kubernetes/pki/etcd/ca.crt

/etc/kubernetes/pki/etcd/ca.key

/etc/kubernetes/admin.conf

)

pkiDir=/etc/kubernetes/pki/etcd

for h in $vhost

do

ssh ${usr}@$h "mkdir -p $pkiDir"

echo "Dirs for ca scp created, start to scp..."

# scp 文件到目标机

scp /etc/kubernetes/pki/ca.crt /etc/kubernetes/pki/ca.key /etc/kubernetes/pki/sa.key /etc/kubernetes/pki/sa.pub /etc/kubernetes/pki/front-proxy-ca.crt /etc/kubernetes/pki/front-proxy-ca.key ${usr}@$h:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/etcd/ca.crt /etc/kubernetes/pki/etcd/ca.key ${usr}@$h:/etc/kubernetes/pki/etcd/

scp /etc/kubernetes/admin.conf ${usr}@$h:/etc/kubernetes/

echo "Ca files transfered for $h ... ok"

done

到node2和node3上查看/etc/kubernetes/ 目录###

5.安装node2,node3

在master的join命令里加入 --experimental-control-plane 参数,这个就是master集群的加入,不是普通node节点的加入.

kubeadm join api.k8s.mzywx.com:6443 --token 39tdfod --discovery-token-ca-cert-hash sha256:4270dsf6f7 --experimental-control-plane

master同时也做work节点###

kubectl taint nodes --all node-role.kubernetes.io/master-

node3的操作和node2的一致###

6.查看节点状态

kubectl get node

转载自光石头https://my.oschina.net/baobao/blog/3031712?tdsourcetag=s_pcqq_aiomsg