- 1 进程描述符struct task_struct

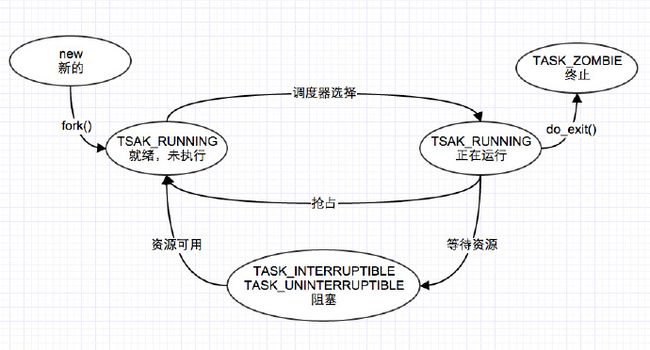

- 1.1 进程状态

- 1.1.1 5个互斥状态

- 1.1.2 2个终止状态

- 1.1.3 睡眠状态

- 1.1.3.1 内核将进程置为睡眠状态的方法

- 1.1.4 状态切换

- 1.2 进程标识符(PID)

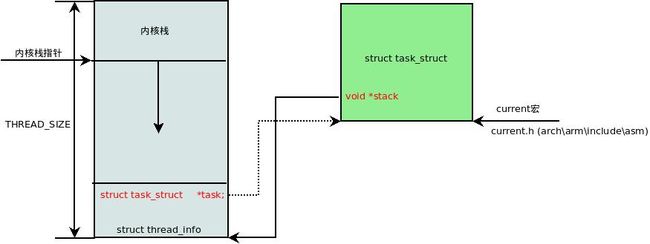

- 1.3 进程内核栈与thread_info结构

- 1.3.1 为什么需要内核栈

- 1.3.2 为什么需要thread_info

- 1.3.3 内核栈和线程描述符

- 1.3.4 内核栈数据结构描述thread_info和thread_union

- 1.3.5 获取当前在CPU上正在运行进程的thread_info

- 1.3.6 分配和销毁thread_info

- 1.4 进程标记

- 1.5 表示进程亲属关系的成员

- 1.6 ptrace系统调用

- 1.7 Performance Event

- 1.8 进程调度

- 1.8.1 优先级

- 1.8.2 调度策略相关字段

- 1.9 进程地址空间

- 1.10 判断标志

- 1.11 时间

- 1.12 信号处理

- 1.13 其他

- 1.1 进程状态

- 2 命名空间

- 2.1 Linux内核命名空间描述

- 2.2 命名空间的创建

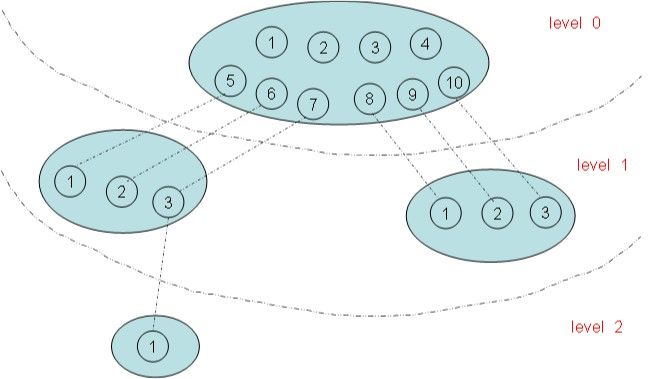

- 2.3 PID Namespace

- 3 进程ID类型

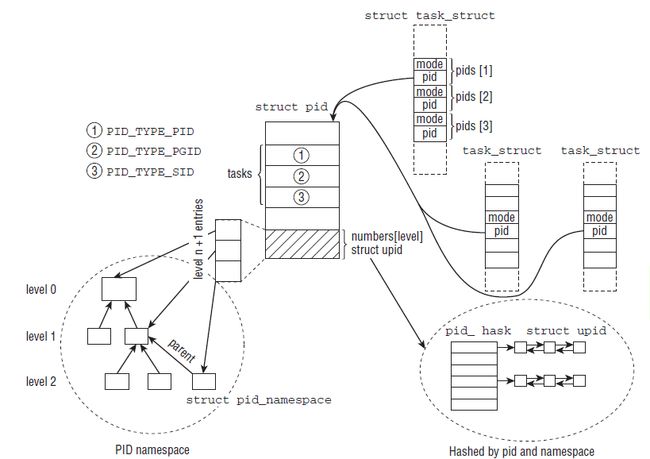

- 4 PID命名空间

- 4.1 pid命名空间概述

- 4.2 局部ID和全局ID

- 4.2.1 全局ID

- 4.2.2 局部ID

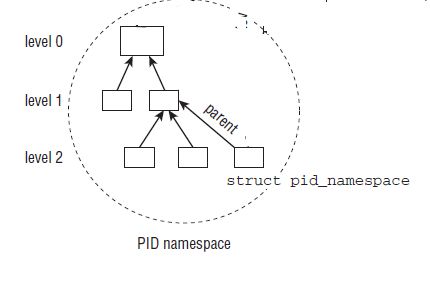

- 4.3 PID命名空间数据结构pid_namespace

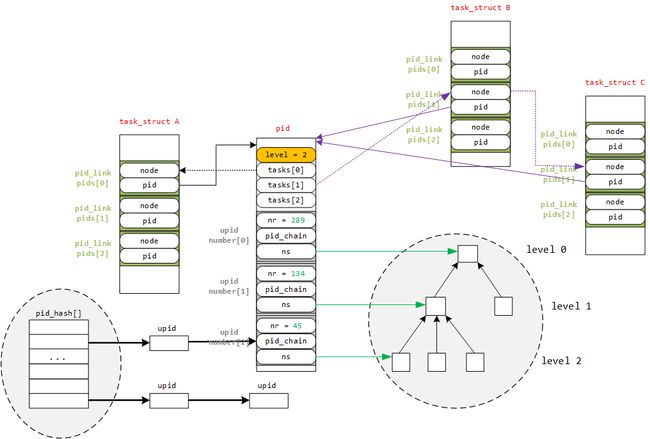

- 5 pid结构描述

- 5.1 pid与upid

- 5.1.1 特定命名空间信息struct upid

- 5.1.2 局部ID类struct pid

- 5.2 用于分配pid的位图struct pidmap

- 5.3 pid的哈希表存储结构struct pid_link

- 5.4 task_struct中的进程ID相关描述符信息

- 5.5 进程ID管理函数

- 5.5.1 进程pid号找到struct pid实体

- 5.5.2 获取局部ID

- 5.5.3 根据PID查找进程task_struct

- 5.5.4 生成唯一的PID

- 5.1 pid与upid

- 6 Liux进程类别

- 6.1 内核线程

- 7 linux进程的创建流程

- 7.1 进程的复制fork和加载execve

- 7.2 写时复制技术

- 7.3 内核线程创建接口

- 7.3.1 kernel_thread

- 7.3.2 kthread_create

- 7.3.3 kthread_run

- 7.4 内核线程的退出接口

- 8 Linux中3个特殊的进程

- 8.1 0号idle进程

- 8.1.1 0号进程上下文信息--init_task描述符

- 8.1.2 进程堆栈init_thread_union

- 8.1.3 进程内存空间

- 8.1.4 0号进程的演化

- 8.1.4.1 rest_init创建init进程(PID=1)和kthread进程(PID=2)

- 8.1.4.1.1 创建kernel_init

- 8.1.4.1.2 创建kthreadd

- 8.1.4.2 0号进程演变为idle

- 8.1.4.1 rest_init创建init进程(PID=1)和kthread进程(PID=2)

- 8.1.5 idle的运行与调度

- 8.1.5.1 idle的workload--cpu_idle_loop

- 8.1.5.2 idle的运行时机

- 8.2 1号init进程

- 8.2.1 执行函数kernel_init()

- 8.2.2 关于init程序

- 8.3 2号kthreadd进程

- 8.3.1 执行函数kthreadd()

- 8.3.1.1 create_kthread(struct kthread_create_info)完成内核线程创建

- 8.3.2 新创建的内核线程执行函数kthread()

- 8.3.3 小结

- 8.3.1 执行函数kthreadd()

- 8.1 0号idle进程

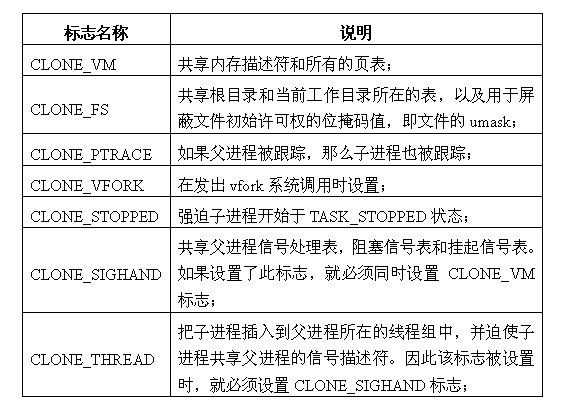

- 9 用户空间创建进程/线程的三种方法

- 9.1 系统调用的参数传递

- 9.2 sys_fork的实现

- 9.3 sys_vfork的实现

- 9.4 sys_clone的实现

- 10 创建子进程流程

- 10.1 _do_fork的流程

- 10.2 copy_process流程

- 10.2.1 dup_task_struct()产生新的task_struct

- 10.2.2 sched_fork()流程

- 10.2.3 copy_thread和copy_thread_tls流程

- 11 用户程序结束进程

- 12 进程状态变化过程

- 13 内核线程

- 13.1 概述

- 13.2 内核线程的创建

- 13.2.1 创建内核线程接口

- 13.2.2 2号进程kthreadd

- 13.2.3 kernel_thread()创建内核线程

- 14 可执行程序的加载和运行

- 14.1 exec()函数族

- 14.2 可执行程序相关数据结构

- 14.2.1 struct linux_binprm结构描述一个可执行程序的信息

- 14.2.2 struct linux_binfmt可执行格式的结构

- 14.3 execve加载可执行程序的过程

- 14.4 execve的入口函数sys_execve

- 14.5 do_execve函数

- 14.6 exec_binprm()识别并加载二进程程序

- 14.7 search_binary_handler()识别二进程程序

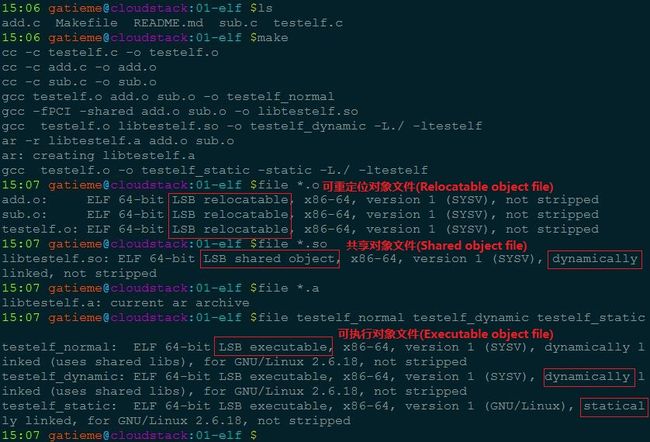

- 15 对象文件格式

- 15.1 对象文件

- 15.1.1 可重定位的对象文件(Relocatable file)

- 15.1.2 可执行的对象文件(Executable file)

- 15.1.3 可被共享的对象文件(Shared object file)

- 15.2 文件格式

- 15.3 ELF对象文件格式

- 15.4 示例

- 15.4.1 add.c

- 15.4.2 sub.c

- 15.4.3 testelf.c

- 15.4.4 Makefile

- 15.1 对象文件

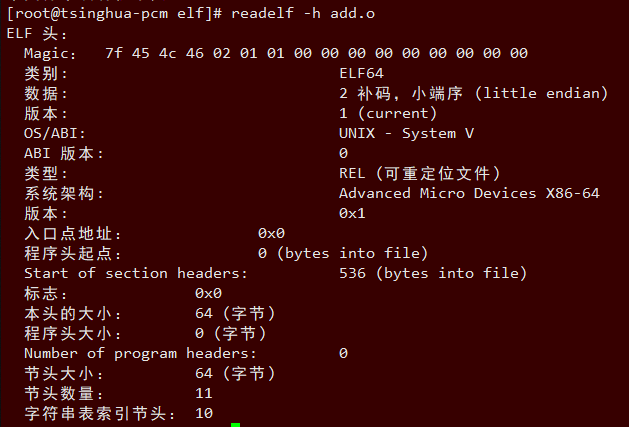

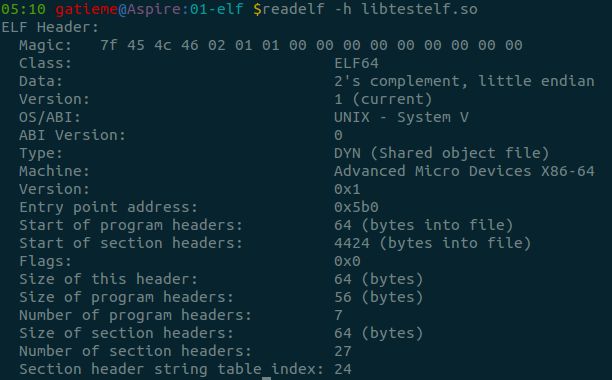

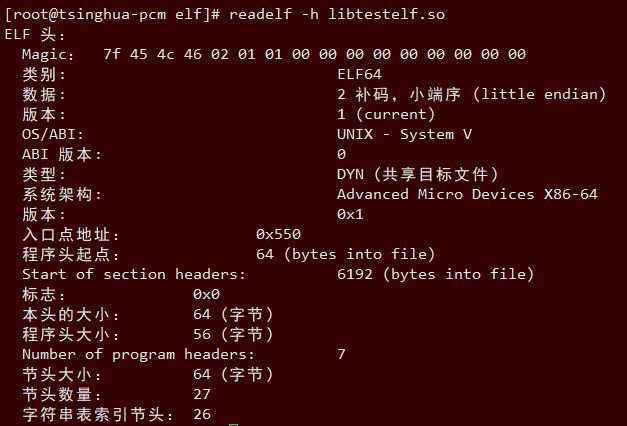

- 16 ELF可执行与链接文件格式详解

- 16.1 布局和结构

- 16.1.1 链接视图

- 16.1.2 执行视图

- 16.2 ELF基本数据类型定义

- 16.3 ELF头部elfxx_hdr

- 16.3.1 ELF魔数e_ident

- 16.3.2 目标文件类型e_type

- 16.3.3 目标体系结构类型e_machine

- 16.3.4 ELF版本e_version

- 16.3.5 readelf -h查看elf头部

- 16.3.5.1 可重定位的对象文件(Relocatable file)

- 16.3.5.2 可执行的对象文件(Executable file)

- 16.3.5.3 可被共享的对象文件(Shared object file)

- 16.4 程序头部elf32_phdr

- 16.4.1 段类型p_type

- 16.4.2 readelf -l查看程序头表

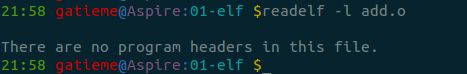

- 16.4.2.1 可重定位的对象文件(Relocatable file)

- 16.4.2.2 可被共享的对象文件(Shared object file)

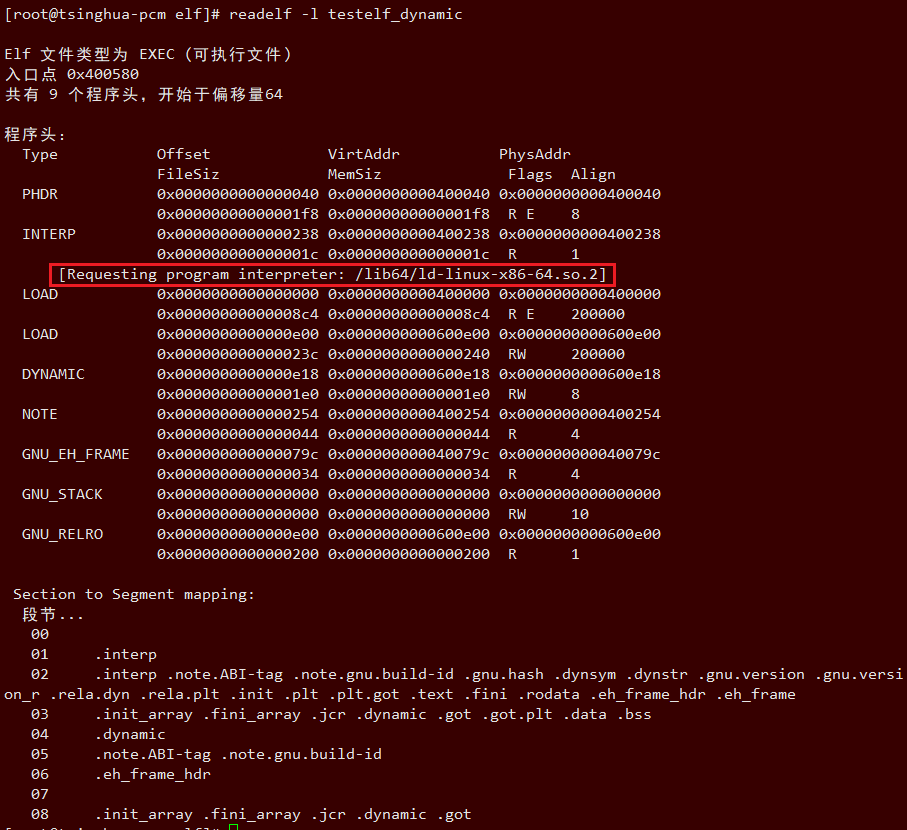

- 16.4.2.3 可执行的对象文件(Executable file)

- 16.5 节区(Sections)

- 16.5.1 节区头部表格

- 16.5.2 特殊节区

- 16.5.3 readelf -S查看节区头表

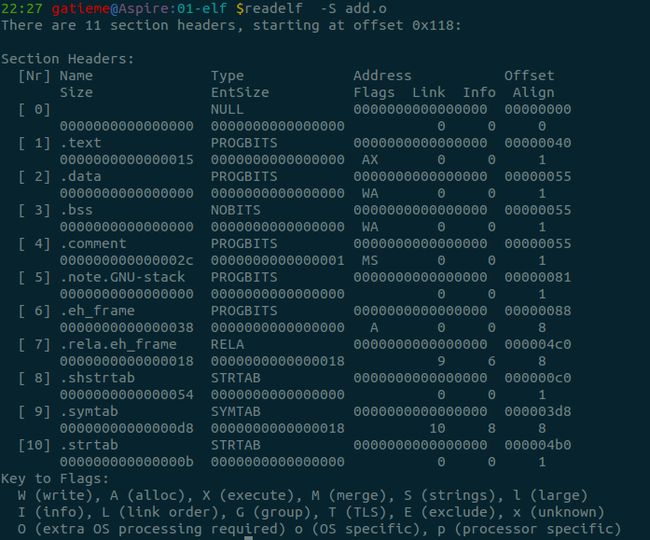

- 16.5.3.1 可重定位的对象文件(Relocatable file)

- 16.5.3.2 可执行的对象文件(Executable file)

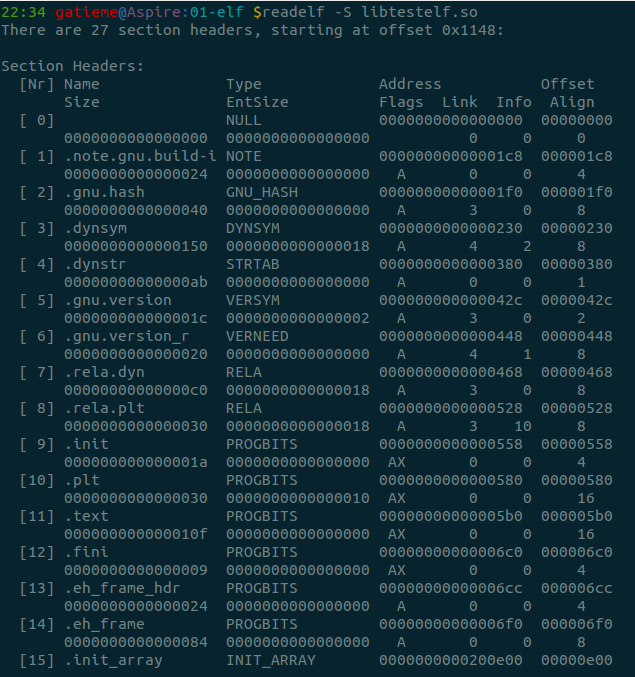

- 16.5.3.3 可被共享的对象文件(Shared object file)

- 16.6 字符串表

- 16.7 符号表(Symbol Table)

- 16.7.1 数据结构elfxx_sym

- 17 加载和动态链接

- 16.1 布局和结构

- 18 elf文件格式的注册

- 19 内核空间的加载过程load_elf_binary

- 19.1 填充并且检查目标程序ELF头部

- 19.2 load_elf_phdrs加载目标程序的程序头表

- 19.3 如果需要动态链接, 则寻找和处理解释器段, 得到解释器映像的elf头部

- 19.4 检查并读取解释器的程序表头

- 19.5 装入目标程序的段segment

- 19.6 填写程序的入口地址

- 19.7 create_elf_tables()填写目标文件的参数环境变量等必要信息

- 19.8 start_thread宏准备进入新的程序入口

- 19.9 小结

- 20 ELF文件中符号的动态解析过程

- 20.1 内核的工作

- 20.2 动态链接器的工作

- 21 Linux进程退出

- 21.1 linux下进程退出的方式

- 21.1.1 正常退出

- 21.1.2 异常退出

- 21.2 _exit, exit和_Exit的区别和联系

- 21.3 进程退出的系统调用

- 21.3.1 _exit和exit_group系统调用

- 21.3.2 系统调用声明

- 21.3.3 系统调用号

- 21.3.4 系统调用实现

- 21.4 do_group_exist流程

- 21.5 do_exit()流程

- 22 调度器和调度策略

- 22.1 进程饥饿

- 23 Linux进程的分类

- 23.1 进程的分类

- 23.2 实时进程与普通进程

- 21.1 linux下进程退出的方式

- 24 linux调度器的演变

- 24.1 O(n)的始调度算法

- 24.2 O(1)调度器

- 24.3 CFS调度器Completely Fair Scheduler

- 24.3.1 楼梯调度算法staircase scheduler(SD)

- 24.3.2 RSDL(Rotating Staircase Deadline Scheduler)

- 24.3.3 完全公平的调度器CFS

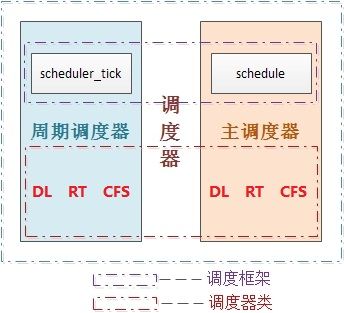

- 25 Linux调度器的组成

- 25.1 2个调度器

- 25.2 6种调度策略

- 25.3 5个调度器类

- 25.4 3个调度实体

- 25.5 调度器类的就绪队列

- 25.6 调度器整体框架

- 25.7 5种调度器类为什么只有3种调度实体?

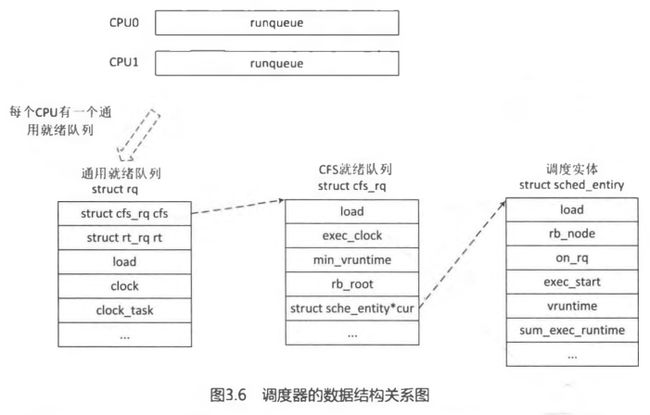

- 26 进程调度的数据结构

- 26.1 task_struct中调度相关的成员

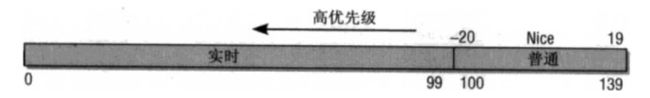

- 26.1.1 优先级

- 26.1.2 调度策略

- 26.1.3 调度策略相关字段

- 26.2 调度类

- 26.3 就绪队列

- 26.3.1 CPU就绪队列struct rq

- 26.3.2 CFS公平调度器的就绪队列cfs_rq

- 26.3.3 实时进程就绪队列rt_rq

- 26.3.4 deadline就绪队列dl_rq

- 26.4 调度实体

- 26.4.1 普通进程调度实体sched_entity

- 26.4.2 实时进程调度实体sched_rt_entity

- 26.4.3 EDF调度实体sched_dl_entity

- 26.5 组调度(struct task_group)

- 26.1 task_struct中调度相关的成员

- 27 进程调度小结

- 28 周期性调度器scheduler_tick

- 28.1 周期性调度器主流程

- 28.2 更新统计量

- 28.3 激活进程所属调度类的周期性调度器

- 29 周期性调度器的激活

- 29.1 定时器周期性的激活调度器

- 29.2 定时器中断实现

- 30 主调度器schedule()

- 30.1 调度函数的__sched前缀

- 30.2 schedule()函数

- 30.2.1 schedule主框架

- 30.2.2 sched_submit_work()避免死锁

- 30.2.3 preempt_disable和sched_preempt_enable_no_resched开关内核抢占

- 30.3 __schedule()开始进程调度

- 30.3.1 __schedule()函数主框架

- 30.3.2 pick_next_task选择抢占的进程

- 30.3.3 context_switch进程上下文切换

- 30.3.3.1 进程上下文切换

- 30.3.3.2 context_switch()流程

- 30.3.3.3 switch_mm切换进程虚拟地址空间

- 30.3.3.4 switch_to切换进程堆栈和寄存器

- 30.3.4 need_resched()判断是否用户抢占

- 31 用户抢占和内核抢占

- 31.1 Linux用户抢占

- 31.1.1 need_resched标识TIF_NEED_RESCHED

- 31.1.2 用户抢占的发生时机(什么时候需要重新调度need_resched)

- 31.2 Linux内核抢占

- 31.2.1 内核抢占的发生时机

- 31.2.2 内核抢占的实现

- 31.2.2.1 内核如何跟踪它能否被抢占?

- 31.2.2.2 内核如何知道是否需要抢占?

- 31.2.2.2.1 重新启用内核抢占时使用preempt_schedule()检查抢占

- 31.2.2.2.2 中断之后返回内核态时通过preempt_schedule_irq()触发

- 31.2.2.2.3 PREEMPT_ACTIVE标识位和PREEMPT_DISABLE_OFFSET

- 31.3 小结

- 31.3.1 用户抢占

- 31.3.2 内核抢占

- 31.1 Linux用户抢占

- 32 Linux优先级

- 32.1 内核的优先级表示

- 32.2 DEF最早截至时间优先实时调度算法的优先级描述

- 32.3 进程优先级的计算

- 32.3.1 normal_prio()设置普通优先级normal_prio

- 32.3.1.1 辅助函数task_has_dl_policy和task_has_rt_policy

- 32.3.1.2 关于rt_priority数值越大, 实时进程优先级越高的问题

- 32.3.1.3 为什么需要__normal_prio函数

- 32.3.2 effective_prio()设置动态优先级prio

- 32.3.2.1 使用优先级数值检测实时进程rt_prio()

- 32.3.3 设置prio的时机

- 32.3.3.1 nice系统调用的实现

- 32.3.3.2 fork时优先级的继承

- 32.3.1 normal_prio()设置普通优先级normal_prio

- 33 Linux睡眠唤醒抢占

- 33.1 Linux进程的睡眠

- 33.2 Linux进程的唤醒

- 33.2.1 wake_up_process()

- 33.2.2 try_to_wake_up()

- 33.2.3 wake_up_new_task()

- 33.2.3.1 check_preempt_curr

- 33.3 无效唤醒

- 33.3.1 无效唤醒的原因

- 33.3.2 避免无效抢占

- 34 stop_sched_class调度器类与stop_machine机制

- 35 dl_sched_class调度器类

- 36 rt_sched_class调度器类

- 37 fair_sched_clas调度器类

- 37.1 CFS调度器类fair_sched_class

- 37.2 cfs的就绪队列

- 37.3 进程优先级

- 37.4 负荷权重

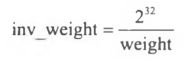

- 37.4.1 调度实体的负荷权重结构struct load_weight

- 37.4.2 进程的负荷权重

- 37.5 优先级和权重的转换

- 37.5.1 优先级->权重转换表

- 37.5.2 set_load_weight()依据静态优先级设置进程的负荷权重

- 37.6 就绪队列的负荷权重

- 37.6.1 就绪队列的负荷权重计算

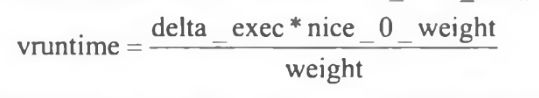

- 37.7 虚拟运行时间

- 37.7.1 虚拟时钟相关的数据结构

- 37.7.1.1 调度实体的虚拟时钟信息

- 37.7.1.2 就绪队列上的虚拟时钟信息

- 37.7.2 update_curr()函数计算进程虚拟时间

- 37.7.2.1 计算时间差

- 37.7.2.2 模拟虚拟时钟

- 37.7.2.3 重新设置cfs_rq->min_vruntime

- 37.7.1 虚拟时钟相关的数据结构

- 37.8 红黑树的键值entity_key和entity_before

- 37.x 进程调度相关的初始化sched_fork()

- 38 idle_sched_class调度器类

1 进程描述符struct task_struct

1.1 进程状态

struct task_struct{

volatile long state; /* -1 unrunnable, 0 runnable, >0 stopped */

}可能取值是

[include/linux/sched.h]

#define TASK_RUNNING 0

#define TASK_INTERRUPTIBLE 1

#define TASK_UNINTERRUPTIBLE 2

#define __TASK_STOPPED 4

#define __TASK_TRACED 8

/* in tsk->exit_state */

#define EXIT_DEAD 16

#define EXIT_ZOMBIE 32

#define EXIT_TRACE (EXIT_ZOMBIE | EXIT_DEAD)

/* in tsk->state again */

#define TASK_DEAD 64

#define TASK_WAKEKILL 128 /** wake on signals that are deadly **/

#define TASK_WAKING 256

#define TASK_PARKED 512

#define TASK_NOLOAD 1024

#define TASK_STATE_MAX 2048

/* Convenience macros for the sake of set_task_state */

#define TASK_KILLABLE (TASK_WAKEKILL | TASK_UNINTERRUPTIBLE)

#define TASK_STOPPED (TASK_WAKEKILL | __TASK_STOPPED)

#define TASK_TRACED (TASK_WAKEKILL | __TASK_TRACED)1.1.1 5个互斥状态

| 状态 | 描述 |

|---|---|

| TASK_RUNNING | 表示进程要么正在执行,要么正要准备执行(已经就绪),正在等待cpu时间片的调度 |

| TASK_INTERRUPTIBLE | 阻塞态.进程因为等待一些条件而被挂起(阻塞)而所处的状态。这些条件主要包括:硬中断、资源、一些信号……,一旦等待的条件成立,进程就会从该状态(阻塞)迅速转化成为就绪状态TASK_RUNNING |

| TASK_UNINTERRUPTIBLE | 意义与TASK_INTERRUPTIBLE类似,除了不能通过接受一个信号来唤醒以外,对于处于TASK_UNINTERRUPIBLE状态的进程,哪怕我们传递一个信号或者有一个外部中断都不能唤醒他们。只有它所等待的资源可用的时候,他才会被唤醒。这个标志很少用,但是并不代表没有任何用处,其实他的作用非常大,特别是对于驱动刺探相关的硬件过程很重要,这个刺探过程不能被一些其他的东西给中断,否则就会让进城进入不可预测的状态 |

| TASK_STOPPED | 进程被停止执行,当进程接收到SIGSTOP、SIGTTIN、SIGTSTP或者SIGTTOU信号之后就会进入该状态 |

| TASK_TRACED | 表示进程被debugger等进程监视,进程执行被调试程序所停止,当一个进程被另外的进程所监视,每一个信号都会让进城进入该状态 |

1.1.2 2个终止状态

有两个附加的进程状态既可以被添加到state域中,又可以被添加到exit_state域中.

只有当进程终止的时候,才会达到这两种状态.

struct task_struct{

int exit_state;

int exit_code, exit_signal;

}| 状态 | 描述 |

|---|---|

| EXIT_ZOMBIE | 进程的执行被终止,但是其父进程还没有使用wait()等系统调用来获知它的终止信息,此时进程成为僵尸进程 |

| EXIT_DEAD | 进程的最终状态 |

1.1.3 睡眠状态

1.1.3.1 内核将进程置为睡眠状态的方法

两种方法.

普通方法是将进程状态置为TASK_INTERRUPTIBLE或TASK_UNINTERRUPTIBLE, 然后调用调度程序的schedule()函数。这样会将进程从CPU运行队列中移除。

- TASK_INTERRUPTIBLE: 可中断模式的睡眠状态, 可通过显式的唤醒呼叫(wakeup_process())或者需要处理的信号来唤醒

- TASK_UNINTERRUPTIBLE: 不可中断模式的睡眠状态, 只能通过显式的唤醒呼叫, 一般不建议设置

新方法是使用新的进程睡眠状态TASK_KILLABLE

TASK_KILLABLE: 可以终止的新睡眠状态, 原理类似于TASK_UNINTERRUPTIBLE,只不过可以响应致命信号

1.1.4 状态切换

进程状态的切换过程和原因大致如下图

1.2 进程标识符(PID)

typedef int __kernel_pid_t;

typedef __kernel_pid_t pid_t;

struct task_struct{

pid_t pid;

pid_t tgid;

}pid来标识进程,一个线程组所有线程与领头线程具有相同的pid,存入tgid字段,只有线程组的领头线程的pid成员才会被设置为与tgid相同的值。

注意, getpid()返回当前进程的tgid值而不是pid的值(!!!)。

在CONFIG_BASE_SMALL配置为0的情况下,PID的取值范围是0到32767,即系统中的进程数最大为32768个。

#define PID_MAX_DEFAULT (CONFIG_BASE_SMALL ? 0x1000 : 0x8000) 1.3 进程内核栈与thread_info结构

1.3.1 为什么需要内核栈

struct task_struct{

// 指向内核栈的指针

void *stack;

}进程在内核态运行时需要自己的堆栈信息,因此linux内核为每个进程(!!!每一个!!!)都提供了一个内核栈kernel stack(这里的stack就是这个进程在内核态的堆栈信息!!!)

内核态的进程访问处于内核数据段的栈,这个栈不同于用户态的进程所用的栈。

用户态进程所用的栈,是在进程线性地址空间中;

而内核栈是当进程从用户空间进入内核空间时,特权级发生变化,需要切换堆栈,那么内核空间中使用的就是这个内核栈。因为内核控制路径使用很少的栈空间,所以只需要几千个字节的内核态堆栈。

需要注意的是,内核态堆栈仅用于内核例程,Linux内核另外为中断提供了单独的硬中断栈和软中断栈

1.3.2 为什么需要thread_info

内核还需要存储每个进程的PCB信息,linux内核是支持不同体系的,但是不同的体系结构可能进程需要存储的信息不尽相同,这就需要我们实现一种通用的方式,我们将体系结构相关的部分和无关的部分进行分离

用一种通用的方式来描述进程, 这就是struct task_struct, 而thread_info就保存了特定体系结构的汇编代码段需要访问的那部分进程的数据, 我们在thread_info中嵌入指向task_struct的指针, 则我们可以很方便的通过thread_info来查找task_struct

1.3.3 内核栈和线程描述符

对每个进程,Linux内核都把两个不同的数据结构紧凑的存放在一个单独为进程分配的内存区域中

-

一个是内核态的进程堆栈,

-

另一个是紧挨着进程描述符的小数据结构thread_info,叫做线程描述符。

Linux将这两个存放在一块, 这块区域通常是8192 Byte(两个页框), 其地址必须是8192的整数倍.

[arch/x86/include/asm/page_32_types.h]

#define THREAD_SIZE_ORDER 1

// 2个页大小

#define THREAD_SIZE (PAGE_SIZE << THREAD_SIZE_ORDER)[arch/x86/include/asm/page_64_types.h]

#ifdef CONFIG_KASAN

#define KASAN_STACK_ORDER 1

#else

#define KASAN_STACK_ORDER 0

#endif

#define THREAD_SIZE_ORDER (2 + KASAN_STACK_ORDER)

// 4个页或8个页大小

#define THREAD_SIZE (PAGE_SIZE << THREAD_SIZE_ORDER)下图中显示了在物理内存中存放两种数据结构的方式。线程描述符驻留与这个内存区的开始,而栈顶末端向下增长。

sp寄存器是CPU栈指针,用来存放栈顶单元的地址。在80x86系统中,栈起始于顶端,并朝着这个内存区开始的方向增长。从用户态刚切换到内核态以后,进程的内核栈总是空的。因此,esp寄存器指向这个栈的顶端。一旦数据写入堆栈,esp的值就递减。

进程描述符task_struct结构中没有直接指向thread_info结构的指针,而是用一个void指针类型的成员表示,然后通过类型转换来访问thread_info结构。

#define task_thread_info(task) ((struct thread_info *)(task)->stack)1.3.4 内核栈数据结构描述thread_info和thread_union

thread_info是体系结构相关的,结构的定义在thread_info.h, 不同体系结构不同文件.

[arch/x86/include/asm/thread_info.h]

struct thread_info {

struct task_struct *task; /* main task structure */

__u32 flags; /* low level flags */

__u32 status; /* thread synchronous flags */

__u32 cpu; /* current CPU */

mm_segment_t addr_limit;

unsigned int sig_on_uaccess_error:1;

unsigned int uaccess_err:1; /* uaccess failed */

};Linux内核中使用一个联合体来表示一个进程的线程描述符和内核栈:

[include/linux/sched.h]

union thread_union

{

struct thread_info thread_info;

unsigned long stack[THREAD_SIZE/sizeof(long)];

};1.3.5 获取当前在CPU上正在运行进程的thread_info

static inline unsigned long current_top_of_stack(void)

{

#ifdef CONFIG_X86_64

// 内核栈(0)栈顶寄存器SP0

return this_cpu_read_stable(cpu_tss.x86_tss.sp0);

#else

/* sp0 on x86_32 is special in and around vm86 mode. */

return this_cpu_read_stable(cpu_current_top_of_stack);

#endif

}

static inline struct thread_info *current_thread_info(void)

{

return (struct thread_info *)(current_top_of_stack() - THREAD_SIZE);

}为了获取当前CPU上运行进程的task_struct结构,内核提供了current宏,由于task_struct *task在thread_info的起始位置,该宏本质上等价于current_thread_info()->task

[include/asm-generic/current.h]

#define get_current() (current_thread_info()->task)

#define current get_current()1.3.6 分配和销毁thread_info

进程通过alloc_thread_info_node()函数分配它的内核栈,通过free_thread_info()函数释放所分配的内核栈。

1.4 进程标记

struct task_struct{

unsigned int flags;

}反应进程状态的信息,但不是运行状态,用于内核识别进程当前的状态

取值以PF(ProcessFlag)开头的宏, 定义在include/linux/sched.h

1.5 表示进程亲属关系的成员

struct task_struct{

struct task_struct __rcu *real_parent; /* real parent process */

struct task_struct __rcu *parent; /* recipient of SIGCHLD, wait4() reports */

struct list_head children; /* list of my children */

struct list_head sibling; /* linkage in my parent's children list */

struct task_struct *group_leader; /* threadgroup leader */

}| 字段 | 描述 |

|---|---|

| real_parent | 指向其父进程,如果创建它的父进程不再存在,则指向PID为1的init进程 |

| parent | 指向其父进程,当它终止时,必须向它的父进程发送信号。它的值通常与real_parent相同 |

| children | 表示链表的头部,链表中的所有元素都是它的子进程 |

| sibling | 用于把当前进程插入到兄弟链表中 |

| group_leader | 指向其所在进程组的领头进程 |

1.6 ptrace系统调用

ptrace提供了一种父进程可以控制子进程运行,并可以检查和改变它的核心image。

主要用于实现断点调试。一个被跟踪的进程运行中,直到发生一个信号,则进程被中止,并且通知其父进程。在进程中止的状态下,进程的内存空间可以被读写。父进程还可以使子进程继续执行,并选择是否是否忽略引起中止的信号。

struct task_struct{

unsigned int ptrace;

struct list_head ptraced;

struct list_head ptrace_entry;

unsigned long ptrace_message;

siginfo_t *last_siginfo;

}成员ptrace被设置为0时表示不需要被跟踪, 取值定义在文件include/linux/ptrace.h, 以PT开头

1.7 Performance Event

性能诊断工具.分析进程的性能问题.

struct task_struct{

#ifdef CONFIG_PERF_EVENTS

struct perf_event_context *perf_event_ctxp[perf_nr_task_contexts];

struct mutex perf_event_mutex;

struct list_head perf_event_list;

#endif

}1.8 进程调度

1.8.1 优先级

struct task_struct{

int prio, static_prio, normal_prio;

unsigned int rt_priority;| 字段 | 描述 |

|---|---|

| static_prio | 用于保存静态优先级,可以通过nice系统调用来进行修改 |

| rt_priority | 用于保存实时优先级 |

| normal_prio | 值取决于静态优先级和调度策略 |

| prio | 用于保存动态优先级 |

实时优先级范围是0到MAX_RT_PRIO-1(即99),而普通进程的静态优先级范围是从MAX_RT_PRIO到MAX_PRIO-1(即100到139)。值越大静态优先级越低。

1.8.2 调度策略相关字段

struct task_struct{

unsigned int policy;

const struct sched_class *sched_class;

struct sched_entity se;

struct sched_rt_entity rt;

cpumask_t cpus_allowed;

}| 字段 | 描述 |

|---|---|

| policy | 调度策略 |

| sched_class | 调度类 |

| se | 普通进程的调度实体,每个进程都有其中之一的实体 |

| rt | 实时进程的调度实体,每个进程都有其中之一的实体 |

| cpus_allowed | 用于控制进程可以在哪些处理器上运行 |

1.9 进程地址空间

struct task_struct{

struct mm_struct *mm, *active_mm;

/* per-thread vma caching */

u32 vmacache_seqnum;

struct vm_area_struct *vmacache[VMACACHE_SIZE];

#if defined(SPLIT_RSS_COUNTING)

struct task_rss_stat rss_stat;

#endif

#ifdef CONFIG_COMPAT_BRK

unsigned brk_randomized:1;

#endif

}| 字段 | 描述 |

|---|---|

| mm | 进程所拥有的用户空间内存描述符(拥有的!!!),内核线程无,mm为NULL |

| active_mm | active_mm指向进程运行时所使用的内存描述符(使用的!!!内核线程不拥有用户空间内存,但是必须有使用的空间),对于普通进程而言,这两个指针变量的值相同。但是内核线程kernel thread是没有进程地址空间的,所以内核线程的tsk->mm域是空(NULL)。但是内核必须知道用户空间包含了什么,因此它的active_mm成员被初始化为前一个运行进程的mm值。 |

| brk_randomized | 用来确定对随机堆内存的探测。参见LKML上的介绍 |

| rss_stat | 用来记录缓冲信息 |

如果当前内核线程被调度之前运行的也是另外一个内核线程时候,那么其mm和avtive_mm都是NULL

对Linux来说,用户进程和内核线程(kernel thread)都是task_struct的实例,唯一的区别是kernel thread是没有进程地址空间的,内核线程也没有mm描述符的,所以内核线程的tsk->mm域是空(NULL)。

内核scheduler在进程context switching的时候,会根据tsk->mm判断即将调度的进程是用户进程还是内核线程。

但是虽然thread thread不用访问用户进程地址空间,但是仍然需要page table来访问kernel自己的空间。但是幸运的是,对于任何用户进程来说,他们的内核空间都是100%相同的,所以内核可以’borrow'上一个被调用的用户进程的mm中的页表来访问内核地址,这个mm就记录在active_mm。

简而言之就是,对于kernel thread,tsk->mm == NULL表示自己内核线程的身份,而tsk->active_mm是借用上一个用户进程的mm,用mm的page table来访问内核空间。对于用户进程,tsk->mm == tsk->active_mm。

1.10 判断标志

struct task_struct{

int exit_code, exit_signal;

int pdeath_signal; /* The signal sent when the parent dies */

unsigned long jobctl; /* JOBCTL_*, siglock protected */

/* Used for emulating ABI behavior of previous Linux versions */

unsigned int personality;

/* scheduler bits, serialized by scheduler locks */

unsigned sched_reset_on_fork:1;

unsigned sched_contributes_to_load:1;

unsigned sched_migrated:1;

unsigned :0; /* force alignment to the next boundary */

/* unserialized, strictly 'current' */

unsigned in_execve:1; /* bit to tell LSMs we're in execve */

unsigned in_iowait:1;

}| 字段 | 描述 |

|---|---|

| exit_code | 用于设置进程的终止代号,这个值要么是_exit()或exit_group()系统调用参数(正常终止),要么是由内核提供的一个错误代号(异常终止)。 |

| exit_signal | 被置为-1时表示是某个线程组中的一员。只有当线程组的最后一个成员终止时,才会产生一个信号,以通知线程组的领头进程的父进程。 |

| pdeath_signal | 用于判断父进程终止时发送信号。 |

| personality | 用于处理不同的ABI |

| in_execve | 用于通知LSM是否被do_execve()函数所调用 |

| in_iowait | 用于判断是否进行iowait计数 |

| sched_reset_on_fork | 用于判断是否恢复默认的优先级或调度策略 |

1.11 时间

| 字段 | 描述 |

|---|---|

| utime/stime | 用于记录进程在用户态/内核态下所经过的节拍数(定时器) |

| prev_utime/prev_stime | 先前的运行时间 |

| utimescaled/stimescaled | 用于记录进程在用户态/内核态的运行时间,但它们以处理器的频率为刻度 |

| gtime | 以节拍计数的虚拟机运行时间(guest time) |

| nvcsw/nivcsw | 是自愿(voluntary)/非自愿(involuntary)上下文切换计数 |

| last_switch_count | nvcsw和nivcsw的总和 |

| start_time/real_start_time | 进程创建时间,real_start_time还包含了进程睡眠时间,常用于/proc/pid/stat |

| cputime_expires | 用来统计进程或进程组被跟踪的处理器时间,其中的三个成员对应着cpu_timers[3]的三个链表 |

1.12 信号处理

struct task_struct{

struct signal_struct *signal;

struct sighand_struct *sighand;

sigset_t blocked, real_blocked;

sigset_t saved_sigmask; /* restored if set_restore_sigmask() was used */

struct sigpending pending;

unsigned long sas_ss_sp;

size_t sas_ss_size;

}| 字段 | 描述 |

|---|---|

| signal | 指向进程的信号描述符 |

| sighand | 指向进程的信号处理程序描述符 |

| blocked | 表示被阻塞信号的掩码,real_blocked表示临时掩码 |

| pending | 存放私有挂起信号的数据结构 |

| sas_ss_sp | 是信号处理程序备用堆栈的地址,sas_ss_size表示堆栈的大小 |

1.13 其他

2 命名空间

Linux Namespaces机制提供一种资源隔离方案。

命名空间是为操作系统层面的虚拟化机制提供支撑,目前实现的有六种不同的命名空间,分别为mount命名空间、UTS命名空间、IPC命名空间、用户命名空间、PID命名空间、网络命名空间。命名空间简单来说提供的是对全局资源的一种抽象,将资源放到不同的容器中(不同的命名空间),各容器彼此隔离。

命名空间有的还有层次关系,如PID命名空间

要创建新的Namespace,只需要在调用clone时指定相应的flag。

LXC(Linux containers)就是利用这一特性实现了资源的隔离。

虽然子容器不了解系统中的其他容器,但父容器知道子命名空间的存在,也可以看到其中执行的所有进程。子容器的进程映射到父容器中,PID为4到9。尽管系统上有9个进程,但却需要15个PID来表示,因为一个进程可以关联到多个PID。

2.1 Linux内核命名空间描述

在Linux内核中提供了多个namespace!!!,一个进程可以属于多个namesapce.

在task_struct 结构中有一个指向namespace结构体的指针nsproxy。

struct task_struct

{

/* namespaces */

struct nsproxy *nsproxy;

}

struct nsproxy

{

atomic_t count;

struct uts_namespace *uts_ns;

struct ipc_namespace *ipc_ns;

struct mnt_namespace *mnt_ns;

struct pid_namespace *pid_ns_for_children;

struct net *net_ns;

};struct nsproxy定义了5个指向各个类型namespace的指针, 由于多个进程可以使用同一个namespace,所以nsproxy可以共享使用,count字段是该结构的引用计数。

-

UTS命名空间包含了运行内核的名称、版本、底层体系结构类型等信息。UTS是UNIX Timesharing System的简称。

-

保存在struct ipc_namespace中的所有与进程间通信(IPC)有关的信息。

-

已经装载的文件系统的视图,在struct mnt_namespace中给出。

-

有关进程ID的信息,由struct pid_namespace提供。

-

struct net包含所有网络相关的命名空间参数。

系统中有一个默认的nsproxy,init_nsproxy,该结构在task初始化是也会被初始化,定义在include/linux/init_task.h

#define INIT_TASK(tsk) \

{

.nsproxy = &init_nsproxy,

}其中init_nsproxy的定义为:

struct nsproxy init_nsproxy = {

.count = ATOMIC_INIT(1),

.uts_ns = &init_uts_ns,

#if defined(CONFIG_POSIX_MQUEUE) || defined(CONFIG_SYSVIPC)

.ipc_ns = &init_ipc_ns,

#endif

.mnt_ns = NULL,

.pid_ns_for_children = &init_pid_ns,

#ifdef CONFIG_NET

.net_ns = &init_net,

#endif

};

对于.mnt_ns没有进行初始化,其余的namespace都进行了系统默认初始化

2.2 命名空间的创建

新的命名空间可以用下面两种方法创建。

-

在用fork或clone系统调用创建新进程时,有特定的选项可以控制是与父进程共享命名空间,还是建立新的命名空间。

-

unshare系统调用将进程的某些部分从父进程分离,其中也包括命名空间。

命名空间的实现需要两个部分:

-

每个子系统的命名空间结构,将此前所有的全局组件包装到命名空间中;

-

将给定进程关联到所属各个命名空间的机制。

使用fork或clone系统调用创建新进程可使用的选项:

-

CLONE_NEWPID 进程命名空间。空间内的PID是独立分配的,意思就是命名空间内的虚拟PID可能会与命名空间外的PID相冲突,于是命名空间内的PID映射到命名空间外时会使用另外一个PID。比如说,命名空间内第一个PID为1,而在命名空间外就是该PID已被init进程所使用。

-

CLONE_NEWIPC 进程间通信(IPC)的命名空间,可以将SystemV的IPC和POSIX的消息队列独立出来。

-

CLONE_NEWNET 网络命名空间,用于隔离网络资源(/proc/net、IP地址、网卡、路由等)。后台进程可以运行在不同命名空间内的相同端口上,用户还可以虚拟出一块网卡。

-

CLONE_NEWNS 挂载命名空间,进程运行时可以将挂载点与系统分离,使用这个功能时,我们可以达到 chroot 的功能,而在安全性方面比 chroot 更高。

-

CLONE_NEWUTS UTS命名空间,主要目的是独立出主机名和网络信息服务(NIS)。

-

CLONE_NEWUSER 用户命名空间,同进程ID一样,用户ID和组ID在命名空间内外是不一样的,并且在不同命名空间内可以存在相同的ID。

2.3 PID Namespace

CLONE_NEWPID, 会创建一个新的PID Namespace,clone出来的新进程将成为Namespace里的第一个进程,PID Namespace内的PID将从1开始, 类似于独立系统中的init进程, 该Namespace内的孤儿进程都将以该进程为父进程,当该进程被结束时,该Namespace内所有的进程都会被结束。

PID Namespace是层次性,新创建的Namespace将会是创建该Namespace的进程属于的Namespace的子Namespace。子Namespace中的进程对于父Namespace是可见的,一个进程将拥有不止一个PID,而是在所在的Namespace以及所有直系祖先Namespace中都将有一个PID(直系祖先!!!)。

系统启动时,内核将创建一个默认的PID Namespace,该Namespace是所有以后创建的Namespace的祖先,因此系统所有的进程在该Namespace都是可见的。

3 进程ID类型

[include/linux/pid.h]

enum pid_type

{

PIDTYPE_PID,

PIDTYPE_PGID,

PIDTYPE_SID,

PIDTYPE_MAX

};- PID, 其命名空间中唯一标识进程

- TGID, 线程组(轻量级进程组)的ID标识

在一个进程中,如果以CLONE_THREAD标志来调用clone建立的进程就是该进程的一个线程(即轻量级进程,Linux其实没有严格的线程概念),它们处于一个线程组, 所有进程都有相同的TGID, pid不同.

线程组组长(也叫主线程)的TGID与其PID相同;一个进程没有使用线程,则其TGID与PID也相同。

该枚举没有包括线程组ID, 因为task_struct已经线程组ID

struct task_struct

{

pid_t pid;

pid_t tgid;

}- PGID, 进程组的ID标识

独立的进程可以组成进程组(使用setpgrp系统调用),进程组可以简化向所有组内进程发送信号的操作

- SID, 会话组的ID标识

几个进程组可以合并成一个会话组(使用setsid系统调用), SID保存在task_struct的session成员中

4 PID命名空间

4.1 pid命名空间概述

PID命名空间有层次关系

上图有四个命名空间,一个父命名空间衍生了两个子命名空间,其中的一个子命名空间又衍生了一个子命名空间。以PID命名空间为例,由于各个命名空间彼此隔离,所以每个命名空间都可以有 PID 号为 1 的进程;但又由于命名空间的层次性,父命名空间是知道子命名空间的存在,因此子命名空间要映射到父命名空间中去,因此上图中 level 1 中两个子命名空间的六个进程分别映射到其父命名空间的PID号5~10。

level 2的PID是1的进程在level 1和level 0都有映射

4.2 局部ID和全局ID

全局ID: 在内核本身和初始命名空间中唯一的ID(初始命名空间中!!!), 系统启动期间开始的init进程即属于该初始命名空间。

局部ID: 属于某个特定的命名空间

4.2.1 全局ID

- 全局PID和全局TGID直接保存在task_struct中,分别是task_struct的pid和tgid成员:

struct task_struct

{

pid_t pid;

pid_t tgid;

} 两项都是pid_t类型,该类型定义为__kernel_pid_t,后者由各个体系结构分别定义。通常定义为int,即可以同时使用232个不同的ID。

-

task_struct->signal->__session表示全局SID, set_task_session用于修改

-

全局PGID则保存在task_struct->signal->__pgrp, set_task_pgrp用于修改

4.2.2 局部ID

4.3 PID命名空间数据结构pid_namespace

struct pid_namespace

{

struct kref kref;

struct pidmap pidmap[PIDMAP_ENTRIES];

int last_pid;

struct task_struct *child_reaper;

struct kmem_cache *pid_cachep;

unsigned int level;

struct pid_namespace *parent;

}; | 字段 | 描述 |

|---|---|

| kref | 表示指向pid_namespace的个数 |

| pidmap | pidmap结构体表示分配pid的位图。当需要分配一个新的pid时只需查找位图,找到bit为0的位置并置1,然后更新统计数据域(nr_free) |

| last_pid | 用于pidmap的分配。指向最后一个分配的pid的位置。 |

| child_reaper | 指向的是当前命名空间的init进程,每个命名空间都有一个作用相当于全局init进程的进程 |

| pid_cachep | 域指向分配pid的slab的地址。 |

| level | 代表当前命名空间的等级,初始命名空间的level为0,它的子命名空间level为1,依次递增,而且子命名空间对父命名空间是可见的。从给定的level设置,内核即可推断进程会关联到多少个ID。 |

| parent | 指向父命名空间的指针 |

PID分配器也需要依靠该结构的某些部分来连续生成唯一ID

每个PID命名空间都具有一个进程,其发挥的作用相当于全局的init进程。init的一个目的是对孤儿进程调用wait4,命名空间局部的init变体也必须完成该工作。

5 pid结构描述

5.1 pid与upid

PID的管理围绕两个数据结构展开:

-

struct pid是内核对PID的内部表示

-

struct upid则表示特定的命名空间中可见的信息

5.1.1 特定命名空间信息struct upid

[include/linux/pid.h]

struct upid

{

int nr;

struct pid_namespace *ns;

struct hlist_node pid_chain;

}; struct upid是一个特定namespace里面的进程的信息,包含该namespace里面进程具体ID号,namespace指针,哈希列表指针.

| 字段 | 描述 |

|---|---|

| nr | 表示在该命名空间所分配的进程ID具体的值 |

| ns | 指向命名空间的指针 |

| pid_chain | 指向PID哈希列表的指针,用于关联对应的PID |

所有的upid实例都保存在一个散列表中

5.1.2 局部ID类struct pid

[include/linux/pid.h]

struct pid

{

atomic_t count;

/* 使用该pid的进程的列表 */

struct hlist_head tasks[PIDTYPE_MAX];

int level;

struct upid numbers[1];

};srtuct pid是局部ID类,对应一个

| 字段 | 描述 |

|---|---|

| count | 是指使用该PID的task的数目; |

| level | 表示可以看到该PID的命名空间的数目,也就是包含该进程的命名空间的深度 |

| tasks[PIDTYPE_MAX] | 是一个数组,每个数组项都是一个散列表头,分别对应以下三种类型 |

| numbers[1] | 一个upid的实例数组,每个数组项代表一个命名空间,用来表示一个PID可以属于不同的命名空间,该元素放在末尾,可以向数组添加附加的项。 |

tasks是一个数组,每个数组项都是一个散列表头,对应于一个ID类型, PIDTYPE_PID,PIDTYPE_PGID,PIDTYPE_SID(PIDTYPE_MAX表示ID类型的数目)这样做是必要的,因为一个ID可能用于几个进程(task_struct)!!!。所有共享同一ID的task_struct实例,都通过该列表连接起来(这个列表就是使用这个pid的进程

5.2 用于分配pid的位图struct pidmap

需要分配一个新的pid时查找可使用pid的位图

struct pidmap

{

atomic_t nr_free;

void *page;

};| 字段 | 描述 |

|---|---|

| nr_free | 表示还能分配的pid的数量 |

| page | 指向的是存放pid的物理页 |

pidmap[PIDMAP_ENTRIES]域表示该pid_namespace下pid已分配情况

5.3 pid的哈希表存储结构struct pid_link

pid_link是pid的哈希表存储结构

task_struct中的struct pid_link pids[PIDTYPE_MAX]指向了和该task_struct相关的pid结构体。

struct pid_link

{

struct hlist_node node;

struct pid *pid;

};5.4 task_struct中的进程ID相关描述符信息

enum pid_type

{

PIDTYPE_PID,

PIDTYPE_PGID,

PIDTYPE_SID,

PIDTYPE_MAX

};

struct task_struct

{

pid_t pid;

pid_t tgid;

struct task_struct *group_leader;

struct pid_link pids[PIDTYPE_MAX];

struct list_head thread_group;

struct list_head thread_node;

struct nsproxy *nsproxy;

};

struct pid_link

{

struct hlist_node node;

struct pid *pid;

};

struct pid

{

unsigned int level;

/* 使用该pid的进程的列表, lists of tasks that use this pid */

struct hlist_head tasks[PIDTYPE_MAX];

struct upid numbers[1];

};

struct upid

{

int nr;

struct pid_namespace *ns;

struct hlist_node pid_chain;

};task_struct结构信息

| 字段 | 描述 |

|---|---|

| pid | 指该进程的进程描述符。在fork函数中对其进行赋值的 |

| tgid | 指该进程的线程描述符。在linux内核中对线程并没有做特殊的处理,还是由task_struct来管理。所以从内核的角度看, 用户态的线程本质上还是一个进程。对于同一个进程(用户态角度)中不同的线程其tgid是相同的,但是pid各不相同。 主线程即group_leader(主线程会创建其他所有的子线程)。如果是单线程进程(用户态角度),它的pid等于tgid。 |

| group_leader | 除了在多线程的模式下指向主线程!!!,还有一个用处,当一些进程组成一个群组时(PIDTYPE_PGID), 该域指向该进程群组!!!的leader |

| pids | pids[0]是PIDTYPE_PID类型的,指向自己的PID结构, 其余指向了相应群组的leader的PID结构,也就是组长的PID结构 |

| nsproxy | 指针指向namespace相关的域,通过nsproxy域可以知道该task_struct属于哪个pid_namespace |

对于用户态程序来说,调用getpid()函数其实返回的是tgid,因此线程组中的进程id应该是是一致的,但是他们pid不一致,这也是内核区分他们的标识

-

多个task_struct可以共用一个PID

-

一个PID可以属于不同的命名空间

-

当需要分配一个新的pid时候,只需要查找pidmap位图即可

那么最终,linux下进程命名空间和进程的关系结构如下:

可以看到,多个task_struct指向一个PID,同时PID的hash数组里安装不同的类型对task进行散列,并且一个PID会属于多个命名空间。

-

进程的结构体是task_struct, 一个进程对应一个task_struct结构体(一对一). 一个进程会有PIDTYPE_MAX个(3个)pid_link结构体(一对多), 这三个结构体中的pid分别指向 ①该进程对应的进程本身(PIDTYPE_PID)的真实的pid结构体; ②该进程的进程组(PIDTYPE_PGID)的组长本身的pid结构体; ③该进程的会话组(PIDTYPE_SID)的组长本身的pid结构体. 所以一个真实的进程只会有一个自身真实的pid结构体; thread_group指向的是该线程所在线程组的链表头; thread_node是线程组中的结点.

-

这三个pid_link结构体里面有个哈希节点node, 因为进程组、会话组等的存在, 这个node用来链接同一个组的进程task_struct, 指向的是task_struct中的pid_link的node

-

pid结构体(不是一个ID号)代表一个真实的进程(某个组的组长的pid也是这个结构体, 因为组长也是真实的进程, 也就有相应的真实的pid结构体, 而组长身份是通过task_struct引的), 所以里面会有 ①该进程真实所处命名空间的level; ②PIDTYPE_MAX个(3个)散列表头, tasks[PIDTYPE_PID]指向自身进程(因为PIDTYPE_PID是PID类型), 如果该进程是进程组组长, 那么tasks[PIDTYPE_PGID]就是这个散列表的表头, 指向下一个进程的相应组变量pids[PIDTYPE_PGID]的node, 如果该进程是会话组组长, 那么tasks[PIDTYPE_SID]就是这个散列表的表头, 指向下一个进程的相应组变量pids[PIDTYPE_SID]的node; ③由于一个进程可能会呈现在多个pid命名空间, 所以有该进程在其他命名空间中的信息结构体upid的数组, 每个数组项代表一个

-

结构体upid的数组number[1], 数组项个数取决于该进程pid的level值, 每个数组项代表一个命名空间, 这个就是用来一个PID可以属于不同的命名空间, nr值表示该进程在该命名空间的pid值, ns指向该信息所在的命名空间, pid_chain属于哈希表的节点. 系统有一个pid_hash[], 通过pid在某个命名空间的nr值哈希到某个表项, 如果多个nr值哈希到同一个表项, 将其加入链表, 这个节点就是upid的pid_chain

遍历线程所在线程组的所有线程函数while_each_thread(p, t)使用了:

static inline struct task_struct *next_thread(const struct task_struct *p)

{

return list_entry_rcu(p->thread_group.next,

struct task_struct, thread_group);

}

#define while_each_thread(g, t) \

while ((t = next_thread(t)) != g)扫描同一个进程组的可以, 扫描与current->pids[PIDTYPE_PGID](这是进程组组长pid结构体)对应的PIDTYPE_PGID类型的散列表(因为是进程组组长,所以其真实的pid结构体中tasks[PIDTYPE_PGID]是这个散列表的表头)中的每个PID链表

图中关于如何分配唯一的PID没有画出

5.5 进程ID管理函数

5.5.1 进程pid号找到struct pid实体

首先就需要通过进程的pid找到进程的struct pid,然后再通过struct pid找到进程的task_struct

实现函数有三个

//通过pid值找到进程的struct pid实体

struct pid *find_pid_ns(int nr, struct pid_namespace *ns)

struct pid *find_vpid(int nr)

struct pid *find_get_pid(pid_t nr)find_pid_ns获得pid实体的实现原理,主要使用哈希查找。

内核使用哈希表组织struct pid,每创建一个新进程,给进程的struct pid都会插入到哈希表中,这时候就需要使用进程的进程pid和pid命名空间ns在哈希表中将相对应的struct pid索引出来

根据局部PID以及命名空间计算在pid_hash数组中的索引,然后遍历散列表找到所要的upid,再根据内核的 container_of 机制找到 pid 实例。

struct pid *find_pid_ns(int nr, struct pid_namespace *ns)

{

struct hlist_node *elem;

struct upid *pnr;

//遍历散列表

hlist_for_each_entry_rcu(pnr, elem,

&pid_hash[pid_hashfn(nr, ns)], pid_chain) //pid_hashfn() 获得hash的索引

// 比较 nr 与 ns 是否都相同

if (pnr->nr == nr && pnr->ns == ns)

//根据container_of机制取得pid 实体

return container_of(pnr, struct pid, numbers[ns->level]);

return NULL;

}

EXPORT_SYMBOL_GPL(find_pid_ns);5.5.2 获取局部ID

根据进程的 task_struct、ID类型、命名空间,可以很容易获得其在命名空间内的局部ID

5.5.3 根据PID查找进程task_struct

-

根据PID号(nr值)取得task_struct 结构体

-

根据PID以及其类型(即为局部ID和命名空间)获取task_struct结构体

如果根据的是进程的ID号,我们可以先通过ID号(nr值)获取到进程struct pid实体(局部ID),然后根据局部ID、以及命名空间,获得进程的task_struct结构体

5.5.4 生成唯一的PID

内核中使用下面两个函数来实现分配和回收PID的:

static int alloc_pidmap(struct pid_namespace *pid_ns);

static void free_pidmap(struct upid *upid);struct pid *alloc_pid(struct pid_namespace *ns)

{

struct pid *pid;

enum pid_type type;

int i, nr;

struct pid_namespace *tmp;

struct upid *upid;

tmp = ns;

pid->level = ns->level;

// 初始化 pid->numbers[] 结构体

for (i = ns->level; i >= 0; i--)

{

nr = alloc_pidmap(tmp); //分配一个局部ID

pid->numbers[i].nr = nr;

pid->numbers[i].ns = tmp;

tmp = tmp->parent;

}

// 初始化 pid->task[] 结构体

for (type = 0; type < PIDTYPE_MAX; ++type)

INIT_HLIST_HEAD(&pid->tasks[type]);

// 将每个命名空间经过哈希之后加入到散列表中

upid = pid->numbers + ns->level;

for ( ; upid >= pid->numbers; --upid)

{

hlist_add_head_rcu(&upid->pid_chain, &pid_hash[pid_hashfn(upid->nr, upid->ns)]);

upid->ns->nr_hashed++;

}

return pid;

}6 Liux进程类别

Linux下只有一种类型的进程,那就是task_struct,当然我也想说linux其实也没有线程的概念, 只是将那些与其他进程共享资源的进程称之为线程。

通常在一个进程中可以包含若干个线程,它们可以利用进程所拥有的资源。通常把进程作为分配资源的基本单位,而把线程作为独立运行和独立调度的基本单位。

线程和进程的区别在于,子进程和父进程有不同的代码和数据空间,而多个线程则共享数据空间,每个线程有自己的执行堆栈和程序计数器为其执行上下文(!!!这些是线程独享的!!!)。

-

一个进程由于其运行空间的不同, 从而有内核线程和用户进程的区分, 内核线程运行在内核空间, 之所以称之为线程是因为它没有虚拟地址空间(唯一使用的资源是内核栈和上下文切换时保持寄存器的空间), 只能访问内核的代码和数据, 而用户进程则运行在用户空间, 但是可以通过中断,系统调用等方式从用户态陷入内核态。

-

用户进程运行在用户空间上,而一些通过共享资源实现的一组进程我们称之为线程组, Linux下内核其实本质上没有线程的概念,Linux下线程其实上是与其他进程共享某些资源的进程而已。但是我们习惯上还是称他们为线程或者轻量级进程

因此, Linux上进程分3种,内核线程(或者叫内核进程)、用户进程、用户线程(!!!因为内核里面的进程没有虚拟地址空间!!!), 当然如果更严谨的,你也可以认为用户进程和用户线程都是用户进程。

-

内核线程拥有进程描述符、PID、进程正文段、内核堆栈

-

用户进程拥有进程描述符、PID、进程正文段、内核堆栈、用户空间的数据段和堆栈

-

用户线程拥有进程描述符、PID、进程正文段、内核堆栈,同父进程共享用户空间的数据段和堆栈

用户线程也可以通过exec函数族拥有自己的用户空间的数据段和堆栈,成为用户进程。

进程task_struct中pid存储的是内核对该进程的唯一标示, 即对进程则标示进程号, 对线程来说就是其线程号, 那么对于线程来说一个线程组所有线程与领头线程具有相同的进程号,存入tgid字段

每个线程除了共享进程的资源外还拥有各自的私有资源:一个寄存器组(或者说是线程上下文);一个专属的堆栈;一个专属的消息队列;一个专属的Thread Local Storage(TLS);一个专属的结构化异常处理串链。

6.1 内核线程

只运行在内核态,不受用户态上下文的拖累。

从内核的角度来说, Linux并没有线程这个概念。Linux把所有的线程都当做进程来实现。

跟普通进程一样,内核线程也有优先级和被调度。当和用户进程拥有相同的static_prio时,内核线程有机会得到更多的cpu资源

内核线程没有自己的地址空间,所以它们的"current->mm"都是空的, 唯一使用的资源就是内核栈和上下文切换时保存寄存器的空间。

内核线程还有核心堆栈,没有mm怎么访问它的核心堆栈呢?这个核心堆栈跟task_struct的thread_info共享8k的空间,所以不用mm描述。

但是内核线程总要访问内核空间的其他内核啊,没有mm域毕竟是不行的。所以内核线程被调用时,内核会将其task_strcut的active_mm指向前一个被调度出的进程的mm域,在需要的时候,内核线程可以使用前一个进程的内存描述符。

因为内核线程不访问用户空间,只操作内核空间内存,而所有进程的内核空间都是一样的。这样就省下了一个mm域的内存。

7 linux进程的创建流程

7.1 进程的复制fork和加载execve

Linux下进行进行编程,往往都是通过fork出来一个新的程序.

一个进程,包括代码、数据和分配给进程的资源,它其实是从现有的进程(父进程)复制出的一个副本(子进程),fork()函数通过系统调用创建一个与原来进程几乎完全相同的进程,也就是两个进程可以做完全相同的事,然后如果我们通过execve为子进程加载新的应用程序后,那么新的进程将开始执行新的应用

- fork生成当前进程的的一个相同副本,该副本成为子进程

原进程(父进程)的所有资源都以适当的方法复制给新的进程(子进程)。因此该系统调用之后,原来的进程就有了两个独立的实例,这两个实例的联系包括:同一组打开文件,同样的工作目录,进程虚拟空间(内存)中同样的数据(当然两个进程各有一份副本,也就是说他们的虚拟地址相同,但是所对应的物理地址不同)等等。

- execve从一个可执行的二进制程序镜像加载应用程序, 来代替当前运行的进程

换句话说, 加载了一个新的应用程序。因此execv并不是创建新进程

所以我们在linux要创建一个进程的时候,其实执行的操作就是

-

首先使用fork复制一个旧的进程

-

然后调用execve在为新的进程加载一个新的应用程序

7.2 写时复制技术

大批量的复制会导致执行效率过低。

现在的Linux内核采用一种更为有效的方法,称之为写时复制(Copy On Write,COW)。这种思想相当简单:父进程和子进程共享页帧而不是复制页帧。然而,只要页帧被共享,它们就不能被修改,即页帧被保护。无论父进程还是子进程何时试图写一个共享的页帧,就产生一个异常,这时内核就把这个页复制到一个新的页帧中并标记为可写(标志位设置只是对用户特权级即3特权级有效)。原来的页帧仍然是写保护的:当其他进程试图写入时,内核检查写进程是否是这个页帧的唯一属主,如果是,就把这个页帧标记为对这个进程是可写的。

当父进程A或子进程B任何一方对这些已共享的物理页面执行写操作时,都会产生页面出错异常(page_fault int14)中断,此时CPU会执行系统提供的异常处理函数do_wp_page()来解决这个异常.

do_wp_page()会对这块导致写入异常中断的物理页面进行取消共享操作,为写进程复制一新的物理页面,使父进程A和子进程B各自拥有一块内容相同的物理页面.最后,从异常处理函数中返回时,CPU就会重新执行刚才导致异常的写入操作指令,使进程继续执行下去.

一个进程调用fork()函数后,系统先给新的进程分配资源,例如存储数据和代码的空间。然后把原来的进程的所有值都复制到新的新进程中,只有少数值与原来的进程的值(比如PID)不同。相当于克隆了一个自己。

7.3 内核线程创建接口

在内核中,有两种方法可以生成内核线程,一种是使用kernel_thread()接口,另一种是用kthread_create()接口

7.3.1 kernel_thread

先说kernel_thread接口,使用该接口创建的线程,必须在该线程中调用daemonize()函数,这是因为只有当线程的父进程指向"Kthreadd"时,该线程才算是内核线程(!!!),而恰好daemonize()函数主要工作便是将该线程的父进程改成“kthreadd"内核线程;

默认情况下,调用deamonize()后,会阻塞所有信号,如果想操作某个信号可以调用allow_signal()函数。

// fn为线程函数,arg为线程函数参数,flags为标记

int kernel_thread(int (*fn)(void *), void *arg, unsigned long flags);

// name为内核线程的名称

void daemonize(const char * name,...); 7.3.2 kthread_create

而kthread_create接口,则是标准的内核线程创建接口,只须调用该接口便可创建内核线程;

默认创建的线程是存于不可运行的状态,所以需要在父进程中通过调用wake_up_process()函数来启动该线程。

//threadfn为线程函数;data为线程函数参数;namefmt为线程名称,可被格式化的, 类似printk一样传入某种格式的线程名

struct task_struct *kthread_create(int (*threadfn)(void *data),void *data,

const char namefmt[], ...);

线程创建后,不会马上运行,而是需要将kthread_create()返回的task_struct指针传给wake_up_process(),然后通过此函数运行线程。

7.3.3 kthread_run

当然,还有一个创建并启动线程的函数:kthread_run

struct task_struct *kthread_run(int (*threadfn)(void *data),

void *data,

const char *namefmt, ...);线程一旦启动起来后,会一直运行,除非该线程主动调用do_exit函数,或者其他的进程调用kthread_stop函数,结束线程的运行。

int kthread_stop(struct task_struct *thread);kthread_stop() 通过发送信号给线程。

如果线程函数正在处理一个非常重要的任务,它不会被中断的。当然如果线程函数永远不返回并且不检查信号,它将永远都不会停止。

//唤醒线程

int wake_up_process(struct task_struct *p);

//是以上两个函数的功能的总和

struct task_struct *kthread_run(int (*threadfn)(void *data),void *data,

const char namefmt[], ...);因为线程也是进程,所以其结构体也是使用进程的结构体"struct task_struct"。

7.4 内核线程的退出接口

当内核线程执行到函数末尾时会自动调用内核中do_exit()函数来退出或其他线程调用kthread_stop()来指定线程退出。

怎么调用do_exit()可以看kthreadd线程

int kthread_stop(struct task_struct *thread);kthread_stop()通过发送信号给线程。

如果线程函数正在处理一个非常重要的任务,它不会被中断的。当然如果线程函数永远不返回并且不检查信号,它将永远都不会停止。

在执行kthread_stop的时候,目标线程必须没有退出,否则会Oops。原因很容易理解,当目标线程退出的时候,其对应的task结构也变得无效,kthread_stop引用该无效task结构就会出错。

为了避免这种情况,需要确保线程没有退出,其方法如代码中所示:

thread_func()

{

// do your work here

// wait to exit

while(!thread_could_stop())

{

wait();

}

}

exit_code()

{

kthread_stop(_task); //发信号给task,通知其可以退出了

}这种退出机制很温和,一切尽在thread_func()的掌控之中,线程在退出时可以从容地释放资源,而不是莫名其妙地被人“暗杀”。

8 Linux中3个特殊的进程

Linux下有3个特殊的进程,idle进程($PID = 0$), init进程($PID = 1$)和kthreadd($PID = 2$)

- idle进程由系统自动创建, 运行在内核态

idle进程其pid=0,其前身是系统创建的第一个进程,也是唯一一个没有通过fork或者kernel_thread产生的进程。完成加载系统后,演变为进程调度、交换

- init进程由idle通过kernel_thread创建,在内核空间(!!!)完成初始化后, 最终执行/sbin/init进程,变为所有用户态程序的根进程(pstree命令显示),即用户空间的init进程

由0进程创建,完成系统的初始化.是系统中所有其它用户进程(!!!用户进程!!!)的祖先进程.Linux中的所有进程都是有init进程创建并运行的。首先Linux内核启动,然后在用户空间中启动init进程,再启动其他系统程。在系统启动完成后,init将变为守护进程监视系统其他进程

- kthreadd进程由idle通过kernel_thread创建,并始终运行在内核空间,负责所有内核线程(内核线程!!!)的调度和管理, 变为所有内核态其他守护线程的父线程。

它的任务就是管理和调度其他内核线程kernel_thread,会循环执行一个kthread的函数,该函数的作用就是运行kthread_create_list全局链表中维护kthread, 当我们调用kernel_thread创建的内核线程会被加入到此链表中,因此所有的内核线程都是直接或者间接的以kthreadd为父进程

8.1 0号idle进程

在smp系统中,每个处理器单元有独立的一个运行队列,而每个运行队列上又有一个idle进程,即有多少处理器单元,就有多少idle进程。

系统的空闲时间,其实就是指idle进程的"运行时间"。

8.1.1 0号进程上下文信息--init_task描述符

在内核初始化过程中,通过静态定义构造出了一个task_struct接口,取名为init_task变量,然后在内核初始化的后期,通过rest_init()函数新建了内核init线程,kthreadd内核线程

所以init_task决定了系统所有进程、线程的基因, 它完成初始化后, 最终演变为0号进程idle, 并且运行在内核态

在init_task进程执行后期,它会调用kernel_thread()函数创建第一个核心进程kernel_init,同时init_task进程继续对Linux系统初始化。在完成初始化后,init_task会退化为cpu_idle进程,当Core 0的就绪队列中没有其它进程时,该进程将会获得CPU运行。新创建的1号进程kernel_init将会逐个启动次CPU,并最终创建用户进程!

备注:core 0上的idle进程由init_task进程退化而来,而AP的idle进程则是BSP在后面调用fork()函数逐个创建的

内核在初始化过程中,当创建完init和kthreadd内核线程后,内核会发生调度执行,此时内核将使用该init_task作为其task_struct结构体描述符,当系统无事可做时,会调度其执行,此时该内核会变为idle进程,让出CPU,自己进入睡眠,不停的循环,查看init_task结构体,其comm字段为swapper,作为idle进程的描述符。

init_task描述符在init/init_task.c中定义

[init/init_task.c]

struct task_struct init_task = INIT_TASK(init_task);

EXPORT_SYMBOL(init_task);8.1.2 进程堆栈init_thread_union

init_task进程使用init_thread_union数据结构描述的内存区域作为该进程的堆栈空间,并且和自身的thread_info参数共用这一内存空间空间

#define INIT_TASK(tsk) \

{ \

.stack = &init_thread_info,

}init_thread_info则是一段体系结构相关的定义

[arch/x86/include/asm/thread_info.h]

#define init_thread_info (init_thread_union.thread_info)

#define init_stack (init_thread_union.stack)其中init_thread_union被定义在init/init_task.c

union thread_union init_thread_union __init_task_data =

{ INIT_THREAD_INFO(init_task) };init_task是用INIT_THREAD_INFO宏进行初始化的, 这个才是我们真正体系结构相关的部分

[arch/x86/include/asm/thread_info.h]

#define INIT_THREAD_INFO(tsk) \

{ \

.task = &tsk, \

.flags = 0, \

.cpu = 0, \

.addr_limit = KERNEL_DS, \

}init_thread_info定义中的__init_task_data表明该内核栈所在的区域位于内核映像的init data区,我们可以通过编译完内核后所产生的System.map来看到该变量及其对应的逻辑地址

8.1.3 进程内存空间

由于init_task是一个运行在内核空间的内核线程,因此其虚地址段mm为NULL,但是必要时他还是需要使用虚拟地址的,因此avtive_mm被设置为init_mm

.mm = NULL, \

.active_mm = &init_mm, \[mm/init-mm.c]

struct mm_struct init_mm = {

.mm_rb = RB_ROOT,

.pgd = swapper_pg_dir,

.mm_users = ATOMIC_INIT(2),

.mm_count = ATOMIC_INIT(1),

.mmap_sem = __RWSEM_INITIALIZER(init_mm.mmap_sem),

.page_table_lock = __SPIN_LOCK_UNLOCKED(init_mm.page_table_lock),

.mmlist = LIST_HEAD_INIT(init_mm.mmlist),

INIT_MM_CONTEXT(init_mm)

};8.1.4 0号进程的演化

8.1.4.1 rest_init创建init进程(PID=1)和kthread进程(PID=2)

在vmlinux的入口startup_32(head.S)中为pid号为0的原始进程设置了执行环境,然后原始进程开始执行start_kernel()完成Linux内核的初始化工作。包括初始化页表,初始化中断向量表,初始化系统时间等。

从rest_init开始,Linux开始产生进程,因为init_task是静态制造出来的,pid=0,它试图将从最早的汇编代码一直到start_kernel的执行都纳入到init_task进程上下文中。

这个函数其实是由0号进程执行的, 就是在这个函数中, 创建了init进程和kthreadd进程

start_kernel最后一个函数调用rest_init

[init/main.c]

static noinline void __init_refok rest_init(void)

{

int pid;

rcu_scheduler_starting();

smpboot_thread_init();

kernel_thread(kernel_init, NULL, CLONE_FS);

numa_default_policy();

pid = kernel_thread(kthreadd, NULL, CLONE_FS | CLONE_FILES);

rcu_read_lock();

kthreadd_task = find_task_by_pid_ns(pid, &init_pid_ns);

rcu_read_unlock();

complete(&kthreadd_done);

init_idle_bootup_task(current);

schedule_preempt_disabled();

/* Call into cpu_idle with preempt disabled */

cpu_startup_entry(CPUHP_ONLINE);

}-

调用kernel_thread()创建1号内核线程, 该线程随后转向用户空间, 演变为init进程

-

调用kernel_thread()创建kthreadd内核线程, pid=2。

-

init_idle_bootup_task():当前0号进程init_task最终会退化成idle进程,所以这里调用init_idle_bootup_task()函数,让init_task进程隶属到idle调度类中。即选择idle的调度相关函数。

-

调用schedule()函数切换当前进程,在调用该函数之前,Linux系统中只有两个进程,即0号进程init_task和1号进程kernel_init,其中kernel_init进程也是刚刚被创建的。调用该函数后,1号进程kernel_init将会运行!!!, 后续初始化都是使用该进程

-

调用cpu_idle(),0号线程进入idle函数的循环,在该循环中会周期性地检查。

8.1.4.1.1 创建kernel_init

产生第一个真正的进程(pid=1)

kernel_thread(kernel_init, NULL, CLONE_FS);8.1.4.1.2 创建kthreadd

在rest_init函数中,内核将通过下面的代码产生第一个kthreadd(pid=2)

pid = kernel_thread(kthreadd, NULL, CLONE_FS | CLONE_FILES);8.1.4.2 0号进程演变为idle

init_idle_bootup_task(current);

schedule_preempt_disabled();

/* Call into cpu_idle with preempt disabled */

cpu_startup_entry(CPUHP_ONLINE);因此我们回过头来看pid=0的进程,在创建了init进程后,pid=0的进程调用cpu_idle()演变成了idle进程。

0号进程首先执行init_idle_bootup_task, 让init_task进程隶属到idle调度类中。即选择idle的调度相关函数。

void init_idle_bootup_task(struct task_struct *idle)

{

idle->sched_class = &idle_sched_class;

}接着通过schedule_preempt_disabled来执行调用schedule()函数切换当前进程,在调用该函数之前,Linux系统中只有两个进程,即0号进程init_task和1号进程kernel_init,其中kernel_init进程也是刚刚被创建的。调用该函数后,1号进程kernel_init将会运行

void __sched schedule_preempt_disabled(void)

{

sched_preempt_enable_no_resched();

schedule();

preempt_disable();

}最后cpu_startup_entry调用cpu_idle_loop(),0号线程进入idle函数的循环,在该循环中会周期性地检查

void cpu_startup_entry(enum cpuhp_state state)

{

#ifdef CONFIG_X86

boot_init_stack_canary();

#endif

arch_cpu_idle_prepare();

cpu_idle_loop();

}其中cpu_idle_loop就是idle进程的事件循环,定义在kernel/sched/idle.c

整个过程简单的说就是,原始进程(pid=0)创建init进程(pid=1),然后演化成idle进程(pid=0)。init进程为每个从处理器(运行队列)创建出一个idle进程(pid=0),然后演化成/sbin/init。

8.1.5 idle的运行与调度

8.1.5.1 idle的workload--cpu_idle_loop

idle在系统没有其他就绪的进程可执行的时候才会被调度。不管是主处理器,还是从处理器,最后都是执行的cpu_idle_loop()函数

idle进程中并不执行什么有意义的任务,所以通常考虑的是两点

-

节能

-

低退出延迟。

[kernel/sched/idle.c]

static void cpu_idle_loop(void)

{

while (1) {

__current_set_polling();

quiet_vmstat();

tick_nohz_idle_enter();

while (!need_resched()) {

check_pgt_cache();

rmb();

if (cpu_is_offline(smp_processor_id())) {

rcu_cpu_notify(NULL, CPU_DYING_IDLE,

(void *)(long)smp_processor_id());

smp_mb(); /* all activity before dead. */

this_cpu_write(cpu_dead_idle, true);

arch_cpu_idle_dead();

}

local_irq_disable();

arch_cpu_idle_enter();

if (cpu_idle_force_poll || tick_check_broadcast_expired())

cpu_idle_poll();

else

cpuidle_idle_call();

arch_cpu_idle_exit();

}

preempt_set_need_resched();

tick_nohz_idle_exit();

__current_clr_polling();

smp_mb__after_atomic();

sched_ttwu_pending();

schedule_preempt_disabled();

}

}循环判断need_resched以降低退出延迟,用idle()来节能。

默认的idle实现是hlt指令,hlt指令使CPU处于暂停状态,等待硬件中断发生的时候恢复,从而达到节能的目的。即从处理器C0态变到C1态(见ACPI标准)。这也是早些年windows平台上各种"处理器降温"工具的主要手段。当然idle也可以是在别的ACPI或者APM模块中定义的,甚至是自定义的一个idle(比如说nop)。

-

idle是一个进程,其pid为0。

-

主处理器上的idle由原始进程(pid=0)演变而来。从处理器上的idle由init进程fork得到,但是它们的pid都为0。

-

idle进程为最低优先级,且不参与调度,只是在运行队列为空的时候才被调度。

-

idle循环等待need_resched置位。默认使用hlt节能。

8.1.5.2 idle的运行时机

idle进程优先级为MAX_PRIO - 20。早先版本中,idle是参与调度的,所以将其优先级设低点,当没有其他进程可以运行时,才会调度执行idle。而目前的版本中idle并不在运行队列中参与调度,而是在运行队列结构中含idle指针,指向idle进程,在调度器发现运行队列为空的时候运行,调入运行

inux进程的调度顺序是按照rt实时进程(rt调度器),normal普通进程(cfs调度器),和idle的顺序来调度的

那么可以试想如果rt和cfs都没有可以运行的任务,那么idle才可以被调度,那么他是通过怎样的方式实现的呢?

在normal的调度类,cfs公平调度器sched_fair.c中

static const struct sched_class fair_sched_class = {

.next = &idle_sched_class,也就是说,如果系统中没有普通进程,那么会选择下个调度类优先级的进程,即使用idle_sched_class调度类进行调度的进程

当系统空闲的时候,最后就是调用idle的pick_next_task函数,被定义在/kernel/sched/idle_task.c中

static struct task_struct *pick_next_task_idle(struct rq *rq)

{

schedstat_inc(rq, sched_goidle);

calc_load_account_idle(rq);

return rq->idle; //可以看到就是返回rq中idle进程。

}这idle进程在启动start_kernel函数的时候调用init_idle函数的时候,把当前进程(0号进程)置为每个rq运行队列的的idle上。

rq->curr = rq->idle = idle;

这里idle就是调用start_kernel函数的进程,就是0号进程。

8.2 1号init进程

8.2.1 执行函数kernel_init()

0号进程创建1号进程的方式如下

kernel_thread(kernel_init, NULL, CLONE_FS);1号进程的执行函数就是kernel_init, kernel_init函数将完成设备驱动程序的初始化, 并调用init_post函数启动用户空间的init进程。

[init/main.c]

static int __ref kernel_init(void *unused)

{

int ret;

// 完成初始化工作,准备文件系统,准备模块信息

kernel_init_freeable();

/* need to finish all async __init code before freeing the memory */

// 用以同步所有非同步函式呼叫的执行, 加速Linux Kernel开机的效率

async_synchronize_full();

free_initmem();

mark_rodata_ro();

// 设置运行状态SYSTEM_RUNNING

system_state = SYSTEM_RUNNING;

numa_default_policy();

flush_delayed_fput();

rcu_end_inkernel_boot();

if (ramdisk_execute_command) {

ret = run_init_process(ramdisk_execute_command);

if (!ret)

return 0;

pr_err("Failed to execute %s (error %d)\n",

ramdisk_execute_command, ret);

}

if (execute_command) {

ret = run_init_process(execute_command);

if (!ret)

return 0;

panic("Requested init %s failed (error %d).",

execute_command, ret);

}

if (!try_to_run_init_process("/sbin/init") ||

!try_to_run_init_process("/etc/init") ||

!try_to_run_init_process("/bin/init") ||

!try_to_run_init_process("/bin/sh"))

return 0;

panic("No working init found. Try passing init= option to kernel. "

"See Linux Documentation/init.txt for guidance.");

}| 执行流程 | 说明 |

|---|---|

| kernel_init_freeable | 调用kernel_init_freeable完成初始化工作,准备文件系统,准备模块信息 |

| async_synchronize_full | 用以同步所有非同步函式呼叫的执行, 主要设计用来加速Linux Kernel开机的效率,避免在开机流程中等待硬体反应延迟,影响到开机完成的时间 |

| free_initmem | 释放Linux Kernel介于__init_begin到 __init_end属于init Section的函数的所有内存.并会把Page个数加到变量totalram_pages中 |

| system_state | 设置运行状态SYSTEM_RUNNING |

| 加载init进程,进入用户空间 | a,如果ramdisk_execute_command不为0,就执行该命令成为init User Process. b,如果execute_command不为0,就执行该命令成为init User Process. c,如果上述都不成立,就依序执行如下指令 run_init_process(“/sbin/init”); run_init_process(“/etc/init”); run_init_process(“/bin/init”); run_init_process(“/bin/sh”); 也就是说会按照顺序从/sbin/init, /etc/init, /bin/init 与 /bin/sh依序执行第一个 init User Process. 如果都找不到可以执行的 init Process,就会进入Kernel Panic.如下所示panic(“No init found. Try passing init= option to kernel. ”“See Linux Documentation/init.txt for guidance.”); |

由0号进程创建1号进程(内核态),1号内核线程负责执行内核的部分初始化工作及进行系统配置(包括启动AP),并创建若干个用于高速缓存和虚拟主存管理的内核线程。

随后,内核1号进程就会在/sbin, /etc, /bin寻找init程序, 调用do_execve()运行可执行程序init,并演变成用户态1号进程,即init进程。这个过程并没有使用调用do_fork(),因此两个进程都是1号进程。

该init程序会替换kernel_init进程(注意:并不是创建一个新的进程来运行init程序,而是一次变身,使用sys_execve函数改变核心进程的正文段,将核心进程kernel_init转换成用户进程init),此时处于内核态的1号kernel_init进程将会转换为用户空间内的1号进程init。

init进程是linux内核启动的第一个用户级进程。init有许多很重要的任务,比如像启动getty(用于用户登录)、实现运行级别、以及处理孤立进程。

它按照配置文件/etc/initab的要求,完成系统启动工作,创建编号为1号、2号...的若干终端注册进程getty。

每个getty进程设置其进程组标识号,并监视配置到系统终端的接口线路。当检测到来自终端的连接信号时,getty进程将通过函数do_execve()执行注册程序login,此时用户就可输入注册名和密码进入登录过程,如果成功,由login程序再通过函数execv()执行/bin/shell,该shell进程接收getty进程的pid,取代原来的getty进程。再由shell直接或间接地产生其他进程。

用户进程init将根据/etc/inittab中提供的信息完成应用程序的初始化调用。然后init进程会执行/bin/sh产生shell界面提供给用户来与Linux系统进行交互。

上述过程可描述为:0号进程->1号内核进程->1号用户进程(init进程)->getty进程->shell进程

在系统完全起来之后,init为每个用户已退出的终端重启getty(这样下一个用户就可以登录)。init同样也收集孤立的进程:当一个进程启动了一个子进程并且在子进程之前终止了,这个子进程立刻成为init的子进程。

8.2.2 关于init程序

init的最适当的位置(在Linux系统上)是/sbin/init。如果内核没有找到init,它就会试着运行/bin/sh,如果还是失败了,那么系统的启动就宣告失败了。

通过rpm -qf查看系统程序所在的包, 目前系统的包是systemd.

8.3 2号kthreadd进程

pid = kernel_thread(kthreadd, NULL, CLONE_FS | CLONE_FILES);所有其它的内核线程的ppid都是2,也就是说它们都是由kthreadd thread创建的

所有的内核线程在大部分时间里都处于阻塞状态(TASK_INTERRUPTIBLE)只有在系统满足进程需要的某种资源的情况下才会运行

它的任务就是管理和调度其他内核线程kernel_thread,会循环执行一个kthread的函数,该函数的作用就是运行kthread_create_list全局链表中维护的kthread,当我们调用kernel_thread创建的内核线程会被加入到此链表中,因此所有的内核线程都是直接或者间接的以kthreadd为父进程

8.3.1 执行函数kthreadd()

[kernel/kthread.c]

int kthreadd(void *unused)

{

struct task_struct *tsk = current;

/* Setup a clean context for our children to inherit. */

set_task_comm(tsk, "kthreadd");

ignore_signals(tsk);

// 允许kthreadd在任意CPU上运行

set_cpus_allowed_ptr(tsk, cpu_all_mask);

set_mems_allowed(node_states[N_MEMORY]);

current->flags |= PF_NOFREEZE;

for (;;) {

// 首先将线程状态设置为TASK_INTERRUPTIBLE,

// 如果当前没有要创建的线程则主动放弃CPU完成调度.此进程变为阻塞态

set_current_state(TASK_INTERRUPTIBLE);

// 没有需要创建的内核线程

if (list_empty(&kthread_create_list))

// 什么也不做, 执行一次调度, 让出CPU

schedule();

// 运行到此表示kthreadd线程被唤醒(就是我们当前)

// 设置进程运行状态为 TASK_RUNNING

__set_current_state(TASK_RUNNING);

// 加锁,

spin_lock(&kthread_create_lock);

while (!list_empty(&kthread_create_list)) {

struct kthread_create_info *create;

// 从链表中取得 kthread_create_info

// 结构的地址,在上文中已经完成插入操作(将

// kthread_create_info 结构中的 list

// 成员加到链表中,此时根据成员 list 的偏移获得 create)

create = list_entry(kthread_create_list.next,

struct kthread_create_info, list);

/* 完成穿件后将其从链表中删除 */

list_del_init(&create->list);

/* 完成真正线程的创建 */

spin_unlock(&kthread_create_lock);

create_kthread(create);

spin_lock(&kthread_create_lock);

}

spin_unlock(&kthread_create_lock);

}

return 0;

}kthreadd的核心是for和while循环体。

在for循环中,如果发现kthread_create_list是一空链表(!!!),则调用schedule调度函数,因为此前已经将该进程的状态设置为TASK_INTERRUPTIBLE,所以schedule的调用将会使当前进程进入睡眠(会将进程从CPU运行队列中移除,可以通过显式的唤醒呼叫wakeup_process()或需要处理的信号来唤醒它)。

如果kthread_create_list不为空,则进入while循环,在该循环体中会遍历该kthread_create_list列表,对于该列表上的每一个entry,都会得到对应的类型为struct kthread_create_info的节点的指针create.

然后函数在kthread_create_list中删除create对应的列表entry,接下来以create指针为参数调用create_kthread(create).

完成了进程的创建后继续循环,检查kthread_create_list链表,如果为空,则 kthreadd 内核线程昏睡过去

我们在内核中通过kernel_create或者其他方式创建一个内核线程, 然后kthreadd内核线程被唤醒, 来执行内核线程创建的真正工作, 于是这里有三个线程

-

kthreadd进程已经光荣完成使命(接手执行真正的创建工作),睡眠

-

唤醒kthreadd的线程(!!!不是kthreadd线程本身!!!)由于新创建的线程还没有创建完毕而继续睡眠(在kthread_create函数中)

-

新创建的线程已经正在运行kthread()函数,但是由于还有其它工作没有做所以还没有最终创建完成.

8.3.1.1 create_kthread(struct kthread_create_info)完成内核线程创建

[kernel/kthread.c]

static void create_kthread(struct kthread_create_info *create)

{

int pid;

#ifdef CONFIG_NUMA

current->pref_node_fork = create->node;

#endif

/* We want our own signal handler (we take no signals by default). */

// 其实就是调用首先构造一个假的上下文执行环境,

// 最后调用do_fork()返回进程 id, 创建后的线程执行 kthread 函数

pid = kernel_thread(kthread, create, CLONE_FS | CLONE_FILES | SIGCHLD);

if (pid < 0) {

/* If user was SIGKILLed, I release the structure. */

struct completion *done = xchg(&create->done, NULL);

if (!done) {

kfree(create);

return;

}

create->result = ERR_PTR(pid);

complete(done);

}

}里面会调用kernel_thread来生成一个新的进程,该进程的内核函数为kthread,调用参数为

pid = kernel_thread(kthread, create, CLONE_FS | CLONE_FILES | SIGCHLD);

创建的内核线程执行的函数是kthread()

8.3.2 新创建的内核线程执行函数kthread()

static int kthread(void *_create)

{

/* Copy data: it's on kthread's stack

create 指向 kthread_create_info 中的 kthread_create_info */

struct kthread_create_info *create = _create;

/* 新的线程创建完毕后执行的函数 */

int (*threadfn)(void *data) = create->threadfn;

/* 新的线程执行的参数 */

void *data = create->data;

struct completion *done;

struct kthread self;

int ret;

self.flags = 0;

self.data = data;

init_completion(&self.exited);

init_completion(&self.parked);

current->vfork_done = &self.exited;

/* If user was SIGKILLed, I release the structure. */

done = xchg(&create->done, NULL);

if (!done) {

kfree(create);

do_exit(-EINTR);

}

/* OK, tell user we're spawned, wait for stop or wakeup

设置运行状态为 TASK_UNINTERRUPTIBLE */

__set_current_state(TASK_UNINTERRUPTIBLE);

/* current 表示当前新创建的 thread 的 task_struct 结构 */

create->result = current;

complete(done);

/* 至此线程创建完毕, 执行任务切换,让出 CPU */

schedule();

ret = -EINTR;

if (!test_bit(KTHREAD_SHOULD_STOP, &self.flags)) {

__kthread_parkme(&self);

ret = threadfn(data);

}

/* we can't just return, we must preserve "self" on stack */

do_exit(ret);

}线程创建完毕:

-

创建新thread的进程(原进程)恢复运行kthread_create()并且返回新创建线程的任务描述符

-

新创建的线程由于执行了schedule()调度,此时并没有执行(!!!).

直到我们手动使用wake_up_process(p)唤醒新创建的线程

-

线程被唤醒后, 会接着执行threadfn(data)

-

得到执行结果, 将结果(整型类型)作为参数调用do_exit()函数

8.3.3 小结

-

任何一个内核线程入口都是kthread()

-

通过kthread_create()创建的内核线程不会立刻运行.需要手工wake up

-

通过kthread_create()创建的内核线程有可能不会执行相应线程函数threadfn而直接退出(!!!)

9 用户空间创建进程/线程的三种方法

| 系统调用 | 描述 |

|---|---|

| fork | fork创造的子进程是父进程的完整副本,复制了父亲进程的资源,包括内存的task_struct内容 |

| vfork | vfork创建的子进程与父进程共享数据段(数据段!!!),而且由vfork()创建的子进程将先于父进程运行 |

| clone | Linux上创建线程一般使用的是pthread库.实际上linux也给我们提供了创建线程的系统调用,就是clone |

fork, vfork和clone的系统调用的入口地址分别是sys_fork(),sys_vfork()和sys_clone(), 而他们的定义是依赖于体系结构的, 因为在用户空间和内核空间之间传递参数的方法因体系结构而异

9.1 系统调用的参数传递

由于系统调用是通过中断进程从用户态到内核态的一种特殊的函数调用,没有用户态或者内核态的堆栈(!!!)可以被用来在调用函数和被调函数之间进行参数传递。

系统调用通过CPU的寄存器来进行参数传递。在进行系统调用之前,系统调用的参数被写入CPU的寄存器,而在实际调用系统服务例程之前,内核将CPU寄存器的内容拷贝到内核堆栈中,实现参数的传递。

上面函数的任务就是从处理器的寄存器中提取用户空间提供的信息,并调用体系结构无关的_do_fork(或者早期的do_fork)函数,负责进程的复制

Linux有一个TLS(Thread Local Storage)机制,clone的标识CLONE_SETTLS接受一个参数来设置线程的本地存储区。

sys_clone也因此增加了一个int参数来传入相应的tls_val。sys_clone通过do_fork来调用copy_process完成进程的复制,它调用特定的copy_thread和copy_thread把相应的系统调用参数从pt_regs寄存器列表中提取出来,这个参数仍然是体系结构相关的.

所以Linux引入一个新的CONFIG_HAVE_COPY_THREAD_TLS,和一个新的COPY_THREAD_TLS接受TLS参数为额外的长整型(系统调用参数大小)的争论。改变sys_clone的TLS参数unsigned long,并传递到copy_thread_tls。

[include/linux/sched.h]

extern long _do_fork(unsigned long, unsigned long, unsigned long, int __user *, int __user *, unsigned long);

extern long do_fork(unsigned long, unsigned long, unsigned long, int __user *, int __user *);

#ifndef CONFIG_HAVE_COPY_THREAD_TLS

long do_fork(unsigned long clone_flags,

unsigned long stack_start,

unsigned long stack_size,

int __user *parent_tidptr,

int __user *child_tidptr)

{

return _do_fork(clone_flags, stack_start, stack_size,

parent_tidptr, child_tidptr, 0);

}

#endif新版本的系统中clone的TLS设置标识会通过TLS参数传递,因此_do_fork替代了老版本的do_fork。

老版本的do_fork只有在如下情况才会定义

-

只有当系统不支持通过TLS参数传递而是使用pt_regs寄存器列表传递时

-

未定义CONFIG_HAVE_COPY_THREAD_TLS宏

| 参数 | 描述 |

|---|---|

| clone_flags | 与clone()参数flags相同,用来控制进程复制过的一些属性信息,描述你需要从父进程继承哪些资源。该标志位的4个字节分为两部分。最低的一个字节为子进程结束时发送给父进程的信号代码,通常为SIGCHLD;剩余的三个字节则是各种clone标志的组合(本文所涉及的标志含义详见下表),也就是若干个标志之间的或运算。通过clone标志可以有选择的对父进程的资源进行复制; |

| stack_start | 与clone()参数stack_start相同, 子进程用户态(!!!)堆栈的地址 |

| regs | 是一个指向了寄存器集合的指针,其中以原始形式,保存了调用的参数,该参数使用的数据类型是特定体系结构的struct pt_regs,其中按照系统调用执行时寄存器在内核栈上的存储顺序,保存了所有的寄存器,即指向内核态堆栈通用寄存器值的指针,通用寄存器的值是在从用户态切换到内核态时被保存到内核态堆栈中的(指向pt_regs结构体的指针。当系统发生系统调用,即用户进程从用户态切换到内核态时,该结构体保存通用寄存器中的值,并被存放于内核态的堆栈中) |

| stack_size | 用户状态下栈的大小, 该参数通常是不必要的, 总被设置为0 |

| parent_tidptr | 与clone的ptid参数相同,父进程在用户态下pid的地址,该参数在CLONE_PARENT_SETTID标志被设定时有意义 |

| child_tidptr | 与clone的ctid参数相同,子进程在用户态下pid的地址,该参数在CLONE_CHILD_SETTID标志被设定时有意义 |

clone_flags如下表所示

9.2 sys_fork的实现

早期实现

asmlinkage long sys_fork(struct pt_regs regs)

{

return do_fork(SIGCHLD, regs.rsp, ®s, 0);

}

新版本实现

#ifdef __ARCH_WANT_SYS_FORK

SYSCALL_DEFINE0(fork)

{

#ifdef CONFIG_MMU

return _do_fork(SIGCHLD, 0, 0, NULL, NULL, 0);

#else

return -EINVAL;

#endif

}

#endif-

唯一使用的标志是SIGCHLD。这意味着在子进程终止后将发送信号SIGCHLD信号通知父进程

-

写时复制(COW)技术, 最初父子进程的栈地址相同, 但是如果操作栈地址并写入数据, 则COW机制会为每个进程分别创建一个新的栈副本

-

如果do_fork成功, 则新建进程的pid作为系统调用的结果返回, 否则返回错误码

9.3 sys_vfork的实现

早期实现

asmlinkage long sys_vfork(struct pt_regs regs)

{

return do_fork(CLONE_VFORK | CLONE_VM | SIGCHLD, regs.rsp, ®s, 0);

}

新实现

#ifdef __ARCH_WANT_SYS_VFORK

SYSCALL_DEFINE0(vfork)

{

return _do_fork(CLONE_VFORK | CLONE_VM | SIGCHLD, 0,

0, NULL, NULL, 0);

}

#endif相较于sys_vfork, 多使用了额外的标志CLONE_VFORK | CLONE_VM

9.4 sys_clone的实现

早期实现

casmlinkage int sys_clone(struct pt_regs regs)

{

/* 注释中是i385下增加的代码, 其他体系结构无此定义

unsigned long clone_flags;

unsigned long newsp;

clone_flags = regs.ebx;

newsp = regs.ecx;*/

if (!newsp)

newsp = regs.esp;

return do_fork(clone_flags, newsp, ®s, 0);

}

新版本

#ifdef __ARCH_WANT_SYS_CLONE

#ifdef CONFIG_CLONE_BACKWARDS

SYSCALL_DEFINE5(clone, unsigned long, clone_flags, unsigned long, newsp,

int __user *, parent_tidptr,

unsigned long, tls,

int __user *, child_tidptr)

#elif defined(CONFIG_CLONE_BACKWARDS2)

SYSCALL_DEFINE5(clone, unsigned long, newsp, unsigned long, clone_flags,

int __user *, parent_tidptr,

int __user *, child_tidptr,

unsigned long, tls)

#elif defined(CONFIG_CLONE_BACKWARDS3)

SYSCALL_DEFINE6(clone, unsigned long, clone_flags, unsigned long, newsp,

int, stack_size,

int __user *, parent_tidptr,

int __user *, child_tidptr,

unsigned long, tls)

#else

SYSCALL_DEFINE5(clone, unsigned long, clone_flags, unsigned long, newsp,

int __user *, parent_tidptr,

int __user *, child_tidptr,

unsigned long, tls)

#endif

{

return _do_fork(clone_flags, newsp, 0, parent_tidptr, child_tidptr, tls);

}

#endifsys_clone的标识不再是硬编码的,而是通过各个寄存器参数传递到系统调用, clone也不再复制进程的栈,而是可以指定新的栈地址,在生成线程时,可能需要这样做,线程可能与父进程共享地址空间,但是线程自身的栈可能在另外一个地址空间

另外还指令了用户空间的两个指针(parent_tidptr和child_tidptr), 用于与线程库通信

10 创建子进程流程

_do_fork和do_fork在进程的复制的时候并没有太大的区别,他们就只是在进程tls复制的过程中实现有细微差别

10.1 _do_fork的流程

所有进程复制(创建)的fork机制最终都调用了kernel/fork.c中的_do_fork(一个体系结构无关的函数)

long _do_fork(unsigned long clone_flags,

unsigned long stack_start,

unsigned long stack_size,

int __user *parent_tidptr,

int __user *child_tidptr,

unsigned long tls)

{

struct task_struct *p;

int trace = 0;

long nr;

if (!(clone_flags & CLONE_UNTRACED)) {

if (clone_flags & CLONE_VFORK)

trace = PTRACE_EVENT_VFORK;

else if ((clone_flags & CSIGNAL) != SIGCHLD)

trace = PTRACE_EVENT_CLONE;

else

trace = PTRACE_EVENT_FORK;

if (likely(!ptrace_event_enabled(current, trace)))

trace = 0;

}

/* 复制进程描述符,copy_process()的返回值是一个 task_struct 指针 */

p = copy_process(clone_flags, stack_start, stack_size,

child_tidptr, NULL, trace, tls);

if (!IS_ERR(p)) {

struct completion vfork;

struct pid *pid;

trace_sched_process_fork(current, p);

/* 得到新创建的进程的pid信息 */

pid = get_task_pid(p, PIDTYPE_PID);

nr = pid_vnr(pid);

if (clone_flags & CLONE_PARENT_SETTID)

put_user(nr, parent_tidptr);

/* 如果调用的 vfork()方法,初始化 vfork 完成处理信息 */

if (clone_flags & CLONE_VFORK) {

p->vfork_done = &vfork;

init_completion(&vfork);

get_task_struct(p);

}

/* 将子进程加入到调度器中,为其分配 CPU,准备执行 */

wake_up_new_task(p);

/* forking complete and child started to run, tell ptracer */

if (unlikely(trace))

ptrace_event_pid(trace, pid);

/* 如果设置了 CLONE_VFORK 则将父进程插入等待队列,

并挂起父进程直到子进程释放自己的内存空间

*/

/* 如果是 vfork,将父进程加入至等待队列,等待子进程完成 */

if (clone_flags & CLONE_VFORK) {

if (!wait_for_vfork_done(p, &vfork))

ptrace_event_pid(PTRACE_EVENT_VFORK_DONE, pid);

}

put_pid(pid);

} else {

nr = PTR_ERR(p);

}

return nr;

}-

调用copy_process为子进程复制出一份进程信息

-

如果是vfork(设置了CLONE_VFORK和ptrace标志)初始化完成处理信息

-

调用wake_up_new_task()将子进程加入调度器,为之分配CPU. 计算此进程的优先级和其他调度参数,将新的进程加入到进程调度队列并设此进程为可被调度的,以后这个进程可以被进程调度模块调度执行。

-

如果是vfork,父进程等待子进程完成exec替换自己的地址空间

10.2 copy_process流程

fork的大部分事情,它主要完成讲父进程的运行环境复制到新的子进程,比如信号处理、文件描述符和进程的代码数据等。

-

dup_task_struct()复制当前的task_struct, 并为其分配了新的堆栈.分配一个新的进程控制块,包括新进程在kernel中的堆栈。新的进程控制块会复制父进程的进程控制块,但是因为每个进程都有一个kernel堆栈,新进程的堆栈将被设置成新分配的堆栈

-

检查进程数是否超过限制,两个因素:操作系统和内存大小

-

初始化自旋锁、挂起信号、CPU定时器等

-

调用sched_fork()初始化进程数据结构,并把进程状态设置为TASK_RUNNING. 设置子进程调度相关的参数,即子进程的运行CPU、初始时间片长度和静态优先级等

-

copy_semundo()复制父进程的semaphore undo_list到子进程

-

copy_files()、copy_fs()复制父进程文件系统相关的环境到子进程

-

copy_sighand()、copy_signal()复制父进程信号处理相关的环境到子进程

-

copy_mm()复制父进程内存管理相关的环境到子进程,包括页表、地址空间和代码数据

-

copy_thread_tls()中将父进程的寄存器上下文复制给子进程,保证了父子进程的堆栈信息是一致的. 设置子进程的执行环境,如子进程运行时各CPU寄存器的值、子进程的kernel栈的起始地址

-

将ret_from_fork的地址设置为eip寄存器的值

-

为新进程分配并设置新的pid

-

将子进程加入到全局的进程队列中

-

设置子进程的进程组ID和对话期ID等

-

最终子进程从**ret_from_fork!!!**开始执行

简单的说,copy_process()就是将父进程的运行环境复制到子进程并对某些子进程特定的环境做相应的调整。

10.2.1 dup_task_struct()产生新的task_struct

-

调用alloc_task_struct_node分配一个task_struct节点

-

调用alloc_thread_info_node分配一个thread_info节点,其实是分配了一个thread_union联合体,将栈底返回给ti

union thread_union {

struct thread_info thread_info;

unsigned long stack[THREAD_SIZE/sizeof(long)];

};-

最后将栈底的值ti赋值给新节点的栈

-

最终执行完dup_task_struct之后,子进程除了tsk->stack指针不同之外,全部都一样!

10.2.2 sched_fork()流程

int sched_fork(unsigned long clone_flags, struct task_struct *p)

{

unsigned long flags;

int cpu = get_cpu();

__sched_fork(clone_flags, p);

// 将子进程状态设置为 TASK_RUNNING

p->state = TASK_RUNNING;

p->prio = current->normal_prio;

if (unlikely(p->sched_reset_on_fork)) {

if (task_has_dl_policy(p) || task_has_rt_policy(p)) {

p->policy = SCHED_NORMAL;

p->static_prio = NICE_TO_PRIO(0);

p->rt_priority = 0;

} else if (PRIO_TO_NICE(p->static_prio) < 0)

p->static_prio = NICE_TO_PRIO(0);

p->prio = p->normal_prio = __normal_prio(p);

set_load_weight(p);

p->sched_reset_on_fork = 0;

}

if (dl_prio(p->prio)) {

put_cpu();

return -EAGAIN;

} else if (rt_prio(p->prio)) {

p->sched_class = &rt_sched_class;

} else {

p->sched_class = &fair_sched_class;

}

if (p->sched_class->task_fork)

p->sched_class->task_fork(p);

// 为子进程分配 CPU

set_task_cpu(p, cpu);

put_cpu();

return 0;

}我们可以看到sched_fork大致完成了两项重要工作,后续会详细说明

-

一是将子进程状态设置为TASK_RUNNING, 并设置调度相关字段

-

二是为其分配CPU

10.2.3 copy_thread和copy_thread_tls流程

如果未定义CONFIG_HAVE_COPY_THREAD_TLS宏默认则使用copy_thread同时将定义copy_thread_tls为copy_thread

单独这个函数是因为这个复制操作与其他操作都不相同,这是一个特定于体系结构的函数,用于复制进程中特定于线程(thread-special)的数据,重要的就是填充task_struct->thread的各个成员,这是一个thread_struct类型的结构, 其定义是依赖于体系结构的。它包含了所有寄存器(和其他信息!!!所有寄存器信息在thread里面!!!),内核在进程之间切换时需要保存和恢复的进程的信息。

该函数用于设置子进程的执行环境,如子进程运行时各CPU寄存器的值、子进程的内核栈的起始地址(指向内核栈的指针通常也是保存在一个特别保留的寄存器中)

32位架构的copy_thread_tls函数

[arch/x86/kernel/process_32.c]

int copy_thread_tls(unsigned long clone_flags, unsigned long sp,

unsigned long arg, struct task_struct *p, unsigned long tls)

{

struct pt_regs *childregs = task_pt_regs(p);

struct task_struct *tsk;

int err;

/* 获取寄存器的信息 */

p->thread.sp = (unsigned long) childregs;

p->thread.sp0 = (unsigned long) (childregs+1);

memset(p->thread.ptrace_bps, 0, sizeof(p->thread.ptrace_bps));

if (unlikely(p->flags & PF_KTHREAD)) {

/* kernel thread 内核线程的设置 */

memset(childregs, 0, sizeof(struct pt_regs));

p->thread.ip = (unsigned long) ret_from_kernel_thread;

task_user_gs(p) = __KERNEL_STACK_CANARY;

childregs->ds = __USER_DS;

childregs->es = __USER_DS;

childregs->fs = __KERNEL_PERCPU;

childregs->bx = sp; /* function */

childregs->bp = arg;

childregs->orig_ax = -1;

childregs->cs = __KERNEL_CS | get_kernel_rpl();

childregs->flags = X86_EFLAGS_IF | X86_EFLAGS_FIXED;

p->thread.io_bitmap_ptr = NULL;

return 0;

}

/* 将当前寄存器信息复制给子进程 */

*childregs = *current_pt_regs();

/* 子进程 eax 置 0,因此fork 在子进程返回0 */

childregs->ax = 0;

if (sp)

childregs->sp = sp;

/* 子进程ip设置为ret_from_fork,因此子进程从ret_from_fork开始执行 */

p->thread.ip = (unsigned long) ret_from_fork;

task_user_gs(p) = get_user_gs(current_pt_regs());

p->thread.io_bitmap_ptr = NULL;

tsk = current;

err = -ENOMEM;

if (unlikely(test_tsk_thread_flag(tsk, TIF_IO_BITMAP))) {

p->thread.io_bitmap_ptr = kmemdup(tsk->thread.io_bitmap_ptr,

IO_BITMAP_BYTES, GFP_KERNEL);

if (!p->thread.io_bitmap_ptr) {

p->thread.io_bitmap_max = 0;

return -ENOMEM;

}

set_tsk_thread_flag(p, TIF_IO_BITMAP);

}

err = 0;

/* 为进程设置一个新的TLS */

if (clone_flags & CLONE_SETTLS)

err = do_set_thread_area(p, -1,

(struct user_desc __user *)tls, 0);

if (err && p->thread.io_bitmap_ptr) {

kfree(p->thread.io_bitmap_ptr);

p->thread.io_bitmap_max = 0;

}

return err;

}这里解释了两个相当重要的问题!

一是,为什么fork在子进程中返回0!!!,原因是childregs->ax = 0;这段代码将子进程的 eax 赋值为0!!!

二是,p->thread.ip = (unsigned long) ret_from_fork;将子进程的 ip 设置为 ret_form_fork 的首地址,因此子进程是从ret_from_fork 开始执行的!!!

11 用户程序结束进程

应用程序使用系统调用exit()来结束一个进程,此系统调用接受一个退出原因代码,父进程可以使用wait()系统调用来获取此退出代码,从而知道子进程退出的原因。

对应到kernel,此系统调用sys_exit_group(),它的基本流程如下:

-

将信号SIGKILL加入到其他线程的信号队列中,并唤醒这些线程。

-

此线程执行do_exit()来退出。

do_exit()完成线程退出的任务,其主要功能是将线程占用的系统资源释放,do_exit()的基本流程如下:

-

将进程内存管理相关的资源释放

-

将进程ICP semaphore相关资源释放

-

__exit_files()、__exit_fs()将进程文件管理相关的资源释放。

-

exit_thread()只要目的是释放平台相关的一些资源。

-

exit_notify()在Linux中进程退出时要将其退出的原因告诉父进程,父进程调用wait()系统调用后会在一个等待队列上睡眠。

-

schedule()调用进程调度器,因为此进程已经退出,切换到其他进程。

12 进程状态变化过程

进程的创建到执行过程如下图所示

13 内核线程

内核线程就是内核的分身,一个分身可以处理一件特定事情。内核线程的调度由内核负责,一个内核线程处于阻塞状态时不影响其他的内核线程,因为其是调度的基本单位。

内核线程只运行在内核态

因此,它只能使用大于PAGE_OFFSET(传统的x86_32上是3G)的地址空间(!!!)。

13.1 概述

内核线程是直接由内核本身启动的进程。内核线程实际上是将内核函数委托给独立的进程,它与内核中的其他进程"并行"执行。内核线程经常被称之为内核守护进程。

他们执行下列任务

-

周期性地将修改的内存页与页来源块设备同步

-

如果内存页很少使用,则写入交换区

-

管理延时动作, 如2号进程接手内核进程的创建

-

实现文件系统的事务日志

内核线程主要有两种类型

-

线程启动后一直等待,直至内核请求线程执行某一特定操作。

-

线程启动后按周期性间隔运行,检测特定资源的使用,在用量超出或低于预置的限制时采取行动。

内核线程由内核自身生成,其特点在于

-

它们在CPU的管态执行,而不是用户态。

-

它们只可以访问虚拟地址空间的内核部分(高于TASK_SIZE的所有地址),但不能访问用户空间

内核线程和普通的进程间的区别在于内核线程没有独立的地址空间,mm指针被设置为NULL;它只在内核空间运行,从来不切换到用户空间去;并且和普通进程一样,可以被调度,也可以被抢占。

13.2 内核线程的创建

13.2.1 创建内核线程接口

内核线程可以通过两种方式实现:

- kernel_thread和daemonize

将一个函数传递给kernel_thread创建并初始化一个task,该函数接下来负责帮助内核调用daemonize已转换为内核守护进程

- kthead_create和kthread_run

创建内核更常用的方法是辅助函数kthread_create,该函数创建一个新的内核线程。最初线程是停止的,需要使用wake_up_process启动它。

使用kthread_run,与kthread_create不同的是,其创建新线程后立即唤醒它,其本质就是先用kthread_create创建一个内核线程,然后通过wake_up_process唤醒它

13.2.2 2号进程kthreadd

见前面2号进程的创建.

参见kthreadd函数, 它会循环的是查询工作链表static LIST_HEAD(kthread_create_list)中是否有需要被创建的内核线程

我们的通过kthread_create执行的操作, 只是在内核线程任务队列kthread_create_list中增加了一个create任务, 然后会唤醒kthreadd进程来执行真正的创建操作

内核线程会出现在系统进程列表中,但是在ps的输出中进程名command由方括号包围, 以便与普通进程区分。

如下图所示, 我们可以看到系统中,所有内核线程都用[]标识,而且这些进程父进程id均是2, 而2号进程kthreadd的父进程是0号进程

13.2.3 kernel_thread()创建内核线程

kernel_thread()的实现经历过很多变革

早期的kernel_thread()执行更底层的操作, 直接创建了task_struct并进行初始化,

引入了kthread_create和kthreadd 2号进程后, kernel_thread()的实现也由统一的_do_fork(或者早期的do_fork)托管实现

14 可执行程序的加载和运行

fork, vfork等复制出来的进程是父进程的一个副本, 那么如何我们想加载新的程序, 可以通过execve系统调用来加载和启动新的程序。

在Linux中提供了一系列的函数,这些函数能用可执行文件所描述的新上下文代替进程的上下文。这样的函数名以前缀exec开始。所有的exec函数都是调用了execve()系统调用。

14.1 exec()函数族

exec函数一共有六个,其中execve为内核级系统调用,其他(execl,execle,execlp,execv,execvp)都是调用execve的库函数。

int execl(const char *path, const char *arg, ...);

int execlp(const char *file, const char *arg, ...);

int execle(const char *path, const char *arg,

..., char * const envp[]);

int execv(const char *path, char *const argv[]);

int execvp(const char *file, char *const argv[]);14.2 可执行程序相关数据结构

Linux下标准的可执行文件格式是ELF. ELF(Executable and Linking Format)是一种对象文件的格式, 作为缺省的二进制文件格式来使用.

linux也支持其他不同的可执行程序格式, 各个可执行程序的执行方式不尽相同, 因此linux内核每种被注册的可执行程序格式都用linux_bin_fmt来存储, 其中记录了可执行程序的加载和执行函数

同时我们需要一种方法来保存可执行程序的信息,比如可执行文件的路径,运行的参数和环境变量等信息,即linux_binprm结构

14.2.1 struct linux_binprm结构描述一个可执行程序的信息

struct linux_binprm保存要执行的文件相关的信息, 包括可执行程序的路径, 参数和环境变量的信息

[include/linux/binfmts.h]

struct linux_binprm {

char buf[BINPRM_BUF_SIZE]; // 保存可执行文件的头128字节

#ifdef CONFIG_MMU

struct vm_area_struct *vma;

unsigned long vma_pages;

#else

# define MAX_ARG_PAGES 32

struct page *page[MAX_ARG_PAGES];

#endif

struct mm_struct *mm;

/* current top of mem , 当前内存页最高地址*/

unsigned long p;

unsigned int

cred_prepared:1,

cap_effective:1;

#ifdef __alpha__

unsigned int taso:1;

#endif

unsigned int recursion_depth;

/* 要执行的文件 */

struct file * file;

struct cred *cred; /* new credentials */

int unsafe;

unsigned int per_clear;

/* 命令行参数和环境变量数目 */

int argc, envc;

// 要执行的文件的名称

const char * filename;

// 要执行的文件的真实名称,通常和filename相同

const char * interp;

unsigned interp_flags;

unsigned interp_data;

unsigned long loader, exec;

};14.2.2 struct linux_binfmt可执行格式的结构

linux内核对所支持的每种可执行的程序类型(!!!)都有个struct linux_binfmt的数据结构,定义如下

[include/linux/binfmts.h]

struct linux_binfmt {

struct list_head lh;

struct module *module;

int (*load_binary)(struct linux_binprm *);

int (*load_shlib)(struct file *);

int (*core_dump)(struct coredump_params *cprm);

unsigned long min_coredump; /* minimal dump size */

};其提供了3种方法来加载和执行可执行程序

- load_binary

通过读存放在可执行文件中的信息为当前进程建立一个新的执行环境

- load_shlib

用于动态的把一个共享库捆绑到一个已经在运行的进程, 这是由uselib()系统调用激活的

- core_dump

在名为core的文件中, 存放当前进程的执行上下文.这个文件通常是在进程接收到一个缺省操作为"dump"的信号时被创建的, 其格式取决于被执行程序的可执行类型

所有的linux_binfmt对象都处于一个链表中,第一个元素的地址存放在formats变量!!!中,可以通过调用register_binfmt()和unregister_binfmt()函数在链表中插入和删除元素,在系统启动期间,为每个编译进内核的可执行格式都执行registre_fmt()函数.当实现了一个新的可执行格式的模块正被装载时,也执行这个函数,当模块被卸载时, 执行unregister_binfmt()函数.

当我们执行一个可执行程序的时候,内核会list_for_each_entry遍历所有注册的linux_binfmt对象,对其调用load_binrary方法来尝试加载, 直到加载成功为止.

14.3 execve加载可执行程序的过程

内核中实际执行execv()或execve()系统调用的程序是do_execve()

这个函数先打开目标映像文件,

并从目标文件的头部(第一个字节开始)读入若干(当前Linux内核中是128)字节(实际上就是填充ELF文件头,下面的分析可以看到),

然后调用另一个函数search_binary_handler(),在此函数里面,它会搜索我们上面提到的Linux支持的可执行文件类型队列,让各种可执行程序的处理程序前来认领和处理。

在每种可执行文件类型中, 调用load_binary函数指针所指向的处理函数来处理目标映像文件。在ELF文件格式中,处理函数是load_elf_binary函数:

sys_execve() > do_execve() > do_execveat_common() > search_binary_handler() > load_elf_binary()

14.4 execve的入口函数sys_execve

| 描述 | 定义 | 链接 |

|---|---|---|

| 系统调用号(体系结构相关) | 类似与如下的形式 #define __NR_execve 117 __SYSCALL(117, sys_execve, 3) |

arch/对应体系结构/include/uapi/asm/unistd.h |

| 入口函数声明 | asmlinkage long sys_execve(const char __user *filename, const char __user *const __user *argv, const char __user *const __user *envp); | include/linux/syscalls.h |

| 系统调用实现 | SYSCALL_DEFINE3(execve, const char __user *, filename, const char __user *const __user *, argv, const char __user *const __user *, envp){ return do_execve(getname(filename), argv, envp); } |

fs/exec.c |

execve系统调用的的入口点是体系结构相关的sys_execve,该函数很快将工作委托给系统无关的do_execve()函数

[fs/exec.c]

SYSCALL_DEFINE3(execve,

const char __user *, filename,

const char __user *const __user *, argv,

const char __user *const __user *, envp)

{

return do_execve(getname(filename), argv, envp);

}| 参数 | 描述 |

|---|---|

| filename | 可执行程序的名称 |

| argv | 程序的参数字符串 |

| envp | 环境变量字符串 |

指向程序参数argv和环境变量envp两个数组的指针以及数组中所有的指针都位于虚拟地址空间的用户空间部分。因此内核在访问用户空间内存时,需要多加小心,而__user注释则允许自动化工具来检测时候所有相关事宜都处理得当

14.5 do_execve函数

-

早期linux-2.4中直接由do_execve实现程序的加载和运行

-

linux-3.18do_execve调用do_execve_common来完成程序的加载和运行

-

linux-3.19~至今引入execveat之后do_execve调用do_execveat_common来完成程序的加载和运行

在Linux中提供了一系列的函数,这些函数能用可执行文件所描述的新上下文代替进程的上下文。这样的函数名以前缀exec开始。所有的exec函数都是调用了execve()系统调用。

sys_execve是调用do_execve实现的。do_execve()则是调用do_execveat_common()实现的,在文件[fs/exec.c]中

依次执行以下操作:

-

调用unshare_files()为进程复制一份文件表

-

调用kzalloc()在堆上分配一份struct linux_binprm结构体

-

调用open_exec()查找并打开二进制文件

-

调用sched_exec()找到最小负载的CPU,用来执行该二进制文件

-

根据获取的信息,填充struct linux_binprm结构体中的file、filename、interp成员

-

调用bprm_mm_init()创建进程的内存地址空间,为新程序初始化内存管理.并调用init_new_context()检查当前进程是否使用自定义的局部描述符表;如果是,那么分配和准备一个新的LDT(!!!)

-

填充struct linux_binprm结构体中的argc、envc成员

-

调用prepare_binprm()检查该二进制文件的可执行权限;最后,kernel_read()读取二进制文件的头128字节(这些字节用于识别二进制文件的格式及其他信息,后续会使用到)

-

调用copy_strings_kernel()从内核空间获取二进制文件的路径名称

-

调用copy_string()从用户空间拷贝环境变量和命令行参数

-

至此,二进制文件已经被打开,struct linux_binprm结构体中也记录了重要信息

-

内核开始调用exec_binprm()识别该二进制文件的格式并执行可执行程序, 得到执行的返回结果retval

-

释放linux_binprm数据结构,返回从该文件可执行格式的load_binary中获得的代码

-

将执行结果retval返回

14.6 exec_binprm()识别并加载二进程程序

每种格式的二进制文件对应一个struct linux_binprm结构体,每种可执行的程序类型都对应一个数据结构struct linux_binfmt, 其中的load_binary成员负责识别该二进制文件的格式;

内核使用链表组织这些struct linux_binfmt结构体,链表头是formats。

接着do_execveat_common()中的exec_binprm()继续往下看:

[fs/exec.c]

static int exec_binprm(struct linux_binprm *bprm)

{

pid_t old_pid, old_vpid;

int ret;

/* Need to fetch pid before load_binary changes it */

old_pid = current->pid;

rcu_read_lock();

old_vpid = task_pid_nr_ns(current, task_active_pid_ns(current->parent));

rcu_read_unlock();

ret = search_binary_handler(bprm);

if (ret >= 0) {

audit_bprm(bprm);

trace_sched_process_exec(current, old_pid, bprm);

ptrace_event(PTRACE_EVENT_EXEC, old_vpid);

proc_exec_connector(current);

}

return ret;

}调用search_binary_handler()函数对linux_binprm的formats链表进行扫描,并尝试每个load_binary()函数,如果成功加载了文件的执行格式,对formats的扫描终止。

14.7 search_binary_handler()识别二进程程序

[include/linux/platform_data/simplefb.h]

#define SIMPLEFB_FORMATS \

{ \

{ "r5g6b5", 16, {11, 5}, {5, 6}, {0, 5}, {0, 0}, DRM_FORMAT_RGB565 }, \

{ "x1r5g5b5", 16, {10, 5}, {5, 5}, {0, 5}, {0, 0}, DRM_FORMAT_XRGB1555 }, \

{ "a1r5g5b5", 16, {10, 5}, {5, 5}, {0, 5}, {15, 1}, DRM_FORMAT_ARGB1555 }, \

{ "r8g8b8", 24, {16, 8}, {8, 8}, {0, 8}, {0, 0}, DRM_FORMAT_RGB888 }, \

{ "x8r8g8b8", 32, {16, 8}, {8, 8}, {0, 8}, {0, 0}, DRM_FORMAT_XRGB8888 }, \

{ "a8r8g8b8", 32, {16, 8}, {8, 8}, {0, 8}, {24, 8}, DRM_FORMAT_ARGB8888 }, \

{ "a8b8g8r8", 32, {0, 8}, {8, 8}, {16, 8}, {24, 8}, DRM_FORMAT_ABGR8888 }, \

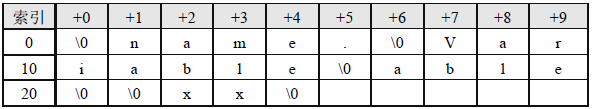

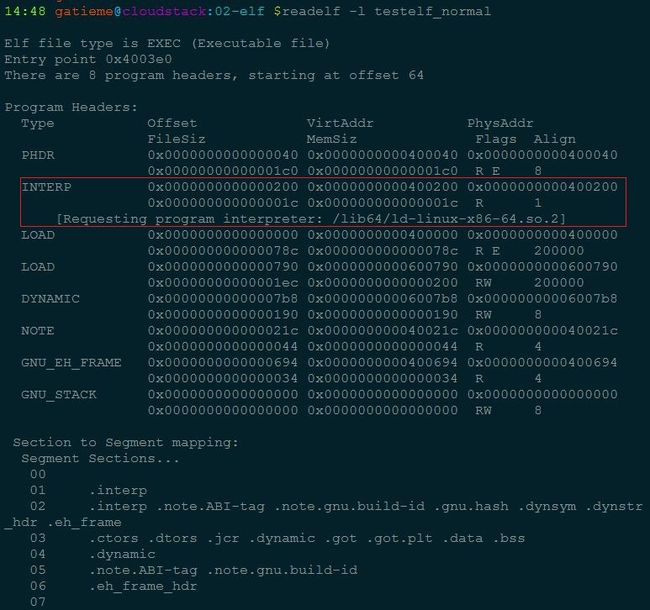

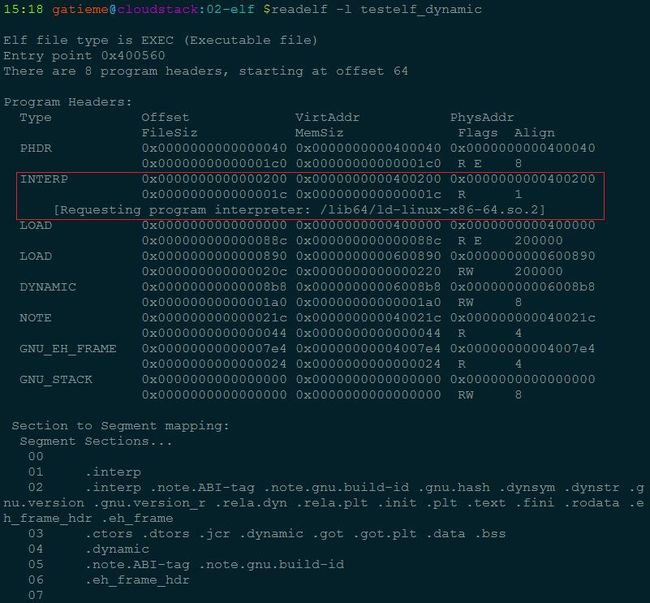

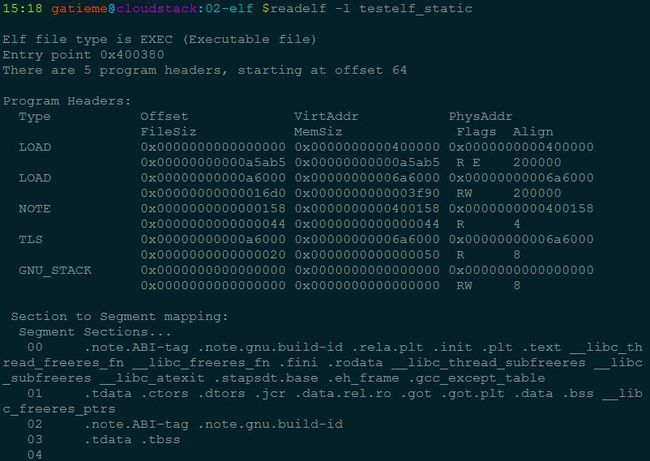

{ "x2r10g10b10", 32, {20, 10}, {10, 10}, {0, 10}, {0, 0}, DRM_FORMAT_XRGB2101010 }, \