一文读懂多帧超分辨率来龙去脉2019

人类消除不了混叠信息,最后逼出了多帧超分。

1 为什么要超分?

与单反相机相比,智能手机相机的传感器更小,这限制了它们的空间分辨率;更小的光圈,限制了它们的聚光能力;更小的像素,这降低了他们的信噪比。实际获得的低分辨率图像可以认为是利用光学成像设备对原始高分辨率场景进行观测的结果,而观测过程不可避免的会受到镜头光学模糊、欠釆样、噪声等降质因素的影响。

2 为什么要多帧超分?

因为图像在成像时,发生了欠采样(传感器像素大于细节所需要的像素,也就是采样率没有达到奈奎斯特频率。),导致我们获得图像存在混叠现象。即存在显示为虚假低频的高频,规则的虚假低频也就是大家常见的摩尔纹。既然图像中存在高频部分信息,那么我就得想办法把它提炼出来,最终得到一张高分辨率图像。另外一个原因是拜尔滤色镜:光达到传感器时,因为在每个像素位置只能记录一个颜色,因此滤色镜将其他信息过滤掉了。

3 为什么需要基于CNN的多帧超分?

尽管从采样定理方面分析,足够多的低分辨率图像有可能可以重建出高分辨率图像。但是现实很残酷,因为还有受到噪声,未知模糊等干扰,那么被噪声和模糊破坏的高频信息咋办。因此要想重建高分辨率图像,基本条件是多帧之间存在亚像素偏移。后期如何精准的对齐,以及如何解决多帧之间存在的遮挡,场景变化都是影响最终的效果。在空间域方法中,基于正则化的方法是最有效的多帧SR重建方法之一。由于SR重构是一个不适定的逆问题,因此关键技术是通过将先验知识整合到SR重构过程中来获得一个稳定的解。传统方法大多通过先验假设加迭代求解。求解能力有限。深度学习可能是一种更好的选择。

4 多帧超分为什么是一个不适定的逆问题?

确定性分量包含了所有的低频信号以及部分与低频信号高度相关的高频信号,这意味着确定性分量中的高频信号仍然可以从下采样图像中的低频信号中恢复。随机分量包含与低频信号相关性很小的其余信号。正是随机分量使得图像超分辨率不适定。

5 为什么说图像存在混叠?

奈奎施特频率:在只有采样频率大于实际频率的二倍的时候我们才能完整的还原出一个信号。同样,对于二维的空间采样来说,要想避免混叠信息(摩尔纹),就需要采样频率(传感器分辨率)达到空间频率(镜头分辨率,影像中条纹的空间频率)的二倍。

如何避免混叠:目前镜头分辨率都比较高,但是传感器的分辨率难以达到镜头分辨率的二倍,因此只能牺牲镜头分辨率, 因此在镜头与传感器之间添加低通滤镜。现实是残酷的,理想的低通滤波在实际不存在的。一般还是会存在混叠的,尤其是当被拍摄的图像是规则的细纹理,这种情况就更容易出现摩尔纹。

苹果iPhone X、谷歌Pixel 3等主流手机主摄像头的采样率在1.5 ~ 1.8(亮度通道)之间,低于临界采样率2。

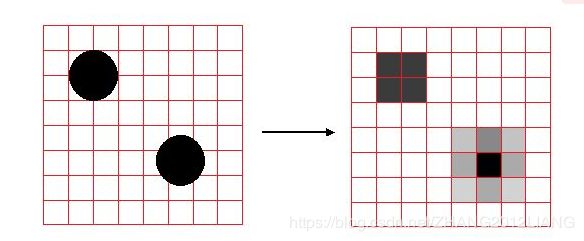

图像有混叠信息:即有高频信息残留,传感器像素面积大于细节所需要表示的像素,因此需要平均,导致这个高频被显示为虚假的低频。如下图,左边是高频细节圆,除非这个正方形足够小,使得每一个正方形刚刚填满,不用与旁边取均值,这时采样率才够。

所以一般拍照不希望有混叠信息,担心出现类似摩尔纹这种东西。但是多帧超分正是利用这种混频信息来重建高频信息,不可为解决不了你,只能使用你了。

6 多帧超分需要两个基本条件?(Tsai[1984]的工作开创了超分辨率的现代概念)

- 输入帧需要包含图像混叠(image aliased),即其包含采样后显示为虚假低频的高频信息(如莫尔条纹)

- 输入的多帧混叠图像是在不同的亚像素位置被采样的,这将表现为输入帧中虚假低频的不同相位。

7 为什么输入帧之间需要亚像素偏移?

本质上来讲从多帧低分辨率图像中进行超分辨率重建是个Inference的问题,高分辨率图像中的细节信息在下采样的成低分辨率帧的时候导致了丢失,然而抖动带来的位移相当于给了多一个维度的信息让我们可以通过算法对信息进行恢复,从某种意义上讲抖动保存了原来图像的细节信息。如果抖动的范围完美覆盖了一个像素周期以内的所有区域,并且每一帧都采样到了这个区域内的所有的点的话,那么理论上是可以恢复出高分辨率图像的,然而通常情况并非如此。

整像素偏移,只能完全去噪用了。

8 多帧超分需要克服那些问题,不然适得其反?

亚像素配准问题,局部运动,遮挡,或场景变化,这些复杂场景影响对齐,以及最后的融合。因此没有处理好这些,结果反而不好。还不如单帧超分。

运动的鲁棒性,对任意序列的图像进行可靠对齐是极具挑战性的,理论和实践不允许。因此基于局部像素统计得到一个权重图。这个权重图的重点是区分(混频区域)和对齐失败区域。混频区域具有一定特征(容易产生混叠的区域也有很大的空间差异)。与参考帧直接的颜色差异小于局部标准差的区域视为无混叠,可以合并来去噪;颜色差异与局部方差差不多可以认为是混频区域,可以合并来SR。颜色差异大于局部方差可采用去鬼影。当然具体还有很多优化操作,可见论文。

9 为什么去拜耳滤镜进一步退化了图像信息?

去马赛克即为使用临近像素来重建缺失的色彩信息的过程。在典型的消费级相机中,相机传感器元件仅用于测量光的强度,而不是直接测量其颜色。为了捕捉场景中存在的真实颜色,相机使用放置在传感器前面的滤色镜阵列,以便每个像素仅测量单一颜色(红色,绿色或蓝色)。通过对缺失的色彩信息进行最佳猜测,通常通过从附近像素中的色彩进行插值来进行去马赛克,这意味着 RGB数码照片三分之二的像素实际上是重建而来。这也是流行Raw域的多帧超分。例如今年一篇mean shoot,多帧raw进行超分。

10 如何实现去噪和超分辨率权衡?

一个实用的超分辨率算法需要注意到这种噪声,并正确地消除它们。我们不希望得到更高分辨率但充满噪声的图像——我们的目标是既增加分辨率又减少噪声的结果。

11为什么需要真实超分?

人们开始通过长远焦或者远近拍摄来构建真实的超分数据,即退化模型不再是通过下采样和上采样来构建数据集或者人为进行模糊,强调视场变化FOV才是超分需要恢复的退化。从发的论文来看,重点在于如果构造数据集,其中最关键的就是如何将远近数据进行对齐。要考虑亮度变化,噪声变化,透视变换,色调变化等。在实验室环境控制这些条件尚且困难,更不用说在真实环境中了。而且不同的视场变化FOV代表不同的退化程度,模型如何去泛化。

对齐:特征点对齐,光流对齐,强度对齐,色调对齐等……一个深度学习方法又转成传统图像处理了。一些论文尝试通过STN或者一些光流网络来进行对齐。

推荐文章:

Handheld Multi-Frame Super-Resolution SIGGRAPH 2019

Image Super-Resolution via Deterministic-Stochastic Synthesis and Local Statistical Rectification 2018