“深度学习”这十年:52篇大神级论文再现AI荣与光

随着2020年的到来,人类进入了一个崭新的十年。回顾过去10年,深度学习领域取得的巨大进步。随着计算能力的不断提高和大数据可用性的不断提高,深度学习已经成功地解决了许多以前难以解决的问题,特别是在计算机视觉和自然语言处理领域。深度学习也开始在现实世界中应用,从自动驾驶汽车和医学成像到虚拟助手和deepfake,或多或少都在影响我们。

今天和大家分享的这篇文章概述了过去十年中一些最有影响力的深度学习论文,受到了reddit网友们的高赞。

2011年:Yoshua Bengio等人提出ReLU激活函数,为更深层次网络铺平了道路

Deep Sparse Rectifier Neural Networks (被引4071次)

ReLU和Softplus

Yoshua Bengio等人的这篇论文提出了ReLU激活函数,ReLU激活函数的表现能力比tanh激活函数的更加好,训练完毕的神经网络具有一定的稀疏性。本文发现,使用ReLU有助于解决梯度消失的问题,并为更深层次的网络铺平了道路。

2011年其他重要论文:

-

Rectifier Nonlinearities Improve Neural Network Acoustic Models

-

Fast and Accurate Deep Network Learning by Exponential Linear Units (ELUs)

-

Self-Normalizing Neural Networks

-

Gaussian Error Linear Units (GELUs)

2012年:Hinton指导,AlexNet轰动一时

ImageNet Classification with Deep Convolutional Neural Networks (被引52025次)

AlexNet体系结构

2012 年,在Hinton的指导下,Alex Krizhevsky和Sutskever 合作开发了轰动一时的AlexNet。这篇题为ImageNet Classification with Deep Convolutional Neural Networks的论文,引用量超50000次。

AlexNet以一种新颖的神经网络架构在NeurIPS亮相,包含五个卷积层和三个全连接层。这篇论文被广泛认为是一项真正的开创性工作,因为它首次证明了在GPU上训练的深度神经网络可以将图像识别任务提升到一个新的水平。

AlexNet网络对神经网络的发展产生了非常重要的影响,之后的ImageNet冠军全都采用了卷积神经网络结构,使得CNN架构成为图像分类的核心模型,并由此开启了深度学习新一波浪潮,其使用的卷积+池化+全连接的架构仍然是当前深度学习最主要的网络结构。

ImageNet层次结构中的图像示例

-

ImageNet: A Large-Scale Hierarchical Image Database

-

Flexible, High Performance Convolutional Neural Networks for Image Classification

-

Gradient-Based Learning Applied to Document Recognition

2013年:DQN打响DRL的第一枪

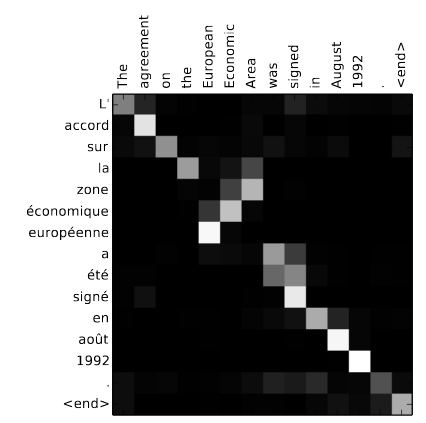

Distributed Representations of Words and Phrases and their Compositionality (被引16923次)

这篇论文是对《Efficient Estimation of Word Representations in Vector Space》的补充,介绍了使用Skip-gram模型和Hierarchical Softmax训练模式的训练方法,并补充了Negative Sampling的训练模式替代Negative Sampling,获得更快的训练效果。本文还提出了对高频词进行二次抽样的方法,以及衡量短语的方法,学习短语的表示。

Mikolov等人引入了Skip-gram模型,这是一种从大量非结构化文本数据中学习高质量向量表示的有效方法。与过去大部分用于学习word vectors的神经网络架构不同,Skip-gram模型的训练不涉及密集矩阵的乘法。这使得训练非常高效:一个优化过的单机实现可以在一天内训练超过1000亿字。

Playing Atari with Deep Reinforcement Learning (被引3251次)

DeepMind Atari DQN

DeepMind的Atari DQN的结果开启了深度强化学习的领域。强化学习以前主要用于网格世界等低维环境,很难应用于更复杂的环境。Atari是强化学习在高维环境中的第一个成功应用,它将强化学习从从默默无闻带到了AI的重要子领域。

本文提出了一种深度学习方法,利用强化学习的方法,直接从高维的感知输入中学习控制策略。模型是一个卷积神经网络,利用 Q-learning的一个变种来进行训练,输入是原始像素,输出是预测将来的奖励的 value function。将此方法应用到 Atari 2600 games 上来,进行测试,发现在所有游戏中都比之前的方法有效,甚至在其中3个游戏中超过了一个人类玩家的水平。

2013年其他重要论文:

-

GloVe: Global Vectors for Word Representation

-

Learning from Delayed Rewards

2014年:Bengio同他的博士生Ian Goodfellow合著论文,提出了著名的生成对抗网络

Generative Adversarial Networks (被引 13917次)

生成对抗网络(GAN)的走红在很大程度上要归功于其产生的惊人视觉效果。依靠生成器和判别器之间的博弈,GAN能够建模复杂的高维分布。生成器的目的是尽量降低判别器正确判断出假样本的概率,而判别器的目标是最大程度地降低图像分类和判断假样本时的错误。

在实践中,通常会训练生成器让判别器错误识别的对数概率最大化。这可以减小梯度饱和,并提高训练稳定性。

Neural Machine Translation by Jointly Learning to Align and Translate (被引 9882 次)

本文介绍了注意力的概念。与其将信息压缩到RNN的潜在空间中,不如将整个上下文保留在内存中,利用o(mn)次操作,让输出的每个元素都参与输入的每个元素。

尽管增加了计算次数,但是注意力机制要比固定状态的RNN性能更好,不仅成为翻译和语言建模等文本类任务不可或缺的一部分,而且也加入到GAN等非文本模型中。

Adam:A Method for Stochastic Optimization (被引 34082 次)

由于便于调节,Adam已成为非常流行的自适应优化器。Adam可以为每个参数单独调节学习率。尽管最近的论文对Adam的性能表示怀疑,但它仍然是目前深度学习中最受欢迎的优化算法之一。

2014年其他重要论文:

-

Wasserstein GAN & Improved Training of Wasserstein GANs

-

A Style-Based Generator Architecture for Generative Adversarial Networks

-

Decoupled Weight Decay Regularization

2015年:ResNet让何恺明正式踏上大神之路

Deep Residual Learning forImage Recognition (被引 34635次 )

深度残差学习最初设计用于解决深度卷积神经网络(CNN)中的梯度消失/梯度爆炸问题,现在,残差块已成为几乎所有CNN的基本组成部分。它的思路很简单:将输入从卷积层的每个块之前添加到输出中。残差网络背后的启示是,理论上神经网络绝不应该分解为更多的层,因为在最坏的情况下,可以将其他层简单地设置为恒等映射。

但是在实践中,更深层的网络经常会遇到训练困难的问题。残差网络使各层更容易学习恒等映射,而且缓解了梯度消失的问题。尽管思路简单,但是残差网络在很大程度上优于常规的CNN,对于较深的网络而言优势尤其明显。

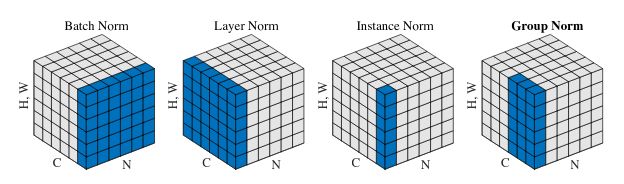

Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift (被引 14384次)

批归一化(Batch normalization)是当今几乎所有神经网络的另一支柱。它基于另一个简单而强大的思路:在训练过程中保持均值和方差统计,并使用该统计将激活范围缩放为零均值和单位方差。批归一化能够有效的确切原因尚有争议,但从过去经验看,其有效性是毫无疑问的。

2015年其他重要论文:

-

Going Deeper with Convolutions

-

Very Deep Convolutional Networks for Large-Scale Image Recognition

-

Neural Ordinary Differential Equations

-

Layer Normalization

-

Instance Normalization: The Missing Ingredient for Fast Stylization

-

Group Normalization

2016年:谷歌DeepMind团队揭秘AlphaGo

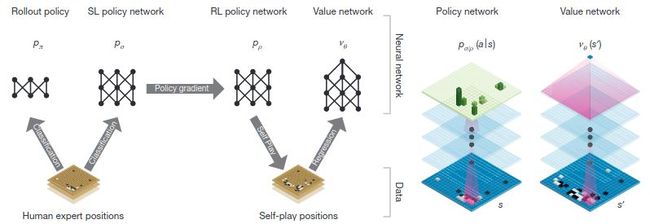

Mastering the game of Go with deep neuralnetworks and tree search (被引 6310 次)

在1997年IBM的计算机“深蓝”击败国际象棋世界冠军卡斯帕罗夫之后,围棋就成为AI社区的下一个目标,这主要是因为围棋的特点:围棋的状态空间比国际象棋大得多,对人类棋手直觉的依赖也更强。

在AlphaGo之前,最成功的AI围棋系统(如Crazy Stone和Zen)都是蒙特卡罗树搜索与许多手工启发式搜索相结合的树搜索形式。从这些系统的进展速度来看,过去认为AI在围棋上击败人类顶尖选手还要很多年。尽管确实存在将神经网络应用于围棋的先前尝试,但之前确实没有一次能达到AlphaGo的水平。AlphaGo由策略网络和价值网络组成,这些策略网络和价值网络分别缩小了搜索树的范围,并允许截断搜索树。这些网络首先通过标准的监督学习进行了训练,然后通过强化学习进行了进一步的调整。

AlphaGo可能对大众的观点产生了巨大影响,2016年,全球估计有1亿人(尤其是在围棋十分流行的中、日、韩三国)观看了AlphaGo和李世石的“人机大战”。这场比赛以及以后的其他AlphaGo Zero的比赛,已经影响了人类棋手的行棋策略。其中本次比赛第二局的第37手是AlphaGo极有影响力的一手。AlphaGo的很多行棋有违人类棋手的常规,让许多分析师感到困惑。后来证明,这一手对于AlphaGo取得胜利至关重要。

2016年其他重要论文:

-

Mastering the Game of Go without Human Knowledge

2017年:谷歌把基于Attention的序列神经模型推向高潮

Attention Is All You Need (被引 5059次)

Transformer体系结构大规模利用了上文提到的注意力机制,现在已成为几乎所有最新NLP模型的基础。Transformer模型在很大程度上优于RNN,这是因为在超大型网络中前者具有计算成本上的优势。

在RNN中,需要在整个“展开”的图中传播梯度,这使内存访问成为一个很大的瓶颈,也让梯度爆炸/梯度消失梯度问题更加严重,因此需要更复杂(且计算量更大)的LSTM和GRU模型。

相比之下,Transformer模型针对高度并行处理进行了优化。计算成本最高的部分是注意力层之后的前馈网络(可以并行化应用)和注意力层本身(大矩阵乘法,很容易优化)。

Neural Architecture Search with Reinforcement Learning (被引1186次)

神经架构搜索(NAS)已成为“榨干”最后一点网络性能的普遍方式。NAS无需手动设计架构,而是让这个过程实现自动化。本文使用强化学习对控制器网络进行了训练,以生成高性能的网络架构,从而创建了许多SOTA网络。其他方法,如面向图像分类器体系结构搜索的AmoebaNet则使用进化算法。

2018年:NLP里程碑,谷歌BERT模型狂破11项纪录

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding (被引3025次)

BERT与GPT和ELMo的比较

谷歌AI团队2018年发布的BERT模型,在NLP业内引起巨大反响。BERT在机器阅读理解测试SQuAD1.1中表现出惊人的成绩:全部两个衡量指标上全面超越人类,并且还在11种不同NLP任务中创出最佳成绩,,包括将GLUE基准推至80.4%(绝对改进7.6%),MultiNLI准确度达到86.7% (绝对改进率5.6%)等。这项工作被认为是NLP领域里程碑式的进步。(详细论文解读:NLP历史突破!谷歌BERT模型狂破11项纪录,全面超越人类!)

2018年其他重要论文:

-

Deep contextualized word representations

-

Improving Language Understanding by Generative Pre-Training

-

Language Models are Unsupervised Multitask Learners

-

Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context

-

XLNet: Generalized Autoregressive Pretraining for Language Understanding

-

Neural Machine Translation of Rare Words with Subword Units

2019年:MIT科学家提出彩票假设,神经网路缩小10倍并不影响结果

Deep Double Descent: Where Bigger Models and More Data Hurt

Deep Double Descent

在这篇论文中,哈佛大学联合 OpenAI 提出了泛化的双重下降假设,即当模型和训练过程的有效模型复杂性与训练样本数量相当时,它们会呈现出非典型的行为。

研究者证明,各种现代深度学习任务都表现出「双重下降」现象,并且随着模型尺寸的增加,性能首先变差,然后变好。此外,他们表明双重下降不仅作为模型大小的函数出现,而且还可以作为训练时间点数量的函数。研究者通过定义一个新的复杂性度量(称为有效模型复杂性,Effective Model Complexity)来统一上述现象,并针对该度量推测一个广义的双重下降。此外,他们对模型复杂性的概念使其能够确定某些方案,在这些方案中,增加(甚至四倍)训练样本的数量实际上会损害测试性能。

The Lottery Ticket Hypothesis: Finding Sparse, Trainable Neural Networks

这篇来自MIT的论文获得了ICLR 2019最佳论文。神经网络剪枝技术可以在不影响精度的前提下,将训练网络的参数数量减少 90% 以上,降低存储需求并提高推理的计算性能。然而,当前的经验是,剪枝产生的稀疏架构从一开始就很难训练,这同样可以提高训练性能。

研究者发现,一种标准的剪枝技术可以自然地揭示子网络,这些子网络的初始化使它们能够有效地进行训练。基于这些结果,研究者提出了 “彩票假设”(lottery ticket hypothesis):包含子网络 (“中奖彩票”,winning tickets) 的密集、随机初始化的前馈网络,这些子网络在单独训练时,经过类似次数的迭代达到与原始网络相当的测试精度。研究者找到的 “中奖彩票” 中了初始化彩票:它们的连接具有初始权重,这使得训练特别有效。

原文链接:

https://leogao.dev/2019/12/31/The-Decade-of-Deep-Learning/