CVPR 2020最新热点:物体位姿估计

![]()

©PaperWeekly 原创 · 作者|文永明

学校|中山大学硕士生

研究方向|物体位姿估计、目标检测

目录

G2L-Net:从全局到局部的 6D 位姿估计网络

PVN3D:3D 关键点投票 6D 姿态估计网络

基于可微分代理投票损失的 6D 姿态估计

![]()

G2L-Net

论文标题:G2L-Net: Global to Local Network for Real-time 6D Pose Estimation with Embedding Vector Features

论文来源:CVPR 2020

论文链接:https://arxiv.org/abs/2003.11089

代码链接:https://github.com/DC1991/G2L_Net

第一篇推荐的 CVPR 2020 论文来自伯明翰大学和国防科技大学,提出了一种新的实时 6D 目标姿态估计框架 G2L-Net,该网络在 RGB-D 探测的点云上以分治的方式运行,能节省时间,并且能达到 SOTA 的效果。这篇论文很好的是已经把代码开源放了出来。

该位姿估计模型框架流程可以分为以下三步:

第一步先从目标物体的 RGB-D 图像获得粗糙的点云。

第二步把目标物体的点云传进平移定位网络,进一步进行 3D 语义分割和估计目标物体的平移。

第三步把经过语义分割和平移后得到精细的点云转换到局部标准坐标系,用旋转定位网络来训练队点向嵌入特征估计物体的旋转。

▲ Fig 1. G2L-Net的框架示意图

笔者认为这篇文章特别之处在于两点,他们的点向嵌入特征充分利用了不同视角的信息从而提高了精度。之前大部分位姿估计模型包括 DenseFusion,它们的 refine 阶段估计得位姿是异步的,也就是先训练好粗略旋转的网络,进一步再去训练细化这个旋转。

而这篇论文另辟蹊径在旋转定位网络中估计的粗略旋转与旋转残差估计网络估计的旋转残差同步输出,从而节省了运行时间。

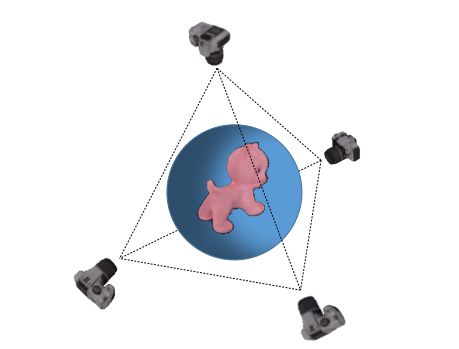

▲ Fig 2. 不同视点(对于一个3D物体,需要至少四个四点来覆盖)

充分利用不同视角信息的想法是来自他们发现在不同视角下全局特征是高度相关高度相似的,这限制了泛化性能,在实验部分就可以表明,在相同大小规模的数据集中,使用点向嵌入特征,由于引入的视角信息,能提高泛化能力。

▲ Fig 3. (a)相同数据规模下,G2L-Net与Frustum-P的ADD-(s)指标对比 (b)训练轮次的影响

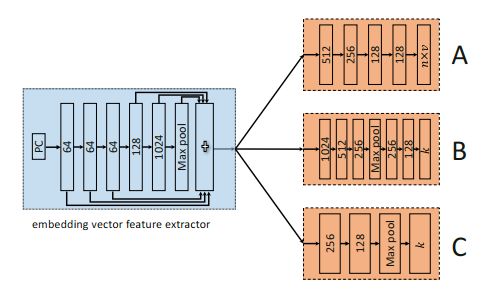

其中的旋转定位网络由三个部分组成,如图 4 所示,先训练 A 结构的网络来预测指向关键点的单位向量,再用 B 结构来生成对于物体旋转估计的点向嵌入向量,再用 C 结构的网络来训练旋转残差。

▲ Fig 4. 旋转定位网络的结构

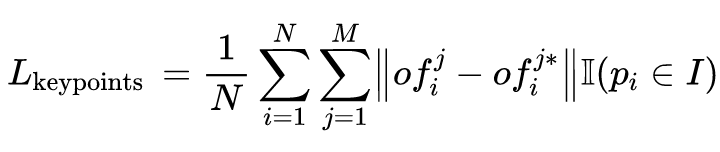

对于旋转定位网络,论文指出我们可以定义如下的损失函数:

其中 表示关键点的数量, 表示网络参数, 和 表示预测的向量和目标真实值, 表示物体点云的标准坐标空间, 则是点的数目。

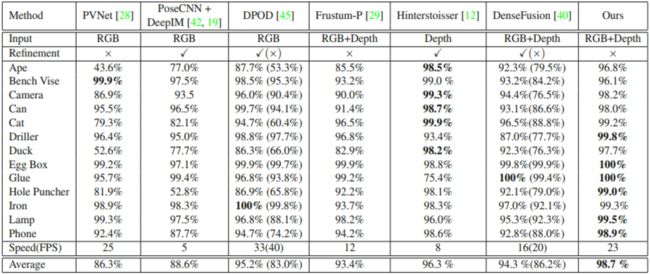

最后来看看在 LINEMOD 数据集上的实验效果:

▲ Fig 5. G2L-Net实验效果

效果看起来真的很好了,ADD 指标达到了 98.7,FPS 是 23 倒是可以接受。笔者准备后续参考 github 公开的代码实验一番,看看到底是否真的能达到论文所说的这么好的效果来。

![]()

PVN3D

论文标题:PVN3D: A Deep Point-wise 3D Keypoints Voting Network for 6DoF Pose Estimation

论文来源:CVPR 2020

论文链接:https://arxiv.org/abs/1911.04231

代码链接:https://github.com/ethnhe/PVN3D

这是一项港科大、深大还有旷视研究院合作的工作,将基于 2D 关键点的方法引入到 3D 位姿估计中,提出一种基于霍夫投票的 3D 关键点检测网络,利用了刚体的几何约束,提高了 6D 姿态估计的精确度。这篇论文代码也已经开源啦,有兴趣的同学可以去看看。

▲ Fig 6. PVN3D总框架

以 RGBD 图像为输入,使用特征提取模块融合外观特征和几何信息。将学习到的特征输入三维关键点检测模块 , 经过训练可以预测每个点的偏移量。此外,还是用了实例语义分割模块 预测每个点的语义标签,而中心投票模块 预测每个点到对象中心的偏移量。

通过学习每个点的偏移量,使用聚类算法来区分具有相同语义标签的不同实例和相同实例上的点对目标关键点进行投票。最后,将最小二乘拟合算法应用于预测关键点,估计出 6 自由度的位姿参数。

投票的点由聚类算法进行聚类以消除离群点的干扰,群集的中心点被选为投票选出的关键点,预测每个点偏移量的损失函数:

给定提取出的逐点特征,语义分割模块 预测每点的语义标签,论文使用了 Focal loss:

而中心点投票模块 投票出不同物体的中心点,以区分相同语义的不同实例,论文中使用了 L1 损失函数进行监督学习:

最终的多任务损失函数为:

对于关键点的选择训练实现,将最小二乘拟合算法应用于预测关键点:

同样,我们看一下在 LINEMOD 数据集上的实验效果,ADD(S) 指标是 95.1:

▲ Fig 7. PVN3D实验效果

YCB-Video 数据集的定性实验效果图:

▲ Fig 8. PVN3D定性实验(YCB-Video)

可以看到是比 DenseFusion 的效果稍好,DenseFusion 右边有个钳子都反了,而 PVN3D 没有,不过是部分定性实验的效果,未知全貌了。

![]()

DPVL

论文标题:6DoF Object Pose Estimation via Differentiable Proxy Voting Loss

论文来源:CVPR 2020

论文链接:https://arxiv.org/abs/2002.03923

这是一项来自澳大利亚国立大学的工作,可谓是“小题大做”型的论文了,论文考虑的角度是,基于向量场的关键点投票已经证明了它在解决 6D 位姿估计问题上的有效性和优越性。

然而,向量场的直接回归忽略了像素点与关键点之间的距离对假设偏差的影响。换句话说,当像素远离关键点时,方向向量上的小误差可能会对预估的关键点产生严重偏差。直观点就是如图 9 所示:

▲ Fig 9. DPVL

相同的角度,当距离越远时,预估的关键点会和实际的关键点产生更大的距离偏差。为了解决这种忽略了像素点与关键点之间的距离对假设偏差的影响,他们提出了一种可微分的代理投票损失。

▲ Fig 10. DPVL总框架

论文作者使用了 smooth L1 损失来回归真实的方向向量:

其中, 表示估计的方向向量, 表示物体的掩码, 表示知识函数, 表示标量变量。

如前所述,单位方向向量估计误差较小,也可能会导致假设偏差较大,假设点不集中会导致关键点不准确,从而降低姿态估计的性能。与以前的工作不同,考虑了假设点的分布,并强制所有的假设点接近于真实关键点。假设一个对象包含 个像素,则有 个假设。

虽然对于从两个像素点获得两个方向向量的假设有一个封闭的解,但是计算所有的假设会导致深度网络的训练效率低下,特别是当一个物体的分辨率非常大的时候,由于决定一个关键点到直线上某个点的距离是没有上界的,而是有下界的。

所以选择使用通过一个关键点的垂线的垂足来近似代理假设点。这样,我们只需要计算 个垂线,而不是 个假设,大大减少了计算量。

更重要的是,一个关键点 与垂足 与像素 的方向向量 之间的距离是一个闭合形式的解,也是可微的。因此,将距离最小化作为可微分的代理投票损失(DPVL) ,以迫使代理假设点更接近于关键点:

其中 ,由于 是直接从我们的网络中估计出来的,它可能不是单位向量,所以在这里面中有一个归一化操作。

在 LINEMOD 数据集上的实验效果,ADD(S) 指标是 91.50:

效果上在这三篇里面是最低的了,但是贵在文章的可微分的公式推理上有可取之处,定性效果如下:

对比原来向量场的直接回归的方法 PVNet 来说,是有所改进的。

![]()

总结

毫无疑问,对于视觉领域来说,越来越多迹象显示未来的研究热点要么在时间维度上,比如视频的处理和理解。另外一个就是在空间维度上做文章,如三维视觉(三维感知、SLAM、三维物体识别与分割、位姿估计),这里面 6 自由度的物体位姿估计的论文应该会越来越多,也会越做越好。

![]()

点击以下标题查看更多往期内容:

CVPR 2020 | 商汤TSD目标检测算法解读

CVPR 2020 | 无域标签下高清场景时移变换

从近年CVPR看域自适应立体匹配

CVPR 2020 三篇有趣的论文解读

CVPR 2020 | 港中文提出3D目标检测新框架

多目标跟踪领域近期值得读的几篇论文

![]()

#投 稿 通 道#

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

???? 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

???? 投稿邮箱:

• 投稿邮箱:[email protected]

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

????

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

![]()