入门篇:从零到一搭建大数据开发平台(七)Hbase入门-集群式环境安装

目录

依赖环境:

简介:

开始安装集群:

更多Shell请查看下一篇博客【传送门】

依赖环境:

VMware15.5【传送门】

Hadoop HDFS【传送门】

ZooKeeper【传送门】

Hbase 强依赖HDFS和ZK,必须保证HDFS集群和ZK集群是可用的

Hbase 强依赖HDFS和ZK,必须保证HDFS集群和ZK集群是可用的

Hbase 强依赖HDFS和ZK,必须保证HDFS集群和ZK集群是可用的【重要的重复三遍···】

简介:

hbase是bigtable的开源java版本。是建立在hdfs之上,提供高可靠性、高性能、列存储、可伸缩、实时读写nosql的数据库系统。

它介于nosql和RDBMS之间,仅能通过主键(row key)和主键的range来检索数据,仅支持单行事务(可通过hive支持来实现多表join等复杂操作)。

主要用来存储结构化和半结构化的松散数据。

Hbase查询数据功能很简单,不支持join等复杂操作,不支持复杂的事务(行级的事务)

Hbase中支持的数据类型:byte[]

与hadoop一样,Hbase目标主要依靠横向扩展,通过不断增加廉价的商用服务器,来增加计算和存储能力。

Hbase是面向列的、稀疏表。

开始安装集群:

一:下载安装包:

所有关于CDH版本的软件包下载地址如下

http://archive.cloudera.com/cdh5/cdh/5/

HBase对应的版本下载地址如下

http://archive.cloudera.com/cdh5/cdh/5/hbase-1.2.0-cdh5.14.0.tar.gz

二:压缩包上传并解压:

上传教程【传送门】,把安装包上传到主节点的/export/soft路径下,解压到/export/servers

tar -zxvf hbase-1.2.0-cdh5.14.0.tar.gz -C ../servers/等待解压完毕

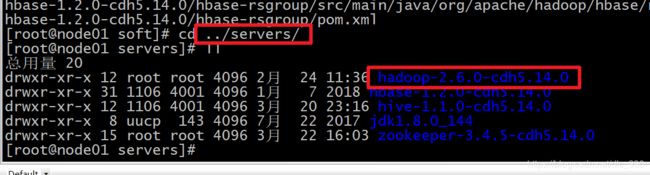

进入到上级目录下的servers目录看到已经解压好的Hbase

三:修改配置文件 hbase-env.sh、hbase-site.xml、regionservers

进入到Hbase的配置文件路径下编辑以上三个配置文件

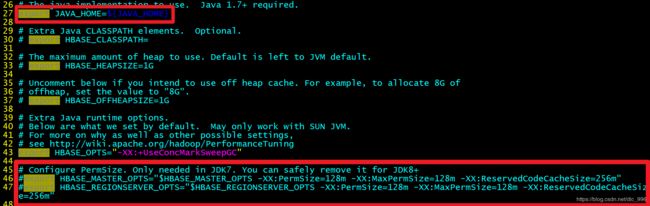

修改第一个配置文件 hbase-env.sh

vim hbase-env.sh

1、配置JAVA_HOME

export JAVA_HOME=${JAVA_HOME}

2、注释掉HBase使用内部zk 把true 改为false

修改为:export HBASE_MANAGES_ZK=false

修改第二个配置文件hbase-site.xml

vim hbase-site.xml

添加以下配置项:

hbase.rootdir

hdfs://node01:8020/hbase

hbase.cluster.distributed

true

hbase.master.port

16000

hbase.zookeeper.quorum

node01:2181,node02:2181,node03:2181

hbase.zookeeper.property.dataDir

/export/servers/zookeeper-3.4.5-cdh5.14.0/zkdatas

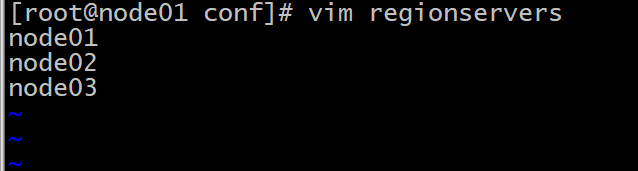

修改第三个配置文件regionservers 配置你的工作节点 填写主机名即可

vim regionservers

创建一个back-masters配置文件,实现HMaster的高可用

vim backup-masters

四:安装包分发到其他机器

cd /export/servers/

scp -r hbase-1.2.0-cdh5.14.0/ node02:$PWD

scp -r hbase-1.2.0-cdh5.14.0/ node03:$PWD五:三台节点创建软连接

因为hbase需要读取hadoop的core-site.xml、hdfs-site.xml当中的配置文件信息,所以我们三台机器都要执行以下命令创建软连接

ln -s /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop/core-site.xml /export/servers/hbase-1.2.0-cdh5.14.0/conf/core-site.xml

ln -s /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop/hdfs-site.xml /export/servers/hbase-1.2.0-cdh5.14.0/conf/hdfs-site.xml六:三台节点配置全局环境变量

cd /etc/profile.d/

vim hbase.sh

export HBASE_HOME=/export/servers/hbase-1.2.0-cdh5.14.0

export PATH=$PATH:$HBASE_HOME/bin再把 hbase.sh分发到其他节点

scp hbase.sh node02:$PWD

scp hbase.sh node03:$PWD三台节点更新环境变量让其 hbase.sh生效

source /etc/profile七:启动Hbase集群

在任意位置使用环境变量一键启动命令:

start-hbase.sh 单节点逐一启动命令:

启动HMaster命令

bin/hbase-daemon.sh start master

启动HRegionServer命令

bin/hbase-daemon.sh start regionserver

为了解决HMaster单点故障问题,我们可以在node02和node03机器上面都可以启动HMaster节点的进程,以实现HMaster的高可用

bin/hbase-daemon.sh start master

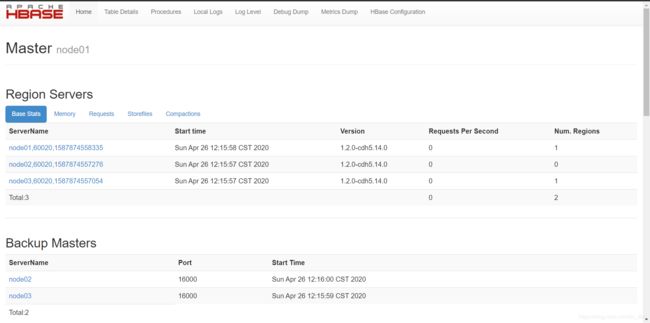

查看WEB页面

http://node01:60010/master-status

已验证集群启动

使用Shell命令验证集群是否可用

1、开启Hbase Shell窗口

hbase shell

2、查看都有那些表

list

3、创建一张表 user表,包含info、data两个列族

create 'user', 'info', 'data'

4、 给表添加点数据

向user表中插入信息,row key为rk0001,列族info中添加name列标示符,值为zhangsan

put 'user', 'rk0001', 'info:name', 'zhangsan'

向user表中插入信息,row key为rk0001,列族info中添加gender列标示符,值为female

hbase(main):012:0> put 'user', 'rk0001', 'info:gender', 'female'

向user表中插入信息,row key为rk0001,列族info中添加age列标示符,值为20

hbase(main):013:0> put 'user', 'rk0001', 'info:age', 20

向user表中插入信息,row key为rk0001,列族data中添加pic列标示符,值为picture

hbase(main):014:0> put 'user', 'rk0001', 'data:pic', 'picture'

5、查询数据

查询user表中的所有信息

scan 'user'