SIGIR2018|选择性GBDT(SelGB)用于排序学习(已开源)

Selective Gradient Boosting for Effective Learning to Rank

Claudio Lucchese, Franco Maria Nardini, Raffaele Perego, Salvatore Orlando, Salvatore Trani

Ca’ Foscari University of Venice, ISTI-CNR

http://quickrank.isti.cnr.it/selective-data/selective-SIGIR2018.pdf

从大量查询和文档中学到比较有效的排序函数具有一定的挑战性。如果在训练集中,对生产系统中网页搜索的真实场景进行建模时,查询通常跟少量文档相关,并且存在大量无关的文档。比如给定某个文档,可能返回几千个相匹配的文档,实际上,只有很少的文档是真实相关的。

这篇文章提出了选择性梯度提升 (SelGB),该算法可以解决学习排序问题,它可以集中在最有可能误排的无关文档上,进而可以大幅提升所学模型的质量。

SelGB利用一种新的方法来最小化误排风险,所谓误排风险即为两个随机样本的排序不对的概率。该方法利用梯度提升来迭代式生成加法集成决策树。在每次迭代中,针对每一个查询,SelGB从训练样本中选择性的提取小部分负样本用于增强所学模型的判别能力。

公开数据集上的可复现详尽实验表明,SelGB可以利用负样本的多样性来训练集成树算法,效果优于当前最好的算法,NDCG@10提升了3.23%。(SelGB 所得到的NDCG@10为0.7800, λ-Mart500对应的NDCG@10为0.7556, 0.7800-0.7556 = 0.0244, 0.0244/0.7556约等于 3.23%)。

这篇文章的主要贡献如下

下面是一些符号约定

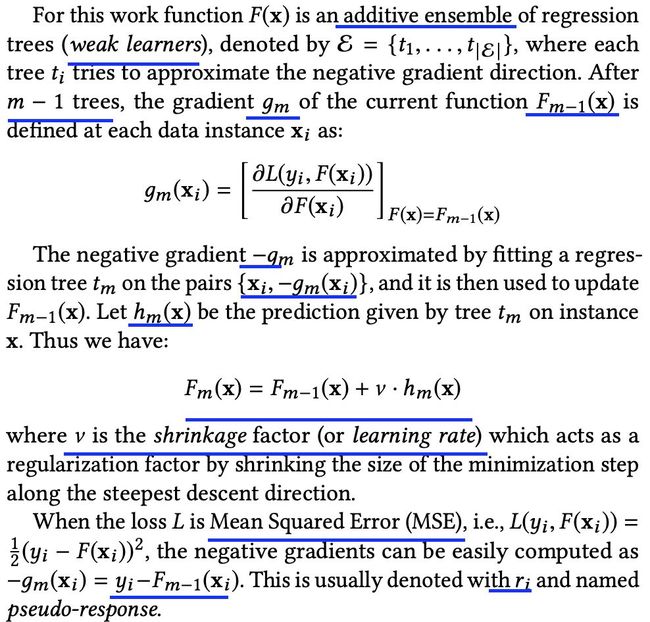

目标函数及梯度的约定如下

通常,针对某个查询,没有关联的样本量远远大于关联性较大的样本量

虽然MART满足上述需求,但是对MSE最小化并不能保证NDCG最优

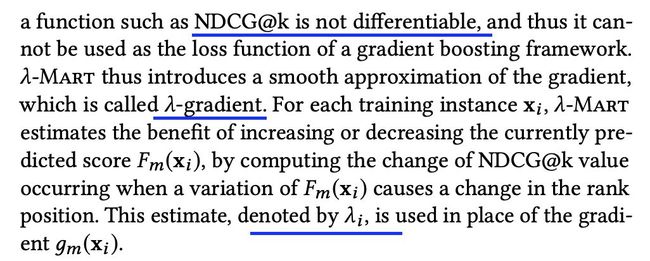

升级版的lambda-MART通过引入光滑的近似梯度之后可以用于排序问题

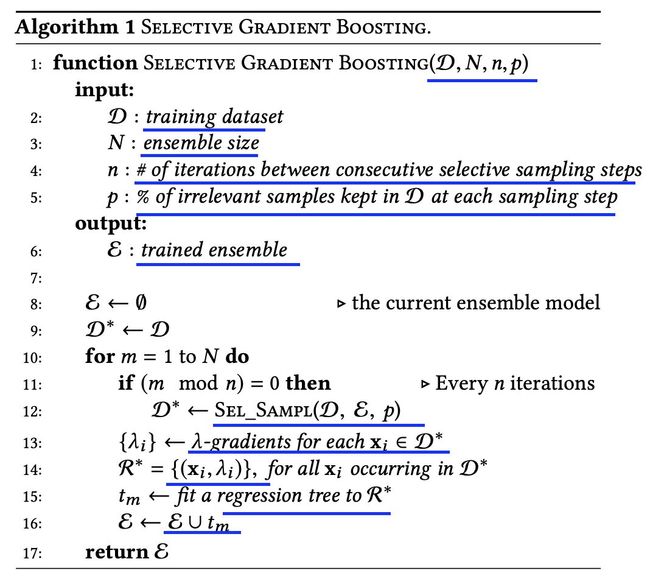

SelGB的伪代码如下

数据集的更新策略如下

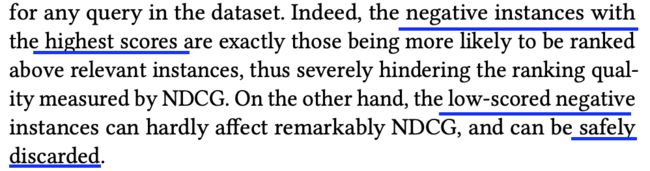

排名比较靠前的负样本质量有可能优于正样本,排名比较靠后的负样本可以放心丢弃掉

可以利用验证集来提前终止训练

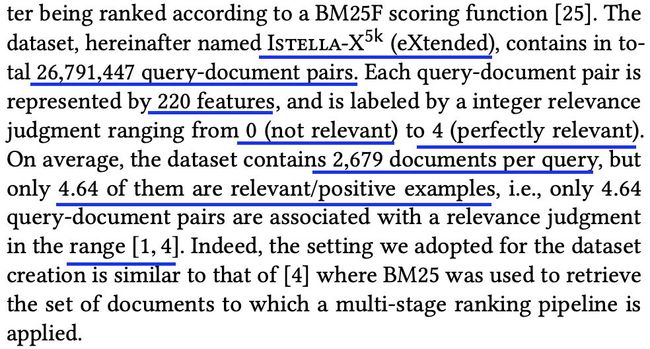

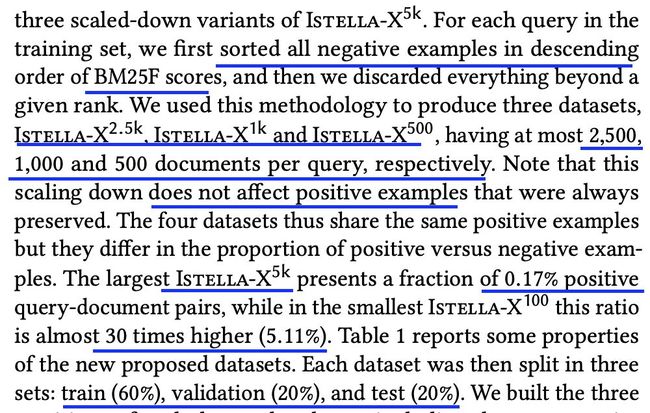

本文所采用的数据集信息如下

此外,又根据不同的采样比例构造了新的数据集

数据集统计如下

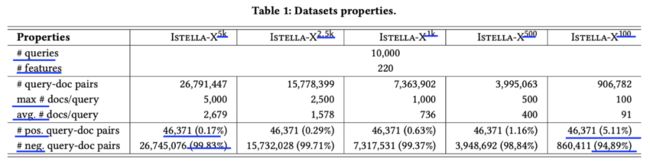

针对lambda-Mart,效果最好的参数组合如下

对于lambda-MART,不同参数对模型效果的影响如下

结果显示lambda-mart对负样本的比例不敏感,效果没有显著差异

实验结果表明,SGB效果不如lambda-mart

虽然NegSGB效果好些,但是依然比不上lambda-mart。

下面是NegSGB不同采样率的效果对比

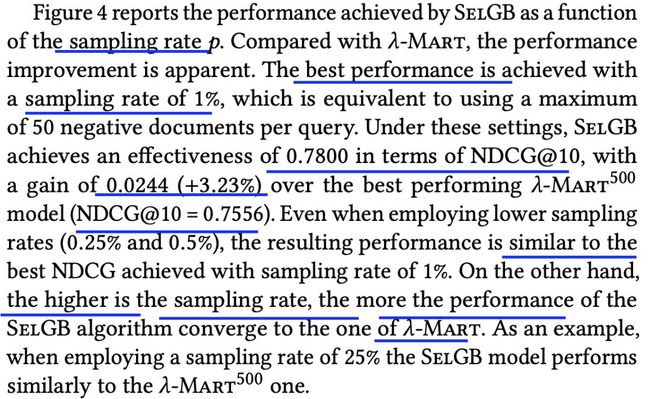

对于selGB,不同的采样率效果影响如下,效果优于lambda-Mart500

对于SelGB,不同参数的效果对比,如下图

不同的采样频率对selGB效果的影响如下

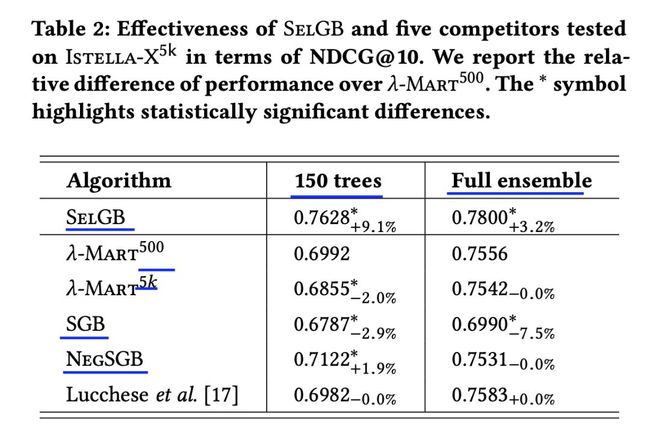

几种算法的效果对比如下

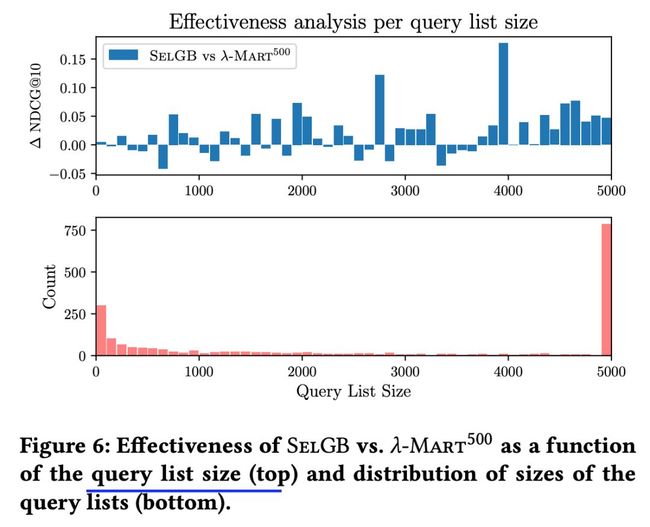

每个query对应的list大小的影响对比如下

进一步,可以得到以下结论

代码地址

http://quickrank.isti.cnr.it/

![]() 我是分割线

我是分割线![]()

您可能感兴趣

AAAI2018|斯坦福大学提出并开源增强生成式模型

ijcai2017|CTR经典模型DeepFM,FNN,PNN,W&D,LR,FM对比(哈工大诺亚方舟提出CTR模型)

ICML2019|一种基于强化学习的推荐系统(GAN用户模型,佐治亚理工学院联合蚂蚁金服提出且已开源)

ICML2018|GBDT中如何寻找影响较大样本(普林斯顿大学联合Yandex提出并开源)

IJCAI2019|基于对抗变分自编码的协同过滤框架VAEGAN

聊聊CatBoost

聊聊XGBoost CatBoost LightGBM RF GBDT

IJCAI2019|新型特征增广GBDT--AugBoost(已开源)

IJCAI2019|清华大学提出并开源新型梯度提升决策树(梯度提升分段线性回归树)

新型梯度提升决策树GBDT-SPARSE(谷歌微软FaceBook加州大学联合提出)

ICML2019|深度学习鼻祖之一Bengio提出并开源图马尔科夫神经网络

GBDT,LR,深度学习如何联合发力(以推荐系统和游戏为例)

大规模GBDT系统应用场景及效果对比(LightGBM,XgBoost,DimBoost等)

新型在线预测模型DeepGBM(基于GBDT扩展的深度学习框架)

顶会中深度学习用于CTR预估的论文及代码集锦 (3)

NIPS2018深度学习(9)|亮点:多元卷积稀疏编码、循环关系网络

ICML 2018 深度学习论文及代码集锦(5)

深度学习用于文本摘要的论文及代码集锦

深度学习用于机器翻译的论文及代码集锦

深度学习用于序列标注中的论文及代码集锦

深度学习在推荐系统中的应用及代码集锦(4)

深度学习在OCR中的应用论文及代码集锦 (2)