hadoop伪分布式安装

因为hadoop伪分布式我已在本地搭建并且运行成功。为了加快学习不足同时分享搭建。直接将不足贴出来,如有不同意见还忘评价共同提升。

Hadoop 伪分布模式 HDFS+YARN

另外补充下: hadoop2.0之后不包含MapReduce;

环境搭建准备:

1,VMware 安装

如果你使用的事VirtualBox 必须将电脑虚拟化。通过开机的时候进入BIOS 找到Virtualization.

将Virtualization 设置为Enabled;

2.下载 Centos6.6 镜像

官网地址:http://vault.centos.org/6.6/isos/x86_64/CentOS-6.6-x86_64-bin-DVD1.iso

链接:http://pan.baidu.com/s/1bpqOQhL 密码:z02w

3. 新建虚拟电脑注意:

1,hadoop分布式是采用桥接模式通信。建议不要使用NAT模式。其他准备工作就不需要讲了很简单。在liunx环境中搭建框架的基本都知道。

2, liunx命令注意将hadoop用户命令赋权

sudo 是 liunx 下常用的允许普通用户使用超级用户权限的工具

在虚拟机上,执行命令 sudo vim /etc/hosts

会提示 hadoop不在 sudoers 文件中。此事将被报告。为 hadoop用户配置 sudo 权限切换到 root 用户执行命令 su root

查看/etc/sudoers 文件权限,如果只读权限,修改为可写权限查看文件权限,执行命令 ll /etc/sudoers 修改权限,执行命令 chmod 777 /etc/sudoers

将 hadoop ALL=(ALL) NOPASSWD:ALL /etc/sudoers 追加到文件中。

内容含义是:用户名 chinahadoop 网络中主机=(全部用户) 不需要密码:全部范围’执行命令 echo ‘hadoop ALL=(ALL)NOPASSWD:ALL’ >> /etc/sudoers

恢复/etc/sudoers 的访问权限为 440 执行命令 chmod 440 /etc/sudoers

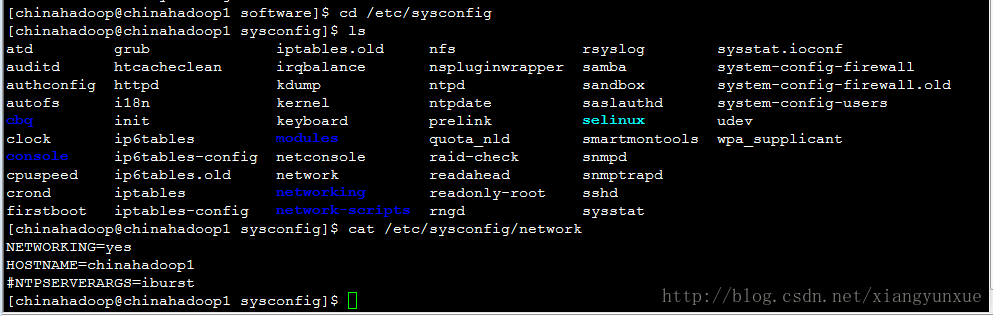

切换到 hadoop 用户,执行命令 sudo vim /etc/hosts4.配置hosts文件

计算机系统在处理 DNS 请求以前,会先检查自己的hosts 文件中是否有这个地址映射关系,如果有则调用这个 IP 地址映射,如果没有再向已知的DNS 服务器提出域名解析。

我们在访问 自己网站或者www.baidu.com 时,DNS 服务器把网络域名(www.baidu.com)

解析成对应的服务器 IP 地址后,我们才能访问小象学院的网站。

自定义的名字没有注册过域名,就可以通过配置 hosts 文件建立 IP 映射,这样以后访问虚拟机上的服务时我们输入名字就行了。

4.1 在windows/liunx hosts文件中配置虚拟机Ip

liunx : sudo vim /etc/hosts 在文件中追加windows ip 并加上windows 自定义名称

例如 192.168.1.89 win8

windows:

win8 的 C:\Windows\System32\drivers\etc 目录下的 hosts 文件。加入内容 192.168.1.119chinahadoop0

注意:自测试相互能调通。

5.SSH 客户端

SSH 客户端有很多,比如:Xshell、putty、SecureCRT 和 WinSCP

Xme4 软件下载链接:http://pan.baidu.com/s/1pKFmC0j 密码:n2j4

putty 软件下载链接:http://pan.baidu.com/s/1c2gDyQO 密码:im6e

SecureCRT 软件下载链接:http://pan.baidu.com/s/1c2G5nVi 密码:dgz5

WinSCP 软件下载链接:http://pan.baidu.com/s/1nvKqDG9 密码:vf48

6. 下载hadoop包 本文采用2.5.2版本

注意下载需要查看自己下载文件位置。使用命令pwd查看当前目录位置。

我的目录 下载目录为/home/chinahadoop/software

7.1 回顾window/liunx hosts文件中相互配置对方的ip和映射名称。

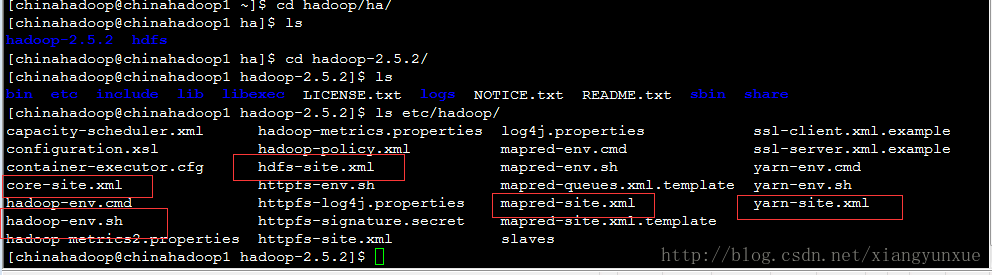

8. 将software下载hadoop包解压到hadoop(自己新建)

命令: tar zxvf hadoop-2.5.2.tar.gz 是解压到当前目录

我是解压到: tar zxvf software/hadoop-2.5.2.tar.gz -C hadoop/ha

注意:加上 -C是 解压到 hadoop/ha 目录

9. 修改hadoop配置文件

9.1 修改 hadoop-env.sh 文件

在hadoop-env.sh文件中配置jdk环境变量

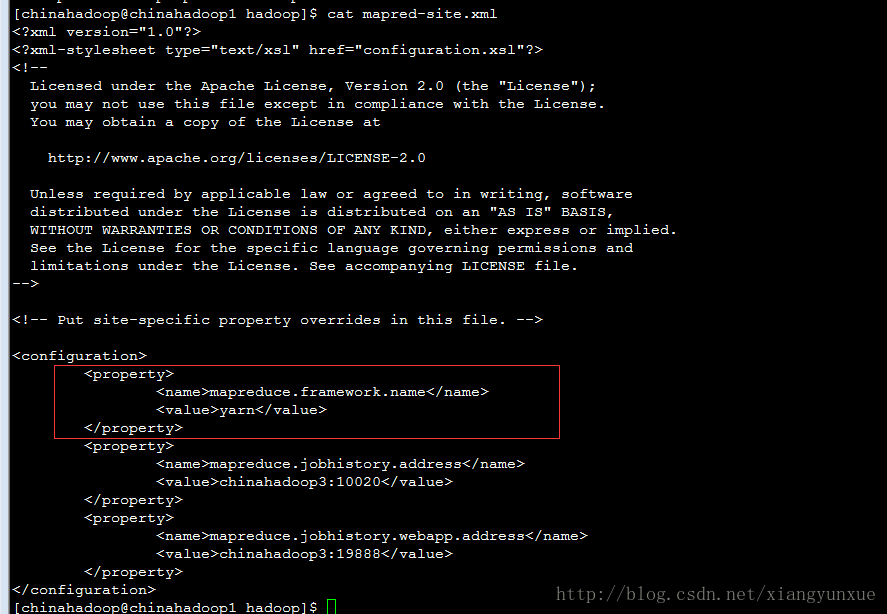

9.2 修改 mapred-site.xml 文件

其中,名称mapreduce.framework.name指的是使用yarn运行mapreduce程序。

启动了HDFS之后,就可以启动yarn了。执行命令start-yarn.sh即可启动MapReduce集群

9.3 修改 core-site.xml 文件

9.4 修改 hdfs-site.xml 文件

注意: 防止每次重启需要格式化namnode 将配置红色部分。同时红色部分也可以配置到core-site.xml文件中。

这是为了防止在非tmp目录下生产文件。

9.5 修改 yarn-site.xml 文件

输入命令vim etc/hadoop/yarn-site.xml

加入下面内容

10 格式化namenode

首次: bin/hadoop namenode -format

10.1 启动namenodesbin/hadoop-daemon.sh start namenode

同时 jps 查看下

10.2 启动datanode

执行命令 sbin/hadoop-daemon.sh startdatanode

11 访问

http://chinahadoop0:50070

本Markdown编辑器使用StackEdit修改而来,用它写博客,将会带来全新的体验哦:

- Markdown和扩展Markdown简洁的语法

- 代码块高亮

- 图片链接和图片上传

- LaTex数学公式

- UML序列图和流程图

- 离线写博客

- 导入导出Markdown文件

- 丰富的快捷键

快捷键

- 加粗

Ctrl + B - 斜体

Ctrl + I - 引用

Ctrl + Q - 插入链接

Ctrl + L - 插入代码

Ctrl + K - 插入图片

Ctrl + G - 提升标题

Ctrl + H - 有序列表

Ctrl + O - 无序列表

Ctrl + U - 横线

Ctrl + R - 撤销

Ctrl + Z - 重做

Ctrl + Y

Markdown及扩展

Markdown 是一种轻量级标记语言,它允许人们使用易读易写的纯文本格式编写文档,然后转换成格式丰富的HTML页面。 —— [ 维基百科 ]

使用简单的符号标识不同的标题,将某些文字标记为粗体或者斜体,创建一个链接等,详细语法参考帮助?。

本编辑器支持 Markdown Extra , 扩展了很多好用的功能。具体请参考Github.

表格

Markdown Extra 表格语法:

| 项目 | 价格 |

|---|---|

| Computer | $1600 |

| Phone | $12 |

| Pipe | $1 |

可以使用冒号来定义对齐方式:

| 项目 | 价格 | 数量 |

|---|---|---|

| Computer | 1600 元 | 5 |

| Phone | 12 元 | 12 |

| Pipe | 1 元 | 234 |

定义列表

- Markdown Extra 定义列表语法:

- 项目1

- 项目2

- 定义 A

- 定义 B

- 项目3

- 定义 C

-

定义 D

定义D内容

代码块

代码块语法遵循标准markdown代码,例如:

@requires_authorization

def somefunc(param1='', param2=0):

'''A docstring'''

if param1 > param2: # interesting

print 'Greater'

return (param2 - param1 + 1) or None

class SomeClass:

pass

>>> message = '''interpreter

... prompt'''脚注

生成一个脚注1.

目录

用 [TOC]来生成目录:

-

- 快捷键

- Markdown及扩展

- 表格

- 定义列表

- 代码块

- 脚注

- 目录

- 数学公式

- UML 图:

- 离线写博客

- 浏览器兼容

数学公式

使用MathJax渲染LaTex 数学公式,详见math.stackexchange.com.

- 行内公式,数学公式为: Γ(n)=(n−1)!∀n∈N Γ ( n ) = ( n − 1 ) ! ∀ n ∈ N 。

- 块级公式:

更多LaTex语法请参考 这儿.

UML 图:

可以渲染序列图:

或者流程图:

- 关于 序列图 语法,参考 这儿,

- 关于 流程图 语法,参考 这儿.

离线写博客

即使用户在没有网络的情况下,也可以通过本编辑器离线写博客(直接在曾经使用过的浏览器中输入write.blog.csdn.net/mdeditor即可。Markdown编辑器使用浏览器离线存储将内容保存在本地。

用户写博客的过程中,内容实时保存在浏览器缓存中,在用户关闭浏览器或者其它异常情况下,内容不会丢失。用户再次打开浏览器时,会显示上次用户正在编辑的没有发表的内容。

博客发表后,本地缓存将被删除。

用户可以选择 把正在写的博客保存到服务器草稿箱,即使换浏览器或者清除缓存,内容也不会丢失。

注意:虽然浏览器存储大部分时候都比较可靠,但为了您的数据安全,在联网后,请务必及时发表或者保存到服务器草稿箱。

浏览器兼容

- 目前,本编辑器对Chrome浏览器支持最为完整。建议大家使用较新版本的Chrome。

- IE9以下不支持

- IE9,10,11存在以下问题

- 不支持离线功能

- IE9不支持文件导入导出

- IE10不支持拖拽文件导入

- 这里是 脚注 的 内容. ↩