kylin单机版搭建OLAP

最近想尝试大数据框架,所以选择了kylin 当然 druid 框架也是很不错,不过他有自己特定的语言,不支持SQL,这样对后期改造项目不方便,另外是kylin团队是国内维护,中文文档全,所以就选它来试试手

首生下载

http://kylin.apache.org/download/ 2.6.1 下载安装版本

http://mirrors.shu.edu.cn/apache/kylin/apache-kylin-2.6.1/apache-kylin-2.6.1-bin-hbase1x.tar.gz

解压数据包到相应的目录

[root@p3 itcast]# tar -zxvf apache-kylin-2.6.1-bin-hbase1x.tar.gz 安装部署环境 我这里使用的相关版本为:

JDK8

hadoop-2.7.6

hbase-1.2.7

pache-hive-2.3.4-bin

pache-kylin-2.6.1-bin-hbase1x

配置环境变量

部署使用的用户为root 不同系统的配置环境变量文件名不一样 根目录下 .bashrc或者etc/profile 配置

export PATH=$PATH:/itcast/hadoop-2.7.6/

#Set HADOOP_HOME

export HADOOP_HOME=/itcast/hadoop-2.7.6

#Set JAVA_HOME

export JAVA_HOME=/home/jdk/jdk1.8.0_181

# Add bin/ directory of Hadoop to PATH

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

export HBASE_MANAGES_ZK=true

export PATH=$PATH:/itcast/hbase-1.2.7/bin

export HIVE_HOME=/itcast/apache-hive-2.3.4-bin

export HCAT_HOME=$HIVE_HOME/hcatalog

export HIVE_CONF=$HIVE_HOME/conf

export PATH=$PATH:$HIVE_HOME/bin

export KYLIN_HOME=/itcast/apache-kylin-2.6.1-bin-hbase1x

export KYLIN_CONF=/itcast/apache-kylin-2.6.1-bin-hbase1x/conf

export tomcat_root=$KYLIN_HOME/tomcat #变量名小写

export hive_dependency=$HIVE_HOME/conf:$HIVE_HOME/lib/*:$HCAT_HOME/share/hcatalog/hive-hcatalog-core-2.3.4.jar #变量名小写

export PATH=$PATH:$KYLIN_HOME/bin使配置环境变量文件生效

source .bashrc

检测kylin环境是否有问题:

bin/check-env.sh

[root@p3 bin]# ./check-env.sh

Retrieving hadoop conf dir...

KYLIN_HOME is set to /itcast/apache-kylin-2.6.1-bin-hbase1x

上面这样表示成功

启动kylin

bin/kylin.sh start

主配置$KYLIN_HOME/conf/kylin.properties

先创建工作目录

使用HDFS超级用户在HDFS上为Kylin创建工作目录,并赋权给root:

hadoop fs -mkdir /kylin

hadoop fs -chown -R root:root /kylin

##hdfs上kylin工作目录 /kylin.properties配置目录

kylin.env.hdfs-working-dir=/kylin配置$KYLIN_HOME/bin/kylin.sh

在文件开头添加

export HBASE_CLASSPATH_PREFIX=${tomcat_root}/bin/bootstrap.jar:${tomcat_root}/bin/tomcat-juli.jar:${tomcat_root}/lib/*:$hive_dependency:$HBASE_CLASSPATH_PREFIX

这么做的目的是为了加入$hive_dependency环境,解决后续的两个问题,都是没有hive依赖的原因:

a) kylinweb界面load hive表会失败

b) cube build的第二步会报org/apache/Hadoop/hive/conf/hiveConf的错误。

从 v2.6.1 开始, Kylin 不再包含 Spark 二进制包; 您需要另外下载 Spark,然后设置 SPARK_HOME 系统变量到 Spark 安装目录:

使用脚本下载: 因为启动依赖报错 可能还有kafka 直接命令安装,否则启动kylin会报spark错

$KYLIN_HOME/bin/download-spark.sh

启动依赖的必须组件

start-dfs.sh

start-yarn.sh

start-hbase.sh

启动Hive

启动 mysql

hadoop-2.7.6/ ./sbin/mr-jobhistory-daemon.sh start historyserver

./kylin.sh start安装目录/hbase-site.xml 添加本机zookeeper peer1 在etc/hosts里配置了

hbase.zookeeper.quorum

peer1

kylin 官方硬件要求 如果达不到去 setenv.sh 配置JVM参数

运行 Kylin 的服务器的最低配置为 4 core CPU,16 GB 内存和 100 GB 磁盘。 对于高负载的场景,建议使用 24 core CPU,64 GB 内存或更高的配置。

启动kylin后,并且保证后续数据不错,必要的进程如下:

[root@p3 /]# jps

4994 NodeManager

14226 Jps

4517 SecondaryNameNode

4331 DataNode

14972 Main

4701 ResourceManager

4190 NameNode

7038 HMaster

14174 JobHistoryServer

7471 RunJar

31631 RunJar导入官方数据

命令行 $KYLIN_HOME/bin/sample.sh

如果出现Restart Kylin Server or click Web UI => System Tab => Reload Metadata to take effect,就说明示例cube创建成功了

数据成功后,查看hbase里的数据

hbase(main):001:0> list

TABLE

ims_tms_habsesql

kylin_metadata

member

tspCompleteCondition

tspVehicleCondition

5 row(s) in 0.3570 seconds

=> ["ims_tms_habsesql", "kylin_metadata", "member", "tspCompleteCondition", "tspVehicleCondition"]

hbase(main):002:0>

查看hive里的数据 kylin_sales就是导入的数据

hive> use default;

OK

Time taken: 0.09 seconds

hive> show tables;

OK

kylin_account

kylin_cal_dt

kylin_category_groupings

kylin_country

kylin_sales

Time taken: 0.124 seconds, Fetched: 5 row(s)

hive>

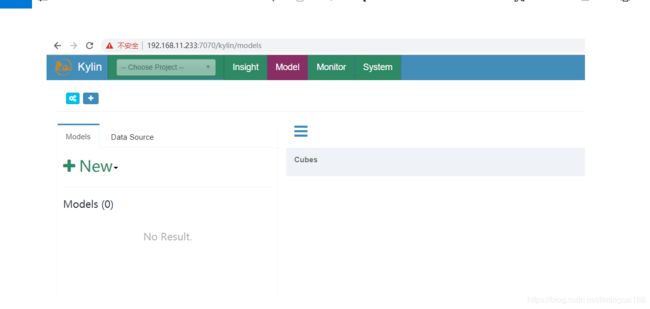

然后输入http://192.168.11.233:7070/kylin

WEB UI界面出现了 默认用户名 admin/KYLIN 一切搞定

简单的过程,到此结束