python实现爬虫查看冠状病毒肺炎疫情

介绍

本文是使用python语言实现的简单爬虫,用于爬取官方网站给出的具体数据,以便得知具体的肺炎疫情状况。

数据来源

本次我们使用的数据来源是 丁香医生的疫情通报网站

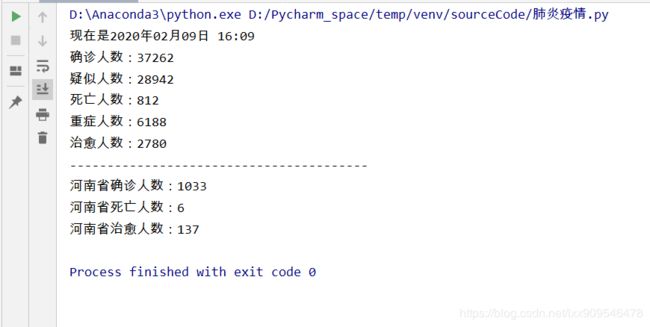

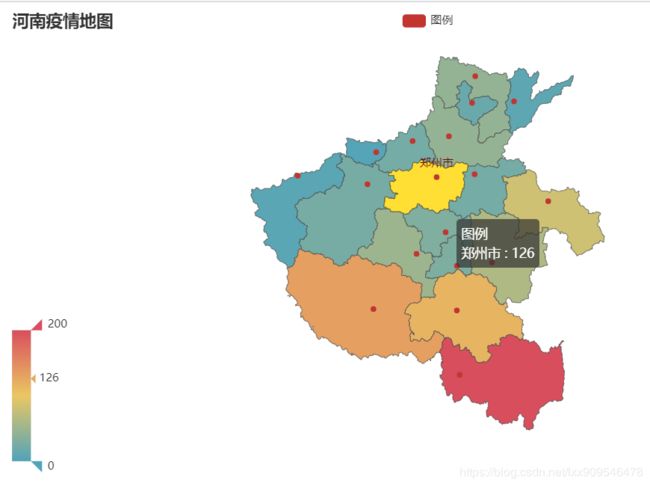

我们将通过下面这些代码得到我们想要的疫情数据。同时我们使用pyecharts库,为河南省内所有数据绘制了一份疫情地图。

值得注意的是:这个网站其中的一部分内容是使用js异步加载出的,因此我们并不能直接找到上面图片中那些数据的直接xpath,因为很容易发现,从直接xpath加载出的数据为空。

若要直接从xpath中拿到数据,需要使用python的webdriver库模拟人打开浏览器进行交互,从而得到我们想要的数据。

在这里我们使用的不是上面的方法,而是在原始网页中找到了存储这些数据的位置。

代码

import requests

from lxml import html

import re

import json

import time

from pyecharts import options as opts

from pyecharts.charts import Map

from pyecharts.globals import ChartType, SymbolType

def geo_henan(city_list, num_list) -> Map():

c = (

Map()

.add(

"图例",

[list(z) for z in zip(city_list, num_list)],

"河南"

)

.set_series_opts(label_opts=opts.LabelOpts(is_show=False))

.set_global_opts(

title_opts=opts.TitleOpts(title="河南疫情地图"),

visualmap_opts=opts.VisualMapOpts(max_=200, is_piecewise=False)

)

)

return c

url = 'https://ncov.dxy.cn/ncovh5/view/pneumonia'

res = requests.get(url)

res.encoding = 'utf-8'

# f = open('../疫情.html', 'w+', encoding='utf-8')

# f.write(res.text)

pattern = re.compile(r'"confirmedCount":.+"virus"')

pattern_Henan = re.compile(r'"河南".+?"comment"')

pattern_Henan_Inner = re.compile(r'{"cityName":"信阳.+?待明确地区')

tree = html.fromstring(res.text)

pos = '//*[@id="getStatisticsService"]/text()'

data = str(tree.xpath(pos))

data = re.findall(pattern, data)

data = data[0][:-8]

data = '{' + str(data) + '}'

data = json.loads(data)

print(time.strftime('{a}%Y{y}%m{m}%d{d} %H:%M').format(a='现在是', y='年', m='月', d='日'))

print(f"确诊人数:{data['confirmedCount']}")

print(f"疑似人数:{data['suspectedCount']}")

print(f"死亡人数:{data['deadCount']}")

print(f"重症人数:{data['seriousCount']}")

print(f"治愈人数:{data['curedCount']}")

pos = '//*[@id="getListByCountryTypeService1"]/text()'

data = str(tree.xpath(pos))

data = re.findall(pattern_Henan, data)

data = data[0]

data = '{' + data[19:-10] + '}'

data = json.loads(data)

print('-' * 40)

print(f"河南省确诊人数:{data['confirmedCount']}")

print(f"河南省死亡人数:{data['deadCount']}")

print(f"河南省治愈人数:{data['curedCount']}")

pos = '//*[@id="getAreaStat"]/text()'

data = str(tree.xpath(pos))

data = re.findall(pattern_Henan_Inner, data)

data = data[0]

data = data[:-20]

data_list = data.split('},')

city_list = []

num_list = []

for i in range(len(data_list)):

data_list[i] = data_list[i][1:]

data_list[i] = '{' + data_list[i] + '}'

data_list[i] = json.loads(data_list[i])

data_list[i]['cityName'] = data_list[i]['cityName'] + '市'

city_list.append(data_list[i]['cityName'])

num_list.append(data_list[i]['confirmedCount'])

geo_henan(city_list, num_list).render('../河南疫情地图.html')