众包系统的综述

A Survey of Crowdsourcing Systems

- 作者

- 绪论

- 介绍

- 应用

- 投票系统(voting system)

- 信息共享系统(information sharing system)

- 游戏(game)

- 创意系统(creative system)

- 算法

- 性能

- 用户参与(User Participation)

- 质量管理(Quality Management)

- 作弊检测(Cheating Detection)

- 数据集

- 结论

- 致谢

- 文献

作者

Man-Ching Yuen , Irwin King , and Kwong-Sak Leung

Department of Computer Science and Engineering, The Chinese University of Hong Kong, Hong Kong

AT&T Labs Research, San Francisco, USA

{mcyuen, king, ksleung}@cse.cuhk.edu.hk; [email protected]

绪论

近年来,众包作为一种分布式问题解决和商业生产模式正在发展。在众包范例中,任务被分配给联网的人来完成,这样就可以大大降低公司的生产成本。2003年,路易斯·冯·安和他的同事开创了“人类计算”的概念,它利用人类的能力执行计算机难以处理的计算任务。后来,“众包”这个词是由Jeff Howe在2006创造的。从那时起,众包领域的许多工作都集中在众包的不同方面,例如计算技术和性能分析。本文综述了有关众包技术的文献,根据其应用领域、算法、性能和数据集进行了分类。本文提供了一个结构化的观点,目前的众包研究。

关键词:众包,综述

介绍

如今,许多对人类来说微不足道的任务继续挑战甚至最复杂的计算机程序,例如图像注释。这些任务不能被计算机化。在引入众包概念之前,解决对于计算机来说困难但对于人类来说微不足道的问题的传统方法集中于将任务分配给公司的员工。然而,它增加了公司的生产成本。

为了降低企业的生产成本,更有效地利用劳动力和资源,提出了众包概念 [33]。众包是一种分布式的解决问题和企业生产模式。在2006年为《连线》杂志撰写的一篇文章中,Jeff Howe将“众包”定义为“将传统上由员工以公开呼叫的形式执行的任务外包给一大群人的理念”[32]。众包任务的一个例子是创造性的图纸,如Sheep Market[3],[46]。Sheep Market是一部基于网络的艺术作品,它让数千名工人参与到大量绘画数据库的创建中。工人们用简单的绘图工具制作他们的“面向左边的羊”的版本。每一个工人负责一张图纸支付两分钱作为他的劳动。

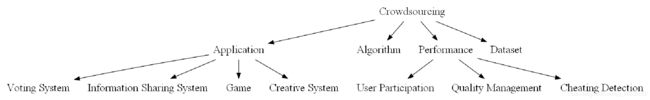

互联网的爆炸性增长和广泛的可访问性导致了在众包方面的研究活动的激增。目前,所有的众包应用都以特别的方式开发,并且许多工作都集中在众包的不同方面,例如计算技术和性能分析。众包相关的文献可以分为应用、算法、性能和数据集。图1示出了众包的分类。

本文的其余部分整理如下。第二节介绍了众包应用的研究。描述了众包应用的种类和特点。介绍了基于分类的以往工作中的应用。第三节研究了众包系统开发的算法。第四节介绍了在评估拥挤系统方面的性能方面的调查。第五节描述了在Web上可用的实验数据集。第六部分对我们的工作进行了讨论和总结。

应用

由于Web 2.0技术的普及,众包网站目前引起了广泛的关注[91],[90]。众包网站有两组用户:请求者和工人。众包站点显示一个可用的任务列表,与请求者给出的奖励和时间周期相关联;在此期间,工人们竞争提供最佳提交。同时,工人从任务列表中选择任务并完成任务,因为工人希望获得相关的奖励。在此期间结束时,选择提交的子集,并且相应的工人被请求者授予奖励。除了金钱报酬外,工人在接受请求者接受的任务时也会获得信誉。有时,任务请求者有义务根据要求向完成任务的每个工人支付报酬。在某些情况下,员工不是出于奖励而工作,而是为了娱乐或Altruist[66]工作。在这一部分中,我们将众包应用分成四类,即投票系统( voting system)、信息共享系统(information sharing system)、游戏( game)和创意系统(creative system)。

投票系统(voting system)

流行的众包网站的一个例子是Amazon Mechanical Turk(或MTurk)[1]。在Amazon的MTurk网站上进行了大量的应用或实验。它可以支持大量的投票任务。这些投票任务需要众包工作者从多个选择中选择他的答案。多数选择的答案被认为是正确的。投票可以作为评估人群回答正确性的工具。下面列举了一些例子:

-

Geometric reasoning tasks(几何推理任务)——解释和推理形状的能力是一种特定的人类能力,已经证明很难通过算法来再现。一些解决几何推理问题的工作在MTurk被提出[39],[28]。

-

Named entity annotation(命名实体注释)——命名实体识别用于识别和分类文本引用的对象在世界上,如个人和组织。MTurk是一种非常有前途的用于注释大型语料库的工具,例如阿拉伯昵称、Twitter数据、大型电子邮件数据集和医学命名实体[29],[20],[49],[89]。

-

Opinions(意见)——意见是主观偏好。在众包系统中很容易就可以从人群中收集意见。MeleBeek等人[59]使用众包范式对西班牙消费者评论进行分类。他们证明了使用各种分类器的非专家MTurk注释优于专家注释。

-

Commonsense(常识)——显然,人类能够拥有关于世界的常识知识,但是计算机程序不能。许多研究集中在MTurk收集常识知识[23],[84]。

-

Relevance evaluation(相关性评估)——人类必须阅读语料库中的每个文档以确定其与一组测试查询的相关性。Alonso等人[6]提出了相关性评价的众包,因此每个众包工作执行一个小的评估任务。

-

Natural language annotation(自然语言注释)——自然语言注释对人类来说很容易,但是目前对于自动化过程来说很困难。最近,研究人员研究了MTurk作为非专家自然语言注释的来源,它是专家注释的廉价而快速的替代[4],[11],[21],[41],[65],[72]。Akkaya等人[4]表明,众包的主观性词义标注是可靠的。Callison-Burch和Dredze[11]展示了他们以非常低的成本为语音和语言应用程序创建数据的成功。Gao和Vogel[21]证明了,从对齐错误率来看,众包工作者在单词对齐任务上优于专家。Jha等人[41]指出,通过众包工作者可以建立一个准确的介词短语依附语料库。Parent和Eskenazi[65]演示了一种在MTurk中定义字典定义任务的方法。Skory和Eskenazi[72]向MTurk的工作人员提交了开放式完形填空任务,并讨论了评估这些任务结果的质量的方法。

-

Spam identification(垃圾邮件识别)——如果没有人类理解内容的任务,就无法确定垃圾邮件。一些反垃圾邮件机制如Vipul’s Razor.1使用人工投票来确定给定的电子邮件是否为垃圾邮件。

信息共享系统(information sharing system)

网站可以帮助方便地在互联网用户之间共享信息。一些众包系统旨在在人群中共享各种类型的信息。为了监测噪声污染,Maisonneuve[53]设计了一个名为NoiseTube的系统,该系统使公民能够通过使用配备GPS的手机作为噪声传感器来测量他们在日常生活环境中暴露于噪声的个人暴露。地理定位测量和用户生成的元数据可以自动发送,并与公众在线共享,以便为城市的集体噪声测绘做出贡献。此外,Channe等人[15]利用众包贡献来监控服务级别的网络事件,并从最终用户的角度研究了网络事件对服务的影响。此外,许多流行的信息共享系统在因特网上启动,如下所示:

- Wikipedia.2 是由互联网用户编写的在线百科全书,其内容基本上是任何人都可以对维基做出贡献的。

- Yahoo! Answers.3是一个通用的回答问题的论坛,提供互联网规模的人类审查数据的自动收集。企业和Web数据处理通常需要这些人评审的数据。

- Yahoo! Suggestion Board.4 是一个互联网规模的反馈和建议系统。

- website 43Things.5 还收集来自用户的目标,并且反过来它为用户提供了找到具有相同目标的其他用户的方法,即使这些用户并不常见。

- Yahoo’s flickr.6是一个流行的照片共享网站,它为用户提供了一种用于为照片添加字幕的机制。 这些标题已被用作替代文字。

- del.icio.us.7 是Golder和Huberman开发的互联网上的社交书签网站[22]。

游戏(game)

“社会游戏”的概念是由路易斯·冯·安和他的同事们开创的,他们创造了一个有目的的游戏[76]。游戏产生有用的元数据作为副产品。利用人们的娱乐欲望,网络游戏玩家可以有效地解决问题。

在线ESP游戏[77]是第一个人类计算系统,随后被用作 Google Image Labeler.8。它的目的是收集标签在网络上的图像。除了图像注释之外,Peekaboom系统[81]可以帮助确定图像中对象的位置,Squigl系统[2]提供图像中对象的完整轮廓。此外,Phetch[78],[79]提供了图像描述,改善了网络的可访问性和图像搜索,而Matchin系统[2]帮助图像搜索引擎根据哪些图像最吸引人,对图像进行排序。ESP游戏的概念已被应用于其他问题。例如,TagATune系统[48]、MajorMiner[54]和Listen Game[75]为声音和音乐提供注释,这可以改进音频搜索。详细系统[80]和共同共识系统[51]收集常识知识,这些知识对于常识推理和增强交互式用户界面的设计是有价值的。 Green[26]提出了一种挖掘语义数据的PACKPLACE方法。在[8],[9],[85]中描述了社会注释的例子。近年来,已经提出了几种基于GWAP的地理空间标记系统,如Mobi.on[25]、Gopher游戏[13]和CityExplorer[57]、[58]。为了简化一个特定问题的社交游戏的设计方法,Chan等人[14]提出了总体设计社交游戏的形式框架。

创意系统(creative system)

人类在创造力中的作用不能被任何先进技术所取代。创造性的任务,如绘图和编码,只能由人类来完成。因此,一些研究人员寻求众包工人做一些创造性的任务,以减少生产成本。Sheep Market就是一个例子。Sheep Market是一部基于网络的艺术作品,它让成千上万的在线工作者参与到一个庞大的绘画数据库的创建中。这是一组由MTurk工人创造的10000只绵羊的集合,每个工人被支付0.02美元来画一头朝左的绵羊[3],[46]。另一个例子是Threadless.9。Threadless是一个收集由通信产生的图形T恤设计的平台。虽然当今技术发展迅速,但人类在产品设计过程中可以创新创意,而计算机却不能。关于如何开发新产品的具体问题,目前尚无定论。不同的人可能会产生不同的想法,比如设计一件T恤衫[10]。此外,Leimeister等人[50]建议将软件开发任务作为思想竞赛来众包化,以激励更多的用户支持和参与。如今,科学家们面临着日益复杂的问题,但是目前的技术无法提供解决方案。一些众包系统被设计来解决这些问题。Foldit.10是一款革命性的新电脑游戏,它允许玩家利用人类解谜的直觉来帮助预测蛋白质结构,这是生物化学的一个重要领域,旨在寻找疾病的治疗方法。

众包系统通常只支持简单、独立的任务,例如标记图像或判断搜索结果的相关性。一些工作提出了许多个体之间的协调以完成更复杂的人工计算任务[52]、[44]。Little等人介绍了TurKIT[52],它是探索MTurk上的人类计算算法的工具包。TurKit允许用户以直接的命令式编程风格编写算法,将MTurk抽象为函数调用。TurKit没有解决分成单个HIT的许多小的,不相关的任务,而是提出了一个概念,即单个任务(如排序或编辑文本)可能需要多个协调的HIT,并提供持久层,使迭代开发此类任务变得简单,而不会产生过多的HIT成本。Kittur et等人提出了CrowdForge[44]的微任务市场的通用框架,该框架为更复杂的人工计算任务提供了框架,这些任务需要许多个人之间的协调,例如撰写一篇文章。CrowdForge通过将分区/映射/缩减步骤作为分布式流程流的基本构建块,将创建和管理子任务的许多编程细节抽象出来,从而使复杂的任务能够系统地、动态地分解为连续的、可并行的子任务。

算法

一种算法可以帮助形式化的众包系统的设计。Yan等人[87]为iPhone设计了一个精确的实时图像搜索系统CuldDebug。CrowdSearch结合了自点动图像搜索和使用MTurk对搜索结果进行实时人工验证。然而,算法可以模拟众包系统的性能。 Wang等人[83]将任务完成时间建模为随机过程,建立了MTurk任务完成预期时间的统计预测方法。实验结果表明,发布任务的时间独立变量(例如,任务类型、HIT价格、发布日期等)如何影响完成时间。Singh[71]提出了一个研究社交媒体网络中用户行为和动机模式的博弈论框架。DiPalantino和Vojnovic[16]建立了一个竞争性众包系统的模型,并证明参与率随着提供的奖励而呈对数增长。 Ipeirotis等人[38]提出了一种用于大众外包系统中标签过程的质量管理的算法。该算法可以生成标量分数,表示每个工人的固有质量。Carterette和Soboroff[12]针对人群的相关性判断提出了八个可能的误差模型,并展示了每个模型如何影响平均精度的估计。Jain和Parkes[40]调查了各种人类计算设计的现有博弈论模型,并概述了通过推进博弈论以更好地设计人类计算系统的研究挑战。

性能

除了为众包概念设计新的应用和算法之外,最近一些研究还研究了众包的性能方面。如本节所示,这些工作可以分为用户参与(User Participation)、质量管理(Quality Management)和作弊检测(Cheating Detection)。

用户参与(User Participation)

在众包系统中,任务被分配给大量匿名互联网用户以供完成。了解群众包的人群特征和检查他们的行为引起了极大的关注。

- 人群特征: 由于亚马逊的Mechanical Turk(MTurk)最近越来越受欢迎,Ross等人[68]描述了工人群体如何随着时间的推移而发生变化,从主要收入适中的美国劳动力转向日益国际化的群体,这些群体拥有大量年轻,受过良好教育的印度工人。对于这些印度工人来说,MTurk可能会越来越多地担任全职工作。为了取消参加但未认真对待学习任务的工人的资格,Downs等人[17]通过使用两个先前试验过的筛选问题来筛选MTurk工作人员。实验结果表明,那些专业人士,学生和非工人似乎比金融工人,小时工和其他工人更重视这项任务。此外,30岁以上的男性和任何年龄的女性更有可能获得资格。

- 财务激励: 许多研究调查了员工在众包系统中的动机。Silberman等人[70]提出与其他动机相比,金钱的重要性,大多数受访者说他们不是为了好玩或消磨时间而做任务。25%的印度受访者和13%的美国受访者表示,MTurk是他们的主要收入来源。研究了财务激励对特定众包任务的影响[27]、[42]、[60]、[31]。哈里斯[27]发现,如果简历审查中任务设计得当,财务激励实际上鼓励了质量。Kazai[42]发现,低工资条件导致大量数字化图书的不可用和垃圾标签数量增加。Moreno等[60]得出的结论是,问题回答网站应该发挥更好的作用(通过更快地填写常见问题解答清单,更快地得到答案),同时获得长期和短期的回报。为了平衡公司生产成本与工人的预约工资,Horton和Chilton[31]提出了一个劳动力供应模型来估计工人的预约工资。

- 内部激励: 虽然货币众包激励占主导地位,但是一些众包系统不向员工提供金钱奖励,比如YouTube。在这些系统中贡献的动机是什么?我们描述不是金钱激励的不同的激励措施,如下。就YouTube而言,注意,通过下载数量来衡量,它是贡献的重要驱动力[36]。显然,在YouTube中生成内容的速率和下载数量之间存在关联。缺乏关注导致上传的视频数量减少,并因此导致生产力下降,这在很多情况下是渐近于没有任何上传。Wu等人[86]表明,YouTube上停止接受关注的贡献者往往会停止贡献,而高产的贡献者则会吸引越来越多的追随者,并将他们的注意力放在反馈回路中。在问答网站,Nam等人[61]研究发现,利他主义、学习和能力是高级应答者经常参与的动机,但这种参与往往是间歇性的。此外,他们还表明,较高的参与水平与更好的性能。为了公开bug报告,Ko和Chilana[45]发现,对于Mozilla,Mozilla所获得的是一小部分有才华的开发人员以及Firefox 1.0发布之前的一些关键修复。这些对开源项目有贡献的大力贡献者无意成为常规的贡献者;他们只是希望修复bug或实现特性。为了实现程序编码的目的,Archak[7]使用世界上最大的竞争软件开发社区(TopCoder.com)的独特数据集,对多个同时进行的众包竞赛中个体性能的决定因素进行了实证分析。它研究了TopCoder.com目前使用的声誉系统对参赛者行为的影响。从观察来看,高分选手在比赛阶段面临着来自对手的更加激烈的竞争。在一个在线照片分享社区,Nov等人[62]表明,社区任期的确影响参与,但这种影响取决于参与活动的类型。

- 工人行为: 许多以前的工作表明用户界面可以影响众包工人的行为。通过分析MTurk上发布任务的等待时间,Ipeirotis[37]发现工人受到当前用户界面的限制,并且通过选择通过现有排序标准之一可用的任务来完成任务。除了用户界面,在文献中还发现了影响众包工作者行为的其他因素。Grady和Lease[24]调查了在MTurk上为文档相关评估设计有效任务所涉及的人为因素。他们发现,许多相同的工人以多批次完成任务,损害了实验控制,可能导致训练或疲劳的影响。然而,MTurk无法阻止这种情况发生。为了提高输出精度,必须确保每个实验都涉及一组不同的工人。除了MTurk,其他众包网站在文献中进行了研究。2008年,Yang等人[88]在中国最大的众包网站之一Taskcn.com上观察了工人活动随时间变化的几个特征。调查发现,大多数工人在仅仅提交几份意见后就变得不活跃,而其他人则继续尝试任务。他们倾向于选择与较少的对手竞争的任务,以增加获胜的机会;或者他们倾向于选择期望回报更高的任务。公司可以将任务外包给员工,而不是将任务分配给特定的员工。基于可量化的努力水平度量, Stewart等人[74]提出了SCOUT的概念((S)uper Contributor超级贡献者、©ontributor贡献者和(OUT)lier离群者)模型,用于描述企业内部(公司防火墙内)的用户参与,并表明可以实现比33-66-1的更公平的分配。

质量管理(Quality Management)

在众包系统中,请求者必须决定如何将一个任务分解成几个小任务。众包系统中的一个中心挑战是如何设计一个任务以便从工人那里获得好的输出。一些研究使用真实数据集进行了综合实验,以研究用户行为对人工审查数据质量的影响。 Mason和Watts[56]指出,增加的金钱刺激增加了群众外包工人的工作数量,但质量没有提高。为了保证工人的输出质量,有必要推导出一套关于众包系统任务的设计原则。

- 图像注释: 以 Amazon Mechanical Turk[1]为例, Snow等人比较了由专家标签提供的自然语言任务的非专家注释和现有黄金标准标签的质量[73]。结果表明,为了模拟专家级别的标签质量,每个项目平均需要收集4个非专家标签,并且应用偏差校正技术后,注释质量可以显著提高。Sheng等人[69]提出了一种利用重复标记的成本模型来进行数据质量分析的方法。他们发现,通过反复的标签,有可能以低成本提高数据质量,特别是在标签有噪声的情况下。此外,当处理未标记数据的成本不是免费的时,重复标记是优选的,因为它在提供高质量的标签方面是有效和稳健的。2010年,Nowak和Rüger[63]对多标签图像标注的注释者间协议进行了研究。虽然它们没有回答需要多少非专家注释集才能获得与专家注释器类似的结果,但它们证明了不同的注释器判断相同的数据,并且不同注释器之间的注释器间协议可以确保质量。

- 文本注释: Rashtchian等人[67]发现使用资格考试可以提高MTurk语言学数据的质量。Hsueh等人[34]是政治博客片断中情感分类的难题。他们确定并确认了MTurk中用于高质量注释的三个选择标准的实用性:噪声水平、情感模糊性和词汇不确定性。事实上,标签质量受人类知识认知意识的影响。Feng等人[19]进行实验,结果表明,对于同一任务,如果事先提供不同的知识,特客(Turker ,亚马逊注册用户)回答问题的方式就会大不相同。局部搜索相关性仅限于局部相关性和地理相关性。Paimess等人[64]使用注释者间协议作为MTurk标签的质量度量,并讨论了仅选择最可靠的标签的简单方法。维基百科通过许多贡献者的努力来改进。Kittur和Kraut[43]表明,在文章中添加更多的编辑器只有在他们使用适当的协调技巧时才能提高文章的质量,而没有添加编辑器则有害。当许多编辑做出贡献时,通过集中工作进行的隐式协调更有帮助,但是通过沟通进行的显式协调没有帮助。

- 一般任务: 一些工作集中于一般任务的质量管理[35],[82]。Huang等人[35]介绍了一种通用的MTurk任务设计方法。他们构建了模型来预测工作的速度和质量。这些模型在一组设计上训练工人输出,然后用于优化任务的设计。他们证明了他们的模型能够精确地预测每单位任务的输出质量,并根据质量度量生成不同的设计。Voyer等人[82]提出了一种生成训练数据的两相混合模型。他们使用命名实体识别作为一个例子。在第一阶段,训练有素的注释器在文本中标记所有命名实体,而不考虑类型。在第二阶段,初始的的众包工作者完成二元判断任务,以指示每个实体的类型。以这种方式分解数据生成任务可以得到一个灵活的、可重用的语料库,该语料库可以适应实体类型分类法的变化。此外,它通过以不牺牲质量的方式利用高可用性和成本效益高的众包工作者池,有效地利用了宝贵的训练有素的注释器资源。

作弊检测(Cheating Detection)

由于众包工作者的匿名性,恶意工作者常常试图通过产生通用答案来最大化他们的经济收益,而不是实际地完成任务。目前,欺诈检测技术要么基于自动评估的控制问题,要么依赖于请求者的手动检查。Eickhoff和de Vries[18]检查了常见的恶意众包工作者的方法,如任务依赖评估、界面依赖评估和观众依赖评估。基于实验结果,他们得出结论,在涉及一定程度的创造性和抽象性的新任务中,恶意工作者不太常见,并且先前的人群过滤可以大大减少恶意工作者的数量。

对于控制问题不适用并且手动重新检查无效的众包系统。Hirth等人[30]提出了两种基于人群的方法来检测作弊工人:多数决策(Majority Decision,MD)和使用控制组(Control Group,CG)来重新检查主要任务的方法。对于MD,同样的任务是给几个不同的工人,并对结果进行比较。大多数工人提交的结果被认为是正确的。对于CG,单个工人处理一个主要任务,而由某些其他工人组成的控制组重新检查结果,无论它是否有效。通常,主要任务是昂贵的,而重新检查任务更便宜。如果控制组的大多数成员认为任务正确完成,则认为任务是有效的。实验结果表明,基于人群的欺诈检测机制廉价、可靠、易于实现,适用于不同类型的典型众包任务。

在某些情况下,雇佣专家进行欺诈检测是非常昂贵的。Almendra和Schwabe[5]建议使用众包来提高在线拍卖网站当前欺诈检测技术的精确度和召回率。他们表示,在负面反馈出现之前,他们可以区分欺诈者和普通卖家,并只查看卖家简介的快照。

数据集

一些众包数据集现在可用于进一步的研究。例如,von Ahn等人从他们的ESP Game.11提供了100000张带有英文标签的图片列表。Law等人发布了一个名为Taatatune.12[48]的人类计算游戏的研究数据集。他们的网站包含由TagATune游戏收集的人类注释、从下载名为Magnatune.13的歌曲的网站下载的相应声音剪辑、脚本的源代码、以及曲目结构和音乐内容的详细分析。最近,Chen等人开发了ESP Lite游戏,类似于von Ahn等人介绍的ESP游戏,并收集了玩家玩Game.14的统计数据。Oversite有限公司开发了CiteULike.15,一个免费的网站,帮助学者跟踪他们阅读的文章。鼓励用户在网上公开他们的库,这样其他人就可以从发现他们可能没有发现的有用文章中获益。2009年,Benjamin Markines和Filippo Menczer从两个社交书签系统——Bibson.16和.AL.17——的可用数据集中提取了标签和资源之间的关系[55]。在2010, Ipeirotis等人通过计算新项目的每日统计数据和每天一次完成的任务,从Amazon Machine Turk收集所有可用的信息,并将数据集共享给公众.18。Körner和Strohmaier[47]发布了一份可用于研究的社交标签数据集.19。

结论

我们调查了各种众包系统,并将它们分为四类:应用程序,算法,性能和数据集。 据我们所知,这是对新兴众包问题的第一次广泛调查。 该调查不仅提供了对众包系统的更好理解,还促进了众包领域未来的研究活动和应用开发。

致谢

作者要感谢评论者的有益意见。这项工作部分得到了微软(项目6902498号)和中国香港特别行政区研究资助委员会的资助(香港中文大学413210号项目)。它隶属于微软-中大以人为中心的计算和接口技术联合实验室。

文献

[1] Amazon mechanical turk. https://www.mturk.com/.

[2] GWAP. http://www.gwap.com/gwap/.

[3] The sheep market. http://www.thesheepmarket.com/.

[4] C. Akkaya, A. Conrad, J. Wiebe, and R. Mihalcea. Amazon mechanical turk for subjectivity word sense disambiguation. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 195–203, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[5] V. Almendra and D. Schwabe. Fraud detection by human agents: A pilot study. In Proceedings of the 10th International Conference on E-Commerce and Web Technologies, EC-Web 2009, pages 300–311, Berlin, Heidelberg, 2009. Springer-Verlag.

[6] O. Alonso, D. E. Rose, and B. Stewart. Crowdsourcing for relevance evaluation. SIGIR Forum, 42:9–15, November 2008.

[7] N. Archak. Money, glory and cheap talk: analyzing strategic behavior of contestants in simultaneous crowdsourcing contests on topcoder.com. In Proceedings of the 19th international conference on World wide web, WWW ’10, pages 21–30, New York, NY, USA, 2010. ACM.

[8] M. Bernstein, D. Tan, G. Smith, M. Czerwinski, and E. Horvitz. Collabio: a game for annotating people within social networks. In Proceedings of the 22nd annual ACM symposium on User interface software and technology, UIST ’09, pages 97–100, New York, NY, USA, 2009. ACM.

[9] M. S. Bernstein, D. Tan, G. Smith, M. Czerwinski, and E. Horvitz. Personalization via friendsourcing. ACM Trans. Comput.-Hum. Interact., 17:6:1–6:28, May 2008.

[10] D. C. Brabham. Crowdsourcing as a model for problem solving: An introduction and cases. Convergence: The International Journal of Research into New Media Technologies, 14(1):75–90, 2008.

[11] C. Callison-Burch and M. Dredze. Creating speech and language data with amazon’s mechanical turk. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 1–12, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[12] B. Carterette and I. Soboroff. The effect of assessor error on ir system evaluation. In Proceeding of the 33rd international ACM SIGIR conference on Research and development in information retrieval, SIGIR ’10, pages 539–546, New York, NY, USA, 2010. ACM.

[13] S. Casey, B. Kirman, and D. Rowland. The gopher game: a social, mobile, locative game with user generated content and peer review. In International Conference on Advances in Computer Entertainment Technology, pages 9–16, 2007.

[14] K. T. Chan, I. King, and M.-C. Yuen. Mathematical modeling of social games. In CSE ’09: Proceedings of the 2009 International Conference on Computational Science and Engineering, pages 1205–1210. IEEE Computer Society, 2009.

[15] D. R. Choffnes, F. E. Bustamante, and Z. Ge. Crowdsourcing servicelevel network event monitoring. SIGCOMM Comput. Commun. Rev., 40:387–398, August 2010.

[16] D. DiPalantino and M. Vojnovic. Crowdsourcing and all-pay auctions. In Proceedings of the 10th ACM conference on Electronic commerce, EC ’09, pages 119–128, New York, NY, USA, 2009. ACM.

[17] J. S. Downs, M. B. Holbrook, S. Sheng, and L. F. Cranor. Are your participants gaming the system?: screening mechanical turk workers. In Proceedings of the 28th international conference on Human factors in computing systems, CHI ’10, pages 2399–2402, New York, NY, USA, 2010. ACM.

[18] C. Eickhoff and A. P. de Vries. How crowdsourcable is your task? In Proceedings of the Workshop on Crowdsourcing for Search and Data Mining (CSDM 2011), WSDM 2011, pages 11–14, New York, NY, USA, 2011. ACM.

[19] D. Feng, S. Besana, K. Boydston, and G. Christian. Towards high-quality data extraction via crowdsourcing. In Proceedings of the CrowdConf 2010, CrowdConf 2010, 2010.

[20] T. Finin, W. Murnane, A. Karandikar, N. Keller, J. Martineau, and M. Dredze. Annotating named entities in twitter data with crowdsourcing. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 80–88, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[21] Q. Gao and S. Vogel. Consensus versus expertise: a case study of word alignment with mechanical turk. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 30–34, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[22] S. A. Golder and B. A. Huberman. The structure of collaborative tagging systems. CoRR, abs/cs/0508082, 2005.

[23] J. Gordon, V. D. Benjamin, and L. K. Schubert. Evaluation of commonsense knowledge with mechanical turk. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 159–162, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[24] C. Grady and M. Lease. Crowdsourcing document relevance assessment with mechanical turk. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 172–179, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[25] L. Grant, H. Daanen, S. Benford, A. Hampshire, A. Drozd, and C. Greenhalgh. MobiMissions: the game of missions for mobile phones. In ACM SIGGRAPH, 2007.

[26] N. Green, P. Breimyer, V. Kumar, and N. F. Samatova. Packplay: mining semantic data in collaborative games. In Proceedings of the Fourth Linguistic Annotation Workshop, LAW IV ’10, pages 227–234, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[27] C. G. Harris. You’re hired! an examination of crowdsourcing incentive models in human resource tasks. In Proceedings of the Workshop on Crowdsourcing for Search and Data Mining (CSDM 2011), WSDM 2011, pages 15–18, New York, NY, USA, 2011. ACM.

[28] J. Heer and M. Bostock. Crowdsourcing graphical perception: using mechanical turk to assess visualization design. In Proceedings of the 28th international conference on Human factors in computing systems, CHI ’10, pages 203–212, New York, NY, USA, 2010. ACM.

[29] C. Higgins, E. McGrath, and L. Moretto. Mturk crowdsourcing: a viable method for rapid discovery of arabic nicknames? In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 89–92, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[30] M. Hirth, T. Hoßfeld, and P. Tran-Gia. Cheat-detection mechanisms for crowdsourcing. Technical Report 474, University of Würzburg, 8 2010.

[31] J. J. Horton and L. B. Chilton. The labor economics of paid crowdsourcing. In Proceedings of the 11th ACM conference on Electronic commerce, EC ’10, pages 209–218, New York, NY, USA, 2010. ACM.

[32] J. Howe. The rise of crowdsourcing. Wired, 14(6), June 2006.

[33] J. Howe. Crowdsourcing: Why the Power of the Crowd is Driving the Future of Business. Crown Business, 2008.

[34] P.-Y. Hsueh, P. Melville, and V. Sindhwani. Data quality from crowdsourcing: a study of annotation selection criteria. In Proceedings of the NAACL HLT 2009 Workshop on Active Learning for Natural Language Processing, HLT ’09, pages 27–35, Morristown, NJ, USA, 2009. Association for Computational Linguistics.

[35] E. Huang, H. Zhang, D. C. Parkes, K. Z. Gajos, and Y. Chen. Toward automatic task design: a progress report. In Proceedings of the ACM SIGKDD Workshop on Human Computation, HCOMP ’10, pages 77–85, New York, NY, USA, 2010. ACM.

[36] B. A. Huberman, D. M. Romero, and F. Wu. Crowdsourcing, attention and productivity. J. Inf. Sci., 35:758–765, December 2009.

[37] P. G. Ipeirotis. Analyzing the amazon mechanical turk marketplace. XRDS, 17:16–21, December 2010.

[38] P. G. Ipeirotis, F. Provost, and J. Wang. Quality management on amazon mechanical turk. In Proceedings of the ACM SIGKDD Workshop on Human Computation, HCOMP ’10, pages 64–67, New York, NY, USA, 2010. ACM.

[39] A. P. Jagadeesan, A. Lynn, J. R. Corney, X. T. Yan, J. Wenzel, A. Sherlock, and W. Regli. Geometric reasoning via internet crowdsourcing. In 2009 SIAM/ACM Joint Conference on Geometric and Physical Modeling, SPM ’09, pages 313–318, New York, NY, USA, 2009. ACM.

[40] S. Jain and D. C. Parkes. The role of game theory in human computation systems. In Proceedings of the ACM SIGKDD Workshop on Human Computation, HCOMP ’09, pages 58–61, New York, NY, USA, 2009. ACM.

[41] M. Jha, J. Andreas, K. Thadani, S. Rosenthal, and K. McKeown. Corpus creation for new genres: A crowdsourced approach to pp attachment. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 13–20, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[42] G. Kazai. An exploration of the influence that task parameters have on the performance of crowds. In Proceedings of the CrowdConf 2010, CrowdConf 2010, 2010.

[43] A. Kittur and R. E. Kraut. Harnessing the wisdom of crowds in wikipedia: quality through coordination. In Proceedings of the 2008 ACM conference on Computer supported cooperative work, CSCW ’08, pages 37–46, New York, NY, USA, 2008. ACM.

[44] A. Kittur, B. Smus, and R. Kraut. Crowdforge: crowdsourcing complex work. In Proceedings of the 2011 annual conference extended abstracts on Human factors in computing systems, CHI EA ’11, pages 1801–1806, New York, NY, USA, 2011. ACM.

[45] A. J. Ko and P. K. Chilana. How power users help and hinder open bug reporting. In Proceedings of the 28th international conference on Human factors in computing systems, CHI ’10, pages 1665–1674, New York, NY, USA, 2010. ACM.

[46] A. M. Koblin. The sheep market. In Proceeding of the seventh ACM conference on Creativity and cognition, C&C ’09, pages 451–452, New York, NY, USA, 2009. ACM.

[47] C. Körner and M. Strohmaier. A call for social tagging datasets. SIGWEB Newsl., pages 2:1–2:6, January 2010.

[48] E. Law and L. von Ahn. Input-agreement: A new mechanism for data collection using human computation games. In ACM CHI, 2009.

[49] N. Lawson, K. Eustice, M. Perkowitz, and M. Yetisgen-Yildiz. Annotating large email datasets for named entity recognition with mechanical turk. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 71–79, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[50] J. Leimeister, M. Huber, U. Bretschneider, and H. Krcmar. Leveraging crowdsourcing: Activation-supporting components for it-based ideas competition. J. Manage. Inf. Syst., 26:197–224, July 2009.

[51] H. Lieberman, D. Smith, and A. Teeters. Common Consensus: a webbased game for collecting commonsense goals. In ACM Workshop on Common Sense for Intelligent Interfaces, 2007.

[52] G. Little, L. B. Chilton, M. Goldman, and R. C. Miller. Turkit: human computation algorithms on mechanical turk. In Proceedings of the 23nd annual ACM symposium on User interface software and technology, UIST ’10, pages 57–66, New York, NY, USA, 2010. ACM.

[53] N. Maisonneuve, M. Stevens, M. E. Niessen, P. Hanappe, and L. Steels. Citizen noise pollution monitoring. In Proceedings of the 10th Annual International Conference on Digital Government Research: Social Networks: Making Connections between Citizens, Data and Government, dg.o ’09, pages 96–103. Digital Government Society of North America, 2009.

[54] M. Mandel and D. Ellis. A web-based game for collecting music metadata. In 8th International Conference on Music Information Retrieval (ISMIR).

[55] B. Markines and F. Menczer. A scalable, collaborative similarity measure for social annotation systems. In HT ’09: Proceedings of the 20th ACM conference on Hypertext and hypermedia, pages 347–348, New York, NY, USA, 2009. ACM.

[56] W. Mason and D. J. Watts. Financial incentives and the ”performance of crowds”. SIGKDD Explor. Newsl., 11:100–108, May 2010.

[57] S. Matyas. Playful geospatial data acquisition by location-based gaming communities. The International Journal of Virtual Reality, 6(3):1–10, 2007.

[58] S. Matyas, C. Matyas, C. Schlieder, P. Kiefer, H. Mitarai, and M. Kamata. Designing Location-based Mobile Games With A Purpose: Collecting Geospatial Data with CityExplorer. In ACM ACE, 2008.

[59] B. Mellebeek, F. Benavent, J. Grivolla, J. Codina, M. R. Costa-jussà, and R. Banchs. Opinion mining of spanish customer comments with nonexpert annotations on mechanical turk. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 114–121, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[60] A. Moreno, J. L. de la Rosa, B. K. Szymanski, and J. M. Barcenas. Reward system for completing faqs. In Proceeding of the 2009 conference on Artificial Intelligence Research and Development: Proceedings of the 12th International Conference of the Catalan Association for Artificial Intelligence, pages 361–370, Amsterdam, The Netherlands, The Netherlands, 2009. IOS Press.

[61] K. K. Nam, M. S. Ackerman, and L. A. Adamic. Questions in, knowledge in?: a study of naver’s question answering community. In Proceedings of the 27th international conference on Human factors in computing systems, CHI ’09, pages 779–788, New York, NY, USA, 2009. ACM.

[62] O. Nov, M. Naaman, and C. Ye. Analysis of participation in an online photo-sharing community: A multidimensional perspective. J. Am. Soc. Inf. Sci. Technol., 61:555–566, March 2010.

[63] S. Nowak and S. Rüger. How reliable are annotations via crowdsourcing: a study about inter-annotator agreement for multi-label image annotation. In Proceedings of the international conference on Multimedia information retrieval, MIR ’10, pages 557–566, New York, NY, USA, 2010. ACM.

[64] J.-F. Paiement, J. G. Dr. Shanahan, and R. Zajac. Crowdsourcing local search relevance. In Proceedings of the CrowdConf 2010, CrowdConf 2010, 2010.

[65] G. Parent and M. Eskenazi. Clustering dictionary definitions using amazon mechanical turk. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 21–29, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[66] A. J. Quinn and B. B. Bederson. Human computation: a survey and taxonomy of a growing field. In Proceedings of the 2011 annual conference on Human factors in computing systems, CHI ’11, pages 1403–1412, New York, NY, USA, 2011. ACM.

[67] C. Rashtchian, P. Young, M. Hodosh, and J. Hockenmaier. Collecting image annotations using amazon’s mechanical turk. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 139–147, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[68] J. Ross, L. Irani, M. S. Silberman, A. Zaldivar, and B. Tomlinson. Who are the crowdworkers?: shifting demographics in mechanical turk. In Proceedings of the 28th of the international conference extended abstracts on Human factors in computing systems, CHI EA ’10, pages 2863–2872, New York, NY, USA, 2010. ACM.

[69] V. S. Sheng, F. Provost, and P. G. Ipeirotis. Get Another Label? Improving Data Quality and Data Mining Using Multiple, Noisy Labelers. In ACM KDD, 2008.

[70] M. S. Silberman, L. Irani, and J. Ross. Ethics and tactics of professional crowdwork. XRDS, 17:39–43, December 2010.

[71] V. K. Singh, R. Jain, and M. S. Kankanhalli. Motivating contributors in social media networks. In Proceedings of the first SIGMM workshop on Social media, WSM ’09, pages 11–18, New York, NY, USA, 2009. ACM.

[72] A. Skory and M. Eskenazi. Predicting cloze task quality for vocabulary training. In Proceedings of the NAACL HLT 2010 Fifth Workshop on Innovative Use of NLP for Building Educational Applications, IUNLPBEA ’10, pages 49–56, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[73] R. Snow, B. O’Connor, D. Jurafsky, and A. Y. Ng. Cheap and fast—but is it good?: evaluating non-expert annotations for natural language tasks. In Proceedings of the Conference on Empirical Methods in Natural Language Processing, EMNLP ’08, pages 254–263, Morristown, NJ, USA, 2008. Association for Computational Linguistics.

[74] O. Stewart, D. Lubensky, and J. M. Huerta. Crowdsourcing participation inequality: a scout model for the enterprise domain. In Proceedings of the ACM SIGKDD Workshop on Human Computation, HCOMP ’10, pages 30–33, New York, NY, USA, 2010. ACM.

[75] D. Turnbull, R. Liu, L. Barrington, and G. Lanckriet. A gamebased approach for collecting semantic annotations of music. In 8th International Conference on Music Information Retrieval (ISMIR).

[76] L. von Ahn. Games with a Purpose. IEEE Computer, 39(6):92–94, June 2006.

[77] L. von Ahn and L. Dabbish. Labeling Images with a Computer Game. In ACM SIGCHI Conference on Human Factors in Computing Systems, 2004.

[78] L. von Ahn, S. Ginosar, M. Kedia, and M. Blum. Improving Image Search with PHETCH. In IEEE International Conference on Acoustics, Speech and Signal Processing, 2007.

[79] L. von Ahn, S. Ginosar, M. Kedia, R. Liu, and M. Blum. Improving accessibility of the web with a computer game. In ACM SIGCHI Conference on Human Factors in Computing Systems, 2006.

[80] L. von Ahn, M. Kedia, and M. Blum. Verbosity: A Game for Collecting Common-Sense Facts. In ACM SIGCHI Conference on Human Factors in Computing Systems, 2006.

[81] L. von Ahn, R. Liu, and M. Blum. Peekaboom: A Game for Locating Objects in Images. In ACM SIGCHI Conference on Human Factors in Computing Systems, 2006.

[82] R. Voyer, V. Nygaard, W. Fitzgerald, and H. Copperman. A hybrid model for annotating named entity training corpora. In Proceedings of the Fourth Linguistic Annotation Workshop, LAW IV ’10, pages 243–246, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[83] J. Wang, S. Faridani, and P. G. Ipeirotis. Estimating the completion time of crowdsourced tasks using survival analysis models. In Proceedings of the Workshop on Crowdsourcing for Search and Data Mining (CSDM 2011), WSDM 2011, pages 31–34, New York, NY, USA, 2011. ACM.

[84] R. Wang and C. Callison-Burch. Cheap facts and counter-facts. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 163–167, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[85] L. Weng and F. Menczer. Givealink tagging game: an incentive for social annotation. In Proceedings of the ACM SIGKDD Workshop on Human Computation, HCOMP ’10, pages 26–29, New York, NY, USA, 2010. ACM.

[86] F. Wu, D. M. Wilkinson, and B. A. Huberman. Feedback loops of attention in peer production. In Proceedings of the 2009 International Conference on Computational Science and Engineering Volume 04, pages 409–415, Washington, DC, USA, 2009. IEEE Computer Society.

[87] T. Yan, V. Kumar, and D. Ganesan. Crowdsearch: exploiting crowds for accurate real-time image search on mobile phones. In Proceedings of the 8th international conference on Mobile systems, applications, and services, MobiSys ’10, pages 77–90, New York, NY, USA, 2010. ACM.

[88] J. Yang, L. A. Adamic, and M. S. Ackerman. Crowdsourcing and knowledge sharing: strategic user behavior on taskcn. In Proceedings of the 9th ACM conference on Electronic commerce, EC ’08, pages 246– 255, New York, NY, USA, 2008. ACM.

[89] M. Yetisgen-Yildiz, I. Solti, F. Xia, and S. R. Halgrim. Preliminary experience with amazon’s mechanical turk for annotating medical named entities. In Proceedings of the NAACL HLT 2010 Workshop on Creating Speech and Language Data with Amazon’s Mechanical Turk, CSLDAMT ’10, pages 180–183, Morristown, NJ, USA, 2010. Association for Computational Linguistics.

[90] M.-C. Yuen, L.-J. Chen, and I. King. A survey of human computation systems. In CSE ’09: Proceedings of IEEE International Conference on Computational Science and Engineering, pages 723–728. IEEE Computer Society, 2009.

[91] M.-C. Yuen, I. King, and K.-S. Leung. Task matching in crowdsourcing. In CPSCom ’11: Proceedings of The 4th IEEE International Conferences on Cyber, Physical and Social Computing. IEEE Computer Society, 2011. To be appeared.