负载均衡之Haproxy配置

常用开源软件负载均衡器有:Nginx、LVS、Haproxy。

三大主流软件负载均衡器对比(LVS VS Nginx VS Haproxy)

一、LVS:

1、抗负载能力强。抗负载能力强、性能高,能达到F5硬件的60%;对内存和cpu资源消耗比较低

2、工作在网络4层,通过vrrp协议转发(仅作分发之用),具体的流量由linux内核处理,因此没有流量的产生。

2、稳定性、可靠性好,自身有完美的热备方案;(如:LVS+Keepalived)

3、应用范围比较广,可以对所有应用做负载均衡;

4、不支持正则处理,不能做动静分离。

5、支持负载均衡算法:rr(轮循)、wrr(带权轮循)、lc(最小连接)、wlc(权重最小连接)

6、配置 复杂,对网络依赖比较大,稳定性很高。

二、Ngnix:

1、工作在网络的7层之上,可以针对http应用做一些分流的策略,比如针对域名、目录结构;

2、Nginx对网络的依赖比较小,理论上能ping通就就能进行负载功能;

3、Nginx安装和配置比较简单,测试起来比较方便;

4、也可以承担高的负载压力且稳定,一般能支撑超过1万次的并发;

5、对后端服务器的健康检查,只支持通过端口来检测,不支持通过url来检测。

6、Nginx对请求的异步处理可以帮助节点服务器减轻负载;

7、Nginx仅能支持http、https和Email协议,这样就在适用范围较小。

8、不支持Session的直接保持,但能通过ip_hash来解决。、对Big request header的支持不是很好,

9、支持负载均衡算法:Round-robin(轮循)、Weight-round-robin(带权轮循)、Ip-hash(Ip哈希)

10、Nginx还能做Web服务器即Cache功能。

三、HAProxy的特点是:

1、支持两种代理模式:TCP(四层)和HTTP(七层),支持虚拟主机;

2、能够补充Nginx的一些缺点比如Session的保持,Cookie的引导等工作

3、支持url检测后端的服务器出问题的检测会有很好的帮助。

4、更多的负载均衡策略比如:动态加权轮循(Dynamic Round Robin),加权源地址哈希(Weighted Source Hash),加权URL哈希和加权参数哈希(Weighted Parameter Hash)已经实现

5、单纯从效率上来讲HAProxy更会比Nginx有更出色的负载均衡速度。

6、HAProxy可以对Mysql进行负载均衡,对后端的DB节点进行检测和负载均衡。

9、支持负载均衡算法:Round-robin(轮循)、Weight-round-robin(带权轮循)、source(原地址保持)、RI(请求URL)、rdp-cookie(根据cookie)

10、不能做Web服务器即Cache。

三大主流软件负载均衡器适用业务场景:

1、网站建设初期,可以选用Nigix/HAproxy作为反向代理负载均衡(或者流量不大都可以不选用负载均衡),因为其配置简单,性能也能满足一般的业务场景。如果考虑到负载均衡器是有单点问题,可以采用Nginx+Keepalived/HAproxy+Keepalived避免负载均衡器自身的单点问题。

2、网站并发达到一定程度之后,为了提高稳定性和转发效率,可以使用LVS、毕竟LVS比Nginx/HAproxy要更稳定,转发效率也更高。不过维护LVS对维护人员的要求也会更高,投入成本也更大。

注:Niginx与Haproxy比较:Niginx支持七层、用户量最大,稳定性比较可靠。Haproxy支持四层和七层,支持更多的负载均衡算法,支持session保存等。具体选型看使用场景,目前来说Haproxy由于弥补了一些Niginx的缺点用户量也不断在提升。

衡量负载均衡器好坏的几个重要因素:

1、会话率 :单位时间内的处理的请求数

2、会话并发能力:并发处理能力

3、数据率:处理数据能力

经过官方测试统计,haproxy 单位时间处理的最大请求数为20000个,可以同时维护40000-50000个并发连接,最大数据处理能力为10Gbps。综合上述,haproxy是性能优越的负载均衡、反向代理服务器。

总结HAProxy主要优点:

一、免费开源,稳定性也是非常好,这个可通过我做的一些小项目可以看出来,单Haproxy也跑得不错,稳定性可以与LVS相媲美;

二、根据官方文档,HAProxy可以跑满10Gbps-New benchmark of HAProxy at 10 Gbps using Myricom’s 10GbE NICs (Myri-10G PCI-Express),这个作为软件级负载均衡,也是比较惊人的;

三、HAProxy可以作为MySQL、邮件或其它的非web的负载均衡,我们常用于它作为MySQL(读)负载均衡;

四、自带强大的监控服务器状态的页面,实际环境中我们结合Nagios进行邮件或短信报警,这个也是我非常喜欢它的原因之一;

五、HAProxy支持虚拟主机。

下述将选择Haproxy作为负载均衡器进行讲解:

本次使用环境:

ubuntu16.04+Haproxy 192.168.93.21

centos6+httpd 192.168.93.5

centos6+httpd 192.168.93.7

Haproxy配置文件

vi /etc/haproxy/haproxy.cfg

global

log /dev/log local0

log /dev/log local1 notice

chroot /var/lib/haproxy

stats socket /run/haproxy/admin.sock mode 660 level admin

stats timeout 30s

user haproxy

group haproxy

daemon

# Default SSL material locations

ca-base /etc/ssl/certs

crt-base /etc/ssl/private

# Default ciphers to use on SSL-enabled listening sockets.

# For more information, see ciphers(1SSL). This list is from:

# https://hynek.me/articles/hardening-your-web-servers-ssl-ciphers/

ssl-default-bind-ciphers ECDH+AESGCM:DH+AESGCM:ECDH+AES256:DH+AES256:ECDH+AES128:DH+AES:ECDH+3DES:DH+3DES:RSA+AESGCM:RSA+AES:RSA+3DES:!aNULL:!MD5:!DSS

ssl-default-bind-options no-sslv3

defaults

log global

mode http #默认的模式mode { tcp|http|health },tcp是4层,http是7层,health只会返回OK

option httplog

option dontlognull

timeout connect 5000

timeout client 50000

timeout server 50000

errorfile 400 /etc/haproxy/errors/400.http

errorfile 403 /etc/haproxy/errors/403.http

errorfile 408 /etc/haproxy/errors/408.http

errorfile 500 /etc/haproxy/errors/500.http

errorfile 502 /etc/haproxy/errors/502.http

errorfile 503 /etc/haproxy/errors/503.http

errorfile 504 /etc/haproxy/errors/504.http

########统计页面配置########

listen admin_stats

bind 0.0.0.0:1080 #监听端口

mode http #http的7层模式

option httplog #采用http日志格式

#log 127.0.0.1 local0 err

maxconn 10

stats refresh 30s #统计页面自动刷新时间

stats uri /stats #统计页面url

stats realm XingCloud\ Haproxy #统计页面密码框上提示文本

stats auth admin:admin #统计页面用户名和密码设置

stats hide-version #隐藏统计页面上HAProxy的版本信息

########test配置#################

listen test

bind 0.0.0.0:8080 #注意端口号要不低于1024

mode tcp

#maxconn 4086

#log 127.0.0.1 local0 debug

server s1 192.168.93.5:80

server s2 192.168.93.7:80

假若想访问监控界面:配置stats uri /haproxy项,重启服务:

service haproxy restart

接下来对Haproxy+web负载均衡使用进行实战讲解:

首先配置两台web服务器:192.168.93.5/192.168.93.7

两台都是同样操作:

1、实验环境

CentOS release 6.8 (Final)

2、配置web服务器(node5/7):

测试方便,关闭selinux、关闭iptables

一下都采用默认,不做配置即可。

yum install httpd -y

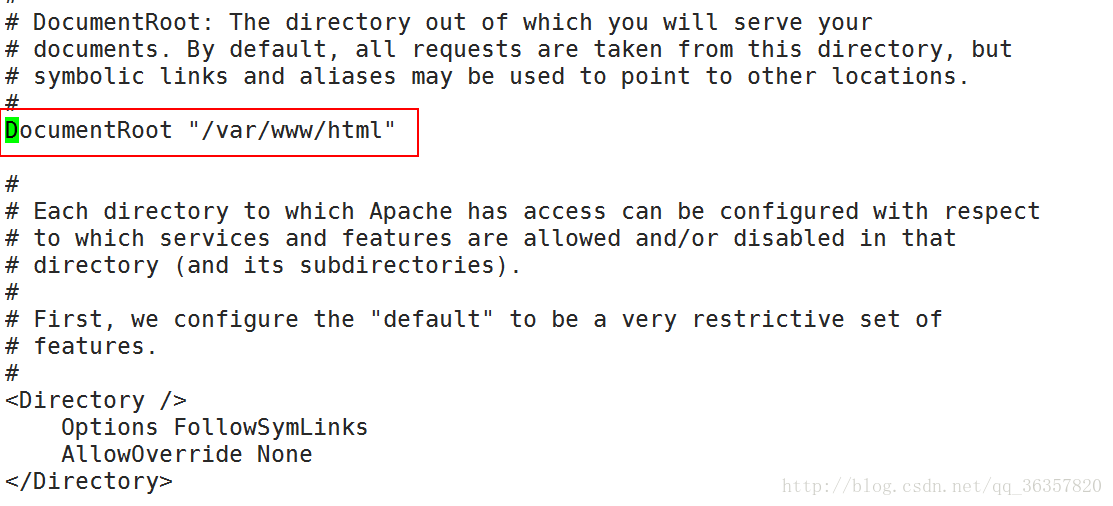

# vim /etc/httpd/conf/httpd.conf

httpd监听端口:

DocumentRoot:网页存放的路径,文档的根目录

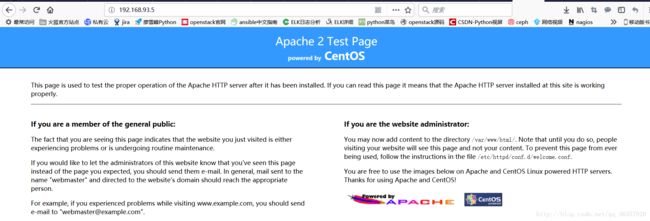

重启httpd

#service httpd restart

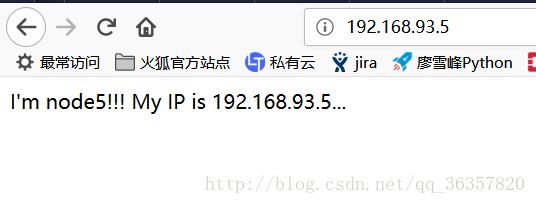

修改显示内容:

# vim /var/www/html/index.html

I'm node5!!! My IP is 192.168.93.5...

再次访问:

这样三个web服务就搭好了

接下来配置负载均衡(本次实验只用一个Haproxy:192.168.93.21):

vim /etc/haproxy/haproxy.cfg

########test配置#################

listen test

bind 0.0.0.0:8080 #注意端口号要不低于1024

mode tcp

#maxconn 4086

#log 127.0.0.1 local0 debug

server s1 192.168.93.5:80

server s2 192.168.93.7:80

浏览器请求192.168.93.21:8080

从上述结果可知,前端对192.168.93.21的请求,被Haproxy的负载均衡器,均衡请求到两个后端web192.168.93.5、192.168.93.7上面去了。

这样当两个中的一个出现故障,流量则能正常分发到剩余一个正常的web上,从来提高了系统可靠性。