AI深度 | 3D人脸识别和双目结构光惯导

文/纽豪斯

发布/AI智道

一文看尽双目摄像、结构光、ToF和激光雷达技术;一文深入了解小觅智能、奥比中光、华捷艾米、的卢深视、Pico和镭神智能;AI赋能2大趋势、4大核心技术。

前言

纽豪斯刚刚完成《AI深度(上) | 3D人脸识别和结构光》,发表到公众号AI智道受到了广泛的关注,读者的反馈很多,有的读者评价说“技术理论部分讲的很清楚、趋势判断也很准确”,有的读者评论关于双目摄像机的典型代表选用的不正确,原因是“双目摄像头现在都是要求有瞳间距,而且两个摄像头之间是越远越准确。”好吧,纽豪斯承认,在AI深度相机的学习道路上,我刚刚上路7天,现学现卖。有一位郭姓读者留言道“第一个视派尔的模组似乎没有双目测距,看图片只是一个IR和一个RGB而已”,看来纽豪斯是碰到专业读者了。

于是纽豪斯赶快咨询了专业人士,也找到了专业论文,在“AI深度(上)”、“AI深度(下)”完成之后赶快补一篇“AI深度(续)”,这让纽豪斯想到了“狗尾续貂”这个成语,前两篇文章不一定是“狗尾”,但这一篇一定是貂皮大衣。

专业人士

纽豪斯找到的专业人士名叫Leo,美国斯坦福大学机械工程博士和计算机硕士双学位,向纽豪斯提供了一篇专业的论文《IMU Integrated Structured-Light Stereo Depth Camera for Mobile Robot Navigation and Obstacle Detection》(为机器人导航和避障而打造的的小觅双目结构光惯导深度相机),当然作者正是Leo本人,让我们一起来领略一下双目结构光惯导技术。

Leo认为传统的双目属于被动的双目,而另外一种是主动双目。被动双目如果同时打两个结构光的斑点的话会发生干涉和光污染的问题,但主动双目就没有这样的问题。这篇文章主要是基于Leo的论文完成的,感谢Leo。

AI深度双目技术背景

在动物世界中,人类从肉体上来说并不是最强大的物种,如果赤手空拳,相信最强大的人也很难和猛兽进行搏击,丝毫不占优势,但在地球的生活环境中看,现实中还不存在人类无法战胜的兽类,因为人和其它动物的最大区别在于人有智慧,语言是人类最强大的工具,因为语言是有能力的,在西方国家很多人都相信世界是由话语(Word)创造的。

人和动物的最大区别主要在于语言,那么人和机器之间最大的区别是什么?这正是人工智能(AI)所要研究的核心问题。人的眼睛能够获得三维的信息,可以准确的认识这个世界,没有复杂的算法、延迟、分辨率,而机器认识这个世界只能通过传感器来认识,用摄像机(相机)模仿人的眼睛是最好的一种方式,这种技术被称之为计算机视觉,也被称之为人工智能。

人工智能的字面含义就是模仿人感知世界的能力,主要就包括计算机视觉、语音(识别)和文字(OCR)识别三种。

目前市面上大多数的计算机视觉技术主要应用于人脸识别,由于视频监控的发展趋势和基础,50多年的发展都是基于RGB监控摄像机的(用专业术语来讲就是2D摄像机),也就是说大家常见的摄像机所拍摄到的视频(实际上是每秒25帧的画面)是平面图像的,没有深度,从而造成机器理解世界产生了巨大的限制,而每个健全的人拥有两个眼睛(双目),故而市面上出现了深度相机(摄像机)采用双目架构,使得机器(姑且称之为计算机)获得三维视觉能力(深度图像),由此视频监控系统进入3D人脸识别世界,而这是大多数人脸识别独角兽不具备的能力。

深度摄像机大行其道必定会成为一种趋势。

立体视觉

立体视觉又称距离知觉或立体知觉。是个体对同一物体的凹凸或对不同物体的远近的反映。视网膜是一个两维的平面,人不仅能感知平面物体,还能感知三维空间中的物体。深度知觉是通过双目视觉实现的。

计算机立体视觉和人眼有类似之处,一般而言,计算机立体视觉,尤其和以仿生学为基础的双目立体视觉由如下几部分组成:

(1) 图像获取。包括场景领域、计时、时间(照明和阴影)、成像形态(包括特殊的遮盖)、分辨率、视野 (field of view, FOV)、摄像机的相对位置。场景的复杂程度受如下因素的影响:遮掩、人工物体(直的边界,平的表面) 、均匀的纹理区域、含有重复结构的区域。

(2) 摄像机模型。就是对立体摄像机组的重要的几何与物理特征的表示形式,它作为一个计算模型,根据对应点的视差信息,用于计算对应点所代表的空间点的位置。摄像机模型除了提供图像上对应点空间与实际场景空间之间的映射关系外,还可以用于约束寻找对应点时的搜索空间,从而降低匹配算法的复杂性,减小误匹配率。

(3) 特征抽取。

(4) 图像匹配。

(5) 深度计算。立体视觉的关键在于左右眼图像中相同特征的匹配,一旦精确的对应点建立起来,距离的计算相对而言只是一个简单的三角计算而已。

总之,提高深度计算精度的途径有三条,各自涉及了一些附加的计算量:半象素精度估计、 加长基线长、内插。

深度检测主要技术方法

在《AI深度(上) | 3D人脸识别和结构光》中,纽豪斯就提到深度相机分为双目、ToF、结构光和激光雷达四种。双目跟结构光一样,都是使用三角测量法根据物体匹配点的视差反算物体距离,只是双目是用自然光,而结构光是用主动光发射特定图案的条纹或散斑。ToF 是通过给目标连续发送光脉冲,然后用传感器接收从物体返回的光,通过探测光脉冲的飞行(往返)时间来得到目标物距离。

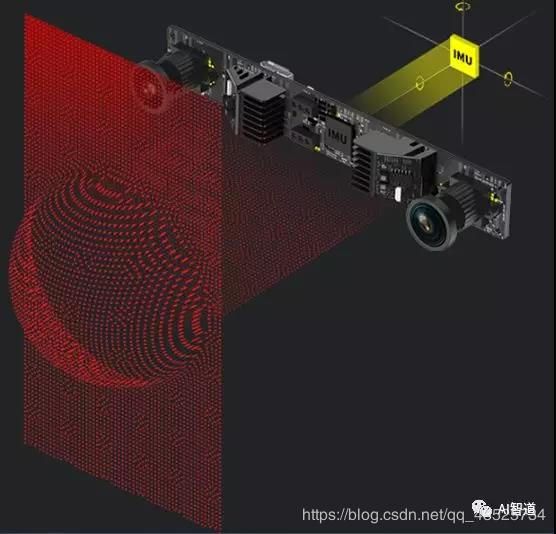

小觅双目结构光深度惯导相机

接下来就是纽豪斯要补充完善的双目摄像机的代表产品:小觅智能双目结构光深度惯导相机。

双目+结构光+惯导的三项融合而成的新型深度相机。从前文对三类视觉深度相机的分析可以看出,ToF和结构光都属于主动光,容易受可见光和物体表面干扰,所以更适合室内和短距离的应用场景,而纯双目适合室内外,测量距离范围大,相差计算方法精度更高鲁棒性更好,缺点是在无纹理的物体(像是白墙)和在全黑情况下不可行。基于此,小觅智能将双目和结构光的优点结合起来,用双目的相差计算方法加上红外的结构光对黑暗和无纹理的情况作辅助,提出了“视觉+结构光+惯性导航”融合的双目结构光深度惯导相机方案。

(a). 左目的图像, (b). 右目的图像, ©. 计算出来的深度图(用伪彩色表示深度,由近到远的颜色是从红到蓝)

采用双目结构光是考虑到传统的单目结构光容易受光照的影响,在室外环境下,如果是晴天,激光器发出的编码光斑容易太阳光淹没掉,只有在阴天情况下勉强能用。而双目在室内外的情况下都可以使用,使用结构光可以在黑暗情况下和室内缺乏纹理的情况下,用红外结构光照明物体,并且在物体的表面投射出人造的纹理,同时还是使用双目的匹配方法,因为双目的匹配方法鲁棒性更高,而且可以做到亚像素,这样其抗环境干扰能力、可靠性更强,深度图质量有更大提升空间。

此外,结构光方案中的激光器寿命较短,难以满足7×24小时的长时间工作要求,其长时间连续工作很容易损坏。因为单目镜头和激光器需要进行精确的标定,一旦损坏,替换激光器时重新进行两者的标定是非常困难的,所以往往导致整个模块都要一起被换掉。而使用双目结构光的方式,其标定与激光器无关,替换起来就比较简单。

关于双目的算法复杂度和计算量,随着半导体的发展这也得到了解决。小觅对双目的算法进行了硬件加速,可以利用GPU的大规模并行计算来实施,也有用FPGA将算法硬化,同时还和芯片设计厂商进行合作,将双目匹配的算法做到专有芯片ASIC中,这样可以实现高分辨率(720P)、高帧率(30fps、甚至60fps)的深度计算。

在此基础上,小觅还在双目结构光深度相机的基础上再加上了位移加速度传感器(IMU),并将其信号和双目的视频信号做了同步,以满足双目视觉惯导(SLAM)的需求。

普及一下,SLAM (Simultaneous Localization and Mapping),也称为CML (Concurrent Mapping and Localization), 即时定位与地图构建,或并发建图与定位。问题可以描述为:将一个机器人放入未知环境中的未知位置,是否有办法让机器人一边移动一边逐步描绘出此环境完全的地图,所谓完全的地图(a consistent map)是指不受障碍行进到房间可进入的每个角落。

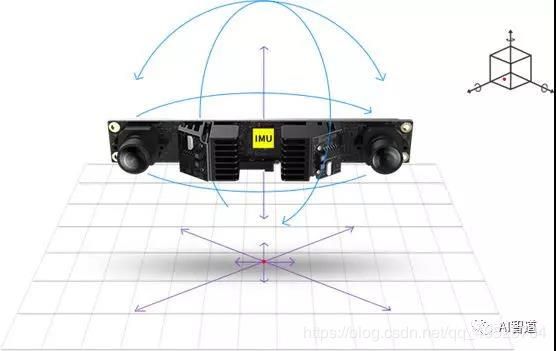

双目视觉惯导SLAM

双目视觉惯导里程计(Stereo VIO)和之前SLAM最大的不同在于两点:首先,VIO在硬件上需要传感器的融合,包括相机和六轴陀螺仪,相机产生图片,六轴陀螺仪产生加速度和角速度。相机相对准但相对慢,六轴陀螺仪的原始加速度如果拿来直接积分会在很短的时间飘走(zero-drift),但六轴陀螺仪的频率很高,至少有200Hz。

使用IMU对相机在快门动作期间内估计相机的运动,但是由于CMOS相机的快门时间戳和 IMU 的时间戳的同步比较困难 ,且相机的时间戳不太准确 (自动曝光时间每帧都可能变化,时间戳是在曝光前,曝光中,还是曝光后)。传感器融合是一个趋势,也或者说是一个妥协的结果。主要的原因还是由于单一的传感器不能适用所有的场景,所以通过多个传感器的融合达到理想的定位效果。

双目视觉+IMU的融合方案

视觉传感器在大多数纹理丰富的场景中效果很好,但是对旋转不敏感,IMU长时间使用有非常大的累积误差,但是在短时间内,其相对位移数据又有很高的精度,所以当视觉传感器失效时,融合IMU数据,能够提高定位的精度。

对于短时间内的快速运动,IMU能够提供一些较好的估计。这正是相机的弱点。当运动过快时,(卷帘快门的)相机会出现运动模糊 (小觅的双目采用全局快门),或者两帧之间重叠区域太少以至于无法进行特征匹配,所以纯视觉SLAM需要加大视角以应对快速的运动。而有了IMU,即使在相机数据无效的那段时间内,也能保持一个较好的位姿估计,这是纯视觉SLAM无法做到的。

相比于IMU,相机数据基本不会有漂移。如果相机放在原地固定不动,那么(在静态场景下)视觉SLAM的位姿估计也是固定不动的。所以,相机数据可以有效地估计并修正IMU读数中的漂移,使得在慢速运动后的位姿估计依然有效。

当图像发生变化时,本质上没法知道是相机自身发生了运动,还是外界条件发生了变化,所以纯视觉SLAM难以处理动态的障碍物。而IMU能够感受到自己的运动信息,从某种程度上减轻动态物体的影响。

作为基于视觉识别技术的3D传感器,双目结构光深度惯导相机适用于室内外双重环境,可以应对室外强光环境,识别距离可达30到50米,完全黑暗的室内环境亦可工作。此外,红外主动结构光,可以让双目摄像头完美解决了室内白墙和无纹理物体的难题。“双目+IMU”的惯性导航方案,可为VSLAM的应用提供精准的互补数据,并且相较其他单一方案拥有更高精度和鲁棒性。

基于“视觉+结构光+惯性导航”方案,在陌生环境中,搭载了双目结构光深度惯导相机的移动机器人就可以在自主行走的过程中实时三维重建现场环境的地图,也可实现三维立体避障,充分认知所处环境,让每一移动机器人拥有了一双超人的眼睛。

总结

最后再对三种深度技术进行一个总结,作为下篇总结的补充。

- TOF原理是传感器发出经调制的近红外光,遇物体后反射,通过计算光线发射和反射时间差或相位差来换算被拍摄物体的距离。

- 结构光(Structured Light)技术则要相对复杂一些,该技术将编码的光栅或线光源等投射到被测物上,根据它们产生的畸变来解调出被测物的三维信息。

- 双目视觉则是和人眼一样用两个普通摄像头以视差的方式来计算被测物距离。三种方式各有优缺点,在现有技术条件下各有应用场景。

孰优孰劣,尚待时间检验,还有技术的发展。

参考文献:

L. Pang,“IMU Integrated Structured-Light Stereo Depth Camera for Mobile Robot Navigation and Obstacle Detection”

P. J. Besl, “Active, Optical Range Imaging Sensors”, Machine Vision and Applications (1988) 1:127-152

D. Van Nieuwenhove, W. Van der Tempel, R. Grrotjans, M. Kuijk, “Time-of-flight Optical Ranging Sensor based on a Current Assisted Photonic Demodulator”, Proceedings Symposium, IEEE/LEOS Benelux Chapter, 2006, Eindhoven.

M. Hansard, S. Lee, O. Choi, R. Horaud, “Time-of-Flight Cameras: Principles, Methods and Applications”, Springer Brief in Computer Science, 2012.

A.P.P Jongenelen, D. G. Bailey, A.D. Payne, A.A. Dorrington, D.A. Carnegie, Analysis of Errors in ToF Range Imaging with Dual-Frequency Modulation, IEEE Transactions on Instrumentation and Measurement, Vo. 60, No. 5, May 2011, SSN 0018-9456.

J. Geng, “Structured-Light 3D Surface Imaging: a Tutorial”, Advances in Optics and Photonics 3, 128-160 (2011).

J. Kravanja, et al, “Robust Depth Image Acquisition Using Modulated Pattern Projection and Probabilistic Graphical Models”, Sensors 2016, 16, 1740; doi:10.3390/s16101740

L. Pang, “3D reconstruction of the material surface shape from stereo images of electron micrographs”, Microscopy: Image Acquisition and Processing III, 1996