基于BP算法的Adaboost模型在二分类问题当中的应用

本篇博客参考了书籍《MATLAB神经网络43个案例分析》,文中的代码也是来源于书中的实例,在此向原作者表示感谢。

Adaboost算法的思想是合并多个“弱”分类器的输出以产生有效分类,其主要步骤为:首先给出弱学习算法和样本空间(x,y),从样本空间中找出m组训练数据,每组训练数据的权重都是1/m。然后用弱学习算法迭代运算T次,每次运算后都按照分类结果更新训练数据权重分布,对于分类失败的训练个体赋予较大权重,下一次迭代运算时更加关注这些训练个体。弱分类器通过反复迭代得到同一个分类函数序列![]() ,每个分类函数赋予一个权重,分类结果越好的函数,其对应权重越大。T次迭代之后,最终强分类函数F由弱分类函数加权得到。BP_Adaboost模型即把BP神经网络作为弱分类器,反复训练BP神经网络预测样本输出,通过Adaboost算法得到多个BP神经网络弱分类器组成的强分类器。当然Adaboost算法也可以和其他算法相结合,比如SVM,PCA等等。

,每个分类函数赋予一个权重,分类结果越好的函数,其对应权重越大。T次迭代之后,最终强分类函数F由弱分类函数加权得到。BP_Adaboost模型即把BP神经网络作为弱分类器,反复训练BP神经网络预测样本输出,通过Adaboost算法得到多个BP神经网络弱分类器组成的强分类器。当然Adaboost算法也可以和其他算法相结合,比如SVM,PCA等等。

算法步骤如下:

步骤1:数据选择和网络初始化,从样本空间中随机选择m组训练数据,初始化测试数据的分布权值为1/m,根据样本输入输出维数确定神经网络结构,初始化BP神经网络权值和阈值。

步骤2:弱分类器预测。训练第t个弱分类器时,用训练数据训练BP神经网络并且预测训练数据输出,得到预测序列g(t)的预测误差和,误差和的计算公式如下所示:

式中,g(t)为预测分类结果,y为期望分类结果。

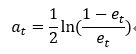

步骤3:计算预测序列权重。根据预测序列g(t)的预测误差计算序列的权重,权重计算公式为:

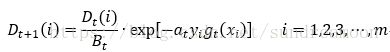

步骤4:测试数据权重调整。根据预测序列权重,调整下一轮训练样本的权重,调整公式为

式中,![]() 是归一化因子,目的是在权重比例不变的情况下使分布权值和为1。

是归一化因子,目的是在权重比例不变的情况下使分布权值和为1。

步骤5:强分类函数。训练T轮后得到T组弱分类函数![]() ,由T组弱分类函数组合得到了强分类函数h(x)。

,由T组弱分类函数组合得到了强分类函数h(x)。

讲完基本的算法之后,我们来看一个实际的二分类问题,比较常见的就是这个---公司财务状况预警模型。

对于这个实际问题来说,一共有1350组公司财务状况数据,每组数据的输入为10维,代表与财务状况有关的10个指标,输出为1维,代表当前公司的财务状况,为1时表示财务状况良好,为-1时表示财务状况出现问题,从中随机选取1000组数据作为训练数据,350组数据作为测试数据,根据数据维数,采用的BP神经网络结构为10-6-1,共训练生成了K个BP神经网络弱分类器。

实现代码如下:

%% 清空环境变量

clc

clear

%% 加载数据

load data input_train output_train input_test output_test

%input_train是训练数据,output_train是训练标签

%% 权重初始化

[mm,nn]=size(input_train);

D(1,:)=ones(1,nn)/nn;

%% 弱分类器分类

K=6; %弱分类器的个数

for i=1:K

%训练样本归一化

[inputn,inputps]=mapminmax(input_train);

[outputn,outputps]=mapminmax(output_train);

error(i)=0;

%BP神经网络构建

net=newff(inputn,outputn,6);

net.trainParam.epochs=5;

net.trainParam.lr=0.1;

net.trainParam.goal=0.00004;

%BP神经网络训练

net=train(net,inputn,outputn);

%训练数据预测

an1=sim(net,inputn);

test_simu1(i,:)=mapminmax('reverse',an1,outputps);

%测试数据预测

inputn_test =mapminmax('apply',input_test,inputps);

an=sim(net,inputn_test);

test_simu(i,:)=mapminmax('reverse',an,outputps);

%统计输出效果

kk1=find(test_simu1(i,:)>0);

kk2=find(test_simu1(i,:)<0);

aa(kk1)=1;

aa(kk2)=-1;

%统计错误样本数

for j=1:nn

if aa(j)~=output_train(j);

error(i)=error(i)+D(i,j);

end

end

%弱分类器i权重

at(i)=0.5*log((1-error(i))/error(i));

%更新D值

for j=1:nn

D(i+1,j)=D(i,j)*exp(-at(i)*aa(j)*test_simu1(i,j));

end

%D值归一化

Dsum=sum(D(i+1,:));

D(i+1,:)=D(i+1,:)/Dsum;

end

%% 强分类器分类结果

output=sign(at*test_simu);

%% 分类结果统计

%统计强分类器每类分类错误个数

kkk1=0;

kkk2=0;

for j=1:350

if output(j)==1

if output(j)~=output_test(j)

kkk1=kkk1+1;

end

end

if output(j)==-1

if output(j)~=output_test(j)

kkk2=kkk2+1;

end

end

end

kkk1

kkk2

disp('第一类分类错误 第二类分类错误 总错误');

% 窗口显示

disp([kkk1 kkk2 kkk1+kkk2]);

plot(output)

hold on

plot(output_test,'g')

%统计弱分离器效果

for i=1:K

error1(i)=0;

kk1=find(test_simu(i,:)>0);

kk2=find(test_simu(i,:)<0);

aa(kk1)=1;

aa(kk2)=-1;

for j=1:350

if aa(j)~=output_test(j);

error1(i)=error1(i)+1;

end

end

end

disp('统计弱分类器分类效果');

error1

disp('强分类器分类误差率')

(kkk1+kkk2)/350

disp('弱分类器分类误差率')

(sum(error1)/(K*350))

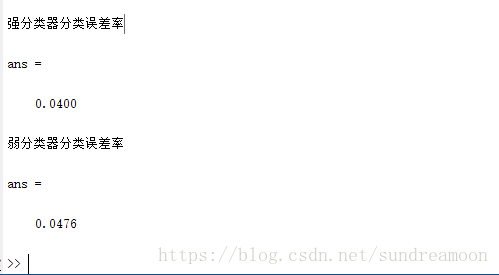

运行结果如下所示:

从结果中我们可以看出,强分类器的误差率要低于弱分类器的误差率,分类效果得到了提升。