Spark单节点安装-VirtualBox-Ubuntu-14.04

实验环境:

Windows版本:Windows 10 家庭版中文版 1607

Virtualbox版本:5.0.22 中文版

Ubuntu版本:ubuntu-14.04.1-server-amd64

Xshell版本:Xshell 5

Spark版本:Spark-1.5.1-bin-hadoop2.6

1.环境准备

1.1 在VirtualBox中安装有Ubuntu-14.04-server版的虚拟机(可以参考:VirtualBox安装Ubuntu-14.04.1-server)。

1.2 装有以下服务:

ssh服务:进行远程连接

$sudo apt-get install openssh-server$sudo apt-get install vimlrzsz工具:上传和下载程序,rz命令:服务器从宿主机接收(received)文件;sz命令:服务器向宿主机发送(send)文件。

$sudo apt-get install lrzsz1.3 下载好以下源文件

xshell 5 :xshell官方下载 或 https://yunpan.cn/cMCDTTY5Rb37D 访问密码 d3fe

jdk 1.8版本:jdk官方下载 或https://yunpan.cn/cMCUi49u8rR36 访问密码 903c

scala 2.11.7:scala官方下载 或 https://yunpan.cn/cMCDcHZavNByT 访问密码 87bd

spark-1.5.1-bin-hadoop2.6: spark官方下载或https://yunpan.cn/cMCD27UiZddLU 访问密码 05c7

以下操作均是使用Xshell连接到系统后操作的,均使用root用户。

2.安装配置jdk

创建存放jdk的文件夹,并上传jdk源文件

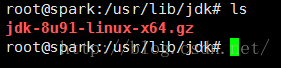

#mkdir /usr/lib/jdk

#cd /usr/lib/jdk

#rz上传成功后查看文件

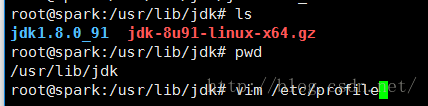

#tar -xzvf jdk-8u91-linux-x64.gz查看解压后的文件,并修改配置文件

在末尾添加如下代码

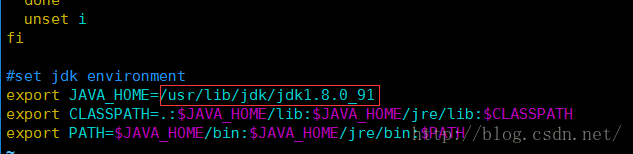

#set jdk environment

export JAVA_HOME=/usr/lib/jdk/jdk1.8.0_91

export CLASSPATH=.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH生效配置文件

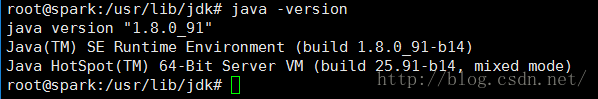

#source /etc/profile3.安装配置scala

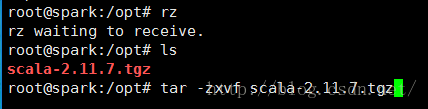

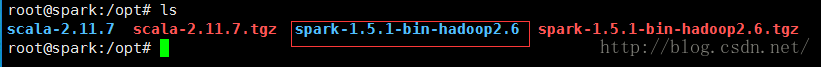

切换到/opt/目录,并上传scala源文件:scala-2.11.7.tgz

#cd /opt/

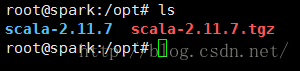

#rz查看并解压

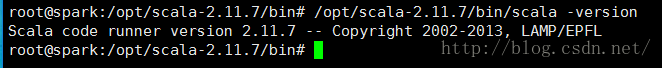

查看scala版本

出现以上版本信息说明scala已经安装完成。

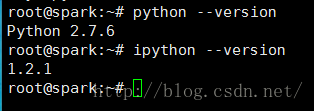

4.安装Python及Ipython

#sudo apt-get install python ipython -y查看版本信息

(spark 2.0及以后版本会去除对ipython的支持)

5.安装Spark

切换到/opt/文件夹并上传spark文件,上传成功后解压到当前文件夹

#cd /opt/

#rz

#ls

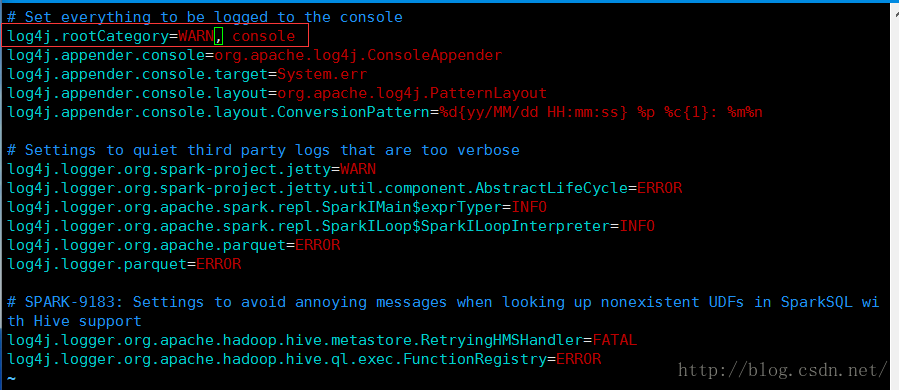

#tar -zxvf spark-1.5.1-bin-hadoop2.6.tgz然后配置日志级别,只显示警告以上信息

#cd /opt/spark-1.5.1-bin-hadoop2.6/conf

#cp log4j.properties.template log4j.properties

#vim log4j.properties修改log4j.rootCategory为WARN, console,可避免测试中输出太多信息

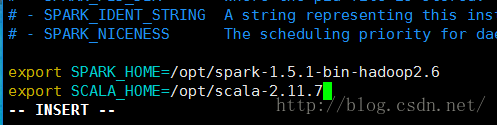

接着基于模板创建配置文件

#sudo cp spark-env.sh.template spark-env.sh

#vim spark-env.sh末尾加上如下内容,设置spark的环境变量

export SPARK_HOME=/opt/spark-1.5.1-bin-hadoop2.6

export SCALA_HOME=/opt/scala-2.11.7

等号后的内容分别为spark的安装目录和scala的安装目录,若安装路径不同可根据实际安装路径填写。

至此spark已经安装完成,最后执行测试下是否安装成功。

6.测试启动Spark

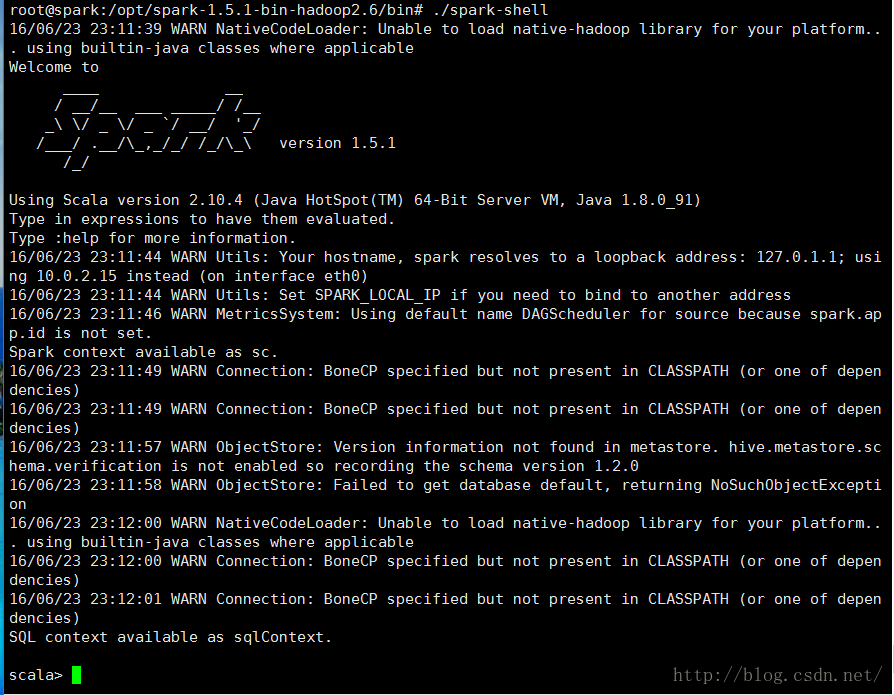

6.1 启动shell功能

进入spark的bin目录执行spark-shell

#cd /opt/spark-1.5.1-bin-hadoop2.6/bin/

#./spark-shell

退出使用Ctrl+D键。

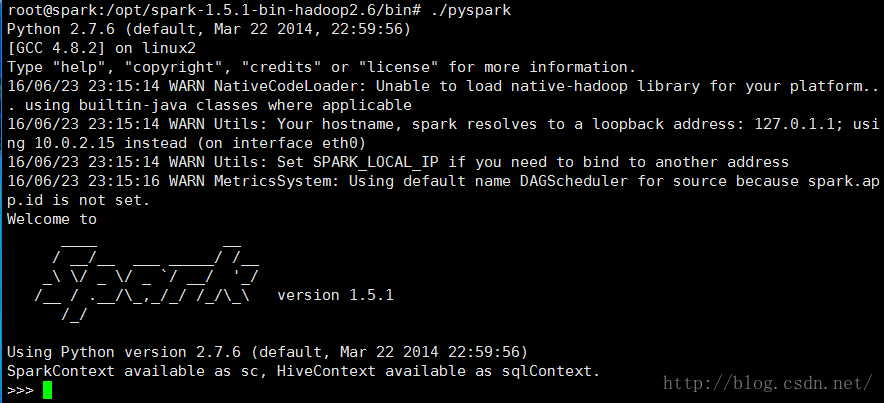

进入pyspark

#./pyspark

同样可以使用Ctrl+D键退出。

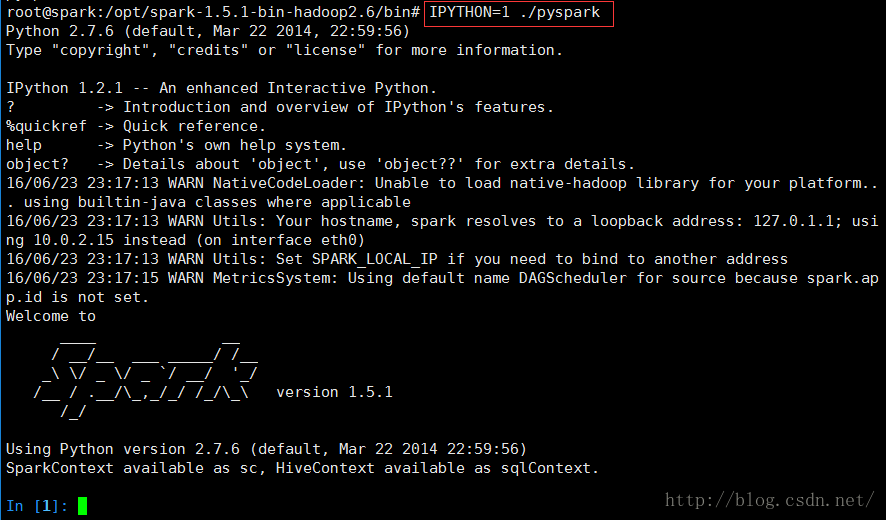

使用IPython

#IPYTHON=1 ./pyspark

仍可用Ctrl+D键退出,spark 2.0后无ipyhton。

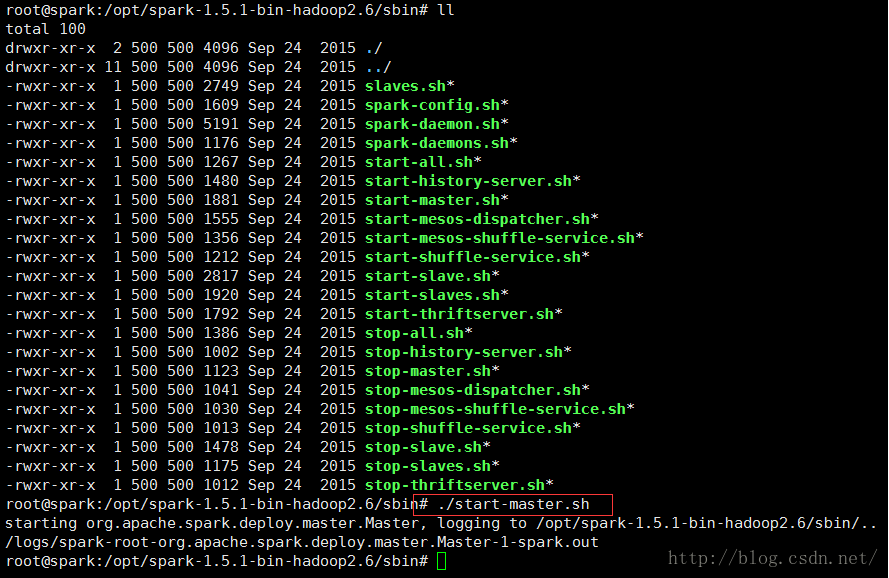

6.2 启动spark

启动主节点

#cd /opt/spark-1.5.1-bin-hadoop2.6/sbin/

#ls

#./start-master.sh

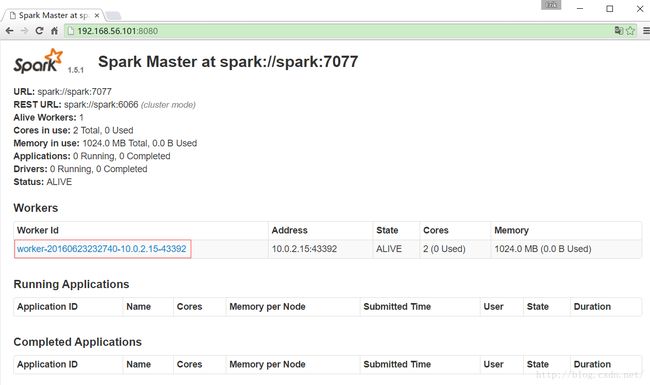

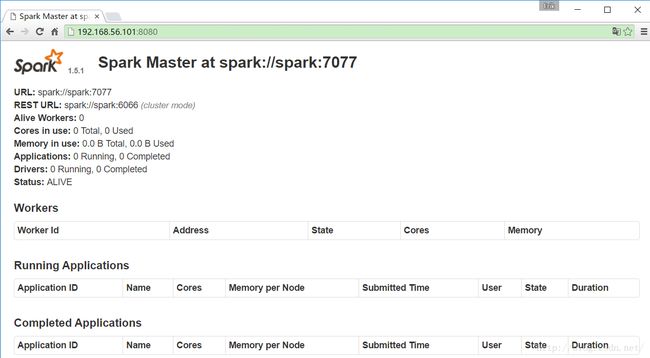

在网页端查看

http://192.168.56.101:8080

192.168.56.101为虚拟机ip地址,需根据自己实际ip地址更改,8080为端口号

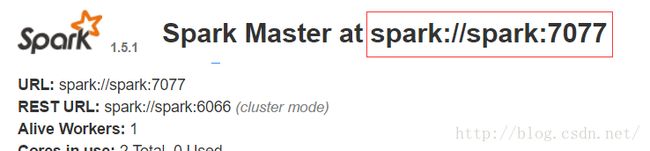

启动从节点

#./start-slave.sh apark://spark:7077spark://spark:7077是根据网页上的显示所定,一定要保持一致

启动从节点后刷新网页,会增加Workers Id

说明spark安装成功。

停止所有spark节点服务可以使用

#./stop-all.sh至此spark已经安装完成,可以进行后续实验了。

参考文章

Spark 大数据动手实验:http://www.jianshu.com/p/27b6589cee32