用postman快速学习ElasticSearch的搜索功能

前言

ElasticSearch(以下简称ES)是一个基于Lucene构建的开源(open-source),分布式(distributed),RESTful,实时(real-time)的搜索与分析(analytics)引擎。它可以让你在浏览数据时具备非常快的速度和优秀的可扩展性。它用于全文索引、结构化数据索引、数据分析以及三者的结合。在初步学习ElasticSearch的时候,我们大部分的时候需要通过其REST API来探索ES提供的各种功能,网上有很多各种干货教程,但基本都是通过curl命令来进行演示,各种小白肯定是不太习惯的,除了输出不够美观整洁之外,也不太方便进行分类,归纳和复用。这里,结合postman一起来演示ES关于搜索的干货教程。

样例数据

为了更好的使用和理解ES,没有点样例数据还是不好模拟的。这里提供了一份官网上的数据,accounts.json。如果需要的话,也可以去这个网址玩玩,它可以帮助你自定义写随机的JSON数据。

导入

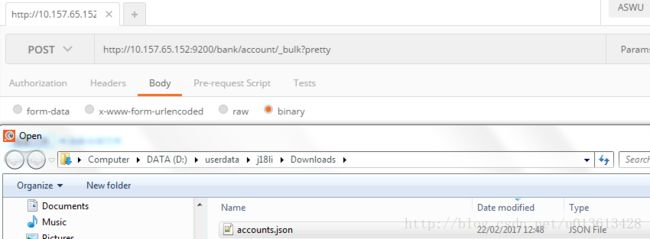

打开你的postman,输入对应的REST API,http://10.157.65.152:9200/bank/account/_bulk?pretty

选择post; body->binary; 选择文件,选中你下载好的account.json文件:

注意:

1 10.157.65.152:9200是ES得访问地址和端口

2 bank是索引的名称

3 account是类型的名称

4 索引和类型的名称在文件中如果有定义,可以省略;如果没有则必须要指定

5 _bulk是rest得命令,可以批量执行多个操作

6 pretty是将返回的信息以可读的JSON形式返回。(不过postman自带了pretty的功能)

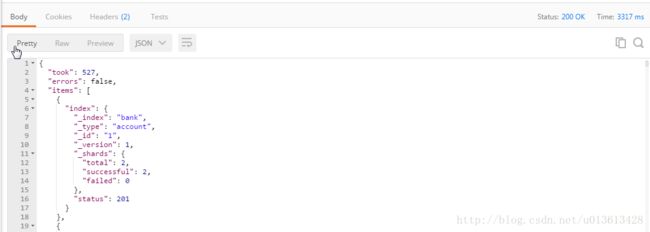

send之后,可以很快看到结果:

然后我们可以通过另一个REST API查询:

http://10.157.65.152:9200/_cat/indices?v

插入1000条数据成功

保存对应的REST API到postman

下面的步骤很重要,在接下来的文章里面我不会在重复。

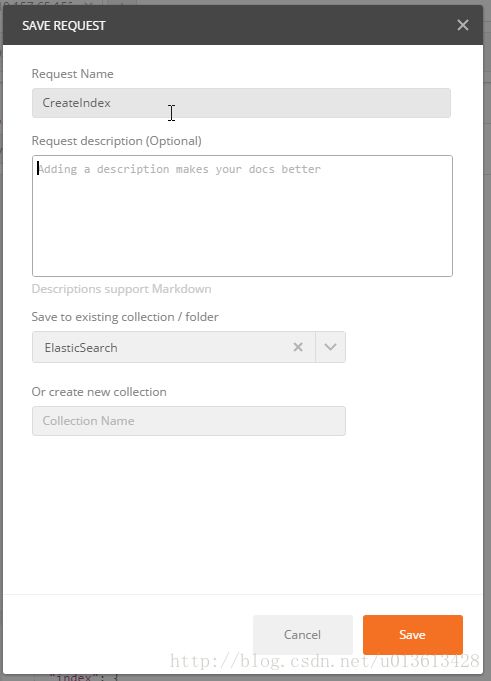

点击save:

![]()

在弹出的save窗口中,给对应的request起一个合适的名字,比如这里createBankIndex,并将其保存到对应的collection中(在这里,我已提前创建了一个ElasticSearch的collection,专门用于保存和ES相对应的REST API的操作)。如果你的ES服务器的名字会经常变,就请把10.157.65.152:9200保存为一个变量,在所有的case中使用这个变量,具体请看我之前的博文。

搜索API

ES提供了两种搜索的方式:请求参数方式 和 请求体方式。

请求参数方式

curl 'localhost:9200/bank/_search?q=*&pretty'其中bank是查询的索引名称,q后面跟着搜索的条件:q=*表示查询所有的内容

请求体方式(推荐这种方式)

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": { "match_all": {} }

}'这种方式特别适合在postman里面用,因为postman里面可以使用配合使用各种变量,而且编辑起来更方便:

返回的内容大致可以如下讲解:

- took:是查询花费的时间,毫秒单位

- time_out:标识查询是否超时

- _shards:描述了查询分片的信息,查询了多少个分片、成功的分片数量、失败的分片数量等

- hits:搜索的结果,total是全部的满足的文档数目,hits是返回的实际数目(默认是10)

- _score是文档的分数信息,与排名相关度有关,参考各大搜索引擎的搜索结果,就容易理解。

查询语言DSL

ES支持一种JSON格式的查询,叫做DSL,domain specific language。这门语言刚开始比较难理解,因此通过几个简单的例子开始:

下面的命令,可以搜索全部的文档:

{

"query": { "match_all": {} }

}query定义了查询,match_all声明了查询的类型。还有其他的参数可以控制返回的结果:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": { "match_all": {} },

"size": 1

}'(记住,还是用postman来做客户端,绝逼比curl好用)

上面的命令返回了所有文档数据中的第一条文档。如果size不指定,那么默认返回10条。

下面的命令请求了第10-20的文档。

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": { "match_all": {} },

"from": 10,

"size": 10

}'下面的命令指定了文档返回的排序方式:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": { "match_all": {} },

"sort": { "balance": { "order": "desc" } }

}'执行搜索

上面了解了基本的搜索语句,下面就开始深入一些常用的DSL了。

之前的返回数据都是返回文档的所有内容,这种对于网络的开销肯定是有影响的,下面的例子就指定了返回特定的字段:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": { "match_all": {} },

"_source": ["account_number", "balance"]

}'再回到query,之前的查询都是查询所有的文档,并不能称之为搜索引擎。下面就通过match方式查询特定字段的特定内容,比如查询余额为20的账户信息:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": { "match": { "account_number": 20 } }

}'查询地址为mill的信息:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": { "match": { "address": "mill" } }

}'查询地址为mill或者lane的信息:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": { "match": { "address": "mill lane" } }

}'如果我们想要返回同时包含mill和lane的,可以通过match_phrase查询:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": { "match_phrase": { "address": "mill lane" } }

}'ES提供了bool查询,可以把很多小的查询组成一个更为复杂的查询,比如查询同时包含mill和lane的文档:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": {

"bool": {

"must": [

{ "match": { "address": "mill" } },

{ "match": { "address": "lane" } }

]

}

}

}'修改bool参数,可以改为查询包含mill或者lane的文档:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": {

"bool": {

"should": [

{ "match": { "address": "mill" } },

{ "match": { "address": "lane" } }

]

}

}

}'也可以改写为must_not,排除包含mill和lane的文档:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": {

"bool": {

"must_not": [

{ "match": { "address": "mill" } },

{ "match": { "address": "lane" } }

]

}

}

}'bool查询可以同时使用must, should, must_not组成一个复杂的查询:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": {

"bool": {

"must": [

{ "match": { "age": "40" } }

],

"must_not": [

{ "match": { "state": "ID" } }

]

}

}

}'(不过这种DSL确实比较反人类)

过滤查询

之前说过score字段指定了文档的分数,使用查询会计算文档的分数,最后通过分数确定哪些文档更相关,返回哪些文档。

有的时候我们可能对分数不感兴趣,就可以使用filter进行过滤,它不会去计算分值,因此效率也就更高一些。

filter过滤可以嵌套在bool查询内部使用,比如想要查询在2000-3000范围内的所有文档,可以执行下面的命令:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"query": {

"bool": {

"must": { "match_all": {} },

"filter": {

"range": {

"balance": {

"gte": 20000,

"lte": 30000

}

}

}

}

}

}'ES除了上面介绍过的范围查询range、match_all、match、bool、filter还有很多其他的查询方式,这里就先不一一说明了。

聚合

聚合提供了用户进行分组和数理统计的能力,可以把聚合理解成SQL中的GROUP BY和分组函数。在ES中,你可以在一次搜索查询的时间内,即完成搜索操作也完成聚合操作,这样就降低了多次使用REST API造成的网络开销。

下面就是通过terms聚合的简单样例:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"size": 0,

"aggs": {

"group_by_state": {

"terms": {

"field": "state"

}

}

}

}'它类似于SQL中的下面的语句:

SELECT state, COUNT(*) FROM bank GROUP BY state ORDER BY COUNT(*) DESC由于size设置为0,它并没有返回文档的信息,只是返回了聚合的结果。

比如统计不同账户状态下的平均余额:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"size": 0,

"aggs": {

"group_by_state": {

"terms": {

"field": "state"

},

"aggs": {

"average_balance": {

"avg": {

"field": "balance"

}

}

}

}

}

}'聚合支持嵌套,举个例子,先按范围分组,在统计不同性别的账户余额:

curl -XPOST 'localhost:9200/bank/_search?pretty' -d '

{

"size": 0,

"aggs": {

"group_by_age": {

"range": {

"field": "age",

"ranges": [

{

"from": 20,

"to": 30

},

{

"from": 30,

"to": 40

},

{

"from": 40,

"to": 50

}

]

},

"aggs": {

"group_by_gender": {

"terms": {

"field": "gender"

},

"aggs": {

"average_balance": {

"avg": {

"field": "balance"

}

}

}

}

}

}

}

}'聚合可以实现很多复杂的功能,而且ES也提供了很多复杂的聚合,这里作为引导篇,也不过多介绍了。

对于基本的数据搜索大致就是上面讲述的样子,熟悉了一些常用的API,入门还是很简单的,倒是要熟练使用ES,还是需要掌握各种搜索查询的命令,以及ES内部的原理。