在SAR-Opt数据融合领域针对深度学习的SEN1-2数据集

The SEN1-2 Dataset for Deep Learning in SAR-Optical Data Fusion

Jul 2018 by M. Schmitt & L. H. Hughes & X. X. Zhu

(一)

关键词

合成孔径雷达(SAR)、光学遥感(optical remote sensing)、哨兵一号、哨兵二号、深度学习、数据融合

0. 摘要

虽然在许多技术领域,深度学习爆发了一波影响力,但是在遥感领域生成足够大量的训练数据仍然是一个很有挑战性的难题,尤其是涉及到来自于多种传感器的带有异质特征的数据。举一个例子,合成孔径雷达(SAR)的数据和光学影像的融合就很能说明问题。在这篇文章中,我们推出了一个SEN1-2数据集,用来为将深度学习应用到SAR-Opt数据融合领域提供助力。SEN1-2容纳了 282,384 对儿(pairs of)呈对应关系的图像块儿(patches),空间上,来自全球,时间上则囊括了每一个气象季节。抛开对数据集的详细描述不谈,我们还展示了几个实例性的实际应用,像是SAR图像着色、SAR-Opt图像匹配,还包括把输入的SAR图像转变成光学图像。既然SEN1-2是此类首个大型开源数据集,我们相信它将会支撑在「遥感领域的深度学习」和「多传感器数据融合」领域的长远发展。

1. 引言

在过去的几年里,深度学习在遥感领域崭露头角( Zhang et al., 2016, Zhu et al., 2017 ),这主要是因为在遥感观测结果和我们期待的地理信息之间存在着高度非线性的关系,这样的关系用物理模型来解释非常操蛋,但深度神经网络却可以模拟出来。深度学习在遥感这一块最让人感觉靠谱的方向之一应该就是数据融合( Schmitt and Zhu, 2016 ),这尤其适合SAR和光学数据的联合研究,因为它俩无论在几何方面还是辐射测量的表征上都截然不同。SAR系统基于距离测量(range measurements)并主要观测目标场景的理化性质,光学图像基于角度测量(angular measure- ments)观测环境的化学特征的信息。

为了推动深度学习技术在SAR-Opt数据融合领域的发展,能够搞一个完美对齐的图像或图像块组成的大型数据集相当重要,但这需要在工程上作出很大的努力。与此同时,比起传统的计算机视觉使用一些随处可得的图像就能玩得溜,遥感图像一般颇为昂贵,发射一颗遥感卫星要花好多钱,这就造成了图像成本相对比较高的问题。不过,在2014年,情况被大大改善了,哨兵系列卫星的第一颗——搭载着SAR系统的哨兵一号A(Sentinel-1A)被欧洲空间局ESA送上太空,多说两句,哨兵系列工程是哥白尼计划的一部分,这一计划最终目的是持续性地向终端用户免费提供各种卫星的观测数据。

利用这个新潮的大型遥感数据源,我们就在这篇文章了里推出了被称为SEN1-2的数据集。它包括282,384对儿SAR-Opt图像块,这些图像都是哨兵一号和哨兵二号的观测结果。这些图像块范围遍布全球陆地,四季都有。这篇文章主要描述了一下数据集的制作过程,它的特点(characteristics)和特征(features),还有一些用作实例的应用。

2.哨兵一号、哨兵二号遥感数据集介绍

哨兵卫星是ESA的哥白尼工程的一部分,其目的是取代过去在气候、海洋、陆地检测的领域的遥感任务,以保持数据的连续性。为了完成这一任务,六个不同的卫星投入运行,它们在地球观测方面有不同的侧重。在这些任务中,我们尤其关注哨兵一号和哨兵二号,因为它们分别提供了合成孔径雷达和光学遥感最常规的影像。

2.1 哨兵一号

哨兵一号( Torres et al., 2012 )包括两个极地轨道卫星,配备了C波段SAR遥感系统,使它们获得了无视天气情况进行观测的能力。

哨兵一号以预编程模式运行,以避免冲突并向长期运行的程序生成具有一致性的数据存档。取决于选择四种特有的成像模式中的某一种,图像分辨率最高可达五米,覆盖四百公里内的区域,而且,哨兵一号在赤道附近能提供双极化能力,重访时间也非常短,大概一周。将卫星高度和姿态的高精度和基于距离的SAR系统的高精度相结合,哨兵一号具有高开箱即用( high out-of-the-box )的地理定位精度( Schubert et al., 2015 )。

对于我们数据集中的哨兵一号图像,采用了最为常规的干涉宽幅宽带(IW)模式下采集,结果就是所谓的地面检测(GRD)效果。这些图像中每个像素都包含dB标度和σ0反向散射系统,采用的方向角为五米,范围是二十米。为了简化操作,我们把注意力集中在垂直极化(VV)数据上而把其他的极化抛到一边。最后,对于精确的正射校正,恢复的轨道信息与三十米的SRTM-DEM或者是ASTER-DEM相结合,弥补了高纬度地区无法得到数据的缺陷。

终端用户可能对数据做自己想要的预处理来使数据更适合自己的任务,因此,我们就没有做什么散斑过滤之类的工作。

2.2 哨兵二号

哨兵二号( Drusch et al., 2012 )包括了在同一个极地轨道上的两颗卫星,它们彼此相差180°,这项工程目的是为SPOT和LandSat类型的多光谱图像数据续命,所得到的数据提供了有关地球表面几十年的信息。它的扫描宽幅达到290公里,当卫星运行在赤道面附近(仅有一颗)时,回访时间大约是十天,有两颗卫星是则是五天。在没有云的时候,它尤其适合处在生长季节内的植被检测。

对于我们所使用的哨兵二号卫星数据的部分来说,只涉及了红色、绿色和蓝色通道(也就是第4、3和2波段),用RGB来生成逼真的彩色图像。哨兵二号的数据并非以卫星图片的形式分发,而是精确的地理参考颗粒(granules),因此就省了我们做进一步处理。与SAR系统不同,光学图像选择数据必须参考云层覆盖的量,对于刚开始的选择,在数据库里查询,从而能使用那些云层覆盖率在一个百分点以下的颗粒。

(二)

3. 数据集

为产生一个多传感器的SAR-Opt匹配对数据集,需要相当多有着空间线性关系的的遥感数据,而为了采取一个尽量自动化的方式做到这一点,我们利用了用了一个遥感云平台 Google Earth Engine ( Gorelick et al., 2017 ),下面,我们将详细描述这个数据集生成过程的每一个步骤。

3.1 在 Google Earth Engine 上做的数据准备

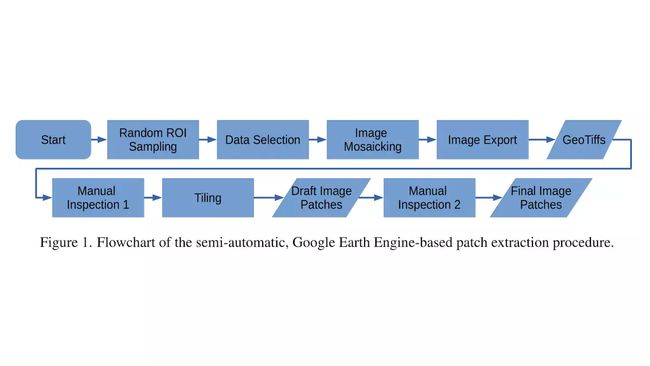

从我们制作数据集的角度来看,Google Earth Engine 具有两方面的优势:一方面,它提供了很大覆盖范围的数据目录,包括好几PB的遥感影像,其中包括所有可用的哨兵卫星数据还有其他的开源地理数据,另一方面,GEE里有一个功能很强大的编程接口,允许我们在Google的计算机中心做一些数据准备和分析工作。因此,我们使用它来挑选、准备并且下载哨兵一号和哨兵二号的影像,这些图像我们随后会制作成匹配对。基于GEE的图像下载还有准备的工作流程我们展示在了Fig.1中。

Fig.1:GEE准备工作流程示意图,半自动的

细节上,它包括以下几步:

3.1.1. 随机ROI采样

为了生成一个尽可能和我们的星球看起来比较相似的数据集,我们想采样这样一些区域,它们看起来就像是产生自全世界,为了实现这一任务,我们使用了GEE中提供的ee.FeatureCollection.randomPoints()函数从一个均匀的空间区域随机取样。介于很多遥感观测都把注意力放在城市区域而且城区也确实比农村包含有更复杂的可视信息,我们特地通过在地表泛泛地选100个点再从城区专门选50个点,人为选定了一些城市区域。陆地和城区都是公共区域数据服务所提供的,标尺是1:50米。如果两个点落在一个相当接近的地方,我们就去掉其中的一个,保证没有重叠部分。

采样来自于四个不同的种子值,分别是 1158, 1868, 1970, 2017 ,结果就是 Fig.2a 所展示的那样的随机ROI采样结果。

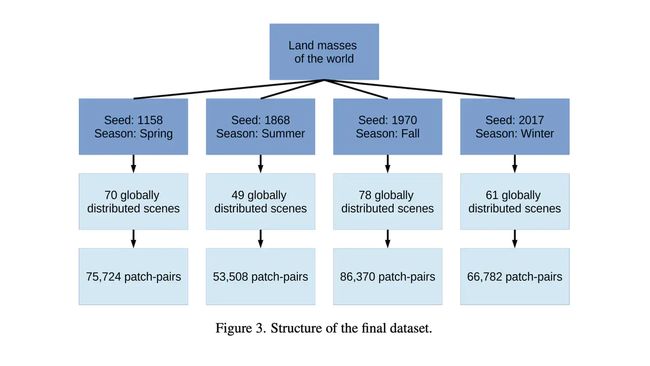

3.1.2 数据选择

在第二步,我们使用了GEE的工具去过滤图像,来挑选出适合我们场景的哨兵一号和哨兵二号的图像数据。我们想要只使用最近的2017年的数据,所以我们就把这一年分成了四个气象季节:冬季(2016.12.1-2017.2.28)、春季(2017.3.1-2017.5.30)、夏季(2017.6.1-2017.8.31),还有秋季(2017.9.1-2017.11.30)。每一个季节都与四个随机ROI之一联系在一起,这样,提供给我们顶级的数据集结构( Fig.3 ):我们把最后的数据集划分成四个界限相对明显的组ROI,这样命名:ROIs1158 spring、ROIs1868 summer、ROIs1970 fal、ROIs2017 winter。

Fig.3 数据集结构

而后,对于每一个ROI,我们给哨兵二号做了过滤,得到了云层覆盖的最大值不超过1%的数据,哨兵一号图像的过滤结果则是得到了IW工作模式和VV极化方式。如果去云的光学数据或者是VV-IW的SAR图像中任意一个没有处在可用状态,这个ROI就被丢弃。如此一来,ROI的数量就从600个急剧减少到429个。举个例子,所有被抛洒在南极洲的ROI都被不可避免地砍掉了,因为哨兵二号的观测范围只能覆盖到南纬56°到北纬83°。

3.1.3 图像镶嵌

通过持续地挑选图像数据,我们使用GEE内置的ee.ImageCollection.mosaic()函数和ee.Image.clip()函数去为每一个ROI创建单独的图像并修剪ROI的大小。简而言之,ee.ImageCollection.mosaic()函数就是用来拼接那些部分重叠的图像。在 2.2 部分中重点提了一下。我们只选择了哨兵二号的4、3、2波段去创造RGB图像。

3.1.4 图像导出

最后,我们使用GEE的Export.image.toDrive函数导出了前几步创建的图像,数据格式是 GeoTiffs ,分辨率是10米。下载好的 GeoTiffs 然后再做预处理来应付更进一步的应用,具体一点是把灰度值控制在 ±2.5σ 的范围内。把他们的区间限制在[0; 1]内用来表征一个相对大的范围。这些校正分别应用在所有的波段上。

3.1.5 一轮人工审查

我们接着在视觉上把所有个下载好的图像看了一遍,用来找出那些严重的问题。它们可以大体上被归类为以下的几种之一:

1) 大块的无数据区域:不幸的是,ee.ImageCollection.mosaic()函数即使没有找到对应整个ROI的数据适合的信息去也并不会返回任何error信息。当在一个给定的时间区间没有明显的无云颗粒可用时,哨兵二号大量出现这种问题。

2) 严重的云覆盖:来自于每一个哨兵二号的颗粒的云覆盖后设数据信息都仅仅是一个全球共享的参数。如此一来,就可能发生这样的情况:整个颗粒中仅仅包括了一堆云,但是覆盖了ROI的部分就是那些有云的颗粒。

3) 严重的颜色扭曲:偶尔,我们观察哨兵二号的图像其中有一些非常别扭的颜色。我们想做一个容纳那些比较自然的RGB图像的数据集,因此我们就把那些哨兵二号中带有太奇怪颜色的图像去掉了。

在第一轮人工审查之后,只有 258 个ROI被留下了( cf. Fig. 2b )。

Fig.2a Fig.2b

3.1.6 分块

考虑到我们的目标是一个包含了能够被用于机器学习模型的数据集指向多种不同的数据融合任务,我们最终选择了256*256像素的块。使用了128的步长(跨度?stride),我们减去了那些处在相邻块之间的重叠部分,当把独立块的数字进行最大化,只有50%能提供可用的场景。在这一步之后,SEN-1-2的数据对的数量就停留在了 298,790 。

3.1.7 第二遍的人工审查

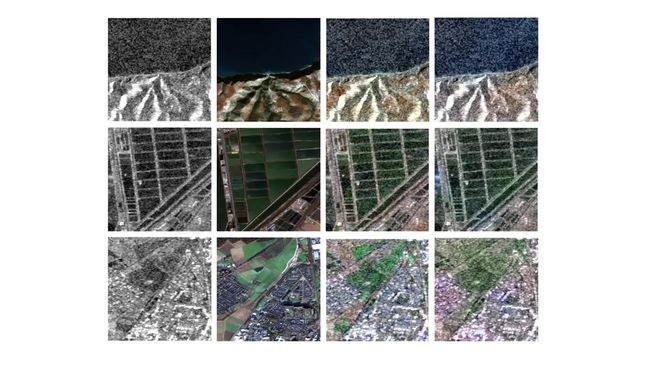

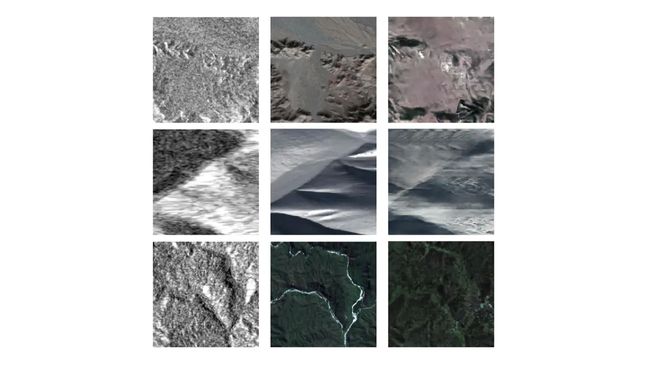

为了删掉仍有少量云雾或者其他问题的图像块,我们又一次肉眼审查了所有的块。在这一步,又人工删掉了 16,406 对儿图像块。留下了最后 282,384 个质量得到良好控制的图像块对。其中的一些我们都放在 Fig.4中了。

Fig.4 上排是SAR图像,下排是对应的光学图像

3.2 数据集可得性

SEN1-2数据集已经在CCBY开源可用协议之下分享出来了,可以通过慕尼黑科技大学(the Technical University of Munich)的图书馆的一个链接进行下载,链接在此: 数据集下载 。当这个数据集被用作科研目的时,请务必引用这篇文章。

(三)

4. 应用示例

在这一部分中,我们展示了几个实例应用,它们都已经用上了这个数据集。希望在未来的研究和针对SAR-Opt深度学习数据融合领域进一步的探索中,这些应用可以启发到大家。

4.1 哨兵一号图像着色

即使对于经过良好训练的专家来说,SAR图像的解释也一直是一个相对重量级的任务。原因之一就在于SAR图像缺失了颜色信息,这就有一点点麻烦。我们SEN1-2数据集其中一个很有前景的应用场景就是照着对应光学图像的样子去给SAR图像加上颜色信息,这一点我们早就论证过(Schmitt et al., 2018)。在这一方法中,我们使用了SAR-Opt数据融合技术去创造人工的有色SAR图像作为训练样例,还结合了已有的变分自编码器和混合密度网络的组合 (Deshpande et al., 2017)以学习条件颜色分布,而这些东西不同的着色示例都能描绘出来。有一些训练的第一手结果被展示在 Fig.5 中。

Fig.5 自左向右分别是:SAR图像,原光学图像,颜色空间技术着色图像,深度生成网络着色图像

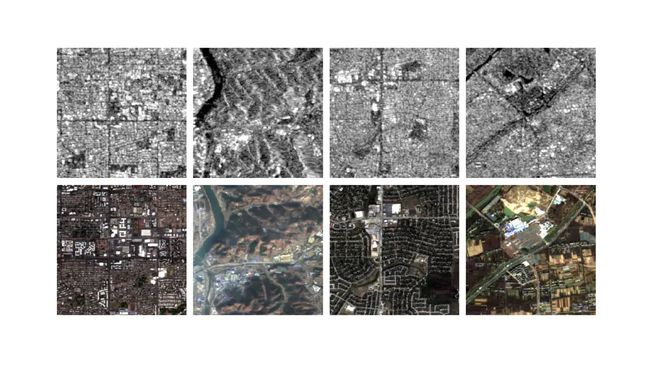

4.2 SAR-Opt图像配对

像是图像登记( registration )、3D重建模、变化监测之类的任务依赖于能否准确地确定不同对应位置的相似性(也就是所谓的“匹配”)。即使已经建立了很好的方法和相似性度量来实现单模态图像的配对,但多模态数据的匹配就完全是另一回事了。SEN1-2数据集可以提供适用于现代深度学习技术的大量数据来帮助实现多模态图像匹配的解决方案。例如( Merkle et al., 2017 )和( Hughes et al., 2018 )所提出的那样,使用伪孪生卷积神经网络结构,识别对应的SEN1-2测试子集的SAR于光学图像块,准确率可达93%;再者,( Hughes et al., 2018 )做出来的模型混淆矩阵训练了从SEN1-2的训练子集创建的300,000个相对应和不对应的图像对,在Tab.1中可以一看。此外,在测试子集中实现的一些示例性的图像匹配可以在 Fig.6 中看到。

Tab.1: 伪孪生神经网络的混淆矩阵在数据集上的训练成果

| yˆ/y | non-match | match |

|---|---|---|

| non-match | 93.84% | 6.16% |

| match | 6.02% | 93.98% |

Fig.6 一些SAR-Opt匹配的成果

4.3 从输入的SAR图像之中生成人工的光学图像

SEN1-2数据集另一个可能的应用领域就是训练一个生成网络,这一网络从输入的光学图像中生成人工的SAR图像( Marmanis et al., 2017, Merkle et al., 2018 )或是正相反,从输入的SAR图像中生成人工的光线影像( Wang and Patel, 2018, Ley et al., 2018, Grohnfeldt et al., 2018 )。有些基于Pix2Pix这个鼎鼎大名的生成是对抗网络GAN模型( Isola et al., 2017 )的初步结果,训练的数据使用了 Fig.7 中展示的 108,221 个SEN1-2中的数据对。

Fig.7: 使用Pix2Pix模型从输入的SAR图像中产生光学图像的初步例子,从左到右依次为:SAR图像,原始光学图像和生成的光学图像

5. 数据集的优点和不足

据我们所知,SEN1-2是有史以来第一个真正意义上包含了SAR和光学图像图像对并且可称之为“大规模(超过百万个)”的数据集。在这一领域还有另一个叫 SARpitcal 的数据集 ( Wang and Zhu, 2018 )。与我们的数据集相比,它提供了分辨率非常高的图像对,来自于TerraSAR-X卫星和航空摄影,但是它仅限于从单一场景中提取出来的 10,000个块儿,对于许多深度学习的应用来说可能是不太够,尤其还要考虑到许多块中包含着超过50%的重叠部分。有了采自全球和全部四个观测季节的 282,384 图像块,SEN1-2将会成为许多在SAR-Opt数据融合领域或事遥感方向机器学习研究者们的一个很有价值的数据源。一个特殊的长处就是这个数据集可以轻而易举地被划分成各种有着明确界限的子集(例如根据场景或是季节进行分类),有了这样的能力,我们就可以创建真正相互独立的训练集和测试集,对于看不见的数据也可以做到客观独立的评估。

然而,虽然SEN1-2并不是挑不出毛病来,举个例子来说,我们严格限制了哨兵二号的RGB图像数量,对于那些利用多光谱卫星图像的全辐射带宽来搞研究的人来说,数据量可能不太够。另外,我们在进行数据集准备时,GEE仅仅包含了Level-1C数据信息,这就意味着像素值实际代表了大气顶层(TOA)反射率,而不是大气层校正的大气底层(BOA)信息。我们正在计划着扩充对应的第二版本数据集。

6. 总结和结论

这篇文章中,我们已经描述并且发布了SEN1-2数据集,该数据集容纳了来自于哨兵一号和哨兵二号的 282,384 个SAR-Opt数据对。我们确定这个数据集将会推动机器学习——尤其是深度学习在卫星遥感和SAR-Opt数据融合领域的应用发展。在未来,我们计划推出一个更好的第二版本的数据集,不止容纳了哨兵二号的RBG图像,还有包含了大气校正的多光谱数据。此外,我们可能会对每个数据对添加比较粗糙的土地利用/土地覆盖(LULC)信息,致力于促进LULC分类领域技术的发展。

致谢

我们的工作接受了亥姆霍兹协会( Helmholtz Association )在德国研究基金会(DFG)的青年调查组SiPEO(VHNG-1018)的支持,授权号:SCHM 3322/1-1 ,根据欧盟的Horizon2020研究创新计划( Horizon 2020 research and innovation programme )中的欧洲研究理事会(ERC)也提供了帮助,授权协议: ERC-2016- StG-714087 ,缩写是 So2Sat 。

(四)

引用

Deshpande, A., Lu, J., Yeh, M.-C., Chong, M. J. and Forsyth, D., 2017. Learning diverse image colorization. In: Proc. CVPR, Honolulu, HI, USA, pp. 6837–6845.

Drusch, M., Del Bello, U., Carlier, S., Colin, O., Fernandez, V., Gascon, F., Hoersch, B., Isola, C., Laberinti, P., Martimort, P. et al., 2012. Sentinel-2: ESA’s optical high-resolution mission for GMES operational services. Remote sensing of Environment 120, pp. 25–36.

European Space Agency, 2015. Sentinels: Space for Coper- nicus. http://esamultimedia.esa.int/multimedia/ publications/sentinels-family/. [Online].

Gorelick, N., Hancher, M., Dixon, M., Ilyushchenko, S., Thau, D. and Moore, R., 2017. Google earth engine: Planetary-scale geospatial analysis for everyone. Remote Sensing of Environment 202, pp. 18–27.

Grohnfeldt, C., Schmitt, M. and Zhu, X., 2018. A conditional generative adversarial network to fuse SAR and multispectral op- tical data for cloud removal from Sentinel-2 images. In: Proc. IGARSS, Valencia, Spain. in press.

Hughes, L. H., Schmitt, M., Mou, L., Wang, Y. and Zhu, X. X., 2018. Identifying corresponding patches in SAR and optical im- ages with a pseudo-siamese CNN. IEEE Geoscience and Remote Sensing Letters 15(5), pp. 784–788.

Isola, P., Zhu, J.-Y., Zhou, T. and Efros, A. A., 2017. Image- to-image translation with conditional adversarial networks. In: Proc. CVPR, Honolulu, HI, USA, pp. 1125–1134.

Ley, A., d’Hondt, O., Valade, S., Ha ̈nsch, R. and Hellwich, O., 2018. Exploiting GAN-based SAR to optical image transcoding for improved classification via deep learning. In: Proc. EUSAR, Aachen, Germany, pp. 396–401.

Marmanis, D., Yao, W., Adam, F.Datcu, M., Reinartz, P., Schindler, K., Wegner, J. D. and Stilla, U., 2017. Artificial gen- eration of big data for improving image classification: a genera- tive adversarial network approach on SAR data. In: Proc. BiDS, Toulouse, France, pp. 293–296.

Merkle, N., Auer, S., Mu ̈ller, R. and Reinartz, P., 2018. Explor- ing the potential of conditional adversarial networks for optical and SAR image matching. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing. in press.

Merkle, N., Wenjie, L., Auer, S., Mu ̈ller, R. and Urtasun, R., 2017. Exploiting deep matching and SAR data for the geo- localization accuracy improvement of optical satellite images. Remote Sensing 9(9), pp. 586–603.

Schmitt, M. and Zhu, X., 2016. Data fusion and remote sensing – an ever-growing relationship. IEEE Geosci. Remote Sens. Mag. 4(4), pp. 6–23.

Schmitt, M., Hughes, L. H., Ko ̈rner, M. and Zhu, X. X., 2018. Colorizing Sentinel-1 SAR images using a variational autoen- coder conditioned on Sentinel-2 imagery. In: Int. Arch. Pho- togramm. Remote Sens. Spatial Inf. Sci., Vol. XLII-2, pp. 1045– 1051.

Schubert, A., Small, D., Miranda, N., Geudtner, D. and Meier, E., 2015. Sentinel-1a product geolocation accuracy: Commissioning phase results. Remote Sensing 7(7), pp. 9431–9449.

Torres, R., Snoeij, P., Geudtner, D., Bibby, D., Davidson, M., Attema, E., Potin, P., Rommen, B., Floury, N., Brown, M. et al., 2012. GMES Sentinel-1 mission. Remote Sensing of Environment 120, pp. 9–24.

Wang, P. and Patel, V. M., 2018. Generating high quality visible images from SAR images using CNNs. arXiv:1802.10036.

Wang, Y. and Zhu, X. X., 2018. The SARptical dataset for joint analysis of SAR and optical image in dense urban area. arXiv:1801.07532.

Zhang, L., Zhang, L. and Du, B., 2016. Deep learning for remote sensing data. IEEE Geoscience and Remote Sensing Magazine 4(2), pp. 22–40.

Zhu, X. X., Tuia, D., Mou, L., Xia, G.-S., Zhang, L., Xu, F. and Fraundorfer, F., 2017. Deep learning in remote sensing: A comprehensive review and list of resources. IEEE Geoscience and Remote Sensing Magazine 5(4), pp. 8–36.

转载自——https://www.jianshu.com/p/be160434edce

作者:杜若飞er

链接:https://www.jianshu.com/p/be160434edce

来源:简书

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。