- Python OpenAI 库开发指南:从入门到实战精通

senger_lcc

python开发语言

在人工智能(AI)领域,OpenAI无疑是全球最受瞩目的机构之一。它推出的GPT系列模型、DALL·E等创新技术,正在深刻改变各行各业。作为Python开发者,我们该如何快速上手并高效利用OpenAI的API,成为了提升个人竞争力的关键。本文将带你从零开始,深入解析Python语言中的openAI库,助你掌握AI开发的核心工具,成为AI领域的专家。一、什么是openAI库?它能为开发者带来什么?1

- Python入门:4.Python中的运算符

平凡程序猿~

Pythonpython

引言Python是一间强大而且便捷的编程语言,支持多种类型的运算符。在Python中,运算符被分为算术运算符、赋值运算符、复合赋值运算符、比较运算符和逻辑运算符等。本文将从基础到进阶进行分析,并通过一个综合案例展示其实际应用。1.算术运算符算术运算符用于执行基本的数学操作。常见的算术运算符以下是Python常见算术运算符的表格:运算符描述示例结果+加法3+25-减法3-21*乘法3*26/除法(浮

- Python 中 PIL 构建图片裁剪工具

winfredzhang

pythoncrop

概述这篇博客将为您展示如何使用wxPython和PIL库开发一个图片裁剪工具。本工具能够加载图片,允许用户通过拖拽选择框裁剪图片,并保存裁剪后的结果。以下是完整代码和实现步骤。C:\pythoncode\new\cropimageandsave.py功能特性图片加载:支持加载JPG和PNG格式的图片。动态裁剪:通过鼠标绘制矩形选择框进行裁剪。缩放适配:图片会根据面板大小自动缩放显示。保存裁剪结果:

- Python3.13来了!编程爱好者必看

Python之栈

人工智能python开发语言

Python3.13于近期发布,其中包含大量重要更新。Python作为机器学习、数据科学和人工智能领域使用最广泛的编程语言,一直在不断发展,以满足这些领域日益增长的需求。最新发布的Python3.13提供了多项具有影响力的改进,旨在提高性能和生产力,对于从事ML和AI项目的开发人员来说是一个重要的里程碑。Python在ML和AI领域的主导地位主要归功于它的简单性、广泛的库支持和庞大的社区。然而,随

- python读取路径只能是双左斜杠、双右斜杠、左斜杠,不能是右斜杠吗?

神笔馬良

人工智能

问题描述:python读取路径只能是双左斜杠、双右斜杠、左斜杠,不能是右斜杠吗?问题解答:在Python中,读取文件路径时,可以使用双左斜杠(\),也可以使用双右斜杠(//),或者使用单左斜杠(/)。事实上,Python中的路径处理函数通常会接受和处理这三种形式的路径分隔符。但是,在Windows操作系统中,路径中的分隔符通常是反斜杠(\),而在Linux和Unix系统中通常是正斜杠(/)。因此,

- Python 操作 Elasticsearch 全指南:从连接到数据查询与处理

XMYX-0

pythonelasticsearchjenkins

文章目录Python操作Elasticsearch全指南:从连接到数据查询与处理引言安装`elasticsearch-py`连接到Elasticsearch创建索引插入数据查询数据1.简单查询2.布尔查询更新文档删除文档和索引删除文档删除索引批量插入数据处理分页结果总结Python操作Elasticsearch全指南:从连接到数据查询与处理引言在大数据分析与搜索应用中,Elasticsearch是

- Python(四)——SVG 图坐标轴数字和其他文本设置总结

八年。。

python开发语言笔记

在学术论文中,图像的质量和规范性直接影响文章的专业性和表达效果。尤其是在使用Python绘制SVG图时,图像的字体选择、大小设置、以及整体样式需要符合期刊或会议的要求。这不仅能提升视觉呈现的清晰度,还能增强论文内容的可读性和说服力。因此,合理设置坐标轴字体(如数字使用“TimesNewRoman”、文字使用“宋体”)和调整图像细节是学术制图中不可忽视的重要环节。1.设置全局字体frommatplo

- 【Es】python es操作

小毛驴吃梨子

elasticsearchpython大数据

表因为es是集群所以es_hosts是列表fromelasticsearchimportElasticsearchES_HOSTS=["127.0.0.1:9200"]ES_HTTP_AUTH="******************"#连接Eses=Elasticsearch(hosts=ES_HOSTS,http_auth=ES_HTTP_AUTH,maxsize=60,timeout=30,m

- Python中Cache的使用

爬虫俗手小马达

python开发语言缓存

文章目录一、缓存的基础概念二、基础使用三、进阶使用四、外部缓存工具五、缓存的注意事项一、缓存的基础概念缓存(Cache)是一种在应用程序中提升性能的技术,它通过将一些数据临时存储在快速访问的存储介质(如内存)中,以减少数据的重复计算或重复读取。通常,缓存用于存储一些昂贵计算或IO密集型操作的结果,从而加快程序的执行速度。在Python中,缓存通常用于函数的输出、API请求的结果、数据库查询、文件读

- Python学习:Pandas库使用(二)之读写Excel文件——read_excel()和to_excel()函数及其参数详解

爬虫俗手小马达

python学习pandas

在Python的Pandas库中,读取和写入Excel文件主要使用read_excel和to_excel函数。以下是详细用法和示例:1.读取Excel文件:pd.read_excel()importpandasaspd#读取Excel文件df=pd.read_excel('文件路径.xlsx',sheet_name='Sheet1',header=0,usecols='A:C',skiprows=

- Python学习——装饰器(一):两个简单例子

爬虫俗手小马达

python学习开发语言

例一计时器#创建一个装饰器,用于计算函数执行时间importtimedeftime_this(func):defwrapper(*args,**kwargs):start_time=time.time()result=func(*args,**kwargs)end_time=time.time()execution_time=end_time-start_timeprint(f"Execution

- PyInstaller 打包 exe 文件

cliffordl

python综合python开发语言

PyInstaller是一个第三方库,它能够在Windows、Linux、MacOSX等操作系统下将Python源文件打包。通过对源文件打包,Python程序可以在没有安装Python的环境中运行,也可以作为一个独立文件方便传递和管理。PyInstaller支持Python2.7和Python3.3+。可以在Windows、MacOSX和Linux上使用,但是并不是跨平台的,而是说你要是希望打包成

- OpenCV: 深入理解OpenCV中CV_WRAP_AS宏及其作用

湫兮之风

opencvopencv人工智能计算机视觉

在OpenCV中,CV_WRAP_AS是一个宏,主要用于为C++函数或运算符定义别名,以便在生成语言绑定时使用。这对于在不同的编程语言(如Python)中使用OpenCV库时提供更友好的接口非常有用。尽管它在C++代码中不会改变函数的行为,但它在OpenCV的语言绑定系统中起到了重要作用,特别是当OpenCV要为多个语言(如Python)提供接口时。1.CV_WRAP_AS宏的基本用途CV_WRA

- python连接elasticsearch实战(附完整代码)

当初

pythonelasticsearch

python连接elasticsearchfromelasticsearchimportElasticsearchfromelasticsearch.helpersimportscanES_HOSTS=[{'host':'','port':9200,'scheme':'http'}]es=Elasticsearch(hosts=ES_HOSTS,basic_auth=('账号','密码'))#检查

- mongodb清理删除历史数据

程序员

批量清理mongodb历史数据清理程序的原来目前项目组上很多平台上线历史数据积压,导致入库查询数据缓慢,历史数据有些已经归档,进行历史数据清理删除。之前临时写shell脚本,太简陋,重新使用Python进行改造,新增备份功能,和配置文件删除指定字段和时间范围内数据。代码篇#!/usr/local/python3/bin/python3importconfigparser,logging.confi

- Python 3.13性能大提升:免费多线程时代来临

敖行客 Allthinker

pythonjava开发语言爬虫

在编程的世界里,Python一直以其简洁、易读和强大的功能而备受青睐。随着技术的不断进步,Python的每一个新版本都带来了新的惊喜和改进。而Python3.13无疑是其中的一颗璀璨明星。在一个数据驱动的世界里,Python已经成为了一种无处不在的编程语言,它的性能和功能的提升始终是开发者们关注的热点。随着大数据、人工智能、云计算等技术的飞速发展,对编程语言性能的要求也在不断提高。在这样的背景下,

- 使用Python开发PPT文本提取工具

winfredzhang

pythonpowerpoint提取文字

在日常工作中,我们经常需要从PowerPoint文档中提取文本内容进行处理。本文将详细介绍如何使用Python开发一个带图形界面的PPT文本提取工具,该工具可以轻松地从PPTX文件中提取所有文本内容,并按页码显示。C:\pythoncode\new\GetContentOFPPT.py全部代码importwximportosfrompptximportPresentationclassPPTExt

- Python(二)——设置文件路径:反斜杠 \ 、双反斜杠 \\和正斜杠 /的区别

八年。。

python开发语言学习

在Python中设置文件路径时,不清楚是用双反斜杠\\、反斜杠\还是正斜杠/时,一句话,使用正斜杠/!!!!下面对这三者进行详细介绍及区分:1.双反斜杠\\含义:在编程语言(如Python、C++等)中,反斜杠\是转义字符,用来表示特殊字符(如\n表示换行,\t表示制表符)。为了表示真正的反斜杠,必须使用双反斜杠\\。其实在Python中,第一个\用于转义,告诉Python后面的\是普通的反斜杠字

- Python googletrans库使用

爬虫俗手小马达

python前端

googletrans是一个用于翻译文本的Python库,使用谷歌翻译的API。它可以将文本从一种语言翻译为另一种语言,支持多种语言自动检测。以下是基本的用法示例:安装googletrans库在终端或命令行中执行以下命令安装:pipinstallgoogletrans==4.0.0-rc1使用示例fromgoogletransimportTranslator#初始化翻译器translator=Tr

- python中常用排序操作——sort方法和sorted函数的使用,超详细,内置模板代码!!!

盲敲代码的阿豪

python实用知识点pythonsortedsort排序

文章目录前言1、sort()方法的使用1.1基础操作1.2操作进阶(自定义排序的对象)2、sorted()函数的使用2.1基础操作2.2操作进行(自定义排序的对象)3、扩展:排序案例模板代码前言在Python中,排序的方法有多种,其中最常用的是使用内置的sort()方法和sorted()函数,接下来我将通过各种案例带领大家轻松学会这两种方法,同时还会扩展一些实用的排序案例模板代码。1、sort()

- 成功解决error while loading shared libraries: libpython2.7.so.1.0: cannot open shared object file: No su

哎呦,帅小伙哦

安装

安装了python2.7,第一次执行时报错:errorwhileloadingsharedlibraries:libpython2.7.so.1.0:cannotopensharedobjectfile:Nosuchfileordirectory解决方法如下:1.编辑vi/etc/ld.so.conf如果是非root权限帐号登录,使用sudovi/etc/ld.so.conf添加上python2.

- python爬虫——pandas的简单使用

张謹礧

python爬虫+可视化python网络爬虫pythonpandas爬虫

pandas作为爬虫中最重要的包之一,我们要想学好爬虫,就必须要深入了解pandas直接上代码importpandasaspdimportnumpyasnpdata=pd.DataFrame(np.arange(16).reshape((4,4)),index=['a','b','c','d'],#如果不写列索引默认为0,1,2,3columns=['a','b','c','d'])print(d

- Redis实战之Jedis使用技巧详解

小马不敲代码

实战redis缓存

一、前言基于redis开放的通信协议,大神们纷纷开发了各种语言的redis客户端,有c、c++、java、python、php、nodeJs等等开发语言的客户端,准确来说其实这些客户端都是基于redis命令做了一层封装,然后打包成工具以便大家更佳方便的操作redis,以Java项目为例,使用最广的就是以下三种客户端:JedisLettuceRedisson二、JedisJedis是老牌的Redis

- Transformer入门(1)transformer及其编码器-解码器

通信仿真实验室

GoogleBERT构建和训练NLP模型berttransformer人工智能NLP自然语言处理

文章目录1.Transformer简介2.Transformer的编码器-解码器架构3.transformer的编码器1.Transformer简介Transformer模型是一种用于自然语言处理的机器学习模型,它在2017年由Google的研究者提出,并在论文《AttentionisAllYouNeed》中详细描述。Transformer模型的核心创新在于其采用了自注意力(self-attent

- python venv文件夹_Python虚拟环境Venv

weixin_39640911

pythonvenv文件夹

当你的项目比较复杂,对模块版本要求不一时,不需要安装多个Python,只需要配置虚拟环境即可。提起虚拟环境,很多人都会想到Virtualenv,实际上从Python3.3版本开始内置了Venv模块用以建立轻量级的虚拟环境。Venv的用法和机制和Virtualenv非常相似,当你的项目只需要Python3.4或以上版本时,Venv完全可以替代Virtualenv。我这里的演示环境为Win10,使用的

- python selenium安装步骤_Python:Selenium+Webdriver安装

weixin_39619893

pythonselenium安装步骤

本人小白一枚,今天在使用selenium+webdriver的时候遇到了一个小问题:WebDriverException:'chromedriver'executableneedstobeinPATH.Pleaseseehttps://sites.google.com/a/chromium.org/chromedriver/home在debug过程中,也去baidu上查询了,很多说法,但是有些是行

- python selenium canvas_selenium webdriver 实现Canvas画布自动化测试

我不勇敢

pythonseleniumcanvas

https://blog.csdn.net/xiaoguanyusb/article/details/80324210由借鉴意义,转过来canvas是一个画布,定位元素时只能定位到画布上,如下乳所示,网页上有一张类似于下图的eChart报表图片。selenium的基本定位方式只能定位到该画布上,画布上的子元素通过selenium的基础定位方式是定位不到的,此时就需要使用selenium的js注入的

- 深度学习理论基础(七)Transformer编码器和解码器

小仇学长

深度学习深度学习transformer人工智能编码器解码器

学习目录:深度学习理论基础(一)Python及Torch基础篇深度学习理论基础(二)深度神经网络DNN深度学习理论基础(三)封装数据集及手写数字识别深度学习理论基础(四)Parser命令行参数模块深度学习理论基础(五)卷积神经网络CNN深度学习理论基础(六)Transformer多头自注意力机制深度学习理论基础(七)Transformer编码器和解码器本文目录学习目录:前述:Transformer

- Windows下使用venv创建python虚拟环境

Mr.Justice(JYZN)

深度学习Python基础

Windows下使用venv创建python虚拟环境(这里使用的是win10进行,其他Windows版本创建方法相同)必须是python3.x以上版本才有自带的venv包,本方法均是使用venv包下面的相关命令进行创建,这里的虚拟环境名称为“test”,所以都可以修改为自己的环境名称创建文件夹,切换当前目录mkdirtest#创建存放虚拟环境的文件夹cdtest#切换到创建的文件夹内创建虚拟环境p

- embed版Python如何安装第三方包

peanutwang

python开发语言

embed版本相当于一个纯Python运行环境,解压之后在命令行就可以Python.exexxx.py。但是涉及到使用第三方包的情况,还是需要安装的。以下是安装方法(整个过程无需配置环境变量):1.解压python-3.8.10-embed-amd642.配置包导入搜索路径默认的包导入搜索路径由根目录内pythonXX._pth,打开它把它前面的#注释去掉#importsite3.配置pip国内源

- 面向对象面向过程

3213213333332132

java

面向对象:把要完成的一件事,通过对象间的协作实现。

面向过程:把要完成的一件事,通过循序依次调用各个模块实现。

我把大象装进冰箱这件事为例,用面向对象和面向过程实现,都是用java代码完成。

1、面向对象

package bigDemo.ObjectOriented;

/**

* 大象类

*

* @Description

* @author FuJian

- Java Hotspot: Remove the Permanent Generation

bookjovi

HotSpot

openjdk上关于hotspot将移除永久带的描述非常详细,http://openjdk.java.net/jeps/122

JEP 122: Remove the Permanent Generation

Author Jon Masamitsu

Organization Oracle

Created 2010/8/15

Updated 2011/

- 正则表达式向前查找向后查找,环绕或零宽断言

dcj3sjt126com

正则表达式

向前查找和向后查找

1. 向前查找:根据要匹配的字符序列后面存在一个特定的字符序列(肯定式向前查找)或不存在一个特定的序列(否定式向前查找)来决定是否匹配。.NET将向前查找称之为零宽度向前查找断言。

对于向前查找,出现在指定项之后的字符序列不会被正则表达式引擎返回。

2. 向后查找:一个要匹配的字符序列前面有或者没有指定的

- BaseDao

171815164

seda

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.SQLException;

import java.sql.PreparedStatement;

import java.sql.ResultSet;

public class BaseDao {

public Conn

- Ant标签详解--Java命令

g21121

Java命令

这一篇主要介绍与java相关标签的使用 终于开始重头戏了,Java部分是我们关注的重点也是项目中用处最多的部分。

1

- [简单]代码片段_电梯数字排列

53873039oycg

代码

今天看电梯数字排列是9 18 26这样呈倒N排列的,写了个类似的打印例子,如下:

import java.util.Arrays;

public class 电梯数字排列_S3_Test {

public static void main(S

- Hessian原理

云端月影

hessian原理

Hessian 原理分析

一. 远程通讯协议的基本原理

网络通信需要做的就是将流从一台计算机传输到另外一台计算机,基于传输协议和网络 IO 来实现,其中传输协议比较出名的有 http 、 tcp 、 udp 等等, http 、 tcp 、 udp 都是在基于 Socket 概念上为某类应用场景而扩展出的传输协

- 区分Activity的四种加载模式----以及Intent的setFlags

aijuans

android

在多Activity开发中,有可能是自己应用之间的Activity跳转,或者夹带其他应用的可复用Activity。可能会希望跳转到原来某个Activity实例,而不是产生大量重复的Activity。

这需要为Activity配置特定的加载模式,而不是使用默认的加载模式。 加载模式分类及在哪里配置

Activity有四种加载模式:

standard

singleTop

- hibernate几个核心API及其查询分析

antonyup_2006

html.netHibernatexml配置管理

(一) org.hibernate.cfg.Configuration类

读取配置文件并创建唯一的SessionFactory对象.(一般,程序初始化hibernate时创建.)

Configuration co

- PL/SQL的流程控制

百合不是茶

oraclePL/SQL编程循环控制

PL/SQL也是一门高级语言,所以流程控制是必须要有的,oracle数据库的pl/sql比sqlserver数据库要难,很多pl/sql中有的sqlserver里面没有

流程控制;

分支语句 if 条件 then 结果 else 结果 end if ;

条件语句 case when 条件 then 结果;

循环语句 loop

- 强大的Mockito测试框架

bijian1013

mockito单元测试

一.自动生成Mock类 在需要Mock的属性上标记@Mock注解,然后@RunWith中配置Mockito的TestRunner或者在setUp()方法中显示调用MockitoAnnotations.initMocks(this);生成Mock类即可。二.自动注入Mock类到被测试类 &nbs

- 精通Oracle10编程SQL(11)开发子程序

bijian1013

oracle数据库plsql

/*

*开发子程序

*/

--子程序目是指被命名的PL/SQL块,这种块可以带有参数,可以在不同应用程序中多次调用

--PL/SQL有两种类型的子程序:过程和函数

--开发过程

--建立过程:不带任何参数

CREATE OR REPLACE PROCEDURE out_time

IS

BEGIN

DBMS_OUTPUT.put_line(systimestamp);

E

- 【EhCache一】EhCache版Hello World

bit1129

Hello world

本篇是EhCache系列的第一篇,总体介绍使用EhCache缓存进行CRUD的API的基本使用,更细节的内容包括EhCache源代码和设计、实现原理在接下来的文章中进行介绍

环境准备

1.新建Maven项目

2.添加EhCache的Maven依赖

<dependency>

<groupId>ne

- 学习EJB3基础知识笔记

白糖_

beanHibernatejbosswebserviceejb

最近项目进入系统测试阶段,全赖袁大虾领导有力,保持一周零bug记录,这也让自己腾出不少时间补充知识。花了两天时间把“传智播客EJB3.0”看完了,EJB基本的知识也有些了解,在这记录下EJB的部分知识,以供自己以后复习使用。

EJB是sun的服务器端组件模型,最大的用处是部署分布式应用程序。EJB (Enterprise JavaBean)是J2EE的一部分,定义了一个用于开发基

- angular.bootstrap

boyitech

AngularJSAngularJS APIangular中文api

angular.bootstrap

描述:

手动初始化angular。

这个函数会自动检测创建的module有没有被加载多次,如果有则会在浏览器的控制台打出警告日志,并且不会再次加载。这样可以避免在程序运行过程中许多奇怪的问题发生。

使用方法: angular .

- java-谷歌面试题-给定一个固定长度的数组,将递增整数序列写入这个数组。当写到数组尾部时,返回数组开始重新写,并覆盖先前写过的数

bylijinnan

java

public class SearchInShiftedArray {

/**

* 题目:给定一个固定长度的数组,将递增整数序列写入这个数组。当写到数组尾部时,返回数组开始重新写,并覆盖先前写过的数。

* 请在这个特殊数组中找出给定的整数。

* 解答:

* 其实就是“旋转数组”。旋转数组的最小元素见http://bylijinnan.iteye.com/bl

- 天使还是魔鬼?都是我们制造

ducklsl

生活教育情感

----------------------------剧透请原谅,有兴趣的朋友可以自己看看电影,互相讨论哦!!!

从厦门回来的动车上,无意中瞟到了书中推荐的几部关于儿童的电影。当然,这几部电影可能会另大家失望,并不是类似小鬼当家的电影,而是关于“坏小孩”的电影!

自己挑了两部先看了看,但是发现看完之后,心里久久不能平

- [机器智能与生物]研究生物智能的问题

comsci

生物

我想,人的神经网络和苍蝇的神经网络,并没有本质的区别...就是大规模拓扑系统和中小规模拓扑分析的区别....

但是,如果去研究活体人类的神经网络和脑系统,可能会受到一些法律和道德方面的限制,而且研究结果也不一定可靠,那么希望从事生物神经网络研究的朋友,不如把

- 获取Android Device的信息

dai_lm

android

String phoneInfo = "PRODUCT: " + android.os.Build.PRODUCT;

phoneInfo += ", CPU_ABI: " + android.os.Build.CPU_ABI;

phoneInfo += ", TAGS: " + android.os.Build.TAGS;

ph

- 最佳字符串匹配算法(Damerau-Levenshtein距离算法)的Java实现

datamachine

java算法字符串匹配

原文:http://www.javacodegeeks.com/2013/11/java-implementation-of-optimal-string-alignment.html------------------------------------------------------------------------------------------------------------

- 小学5年级英语单词背诵第一课

dcj3sjt126com

englishword

long 长的

show 给...看,出示

mouth 口,嘴

write 写

use 用,使用

take 拿,带来

hand 手

clever 聪明的

often 经常

wash 洗

slow 慢的

house 房子

water 水

clean 清洁的

supper 晚餐

out 在外

face 脸,

- macvim的使用实战

dcj3sjt126com

macvim

macvim用的是mac里面的vim, 只不过是一个GUI的APP, 相当于一个壳

1. 下载macvim

https://code.google.com/p/macvim/

2. 了解macvim

:h vim的使用帮助信息

:h macvim

- java二分法查找

蕃薯耀

java二分法查找二分法java二分法

java二分法查找

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 2015年6月23日 11:40:03 星期二

http:/

- Spring Cache注解+Memcached

hanqunfeng

springmemcached

Spring3.1 Cache注解

依赖jar包:

<!-- simple-spring-memcached -->

<dependency>

<groupId>com.google.code.simple-spring-memcached</groupId>

<artifactId>simple-s

- apache commons io包快速入门

jackyrong

apache commons

原文参考

http://www.javacodegeeks.com/2014/10/apache-commons-io-tutorial.html

Apache Commons IO 包绝对是好东西,地址在http://commons.apache.org/proper/commons-io/,下面用例子分别介绍:

1) 工具类

2

- 如何学习编程

lampcy

java编程C++c

首先,我想说一下学习思想.学编程其实跟网络游戏有着类似的效果.开始的时候,你会对那些代码,函数等产生很大的兴趣,尤其是刚接触编程的人,刚学习第一种语言的人.可是,当你一步步深入的时候,你会发现你没有了以前那种斗志.就好象你在玩韩国泡菜网游似的,玩到一定程度,每天就是练级练级,完全是一个想冲到高级别的意志力在支持着你.而学编程就更难了,学了两个月后,总是觉得你好象全都学会了,却又什么都做不了,又没有

- 架构师之spring-----spring3.0新特性的bean加载控制@DependsOn和@Lazy

nannan408

Spring3

1.前言。

如题。

2.描述。

@DependsOn用于强制初始化其他Bean。可以修饰Bean类或方法,使用该Annotation时可以指定一个字符串数组作为参数,每个数组元素对应于一个强制初始化的Bean。

@DependsOn({"steelAxe","abc"})

@Comp

- Spring4+quartz2的配置和代码方式调度

Everyday都不同

代码配置spring4quartz2.x定时任务

前言:这些天简直被quartz虐哭。。因为quartz 2.x版本相比quartz1.x版本的API改动太多,所以,只好自己去查阅底层API……

quartz定时任务必须搞清楚几个概念:

JobDetail——处理类

Trigger——触发器,指定触发时间,必须要有JobDetail属性,即触发对象

Scheduler——调度器,组织处理类和触发器,配置方式一般只需指定触发

- Hibernate入门

tntxia

Hibernate

前言

使用面向对象的语言和关系型的数据库,开发起来很繁琐,费时。由于现在流行的数据库都不面向对象。Hibernate 是一个Java的ORM(Object/Relational Mapping)解决方案。

Hibernte不仅关心把Java对象对应到数据库的表中,而且提供了请求和检索的方法。简化了手工进行JDBC操作的流程。

如

- Math类

xiaoxing598

Math

一、Java中的数字(Math)类是final类,不可继承。

1、常数 PI:double圆周率 E:double自然对数

2、截取(注意方法的返回类型) double ceil(double d) 返回不小于d的最小整数 double floor(double d) 返回不大于d的整最大数 int round(float f) 返回四舍五入后的整数 long round

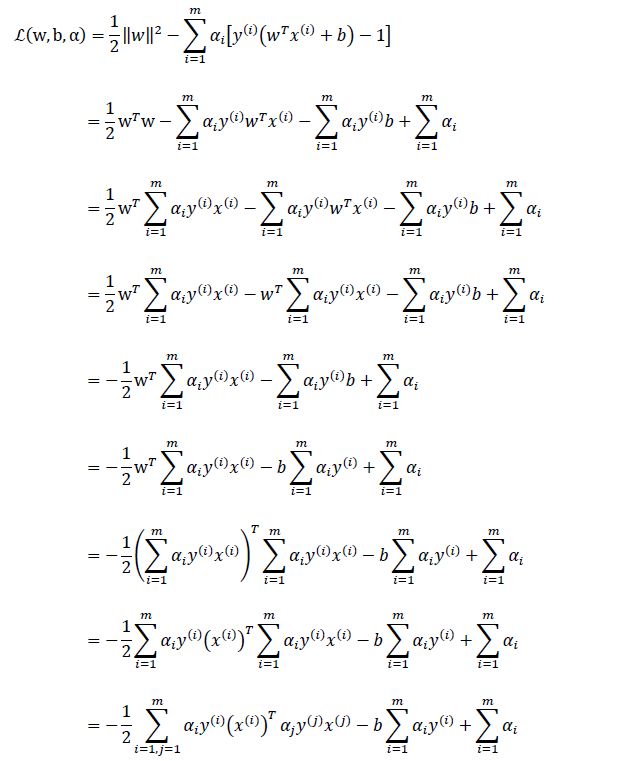

![]()

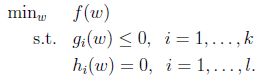

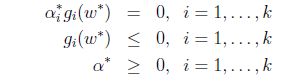

![]() 就是我们要求解的原问题(primal problem),只要通过最小化

就是我们要求解的原问题(primal problem),只要通过最小化![]() 就可以解决 。为什么最小化

就可以解决 。为什么最小化![]() 就可以了呢?我们以一个更一般的例子来解释一下这个求解原理。

就可以了呢?我们以一个更一般的例子来解释一下这个求解原理。

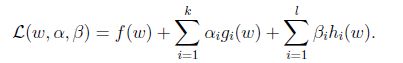

![]() 和

和![]() 是拉格朗日乘子,我们首先想到是不是要求解min L()啊,但是却恰恰相反,我们要最大化L。因为在g小于0的情况下如果我们无限的增大

是拉格朗日乘子,我们首先想到是不是要求解min L()啊,但是却恰恰相反,我们要最大化L。因为在g小于0的情况下如果我们无限的增大![]() ,min L()其实是根本无解的,因为可以无限的小。为了排除这种情况,我们定义了如下函数:

,min L()其实是根本无解的,因为可以无限的小。为了排除这种情况,我们定义了如下函数: ![]()

![]() 和

和![]() 的时候只要调节一下

的时候只要调节一下![]() 和

和![]() 就可以得到无穷的值,但是只有满足我们上面的g和h满足约束的时候才能够得到

就可以得到无穷的值,但是只有满足我们上面的g和h满足约束的时候才能够得到![]() 等于f(w)。但是切记有个条件,就是

等于f(w)。但是切记有个条件,就是![]() 。

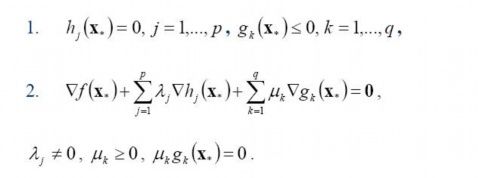

。 ![]()

![]() 就可以了。

就可以了。 ![]()

![]() 代替min f(w),但是我们也发现了,解决

代替min f(w),但是我们也发现了,解决![]() 的最小化也不是一个简单的问题,因为其中还是有一个不等式约束

的最小化也不是一个简单的问题,因为其中还是有一个不等式约束![]() ,那么怎么解决这个问题呢???

,那么怎么解决这个问题呢???

![]() 求解min

求解min![]()

![]() 的最小值因为在满足约束条件的情况下

的最小值因为在满足约束条件的情况下![]() 。

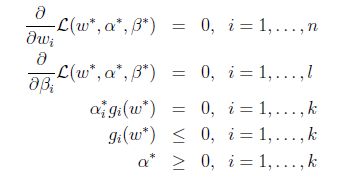

。 ![]()

![]() 叫做

叫做![]() (原始问题),解决这个问题的办法就是将之变为对偶问题,什么是对偶问题呢?

(原始问题),解决这个问题的办法就是将之变为对偶问题,什么是对偶问题呢? ![]()

![]() ,我们可以看出对偶问题就是原始问题的min和max进行了调换,但是注意下标哦,两个问题的变量也跟着变化了。

,我们可以看出对偶问题就是原始问题的min和max进行了调换,但是注意下标哦,两个问题的变量也跟着变化了。 ![]() 和对偶问题

和对偶问题![]() 有什么关联呢?

有什么关联呢? ![]()

![]() 为一个凸集,f:

为一个凸集,f:![]() 为一个凸函数。凸优化就是找出一个点

为一个凸函数。凸优化就是找出一个点![]() ,使得每一个

,使得每一个![]() 满足

满足![]()

![]() ,此时

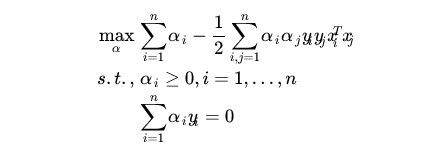

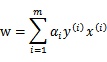

,此时 的最小值只与w和b有关,按照正常的求解最小值方式,对w和b分别求导并令导数为0:

的最小值只与w和b有关,按照正常的求解最小值方式,对w和b分别求导并令导数为0:  (对w求导为二范数求导)

(对w求导为二范数求导)

![]() 了

了

![]() 要用到SMO算法,我会在后面结合Python一起讲

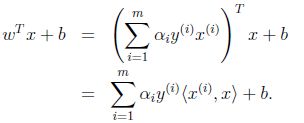

要用到SMO算法,我会在后面结合Python一起讲  得到w,在根据

得到w,在根据![]()

![]() (这其实就是整个问题的出发点,超平面)得到

(这其实就是整个问题的出发点,超平面)得到

![]() 我们就根本不用求出w就可以了,直接就用新数据和原始数据中的所有样本做内积就可以了。为什么这样比计算w再用新数据和w、b线性运算更快呢?

我们就根本不用求出w就可以了,直接就用新数据和原始数据中的所有样本做内积就可以了。为什么这样比计算w再用新数据和w、b线性运算更快呢?

![]() 就是约束条件)

就是约束条件) ![]() 是大于零的,其余点的

是大于零的,其余点的![]() 都等于零。这些函数间隔最小的点就叫做支持向量参考下面图中虚线上的点

都等于零。这些函数间隔最小的点就叫做支持向量参考下面图中虚线上的点

![]() 都等于零,而且支持向量是少数的,所以运算比较快,而且还可以用核函数来解决问题。

都等于零,而且支持向量是少数的,所以运算比较快,而且还可以用核函数来解决问题。![]() 都为0。求解w、b的偏导数,再利用SMO求

都为0。求解w、b的偏导数,再利用SMO求![]() 。反推得到b,就可以利用核函数解决了。

。反推得到b,就可以利用核函数解决了。![]() 的SMO还没有介绍。

的SMO还没有介绍。