python基础知识整理

1.列表去重

#方法一

def delList(L):

L1 = [ ]

for i in L:

if i not in L1:

L1.append(i)

return L1

print(delList(L1))

#方法二:去重

L1=list(set(L))

#a = [2,2,2,2,6,84,5,9]

#print(delList(a))

#a2 = list(set(a))

#print(a2)

2.Python中如何拷贝一个对象

1).浅拷贝:

使用copy.copy,它可以进行对象的浅拷贝(shallow copy),它复制了对象,但对于对象中的元素,依然使用引用(换句话说修改拷贝对象元素,则被拷贝对象元素也被修改)

2).深拷贝:

使用copy.deepcopy,它可以进行深拷贝,不仅拷贝了对象,同时也拷贝了对象中的元素,获得了全新的对象,与被拷贝对象完全独立,但这需要牺牲一定的时间和空间。

3).特殊拷贝:

如要复制列表L,使用list(L),要复制一个字典d,使用dict(d),要复制一个集合s,使用set(s)。

总结一下的话:如果你要复制某个对象object, 它属于python内建的类型type,那么你可以使用type(object)来 获得一个拷贝。

4) 举例:

import copy

list = [1, 2, 3, 4, ['a', 'b']] #原始对象

b = list #赋值,传对象的引用,依然指向list

c = copy.copy(list) #对象拷贝,浅拷贝(元素依然是共享的引用)

d = copy.deepcopy(list) #对象拷贝,深拷贝

list.append(5) #修改对象list

list[4].append('c') #修改对象list中的['a', 'b']数组对象

print ('list = ', list)

print ('b = ', b)

print ('c = ', c)

print ('d = ', d)

#输出结果:

list = [1, 2, 3, 4, ['a', 'b', 'c'], 5]

b = [1, 2, 3, 4, ['a', 'b', 'c'], 5]

c = [1, 2, 3, 4, ['a', 'b', 'c']]

d = [1, 2, 3, 4, ['a', 'b']]

3.赋值、深拷贝与浅拷贝的区别

一、赋值

在 Python 中,对象的赋值就是简单的对象引用,这点和 C++不同,如下所示:

a = [1,2,"hello",['python', 'C++']]

b = a

在上述情况下,a 和 b 是一样的,他们指向同一片内存,b 不过是 a 的别名,是引用。我们可以使用bisa去判断,返回 True,表明他们地址相同,内容相同,也可以使用 id()函数来查看两个列表的地址是否相同。赋值操作(包括对象作为参数、返回值)不会开辟新的内存空间,它只是复制了对象的引用。也就是说除了 b 这个名字之外,没有其他的内存开销。修改了 a,也就影响了 b,同理,修改了 b,也就影响了 a。

二、浅拷贝(shallow copy)

浅拷贝会创建新对象,其内容非原对象本身的引用,而是原对象内第一层对象的引用。

浅拷贝有三种形式:

切片操作

工厂函数

copy 模块中的 copy 函数

比如上述的列表 a;

b = a[:] 或者 b = [x for x in a] #切片操作

b = list(a) #工厂函数

b = copy.copy(a) #copy函数

浅拷贝产生的列表 b 不再是列表 a 了,使用 is 判断可以发现他们不是同一个对象,使用 id 查看,他们也不指向同一片内存空间。但是当我们使用 id(x) for x in a 和 id(x) for x in b 来查看 a 和 b 中元素的地址时,可以看到二者包含的元素的地址是相同的。在这种情况下,列表 a 和 b 是不同的对象,修改列表 b 理论上不会影响到列表 a。但是要注意的是,浅拷贝之所以称之为浅拷贝,是它仅仅只拷贝了一层,在列表 a 中有一个嵌套的list,如果我们修改了它,情况就不一样了。

比如:

a[3].append('java')

查看列表 b,会发现列表 b 也发生了变化,这是因为,我们修改了嵌套的 list,修改外层元素,会修改它的引用,让它们指向别的位置,修改嵌套列表中的元素,列表的地址并未发生变化,指向的都是用一个位置。

三、深拷贝(deep copy)

深拷贝只有一种形式,copy 模块中的 deepcopy()函数。深拷贝和浅拷贝对应,深拷贝拷贝了对象的所有元素,包括多层嵌套的元素。因此,它的时间和空间开销要高。同样的对列表 a,如果使用 b = copy.deepcopy(a),再修改列表 b 将不会影响到列表 a,即使嵌套的列表具有更深的层次,也不会产生任何影响,因为深拷贝拷贝出来的对象根本就是一个全新的对象,不再与原来的对象有任何的关联。

四、拷贝的注意点

对于非容器类型,如数字、字符,以及其他的“原子”类型,没有拷贝一说,产生的都是原对象的引用。

如果元组变量值包含原子类型对象,即使采用了深拷贝,也只能得到浅拷贝

4.列表插入

l = [1,2,3]

l.insert(0,4) #在列表的索引处插入

print(l)

5.列表元素替换

x = "hello world "

y = x.replace("hello","hi")

print(y) # 结果为:hi world

6.a=1,b=2,不用中间变量交换 a 和 b 的值?

#方法一:

a = a+b

b = a-b

a = a-b

#方法二:

a = a^b

b =b^a

a = a^b

#方法三:

a,b = b,a

7.代码中要修改不可变数据会出现什么问题? 抛出什么异常?

代码不会正常运行,抛出 TypeError 异常。

8.print 调用 Python 中底层的什么方法?

print 方法默认调用 sys.stdout.write 方法,即往控制台打印字符串。

9.下面这段代码的输出结果将是什么?请解释?

class Parent(object):

x=1

class Child1(Parent):

pass

class Child2(Parent):

pass

print(Parent.x, Child1.x, Child2.x)

Child1.x = 2

print( Parent.x, Child1.x, Child2.x)

Parent.x = 3

print( Parent.x, Child1.x, Child2.x)

#结果为:

1 1 1 #继承自父类的类属性 x,所以都一样,指向同一块内存地址。

1 2 1 #更改 Child1,Child1 的 x 指向了新的内存地址。

3 2 3 #更改 Parent,Parent 的 x 指向了新的内存地址。

10.简述你对 input()函数的理解?

在 Python3 中,input()获取用户输入,不论用户输入的是什么,获取到的都是字符串类型的。

在 Python2 中有 raw_input()和 input(), raw_input()和 Python3 中的 input()作用是一样的,input()输入的是什么数据类型的,获取到的就是什么数据类型的。

11.阅读下面的代码,写出 A0,A1 至 An 的最终值。

A0 = dict(zip(('a','b','c','d','e'),(1,2,3,4,5)))

A1 = range(10)

A2 = [i for i in A1 if i in A0]

A3 = [A0[s] for s in A0] #[]

A4 = [i for i in A1 if i in A3]

A5 = {i:i*i for i in A1}

A6 = [[i,i*i] for i in A1]

#结果为:

A0 = {'a': 1, 'c': 3, 'b': 2, 'e': 5, 'd': 4}

A1 = [0, 1, 2, 3, 4, 5, 6, 7, 8, 9]

A2 = []

A3 = [1, 3, 2, 5, 4]

A4 = [1, 2, 3, 4, 5]

A5 = {0: 0, 1: 1, 2: 4, 3: 9, 4: 16, 5: 25, 6: 36, 7: 49, 8: 64, 9: 81}

A6 = [[0, 0], [1, 1], [2, 4], [3, 9], [4, 16], [5, 25], [6, 36],[7, 49],[8, 64] [9,81]]

12.考虑以下 Python 代码,如果运行结束,命令行中的运行结果是什么?

l = []

for i in range(10):

l.append({'num':i})

print (l)

#结果为:

[{'num':0},{'num':1},{'num':2},{'num':3},{'num':4},{'num':5},{'num':6},{'num':7},{'num':8},{'num':9}]

再考虑以下代码,运行结束后的结果是什么?

l = []

a = {'num':0}

for i in range(10):

a['num'] = i

l.append(a)

print(l)

#结果为:

[{'num':9},{'num':9},{'num':9},{'num':9},{'num':9},{'num':9},{'num':9},{'num':9},{'num':9},{'num':9}]

原因是:字典是可变对象,在下方的 l.append(a)的操作中是把字典 a 的引用传到列表 l 中,当后续操作修改 a[‘num’]的值的时候,l 中的值也会跟着改变,相当于浅拷贝。

13.4G 内存怎么读取一个 5G 的数据?

方法一:

可以通过生成器,分多次读取,每次读取数量相对少的数据(比如 500MB)进行处理,处理结束后在读取后面的 500MB 的数据。

方法二:

可以通过 linux 命令 split 切割成小文件,然后再对数据进行处理,此方法效率比较高。可以按照行数切割,可以按照文件大小切割。

将一个大文件分成若干个小文件方法

例如将一个BLM.txt文件分成前缀为 BLM_ 的1000个小文件,后缀为系数形式,且后缀为4位数字形式

先利用

wc -l BLM.txt #读出 BLM.txt 文件一共有多少行

再利用 split 命令

split -l 2482 ../BLM/BLM.txt -d -a 4 BLM_

将文件 BLM.txt 分成若干个小文件,每个文件2482行(-l 2482),文件前缀为BLM_ ,系数不是字母而是数字(-d),后缀系数为四位数(-a 4)

linux下文件分割可以通过split命令来实现,可以指定按行数分割和按大小分割两种模式。Linux下文件合并可以通过cat命令来实现,非常简单。

在Linux下用split进行文件分割:

模式一:指定分割后文件行数

对与txt文本文件,可以通过指定分割后文件的行数来进行文件分割。

命令:split -l 300 large_file.txt new_file_prefix

模式二:指定分割后文件大小

命令: split -b 10m server.log waynelog

对二进制文件我们同样也可以按文件大小来分隔。

在Linux下用cat进行文件合并:

命令:cat small_files* > large_file

将a.txt的内容输入到b.txt的末尾

cat a.txt >> b.txt

14.修改代码

现在考虑有一个 jsonline 格式的文件 file.txt 大小约为 10K,之前处理文件的代码如下所示:

def get_lines():

l = []

with open('file.txt','rb') as f:

for eachline in f:

l.append(eachline)

return l

if __name__ == '__main__':

for e in get_lines():

process(e) #处理每一行数据

现在要处理一个大小为 10G 的文件,但是内存只有 4G,如果在只修改 get_lines 函数而其他代码保持不变的情况下,应该如何实现?需要考虑的问题都有哪些?

def get_lines():

l = []

with open('file.txt','rb') as f:

data = f.readlines(60000)

l.append(data)

yield l

if __name__ == '__main__':

for e in get_lines():

process(e)

要考虑到的问题有:

内存只有 4G 无法一次性读入 10G 的文件,需要分批读入。分批读入数据要记录每次读入数据的位置。分批每次读入数据的大小,太小就会在读取操作上花费过多时间。

15.read、readline 和 readlines 的区别

read() : 一次性读取整个文件内容。推荐使用read(size)方法,size越大运行时间越长

readline() :每次读取一行内容。内存不够时使用,一般不太用.使用生成器方法

readlines() :一次性读取整个文件内容,并按行返回到list,方便我们遍历

一般小文件我们都采用read(),不确定大小你就定个size,大文件就用readlines()

16.返回文件及其子文件路径

def print_directory_contents(sPath):

"""

这个函数接收文件夹的名称作为输入参数

返回该文件夹中文件的路径

以及其包含文件夹中文件的路径

"""

# ------------代码如下--------------------

import os

for sChild in os.listdir(sPath):

sChildPath = os.path.join(sPath, sChild)

if os.path.isdir(sChildPath):

print_directory_contents(sChildPath)

else:

print(sChildPath)

17.在 except 中 return 后还会不会执行 finally 中的代码?怎么抛出自定义异常?

会继续处理 finally 中的代码;用 raise 方法可以抛出自定义异常。

18.介绍一下 except 的作用和用法?

except #捕获所有异常

except: <异常名> #捕获指定异常

except:<异常名 1, 异常名 2> #捕获异常 1 或者异常 2

except:<异常名>,<数据> #捕获指定异常及其附加的数据

except:<异常名 1,异常名 2>:<数据> #捕获异常名 1 或者异常名 2,及附加的数据

19.常用的 Python 标准库都有哪些?

os #操作系统

time #时间

random #随机

pymysql #连接数据库

threading #线程

multiprocessing #进程

queue #队列

第三方库:

django 和 flask 也是第三方库,

requests,

virtualenv,

selenium,

scrapy,

xadmin,

celery,

re,

hashlib,

md5。

常用的科学计算库(如 Numpy,Scipy,Pandas)。

20.init 和__new__的区别?

init 在对象创建后,对对象进行初始化。

new 是在对象创建之前创建一个对象,并将该对象返回给 init。

21.Python 里面如何生成随机数?

在 Python 中用于生成随机数的模块是 random,在使用前需要 import. 如下例子可以酌情列

举:

import random

random.random() #生成一个 0-1 之间的随机浮点数;

random.uniform(a, b) #生成[a,b]之间的浮点数;

random.randint(a, b) #生成[a,b]之间的整数;

random.randrange(a, b, step) #在指定的集合[a,b)中,以 step 为基数随机取一个数;

random.choice(sequence) #从特定序列中随机取一个元素,这里的序列可以是字符串,列表,元组等。

22.输入某年某月某日,判断这一天是这一年的第几天?(可以用 Python 标准库)

import datetime

def dayofyear():

year = input("请输入年份:")

month = input("请输入月份:")

day = input("请输入天:")

date1 = datetime.date(year=int(year),month=int(month),day=int(day))

date2 = datetime.date(year=int(year),month=1,day=1)

return (date1 - date2 + 1).days

23.打乱一个排好序的 list 对象 alist?

import random

alist = [1,2,3,4,5,98,56]

random.shuffle(alist)

print(alist)

24.说明一下 os.path 和 sys.path 分别代表什么?

os.path 主要是用于对系统路径文件的操作。

sys.path 主要是对 Python 解释器的系统环境参数的操作(动态的改变 Python 解释器搜索路径)。

25.Python 中的 os 模块常见方法?

os.remove() #删除文件

os.rename() #重命名文件

os.walk() #生成目录树下的所有文件名

os.chdir() #改变目录

os.mkdir/makedirs #创建目录/多层目录

os.rmdir/removedirs #删除目录/多层目录

os.listdir() #列出指定目录的文件

os.getcwd() #取得当前工作目录

os.chmod() #改变目录权限

os.path.basename() #去掉目录路径,返回文件名

os.path.dirname() #去掉文件名,返回目录路径

os.path.join() #将分离的各部分组合成一个路径名

os.path.split() #返回(dirname(),basename())元组

os.path.splitext() #(返回 filename,extension)元组

os.path.getatime\ctime\mtime #分别返回最近访问、创建、修改时间

os.path.getsize() #返回文件大小

os.path.exists() #是否存在

os.path.isabs() #是否为绝对路径

os.path.isdir() #是否为目录

os.path.isfile() #是否为文件

26.Python 的 sys 模块常用方法?

sys.argv #命令行参数 List,第一个元素是程序本身路径

sys.modules.keys() #返回所有已经导入的模块列表

sys.exc_info() #获取当前正在处理的异常类,exc_type、exc_value、exc_traceback 当前处理的异常详细信息

sys.exit(n) #退出程序,正常退出时 exit(0)

sys.hexversion #获取 Python 解释程序的版本值,16 进制格式如:0x020403F0

sys.version #获取 Python 解释程序的版本信息

sys.maxint #最大的 Int 值

sys.maxunicode #最大的 Unicode 值

sys.modules #返回系统导入的模块字段,key 是模块名,value 是模块

sys.path #返回模块的搜索路径,初始化时使用 PYTHONPATH 环境变量的值

sys.platform #返回操作系统平台名称

sys.stdout #标准输出

sys.stdin #标准输入

sys.stderr #错误输出

sys.exc_clear() #用来清除当前线程所出现的当前的或最近的错误信息

sys.exec_prefix #返回平台独立的 python 文件安装的位置

sys.byteorder #本地字节规则的指示器,big-endian 平台的值是'big',little-endian 平台的是'little'

sys.copyright #记录 python 版权相关的东西

sys.api_version #解释器的 C 的 API 版本

sys.version_info #元组则提供一个更简单的方法来使你的程序具备 Python 版本要求功能

27.unit test 是什么?

在 Python 中,unittest 是 Python 中的单元测试框架。它拥有支持共享搭建、自动测试、在测试中暂停代码、将不同测试迭代成一组,等的功能。

28.模块和包是什么?

在 Python 中,模块是搭建程序的一种方式。每一个 Python 代码文件都是一个模块,并可以引用其他的模块,比如对象和属性。

一个包含许多 Python 代码的文件夹是一个包。一个包可以包含模块和子文件夹。

29.Python 是强语言类型还是弱语言类型?

Python 是强类型的动态脚本语言。

强类型:不允许不同类型相加。

动态:不使用显示数据类型声明,且确定一个变量的类型是在第一次给它赋值的时候。

脚本语言:一般也是解释型语言,运行代码只需要一个解释器,不需要编译。

30.谈一下什么是解释性语言,什么是编译性语言?

计算机不能直接理解高级语言,只能直接理解机器语言,所以必须要把高级语言翻译成机器语言,计算机才能执行高级语言编写的程序。

解释性语言在运行程序的时候才会进行翻译。

编译型语言写的程序在执行之前,需要一个专门的编译过程,把程序编译成机器语言(可执行文件)。

31.Python 中有日志吗?怎么使用?

Python 自带 logging 模块,调用 logging.basicConfig()方法,配置需要的日志等级和相应的参数,Python 解释器会按照配置的参数生成相应的日志。

32.Python 是如何进行类型转换的?

int(x,base=10) #x字符串或数字,base进制数,默认十进制 浮点转为整数

float #整数转换为浮点型

complex(1,2) #转换为复数

str(10) #将对象转换为字符串

repe() #将对象转换为表达式字符串

repr(dict) #将对象转换为表达式字符串

eval(str) #用来计算在字符串中有效的python表达式,返回一个对象

tuple(listi) #将列表转化为元组

list() #将元组转换为列表

set #转换集合

33.Python2 与 Python3 的区别?

1)核心类差异

1.Python3 对 Unicode 字符的原生支持。

Python2 中使用 ASCII 码作为默认编码方式导致 string 有两种类型 str和 unicode,Python3 只支持 unicode 的 string。Python2 和 Python3 字节和字符对应关系为:

| python2 | python3 | 表现 | 装换 | 作用 |

|---|---|---|---|---|

| str | bytes | 字节 | encode | 存储 |

| unicode | str | 字符 | decode | 显示 |

2.Python3 采用的是绝对路径的方式进行 import。

Python2 中相对路径的 import 会导致标准库导入变得困难(想象一下,同一目录下有 file.py,如

何同时导入这个文件和标准库 file)。Python3 中这一点将被修改,如果还需要导入同一目录的文件必须使用绝对路径,否则只能使用相关导入的方式来进行导入。

3.Python2 中存在老式类和新式类的区别,Python3 统一采用新式类。新式类声明要求继承 object,必须用新式类应用多重继承。

4.Python3 使用更加严格的缩进。Python2 的缩进机制中,1 个 tab 和 8 个 space 是等价的所以在缩进中可以同时允许 tab 和 space 在代码中共存。这种等价机制会导致部分 IDE 使用存在问题。

Python3 中 1 个 tab 只能找另外一个 tab 替代,因此 tab 和 space 共存会导致错:TabError:

inconsistent use of tabs and spaces in indentation.

2)废弃类差异

1.print 语句被 Python3 废弃,统一使用 print 函数

2.exec 语句被 python3 废弃,统一使用 exec 函数

3.execfile 语句被 Python3 废弃,推荐使用 exec(open("./filename").read())

4.不相等操作符"<>“被 Python3 废弃,统一使用”!="

5.long 整数类型被 Python3 废弃,统一使用 int

6.xrange 函数被 Python3 废弃,统一使用 range,Python3 中 range 的机制也进行修改并提高了大数据集生成效率

7.Python3 中这些方法再不再返回 list 对象:dictionary 关联的 keys()、values()、items(),zip(),map(),filter(),但是可以通过 list 强行转换:

1. mydict={"a":1,"b":2,"c":3}

2. mydict.keys() #8.迭代器 iterator 的 next()函数被 Python3 废弃,统一使用 next(iterator)

9.raw_input 函数被 Python3 废弃,统一使用 input 函数

10.字典变量的 has_key 函数被 Python 废弃,统一使用 in 关键词

11.file 函数被 Python3 废弃,统一使用 open 来处理文件,可以通过 io.IOBase 检查文件类型

12.apply 函数被 Python3 废弃

13.异常 StandardError 被 Python3 废弃,统一使用 Exception

3) 修改类差异

1.浮点数除法操作符“/”和“//”的区别

“ / ”:

Python2:若为两个整形数进行运算,结果为整形,但若两个数中有一个为浮点数,则结果为

浮点数;

Python3:为真除法,运算结果不再根据参加运算的数的类型。

“//”:

Python2:返回小于除法运算结果的最大整数;从类型上讲,与"/"运算符返回类型逻辑一致。

Python3:和 Python2 运算结果一样。

2.异常抛出和捕捉机制区别

#python2

raise IOError, "file error" #抛出异常

except NameError, err: #捕捉异常

#python3

raise IOError("file error") #抛出异常

except NameError as err: 捕捉异常

3.for 循环中变量值区别

#Python2,for 循环会修改外部相同名称变量的值

i = 1

print ('comprehension: ', [i for i in range(5)])

print ('after: i =', i) #i=4

#Python3,for 循环不会修改外部相同名称变量的值

i = 1

print ('comprehension: ', [i for i in range(5)])

print ('after: i =', i) #i=1

4.round 函数返回值区别

#Python2,round 函数返回 float 类型值

isinstance(round(15.5),int) #True

#Python3,round 函数返回 int 类型值

isinstance(round(15.5),float) #True

5.比较操作符区别

#Python2 中任意两个对象都可以比较

1. 11 < 'test' #True

#Python3 中只有同一数据类型的对象可以比较

1. 11 < 'test' # TypeError: unorderable types: int() < str()

4)第三方工具包差异

我们在 pip 官方下载源 pypi 搜索 Python2.7 和 Python3.5 的第三方工具包数可以发现,Python2.7版本对应的第三方工具类目数量是 28523,Python3.5 版本的数量是 12457,这两个版本在第三方工具包支持数量差距相当大。

我们从数据分析的应用角度列举了常见实用的第三方工具包(如下表),并分析这些工具包在Python2.7 和 Python3.5 的支持情况:

| 分类 | 工具名 | 用途 |

|---|---|---|

| 数据收集 | scrapy | 网页采集,爬虫 |

| 数据收集 | scrapy-redis | 分布式爬虫 |

| 数据收集 | selenium | web 测试,仿真浏览器 |

| 数据处理 | beautifulsoup | 网页解释库,提供 lxml 的支持 |

| 数据处理 | lxml | xml 解释库 |

| 数据处理 | xlrd | excel 文件读取 |

| 数据处理 | xlwt | excel 文件写入 |

| 数据处理 | xlutils | excel 文件简单格式修改 |

| 数据处理 | pywin32 | excel 文件的读取写入及复杂格式定制 |

| 数据处理 | Python-docx | Word 文件的读取写入 |

| 数据分析 | numpy | 基于矩阵的数学计算库 |

| 数据分析 | pandas | 基于表格的统计分析库 |

| 数据分析 | scipy | 科学计算库,支持高阶抽象和复杂模型 |

| 数据分析 | statsmodels | 统计建模和计量经济学工具包 |

| 数据分析 | scikit-learn | 机器学习工具库 |

| 数据分析 | gensim | 自然语言处理工具库 |

| 数据分析 | jieba | 中文分词工具库 |

| 数据存储 | MySQL-python | mysql 的读写接口库 |

| 数据存储 | mysqlclient | mysql 的读写接口库 |

| 数据存储 | SQLAlchemy | 数据库的 ORM 封装 |

| 数据存储 | pymssql | sql server 读写接口库 |

| 数据存储 | redis | redis 的读写接口 |

| 数据存储 | PyMongo | mongodb 的读写接口 |

| 数据呈现 | matplotlib | 流行的数据可视化库 |

| 数据呈现 | seaborn | 美观的数据可是湖库,基于 matplotlib |

| 工具辅助 | jupyter | 基于 web 的 python IDE,常用于数据分析 |

| 工具辅助 | chardet | 字符检查工具 |

| 工具辅助 | ConfigParser | 配置文件读写支持 |

| 工具辅助 | requests | HTTP 库,用于网络访问 |

5) 工具安装问题

windows 环境

Python2 无法安装 mysqlclient。Python3 无法安装 MySQL-python、 flup、functools32、Gooey、Pywin32、 webencodings。

matplotlib 在 python3 环境中安装报错:The following required packages can not be built:freetype, png。需要手动下载安装源码包安装解决。

scipy 在 Python3 环境中安装报错,numpy.distutils.system_info.NotFoundError,需要自己手工下载对应的安装包,依赖 numpy,pandas 必须严格根据 python 版本、操作系统、64 位与否。运行matplotlib 后发现基础包 numpy+mkl 安装失败,需要自己下载,国内暂无下载源。

centos 环境下

Python2 无法安装 mysql-python 和 mysqlclient 包,报错:EnvironmentError: mysql_config not found,解决方案是安装 mysql-devel 包解决。使用 matplotlib 报错:no module named _tkinter,安装 Tkinter、tk-devel、tc-devel 解决。

pywin32 也无法在 centos 环境下安装。

34.关于 Python 程序的运行方面,有什么手段能提升性能?

1、使用多进程,充分利用机器的多核性能

2、对于性能影响较大的部分代码,可以使用 C 或 C++编写

3、对于 IO 阻塞造成的性能影响,可以使用 IO 多路复用来解决

4、尽量使用 Python 的内建函数

5、尽量使用局部变量

35.Python 中的作用域?

Python 中,一个变量的作用域总是由在代码中被赋值的地方所决定。当 Python 遇到一个变量的话它会按照这的顺序进行搜索:

本地作用域(Local)—>当前作用域被嵌入的本地作用域(Enclosing locals)—>全局/模块作用域(Global)—>内置作用域(Built-in)。

36.什么是 Python?

Python 是一种编程语言,它有对象、模块、线程、异常处理和自动内存管理,可以加入其他语言的对比。

Python 是一种解释型语言,Python 在代码运行之前不需要解释。

Python 是动态类型语言,在声明变量时,不需要说明变量的类型。

Python 适合面向对象的编程,因为它支持通过组合与继承的方式定义类。

在 Python 语言中,函数是第一类对象。

Python 代码编写快,但是运行速度比编译型语言通常要慢。

Python 用途广泛,常被用走"胶水语言",可帮助其他语言和组件改善运行状况。

使用 Python,程序员可以专注于算法和数据结构的设计,而不用处理底层的细节。

37.什么是 Python 自省?

Python 自省是 Python 具有的一种能力,使程序员面向对象的语言所写的程序在运行时,能够获得对象的类 Python 型。Python 是一种解释型语言,为程序员提供了极大的灵活性和控制力。

详见:https://blog.csdn.net/yuelai_217/article/details/97628979

Python中常用的自省函数

1)help() 用来查看很多Python自带的帮助文档信息。

2)dir() 可以列出对象的所有属性。

3)type() 返回对象的类型。

4)id() 返回对象的“唯一序号”。对于引用对象来说,返回的是被引用对象的id()。

5)hasattr()和getattr() 分别判断对象是否有某个属性及获得某个属性值。

6)callable() 判断对象是否可以被调用。

7)isinstance() 可以确认某个变量是否有某种类型。

38.什么是 Python 的命名空间?

在 Python 中,所有的名字都存在于一个空间中,它们在该空间中存在和被操作——这就是命名空间。它就好像一个盒子,每一个变量名字都对应装着一个对象。当查询变量的时候,会从该盒子里面寻找相应的对象。

39.你所遵循的代码规范是什么?请举例说明其要求?

PEP8 规范。

1.变量

常量:大写加下划线 USER_CONSTANT。

私有变量 : 小写和一个前导下划线 _private_value。

Python 中不存在私有变量一说,若是遇到需要保护的变量,使用小写和一个前导下划线。但这只是程序员之间的一个约定,用于警告说明这是一个私有变量,外部类不要去访问它。但实际上,外部类还是可以访问到这个变量。

内置变量 : 小写,两个前导下划线和两个后置下划线 class

两个前导下划线会导致变量在解释期间被更名。这是为了避免内置变量和其他变量产生冲突。用户定义的变量要严格避免这种风格。以免导致混乱。

2.函数和方法

总体而言应该使用,小写和下划线。但有些比较老的库使用的是混合大小写,即首单词小写,之后每个单词第一个字母大写,其余小写。但现在,小写和下划线已成为规范。

私有方法 :小写和一个前导下划线

这里和私有变量一样,并不是真正的私有访问权限。同时也应该注意一般函数不要使用两个前导下划线(当遇到两个前导下划线时,Python 的名称改编特性将发挥作用)。

特殊方法 :小写和两个前导下划线,两个后置下划线

这种风格只应用于特殊函数,比如操作符重载等。

函数参数 : 小写和下划线,缺省值等号两边无空格

3.类

类总是使用驼峰格式命名,即所有单词首字母大写其余字母小写。类名应该简明,精确,并足以从中理解类所完成的工作。常见的一个方法是使用表示其类型或者特性的后缀,例如:

SQLEngine,MimeTypes 对于基类而言,可以使用一个 Base 或者 Abstract 前缀 BaseCookie,AbstractGroup

4.模块和包

除特殊模块 init 之外,模块名称都使用不带下划线的小写字母。

若是它们实现一个协议,那么通常使用 lib 为后缀,例如:

import smtplib

import os

import sys

5.关于参数

5.1 不要用断言来实现静态类型检测。断言可以用于检查参数,但不应仅仅是进行静态类型检测。

Python 是动态类型语言,静态类型检测违背了其设计思想。断言应该用于避免函数不被毫无意义的调用。

5.2 不要滥用 *args 和 **kwargs。*args 和 **kwargs 参数可能会破坏函数的健壮性。它们使签名变得模糊,而且代码常常开始在不应该的地方构建小的参数解析器。

6.其他

6.1 使用 has 或 is 前缀命名布尔元素

is_connect = True

has_member = False

6.2 用复数形式命名序列

members = ['user_1', 'user_2']

6.3 用显式名称命名字典

person_address = {'user_1':'10 road WD', 'user_2' : '20 street huafu'}

6.4 避免通用名称

诸如 list, dict, sequence 或者 element 这样的名称应该避免。

6.5 避免现有名称

诸如 os, sys 这种系统已经存在的名称应该避免。

6.4 避免通用名称

诸如 list, dict, sequence 或者 element 这样的名称应该避免。

6.5 避免现有名称

诸如 os, sys 这种系统已经存在的名称应该避免。

6.3 用显式名称命名字典

person_address = {‘user_1’:‘10 road WD’, ‘user_2’ : ‘20 street huafu’}

6.4 避免通用名称

诸如 list, dict, sequence 或者 element 这样的名称应该避免。

6.5 避免现有名称

诸如 os, sys 这种系统已经存在的名称应该避免。

6.2 用复数形式命名序列

members = [‘user_1’, ‘user_2’]

6.3 用显式名称命名字典

person_address = {‘user_1’:‘10 road WD’, ‘user_2’ : ‘20 street huafu’}

6.4 避免通用名称

诸如 list, dict, sequence 或者 element 这样的名称应该避免。

6.5 避免现有名称

诸如 os, sys 这种系统已经存在的名称应该避免。

7.一些数字

一行列数 : PEP 8 规定为 79 列。根据自己的情况,比如不要超过满屏时编辑器的显示列数。

一个函数 : 不要超过 30 行代码, 即可显示在一个屏幕类,可以不使用垂直游标即可看到整个函数。

一个类 : 不要超过 200 行代码,不要有超过 10 个方法。一个模块 不要超过 500 行。

8.验证脚本

可以安装一个 pep8 脚本用于验证你的代码风格是否符合 PEP8。

40.Linux 的基本命令(怎么区分一个文件还是文件夹)?

ls -F 在显示名称的时候会在文件夹后添加“/”,在文件后面加“*”。

41.日志以什么格式,存放在哪里?

日志以文本可以存储在“/var/log/”目录下后缀名为.log。

42.Linux 查看某个服务的端口?

netstat -anp | grep service_name

43.ubuntu 系统如何设置开机自启动一个程序?

直接修改/etc/rc0.d ~ /etc/rc6.d 和/etc/rcS.d 文件夹的内容,添加需启动的程序,S 开头的表示启动,K 开头的表示不启动。

44.在 linux 中 find 和 grep 的区别

Linux 系统中 grep 命令是一种强大的文本搜索工具,它能使用正则表达式搜索文本,并把匹配的行打印出来。grep 全称是 Global Regular Expression Print,表示全局正则表达式版本,它的使用权限是所有用户。

linux 下的 find:

功能:在目录结构中搜索文件,并执行指定的操作。此命令提供了相当多的查找条件,功能很强大。

语法:find 起始目录寻找条件操作

说明:find 命令从指定的起始目录开始,递归地搜索其各个子目录,查找满足寻找条件的文件并对之采取相关的操作。

简单点说说,grep 是查找匹配条件的行,find 是搜索匹配条件的文件。

45.Linux 重定向命令有哪些?有什么区别?

1、重定向 ‘>’

Linux 允许将命令执行结果重定向到一个文件,本应显示在终端上的内容保存到指定文件中。如:ls >test.txt ( test.txt 如果不存在,则创建,存在则覆盖其内容 )。

2、重定向’>>’

'>>'这个是将输出内容追加到目标文件中。如果文件不存在,就创建文件;如果文件存在,则将新的内容追加到那个文件的末尾,该文件中的原有内容不受影响。

46.软连接和硬链接的区别?

软连接类似 Windows 的快捷方式,当删除源文件时,那么软链接也失效了。硬链接可以理解为源文件的一个别名,多个别名所代表的是同一个文件。当 rm 一个文件的时候,那么此文件的硬链接数减1,当硬链接数为 0 的时候,文件被删除。

47.10 个常用的 Linux 命令?

pwd #显示工作路径

ls #查看目录中的文件

cd /home #进入 '/ home' 目录'

cd .. #返回上一级目录

cd ../.. #返回上两级目录

mkdir dir1 #创建一个叫做 'dir1' 的目录'

rm -f file1 #删除一个叫做 'file1' 的文件',-f 参数,忽略不存在的文件,从不给出提示。

rmdir dir1 #删除一个叫做 'dir1' 的目录'

groupadd group_name 创建一个新用户组

groupdel group_name #删除一个用户组

tar -cvf archive.tar file1 #创建一个非压缩的 tarball

tar -cvf archive.tar file1 file2 dir1 #创建一个包含了 'file1', 'file2' 以及 'dir1'的档案文件

tar -tf archive.tar #显示一个包中的内容

tar -xvf archive.tar #释放一个包

tar -xvf archive.tar -C /tmp #将压缩包释放到 /tmp 目录下

tar -cvfj archive.tar.bz2 dir1 #创建一个 bzip2 格式的压缩包

tar -xvfj archive.tar.bz2 #解压一个 bzip2 格式的压缩包

tar -cvfz archive.tar.gz dir1 #创建一个 gzip 格式的压缩包

tar -xvfz archive.tar.gz #解压一个 gzip 格式的压缩包

48.Linux 关机命令有哪些?

reboot #重新启动操作系统

shutdown –r now #重新启动操作系统,shutdown 会给别的用户提示

shutdown -h now #立刻关机,其中 now 相当于时间为 0 的状态

shutdown -h 20:25 #系统在今天的 20:25 会关机

shutdown -h +10 #系统再过十分钟后自动关机

init 0 #关机

init 6 #重启

49.git 合并文件有冲突,如何处理?

1、git merge 冲突了,根据提示找到冲突的文件,解决冲突如果文件有冲突,那么会有类似的标记

2、修改完之后,执行 git add 冲突文件名

3、git commit 注意:没有-m 选项 进去类似于 vim 的操作界面,把 conflict 相关的行删除掉直接 push 就可以了,因为刚刚已经执行过相关 merge 操作了。

50.现有字典 d={‘a’:24,‘g’:52,‘i’:12,‘k’:33}请按字典中的 value值进行排序?

sorted(d.items(),key = lambda x:x[1])

51.说一下字典和 json 的区别?

json的key只能是字符串,python的dict可以是任何可hash对象。

json的key可以是有序、重复的,python的dict的key不可以重复。

json的key存在默认值undefined,dict没有默认值。

json的value只能是字符串、浮点数、布尔值或者null,或者它们构成的数组或者对象。

json访问方式可以是[],也可以是.,遍历方式分in、of,dict的value仅可以通过下标[]访问。

json的字符串强制双引号,dict字符串可以单引号、双引号。

json里只有数组,dict可以嵌套tuple。

json中的中文必须是unicode编码,如“你好”在json中应为"\u4f60\u597d"。

json的数据类型是字符串(str),字典的数据类型是字典(dict)。

json定义布尔值和空值:true、false、null。

python定义布尔值和空值:True、False、None。

52.什么是可变、不可变类型?元组里添加字典,会改变 id 吗?

可变不可变指的是内存中的值是否可以被改变,不可变类型指的是对象所在内存块里面的值不可以改变,有数值、字符串、元组;可变类型则是可以改变,主要有列表、字典。

元组的顶层元素中包含可变类型,在可变类型中修改或添加字典 id 不会改变

53.存入字典里的数据有没有先后排序?

存入的数据不会自动排序,可以使用 sort 函数对字典进行排序。

54.字典推导式

d = {key: value for (key, value) in iterable}

55.如何理解 Python 中字符串中的\字符?

有三种不同的含义:

1、转义字符

2、路径名中用来连接路径名

3、编写太长代码手动软换行。

56.反转字符串"aStr"?

print('aStr'[::-1])

57.将字符串"k:1|k1:2|k2:3|k3:4",处理成 Python 字典:{k:1, k1:2, … } # 字典里的 K 作为字符串处理

str1 = "k:1|k1:2|k2:3|k3:4"

def str2dict(str1):

dict1 = {}

for iterms in str1.split('|'):

key,value = iterms.split(':')

dict1[key] = value

return dict1

re = str2dict(str1)

print(re)

58.python中for循环原理?

for循环的工作原理:

1、执行in后对象的dic.__iter__()方法,得到一个迭代器对象iter_dic

2、执行next(iter_dic),将得到的值赋值给k,然后执行循环体代码

3、重复过程2,直到捕捉到异常StopIteration,结束循环

可以直接作用于for循环的数据类型有以下几种:

一类是集合数据类型,如list、tuple、dict、set、str等;

一类是生成器generator,包括生成器和带yield的generator function。

59.请按 alist 中元素的 age 由大到小排序

alist =[{'name':'a','age':20},{'name':'b','age':30},{'name':'c','age':25}]

def sort_by_age(list1):

return sorted(alist,key=lambda x:x['age'],reverse=True)

re = sort_by_age(alist)

print(re)

60.列表的常用操作

name_list = ["zhangsan", "lisi", "wangwu", "zhaoliu"]

1)增加

列表名.insert(index, 数据):在指定位置插入数据(位置前有空元素会补位)。

1.# 往列表 name_list 下标为 0 的地方插入数据

2.In [3]: name_list.insert(0, "Sasuke")

3.In [4]: name_list

4.Out[4]: ['Sasuke', 'zhangsan', 'lisi', 'wangwu', 'zhaoliu']

5.# 现有的列表下标是 0-4,如果我们要在下标是 6 的地方插入数据,那个会自动插入到下标为 5 的地方,也就是# 插入到最后

6.In [5]: name_list.insert(6, "Tom")

7.In [6]: name_list

8.Out[6]: ['Sasuke', 'zhangsan', 'lisi', 'wangwu', 'zhaoliu', 'Tom']

列表名.append(数据):在列表的末尾追加数据(最常用的方法)。

1.In [7]: name_list.append("Python")

2.In [8]: name_list

3.Out[8]: ['Sasuke', 'zhangsan', 'lisi', 'wangwu', 'zhaoliu', 'Tom', 'Python']

列表.extend(Iterable):将可迭代对象中的元素追加到列表。

1.# 有两个列表 a 和 b a.extend(b) 会将 b 中的元素追加到列表 a 中

2.In [10]: a = [11, 22, 33]

3.In [11]: b = [44, 55, 66]

4.In [12]: a.extend(b)

5.In [13]: a

6.Out[13]: [11, 22, 33, 44, 55, 66]# 有列表 c和 字符串 d c.extend(d)会将字符串 d 中的每个字符拆开作为元素插入到列表c

7.In [14]: c = ['j', 'a', 'v', 'a']

8.In [15]: d = "python"

9.In [16]: c.extend(d)

10.In [17]: c

11.Out[17]: ['j', 'a', 'v', 'a', 'p', 'y', 't', 'h', 'o', 'n']

2)取值和修改

取值:列表名[index] :根据下标来取值。

1.In [19]: name_list = ["zhangsan", "lisi", "wangwu", "zhaoliu"]

2.In [20]: name_list[0]

3.Out[20]: 'zhangsan'

4.In [21]: name_list[3]

5.Out[21]: 'zhaoliu'

修改:列表名[index] = 数据:修改指定索引的数据。

1.In [22]: name_list[0] = "Sasuke"

2.In [23]: name_list

3.Out[23]: ['Sasuke', 'lisi', 'wangwu', 'zhaoliu']

3)删除

del 列表名[index]:删除指定索引的数据。

1.In [25]: name_list = ["zhangsan", "lisi", "wangwu", "zhaoliu"]# 删除索引是 1 的数据

2.In [26]: del name_list[1]

3.In [27]: name_list

4.Out[27]: ['zhangsan', 'wangwu', 'zhaoliu']

列表名.remove(数据):删除第一个出现的指定数据。

5.In [30]: name_list = ["zhangsan", "lisi", "wangwu", "zhaoliu", "lisi"]# 删除 第一次出现的 lisi 的数据

6.In [31]: name_list.remove("lisi")

7.In [32]: name_list

8.Out[32]: ['zhangsan', 'wangwu', 'zhaoliu', 'lisi']

列表名.pop():删除末尾的数据,返回值: 返回被删除的元素。

9.In [33]: name_list = ["zhangsan", "lisi", "wangwu", "zhaoliu"]# 删除最后一个元素 zhaoliu 并将元素 zhaoliu 返回

10.In [34]: name_list.pop()

11.Out[34]: 'zhaoliu'

12.In [35]: name_list

13.Out[35]: ['zhangsan', 'lisi', 'wangwu']

列表名.pop(index):删除指定索引的数据,返回被删除的元素。

14.In [36]: name_list = ["zhangsan", "lisi", "wangwu", "zhaoliu"]# 删除索引为 1 的数据 lisi

15.In [37]: name_list.pop(1)

16.Out[37]: 'lisi'

17.In [38]: name_list

18.Out[38]: ['zhangsan', 'wangwu', 'zhaoliu']

列表名.clear():清空整个列表的元素。

19.In [40]: name_list = ["zhangsan", "lisi", "wangwu", "zhaoliu"]

20.In [41]: name_list.clear()

21.In [42]: name_list

22.Out[42]: []

4)排序

列表名.sort():升序排序 从小到大。

23.In [43]: a = [33, 44, 22, 66, 11]

24.In [44]: a.sort()

25.In [45]: a

26.Out[45]: [11, 22, 33, 44, 66]

列表名.sort(reverse=True):降序排序 从大到小。

27.In [46]: a = [33, 44, 22, 66, 11]

28.In [47]: a.sort(reverse=True)

29.In [48]: a

30.Out[48]: [66, 44, 33, 22, 11]

列表名.reverse():列表逆序、反转。

31.In [50]: a = [11, 22, 33, 44, 55]

32.In [51]: a.reverse()

33.In [52]: a

34.Out[52]: [55, 44, 33, 22, 11]

5)统计相关

len(列表名):得到列表的长度。

35.In [53]: a = [11, 22, 33, 44, 55]

36.In [54]: len(a)

37.Out[54]: 5

列表名.count(数据):数据在列表中出现的次数。

38.In [56]: a = [11, 22, 11, 33, 11]

39.In [57]: a.count(11)

40.Out[57]: 3

列表名.index(数据):数据在列表中首次出现时的索引,没有查到会报错。

41.In [59]: a = [11, 22, 33, 44, 22]

42.In [60]: a.index(22)

43.Out[60]: 1

if 数据 in 列表: 判断列表中是否包含某元素。

44.a = [11, 22, 33, 44 ,55]

45.if 33 in a:

46. print("找到了....")

6)循环遍历

使用 while 循环:

a = [11, 22, 33, 44, 55]

i = 0

while i < len(a):

print(a[i])

i += 1

使用 for 循环:

a = [11, 22, 33, 44, 55]

for i in a:

print(i)

61.下面代码的输出结果将是什么?

list = ['a', 'b', 'c', 'd', 'e']

print (list[10:]) #[]

print(list[10]) #IndexError: list index out of range

62.写一个列表生成式,产生一个公差为 11 的等差数列?

print([x*11 for x in range(10)])

63.给定两个列表,怎么找出他们相同的元素和不同的元素?

1. list1 = [1,2,3]

2. list2 = [3,4,5]

3. set1 = set(list1)

4. set2 = set(list2)

5. print(set1&set2)

6. print(set1^set2)

64.请写出一段 Python 代码实现删除一个 list 里面的重复元素?

比较容易记忆的是用内置的 set:

l1 = ['b','c','d','b','c','a','a']

l2 = list(set(l1))

print(l2)

如果想要保持他们原来的排序:

用 list 类的 sort 方法:

l1 = ['b','c','d','b','c','a','a']

l2 = list(set(l1))

l2.sort(key=l1.index)

print (l2)

也可以这样写:

l1 = ['b','c','d','b','c','a','a']

l2 = sorted(set(l1),key=l1.index)

print (l2)

也可以用遍历:

l1 = ['b', 'c', 'd', 'b', 'c', 'a', 'a']

l2 = []

for i in l1:

if not i in l2:

l2.append(i)

print (l2)

65.有如下数组 list = range(10)我想取以下几个数组,应该如何切片?

1. [1,2,3,4,5,6,7,8,9]

2. [1,2,3,4,5,6]

3. [3,4,5,6]

4. [9]

5. [1,3,5,7,9]

1. [1:]

2. [1:7]

3. [3:7]

4. [-1]

5. [1::2]

66.下面这段代码的输出结果是什么?请解释?

def extendList(val, list=[]):

list.append(val)

return list

list1 = extendList(10) #原列表为空,变为【10】

print("list1 = %s" % list1) # list1 = [10]

list2 = extendList(123,[]) #创建新列表,新的列表为【123】

print("list2 = %s" % list2) # list2 = [123]

list3 = extendList('a') #在列表【10】中加入【‘a']

print("list3 = %s" % list3) # list3 = [10, 'a']

print("list1 = %s" % list1 ,id(list1)) # list1 = [10, 'a']

print("list2 = %s" % list2 ,id(list1)) # list2 = [123]

print("list3 = %s" % list3 ,id(list1)) # list3 = [10, 'a']

新的默认列表只在函数被定义的那一刻创建一次。当 extendList 被没有指定特定参数 list 调用时,这组 list 的值随后将被使用。这是因为带有默认参数的表达式在函数被定义的时候被计算,不是在调用的时候被计算.

67.将以下 3 个函数按照执行效率高低排序

def f1(lIn):

l1 = sorted(lIn)

l2 = [i for i in l1 if i<0.5]

return [i*i for i in l2]

def f2(lIn):

l1 = [i for i in l1 if i<0.5]

l2 = sorted(l1)

return [i*i for i in l2]

def f3(lIn):

l1 = [i*i for i in lIn]

l2 = sorted(l1)

return [i for i in l1 if i<(0.5*0.5)]

按执行效率从高到低排列:f2、f1 和 f3。要证明这个答案是正确的,你应该知道如何分析自己代码的性能。Python

中有一个很好的程序分析包,可以满足这个需求。

import random

import cProfile

lIn = [random.random() for i in range(100000)]

cProfile.run('f1(lIn)')

cProfile.run('f2(lIn)')

cProfile.run('f3(lIn)')

68.获取 1~100 被 6 整除的偶数?

def A():

alist = []

for i in range(1,100):

if i % 6 == 0:

alist.append(i)

print(alist)

A()

69.集合常用操作

快速去除列表中的重复元素

1.In [4]: a = [11,22,33,33,44,22,55]

3.In [5]: set(a)

4.Out[5]: {11, 22, 33, 44, 55}

交集:共有的部分

1.In [7]: a = {11,22,33,44,55}

2.In [8]: b = {22,44,55,66,77}

3.In [9]: a&b

4.Out[9]: {22, 44, 55}

并集:总共的部分

1.In [11]: a = {11,22,33,44,55}

2.In [12]: b = {22,44,55,66,77}

3.In [13]: a | b

4.Out[13]: {11, 22, 33, 44, 55, 66, 77}

差集:另一个集合中没有的部分

1.In [15]: a = {11,22,33,44,55}

2.In [16]: b = {22,44,55,66,77}

3.In [17]: b - a

4.Out[17]: {66, 77}

对称差集(在 a 或 b 中,但不会同时出现在二者中)

1.In [19]: a = {11,22,33,44,55}

2.In [20]: b = {22,44,55,66,77}

3.In [21]: a ^ b

4.Out[21]: {11, 33, 66, 77}

70.简述内键函数Map reduce filter 区别

从参数方面来讲:

map()包含两个参数,第一个是参数是一个函数,第二个是序列(列表或元组)。其中,函数(即 map 的第一个参数位置的函数)可以接收一个或多个参数。

reduce() 第一个参数是函数,第二个是 序列(列表或元组)。但是,其函数必须接收两个参数。

从对传进去的数值作用来讲:

map()是将传入的函数依次作用到序列的每个元素,每个元素都是独自被函数“作用”一次;(请看下面的例子)

reduce()是将传人的函数作用在序列的第一个元素得到结果后,把这个结果继续与下一个元素作用(累积计算)。

map() 会根据提供的函数对指定序列做映射。

第一个参数 function 以参数序列中的每一个元素调用 function 函数,返回包含每次 function 函数返回值的新列表。

filter() 函数用于过滤序列,过滤掉不符合条件的元素,返回由符合条件元素组成的新列表。该接收两个参数,第一个为函数,第二个为序列,序列的每个元素作为参数传递给函数进行判,然后返回 True 或 False,最后将返回 True 的元素放到新列表中。

reduce()函数

reduce 函数可以按照给定的方法把输入参数中上序列缩减为单个的值,具体的做法如下:首先从序列中去除头两个元素并把它传递到那个二元函数中去,求出一个值,再把这个加到序列中循环求下一个值,直到最后一个值 。

71.python 的魔法方法

魔法方法是指Python内部已经包含的,被双下划线所包围的方法,这些方法在进行特定的操作时会自动被调用,它们是Python面向对象下智慧的结晶。使用Python的魔法方法可以使Python的自由度变得更高,当不需要重写时魔法方法也可以在规定的默认情况下生效,在需要重写时也可以让使用者根据自己的需求来重写部分方法来达到自己的期待。而且众所周知Python是支持面向对象的语言Python的基本魔法方法就使得Python在面对对象方面做得更好。

魔法方法就是可以给你的类增加魔力的特殊方法,如果你的对象实现(重载)了这些方法中的某一个,那么这个方法就会在特殊的情况下被 Python 所调用,你可以定义自己想要的行为,而这一切都是自动发生的。它们经常是两个下划线包围来命名的(比如 init,lt),Python 的魔法方法是非常强大的,所以了解其使用方法也变得尤为重要!

init 构造器,当一个实例被创建的时候初始化的方法。但是它并不是实例化调用的第一个方法。

__ new__才是实例化对象调用的第一个方法,它只取下 cls 参数,并把其他参数传给 init。 __new__很少使用,但是也有它适合的场景,尤其是当类继承自一个像元组或者字符串这样不经常改变的类型的时候。

call 允许一个类的实例像函数一样被调用

getitem 定义获取容器中指定元素的行为,相当于 self[key]

getattr 定义当用户试图访问一个不存在属性的时候的行为

setattr 定义当一个属性被设置的时候的行为

getattribute 定义当一个属性被访问的时候的行为

- 基础魔方方法:

| 魔法名 | 说明 |

|---|---|

| new(cls[, …]) | 1. new 是在一个对象实例化的时候所调用的第一个方法 2. 它的第一个参数是这个类,其他的参数是用来直接传递给 init 方法 3. new 决定是否要使用该 init 方法,因为 new 可以调用其他类的构造方法或者直接返回别的实例对象来作为本类的实例,如果 new 没有返回实例对象,则 init 不会被调用 4. new 主要是用于继承一个不可变的类型比如一个 tuple 或者 string |

| init(self[, …]) | 构造方法,初始化类的时候被调用 |

| del(self) | 析构方法,当实例化对象被彻底销毁时被调用(实例化对象的所有指针都被销毁时被调用) |

| call(self[, args…]) | 允许一个类的实例像函数一样被调用:x(a, b) 调用 x.call(a, b) |

| len(self) | 定义当被 len() 调用时的行为 |

| repr(self) | 定义当被 repr() 调用时的行为 |

| str(self) | 定义当被 str() 调用时的行为 |

| bytes(self) | 定义当被 bytes() 调用时的行为 |

| hash(self) | 定义当被 hash() 调用时的行为 |

| bool(self) | 定义当被 bool() 调用时的行为,应该返回 True 或 False |

| format(self, format_spec) | 定义当被 format() 调用时的行为 |

- 属性相关的方法

| 魔法名 | 说明 |

|---|---|

| getattr(self, name) | 定义当用户试图获取一个不存在的属性时的行为 |

| getattribute(self, name) | 定义当该类的属性被访问时的行为 |

| setattr(self, name, value) | 定义当一个属性被设置时的行为 |

| delattr(self, name) | 定义当一个属性被删除时的行为 |

| dir(self) | 定义当 dir() 被调用时的行为 |

| get(self, instance, owner) | 定义当描述符的值被取得时的行为 |

| set(self, instance, value) | 定义当描述符的值被改变时的行为 |

| delete(self, instance) | 定义当描述符的值被删除时的行为 |

- 比较操作符

| 魔法名 | 说明 |

|---|---|

| lt(self, other) | 定义小于号的行为:x < y 调用 x.lt(y) |

| le(self, other) | 定义小于等于号的行为:x <= y 调用 x.le(y) |

| eq(self, other) | 定义等于号的行为:x == y 调用 x.eq(y) |

| ne(self, other) | 定义不等号的行为:x != y 调用 x.ne(y) |

| gt(self, other) | 定义大于号的行为:x > y 调用 x.gt(y) |

| ge(self, other) | 定义大于等于号的行为:x >= y 调用 x.ge(y) |

- 算术运算符

| 魔方名 | 说明 |

|---|---|

| add(self, other) | 定义加法的行为:+ |

| sub(self, other) | 定义减法的行为:- |

| mul(self, other) | 定义乘法的行为:* |

| truediv(self, other) | 定义真除法的行为:/ |

| floordiv(self, other) | 定义整数除法的行为:// |

| mod(self, other) | 定义取模算法的行为:% |

| divmod(self, other) | 定义当被 divmod()调用时的行为 |

| pow(self, other[, modulo]) | 定义当被 power() 调用或 ** 运算时的行为 |

| lshift(self, other) | 定义按位左移位的行为:<< |

| rshift(self, other) | 定义按位右移位的行为:>> |

| and(self, other) | 定义按位与操作的行为:& |

| xor(self, other) | 定义按位异或操作的行为:^ |

| or(self, other) | 定义按位或操作的行为:| |

- 反运算(类似于运算方法)

| 魔法名 | 说明 |

|---|---|

| radd(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rsub(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rmul(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rtruediv(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rfloordiv(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rmod(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rdivmod(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rpow(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rlshift(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rrshift(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| rxor(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

| ror(self, other) | 当被运算对象(左边的操作对象)不支持该运算时被调用 |

- 增量赋值运算

| 魔方名 | 说明 |

|---|---|

| iadd(self, other) | 定义赋值加法的行为:+= |

| isub(self, other) | 定义赋值减法的行为:-= |

| imul(self, other) | 定义赋值乘法的行为:*= |

| itruediv(self, other) | 定义赋值真除法的行为:/= |

| ifloordiv(self, other) | 定义赋值整数除法的行为://= |

| imod(self, other) | 定义赋值取模算法的行为:%= |

| ipow(self, other[, modulo]) | 定义赋值幂运算的行为:**= |

| ilshift(self, other) | 定义赋值按位左移位的行为:<<= |

| irshift(self, other) | 定义赋值按位右移位的行为:>>= |

| iand(self, other) | 定义赋值按位与操作的行为:&= |

| ixor(self, other) | 定义赋值按位异或操作的行为:^= |

| ior(self, other) | 定义赋值按位或操作的行为:|= |

- 一元操作符

| 魔方名 | 说明 |

|---|---|

| neg(self) | 定义正号的行为:+x |

| pos(self) | 定义负号的行为:-x |

| abs(self) | 定义当被 abs() 调用时的行为 |

| invert(self) | 定义按位求反的行为:~x |

- 类型转换

| 魔方名 | 说明 |

|---|---|

| complex(self) | 定义当被 complex() 调用时的行为(需要返回恰当的值) |

| int(self) | 定义当被 int() 调用时的行为(需要返回恰当的值) |

| float(self) | 定义当被 float() 调用时的行为(需要返回恰当的值) |

| round(self[, n]) | 定义当被 round() 调用时的行为(需要返回恰当的值) |

| index(self) | 1. 当对象是被应用在切片表达式中时,实现整形强制转换2. 如果你定义了一个可能在切片时用到的定制的数值型,你应该定义 __index__3. 如果 index 被定义,则 int 也需要被定义,且返回相同的值 |

- 上下文管理(with 语句)

| 魔方名 | 说明 |

|---|---|

| enter(self) | 1. 定义当使用 with 语句时的初始化行为2. enter 的返回值被 with 语句的目标或者 as 后的名字绑定 |

| exit(self, exc_type, exc_value, traceback) | 1. 定义当一个代码块被执行或者终止后上下文管理器应该做什么2. 一般被用来处理异常,清除工作或者做一些代码块执行完毕之后的日常工作 |

10)容器类型(一般用于操作容器类)

| 魔方名 | 说明 |

|---|---|

| len(self) | 定义当被 len() 调用时的行为(一般返回容器类的长度) |

| getitem(self, key) | 定义获取容器中指定元素的行为,相当于 self[key] |

| setitem(self, key, value) | 定义设置容器中指定元素的行为,相当于 self[key] = value |

| delitem(self, key) | 定义删除容器中指定元素的行为,相当于 del self[key] |

| iter(self) | 定义当迭代容器中的元素的行为 |

| reversed(self) | 定义当被 reversed() 调用时的行为 |

| contains(self, item) | 定义当使用成员测试运算符(in 或 not in)时的行为 |

72.求输出结果

def multipliers():

return [lambda x : i * x for i in range(4)]

print ([m(2) for m in multipliers()])

#[6, 6, 6, 6]

上面代码输出的结果是[6, 6, 6, 6] (不是我们想的[0, 2, 4, 6])。

你如何修改上面的 multipliers 的定义产生想要的结果?

上述问题产生的原因是 Python 闭包的延迟绑定。这意味着内部函数被调用时,参数的值在闭包内进行查找。因此,当任何由 multipliers()返回的函数被调用时,i 的值将在附近的范围进行查找。那时,不管返回的函数是否被调用,for 循环已经完成,i 被赋予了最终的值 3。

因此,每次返回的函数乘以传递过来的值 3,因为上段代码传过来的值是 2,它们最终返回的都是 6。(3*2)碰巧的是,《The Hitchhiker’s Guide to Python》也指出,在与 lambdas 函数相关也有一个被广泛被误解的知识点,不过跟这个 case 不一样。由 lambda 表达式创造的函数没有什么特殊的地方,它其实是和 def 创造的函数式一样的。

下面是解决这一问题的一些方法。

一种解决方法就是用 Python 生成器。

def multipliers():

for i in range(4): yield lambda x : i * x

另外一个解决方案就是创造一个闭包,利用默认函数立即绑定。

def multipliers():

return [lambda x, i=i : i * x for i in range(4)]

73.对缺省参数的理解?

缺省参数指在调用函数的时候没有传入参数的情况下,调用默认的参数,在调用函数的同时赋值时,所传入的参数会替代默认参数.

*args 是不定长参数,他可以表示输入参数是不确定的,可以是任意多个。

**kwargs 是关键字参数,赋值的时候是以键 = 值的方式,参数是可以任意多对在定义函数的时候不确定会有多少参数会传入时,就可以使用两个参数。

74.对装饰器的理解,并写出一个计时器记录方法执行性能的装饰器?

装饰器本质上是一个 Python 函数,它可以让其他函数在不需要做任何代码变动的前提下增加额外功能,装饰器的返回值也是一个函数对象.

import time

def timeit(func):

def wrapper():

start = time.clock()

func()

end =time.clock()

print('used:', end - start)

return wrapper

@timeit

def foo():

print('in foo()'foo())

75.什么是线程安全,什么是互斥锁?

每个对象都对应于一个可称为" 互斥锁" 的标记,这个标记用来保证在任一时刻,只能有一个线程访问该对象。

同一个进程中的多线程之间是共享系统资源的,多个线程同时对一个对象进行操作,一个线程操作尚未结束,另一个线程已经对其进行操作,导致最终结果出现错误,此时需要对被操作对象添加互斥锁,保证每个线程对该对象

的操作都得到正确的结果.

76.什么单例模式,其应用场景都有哪些?

确保某一个类只有一个实例,而且自行实例化并向整个系统提供这个实例,这个类称为单例类,单例模式是一种对象创建型模式。

Windows 的 Task Manager(任务管理器)、Recycle Bin(回收站)、网站计数器

单例模式应用的场景一般发现在以下条件下:

(1)资源共享的情况下,避免由于资源操作时导致的性能或损耗等。如上述中的日志文件,应用配置。

(2)控制资源的情况下,方便资源之间的互相通信。如线程池等。

1.网站的计数器 2.应用配置 3.多线程池 4.数据库配置,数据库连接池 5.应用程序的日志应用…

77.递归函数停止的条件?

递归的终止条件一般定义在递归函数内部,在递归调用前要做一个条件判断,根据判断的结果选择是继续调用自身,还是 return;返回终止递归。

终止的条件:

1.判断递归的次数是否达到某一限定值

2.判断运算的结果是否达到某个范围等,根据设计的目的来选择

78.python 的内存管理机制及调优手段?

内存管理机制:引用计数、垃圾回收、内存池

引用计数

引用计数是一种非常高效的内存管理手段, 当一个 Python 对象被引用时其引用计数增加 1, 当其不再被一个变量引用时则计数减 1. 当引用计数等于 0 时对象被删除.

垃圾回收

1.引用计数

引用计数也是一种垃圾收集机制,而且也是一种最直观,最简单的垃圾收集技术。当 Python 的某个对象的引用计数降为 0 时,说明没有任何引用指向该对象,该对象就成为要被回收的垃圾了。比如某个新建对象,它被分配给某个引用,对象的引用计数变为 1。如果引用被删除,对象的引用计数为 0,那么该对象就可以被垃圾回收。不过如果出现循环引用的话,引用计数机制就不再起有效的作用了

2.标记清除

如果两个对象的引用计数都为 1,但是仅仅存在他们之间的循环引用,那么这两个对象都是需要被回收的,也就是说,它们的引用计数虽然表现为非 0,但实际上有效的引用计数为 0。所以先将循环引用摘掉,就会得出这两个对象的有效计数。

3.分代回收

从前面“标记-清除”这样的垃圾收集机制来看,这种垃圾收集机制所带来的额外操作实际上与系统中总的内存块的数量是相关的,当需要回收的内存块越多时,垃圾检测带来的额外操作就越多,而垃圾回收带来的额外操作

就越少;反之,当需回收的内存块越少时,垃圾检测就将比垃圾回收带来更少的额外操作。

举个例子:

4当某些内存块 M 经过了 3 次垃圾收集的清洗之后还存活时,我们就将内存块 M 划到一个集合 A 中去,而新分配的内存都划分到集合 B 中去。当垃圾收集开始工作时,大多数情况都只对集合 B 进行垃圾回收,而对集合 A 进行垃圾回收要隔相当长一段时间后才进行,这就使得垃圾收集机制需要处理的内存少了,效率自然就提高了。在这个过程中,集合 B 中的某些内存块由于存活时间长而会被转移到集合 A 中,当然,集合 A 中实际上也存在一些垃圾,这些垃圾的回收会因为这种分代的机制而被延迟。

内存池

1.Python 的内存机制呈现金字塔形状,-1,-2 层主要有操作系统进行操作;

2.第 0 层是 C 中的 malloc,free 等内存分配和释放函数进行操作;

3.第 1 层和第 2 层是内存池,有 Python 的接口函数 PyMem_Malloc 函数实现,当对象小于 256K 时有该层直接分配内存;

4.第 3 层是最上层,也就是我们对 Python 对象的直接操作;Python 在运行期间会大量地执行 malloc 和 free 的操作,频繁地在用户态和核心态之间进行切换,这将严重影响 Python 的执行效率。为了加速Python 的执行率,Python 引入了一个内存池机制,用于管理对小块内存的申请和释放。

Python 内部默认的小块内存与大块内存的分界点定在 256 个字节,当申请的内存小于 256 字时,PyObject_Malloc 会在内存池中申请内存;当申请的内存大于 256 字节时,PyObject_Malloc 的行为将蜕化为 malloc 的行为。当然,通过修改 Python 源代码,我们可以改变这个默认值,从而改变 Python的默认内存管理行为。

调优手段(了解)

1.手动垃圾回收

2.调高垃圾回收阈值

3.避免循环引用(手动解循环引用和使用弱引用)

79.用自己的话说明迭代器和生成器,它们之间的关系?

迭代指的是一个重复的过程,每一次重复称为一次迭代,迭代器对象从集合的第一个元素开始访问,直到所有的元素被访问完结束。并且每一次重复的结果是下一次重复的初始值,迭代器只能往前不会后退,迭代器是一个可以记住遍历的位置的对象.

在 Python 中,一边循环一边计算的机制,称为生成器:generator,生成器是可以迭代对象,但是生成器可以通过 send 传值返回到前面;只要在函数体内出现yield关键字,那么执行函数就不会执行函数代码,会得到一个结果,该结果就是生成器.

迭代器是一个更抽象的概念,任何对象,如果它的类有 next 方法和 iter 方法返回自己本身,对于 string、list、dict、tuple 等这类容器对象,使用 for 循环遍历是很方便的。在后台 for 语句对容器对象调用 iter()函数,iter()是 python 的内置函数。iter()会返回一个定义了 next()方法的迭代器对象,它在容器中逐个访问容器内元素,next()也是 python 的内置函数。在没有后续元素时,next()会抛出一个 StopIteration 异常。

生成器(Generator)是创建迭代器的简单而强大的工具。它们写起来就像是正规的函数,只是在需要返回数据的时候使用 yield 语句。每次 next()被调用时,生成器会返回它脱离的位置(它记忆语句最后一次执行的位置和所有的数据值)

区别:生成器能做到迭代器能做的所有事,而且因为自动创建了 iter()和 next()方法,生成器显得特别简洁,而且生成器也是高效的,使用生成器表达式取代列表解析可以同时节省内存。除了创建和保存程序状态的自动方法,当发生器终结时,还会自动抛出 StopIteration 异常。

迭代器是一个带状态的对象,它能在你调用next()方法的时候返回容器中的下一个值,任何实现了inter和next()(Python2中实现next())方法的对象都是迭代器,iter返回迭代器自身,next返回容器的下一个值,如果容器中没有更多的元素了,则抛出Stopiteration异常,至于它们到底是如何实现的并不重要。正是因为他是通过next()来返回迭代器中的元素,所以它是一种延迟计算方式返回对象,这种特点对于大数据量元素进行遍历时具有明显优势,他不会一次性把所有元素载入内存,而是遍历一个载入一个,大大降低了内存的占用。

生成器,简单来说就是使用了yield关键字的函数,都叫做生成器。例如:

def func():

yield

f = func()

type(f)

<type 'generator'>

yield的作用是发起当前执行的函数,并返回,直到调用next(),继续执行后续指令,直到再次遇到yield或者抛出StopIteration异常。上面的例子第一次运行生成器f,需要首先调用f.next()启动生成器。

生成器的优点:代码实现更加简洁,可以提高代码的可读性。同时当然也具有迭代器的优点,大量数据遍历时内存占用少。

需要注意的是:生成器一定是迭代器,但是迭代器不一定是生成器,因为创建一个迭代器只需要实现iter和next()方法就可以了,并不一定要使用yield实现。生成器的唯一注意事项就是:生成器只能遍历一次。

80.对不定长参数的理解?

不定长参数有两种:*args 和kwargs;

*args:是不定长参数,用来将参数打包成 tuple 给函数体调用

kwargs:是关键字参数,打包关键字参数成 dict 给函数体调用在定义函数的时候不确定要传入的参数个数会有多少个的时候就可以使用不定长参数作为形参

如果我们不确定要往函数中传入多少个参数,或者我们想往函数中以列表和元组 的形式传参数时,那就使要用*args;

如果我们不知道要往函数中传入多少个关键词参数,或者想传入字典的值作为关 键词参数时,那就要使用**kwargs。

args和kwargs这两个标识符是约定俗成的用法,你当然还可以用*bob和**billy, 但是这样就并不太妥。

81.什么是lambda函数?它有什么好处?

概念:lambda函数是一个可以接收任意多个参数(包括可选参数)并且返回单个表达式值的函数。

好处:

1)使用Python写一些执行脚本时,使用lambda可以省去定义函数的过程,让代码更加精简。

2)对于一些抽象的,不会别的地方再复用的函数,有时候给函数起个名字也是个难题,使用lambda不需要考虑命名的问题。

3)使用lambda在某些时候让代码更容易理解。

语法说明:

1).lambda 只是一个表达式 ,它用来创建一个函数对象

2).当lambda表达式执行时,返回的是冒号(:)后 的表达式的值

3).lambda表达式创建的函数只能包含一条语句

4).lambda比函数简单,且可以随时创建和销毁,有利于减少程序的偶合度

82.解释一下什么是闭包

在函数内部再定义一个函数,并且这个函数用到了外边函数的变量,那么将这个函数以及用到的一些变量称之为闭包

83.解释一下什么是锁,有哪几种锁?

锁(Lock)是 python 提供的对线程控制的对象

有互斥锁、可重入锁、死锁

84.什么是死锁以及怎么解决?

死锁:在线程间共享多个资源的时候,如果两个线程分别占有一部分资源并且同时等待对方的资源,就会造成死锁

给互斥锁添加超时时间

程序设计时要尽量避免(银行家算法)

85.什么是僵尸进程和孤儿进程,怎么避免僵尸进程?

孤儿进程:父进程退出,子进程还在运行的这些子进程都是孤儿进程,孤儿进程将被 init 进程(进程号为 1)所收养,并由 init 进程对它们完成状态收集工作

僵尸进程:进程使用 fork 创建子进程,如果子进程退出,而父进程并没有调用 wait 或 waitpid 获取子进程的状态信息,那么子进程的进程描述符仍然保存在系统中的这些进程是僵尸进程

避免僵尸进程的方法:

1.fork 两次用孙子进程去完成子进程的任务

2.用 wait()函数使父进程阻塞

3.使用信号量,在 signal handler 中调用 waitpid,这样父进程不用阻塞

86.python 中的进程与线程的使用场景?

多进程适合在 CPU 密集型操作(cpu 操作指令比较多,如位数多的浮点运算)

多线程适合在 IO 密集型操作(读写数据操作较多的,比如爬虫)

87.回调函数,如何通信的?

回调函数是把函数的指针(地址)作为参数传递给另一个函数,将整个函数当作一个对象,赋值给调用的函数

88.浮点数如何进行比较大小?

浮点数的表示是不精确的,不能直接比较两个数是否完全相等,一般都是在允许的某个范围内认为像个浮点数相等,如有两个浮点数 a,b,允许的误差范 围为 1e-6,则 abs(a-b)<=1e-6,即可认为 a 和 b 相等

python3.5 的 math 模块新增一个 isclose 函数用来判断两个浮点数的值是否接近或相等

import math

print(math.isclose(1.25,1.25))# 返回一个布尔值 True

print(math.isclose(2.1,2.2,rel_tol=0.1))

参数:

a,b:两个需要比较的浮点数;

rel_tol: 相对于输入值的大小,被认为是“接近”的最大差异;

abs_tol: 无论输入值的大小,被认为“接近”的最大差异

89.线程是并发还是并行,进程是并发还是并行?

线程是并发,进程是并行;进程之间相互独立,是系统分配资源的最小单位,同一个线程中的所有线程共享资源

90.解释一下 Python 中的 and-or 语法?

逻辑运算 and-or,在计算机运算中的短路规则(以尽量少运算,得出正确结果)可以提高计算效率,

在 result = a and b 运算中:

当 a 为假时,无论 b 为真或假,结果都为假,此时 b 的运算就不会进行,结果直接为 a 即可;

当 a 为真时,结果还得看 b,b 为真则真,b 为假则假,此时结果即为 b;

在 result = a or b 运算中:

如果 a 为真则无论 b 为什么结果都会是真,结果即为 b

如果 a 为假则看 b 的情况了,b 为真则结果为真,b 为假则结果为假,即结果为 b

91.Python 中类方法、类实例方法、静态方法有何区别?

一、先是在语法上面的区别:

1).静态方法不需要传入self参数,类成员方法需要传入代表本类的cls参数;

2).静态方法是无妨访问实例变量和类变量的,类成员方法无法访问实例变量但是可以访问类变量

类方法:是类对象的方法,在定义时需要在上方使用“@classmethod”进行装饰,形参为 cls,表示类对象,类对象和实例对象都可调用;

类实例方法:是类实例化对象的方法,只有实例对象可以调用,形参为self,指代对象本身;

静态方法:是一个任意函数,在其上方使用“@staticmethod”进行装饰,可以用对象直接调用,静态方法实际上跟该类没有太大关系

二、使用的区别:

由于静态方法无法访问类属性,实例属性,相当于一个相对独立的方法,跟类其实并没有什么关系。这样说来,静态方法就是在类的作用域里的函数而已。

92.Python 中 pass 语句的作用是什么

在编写代码时只写框架思路,具体实现还未编写就可以用 pass 进行占位,使程序不报错,不会进行任何操作

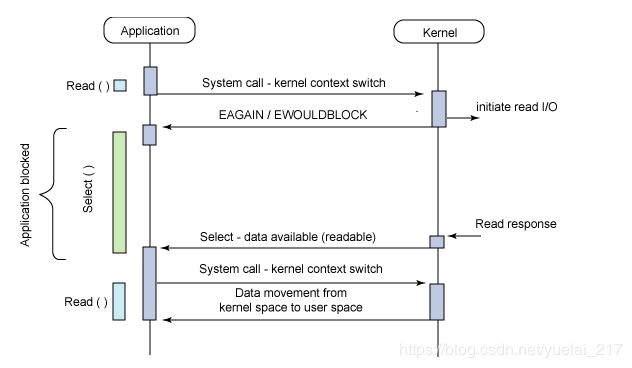

93.谈谈你对同步、异步、阻塞、非阻塞的理解

在计算机领域,同步就是指一个进程在执行某个请求的时候,若该请求需要一段时间才能返回信息,那么这个进程就会一直等待下去,直到收到返回信息才继续执行下去,异步是值进程不需要一直等下去,而继续执行下面的操作,不管其他进程的状态。当有消息返回时系统会通知进程进行处理,这样可以提高执的效率。举个例子,打电话时就是同步通信,发短息时就是异步通信。

阻塞调用是指调用结果返回之前,当前线程会被挂起。函数只有在得到结果之后才会返回。有人也许会把阻塞调用和同步调用等同起来,实际上他是不同的。对于同步调用来说,很多时候当前线程还是激活的,只是从逻辑上当前函数没有返回而已。例如,我们在 CSocket 中调用 Receive 函数,如果缓冲区中没有数据,这个函数就会一直等待,直到有数据才返回。而此时,当前线程还会继续处理各种各样的消息。如果主窗口和调用函数在同一个线程中,除非你在特殊的界面操作函数中调用,其实主界面还是应该可以刷新。socket 接收数据的另外一个函数 recv 则是一个阻塞调用的例子。当 socket工作在阻塞模式的时候,如果没有数据的情况下调用该函数,则当前线程就会被挂起,直到有数据为止。

非阻塞和阻塞的概念相对应,指在不能立刻得到结果之前,该函数不会阻塞当前线程,而会立刻返回。

94.介绍一下 Python 下 range()和 xrange()函数的用法?

range(start,stop,step)函数按照从 start 到 stop 每个 step 生成一个数值,生成的是列表对象,一次性将所有数据都返回;

xrange(start,stop,step)函数按照从 start 到 stop 每个 step 生成一个数值,返回的是可迭代对象,每次调用返回其中的一个值

95.用 Python 匹配 HTML tag 的时候,<.>和<.?>有什么区别?

<.>是贪婪匹配,会从第一个“<”开始匹配,直到最后一个“>”中间所有的字符都会匹配到,中间可能会包含“<>”

<.*?>是非贪婪匹配,从第一个“<”开始往后,遇到第一个“>”结束匹配,这中间的字符串都会匹配到,但是不会有“<>”

96.如何用 Python 来进行查询和替换一个文本字符串?

使用正则表达式

re.findall(r'目的字符串','原有字符串') #查询

re.findall(r'cast','itcast.cn')[0]

re.sub(r'要替换原字符','要替换新字符','原始字符串')

re.sub(r'cast','heima','itcast.cn')

97.说明一下 os.path 和 sys.path 分别代表什么?

os.path 主要是用于用户对系统路径文件的操作

sys.path 主要用户对 python 解释器的系统环境参数的操作

98.请尝试用“一行代码”实现将 1-N 的整数列表以 3 为单位分组,比如 1-100 分组后为?

print([[x for x in range(1,100)][i:i+3] for i in range(0,len(list_a),3)])

99.已知路径 path,写一个函数并以前向遍历的方式打印目录中的所有文件?

(可使用 os.listdir,os.path.isdir,os.path.join 和递归的方式来实现),比如如下的一个文件树结构:

root

|————a.file

|————b.dir

| ——ba.file

」——c.dir

」——d.file

|————e.file

」———f.dir

|———g.file

」——h.dir

」——i.file

将 root 的绝对路径传递给函数 lookup 后,打印的内容如下:

/root/testWork/test_dir/a.file

/root/testWork/test_dir/b.dir/ba.file

/root/testWork/test_dir/b.dir/c.dir/d.file

/root/testWork/test_dir/e.file

/root/testWork/test_dir/f.dir/g.file

/root/testWork/test_dir/f.dir/h.dir/i.file

请实现此函数。

def lookup(path):

# -*- coding:utf-8 -*-

# 要求:升序遍历指定目录中的所有文件名

import os

full_names = []

def lookup(path=None):

global full_names

if not path:

dirs = os.getcwd()

else:

if os.path.isdir(path):

dirs = path

else:

print(path)

return

# 遍历路径下的所有目录,并按顺序排序

os.chdir(dirs)

dirs = os.getcwd()

dir_files = os.listdir(dirs)

dir_files.sort()

for dir_file in dir_files:

if os.path.isfile(dir_file):

full_name = os.path.join(dirs,dir_file)

full_names.append(full_name)

elif os.path.isdir(dir_file):

lookup(dir_file)

os.chdir('../')

if __name__ == '__main__':

dir = input('请输入一个要遍历的目录:')

lookup(dir)

for full_name in full_names:

print(full_name)

100.并行(parallel)和并发(concurrency)?

并行:同一时刻多个任务同时在运行

并发:在同一时间间隔内多个任务都在运行,但是并不会在同一时刻同时运行,存在交替执行的情况

实现并行的库有:multiprocessing

实现并发的库有:threading

程序需要执行较多的读写、请求和回复任务的需要大量的 IO 操作,IO密集型操作使用并发更好

CPU 运算量大的程序程序,使用并行会更好

101.Python 主要的内置数据类型都有哪些?print dir(‘a’)的输出?

内建类型:布尔类型、数字、字符串、列表、元组、字典、集合;

输出字符串‘a’的内建方法

102.给定一个 int list a,满足 a[i + 1]>=a[i],给定 int key找出 list a 中第一个大于等于 key 的元素的 index,无满足要求的元素则返回-1

def findindex(int_list,int_key):

int_list = sorted(int_list)

for i in range(len(int_list)):

if int_list[i] == int_key:

return i

return -1

if __name__ == "__main__":

lista = [12,3,4,5,8,6]

index = findindex(lista,5)

print(index)

103.正则表达式

正则匹配中贪婪模式与非贪婪模式的区别?match、search 函数的使用及区别?请写出以字母或下划线开始,以数字结束的正则表达式?

1 贪婪模式:正则会尽量多的匹配字符串,被匹配到的字符串里面可能包含多个可以终止匹配的字符,但是会匹配到最后一个字符才会停止;非贪婪模式:正则会保证符合规则的情况下尽量少匹配字符,不会出现匹配到的字符中包含可以终止匹配的字符的情况。

2 match 是从字符串的第一个字符开始依次往后匹配,中途若出现不匹配的情况则立即终止匹配,返回寄过为空,匹配到第一个满足要求的字符串也停止匹配并返回匹配到的字符串;search 也是有第一个字符开始,若第个字符不匹配则从下一个字符开始匹配(即可以从中间开始匹配),知道匹配到第一个符合条件字符串,或者匹配到最后一个字符终止匹配。

match方法从头开始找,找到就返回,否则为None,只匹配一次

search从头依次搜索,只匹配一次,若对象中含有目标,则返回目标。否则返回None

re.match() 从第一个字符开始找, 如果第一个字符就不匹配就返回None, 不继续匹配. 用于判断字符串开头或整个字符串是否匹配,速度快.

re.search() 会整个字符串查找,直到找到一个匹配。

3 r’1|[_].*\d$’

正则表达式的优缺点:

缺点

1).正则表达式只适合匹配文本字面,不适合匹配文本意义:像匹配url,email这种纯文本的字符就很好,但比如匹配多少范围到多少范围的数字,如果你这个范围很复杂的话用正则就很麻烦。或者匹配html,这个是很多人经常遇到的,写一个复杂匹配html的正则很麻烦,不如使用针对特定意义的处理器来处理(比如写语法分析器,dom分析器等)

2).容易引起性能问题:像.*这种贪婪匹配符号很容易造成大量的回溯,性能有时候会有上百万倍的下降,编写好的正则表达式要对正则引擎执行方式有很清楚的理解才可以

3).正则的替换功能较差:甚至没有基本的截取字符串或者把首字母改变大小写的功能,这对于url重写引擎有时候是致命的影响

优点:只要熟练应用正则表达式,而且匹配的目标是纯文本,那么相比于写分析器来说,正则可以更快速的完成工作。还有在捕获字符串的能力,正则也可以很好的完成工作,比如截取url的域名或者其他的内容等等

104.描述 Python GIL 的概念,以及它对 Python 多线程的影响?

线程全局锁(Global Interpreter Lock),即 Python 为了保证线程安全而采取的独立线程运行的限制,说白了就是一个核只能在同一时间运行一个线程.

GIL:又叫全局解释器锁,每个线程在执行的过程中都需要先获取GIL,保证同一时刻只有一个线程在运行,目的是解决多线程同时竞争程序中的全局变量而出现的线程安全问题。它并不是python语言的特性,仅仅是由于历史的原因在CPython解释器中难以移除,因为python语言运行环境大部分默认在CPython解释器中。

多线程下每个线程在执行的过程中都需要先获取GIL,保证同一时刻只有一个线程在运行。

即使在多核CPU中,多线程同一时刻也只有一个线程在运行,这样不仅不能利用多核CPU的优势,反而由于每个线程在多个CPU上是交替执行的,导致在不同CPU上切换时造成资源的浪费,反而会更慢。即原因是一个进程只存在一把GIL锁,当在执行多个线程时,内部会争抢GIL锁,这会造成当某一个线程没有抢到锁的时候会让CPU等待,进而不能合理利用多核CPU资源。

计算密集型:要进行大量的数值计算,例如进行上亿的数字计算、计算圆周率、对视频进行高清解码等等。这种计算密集型任务虽然也可以用多任务完成,但是花费的主要时间在任务切换的时间,此时CPU执行任务的效率比较低。

IO密集型:涉及到网络请求(time.sleep())、磁盘IO的任务都是IO密集型任务,这类任务的特点是CPU消耗很少,任务的大部分时间都在等待IO操作完成(因为IO的速度远远低于CPU和内存的速度)。对于IO密集型任务,任务越多,CPU效率越高,但也有一个限度。

GIL:全局解释器锁。每个线程在执行的过程都需要先获取 GIL,保证同一时刻只有一个线程可以执行字节码。

线程释放 GIL 锁的情况:

在 IO 操作等可能会引起阻塞的 system call 之前,可以暂时释放 GIL,但在执行完毕后,必须重新获取 GIL

Python 3.x 使用计时器(执行时间达到阈值后,当前线程释放 GIL)或Python 2.x,tickets 计数达到 100

Python 使用多进程是可以利用多核的 CPU 资源的。

多线程爬取比单线程性能有提升,因为遇到 IO 阻塞会自动释放 GIL 锁

解决GIL问题的方案:

1.使用其它语言,例如C,Java

2.使用其它解释器,如java的解释器jython

3.使用多进程

105.Python 中如何动态获取和设置对象的属性?

if hasattr(Parent,'x'):

print(getattr(Parent,'x'))

setattr(Parent,'x',3)

print(getattr(Parent,'x'))

106.git merge 和 git rebase 有什么区别?git reset 和 git revert 有什么区别?

merge 操作会生成一个新的节点,之前的提交分开显示。而 rebase 操作不会生成新的节点,是将两个分支融合成一个线性的提交

git revert 是生成一个新的提交来撤销某次提交,此次提交之前的commit 都会被保留

git reset 是回到某次提交,提交及之前的 commit 都会被保留,但是此次之后的修改都会被退回到暂存区

107.dict 的 items()和 iteritems()方法的不同?

items()返回的是列表对象,而 iteritems()返回的是 iterator 对象

108.函数调用一个变量的顺序?

Python 变量访问时有个 LEGB 原则,也就是说,变量访问时搜索顺序为Local ==> Enclosing ==> Global ==> Builtin

简单地说,访问变量时,先在当前作用域找,如果找到了就使用,如果没找到就继续到外层作用域看看有没有,找到了就使用,如果还是没找到就继续到更外层作用域找,如果已经到了最外层作用域了还是实在找不到就看看是不是内置对象,如果也不是,抛出异常。

109.面向对象中怎么实现只读属性?

将对象私有化,通过共有方法提供一个读取数据的接口

class person:

def __init__(self,x):

self.__age = 10

def age(self):

return self.__age

t = person(22)

# t.__age = 100

print(t.age())

最好的方法

class MyCls(object):

__weight = 50

@property #以访问属性的方式来访问 weight 方法

def weight(self):

return self.__weight

if __name__ == '__main__':

obj = MyCls()

print(obj.weight)

obj.weight = 12

# raceback (most recent call last):

# 50

# File "C:/PythonTest/test.py", line 11, in 110.内存泄露是什么?如何避免?

指由于疏忽或错误造成程序未能释放已经不再使用的内存的情况。内存泄漏并非指内存在物理上的消失,而是应用程序分配某段内存后,由于设计错误,失去了对该段内存的控制,因而造成了内存的浪费。导致程序运行速度减慢甚至系统崩溃等严重后果。

有 del() 函数的对象间的循环引用是导致内存泄漏的主凶。

不使用一个对象时使用:del object 来删除一个对象的引用计数就可以有效防止内存泄漏问题。

通过 Python 扩展模块 gc 来查看不能回收的对象的详细信息。

可以通过 sys.getrefcount(obj) 来获取对象的引用计数,并根据返回值是否为 0 来判断是否内存泄漏。

111.Python 函数调用的时候参数的传递方式是值传递还是引用传递?

Python 的参数传递有:位置参数、默认参数、可变参数、关键字参数。

函数的传值到底是值传递还是引用传递,要分情况:

不可变参数用值传递:

像整数和字符串这样的不可变对象,是通过拷贝进行传递的,因为你无论如何都不可能在原处改变不可变对象

可变参数是引用传递的:

比如像列表,字典这样的对象是通过引用传递、和 C 语言里面的用指针传递数组很相似,可变对象能在函数内部改变。

112.有这样一段代码,print c 会输出什么,为什么?

a = 10

b = 20

c = [a]

print(c) #[10]

a = 15

print(c) #[10]

113.print(list(map(lambda x: x * x, [y for y in range(3)])))的输出?

[0,1,4]

114.hasattr() getattr() setattr() 函数使用详解?

hasattr(object, name)函数:

判断一个对象里面是否有 name 属性或者 name 方法,返回 bool 值,有 name 属性(方法)返回 True,否则返False。

注意:name 要使用引号括起来。

class function_demo(object):

name = 'demo'

def run(self):

return "hello function"

functiondemo = function_demo()

res = hasattr(functiondemo, 'name')

#判断对象是否有 name 属性,True

# res = hasattr(functiondemo, "run") #判断对象是否有 run 方法,True

# res = hasattr(functiondemo, "age") #判断对象是否有 age 属性,Falsw

print(res)

getattr(object, name[,default]) 函数:

获取对象 object 的属性或者方法,如果存在则打印出来,如果不存在,打印默认值,默认值可选。

注意:如果返回的是对象的方法,则打印结果是:方法的内存地址,如果需要运行这个方法,可以在后面添加括号()。

functiondemo = function_demo()

getattr(functiondemo, 'name') #获取 name 属性,存在就打印出来--- demo

getattr(functiondemo, "run") #获取 run 方法,存在打印出 方法的内存地址--->

getattr(functiondemo, "age") #获取不存在的属性,报错如下:

Traceback (most recent call last):

File "/Users/liuhuiling/Desktop/MT_code/OpAPIDemo/conf/OPCommUtil.py", line 39, in <module>

res = getattr(functiondemo, "age")

AttributeError: 'function_demo' object has no attribute 'age'

getattr(functiondemo, "age", 18)

#获取不存在的属性,返回一个默认值

setattr(object,name,values)函数:

给对象的属性赋值,若属性不存在,先创建再赋值

class function_demo(object):

name = 'demo'

def run(self):

return "hello function"

functiondemo = function_demo()

res = hasattr(functiondemo, 'age')

# 判断 age 属性是否存在,False

print(res)

setattr(functiondemo, 'age', 18 )

#对 age 属性进行赋值,无返回值

res1 = hasattr(functiondemo, 'age') #再次判断属性是否存在,True

综合使用:

class function_demo(object):

name = 'demo'

def run(self):

return "hello function"

functiondemo = function_demo()

res = hasattr(functiondemo, 'addr') # 先判断是否存在

if res:

addr = getattr(functiondemo, 'addr')

print(addr)

else:

addr = getattr(functiondemo, 'addr', setattr(functiondemo, 'addr', '北京首都'))

#addr = getattr(functiondemo, 'addr', '美国纽约')

print(addr)

115.一句话解决阶乘函数?

在 Python2 中:

1.reduce(lambda x,y: x*y, range(1,n+1))

注意:Python3 中取消了该函数。

116.请手写一个单例

class A(object):

__instance = None

def __new__(cls, *args, **kwargs):

if cls.__instance is None:

cls.__instance = object.__new__(cls)

return cls.__instance

else:

return cls.__instance

117.函数装饰器有什么作用?

装饰器本质上是一个 Python 函数,它可以在让其他函数在不需要做任何代码的变动的前提下增加额外的功能。装

饰器的返回值也是一个函数的对象,它经常用于有切面需求的场景。 比如:插入日志、性能测试、事务处理、缓存、

权限的校验等场景 有了装饰器就可以抽离出大量的与函数功能本身无关的雷同代码并发并继续使用。

118.X 是什么类型?

X = (for i in range(10))

X 是 generator 类型。

119.Python 中 yield 的用法?

yield 就是保存当前程序执行状态。你用 for 循环的时候,每次取一个元素的时候就会计算一次。用 yield 的函数叫 generator,和 iterator 一样,它的好处是不用一次计算所有元素,而是用一次算一次,可以节省很多空间。generator

每次计算需要上一次计算结果,所以用 yield,否则一 return,上次计算结果就没了。

def createGenerator():

mylist = range(3)

for i in mylist:

yield i*i

mygenerator = createGenerator() # create a generator

print(mygenerator) # mygenerator is an object!

<generator object createGenerator at 0xb7555c34>

for i in mygenerator:

print(i)

#0 1 4

120.Python 中的可变对象和不可变对象?

不可变对象,该对象所指向的内存中的值不能被改变。当改变某个变量时候,由于其所指的值不能被改变,相当

于把原来的值复制一份后再改变,这会开辟一个新的地址,变量再指向这个新的地址。

可变对象,该对象所指向的内存中的值可以被改变。变量(准确的说是引用)改变后,实际上是其所指的值直接

发生改变,并没有发生复制行为,也没有开辟新的出地址,通俗点说就是原地改变。

Python 中,数值类型(int 和 float)、字符串 str、元组 tuple 都是不可变类型。而列表 list、字典 dict、集合

set 是可变类型。

121.Python 中 is 和==的区别?

is 判断的是 a 对象是否就是 b 对象,是通过 id 来判断的。

==判断的是 a 对象的值是否和 b 对象的值相等,是通过 value 来判断的。

122.谈谈你对面向对象的理解?

面向对象是相对于面向过程而言的。面向过程语言是一种基于功能分析的、以算法为中心的程序设计方法;而面

向对象是一种基于结构分析的、以数据为中心的程序设计思想。在面向对象语言中有一个有很重要东西,叫做类。

面向对象有三大特性:封装、继承、多态。

123.请写出下列正则关键字的含义?

| 语法 | 说明 | 表达式实例 | 完整匹配的字符串 |

|---|---|---|---|

| . | 匹配任意除换行符"\n"外的字符。在 DOTALL 模式中也能匹配换行符。 | a.c | abc |

| \ | 转义字符,使后一个字符改变原来的意思。如果字符串中有字符需要匹配,可以使用*或者字符集[] | a.c 或a\c | a. c 或 a\c |

| […] | 字符集(字符类)。对应的位置可以是字符集中任意字符。字符集中的字符可以逐个列出,也可以给出范围,如[abc]或[a-c]。第一个字符如果是则表示取反,如[^abc]表示不是 abc的其他字符。所有的特殊字符在字符集中都失去其原有的特殊含义。在字符集中如果要使用]、-或,可以在前面加上反斜杠,或把]、-放在第一个字符,把放在非第—个字符。 | a[bcd]e | abe 或ace 或 ade |

| \d | 数字:[0-9] | a\dc | alc |

| \D | 非数字:[^\d] | a\Dc | abc |

| \s | 空白字符:[<空格>\ t\r\n\f\v] | a\sc | ac |

| \S | 非空白字符:[^\s] | a\Sc | abc |

| \w | 单词字符:[A-Za-z0-9_] | a\wc | abc |

| \W | 非单词字符:[^\W] | a\Wc | ac |

| * | 匹配前一个字符 0 或无限次。 | abc* | ab abccc |

| + | 匹配前一个字符 1 次或无限次 | abc+ | abc abccc |

| ? | 匹配前一个字符 0 次或 1 次。 | abc? | Ab abc |

| {m} | 匹配前一个字符 m 次 | ab{2}c | abbc |

124.进程总结

进程:程序运行在操作系统上的一个实例,就称之为进程。进程需要相应的系统资源:内存、时间片、pid。

创建进程:

1.首先要导入 multiprocessing 中的 Process;

2.创建一个 Process 对象;

3.创建 Process 对象时,可以传递参数;

1.p = Process(target=XXX, args=(元组,) , kwargs={key:value})

2.target = XXX 指定的任务函数,不用加()

3.args=(元组,) , kwargs={key:value} 给任务函数传递

4.使用 start()启动进程;

5.结束进程。

Process 语法结构:

Process([group [, target [, name [, args [, kwargs]]]]])

target:如果传递了函数的引用,可以让这个子进程就执行函数中的代码

args:给 target 指定的函数传递的参数,以元组的形式进行传递

kwargs:给 target 指定的函数传递参数,以字典的形式进行传递

name:给进程设定一个名字,可以省略

group:指定进程组,大多数情况下用不到

Process 创建的实例对象的常用方法有:

start():启动子进程实例(创建子进程)

is_alive():判断进程子进程是否还在活着

join(timeout):是否等待子进程执行结束,或者等待多少秒

terminate():不管任务是否完成,立即终止子进程

Process 创建的实例对象的常用属性:

name:当前进程的别名,默认为 Process-N,N 为从 1 开始递增的整数

pid:当前进程的 pid(进程号)

给子进程指定函数传递参数 Demo:

import os

from multiprocessing import Process

import time

def pro_func(name, age, **kwargs):

for i in range(5):

print("子进程正在运行中,name=%s, age=%d, pid=%d" %(name, age, os.getpid()))

print(kwargs)

time.sleep(0.2)

if __name__ == '__main__':

# 创建 Process 对象

p = Process(target=pro_func, args=('小明',18), kwargs={'m': 20})

# 启动进程

p.start()

time.sleep(1)

# 1 秒钟之后,立刻结束子进程

p.terminate()

p.join()

注意:进程间不共享全局变量。

进程之间的通信-Queue

在初始化 Queue()对象时,(例如 q=Queue(),若在括号中没有指定最大可接受的消息数量,或数量为负值时,那么就代表可接受的消息数量没有上限-直到内存的尽头)

Queue.qsize():返回当前队列包含的消息数量。

Queue.empty():如果队列为空,返回 True,反之 False。

Queue.full():如果队列满了,返回 True,反之 False。

Queue.get([block[,timeout]]):获取队列中的一条消息,然后将其从队列中移除,block 默认值为True。

如果 block 使用默认值,且没有设置 timeout(单位秒),消息列队如果为空,此时程序将被阻塞(停在读取状态),直到从消息列队读到消息为止,如果设置了 timeout,则会等待 timeout 秒,若还没读取到任何消息,则出"Queue.Empty"异常;

如果 block 值为 False,消息列队如果为空,则会立刻抛出"Queue.Empty"异常;

Queue.get_nowait():相当 Queue.get(False);

Queue.put(item,[block[, timeout]]):将 item 消息写入队列,block 默认值为 True;

如果 block 使用默认值,且没有设置 timeout(单位秒),消息列队如果已经没有空间可写入,此时程序将被阻塞(停在写入状态),直到从消息列队腾出空间为止,如果设置了 timeout,则会等待timeout 秒,若还没空间,则出"Queue.Full"异常;

如果 block 值为 False,消息列队如果没有空间可写入,则会立刻抛出"Queue.Full"异常;

Queue.put_nowait(item):相当 Queue.put(item, False);

进程间通信 Demo:

from multiprocessing import Process, Queue

import os, time, random

# 写数据进程执行的代码:

def write(q):

for value in ['A', 'B', 'C']:

print('Put %s to queue...' % value)

q.put(value)

time.sleep(random.random())

# 读数据进程执行的代码:def read(q):

while True:

if not q.empty():

value = q.get(True)

print('Get %s from queue.' % value)

time.sleep(random.random())

else:

break

if __name__=='__main__':

# 父进程创建 Queue,并传给各个子进程:

q = Queue()

pw = Process(target=write, args=(q,))

pr = Process(target=read, args=(q,))

# 启动子进程 pw,写入:

pw.start()

# 等待 pw 结束:

pw.join()

# 启动子进程 pr,读取:

pr.start()

pr.join()

# pr 进程里是死循环,无法等待其结束,只能强行终止:

print('')

print('所有数据都写入并且读完')

进程池 Pool

# -*- coding:utf-8 -*-

from multiprocessing import Pool

import os, time, random

def worker(msg):

t_start = time.time()

print("%s 开始执行,进程号为%d" % (msg,os.getpid()))

# random.random()随机生成 0~1 之间的浮点数

time.sleep(random.random()*2)

t_stop = time.time()

print(msg,"执行完毕,耗时%0.2f" % (t_stop-t_start))

po = Pool(3)

# 定义一个进程池,最大进程数 3

for i in range(0,10):

# Pool().apply_async(要调用的目标,(传递给目标的参数元祖,))

# 每次循环将会用空闲出来的子进程去调用目标

po.apply_async(worker,(i,))

print("----start----")

po.close() # 关闭进程池,关闭后 po 不再接收新的请求

po.join()

# 等待 po 中所有子进程执行完成,必须放在 close 语句之后

print("-----end-----")

multiprocessing.Pool 常用函数解析:

apply_async(func[, args[, kwds]]) :使用非阻塞方式调用 func(并行执行,堵塞方式必须等待上一个进程退出才能执行下一个进程),args 为传递给 func 的参数列表,kwds 为传递给 func的关键字参数列表;

close():关闭 Pool,使其不再接受新的任务;

terminate():不管任务是否完成,立即终止;

join():主进程阻塞,等待子进程的退出, 必须在 close 或 terminate 之后使用;

进程池中使用 Queue

如果要使用 Pool 创建进程,就需要使用 multiprocessing.Manager()中的 Queue(),而不是

multiprocessing.Queue(),否则会得到一条如下的错误信息:

RuntimeError: Queue objects should only be shared between processes through inheritance.

from multiprocessing import Manager,Pool

import os,time,random

def reader(q):

print("reader 启动(%s),父进程为(%s)" % (os.getpid(), os.getppid()))

for i in range(q.qsize()):

print("reader 从 Queue 获取到消息:%s" % q.get(True))

def writer(q):

print("writer 启动(%s),父进程为(%s)" % (os.getpid(), os.getppid()))

for i in "itcast":

q.put(i)

if __name__=="__main__":

print("(%s) start" % os.getpid())

q = Manager().Queue() # 使用 Manager 中的 Queue

po = Pool()

po.apply_async(writer, (q,))

time.sleep(1)

# 先让上面的任务向 Queue 存入数据,然后再让下面的任务开始从中取数据

po.apply_async(reader, (q,))

po.close()

po.join()

print("(%s) End" % os.getpid())

125.谈谈你对多进程,多线程,以及协程的理解,项目是否用?

这个问题被问的概率相当之大,其实多线程,多进程,在实际开发中用到的很少,除非是那些对项目性能要求特别高的,有的开发工作几年了,也确实没用过,你可以这么回答,给他扯扯什么是进程,线程(cpython 中是伪多线程)的概念就行,实在不行你就说你之前写过下载文件时,用过多线程技术,或者业余时间用过多线程写爬虫,提升效率。

进程:一个运行的程序(代码)就是一个进程,没有运行的代码叫程序,进程是系统资源分配的最小单位,进程拥有自己独立的内存空间,所以进程间数据不共享,开销大。

线程: 调度执行的最小单位,也叫执行路径,不能独立存在,依赖进程存在一个进程至少有一个线程,叫主线程,而多个线程共享内存(数据共享,共享全局变量),从而极大地提高了程序的运行效率。

协程:是一种用户态的轻量级线程,协程的调度完全由用户控制。协程拥有自己的寄存器上下文和栈。 协程调度切换时,将寄存器上下文和栈保存到其他地方,在切回来的时候,恢复先前保存的寄存器上下文和栈,直接操作栈则基本没有内核切换的开销,可以不加锁的访问全局变量,所以上下文的切换非常快。

126.什么是多线程竞争?

线程是非独立的,同一个进程里线程是数据共享的,当各个线程访问数据资源时会出现竞争状态即:

数据几乎同步会被多个线程占用,造成数据混乱 ,即所谓的线程不安全

那么怎么解决多线程竞争问题?-- 锁。

锁的好处:

确保了某段关键代码(共享数据资源)只能由一个线程从头到尾完整地执行能解决多线程资源竞争下的原子操作问题。

锁的坏处:

阻止了多线程并发执行,包含锁的某段代码实际上只能以单线程模式执行,效率就大大地下降了

锁的致命问题:死锁。

127.IO 密集型和 CPU 密集型区别?

IO 密集型:系统运作,大部分的状况是 CPU 在等 I/O (硬盘/内存)的读/写。

CPU 密集型:大部份时间用来做计算、逻辑判断等 CPU 动作的程序称之 CPU 密集型。

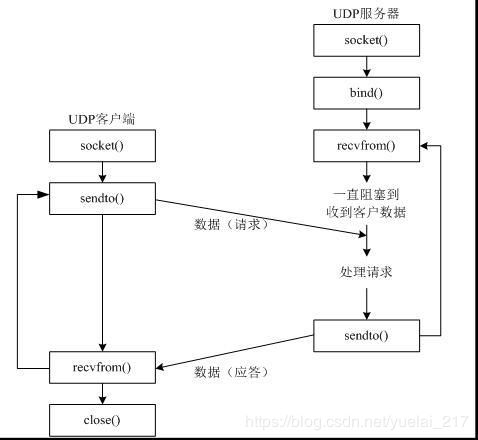

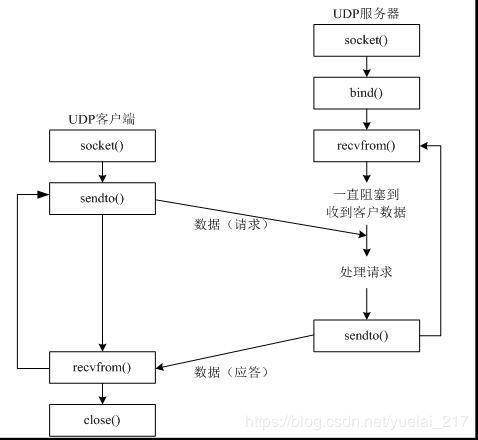

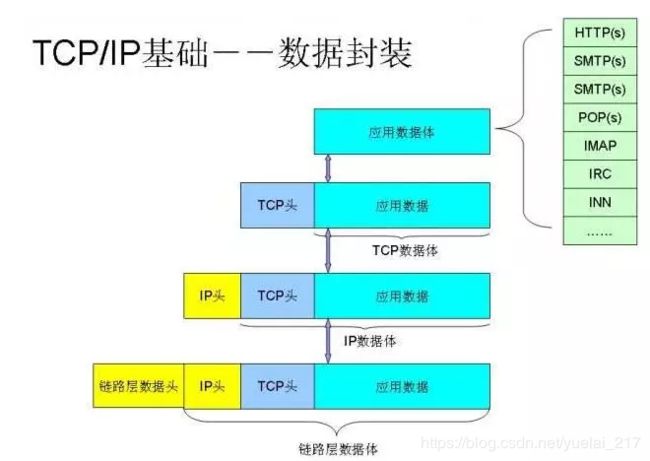

128.UDP总结

UDP 协议

UDP 是User Datagram Protocol的简称, 中文名是用户数据报协议,是OSI(Open System Interconnection,开放式系统互联) 参考模型中一种无连接的传输层协议,提供面向事务的简单不可靠信息传送服务,IETF RFC 768是UDP的正式规范。UDP在IP报文的协议号是17。

UDP的优点

快,比TCP稍安全

UDP没有TCP的握手、确认、窗口、重传、拥塞控制等机制,UDP是一个无状态的传输协议,所以它在传递数据时非常快。没有TCP的这些机制,UDP较TCP被攻击者利用的漏洞就要少一些。但UDP也是无法避免攻击的,比如:UDP Flood攻击……

UDP的缺点

不可靠,不稳定

因为UDP没有TCP那些可靠的机制,在数据传递时,如果网络质量不好,就会很容易丢包。

UDP应用场景

当对网络通讯质量要求不高的时候,要求网络通讯速度能尽量的快,这时就可以使用UDP。在日常生活中,常见使用UDP协议的应用比如:QQ语音、QQ视频、TFTP等。

TCP和UDP使用IP协议从一个网络传送数据包到另一个网络。把IP想像成一种高速公路,它允许其它协议在上面行驶并找到到其它电脑的出口。TCP和UDP是高速公路上的“卡车”,它们携带的货物就是像HTTP,文件传输协议FTP这样的协议等。

使用 udp 发送/接收数据步骤:

1.创建客户端套接字

2.发送/接收数据

3.关闭套接字

import socket

def main():

# 1、创建 udp 套接字

# socket.AF_INET

# socket.SOCK_DGRAM 数据报套接字,只要用于 udp 协议

udp_socket = socket.socket(socket.AF_INET, socket.SOCK_DGRAM)

# 2、准备接收方的地址

# 元组类型 ip 是字符串类型 端口号是整型

dest_addr = ('192.168.113.111', 8888)

# 要发送的数据

send_data = "我是要发送的数据"

# 3、发送数据

udp_socket.sendto(send_data.encode("utf-8"), dest_addr)

# 4、等待接收方发送的数据 如果没有收到数据则会阻塞等待,直到收到数据

# 接收到的数据是一个元组(接收到的数据, 发送方的 ip 和端口)

# 1024 表示本次接收的最大字节数

recv_data, addr = udp_socket.recvfrom(1024)

# 5、关闭套接字

udp_socket.close()

if __name__ == '__main__':

main()

编码的转换

str -->bytes: encode 编码

bytes–> str: decode()解码

UDP 绑定端口号:

1.创建 socket 套接字

2.绑定端口号

3.接收/发送数据

4.关闭套接字

import socket

def main():

# 1、创建 udp 套接字

# socket.AF_INET表示 IPv4 协议 AF_INET6 表示 IPv6 协议

# socket.SOCK_DGRAM 数据报套接字,只要用于 udp 协议

udp_socket = socket.socket(socket.AF_INET, socket.SOCK_DGRAM)

# 2、绑定端口

# 元组类型 ip 一般不写 表示本机的任何的一个 ip

local_addr = ('', 7777)

udp_socket.bind(local_addr)

# 3、准备接收方的地址

# 元组类型 ip 是字符串类型 端口号是整型

dest_addr = ('192.168.113.111', 8888)

# 要发送的数据

send_data = "我是要发送的数据"

# 4、发送数据

udp_socket.sendto(send_data.encode("utf-8"), dest_addr)

# 5、等待接收方发送的数据 如果没有收到数据则会阻塞等待,直到收到数据

# 接收到的数据是一个元组(接收到的数据, 发送方的 ip 和端口)

# 1024 表示本次接收的最大字节数

recv_data, addr = udp_socket.recvfrom(1024)

# 6、关闭套接字

udp_socket.close()

if __name__ == '__main__':

main()

129.TCP总结

TCP协议

TCP(Transmission Control Protocol 传输控制协议)是一种面向连接的、可靠的、基于字节流的传输层通信协议,由IETF的RFC 793定义。在简化的计算机网络OSI模型中,它完成第四层传输层所指定的功能,用户数据报协议(UDP)是同一层内另一个重要的传输协议。

在因特网协议族(Internet protocol suite)中,TCP层是位于IP层之上,应用层之下的中间层。不同主机的应用层之间经常需要可靠的、像管道一样的连接,但是IP层不提供这样的流机制,而是提供不可靠的包交换。

TCP的优点

可靠,稳定

TCP的可靠体现在TCP在传递数据之前,会有三次握手来建立连接,而且在数据传递时,有确认、窗口、重传、拥塞控制机制,在数据传完后,还会断开连接用来节约系统资源。

TCP的缺点

慢,效率低,占用系统资源高,易被攻击

TCP在传递数据之前,要先建连接,这会消耗时间,而且在数据传递时,确认机制、重传机制、拥塞控制机制等都会消耗大量的时间,而且要在每台设备上维护所有的传输连接,事实上,每个连接都会占用系统的CPU、内存等硬件资源。

由于TCP存在确认机制和三次握手机制,这些是导致TCP容易被人利用,实现DOS、DDOS、CC等攻击。

TCP应用场景

当对网络通讯质量有要求的时候,比如:整个数据要准确无误的传递给对方,这往往用于一些要求可靠的应用,比如HTTP、HTTPS、FTP等传输文件的协议,POP、SMTP等邮件传输的协议。

在日常生活中,常见使用TCP协议的应用比如:浏览器使用HTTP,Outlook使用POP、SMTP,QQ文件传输等。

tcp/ip协议

TCP/IP是个协议组,可分为三个层次:网络层、传输层和应用层。

在网络层有:IP协议、ICMP协议、ARP协议、RARP协议和BOOTP协议。

在传输层中有:TCP协议与UDP协议。

在应用层有:FTP、HTTP、TELNET、SMTP、DNS等协议。

因此,HTTP本身就是一个协议,是从Web服务器传输超文本到本地浏览器的传送协议。

TCP和UDP是FTP,HTTP和SMTP之类使用的传输层协议。虽然TCP和UDP都是用来传输其他协议的,它们却有一个显著的不同:TCP提供有保证的数据传输,而UDP不提供。这意味着TCP有一个特殊的机制来确保数据安全的不出错的从一个端点传到另一个端点,而UDP不提供任何这样的保证。

TCP 客户端的创建流程:

1.创建 TCP 的 socket 套接字

2.连接服务器

3.发送数据给服务器端

4.接收服务器端发送来的消息

5.关闭套接字

import socket

def main():

# 1、创建客户端的 socket

# socket.AF_INET表示 IPv4 协议 AF_INET6 表示 IPv6 协议

# socket.SOCK_STREAM 流式套接字,只要用于 TCP 协议

client_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

# 2、构建目标地址

server_ip = input("请输入服务器端的 IP 地址:")

server_port = int(input("请输入服务器端的端口号:"))

# 3、连接服务器

# 参数:元组类型 ip 是字符串类型 端口号是整型

client_socket.connect((server_ip, server_port))

# 要发送给服务器端的数据

send_data = "我是要发送给服务器端的数据"

# 4、发送数据

client_socket.send(send_data.encode("gbk"))

# 5、接收服务器端恢复的消息, 没有消息会阻塞

# 1024 表示接收的最大字节数

recv_date= client_socket.recv(1024)

print("接收到的数据是:", recv_date.decode('gbk'))

# 6、关闭套接字

client_socket.close()

if __name__ == '__main__':

main()

TCP 服务器端的创建流程

1.创建 TCP 服务端的 socket

2.bing 绑定 ip 地址和端口号

3.listen 使套接字变为被动套接字

4.accept 取出一个客户端连接,用于服务

5.recv/send 接收和发送消息

6.关闭套接字

import socket

def main():

# 1、创建 tcp 服务端的 socket

server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

# 2、绑定

server_socket.bind(('', 8888))

# 3、listen 使套接字变为被动套接字

server_socket.listen(128)

# 4、如果有新的客户端来链接服务器,那么就产生一个新的套接字专门为这个客户端服务

# client_socket 用来为这个客户端服务

# tcp_server_socket 就可以省下来专门等待其他新客户端的链接

client_socket, client_addr = server_socket.accept()

# 5、接收客户端发来的消息

recv_data = client_socket.recv(1024)

print("接收到客户端%s 的数据:%s" % (str(client_addr), recv_data.decode('gbk')))

# 6、回复数据给客户端

client_socket.send("收到消息".encode('gbk'))

# 7、关闭套接字

client_socket.close()

server_socket.close()

if __name__ == '__main__':

main()

注意点:

tcp 服务器一般都需要绑定,否则客户端找不到服务器

tcp 客户端一般不绑定,因为是主动链接服务器,所以只要确定好服务器的 ip、port 等信息就好,本地客户端可以随机

tcp 服务器中通过 listen 可以将 socket 创建出来的主动套接字变为被动的,这是做 tcp 服务器时必须要做的

当客户端需要链接服务器时,就需要使用 connect 进行链接,udp 是不需要链接的而是直接发送,但是 tcp 必须先链接,只有链接成功才能通信

当一个 tcp 客户端连接服务器时,服务器端会有 1 个新的套接字,这个套接字用来标记这个客户端,单独为这个客户端服务

listen 后的套接字是被动套接字,用来接收新的客户端的连接请求的,而 accept 返回的新套接字是标识这个新客户端的

关闭 listen 后的套接字意味着被动套接字关闭了,会导致新的客户端不能够链接服务器,但是之前已经链接成功的客户端正常通信。

关闭 accept 返回的套接字意味着这个客户端已经服务完毕

当客户端的套接字调用 close 后,服务器端会 recv 解阻塞,并且返回的长度为 0,因此服务器可以通过返回数据的长度来区别客户端是否已经下线;同理 当服务器断开 tcp 连接的时候 客户端同样也会收到 0 字节数据。

130.怎么实现强行关闭客户端和服务器之间的连接?

在 socket 通信过程中不断循环检测一个全局变量(开关标记变量),一旦标记变量变为关闭,则 调用 socket 的 close 方法,循环结束,从而达到关闭连接的目的。

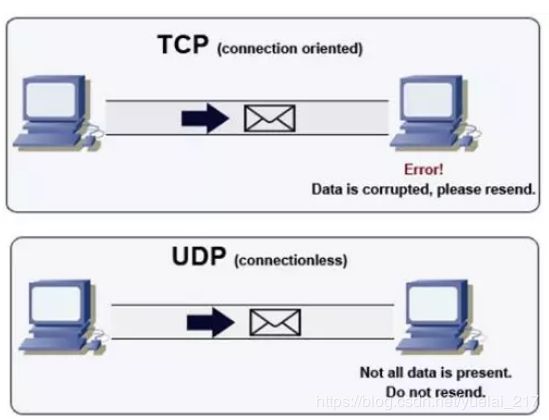

131.简述 TCP 和 UDP 的区别以及优缺点?

UDP 是面向无连接的通讯协议,UDP 数据包括目的端口号和源端口号信息。

优点:UDP 速度快、操作简单、要求系统资源较少,由于通讯不需要连接,可以实现广播发送

缺点:UDP 传送数据前并不与对方建立连接,对接收到的数据也不发送确认信号,发送端不知道数据是否会正确接收,也不重复发送,不可靠。

TCP 是面向连接的通讯协议,通过三次握手建立连接,通讯完成时四次挥手

优点:TCP 在数据传递时,有确认、窗口、重传、阻塞等控制机制,能保证数据正确性,较为可靠。

缺点:TCP 相对于 UDP 速度慢一点,要求系统资源较多。

区别:

1、TCP 面向连接(如打电话要先拨号建立连接);UDP 是无连接的,即发送数据之前不需要建立连接

2、TCP 提供可靠的服务。也就是说,通过 TCP 连接传送的数据,无差错,不丢失,不重复,且按序到达;UDP 尽最大努力交付,即不保证可靠交付

3、TCP 面向字节流,实际上是 TCP 把数据看成一连串无结构的字节流;UDP 是面向报文的,UDP 没有拥塞控制,因此网络出现拥塞不会使源主机的发送速率降低(对实时应用很有用,如 IP 电话,实时视频会议等)

4、每一条 TCP 连接只能是点到点的;UDP 支持一对一,一对多,多对一和多对多的交互通信

5、TCP 首部开销 20 字节;UDP 的首部开销小,只有 8 个字节

6、TCP 的逻辑通信信道是全双工的可靠信道,UDP 则是不可靠信道

| 选项 | UDP | TCP |

|---|---|---|

| 连接 | 无连接 | 面向连接 |

| 速度 | 无需建立连接,速度较快 | 需要建立连接,速度较慢 |

| 目的主机 | 一对一,一对多 | 仅能一对一 |

| 带宽 | UDP报头较短,消耗带宽更少 | 消耗更多带宽 |

| 消息边界 | 有 | 无 |

| 可靠性 | 低 | 高 |

| 顺序 | 无序 | 有序 |

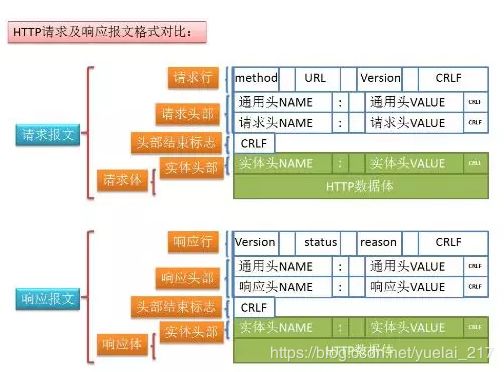

132.简述浏览器通过 WSGI 请求动态资源的过程?

1.发送 http 请求动态资源给 web 服务器

2.web 服务器收到请求后通过 WSGI 调用一个属性给应用程序框架

3.应用程序框架通过引用 WSGI 调用 web 服务器的方法,设置返回的状态和头信息。

4.调用后返回,此时 web 服务器保存了刚刚设置的信息

5.应用程序框架查询数据库,生成动态页面的 body 的信息

6.把生成的 body 信息返回给 web 服务器

7.web 服务器吧数据返回给浏览器

133.描述用浏览器访问 www.baidu.com 的过程

先要解析出 baidu.com 对应的 ip 地址

要先使用 arp 获取默认网关的 mac 地址

组织数据发送给默认网关(ip 还是 dns 服务器的 ip,但是 mac 地址是默认网关的 mac 地址)

默认网关拥有转发数据的能力,把数据转发给路由器

路由器根据自己的路由协议,来选择一个合适的较快的路径转发数据给目的网关

目的网关(dns 服务器所在的网关),把数据转发给 dns 服务器

dns 服务器查询解析出 baidu.com 对应的 ip 地址,并原路返回请求这个域名的 client得到了 baidu.com 对应的 ip 地址之后,会发送 tcp 的 3 次握手,进行连接

使用 http 协议发送请求数据给 web 服务器

web 服务器收到数据请求之后,通过查询自己的服务器得到相应的结果,原路返回给浏览器。

浏览器接收到数据之后通过浏览器自己的渲染功能来显示这个网页。

浏览器关闭 tcp 连接,即 4 次挥手结束,完成整个访问过程

134.Post 和 Get 请求的区别?

概念:

GET 请求,请求的数据会附加在 URL 之后,以?分割 URL 和传输数据,多个参数用&连接。URL 的编码格式采用的是 ASCII 编码,而不是 uniclde,即是说所有的非 ASCII 字符都要编码之后再传输。

POST 请求:POST 请求会把请求的数据放置在 HTTP 请求包的包体中。上面的 item=bandsaw 就是实际的传输数据。

因此,GET 请求的数据会暴露在地址栏中,而 POST 请求则不会。

传输数据的大小:

在 HTTP 规范中,没有对 URL 的长度和传输的数据大小进行限制。但是在实际开发过程中,对于 GET,特定的浏览器和服务器对 URL 的长度有限制。因此,在使用 GET 请求时,传输数据会受到 URL 长度的限制。

对于 POST,由于不是 URL 传值,理论上是不会受限制的,但是实际上各个服务器会规定对 POST提交数据大小进行限制,Apache、IIS 都有各自的配置。

安全性:

POST 的安全性比 GET 的高。这里的安全是指真正的安全,而不同于上面 GET 提到的安全方法中的安全,上面提到的安全仅仅是不修改服务器的数据。比如,在进行登录操作,通过 GET 请求,用户名和密码都会暴露再 URL 上,因为登录页面有可能被浏览器缓存以及其他人查看浏览器的历史记录的原因,此时的用户名和密码就很容易被他人拿到了。除此之外,GET 请求提交的数据还可能会造成 Cross-site request frogery 攻击。

效率:

GET 比 POST 效率高。

请求过程:

POST 请求的过程:

1.浏览器请求 tcp 连接(第一次握手)

2.服务器答应进行 tcp 连接(第二次握手)

3.浏览器确认,并发送 post 请求头(第三次握手,这个报文比较小,所以 http 会在此时进行第一次数据发送)

4.服务器返回 100 continue 响应

5.浏览器开始发送数据

6.服务器返回 200 ok 响应

GET 请求的过程:

1.浏览器请求 tcp 连接(第一次握手)

2.服务器答应进行 tcp 连接(第二次握手)

3.浏览器确认,并发送 get 请求头和数据(第三次握手,这个报文比较小,所以 http 会在此时进行第一次数据发送)

4.服务器返回 200 OK 响应

| 操作 | GET | POST |

|---|---|---|

| 后退按钮/刷新 | 无害 | 数据会被重新提交(浏览器应该告知用户数据会被重新提交) |

| 书签 | 可收藏为书签 | 不可收藏为书签 |

| 缓存 | 能被缓存 | 不能缓存 |

| 编码类型 | application/x-www-form-urlencoded | application/x-www-form-urlencoded 或multipart/form-data。为二进制数据使用多重编码。 |

| 历史 | 参数保留在浏览器历史中。 | 参数不会保存在浏览器历史中。 |

| 对数据长度的限制 | 是的。当发送数据时,GET 方法向 URL 添加数据;URL 的长度是受限制的(URL 的最大长度是 2048 个字符)。 | 无限制。 |

| 对数据类型的限制 | 只允许 ASCII 字符。 | 没有限制。也允许二进制数据。 |

| 安全性 | 与 POST 相比,GET 的安全性较差,因为所发送的数据是 URL 的一部分。在发送密码或其他敏感信息时绝不要使GET ! | POST 比 GET 更安全,因为参数不会被保存在浏览器历史或 web 服务器日志中 |

| 可见性 | 数据在 URL 中对所有人都是可见的。 | 数据不会显示在 URL 中。 |

135.cookie 和 session 的区别?

cookie(储存在用户本地终端上的数据):指某些网站为了辨别用户身份、进行session跟踪而储存在用户本地终端上的数据(通常经过加密)。

Session技术:

是一种将会话状态保存在服务器端的技术,它可以比喻成是医院发放给病人的病历卡和医院为每个病人保留的病历档案的结合方式。客户端需要接收、记忆和回送Session的会话标识号,Session可以且通常是借助Cookie来传递会话标识号。

1、cookie 数据存放在客户的浏览器上,session 数据放在服务器上。

2、cookie 不是很安全,别人可以分析存放在本地的 cookie 并进行 cookie 欺骗考虑到安全应当使用 session。

3、session 会在一定时间内保存在服务器上。当访问增多,会比较占用服务器的性能考虑到减轻服务器性能方面,应当使用 cookie。

4、单个 cookie 保存的数据不能超过 4K,很多浏览器都限制一个站点最多保存 20 个 cookie。

5、建议: 将登陆信息等重要信息存放为 SESSION 其他信息如果需要保留,可以放在 cookie 中

136.HTTP 协议状态码有什么用,列出你知道的 HTTP 协议的状态码,然后讲出他们都表示什么意思?

通过状态码告诉客户端服务器的执行状态,以判断下一步该执行什么操作。

常见的状态机器码有:

1xx:指示信息–表示请求已接收,继续处理

2xx:成功–表示请求已被成功接收、理解、接受

3xx:重定向–要完成请求必须进行更进一步的操作

4xx:客户端错误–请求有语法错误或请求无法实现

5xx:服务器端错误–服务器未能实现合法的请求

100-199:表示服务器成功接收部分请求,要求客户端继续提交其余请求才能完成整个处理过程。

200-299:表示服务器成功接收请求并已完成处理过程,常用 200(OK 请求成功)。

300-399:为完成请求,客户需要进一步细化请求。302(所有请求页面已经临时转移到新的 url)。

304、307(使用缓存资源)。

400-499:客户端请求有错误,常用 404(服务器无法找到被请求页面),403(服务器拒绝访问,权限不够)。

500-599:服务器端出现错误,常用 500(请求未完成,服务器遇到不可预知的情况)。

| 状态码 | 简明解释 | 详细阐述 |

|---|---|---|

| 2开头 (请求成功)表示成功处理了请求的状态代码。 | ||

| 200 | 成功 | 服务器已成功处理了请求。通常这表示服务器提供了请求的网页。 |

| 201 | 已创建 | 请求成功并且服务器创建了新的资源。 |

| 202 | 已接受 | 服务器已接受请求,但尚未处理。 |

| 203 | 非授权信息 | 服务器已成功处理了请求,但返回的信息可能来自另一来源。 |

| 204 | 无内容 | 服务器成功处理了请求,但没有返回任何内容。 |

| 205 | 重置内容 | 服务器成功处理了请求,但没有返回任何内容。 |

| 206 | 部分内容 | 服务器成功处理了部分 GET 请求。 |

| 3开头 (请求被重定向)表示要完成请求,需要进一步操作。 通常,这些状态代码用来重定向。 | ||

| 300 | 多种选择 | 针对请求,服务器可执行多种操作。 服务器可根据请求者 (user agent) 选择一项操作,或提供操作列表供请求者选择。 |

| 301 | 永久移动 | 请求的网页已永久移动到新位置。 服务器返回此响应(对 GET 或 HEAD 请求的响应)时,会自动将请求者转到新位置。 |

| 302 | 临时移动 | 服务器目前从不同位置的网页响应请求,但请求者应继续使用原有位置来进行以后的请求。 |

| 303 | 查看其他位置 | 请求者应当对不同的位置使用单独的 GET 请求来检索响应时,服务器返回此代码。 |

| 304 | 未修改 | 自从上次请求后,请求的网页未修改过。 服务器返回此响应时,不会返回网页内容。 |

| 305 | 使用代理 | 请求者只能使用代理访问请求的网页。 如果服务器返回此响应,还表示请求者应使用代理。 |

| 307 | 临时重定向 | 服务器目前从不同位置的网页响应请求,但请求者应继续使用原有位置来进行以后的请求。 |

| 4开头 (请求错误)这些状态代码表示请求可能出错,妨碍了服务器的处理。 | ||

| 400 | 错误请求 | 服务器不理解请求的语法。 |

| 401 | 未授权 | 请求要求身份验证。 对于需要登录的网页,服务器可能返回此响应。 |

| 403 | 禁止 | 服务器拒绝请求。 |

| 404 | 未找到 | 服务器找不到请求的网页。 |

| 405 | 方法禁用 | 禁用请求中指定的方法。 |

| 406 | 不接受 | 无法使用请求的内容特性响应请求的网页。 |

| 407 | 需要代理授权 | 此状态代码与 401(未授权)类似,但指定请求者应当授权使用代理。 |

| 408 | 请求超时 | 服务器等候请求时发生超时。 |

| 409 | 冲突 | 服务器在完成请求时发生冲突。 服务器必须在响应中包含有关冲突的信息。 |

| 410 | 已删除 | 如果请求的资源已永久删除,服务器就会返回此响应。 |

| 411 | 需要有效长度 | 服务器不接受不含有效内容长度标头字段的请求。 |

| 412 | 未满足前提条件 | 服务器未满足请求者在请求中设置的其中一个前提条件。 |

| 413 | 请求实体过大 | 服务器无法处理请求,因为请求实体过大,超出服务器的处理能力。 |

| 414 | 请求的 URl 过长 | 请求的 URl(通常为网址)过长,服务器无法处理。 |

| 415 | 不支持的媒体类型 | 请求的格式不受请求页面的支持。 |

| 416 | 请求范围不符合要求 | 如果页面无法提供请求的范围,则服务器会返回此状态代码。 |

| 417 | 未满足期望值 | 服务器未满足”期望”请求标头字段的要求。 |

| 5开头(服务器错误)这些状态代码表示服务器在尝试处理请求时发生内部错误。 这些错误可能是服务器本身的错误,而不是请求出错。 | ||

| 500 | 服务器内部错误 | 服务器遇到错误,无法完成请求。 |

| 501 | 尚未实施 | 服务器不具备完成请求的功能。 例如,服务器无法识别请求方法时可能会返回此代码。 |

| 502 | 错误网关 | 服务器作为网关或代理,从上游服务器收到无效响应。 |

| 503 | 服务不可用 | 服务器目前无法使用(由于超载或停机维护).通常,这只是暂时状态。 |

| 504 | 网关超时 | 服务器作为网关或代理,但是没有及时从上游服务器收到请求。 |

| 505 | HTTP 版本不受支持 | 服务器不支持请求中所用的 HTTP 协议版本。 |

137.请简单说一下三次握手和四次挥手?

[外链图片转存失败(img-ESdWuT4x-1567394093107)(/home/tarena/图片/三次握手.png)]

三次握手过程:

1 首先客户端向服务端发送一个带有 SYN 标志,以及随机生成的序号 100(0 字节)的报文

2 服务端收到报文后返回一个报文(SYN200(0 字节),ACk1001(字节+1))给客户端

3 客户端再次发送带有 ACk 标志 201(字节+)序号的报文给服务端至此三次握手过程结束,客户端开始向服务端发送数据.

1 客户端向服务端发起请求:我想给你通信,你准备好了么?

2 服务端收到请求后回应客户端:I’ok,你准备好了么

3 客户端礼貌的再次回一下客户端:准备就绪,咱们开始通信吧!

整个过程跟打电话的过程一模一样:1 喂,你在吗 2 在,我说的你听得到不 3 恩,听得到(接下来请开始你的表演)

补充:SYN:请求询问,ACk:回复,回应。

四次挥手过程:

由于 TCP 连接是可以双向通信的(全双工),因此每个方向都必须单独进行关闭(这句话才是精辟,后面四个挥手过程都是其具体实现的语言描述)

四次挥手过程,客户端和服务端都可以先开始断开连接

1 客户端发送带有 fin 标识的报文给服务端,请求通信关闭

2 服务端收到信息后,回复 ACK 答应关闭客户端通信(连接)请求