OPENCV2计算机视觉编程手册--第八章检测并匹配兴趣点

兴趣点(也叫做关键点或特征点)主要是指某些特殊的点,经过对它们执行局部分析,如果能够检测到足够多的这种点,同时它们区分度很高,并且可以精确定位稳定的特征。这类点被大量用于解决物体识别,图像匹配,视觉跟踪,三维重建等问题。

一、检测Harris角点

1.概念及原理

(1)角点:最直观的印象就是在水平、竖直两个方向上变化均较大的点。Harris观察一个假定的特征点周围小窗口内的方向性强度平均变化。如果我们考虑偏移量(u,v),它的平均强度变换为

即Harris测试的过程为:我们首先获取平均强度变化最大值对应的方向,接着检查位于它垂直方向的变化是否也很强烈,同时满足条件便是一个角点。用数学方式测试该条件的展开公式在此就不介绍了,有兴趣的查找相关资料。

2.实验

(1)检测并显示一幅图像的角点

cv::cornerHarris使用简单输出结果为浮点数类型的图像,其中每一项为对应位置的角点强度,之后可使用阈值化得到一组检测到的角点,得到结果为二值图像,加以反转

#include输入图像;

输出图像:

(2)观察到特征点检测器需要多个参数,难以调优。此外,获取的角点图形包含许多角点群,这与我们需要精准确定位点的事实矛盾。我将通过封装自定义类来改进角点检测的方法。

1、创建Harris检测器的对象

2、计算每个像素处的Harris值,然后进行局部极大值检测

3、基于特定阈值获取特征点。该类通过增加非极大值抑制步骤改进Harris角点检测的效果,

4、将检测到的点通过circle函数绘制处来

#include从经典的Harris角点检测方法不难看出,该算法的稳定性和k有关,而k是个经验值,不好把握,浮动也有可能较大。鉴于此,改进的Harris()方法直接计算出两个特征值,通过比较两个特征值直接分类,这样就不用计算Harris响应函数了。另一方面,我们不再用非极大值抑制了,而选取容忍距离:容忍距离内只有一个特征点。

该算法首先选取一个具有最大 最小特征值的点(即:max(min(e1,e2)),e1,e2是harris矩阵的特征值)作为角点,然后依次按照最大最小特征值顺序寻找余下的角点,当然和前一角点距离在容忍距离内的新角点被忽略。这便是cv::goodFeaturesToTrack实现的方法,它检测到的特征能用于视觉跟踪应用中的优质特征集合。

#include输入图像:

输出图像:

二、检测FAST特征

1.概念及原理

Harris算子是基于两个正交方向上的强度变化率提出了角点。而FAST特征算法对角点的定义有所不同,它定义基于假定特征点周围的图像强度,通过检查候选像素周围一圈像素来决定是否接受一个特征点。与中心差异较大的像素如果组成连续的圆弧,并且弧长大于圆周长度的3/4,那么我们认为找到一个特征点。和Harris特征相同的是可以在找到的角点上执行非极大值抑制,因此需要指定角点强度的测量方法。该算法可以获得非常快速的特征点检测,在需要考虑运行速度时可以选用,如高帧率的视频序列中进行视觉跟踪。

#include输入图像:

输出图像:

三、检测尺度不变的SURF特征

1.概念及原理

(1)通常由于尺度变化我们很难在不同图像之间匹配特征,如果我们尝试使用固定尺寸的相邻尺寸来匹配不同图像中的相同特征,由于尺度变化,强度模板并不会匹配。因此我们引入了尺寸不变特征即每个检测到的特征点都伴随着对应的尺寸因子,也就是SURF特征,加速鲁棒性特征。

(2)尺度不变特征应该即是空间域(图像中)上又是尺度域(在求到滤波器应用于不同尺度时获得)上的局部极大值。SURF的实现如下,首先对每个像素计算Hessian矩阵以得到特征,该矩阵测量一个函数的局部曲率,定义如下:

2.实验

(1)SURF算法检测特征

#includeSURF算法是SIFT的高效变种,SIFT也检测空间域及尺度域上的局部极大值作为特征,但是使用Laplacian滤波器相应而不是Hessian行列式,不同尺度的Laplacian通过Gaussian滤波器的差值进行计算。SIFT在空间和尺度上更加精确,但也更加耗时。

#include输入图像:

输出图像:

四、描述SURF特征

1.概念及原理

(1)描述子在图像匹配中尤其有用,如我们想匹配同一个场景中的两幅图像,首先我们检查每幅图像中的特征,然后提取它们的描述子。第一幅图像中的描述子向量都会与第二幅图像中的描述子进行比较,得分最高的一对描述子将视为那个特征的最佳匹配,该过程对于第一幅图像中的所有特征进行重复,这便是cv::BruteForceMatcher的基本策略。

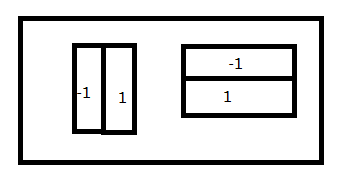

(2)优质的特征描述子必须在光照和视角发生轻微变化,并且受到图形噪点影响下具有不变性。它们通常基于局部强度差值,SURF描述子将在特征点周围较大范围内应用下图所示的简单核。

第一个核测量水平方向的局部强度差值(记为dx),第二个核测量垂直方向的差值(记为dy)。用于提取描述子向量的相邻区域的尺寸定义为特征尺寸因子的20倍(即20σ)。方形区域被分为4x4大小的较小子区域,对于每个子区域我们计算5x5整齐摆放的dx相应和dy响应(核的尺寸为2σ)。对所有这些相应求和,对每个子区域提取4个描述子的值。

2.实验

提取不同的特征点描述子

#include