说明

在playground上有一些二维数据分类的例子,也比较好玩,本文就是来探讨如何对最简单的数据进行分类。

1.生成随机数据

x1 = np.random.rand(100,2)*6

x2 = np.random.rand(100,2)*-6

x_ = np.vstack((x1,x2))

y1 = np.ones((100,1))

y2 = np.zeros((100,1))

y_ = np.vstack((np.hstack((y1,y2)),np.hstack((y2,y1))))

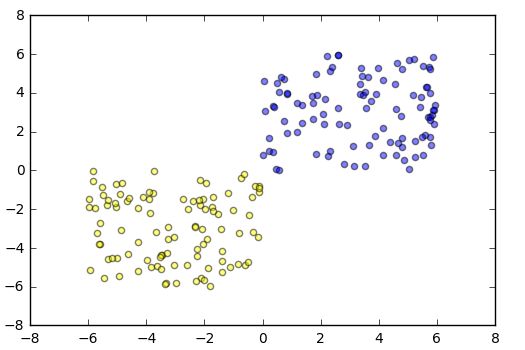

这里我随机生成了两百个样本数据,x_代表点的位置,y_是标签数据。这里标签数据的生成略显复杂,其实本质上就是进行行列合并操作。

为了方便观察这里将生成的数据在图上绘制出来,这里使用matplotlib

for i in range(200):

a,b = x_[i]

if y_[i,0] == 0:

plt.scatter(a,b,c='blue',alpha=0.5)

else:

plt.scatter(a,b,c='yellow',alpha=0.5)

2.构建神经网络

这里我们只有一个神经元,激活函数使用的是relu,这个跟playground是一样的。简单的分析一下这个网络的结构,输入是两个,隐含层是一个,输出是两个。

y1=relu(W1*x+b1)

y2=softmax(W2*y1+b2)

上面的乘法是矩阵乘法,根据分析W1是一个[1,2]的矩阵,b1是[1]矩阵,W2是[1,2]矩阵,b2也是[1,2]矩阵。

b1 = tf.Variable(tf.zeros([1,1],dtype=np.float32))

W1 = tf.Variable(np.random.rand(2,1).astype(np.float32))

y1 = activefun(tf.matmul(x,W1)+b1)

b2 = tf.Variable(tf.zeros([1,2]),dtype=np.float32)

W2 = tf.Variable(np.random.rand(1,2).astype(np.float32))

y2 = tf.nn.softmax(tf.matmul(y1,W2)+b2)

cross_entropy = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(logits=y2, labels=y))

#损失函数

train_step = tf.train.GradientDescentOptimizer(0.03).minimize(cross_entropy)

#优化算法

correct_prediction = tf.equal(tf.argmax(y2,1), tf.argmax(y,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

#精度

上面的代码构建了这个网络,这里要关注矩阵运算,很有可能出现问题。

3.运行和分析

运行的第一步是初始化变量,然后就是迭代。

sess = tf.Session()

sess.run(tf.global_variables_initializer())

for i in range(n):

sess.run(train_step)

if i%10 == 0:

print(sess.run([cross_entropy,accuracy]),i)

把上面的代码总结一下这里定义一个训练函数和一个预测函数:

def model(x,y,n,activefun=tf.nn.relu):

b1 = tf.Variable(tf.zeros([1,1],dtype=np.float32))

W1 = tf.Variable(np.random.rand(2,1).astype(np.float32))

y1 = activefun(tf.matmul(x,W1)+b1)

b2 = tf.Variable(tf.zeros([1,2]),dtype=np.float32)

W2 = tf.Variable(np.random.rand(1,2).astype(np.float32))

y2 = tf.nn.softmax(tf.matmul(y1,W2)+b2)

# cross_entropy = -tf.reduce_sum(y*tf.log(y2))/200.

cross_entropy = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(logits=y2, labels=y))

train_step = tf.train.GradientDescentOptimizer(0.03).minimize(cross_entropy)

correct_prediction = tf.equal(tf.argmax(y2,1), tf.argmax(y,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

sess.run(tf.global_variables_initializer())

for i in range(n):

sess.run(train_step)

if i%10 == 0:

print(sess.run([cross_entropy,accuracy]),i)

return sess.run([b1,W1,b2,W2])

def predict(x,b1,W1,b2,W2):

y1 = tf.nn.relu(tf.matmul(x,W1)+b1)

y2 = tf.nn.softmax(tf.matmul(y1,W2)+b2)

return y2

4.可视化

把结果计算之后,我们希望能看到这个分类边界,其实想法很简单,在坐标中等距离生成2500个点(50行50列),然后在预测函数中进行计算,根据计算结果绘制点的颜色。

bg = []

values = np.linspace(-6,6,num=50)

for i in range(50):

bg.append([[values[i], v] for v in values])

xx = np.array(bg).reshape(2500,2).astype(np.float32)

out = predict(xx,b1,W1,b2,W2)

yy = sess.run(tf.argmax(out,axis=1))

for i in range(2500):

a,b = xx[i]

if yy[i] == 0:

plt.scatter(a,b,c='blue',alpha=0.5)

else:

plt.scatter(a,b,c='yellow',alpha=0.5)