行人属性识别:Improving Pedestrian Attribute Recognition With Weakly-Supervised Multi-Scale Attribute……

参考文献:Tang CF, Sheng L, Zhang ZX, Hu XL. Improving Pedestrian Attribute Recognition With Weakly-Supervised Multi-Scale Attribute-Specific Localization[J].ICCV-2019.

代码实现:https://github.com/chufengt/iccv19_attribute

包括理解!

Improving Pedestrian Attribute Recognition With Weakly-Supervised Multi-Scale Attribute-Specific Localization

摘要

行人属性识别是视频监控领域的一个新兴研究课题。为了预测某一特定属性的存在,需要对与该属性相关的区域进行局部化。但是,在此任务中,数据集中没有属性特定区域标注,如何划分这些与属性相关的区域仍然是一个挑战。现有的方法采用属性不可知的视觉注意或启发式的身体部位定位机制来增强局部特征表达,而忽略了利用属性来定义局部特征区域(理解:目前主要用注意力机制和人体区域提议来关注局部特征,如头部、上半身、下半身,但是它们都不是针对属性来关注局部特征)。我们提出了一个灵活的Attribute Localization Module(ALM)自适应地发现最具判别力的区域,并在多尺度上学习每个属性的区域特征。此外,本文还提出了一种特征金字塔结构(类似于FPN的结构),利用高层语义指导来增强低层的属性定位。该框架不需要额外的区域标注(以STN实现),可以在多尺度的深度监督下进行端到端的训练。大量实验表明,该方法在PETA、RAP和PA-100K三个行人属性数据集上取得了最新的结果。

1 引言

行人属性识别如性别、年龄、服装风格等,因其在视频监控应用中的巨大潜力而受到广泛关注,如人脸验证[10]、人的检索[2,27]和人的重识别[11,22,30]。近年来,基于卷积神经网络(CNN)[6,8]的方法通过从图像中学习强大的特征,在行人属性识别方面取得了很大的成功。已有的一些工作[13,28]将行人属性识别作为一个多标签分类问题,仅从整个输入图像中提取特征表示,这些整体方法通常依赖于全局特征,而区域特征对于细粒度属性分类更为重要。

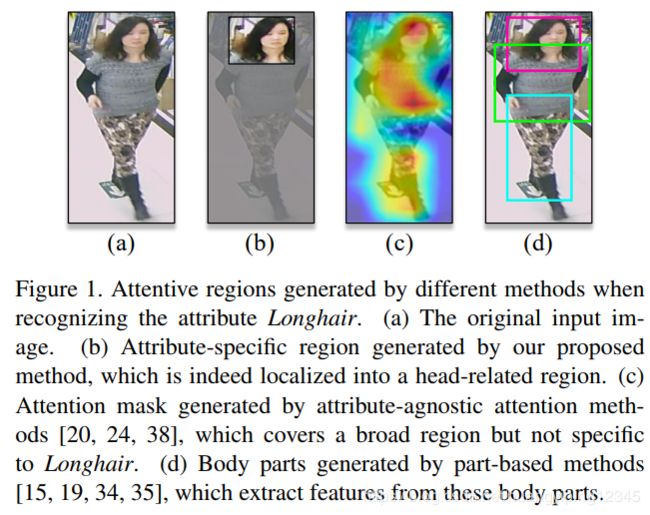

直观地说,属性可以定位到行人图像中的相关区域。如图1(b)所示,当识别长发时,有理由关注与头部相关的区域。最近的方法试图利用注意力定位来学习属性识别中的判别力特征,一种流行的解决方案[20,24,38]是使用视觉注意力机制来捕捉最相关的特征,这些方法通常是从某些层上生成attention masks,然后将它们相乘成相应的特征映射,从而提取出attention特征。然而属性给定区域的mask编码是不明确的,并且没有特定的机制保证属性和attention mask之间的对应,如图1(c)所示,学习到attention mask注意到一个不特定于所需属性(长发)的广泛区域。另一种方法是利用预定义rigid parts[40]或external part定位模块[15、19、34、35]。一些工作应用body-parts detection[35]、姿势估计[15,34]和人体区域建议[19]来学习基于part的局部特征,如图1(d)所示,这些方法从局部身体部位(如头部、上半身、下半身)提取局部特征。然而它们大多只是将基于part的局部特征与全局特征融合在一起,这仍然不能表示属性和区域之间的对应关系,但需要额外的计算资源来实现复杂的局部定位。(理解:注意力机制和人体区域提议网络都是得到广泛的人体局部,比如头部,头部的属性有很多个,比如头发、眼镜等,它们都不是针对属性得到局部区域,比如针对眼镜得到局部眼睛区域)

与这些方法不同,我们提出了一个灵活的Attribute Localization Module(ALM),它可以自动发现判别力区域,并以特定于属性的方式提取基于区域的特征表示。具体地说,ALM首先是一个微小的channel attention子网络,以充分利用输入特征的通道间依赖性,然后是空间变换器[9],以自适应地定位属性特定区域。此外,我们在不同的特征层嵌入了多个ALM(每个特征层有多少属性就有多少ALM),并引入了一种特征金字塔结构集成高层语义来增强低层的属性定位。此外,不同特征层的ALM由同一组称为深度监督(deep supervision)的属性监督训练,通过投票方案获得最终预测,以在不同特征层输出最大响应。该投票方案将建议在一个属性区域最精确的特征层上进行最佳预测,而不受不适当属性区域的特征层的负面干扰。提出的框架是端到端可训练的,只需要图像级的注释。这项工作的贡献可归纳如下:

• 我们提出了一个端到端可训练的框架,该框架在多个尺度上执行属性特定区域的定位,以弱监督的方式发现最具判别力的属性区域。

• 我们提出了一种特征金字塔结构,通过利用低级细节和高级语义,以相互加强的方式增强多尺度属性定位和基于区域的特征学习。通过有效的投票方案进一步融合多尺度属性预测。

• 我们对三个公开可用的行人属性数据集(PETA[1]、RAP[16]和PA-100K[20])进行了广泛的实验,并比以前的最新方法取得了显著的改进。

2 相关工作

2.1 行人属性识别

早期的行人属性识别方法[1,11,39]依赖于手工制作的特征,如颜色和纹理直方图,并分别进行训练,然而这些传统手工制作特征方法的性能远远不能令人满意。近年来,基于卷积神经网络的行人属性识别方法取得了很大的成功,Wang等人[31]简要回顾这些方法;Sudowe等人[28]提出一个整体的CNN模型来共同学习不同的属性;Li等人[13] 将行人属性识别问题转化为多标签分类问题,提出了一种改进的交叉熵损失函数。然而由于缺乏对属性先验信息的考虑,这些整体方法的性能受到限制。最近一些方法试图利用属性间的空间关系和语义关系来进一步提高识别性能。这些方法可分为三个基本类别:

• Relation-based:一些文献[29,37]利用语义关系来辅助属性识别。Wang等人[29]利用属性间的依赖性和相关性提出了一个基于CNN-RNN的框架;Zhao等人[37]将属性分成若干组,并尝试探索组内和组间的关系。然而,这些方法需要人工定义规则,如预测顺序、属性组等,在实际应用中很难确定。

• Attention-based:一些研究者[20,24,25,38]介绍了属性识别中的视觉注意机制。Liu等人[20] 提出了一种多方向注意模型,用于行人多尺度注意特征的学习分析;Sarafianos等人[24]扩展了spatial regularization module[38]以学习多尺度下的有效注意图。虽然识别精度有所提高,但这些方法都是属性不可知的,没有考虑到属性的具体信息。

• Part-based:基于part的方法通常从一些局部的身体部位提取特征。朱等人[40]将整个图像分割成15个rigid块,融合不同块的特征;Yang等人[34]和Li等人[15] 利用外部姿态估计模块定位身体部位;Liu等人[19] 在将属性区域预先分配给EdgeBoxes[42]生成的一些固定方案时,也要以弱监督的方式探索属性区域,这是不完全自适应和端到端可训练的。这些方法要么依赖于预定义的rigid parts,要么依赖于复杂的part localization机制,这些机制对姿态变化的鲁棒性较差,并且需要额外的计算资源。相比之下,本文方法以特定于属性的方式定位最具判别力的区域,在现有的大多数工作中都没有考虑。

2.2 弱监督Attention定位

除了行人属性识别之外,在其他计算机视觉任务中也广泛研究了无区域标注的注意力定位思想。Jaderberg等人[9] 提出了一种著名的空间变换网络(STN),该网络能够以端到端可训练的方式提取任意空间变换的注意区域;最近的一些研究[14,17]采用STN对人体部位进行定位,以便于重新识别;Fu等人[3] 尝试将递归学习用于细粒度图像识别的判别区域;Wang等人[33]使用STN和LSTM搜索判别力区域以进行多标签分类,而不是以标签特定的方式。本文方法受这些工作的启发,能够自适应地对每个属性的单个信息区域进行定位。

2.3 特征金字塔结构

有几项工作利用自上向下或跳远连接,这些连接包含了不同层的特征,例如U-Net[23],Stacked hourglass network[21]。本文的特征金字塔结构类似于特征金字塔网络(FPN)[18],FPN已经在各种目标检测和分割模型中进行了研究[26,41]。据我们所知,这项工作是第一次尝试利用FPN思想来定位行人属性识别的注意区域。

3 本文方法

• 本文框架如图2所示,该框架由一个具有特征金字塔结构的主网络和一组应用于不同特征层的属性定位模块(ALM)组成,首先将无需额外区域标注的行人图像输入到主网络中,然后在自底向上的路径末端获得预测向量。ALM的详细信息如图3所示,每个ALM只对单个特征层的一个属性执行属性定位和基于区域的特征学习,对不同特征层的ALMs进行了深度监督训练。

• 形式上,给定输入行人图像 I I I及其相应的属性标签 y = [ y 1 , y 2 , … , y M ] T y=[y^1,y^2,…,y^M]^T y=[y1,y2,…,yM]T,其中, M M M是数据集里的属性总数量, y m , m ∈ 1 , . . . , M y^m,m ∈ 1, . . . , M ym,m∈1,...,M是一个二进制标签,如果属性 m m m存在 y m = 1 y^m=1 ym=1,否则 y m = 0 y^m=0 ym=0。

• 我们采用BN-Inception[8]架构作为我们框架中的骨干网络,原则上骨干网可以替换为任何其他CNN架构,实施细节见附录A。

3.1 网络结构

以下内容都是与FPN相似的特征金字塔

这项工作的核心思想是对属性特定区域进行定位来提高属性识别能力。众所周知,CNN的深层特征具有较粗的分辨率,尽管我们可以基于语义较强的特征精确地定位属性区域,但由于某些细节可能会消失,提取基于区域的判别力特征仍然很困难。相比之下,底层特征总是捕捉到丰富的细节,而语义信息差导致属性定位不可靠。显然,底层细节和高层语义是相辅相成的。因此,在FPN模型的启发下,我们提出了一种特征金字塔结构,以增强属性定位和基于区域的特征学习。如图2所示,提出的特征金字塔体系结构由自下而上的路径和自上而下的路径组成。

以BN-Inception为骨干网络实现自底向上路径,有不同的特征层,每个特征层包含多个inception块。本文分别从incep_3b、incep_4d和incep_5b三个不同层生成自底向上的特征,对输入图像进行{8、16、32}strides的属性定位。选定的起始块都处于对应阶段的末尾,相同阶段的块保持相同的特征映射分辨率,因为我们认为最后一个块应该具有最强的特征。在给定输入图像 I I I的情况下,我们将生成的自底向上特征表示为 φ i ( I ) ∈ R H i × W i × C i , i ∈ 1 , 2 , 3 φ_i(I)∈R ^{H_i×W_i×C_i},i∈{1,2,3} φi(I)∈RHi×Wi×Ci,i∈1,2,3。对于256×128的RGB输入图像,空间大小 H i × W i H_i×W_i Hi×Wi分别为32×16、16×8和8×4。

此外,自上而下的路径包含三个横向连接和两个自上而下的连接,如图2所示。横向连接只是用来将自底向上特征的通道降到d,在我们的实现中,其中d=256。更高级的特征通过自顶向下的连接进行传输,同时进行上采样操作。随后,相邻层的特征连接如下:

3.2 属性定位模块

如第1节所述,现有的一些方法试图通过与属性无关的视觉注意力机制、预定义rigid parts或external part定位模块来提取局部特征。然而,这些方法并不是最优解,因为它们忽略了属性特定区域定位的重要性。如图1(c,d)所示,将属于不同属性的注意区域混合在一起,这与缩小注意区域以提高属性识别的初衷不一致。我们认为,属性定位是一个更好的选择,因为它可以将混淆的注意区域分为几个单独的区域,每个区域对应一个特定的属性。此外,由于我们可以直观地观察属性和区域的对应关系,因此学习到的属性特定区域更易于解释。我们需要的是一种机制,它可以在给定属性的特征映射中学习表示判别力区域的单个边界框。众所周知的RoI pooling技术[4]是不合适的,因为它需要区域标注,这在行人属性数据集中是不可用的。受空间变换网络(STN)[9]最近的成功启发,我们提出了一个灵活的属性定位模块(ALM),以弱监督的方式自动发现每个属性的判别力区域,属性定位模块如图3所示。

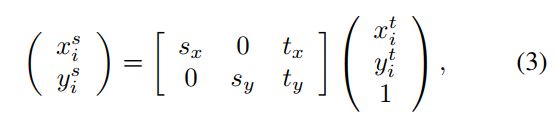

如图所示,每个ALM包含一个源于STN的空间转换器层。STN是一个可微的模块,它能够将空间变换应用于特征图,例如裁剪、平移和缩放。本文采用STN的一个简化版本,将属性区域看作一个简单的边界框,可以通过以下转换来实现:

其中 s x s_x sx, s y s_y sy为缩放参数, t x t_x tx, t y t_y ty为平移参数,通过这四个参数可以得到期望的边界框。 ( x i s , y i s ) (x_i^s,y_i^s) (xis,yis)和 ( x i t , y i t ) (x_i^t,y_i^t) (xit,yit)是第i个像素的源坐标和目标坐标。在某种程度上,这种简化的空间变换器可以看作是一个可微的RoI pololing,它可以在没有区域标注的情况下进行端到端的训练。为了加速收敛,我们简单地通过sigmoid和tanh来激活,限制 s x s_x sx, s y s_y sy为(0,1)和 t x t_x tx, t y t_y ty为(-1,1)。

此外,我们还引入了一个微型channel-attention子网络,如图3所示。如上所述,ALM将来自相邻层的特征组合作为输入,其中更精细的细节和强语义都占相同的比例(都有d个通道),这意味着它们对属性定位的贡献相同。然而,理想的比例应该因属性而异,例如识别更精细的属性时,应该贡献更多的细节特征。因此,我们引入类似于SE-Net的channel-attention子网络来调节通道间的依赖关系。

具体地说,输入特征 X i X_i Xi通过一系列线性和非线性层,产生用于跨通道特征重新校准的权重向量,再加权特征是通过将权重向量与 X i X_i Xi按通道相乘获得的,并且加上额外的链接来保持互补信息。然后,利用全连接层估计变换矩阵R,计算双线性插值采样的基于区域的特征进行属性分类。我们简单地将属于第 i i i层属性 m m m的预测表述为:

3.3 深度监督

如图2所示,从三个ALM组和一个全局分支获得四个单独的预测向量。我们采用深度监督[12,32]机制进行训练,其中四个单独的预测由真实标签直接监督。在推理过程中,多个预测向量通过一个有效的投票方案聚合,该方案在不同的特征层上产生最大的响应。这种设计的初衷是,每个ALM都应该直接接受局部区域是否准确的反馈。如果我们只保留对融合预测(最大值或平均值)的监督,则梯度对于每个特征层的执行情况没有足够的信息,因此某些分支的训练不足。采用最大投票方案从属性区域最精确的不同层次中选择最优预测。(理解:训练时每个尺度都计算损失,推理时采用最大投票方案选择最大值)

具体来说,我们在每个阶段采用加权二元交叉熵损失函数[13],公式如下:

4 实验

4.1 数据集和评价指标

该方法在三个公开的行人属性数据集上进行了评价:• PETA数据集[1]由19000个图像组成,其中61个为二值属性,4个为多值属性。根据前面的工作[1,25],整个数据集被随机分成三个子集:9500用于训练,1900用于验证,7600用于测试。选择正例比例大于5%的35个属性进行评价。• RAP数据集[16]包含从26个室内监视摄像机收集的41585个图像,其中每个图像用72个细粒度属性进行注释。根据官方协议[16],我们将整个数据集分成33268个训练图像和8317个测试图像。选择正例比例大于1%的51个属性进行评价。• PA-100K数据集[20]是迄今为止用于行人属性识别的最大数据集,其中包含从室外监控摄像头收集的总共100000张行人图像,每张图像都有26个常用属性。根据官方设置[20],整个数据集随机分为80000个训练图像、10000个验证图像和10000个测试图像。

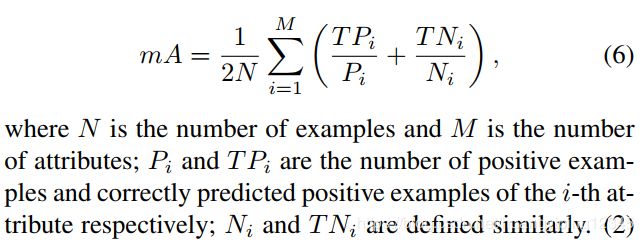

我们采用两种类型的指标进行评价[16]:• 基于标签:计算平均准确度(mA)作为每个属性的正准确度和负准确度的平均值。• 基于实例:我们采用了四个众所周知的标准,accuracy、precision、召回率和F1分数。mA标准可以表述为:

4.2 关键部分的有效性

如表1所示,从BN-Inception基线开始,我们逐渐附加每个关键部分,将其与几个变化模型进行比较。• Attribute Localization Module:我们首先通过在最后一层(incep_5b)嵌入ALM来评估简化ALM(无channel-attention子网络)的贡献,mA和F1分数的增加说明了属性定位的有效性。在此基础上,我们进一步在不同的特征层(incep_3b、4d、5b)嵌入了多个ALM,并取得了较大的改进(mA和F1分别为3.1%和1.3%)。考虑到模型的复杂性,我们将框架中的特征层限制为3。• 自上而下的指导:我们通过比较三个不同的变化模型,来评估所提出的特征金字塔结构的影响,这三个变化模型在如何组合不同层的特征方面是不同的。第一个是通过相加不同层element-wise的特性来实现的,比如原始的FPN[18],但是性能下降了。结果表明,如果忽略特征比例失配问题,一些基本信息可能会丢失。改进后的concatenation方案取得了较好的效果(mA提高了1.0%),说明了高层自顶向下指导的成功。(理解:Top-down(Addittion)是像FPN一样,把各个层特征的通道相加,把特征融合在一起,就没有各个尺度的比例;Top-down(Concatenation)是把各个层特征的通道contact)此外,引入的channel-attention子网络通过调节通道间的依赖性,进一步将mA提高了80.61%。• 深度监督:如第3.3节所述,仅监督融合预测得到的梯度信息不足以说明每个层的执行情况,导致一些特征层的训练不足,针对这一问题,对每个层的ALMs进行了深度监督训练。实验结果表明,与平均方法相比,最大值element-wise是一种更好的集成方法,因为在平均中忽略了一些较弱的存在性。• 删除所有ALMs而保持其他不变会导致显著下降(表1的最后一行),这进一步证实了ALM的有效性。

与基线相比,最终模型取得了显著的性能,在mA和F1指标上分别提高了6.1%和1.9%。图4显示了在RAP数据集上所建议的方法和基线模型之间的在attribute-wise的mA比较,结果表明,该方法对一些属性,特别是一些细粒度的属性,如BaldHead秃头(23.1%)、帽子(12.4%)和Muffler围巾(13.5%)都有显著的改进,对这些属性的准确识别表明了本文提出的属性定位模块的有效性。

4.3 属性定位可视化

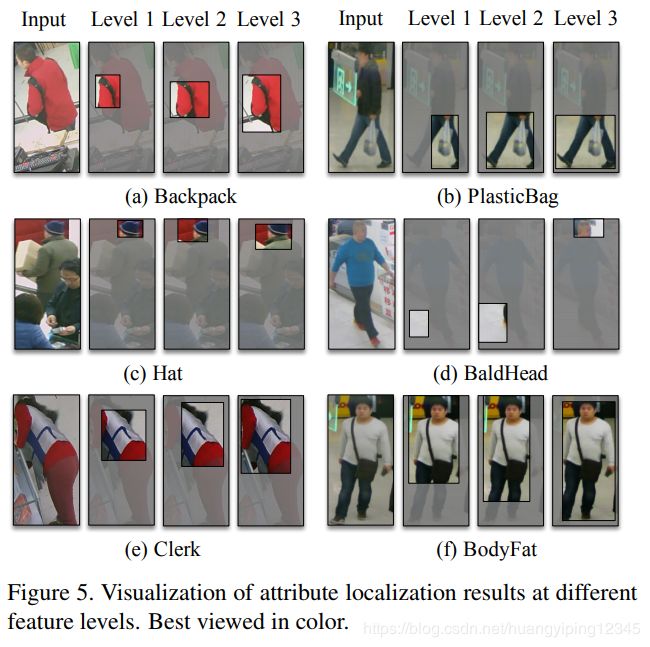

通过上述定量评价,我们可以观察到一些细粒度属性有了显著的改进。在这一小节中,我们从不同的特征层来可视化属性局部区域以进行定性分析。在我们的实现中,属性区域位于特征maps内,而特征图像素与输入图像像素之间的对应关系不是唯一的。对于相对粗糙的可视化,我们只需SPPNet[5]一样,将feature-level像素映射到输入图像上的中心。如图5所示,我们显示了六个不同属性的示例,包括抽象属性和具体属性。正如我们所看到的,所提出的ALMs能够成功地将这些具体属性,例如背包、塑料袋和帽子,定位到相应的信息区域,尽管存在极端的遮挡(a,c)或姿势变化(e)。在识别更抽象的属性Clerk和BodyFat时,ALMs倾向于探索更大的区域,因为它们通常需要从整个图像中获取高级语义。此外,还提供了一个错误案例,如图5(d)所示。在识别BaldHead秃头时,ALMs无法将期望区域定位在两个较低的特征层。我们认为这个问题源于高度不平衡的数据分布,在RAP数据集中只有0.4%的图像被BaldHead注释。虽然这些局部属性区域相对粗糙,但仍然可以用于识别属性,因为它们确实捕获了这些具有较大重叠的最具判别力区域。

4.4 不同的Attribute-Specific方法

这项工作最重要的贡献是为每个属性定位一个单独的信息区域,我们称之为Attribute-Specific的,在以前的工作中没有得到很好的研究。在本小节中,我们将通过与其他特定属性的定位方法(如视觉注意力机制和预定义parts)进行比较,以实验来证明我们提出方法的优势。与图1中所示的属性不可知的注意力机制和身体parts不同,我们将它们扩展到属性特定的版本进行比较。对于注意力机制,我们用一个空间注意模块来代替所提出的ALM,同时保持其他模块不变,以便进行公平的比较。具体来说,我们像HA-CNN[17]一样,通过一个全局cross-channel averaging layer和一个3×3卷积层,为每个属性生成单独的注意masks。对于预定义parts,我们将整个图像分成三个固定部分(头部、上半身和下半身),并使用RoI pooling层提取基于part的特征,然后手动定义attribute-part的关系,例如仅从头部部分识别帽子。关于比较方法的更多细节见附录B。实验结果见表2,如预期的那样,所提出的方法在很大程度上优于其他两种方法(在mA中分别提高了5.3%和3.5%)。

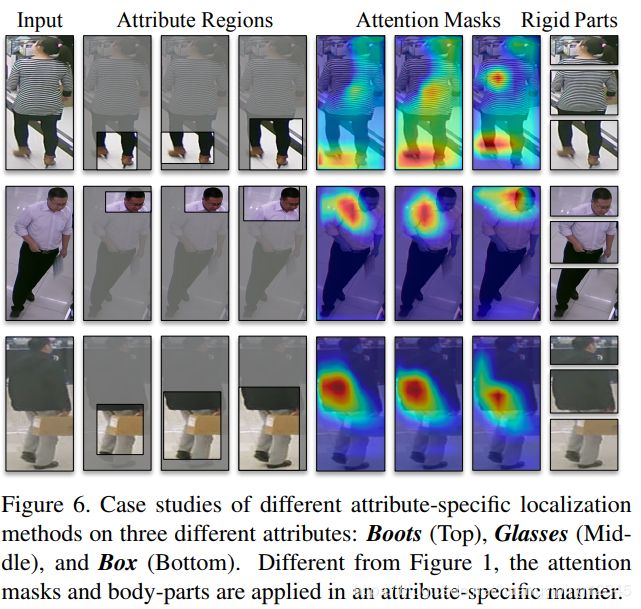

为了更好地理解这些差异,我们在图6中可视化了这些定位结果。我们可以看到,由ALMs生成的属性区域是最精确和最有区别的。虽然注意力机制模型取得了不错的效果,但是生成的注意masks可能会注意到不相关或偏离的区域。预定义parts获得的识别框不能覆盖全部的预期区域,而且还将几乎相同的区域定位在不同的输入图像上。相比之下,本文方法能够成功地处理位置不确定性和姿态变化。我们在图S4中提供了更多的可视化结果。

在某种程度上,注意masks和刚性parts处于两个极端。前者试图以高度自适应的方式完全覆盖信息像素,但由于我们只有图像级的标注,因此大部分都失败了。后者完全抛弃了自适应因素,对姿势变化的鲁棒性较差。因此,本文方法试图将注意区域限制在几个相对粗糙但更具解释性和可控性的边界框上,在这两个极端之间取得平衡。

4.5 与最先进方法比较

在本小节中,我们将所提出方法与几种最先进方法进行性能比较。如第2节所述,我们将这些方法分为四类:• 整体方法利用CNN联合学习多个属性,包括ACN[28]和DeepMar[13]。• 基于关系的方法通过CNN-RNN获得语义关系,包括JRL[29]和GRL[37]。• 基于注意的方法包括基于多尺度注意机制的HP-Net[20]和DIAA[19]以及通过coarse视图预测器执行view-specific属性预测的VeSPA[25]。• 基于parts的方法依赖于外部姿态估计或人体区域建议模块,包括最近提出的PGDM[15]和LG Net[19]。

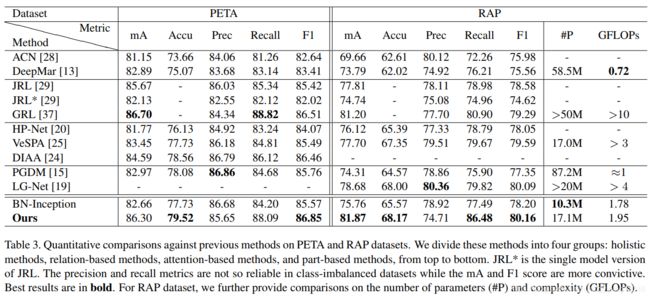

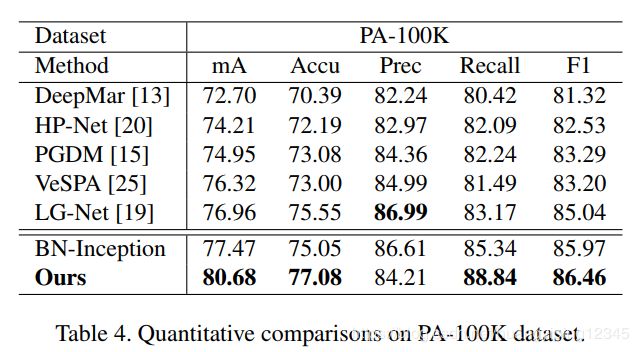

表3和表4显示了三个不同数据集的比较结果。结果表明,与现有方法相比,本文提出方法在三个数据集上都取得了更好的性能。与以往依赖于属性不可知的注意力机制或part定位机制的方法相比,本文方法能在所有数据集上实现显著的改进,证明了attribute-specific定位的有效性。尽管在PETA数据集上取得的mA分数比基于关系的GRL方法略低,但GRL方法具有更强的Inception-v3骨干网络(参数是我们的两倍),我们仍然可以在其他度量和数据集上优于GRL方法。在更具挑战性的数据集PA-100K上,所提出的方法大大优于所有先前的工作,在mA和F1中分别比次优结果提高了3.7%和1.4%。值得注意的是,所提出的方法显著超过了基线模型,特别是基于标签的度量mA(在三个数据集上分别为3.6%、6.1%和3.2%)。请注意,所提出方法通常获得较低精度但具有较高召回率,而这两个指标并不那么可靠,特别是在类不平衡数据集中。此外,这两个度量是负相关的,即一个度量的增加总是导致另一个度量的减少(例如,通过调整损失函数中的类权重),mA和F1度量更适合于度量属性识别模型的性能,我们的方法在这两个度量中始终取得最佳结果。

我们提供了RAP数据集上不同方法(表3中最右边的列)的计算成本比较。对于参数的数量,理论上,每个ALM中都有 ( C 2 / 8 + 4 C ) (C^2/8+4C) (C2/8+4C)可训练的参数: 4 C 4C 4C来自STN模块, C 2 / 8 C^2/8 C2/8来自channel-attention模块,其中 C C C是输入通道的数量。如表中所示,所提出的模型比以前的模型具有更少的可训练参数,就模型复杂度而言,即使有51个属性,由于相比骨干网中只增加了0.17个GFLOPs,因此该模型仍然是轻量级的。原因是ALM只包含FC层(或1×1 Conv),这比3×3卷积层涉及的参数要少得多。总的来说,整个模型比以前的模型效率高很多。

5 结论

我们提出了一个端到端的行人属性识别框架,可以在多个特征层上自动定位attribute-specific区域。此外,我们应用特征金字塔架构,以互相增强的方式来加强属性定位和基于区域的特征学习。在PETA、RAP和PA-100K数据集上的实验结果表明,该方法可以显著地优于现有的大多数方法。大量的分析表明,该方法能够以弱监督的方式成功地对每个属性的信息量最大区域进行定位。

附录A 实现细节

我们采用从ImageNet中预训练的BN-Inception模型作为骨干网络。提出的框架是用PyTorch框架实现的,并且只训练了图像级标注。我们采用Adam优化器,因为在momentum为0.9,权值衰减为0.0005的实验中,它的收敛速度比SGD快。初始学习率等于0.0001,批大小设置为32。对于RAP和PA-100K数据集,我们对模型进行了30个epoch的训练,学习率每10个epoch下降0.1。对于较小的PETA数据集,我们将训练时间加倍。在数据预处理方面,我们将输入的行人图像大小调整为256×128,并采用随机水平翻转和数据混淆进行数据增强。

附录B 不同的Attribute-Specific方法

在第4.4节中,我们将所提出的方法与其他两种特定属性的定位方法(包括视觉注意和刚性part)进行了比较。与现有的基于注意力和基于part的方法不同,我们基于这些思想建立了两个属性特定的模型进行比较。这里我们将展示比较模型的详细信息。

注意力机制模型:我们用一个空间注意模块来代替提议的ALM,同时保持其他模块不变,以便进行公平的比较。空间注意模块由一个3层的小型子网络实现,如图S2所示,其灵感来自HA-CNN[17]。第 i i i层(骨干网中的某一层,共三层)输入特征 X i ∈ R H × W × C X_i∈R^{H×W×C} Xi∈RH×W×C首先输入到cross-channel averaging层,接着是一个3×3conv-BatchNorm-ReLU块来生成预期的注意mask S i m ∈ R H × W × 1 S_i^m∈R^{H×W×1} Sim∈RH×W×1,该mask用于定位第 i i i层第 m m m个属性区域,所有通道共享相同的空间注意mask,最后通过通道将注意mask与输入特征相乘来获得注意特征,预测结果的计算如下:

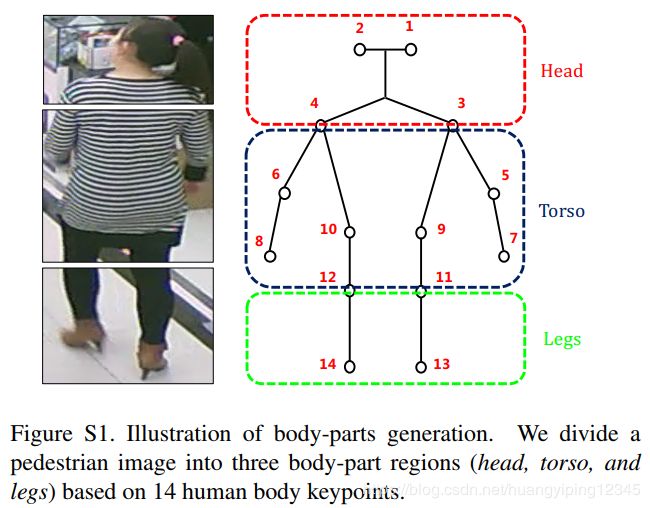

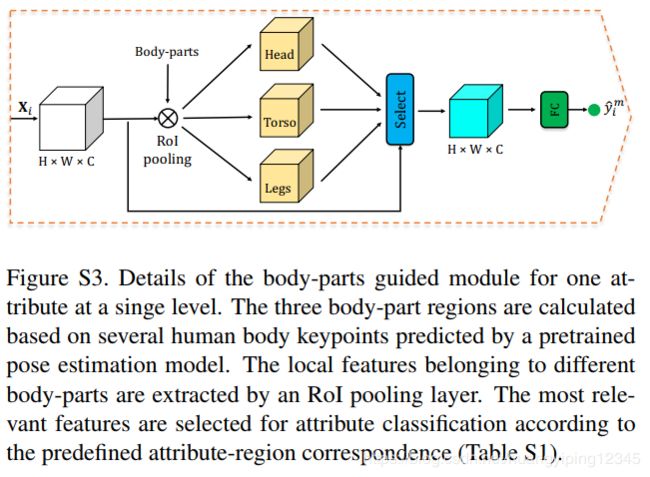

刚性parts模型:对于基于parts的attribute-specific模型,我们将ALM替换为一个由身体parts引导的模块,如图S3所示。关键思想是将每个属性与整个图像的预定义身体区域(包括头部、上半身、下半身)相关联(例如,长发属性与头部部分相关联)。由于在大多数行人属性数据集上,人体部位标注是不可用的,因此我们采用了一种外部姿态估计模型来定位人体部位,这是受到SpindleNet[36]的启发。具体来说,我们使用预先训练的姿势估计模型为每个行人图像定位14个人体关键点[36],然后根据这些关键点将行人图像划分为三个身体部位区域,如图S1所示。在body-parts 引导模块(图S3)中,基于body-part的局部特征通过RoI pooling层从输入特征 X i X_i Xi中提取出来[4]。对于属性预测,如表S1所示,根据属性和区域的对应关系选择最相关的特征,例如,仅使用来自头部的特征识别帽子。