DOTA: A Large-scale Dataset for Object Detection in Aerial Images 翻译

DOTA:用于航空图像中目标检测的大规模数据集

原文:https://arxiv.org/pdf/1711.10398.pdf

官网:https://captain-whu.github.io/DOTA/

dataset:https://captain-whu.github.io/DOTA/dataset.html

Abstract

对象检测是计算机视觉中一个重要且具有挑战性的问题。 尽管过去十年见证了自然场景中物体检测的重大进步,但这种成功对于航空影像而言却是缓慢的,这不仅是由于地球表面物体的规模,方向和形状的巨大差异,而且还因为空中场景中经过注释的数据集的稀缺性。 为了推进“Earth Vision”(也称为“地球观测和遥感”)中的对象检测研究,我们引入了用于航空图像中对象检测的大型数据集(DOTA)。 为此,我们从不同的传感器和平台收集了2806个航拍图像。 每个图像的大小约为4000×4000像素,并包含各种比例,方向和形状的对象。 这些DOTA图像由航空图像解释专家使用15种常见对象类别进行注释。 完全注释的DOTA图像包含188,282个实例,每个实例都由任意(8 d.o.f.)四边形标记。 为了建立Earth Vision中物体检测的基准,我们在DOTA上使用最新物体检测算法进行评估。 实验表明,DOTA很好地代表了真实的Earth Vision应用,并且具有很大的挑战性。

1 Introduction

Earth Vision中的对象检测是指在地球表面上定位感兴趣的对象(例如,车辆,飞机)并预测其类别。 与常规的对象检测数据集不同,在常规的对象检测数据集中,对象通常由于重力而朝上,而航拍图像中的对象实例通常以任意方向出现,如图1所示,具体取决于Earth Vision平台的角度。

广泛的研究致力于航空影像中的物体检测[3,14,17–19,21,23,30,31,38],利用了计算机视觉的最新进展并考虑了地球视觉应用的高要求。 这些方法中的大多数[3,18,31,38]尝试将针对自然场景开发的对象检测算法转移到航空影像领域。 最近,在基于深度学习的对象检测算法取得成功的推动下,Earth Vision研究人员采用了基于在大规模图像数据集上pre-trained的fine-tuning网络的方法(例如ImageNet [6]和MSCOCO [13]) 用于空中领域的检测,请参见例如 [2,3,18,29]。

尽管这种基于微调的方法是探索的合理途径,但是如图1所示的图像显示,航空图像中的对象检测任务在以下方面与常规的对象检测任务有所区别:

-

航空影像中对象实例的比例变化很大。 这不仅是由于传感器的空间分辨率,还在于同类物体的尺寸差别。

-

如图1所示,许多小物体实例拥挤在空中图像中,例如港口的船只和停车场中的车辆,而且,空中图像中实例的频率不平衡,例如,某些小尺寸例如1k×1k)图像包含1900个实例,而一些大尺寸(例如4k×4k)图像可能仅包含少量小实例。

-

航空影像中的物体通常以任意方向出现。 也有一些纵横比非常大的实例,例如桥梁。

除了这些不同的困难外, Earth Vision中的物体检测研究还受到众所周知的data bias问题的挑战[28],即整个数据集的普遍化程度通常较低。 为了减轻这种偏差,数据集的注释应该反映现实应用的需求。

因此,从自然图像中学到的物体检测器不适用于航空图像也就不足为奇了。 但是,现有的带注释的数据集用于航空图像中的对象检测,例如UCAS-AOD [40]和NWPU VHR-10 [2],倾向于在理想条件下使用图像(清晰的背景并且没有密集分布的实例),无法充分反映问题的复杂性。

为了推进 Earth Vision 中的目标检测研究,本文介绍了一种用于航空影像中目标检测的大型数据集(DOTA:Dataset for Object deTection in Aerial images )。 我们通过众包从不同的传感器和平台收集了2806个航拍图像。 每个图像的大小约为4000×4000像素,并包含不同比例,方向和形状的对象。 这些DOTA图像由航空图像解释专家针对15种常见对象类别进行注释。 完全注释的DOTA数据集包含188,282个实例,每个实例都由一个oriented bounding box标记,而不是像在自然场景中通常用于对象注释的 axis-aligned (轴对齐)的边界框。 这项工作的主要贡献是:

-

据我们所知,DOTA是Earth Vision中类别最多的带注释的最大对象数据集。 它可以用于开发和评估航空影像中的物体检测器。 我们将继续更新DOTA,以扩大规模和范围并反映不断变化的现实条件。

-

我们还在DOTA上对最先进的对象检测算法进行了基准测试,可以将其用作将来算法开发的基准。

除了推进Earth Vision中的对象检测研究之外,DOTA还将对计算机视觉中的常规对象检测提出有趣的算法问题。

图1:An example taken from DOTA . (a)DOTA中的典型图像由多个类别的多个实例组成。(b)在实例的方向和大小上说明该种类。(c),(d)分别为稀疏实例和拥挤实例的图示。 在这里,我们显示了DOTA中15种可能的类别中的4种。 (b)(c)(d)是从源图像(a)中裁剪中所示的示例。 直方图(e)(f)展示了实例在DOTA中相对于大小和方向的分布。

2 Motivations

近年来,数据集在数据驱动的研究中发挥了重要作用[6,13,32,35,37,39]。 像MSCOCO [13]这样的大型数据集在促进对象检测和图像字幕研究方面发挥了作用。 对于classification task和scene recognition task,ImageNet [6]和Places [39]也是如此。

然而,在空中物体检测中,缺少在图像数量和详细注释方面都类似于MSCOCO和ImageNet的数据集,这成为Earth Vision研究的主要障碍之一,特别是对于开发基于深度学习的算法。 空中物体检测对于车辆计数,远程物体跟踪和无人驾驶非常有用。 因此,尽可能地接近实际应用的大规模且具有挑战性的航空物体检测基准对于促进该领域的研究势在必行。

我们认为一个好的航空图像数据集应该具有四个属性,即:

1)大量图像,

2)每个类别有很多实例,

3)正确定向的对象注释以及

4)许多不同的对象类别,这使其能够应用到现实世界中。 但是,现有的航空图像数据集[15,17,24,40]有几个共同的缺点:数据和类别不足,缺少详细的注释以及图像分辨率低。 而且,它们的复杂性不足以视为对现实世界的反映。

表1:航空影像中DOTA和物体检测数据集之间的比较。 BB是边界框的缩写。 One-dot表示仅提供实例中心坐标的注释, 不考虑细分类。 例如,DOTA包含15个不同的类别,但只有14个主要类别,因为小型车辆和大型车辆都是车辆的子类别。

TAS [9],VEDAI [24],COWC [20]和DLR 3K Munich Vehicle [15]等数据集仅关注车辆。 UCAS-AOD [40]包含车辆和飞机,而HRSC2016 [17]仅包含船舶,即使给出了细粒度的类别信息。 所有这些数据集的类别数量都很短,这限制了它们在复杂场景中的适用性。 相反,NWPU VHR-10 [2]由十种不同的对象类别组成,而其实例总数仅为3000个左右。这些现有数据集的详细比较如表1所示。与这些航空数据集相比,正如我们将在第4节中看到的那样,DOTA面临着巨大的物体实例,任意但分布良好的方向,各种类别和复杂的航空场景的挑战。 此外,DOTA中的场景与自然场景相吻合,因此DOTA对于实际应用更加有用。

当涉及通用对象数据集时,由于图像数量众多,类别众多且注释详尽,ImageNet和MSCOCO受到研究人员的青睐。 在所有对象检测数据集中,ImageNet的图像数量最多。 但是,每个图像的平均实例数远少于MSCOCO和我们的DOTA,此外还有其干净的背景和精心选择的场景的局限性。 DOTA中的图像包含大量的对象实例,其中一些具有1000多个实例。 PASCAL VOC数据集[7]在每个图像和场景的实例上与ImageNet相似,但是图像数量不足使得它不适合处理大多数检测需求。 我们的DOTA在实例编号和场景类型方面类似于MSCOCO,但是DOTA的类别不如MSCOCO那样多,因为在航空影像中可以清晰看到的物体非常有限。

此外,使DOTA在上述大型通用对象检测基准中独树一帜的是,DOTA中的对象都标注有合适的oriented bounding boxes(简称OBB)。 OBB可以更好地封闭对象并区分拥挤的对象。 使用OBB在航空影像中标注对象的好处将在第3节中进一步介绍。我们在DOTA,PASCAL VOC,ImageNet和MSCOCO之间进行了比较,在表2中显示差异。

表2:DOTA与其他一般物体检测数据集之间的比较。 BBox是边界框的平均值。 BBox数量表示每个图像的平均包围盒数量。 请注意,对于每个图像的平均实例数,DOTA大大超过了其他数据集

3 Annotation of DOTA

3.1 Images collection

如[5]中所述,在航拍图像中,使用的传感器的分辨率和种类是产生数据集偏差的因素。 为了消除偏差,我们从具有多个分辨率的多个传感器和平台(例如Google Earth)中收集了我们数据集中的图像。 为了增加数据的多样性,我们收集了由航空影像解释专家精心挑选的多个城市拍摄的影像。 我们记录该位置的确切地理坐标和每个图像的捕获时间,以确保没有重复的图像。

3.2 Category selection

在我们的DOTA数据集中选择并标注了15种类别,包括飞机,轮船,储罐,棒球场,网球场,篮球场,地面跑道,港口,桥梁,大型车辆,小型车辆,直升机,环形交叉路口,足球场和篮球场。

类别由航空影像解释专家根据一种物体是否常见及其在现实应用中的价值来选择。 前10个类别在现有数据集中是常见的,例如[2,15,20,40]。除了将车辆进一步分为大类和小类之外,我们将它们全部保留,因为这两个子类之间在航空影像中存在明显差异。 其他的主要是从实际应用中的值导致的。 例如,考虑到移动物体在航空影像中的重要性,我们选择直升机。 选择环岛是因为它在道路分析中起着重要的作用。

是否考虑“stuff”类别是值得讨论的。正如SUN的数据集[33]所示,“stuff”类别通常没有明确的定义(例如,港口、机场、停车场)。但是,它们提供的上下文信息可能有助于检测。我们只采用了港口类别,因为它的边界相对容易定义,并且在我们的图像源中有大量的港口实例。最后一个扩展类别是足球场。

在图2中,我们将DOTA类别与NWPU VHR-10 [2]进行了比较,后者在以前的空中物体检测数据集中具有最多的类别。 请注意,DOTA不仅在类别编号上超过了NWPU VHR-10,而且在每个类别上的实例数也超过了NWPU VHR-10。

3.3 Annotation method

我们考虑了不同的注释方式。 在计算机视觉中,许多视觉概念(例如region descriptions, objects, attributes, and relationships)都和bounding box有关,如[12]所示。 边界框的常见描述是(xc,yc,w,h),其中(xc,yc)是中心位置,w,h分别是边界框的宽度和高度。

没有很多方向的对象可以使用此方法进行适当注释。 但是,以这种方式标记的边界框无法准确或紧凑地勾勒出oriented instances,例如航空影像中的文本和对象。 在如图3(c)和(d)所示的极端但实际上很常见的条件下,两个边界框之间的重叠是如此之大,以至于最新的物体检测方法无法区分它们。 为了解决这个问题,我们需要找到一种适用于oriented objects. 的注释方法。

用于标注定向对象的一种方法是基于θ的定向边界框( θ-based oriented bounding box),它在某些文本检测基准[36]中采用,即(xc,yc,w,h,θ),其中θ表示边界框与标准水平方向的夹角。 该方法的缺点是无法紧凑地封装不同零件之间变形较大的定向对象。 考虑到航空影像中复杂的场景和物体的不同方位,我们需要放弃这种方法,选择一种更加灵活,易于理解的方式。 另一种选择是任意四边形边界框,可以将其表示为{(xi,yi),i = 1,2,3,4},其中(xi,yi)表示图像中定向边界框的顶点的位置 。 顶点按顺时针顺序排列。 这种方式在面向场景的文本检测基准中被广泛采用[11]。 我们从这些研究中得到启发,并使用任意的四边形边界框来注释对象。

图3:采用的注释方法的可视化。 黄点代表起点,指的是:(a)飞机的左上角,(b)扇形棒球菱形的中心,(c)大型车辆的左上角。 (d)是水平矩形注释的失败案例,与(c)相比,它具有很高的重叠度。

为了进行更详细的注释,如图3所示,我们强调第一个点(x1,y1)的重要性,该点通常表示对象的“头部”。 对于直升机,大型车辆,小型车辆,港口,棒球钻石,轮船和飞机,我们仔细地指出它们的第一点,以丰富潜在的用途。 对于足球场,游泳池,桥梁,地面跑道场,篮球场和网球场,没有视觉线索来确定第一个点,因此我们通常选择左上角的点作为起点。

我们数据集中的一些带注释的patch(不是整个原始图像)的样本如图4所示。

值得注意的是,Papadopoulos等人[22]探索了一种替代的注释方法,并验证了其有效性和鲁棒性。我们认为,如果注释方法设计得更精巧,那么注释将更精确、更健壮,而替代的注释协议将促进更高效的众包图像注释。

3.4 Dataset splits

为了确保训练数据和测试数据分布大致匹配,我们随机选择原始图像的一半作为训练集,将1/6作为验证集,将1/3作为测试集。 我们将为训练集和验证集公开提供所有带有原始事实的原始图像,但不会为测试集提供。 为了进行测试,我们目前正在构建评估服务。

4 Properties of DOTA

4.1 Image size

与自然图像数据集相比,航空图像通常非常大。在我们的数据集中,图像的原始尺寸范围在800×800到4000×4000之间,而常规数据集(如PASCAL-VOC和MSCOCO)中的图像大多不超过1000×1000。我们对原始的完整图像进行注释,而不将其分割成块,以避免单个实例被分割成不同块的情况。

4.2 Various orientations of instances

如图1 (f)所示,我们的数据集在不同方向的实例中达到了很好的平衡,这对于学习鲁棒检测器有很大的帮助。此外,我们的数据集更接近真实场景,因为在现实世界中,经常可以看到各种方向的对象。

4.3 Spatial resolution information

我们还为数据集中的每个图像提供空间分辨率,这意味着实例的实际大小,在航空目标检测中起着重要的作用。空间分辨率对检测任务的重要性体现在两个方面。首先,它允许模型对同一类别的不同对象具有更强的适应性和鲁棒性。众所周知,从远处看物体会显得更小。相同的对象,不同的尺寸会给模型带来麻烦,不利于分类。然而,模型可以更关注形状提供的分辨率信息,而不是对象的大小。其次,它更适合于细粒度的分类。例如,将小船与大型战舰区分开来是很简单的。

空间分辨率还可以用于过滤数据集中标记错误的离群值,因为大多数类别的类内实际大小变化是有限的。在较小的空间分辨率范围内,选择与同类物体尺寸相差较大的物体,可以发现离群值(Outliers)。

4.4 Various pixel size of categories

根据[34]中的约定,我们将水平边框的高度(简称为像素大小)称为实例大小的度量。 我们根据水平边界框的高度将数据集中的所有实例分为三个部分:较小的范围为10到50,中间的范围为50到300,较大的范围为300以上。 图3说明了不同数据集中的三个实例拆分的百分比。 显然,PASCAL VOC数据集,NWPU VHR-10数据集和DLR 3K Munich Vehicle数据集分别由中等实例,中等实例和较小实例主导(???)。 但是,我们在小实例和中间实例之间实现了良好的平衡,这与现实世界场景更加相似,因此有助于在实际应用中更好地捕获对象的不同大小。

值得注意的是,像素大小在不同类别中有所不同。 例如,车辆可能小到30,但是桥梁可能大到1200,比车辆大40倍。 不同类别实例之间的巨大差异使检测任务更具挑战性,因为模型必须足够灵活,才能处理极小的物体。

4.5 Various aspect ratio of instances

对于基于anchor的模型,例如Faster RCNN [26]和YOLOv2 [25],长宽比是至关重要的因素。 我们为数据集中的所有实例计算两种长宽比,以为更好的模型设计提供参考:1)最小外接水平矩形边框的长宽比,2)原始四边形边框的长宽比。 图5说明了数据集中实例的这两种类型的长宽比分布。我们可以看到实例长宽比变化很大。此外,在我们的数据集中有大量高宽比大的实例。

图5:DOTA中实例的统计信息。AR表示长宽比。(a)horizontal bounding bo AR。(b) oriented bounding box的AR。(c)每张图像的注释实例数量直方图。

4.6 Various instance density of images

航空图像中包含数千个实例是很常见的,这与自然图像不同。例如,ImageNet[6]中的图像平均包含2个类别和2个实例,而MSCOCO分别包含3.5个类别和7.7个实例。我们的数据集在每个图像的实例中更加丰富,最多可以达到2000个。图5说明了DOTA数据集中实例的数量。

在单个图像中有这么多实例,不可避免地要看到实例密集地拥挤的区域。 对于COCO,实例不会一一标注,因为遮挡很难区分一个实例和它的相邻实例。 在这些情况下,实例组被标记为一个具有“ crowd”的属性的段。 但是,对于航空图像却不是这种情况,因为从上面的角度来看,几乎没有遮挡。 因此,我们可以在密集区域中一一注释所有实例。 图4显示了密集实例的示例。 在这些情况下,就对当前的检测方法提出了巨大的挑战。

5 Evaluations

我们在DOTA上使用最先进的目标检测方法进行评估。对于水平目标检测,我们精心选择了Faster R-CNN[26]、R-FCN[4]、YOLOv2[25]和SSD[16]作为我们的基准测试算法,因为它们在一般目标检测方面的性能非常好。对于 oriented object detection,我们修改了原始的Faster R-CNN算法,使其可以预测正确定向的边界框,表示为{(xi,yi),i = 1,2,3,4}。

注意,backbone 分别是用于R-FCN和Faster R-CNN的ResNet-101 [8],用于SSD的InceptionV2 [10]和用于YOLOv2的定制GoogLeNet [27]。

5.1 Evaluation prototypes

DOTA中的图像太大,无法直接使用基于CNN的检测器。 因此,我们从原始图像中裁剪出一系列1024×1024的色块,并将步幅设置为512。请注意,在裁剪过程中,某些完整的对象可能会被切成两部分。 为方便起见,我们将原始对象的面积表示为Ao,将分割部分Pi的面积(i = 1,2)表示为ai(i = 1,2)。 然后,我们计算原始对象区域上的 parts areas 的占比:

最后,我们将Ui < 0.7的Pi部分标记为difficult ,对于其他的,我们将其保留为与原始注释相同。 对于新生成的parts的顶点,我们需要确保使用拟合方法将它们描述为具有顺时针顺序的4个顶点的 oriented bounding box。

在测试阶段,我们首先发送裁剪后的图像以获得临时结果,然后将结果组合在一起以得到原始图像上的检测结果。 最后,我们根据预测的类别对这些结果使用非极大抑制(NMS)。 对于 horizontal bounding box实验(简称HBB),我们将NMS的阈值保持为0.3;对于oriented实验,我们将其阈值保持为0.1。 这样,我们就可以在DOTA上间接训练和测试基于CNN的模型。

对于评估指标,我们采用与PASCAL VOC相同的mAP计算。

5.2 Baselines with horizontal bounding boxes

通过在原始带注释的边界框上计算axis-aligned bounding boxes (与轴对齐的边界框)来生成HBB实验的ground truths。 为了公平起见,我们将所有实验的设置和超级参数都与相应论文[4,16,25,26]中描述的相同。

HBB预测的实验结果如表4所示。注意,SSD的结果远远低于其他模型。我们怀疑这是由于随机裁剪操作在SSD的数据增强策略中,这在一般目标检测中很有用,而在空中目标检测的非常小训练实例中就不行了。结果进一步表明,在实例大小方面,航空对象和一般对象之间存在巨大差异。

5.3 Baselines with oriented bounding boxes

OBB(oriented bounding box)的预测是困难的,因为现有的检测方法都不是针对oriented objects的。因此,我们选择Faster R-CNN作为其准确性和效率的基础框架,并对其进行修改以预测 oriented bounding boxes。

RPN(Region Proposal Network)生成的RoI(Region of Interests)是矩形,可以写成R =(xmin,ymin,xmax,ymax),在这里,要改成,R = {(xi,yi)} i = 1,2,3,4,其中x1 = x4 = xmin,x2 = x3 = xmax,y1 = y2 = ymin,y3 = y4 = ymax。 在R-CNN程序中,每个RoI都附加到ground truth oriented bounding box ,其写为G = {(gxi,gyi),i = 1,2,3,4}。 然后,R-CNN的输出目标T = {(txi,tyi),i = 1,2,3,4},其计算公式如下:

其他设置和超级参数保持与Faster R-CNN [26]中所述相同。 结果显示在表4中。

5.4 Experimental analysis

分析结果列于表中。 如图4所示,小型车辆,大型车辆和轮船等类别的表现都比较差,这归因于其较小的尺寸和在航空影像中密集的位置。 相比之下,大型且离散的物体(例如飞机,游泳池和网球场)的表现还不错。

在图6中,我们比较了HBB和OBB的目标检测实验之间的结果。 对于图6(a)和(b)所示的密集排列和定向的对象,HBB实验中对象的定位精度远低于OBB实验,并且许多结果都通过后期操作来抑制。 因此,OBB回归是定向对象检测的正确方法,可以将其真正集成到实际应用程序中。 在图6(c)中,用OBB样式标注的大长宽比对象(如港口,桥梁)很难使电流检测器回归。 但是在HBB风格中,这些对象通常具有正常的纵横比,因此,结果似乎相当不错,如图6(d)所示。 然而,在极其密集的场景中,例如在图6(e)和(f)中,HBB和OBB的结果都不能令人满意,这映射出了当下检测器的缺陷。

6 Cross-dataset validations

The cross dataset generalization[28]是一种对数据集泛化能力的评价标准。我们选择UCAS-AOD数据集[40]进行跨数据集综合,因为它的数据量相对于其他航空目标检测数据集来说比较大。因为UCAS-AOD没有官方的数据划分,我们随机选择1110条数据进行训练,400个进行测试。我们选择YOLOv2作为下面描述的所有实验的测试检测器,并为所有ground truth使用HBB风格的注释。在UCAS-AOD中,在原有图像大小的基础上,改变输入图像大小为960×544,其他设置不变。

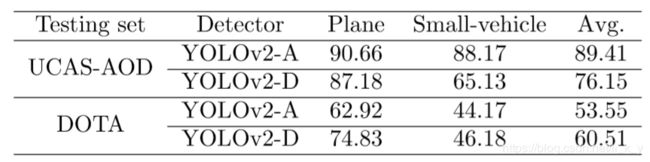

结果如表5所示。YOLOv2-A和YOLOv2-D模型在两个数据集上的性能差异分别为35.8和15.6。这表明DOTA极大地覆盖了UCAS-AOD,而且有更多的模式和属性在UCAS-AOD中没有。两种模型在DOTA上的结果都很低,这反映了DOTA更具挑战性。

表5:跨数据集综合的结果。上面是在UCASAOD上对检测性能进行评估。下面是DOTA的检测性能评估。YOLOv2-A和YOLOv2-D指的是分别使用UCAS-AOD和DOTA进行训练。

7 Conclusion

我们建立了一个大规模的数据集,用于航空图像中的 oriented objects 检测,它比该领域中的任何现有数据集都大得多。 与一般的对象检测基准不同,我们用 oriented bounding boxes注释了大量分布良好的oriented objects。 我们认为该数据集具有挑战性,与自然航空场景非常相似,自然场景更适合实际应用。 我们还为航空图像中的物体检测建立了benchmark ,并通过修改主流检测算法,证明了产生 oriented bounding boxes 的可行性。

8 Acknowledgement

We thank Fan Hu, Pu Jin, Xinyi Tong, Xuan Hu, Zhipeng Dong, Liang Wu, Jun Tang, Linyan Cui, Duoyou Zhou, Tengteng Huang, and all the others who involved in the annotations of DOTA.

References

[1] C. Benedek, X. Descombes, and J. Zerubia. Building development monitoring in multitemporal remotely sensed image pairs with stochastic birth-death dynamics. IEEE TPAMI, 34(1):33–50, 2012.

[2] G. Cheng, P. Zhou, and J. Han. Learning rotation-invariant convolutional neural networks for object detection in VHR optical remote sensing images. IEEE Trans. Geosci. Remote Sens., 54(12):7405–7415, 2016.

[3] G. Cheng, P. Zhou, and J. Han. Rifd-cnn: Rotation-invariant and fisher discriminative convolutional neural networks for object detection. In CVPR, pages 2884–2893, 2016.

[4] J. Dai, Y. Li, K. He, and J. Sun. R-FCN: object detection via region-based fully convolutional networks. In NIPS, pages 379–387, 2016.

[5] A.-M. de Oca, R. Bahmanyar, N. Nistor, and M. Datcu. Earth observation image semantic bias: A collaborative user annotation approach. IEEE J. of Selected Topics in Applied Earth Observations and Remote Sensing, 2017.

[6] J. Deng, W. Dong, R. Socher, L. Li, K. Li, and F. Li. Imagenet: A large-scale hierarchical image database. In CVPR, pages 248–255, 2009.

[7] M. Everingham, L. V. Gool, C. Williams, J. Winn, and A. Zisserman. The pascal visual object classes (VOC) challenge. IJCV, 88(2):303–338, 2010.

[8] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. In CVPR, June 2016.

[9] G. Heitz and D. Koller. Learning spatial context: Using stuff to find things. In ECCV, pages 30–43, 2008.

[10] S. Ioffe and C. Szegedy. Batch normalization: Accelerating deep network training by reducing internal covariate shift. CoRR, abs/1502.03167, 2015.

[11] D. Karatzas, L. Gomez-Bigorda, A. Nicolaou, S. K. Ghosh, A. D. Bagdanov, M. Iwamura, J. Matas, L. Neumann, V. R. Chandrasekhar, S. Lu, F. Shafait, S. Uchida, and E. Valveny. ICDAR 2015 competition on robust reading. In Proc. ICDAR, 2015.

[12] R. Krishna, Y. Zhu, O. Groth, J. Johnson, K. Hata, J. Kravitz, S. Chen, Y. Kalantidis, L.-J. Li, D. A. Shamma, et al. Visual genome: Connecting language and vision using crowdsourced dense image annotations. IJCV, 123(1):32–73, 2017.

[13] T. Lin, M. Maire, S. Belongie, J. Hays, P. Perona, D. Ramanan, P. Doll´ar, and C. L. Zitnick. Microsoft COCO: common objects in context. In ECCV, pages 740–755, 2014.

[14] Y. Lin, H. He, Z. Yin, and F. Chen. Rotation-invariant object detection in remote sensing images based on radial-gradient angle. IEEE Geosci.Remote Sensing Lett., 12(4):746–750, 2015.

[15] K. Liu and G. M´attyus. Fast multiclass vehicle detection on aerial images. IEEE Geosci. Remote Sensing Lett., 12(9):1938–1942, 2015.

[16] W. Liu, D. Anguelov, D. Erhan, C. Szegedy, S. E. Reed, C. Fu, and A. C. Berg. SSD: single shot multibox detector. In ECCV, pages 21–37, 2016.

[17] Z. Liu, H. Wang, L. Weng, and Y. Yang. Ship rotated bounding box space for ship extraction from high-resolution optical satellite images with complex backgrounds. IEEE Geosci. Remote Sensing Lett., 13(8):1074–1078, 2016.

[18] Y. Long, Y. Gong, Z. Xiao, and Q. Liu. Accurate object localization in remote sensing images based on convolutional neural networks. IEEE Trans. Geosci. Remote Sens., 55(5):2486–2498, 2017.

[19] T. Moranduzzo and F. Melgani. Detecting cars in uav images with a catalog-based approach. IEEE Trans. Geosci. Remote Sens., 52(10):6356–6367, 2014.

[20] T. N. Mundhenk, G. Konjevod, W. A. Sakla, and K. Boakye. A large contextual dataset for classification, detection and counting of cars with deep learning. In ECCV, pages 785–800, 2016.

[21] A. ¨O. Ok, C¸. Senaras, and B. Yu¨ksel. Automated detection of arbitrarily shaped buildings in complex environments from monocular VHR optical satellite imagery. IEEE Trans. Geosci. and Remote Sens., 51(3-2):1701–1717, 2013.

[22] D. P. Papadopoulos, J. R. R. Uijlings, F. Keller, and V. Ferrari. Extreme clicking for efficient object annotation. CoRR, abs/1708.02750, 2017.

[23] J. Porway, Q. Wang, and S. C. Zhu. A hierarchical and contextual model for aerial image parsing. IJCV, 88(2):254–283, 2010.

[24] S. Razakarivony and F. Jurie. Vehicle detection in aerial imagery: A small target detection benchmark. J Vis. Commun. Image R., 34:187–203, 2016.

[25] J. Redmon and A. Farhadi. YOLO9000: better, faster, stronger. CoRR, abs/1612.08242, 2016.

[26] S. Ren, K. He, R. B. Girshick, and J. Sun. Faster R-CNN: towards real-time object detection with region proposal networks. IEEE TPAMI, 39(6):1137–1149, 2017.

[27] C. Szegedy, W. Liu, Y. Jia, P. Sermanet, S. Reed, D. Anguelov, D. Erhan, V. Vanhoucke, and A. Rabinovich. Going deeper with convolutions. In CVPR, pages 1–9, 2015.

[28] A. Torralba and A. A. Efros. Unbiased look at dataset bias. In CVPR, pages 1521–1528, 2011.

[29] M. Vakalopoulou, K. Karantzalos, N. Komodakis, and N. Paragios. Building detection in very high resolution multispectral data with deep learning features. In IGARSS, pages 1873–1876, 2015.

[30] L. Wan, L. Zheng, H. Huo, and T. Fang. Affine invariant description and large-margin dimensionality reduction for target detection in optical remote sensing images. IEEE Geosci. Remote Sensing Lett., 2017.

[31] G. Wang, X. Wang, B. Fan, and C. Pan. Feature extraction by rotation-invariant matrix representation for object detection in aerial image. IEEE Geosci.Remote Sensing Lett., 2017.

[32] G. Xia, J. Hu, F. Hu, B. Shi, X. Bai, Y. Zhong, L. Zhang, and X. Lu. AID: A benchmark data set for performance evaluation of aerial scene classification. IEEE Trans. Geosci. Remote Sens., 55(7):3965–3981, 2017.

[33] J. Xiao, J. Hays, K. Ehinger, A. Oliva, and A. Torralba. SUN database: Large-scale scene recognition from abbey to zoo. In CVPR, pages 3485–3492, 2010.

[34] S. Yang, P. Luo, C. C. Loy, and X. Tang. WIDER FACE: A face detection benchmark. In CVPR, pages 5525–5533, 2016.

[35] B. Yao, X. Yang, and S.-C. Zhu. Introduction to a large-scale general purpose ground truth database: Methodology, annotation tool and benchmarks. In EMMCVPR 2007, pages 169–183, 2007.

[36] C. Yao, X. Bai, W. Liu, Y. Ma, and Z. Tu. Detecting texts of arbitrary orientations in natural images. In CVPR, 2012.

[37] Q. You, J. Luo, H. Jin, and J. Yang. Building a large scale dataset for image emotion recognition: The fine print and the benchmark. In AAAI, pages 308–314, 2016.

[38] F. Zhang, B. Du, L. Zhang, and M. Xu. Weakly supervised learning based on coupled convolutional neural networks for aircraft detection. IEEE Trans. Geosci. Remote Sens., 54(9):5553–5563, 2016.

[39] B. Zhou, `A. Lapedriza, J. Xiao, A. Torralba, and A. Oliva. Learning deep features for scene recognition using places database. In NIPS, pages 487–495, 2014.

[40] H. Zhu, X. Chen, W. Dai, K. Fu, Q. Ye, and J. Jiao. Orientation robust object detection in aerial images using deep convolutional neural network. In ICIP, pages 3735–3739, 2015.