Hadoop windows本地环境安装

hadoop使用java编写,所以windows安装和java一样也需要配置环境变量。

一、下载所需文件

- JDK下载地址,jdk1.8下载

- Hadoop下载,hadoop下载,进去后找到一个版本然后点击 Binary download 下载到本地。

- Hadoop windows环境编译工具,winutils下载 ,下载后解压出来

二、安装文件

- jdk安装,jdk安装并不复杂,这里就不详细介绍了,我的安装目录是 C:\Program Files\Java\jdk1.8.0_151

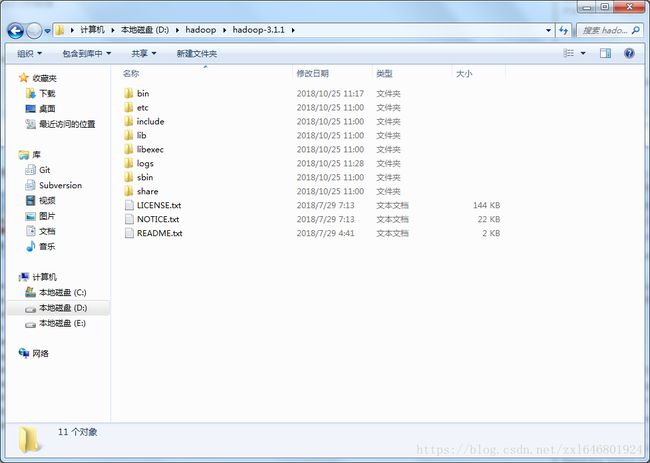

- hadoop安装,由于下载的hadoop文件是不用安装的,我们只需要解压出来就可以了 解压目录 D:\hadoop\hadoop-3.1.1

三、环境变量配置

- jdk环境变量配置,网上很多这里也就不详细说了

- Hadoop环境变量安装,环境变量和java的安装方式一样

先新建一个HADOOP_HOME,里面变量值为 D:\hadoop\hadoop-3.1.1

然后在Path变量值后面追加 %HADOOP_HOME%\bin; ,至此hadoop的环境变量就配置完了。

四、配置hadoop文件

- 进入hadoop目录下面的etc D:\hadoop\hadoop-3.1.1\etc\hadoop 找到 core-site.xml文件并使用编辑器打开,复制下面内容进去

hadoop.tmp.dir

/D:/hadoop/workspace/tmp

dfs.name.dir

/D:/hadoop/workspace/name

fs.default.name

hdfs://localhost:9000

- 在找到 mapred-site.xml 文件并打开,复制下面内容进去

mapreduce.framework.name

yarn

mapred.job.tracker

hdfs://localhost:9001

- 找到 hdfs-site.xml 文件并打开,复制下面内容进去

dfs.replication

1

dfs.data.dir

/D:/hadoop/workspace/data

- 找到 yarn-site.xml 文件并打开,复制下面内容进去

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.aux-services.mapreduce.shuffle.class

org.apache.hadoop.mapred.ShuffleHandler

- 找到 hadoop-env.cmd 文件并打开,将JAVA_HOME用 @rem注释掉,编辑为JAVA_HOME的路径,然后保存。

@rem set JAVA_HOME=%JAVA_HOME%

set JAVA_HOME=C:\Program Files\Java\jdk1.8.0_151注意这里会有个错误,由于我jdk安装在C盘的 program files目录下,这个文件夹有个空格,后面会报错

所以这里我们修改成 ,使用 PROGRA~1 代替

@rem set JAVA_HOME=%JAVA_HOME%

set JAVA_HOME=C:\PROGRA~1\Java\jdk1.8.0_151五、替换文件

解压我们之前下载的 winutils-master 文件,找到符合自己的版本,我这里找的是 D:\hadoop\winutils-master\hadoop-3.0.0 进入文件夹拷贝整个bin文件替换掉 hadoop的bin文件夹,即 D:\hadoop\hadoop-3.1.1 下面的bin

六、运行

1.运行cmd窗口,执行hdfs namenode -format。

2.运行cmd窗口,切换到hadoop的sbin目录,执行start-all.cmd,它将会启动以下4个进程窗口。

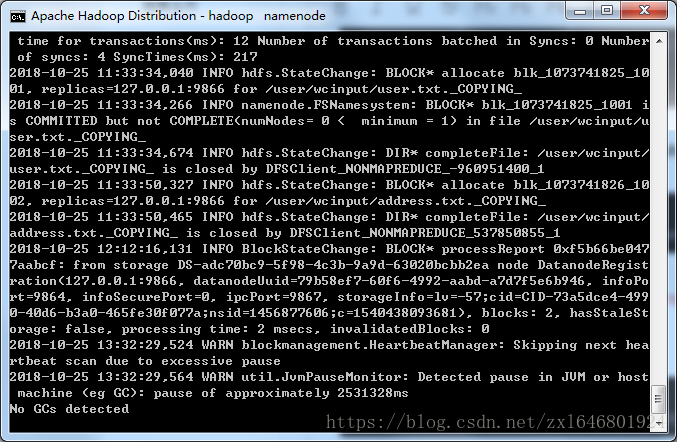

七、上传测试

根据你core-site.xml的配置,接下来你就可以通过:hdfs://localhost:9000 来对hdfs进行操作了。

1.创建输入目录

输入命令,hadoop fs -mkdir hdfs://localhost:9000/user

hadoop fs -mkdir hdfs://localhost:9000/user/wcinput

C:\WINDOWS\system32>hadoop fs -mkdir hdfs://localhost:9000/user/

C:\WINDOWS\system32>hadoop fs -mkdir hdfs://localhost:9000/user/wcinput2.上传数据到目录

输入命令, hadoop fs -put D:\personal\debug.log hdfs://localhost:9000/user/wcinput

hadoop fs -put D:\personal\waz.txt hdfs://localhost:9000/user/wcinput

C:\WINDOWS\system32>hadoop fs -put D:\personal\debug.log hdfs://localhost:9000/user/wcinput

C:\WINDOWS\system32>hadoop fs -put D:\personal\waz.txt hdfs://localhost:9000/user/wcinput3.查看文件

输入命令,hadoop fs -ls hdfs://localhost:9000/user

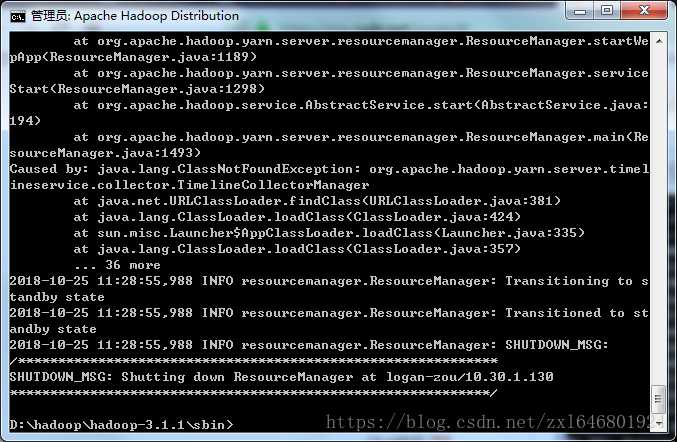

QA常见问题:

1:启动hadoop可能提示找不到JAVA_HOME路径,是因为hadoop读取JAVA_HOME环境变量存在空格导致。

2:启动hadoop提示找不到HADOOP,是因为Hadoop环境变量没有配置好,请检查Hadoop环境变量配置。

hadoop自带的web控制台GUI

1.资源管理GUI:http://localhost:8088/;

![]()

2.节点管理GUI:http://localhost:50070/

![]()