深度聚类 VAE 类方法总结(VAE、GMVAE、VaDE)

深度聚类 VAE 类方法总结(VAE、GMVAE、VaDE)

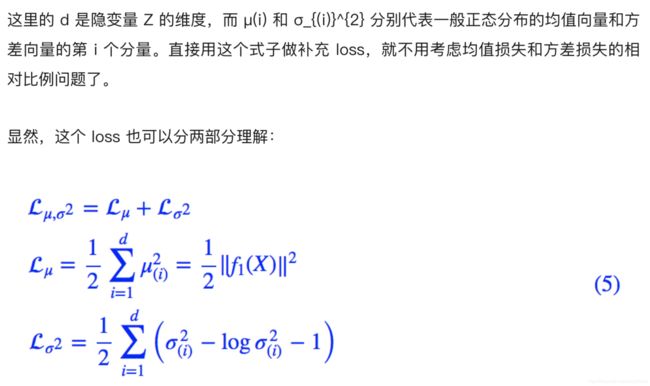

- Variational AutoEncoders(VAE)

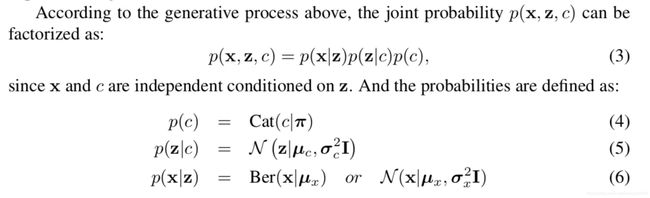

- 概述

- 详解VAE

- 生成模型-----进行分布之间的变换

- 什么是VAE

- GMVAE(GAUSSIAN MIXTURE VARIATIONAL AUTOENCODERS)

- 概述

- 生成和识别模型

- 识别模型的推论

- 离散潜在变量的KL COST

- 过度监管问题

- 实验

- SYNTHETIC DATA

- 无监督的图像聚类

- 图像生成

- VaDE

- 概述

- Variational Deep Embedding

- 生成过程

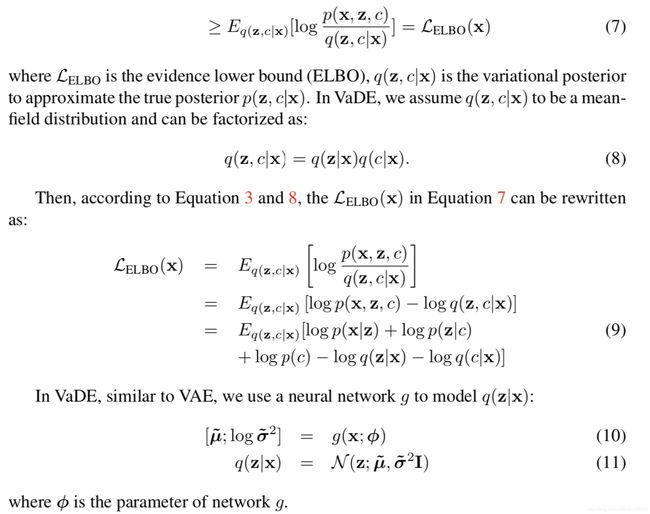

- 变化下界

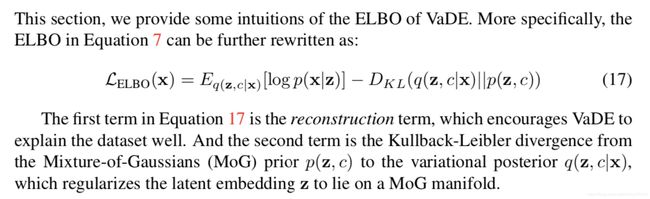

- 了解VaDE的ELBO

- 实验

- 数据集说明

- 实验装置

- 定量比较

- 通过VaDE生成样本

- 可视化学习的嵌入

- The Impact of the Number of Clusters

Variational AutoEncoders(VAE)

概述

VAE是将变分贝叶斯方法与神经网络提供的灵活性和可扩展性相结合的结果。

变分自编码器是一个扭曲的自编码器。同自编码器的传统编码器和解码器网络一起,它们具有附加的随机层。

编码器网络之后的随机层使用高斯分布对数据进行采样,而解码器网络之后的随机层使用伯努利分布对数据进行采样。

与 GAN 一样,变分自编码器根据它们所接受的分布来生成图像和数字。VAE允许设置潜在的复杂先验,从而学习强大的潜在表征。

现在已经有了 VAE 的基本结构,问题在于如何对它们进行训练,因为训练数据和后验密度的最大可能性是难以处理的。通过最大化 log 数据可能性的下限来训练网络。因此,损失项由两部分组成:通过采样从解码器网络获得的生成损失,以及被称为潜在损失的 KL 发散项。

发生损耗确保了由解码器生成的图像和用于训练网络的图像是相同的,并且潜在损失能够确保后验分布 qφ(z|x) 接近于先验分布 pθ(z)。由于编码器使用高斯分布进行采样,所以潜在损耗测量潜在变量与单位高斯匹配的匹配程度。

一旦 VAE 接受训练,只能使用解码器网络来生成新的图像。

使用变分推理可以将棘手的推理问题转化为优化问题,从而扩展了可用的推理工具集,包括优化技术。尽管如此,经典变分推论的一个关键局限性是需要似然性和先验共轭,以便可以对大多数问题进行合理的优化,这反过来又会限制此类算法的适用性。变分自动编码器引入了使用神经网络来输出条件后验的方法(Kingma&Welling,2013),因此可以通过随机梯度下降和标准反向传播来精确地优化变分推理目标。提出了这种称为重新参数化技巧的技术,旨在通过连续随机变量进行反向传播。尽管在正常情况下,如果没有蒙特卡罗方法,将无法通过随机变量进行反向传播,但可以通过确定性函数和独立噪声源的组合来构造潜在变量,从而绕过这种情况。

详解VAE

生成模型-----进行分布之间的变换

通常我们会拿 VAE 跟 GAN 比较,的确,它们两个的目标基本是一致的——希望构建一个从隐变量 Z 生成目标数据 X 的模型,但是实现上有所不同。

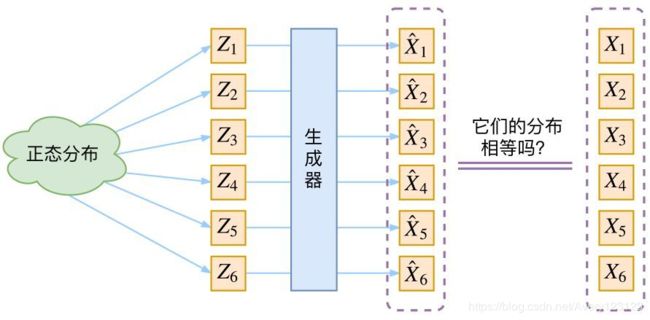

生成模型的难题就是判断生成分布与真实分布的相似度,因为我们只知道两者的采样结果,不知道它们的分布表达式。

什么是VAE

首先我们有一批数据样本 {X1,…,Xn},其整体用 X 来描述,我们本想根据 {X1,…,Xn} 得到 X 的分布 p(X),如果能得到的话,那我直接根据 p(X) 来采样,就可以得到所有可能的 X 了(包括 {X1,…,Xn} 以外的),这是一个终极理想的生成模型了。

当然,这个理想很难实现,于是我们将分布改一改:

这里我们就不区分求和还是求积分了,意思对了就行。此时 p(X|Z) 就描述了一个由 Z 来生成 X 的模型,而我们假设 Z 服从标准正态分布,也就是 p(Z)=N(0,I)。如果这个理想能实现,那么我们就可以先从标准正态分布中采样一个 Z,然后根据 Z 来算一个 X,也是一个很棒的生成模型。

其实,在整个 VAE 模型中,我们并没有去使用 p(Z)(先验分布)是正态分布的假设,我们用的是假设 p(Z|X)(后验分布)是正态分布。

具体来说,给定一个真实样本 Xk,我们假设存在一个专属于 Xk 的分布 p(Z|Xk)(学名叫后验分布),并进一步假设这个分布是(独立的、多元的)正态分布。

那怎么找出专属于 Xk 的正态分布 p(Z|Xk) 的均值和方差呢?

神经网络来拟合出来

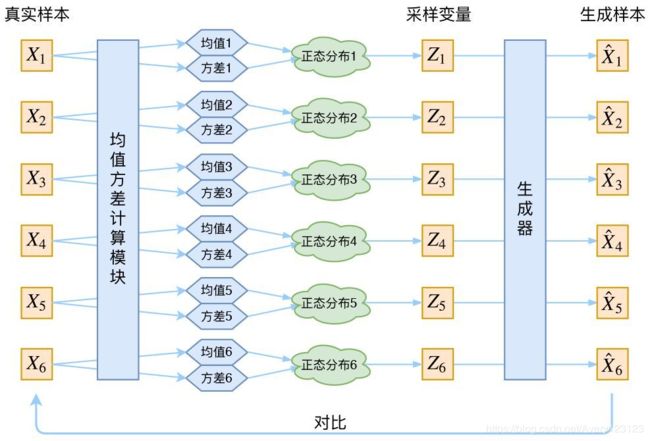

对应于上图我们发现:Encoder 不是用来 Encode 的,是用来算均值和方差的。

分布标准化

让我们来思考一下,根据上图的训练过程,最终会得到什么结果。

首先,我们希望重构 X,也就是最小化 D(X̂k,Xk)^2,但是这个重构过程受到噪声的影响,因为 Zk 是通过重新采样过的,不是直接由 encoder 算出来的。

显然噪声会增加重构的难度,不过好在这个噪声强度(也就是方差)通过一个神经网络算出来的,所以最终模型为了重构得更好,肯定会想尽办法让方差为0。

而方差为 0 的话,也就没有随机性了,所以不管怎么采样其实都只是得到确定的结果(也就是均值),只拟合一个当然比拟合多个要容易,而均值是通过另外一个神经网络算出来的。

说白了,模型会慢慢退化成普通的 AutoEncoder,噪声不再起作用。

这样不就白费力气了吗?说好的生成模型呢?

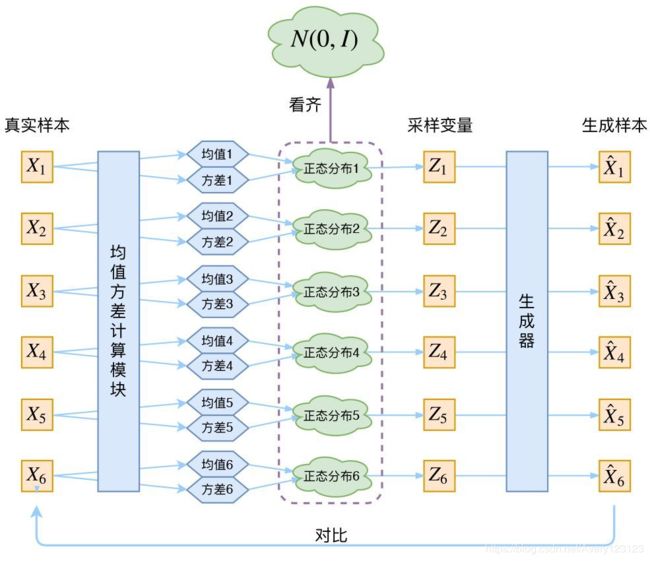

其实 VAE 还让所有的 p(Z|X) 都向标准正态分布看齐,这样就防止了噪声为零,同时保证了模型具有生成能力。

怎么理解“保证了生成能力”呢?如果所有的 p(Z|X) 都很接近标准正态分布 N(0,I),那么根据定义:

这样我们就能达到我们的先验假设:p(Z) 是标准正态分布。然后我们就可以放心地从 N(0,I) 中采样来生成图像了。

VAE本质结构

在 VAE 中,它的 Encoder 有两个,一个用来计算均值,一个用来计算方差,这已经让人意外了:Encoder 不是用来 Encode 的,是用来算均值和方差的,这真是大新闻了,还有均值和方差不都是统计量吗,怎么是用神经网络来算的?

事实上,我觉得 VAE 从让普通人望而生畏的变分和贝叶斯理论出发,最后落地到一个具体的模型中,虽然走了比较长的一段路,但最终的模型其实是很接地气的。

它本质上就是在我们常规的自编码器的基础上,对 encoder 的结果(在VAE中对应着计算均值的网络)加上了“高斯噪声”,使得结果 decoder 能够对噪声有鲁棒性;而那个额外的 KL loss(目的是让均值为 0,方差为 1),事实上就是相当于对 encoder 的一个正则项,希望 encoder 出来的东西均有零均值。

那另外一个 encoder(对应着计算方差的网络)的作用呢?它是用来动态调节噪声的强度的。

直觉上来想,当 decoder 还没有训练好时(重构误差远大于 KL loss),就会适当降低噪声(KL loss 增加),使得拟合起来容易一些(重构误差开始下降)。

反之,如果 decoder 训练得还不错时(重构误差小于 KL loss),这时候噪声就会增加(KL loss 减少),使得拟合更加困难了(重构误差又开始增加),这时候 decoder 就要想办法提高它的生成能力了。

GMVAE(GAUSSIAN MIXTURE VARIATIONAL AUTOENCODERS)

以高斯混合作为先验分布研究变分自动编码器模型(VAE)的变体

本文中,提出了一种在VAE框架内执行无监督聚类的算法。为此,假设可以通过假设观测数据是从多模态先验分布中生成的假设来调整生成模型的无监督聚类,并相应地构建可以使用重新参数化技巧直接优化的推理模型。 。同时作者表明,VAE中的过度规范化问题会严重影响聚类的性能,并且可以用Kingma等人引入的最小信息约束来缓解这一问题。

概述

在常规VAE中,潜在变量的先验值通常是各向同性的高斯。这种先验的选择导致多元高斯的每个维度被推向学习来自数据的单独的连续变化因子,这可能导致学习的表示被结构化和解缠结。虽然这允许更多可解释的潜在变量(Higgins等,2016),但高斯先验是有限的,因为学习的表示只能是单峰的,并且不允许更复杂的表示。结果,已经开发了对VAE的许多扩展,其中可以通过指定越来越复杂的先验来学习更复杂的潜在表示(Chung等人,2015; Gregor等人,2015; Eslami等人,2016)。

在本文中,我们选择混合高斯先验作为先验,因为它是单峰高斯先验的直观扩展。如果我们假设观察到的数据是从混合的高斯产生的,则推断数据点的类别等同于推断数据点是从哪种潜势分布模式产生的。虽然这使我们有可能将潜伏空间划分为不同的类,但在此模型中进行推断并非易事。众所周知,通常用于VAE的重新参数化技巧无法直接应用于离散变量。已经提出了几种估计离散变量梯度的可能性(Glynn,1990; Titsias&Lázaro-Gredilla,2015)。 Graves(2016)还提出了一种通过GMM反向传播的算法。相反,我们表明,通过调整标准VAE的体系结构,可以通过重新参数化技巧通过标准反向传播来优化我们的高斯混合变分自编码器(GMVAE)的变化下限估计量,从而使推理模型保持简单。

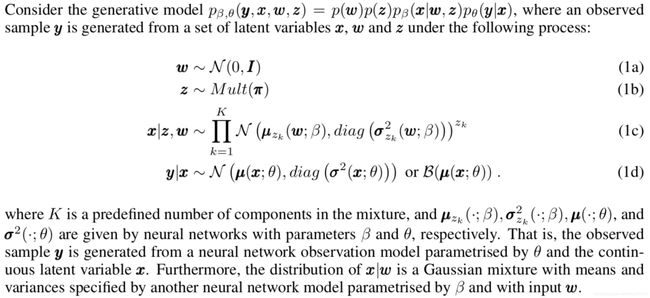

生成和识别模型

高斯混合变分自动编码器(GMVAE)的图形模型,显示了生成模型(左)和变体族(右):

识别模型的推论

用变分推理目标(即对数证据下限(ELBO))训练生成模型,可以将其写为

我们将下限中的术语分别称为重构术语,条件先验条件,w先验条件和z先验条件。

离散潜在变量的KL COST

我们的ELBO中最不常见的术语是z优先级术语。 通过询问x与w生成的每个聚类位置相距多远,z后验直接从x和w的值计算聚类分配概率。 因此,z先验项可以通过同时操纵聚类的位置和编码点x来减小z后验和统一先验之间的KL散度。 凭直觉,它会尝试通过最大程度地重叠聚类,然后将均值靠拢在一起来合并聚类。 与其他KL正则化术语相似,该术语与重建术语存在冲突,随着训练数据量的增加,预计该术语将被过度使用。

过度监管问题

在VAE文献中已多次描述了正则化项可能对VAE训练产生的压倒性影响(Bowman等人,2015;Sønderby等人,2016; Kingma等人,2016; Chen等人,2016b)。由于先验的强大影响,获得的潜在表示常常被过度简化,并且不能很好地表示数据的基础结构。

到目前为止,有两种主要的方法可以克服这种影响:一种解决方案是在训练过程中退火KL项,方法是允许重建项训练自动编码器网络,然后再缓慢整合KL项的正则化(Sønderby等人,2016) 。另一种主要方法是通过设置一个临界值来修改目标函数,该临界值会在低于某个阈值时消除KL项的影响(Kingma等,2016)。正如我们在下面的实验部分所示,过度规整化问题在GMVAE群集的分配中也很普遍,并在大型简并群集中表现出来。虽然我们显示了Kingma等人建议的第二种方法。 (2016年)确实确实减轻了这种合并现象,找到解决过度正规化问题的方法仍然是一个充满挑战的开放问题。

实验

我们的实验的主要目的不仅是评估我们提出的模型的准确性,而且要了解构建有意义的,差异化的潜在数据表示所涉及的优化动力。

本节分为三个部分:

1.首先,我们在一个低维综合数据集中研究推理过程,并特别关注过度规则化问题如何影响GMVAE的聚类性能以及如何缓解该问题;

2.然后,我们根据MNIST无监督聚类任务评估模型;

3.最后,我们显示了由模型生成的图像,这些图像以潜在变量的不同值为条件,这说明GMVAE可以学习解开的,可解释的潜在表示。

在本节中,我们将使用以下数据集:

•综合数据:我们创建一个模仿约翰逊等人介绍的综合数据集。 (2016),这是一个2D数据集,具有从5个圆的弧线创建的10,000个数据点。

•MNIST:标准的手写数字数据集,由28x28灰度图像组成,由60,000个训练样本和10,000个测试样本组成(LeCun等,1998)。

•SVHN:门牌号的32x32图像集合(Netzer等,2011)。我们使用标准版和额外的训练集的裁剪版,总共增加了大约600,000张图像。

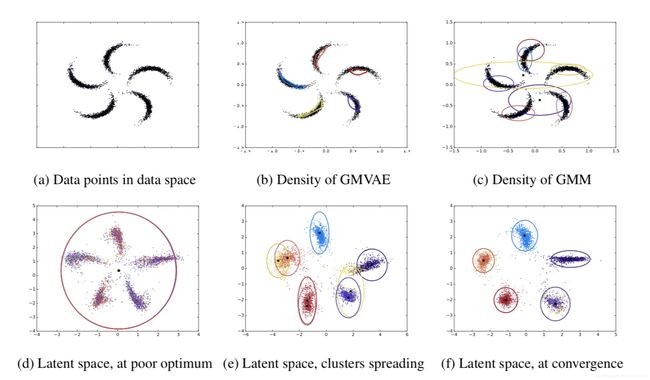

SYNTHETIC DATA

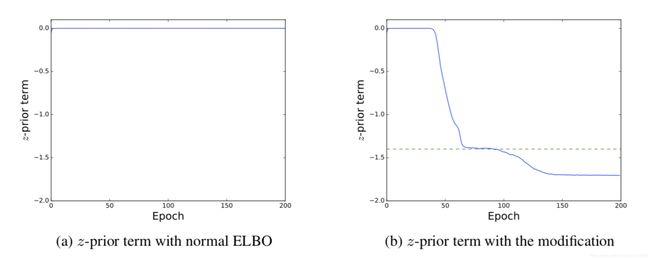

我们通过绘制等式中描述的z先验项的大小来量化聚类性能。公式 6在训练中。 可以将这一数量视为衡量不同群集重叠程度的一种度量。 由于我们的目标是在潜在空间中实现有意义的聚类,因此我们希望随着模型学习单独的聚类,该数量会下降。

但是,根据经验,我们发现情况并非如此。 我们的模型收敛以将所有类合并到相同的大型群集中的潜在表示,而不是表示有关不同群集的信息,如图5和6所示。 2d和3a。 结果,每个数据点都可能属于任何一个群集,这使得我们的潜在表示形式对类结构完全无用。

我们认为,这种现象可以解释为z先验项过度正规化的结果。鉴于此数量是由下限中的KL项的优化推动的,因此达到最大可能值为零,这与通过训练以确保有关类的信息进行编码而减少的相反。我们怀疑先验在初始训练阶段的影响力太大,并且将模型参数驱动到较差的局部最优值,而该最优值随后很难被重建项排除掉。

这种观察从概念上讲与常规VAE中遇到的过度规范化问题非常相似,因此我们假设采用类似的启发式方法可以缓解这一问题。我们在图2f中显示,通过使用先前提到的对Kingma等人提出的下界的修改。 (2016),我们可以避免由z优先级引起的过度规范化。这可以通过将z优先级之前的成本保持在恒定值λ直到超过该阈值来实现。正式地,修改后的z优先级术语写为:

此修改抑制了z优先级合并所有群集的初始效果,因此允许它们散布,直到z优先级成本中的成本足够高为止。 在这一点上,其效果已大大降低,并且主要限于合并足够重叠的单个群集。 这可以在图1和2中清楚地看到。 2e和2f。 前者显示的是未考虑z先验成本的集群,因此集群已经能够扩展。 一旦激活了z优先级,就可以合并非常靠近的群集,如图2f所示。

最后,为了说明使用神经网络进行分布转换的好处,我们将模型(图2c)与常规GMM(图2c)在数据空间中观察到的密度进行了比较。 如图所示,与常规GMM相比,GMVAE可以提供更丰富,因此更准确的表示形式,因此在建模非高斯数据方面更为成功。

图2:合成数据集的可视化:(a)数据在5维模式下分布在二维数据空间上。 (b)GMVAE学习密度模型,该模型可以使用数据空间中非高斯分布的混合来对数据建模。 (c)由于限制性高斯假设,GMM也无法表示数据。 (d)然而,GMVAE受过度正则化的影响,在看潜在空间时可能导致极小的最小值。 (e)使用对ELBO的修改(Kingma et al。,2016)可使星团扩展。 (f)随着模型收敛,z优先级项被激活,并通过合并过多的聚类在最后阶段对聚类进行正则化。

图3:z先验项的图:(a)由于没有信息约束,GMVAE会过度规范化,因为它收敛到一个较差的最优值,该最优值将所有群集合并在一起以避免KL成本。 (b)在达到阈值(虚线)之前,可以先关闭z先验项的梯度,以避免将簇拉在一起(有关详细信息,请参见文本)。 到达到阈值时,群集已充分分离。 此时,来自z先验项的激活梯度仅将非常重叠的簇合并在一起。 即使激活了它的梯度后,z先验的值仍会继续减小,因为它会被其他项所压倒,从而导致有意义的聚类和更好的最佳化。

无监督的图像聚类

现在,我们评估模型在图像聚类任务中表示数据中离散信息的能力。我们在MNIST训练数据集上训练GMVAE,并在测试数据集上评估其聚类性能。为了将GMVAE提供的聚类分配与真实图像标签进行比较,我们遵循Makhzani等人的评估协议。 (2015),为清楚起见,在此进行总结。在这种方法中,我们找到属于簇i的概率最高的测试集元素,并将该标签分配给属于i的所有其他测试样本。然后对所有群集i = 1,…,K重复此操作,并将分配的标签与真实标签进行比较,以获得无监督的分类错误率。

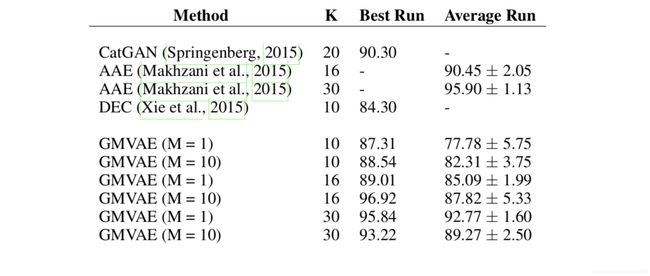

在合成数据集上训练GMVAE时,虽然我们观察到了聚类退化问题,但MNIST数据集并未出现该问题。因此,我们直接使用ELBO优化了GMVAE,无需进行任何修改。表1总结了在MNIST基准上使用GMVAE以及其他最新方法获得的结果。除对抗性自动编码器(AAE)之外,我们获得的分类得分与最新技术1相当。 。我们怀疑其原因再次与VAE目标中的KL条款有关。正如Hoffman等人所指出的,对抗性自动编码器目标的关键区别在于,ELBO中的KL项被对抗性损失所取代,从而使潜伏空间得以更谨慎地操纵(Hoffman&Johnson,2016)。这些实验中使用的网络体系结构的详细信息可以在附录A中找到。

从经验上,我们观察到,增加蒙特卡洛样本的数量和聚类的数量可使GMVAE对初始化更鲁棒,更稳定,如图4所示。如果使用较少的样本或聚类,则GMVAE有时会收敛得更快甚至更差。局部最小值,缺少某些数据分发模式。

表1:具有不同簇数(K)的MNIST的无监督分类准确性(报告为正确标签的百分比)

图4:具有不同数量的聚类(K)和蒙特卡洛样本(M)的聚类精度:仅几个时期之后,GMVAE收敛为一个解。增加群集数量可大大提高解决方案的质量。

图像生成

到目前为止,我们认为GMVAE会拾取数据集中的自然聚类,并且这些聚类与图像的实际类别共享某种结构。

现在,我们在MNIST上用K = 10训练GMVAE,以表明潜在空间分布中的学习成分实际上代表了有意义的数据属性。首先,我们注意到从GMVAE采样时,存在两种随机性来源,即

1.从先验采样w,它将通过神经网络β生成x的均值和方差;

2.从由w和z确定的高斯混合中采样x,这将通过神经网络θ生成图像。

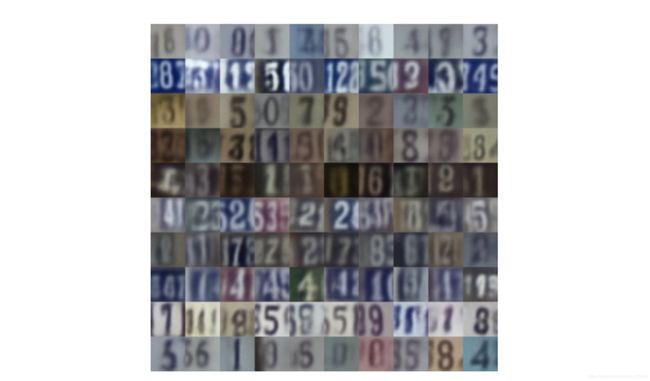

在图5a中,我们通过设置w = 0并从产生的高斯混合中多次采样来探索后一种选择。图5a中的每一行对应于来自高斯混合的不同成分的样本,并且可以清楚地看到,来自相同成分的样本始终如一地产生来自相同数字类别的图像。这证实了学习到的潜在表示包含分化良好的簇,每位数正好一个。另外,在图5b中,我们通过平滑地改变w并从同一分量采样来探索所生成图像对高斯混合分量的敏感性。我们看到,虽然z可靠地控制了生成图像的类别,但是w设置了数字的“样式”。

最后,在图6中,我们显示了从在SVHN上训练的GMVAE采样的图像,表明GMVAE将视觉上相似的图像聚在一起。

图5:生成的MNIST样本:(a)每行包含10个随机生成的样本,这些样本来自高斯混合物的不同高斯分量。 GMVAE学习了有意义的生成模型,其中离散潜变量z以无监督的方式直接对应于数字值。 (b)通过遍历w空间生成的样本,w的每个位置对应于数字的特定样式。

图6:生成的SVHN样本:每行对应于从不同的高斯分量随机生成的10个样本。 GMVAE将视觉上相似的图像分组在一起。

VaDE

在本文中,提出了变分深度嵌入(VaDE),这是一种在变数自动编码器(VAE)框架内的新型无监督生成聚类方法。

具体来说,VaDE使用高斯混合模型(GMM)和深度神经网络(DNN)对数据生成过程进行建模:

1)GMM选择一个聚类;

2)从中生成潜在嵌入;

3)然后,DNN将潜在的嵌入解码为可观察的。

VaDE的推论是以一种变体的方式进行的:使用不同的DNN编码可观察到的潜在嵌入,因此可以使用随机梯度变异贝叶斯(SGVB)估计器和重新参数化技巧来优化证据下界(ELBO)。。与强基线的定量比较包括在本白皮书中,实验结果表明,VaDE在各种模式下的5个基准上均明显优于最新的聚类方法。此外,根据VaDE的生成性质,我们展示了它可以为任何指定簇生成高度真实的样本的能力,而无需在训练过程中使用监督信息。

概述

在本文中,我们提出了一个聚类框架,即变种深度嵌入(VaDE),它结合了VAE Kingma和Welling [2014]以及用于聚类任务的高斯混合模型。

VaDE通过GMM和DNN对数据生成过程进行建模:

1)GMM拾取了一个集群;

2)从中采样潜在表示z;

3)DNN 将z解码为观测值x。

此外,通过使用另一个DNN 将观测数据x编码为潜在嵌入z来优化VaDE,以便可以使用随机梯度变化贝叶斯(SGVB)估计器和重新参数化技巧Kingma and Welling [2014]来最大化证据。下界(ELBO)。 VaDE通过将高斯混合先验替换单个高斯先验来概括VAE。

因此,VaDE在设计上更适合于群集任务。

具体来说,本文的主要贡献是:

• 我们提出了一个无监督的生成聚类框架VaDE,该框架将VAE和GMM组合在一起。

• 我们展示了如何使用SGVB估计器和重新参数化技巧通过最大化ELBO来优化VaDE。

• 实验结果表明,VaDE在各种模式的5个数据集上的表现优于最新的聚类模型;

• 我们证明,VaDE可以为任何指定的簇生成高度逼真的样本,而无需在训练过程中使用监督信息。

VaDE的示意图如图1所示。

图1:VaDE的示意图。 VaDE的数据生成过程如下:

1)从GMM模型中选择一个聚类;

2)根据选取的簇生成潜在嵌入;

3)DNN f(z;θ)将潜在的嵌入解码为可观察的x。 编码器网络g(x;)用于最大化VaDE的ELBO。

Variational Deep Embedding

生成过程

由于VaDE是一种无监督的聚类生成方法,因此我们在此首先描述VaDE的生成过程。 具体来说,假设有K个簇,则通过以下过程生成观察样本x∈RD:

变化下界

了解VaDE的ELBO

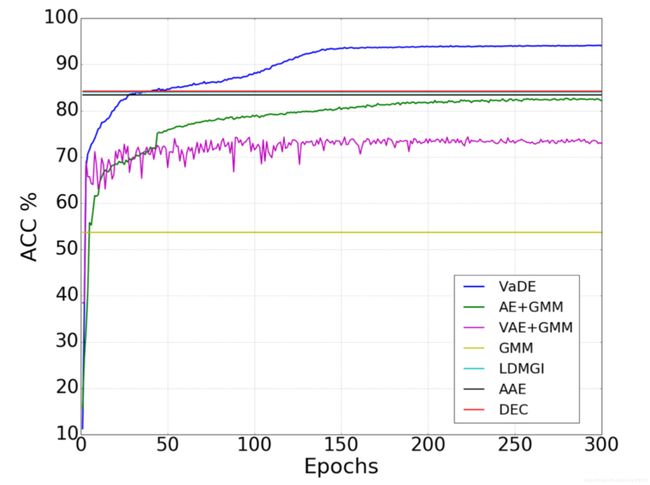

图2:在MNIST上进行训练时,历元数上的聚类精度。 我们还展示了DEC,AAE,LDMGI和GMM的最佳性能。 最好以彩色查看图形。

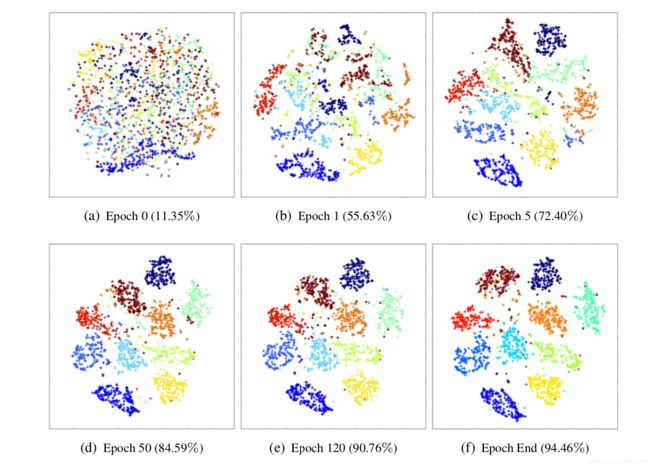

为了证明等式17中KL项的重要性,我们首先训练具有与VaDE相同网络架构的自动编码器(AE),然后将GMM应用于学习到的AE的潜在表示,因为VaDE模型没有KL术语几乎等同于AE。我们将此模型称为AE + GMM。我们还展示了直接在观测空间(GMM)上使用GMM,在观测空间上使用VAE,然后在VAE(VAE + GMM)4的潜在空间上使用GMM的性能,以及LDMGI Yang等的性能。 。 [2010],AAE Makhzani等。 [2016]和DEC Xie等人。 [2016],图2。VaDE优于AE + GMM(无KL项)和VAE + GMM的事实,充分证明了规范化条款的重要性以及通过VaDE共同优化VAE和GMM的优势。我们还提供了集群的插图及其通过w.r.t.进行更改的方式。图3中MNIST数据集上的训练纪元,其中t-SNE Maaten和Hinton [2008]将潜在表示z映射到2D空间。

图3:有关在MNIST训练期间VaDE在潜在空间中如何聚集数据的图示。 不同的颜色表示不同的地面真相类别,并且在相应的纪元处的聚类精度在括号中报告。 很明显,潜在的表示越来越适合训练期间的聚类,这也可以通过提高聚类精度来证明。

实验

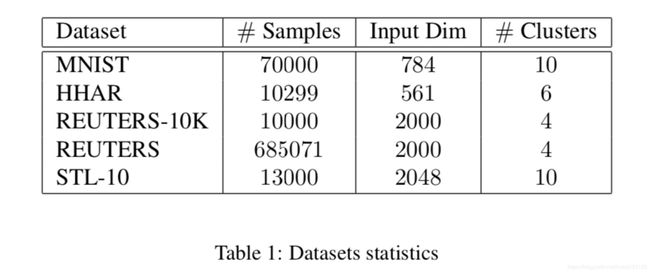

数据集说明

以下数据集用于我们的经验实验。

•MNIST:MNIST数据集由70000个手写数字组成。图像居中,尺寸为28 x 28像素。我们将每个图像重塑为784维矢量。

•HHAR:异质性人类活动识别(HHAR)数据集包含来自智能手机和智能手表的10299条传感器记录。所有样本都分为6类人类活动,每个样本的维度均为561。

•路透社:在原始的路透数据集中,大约有810000个以类别树标记的英语新闻报道。在DEC之后,我们使用了4个根目录类别:公司/工业,政府/社会,市场和经济学作为标签,并丢弃了具有多个标签的所有文档,这产生了685071条数据集。我们计算了2000个最常用词的tf-idf功能,以表示所有文章。与DEC相似,由于某些频谱聚类方法(例如LDMGI)无法扩展到完整的路透数据集,因此会抽取10000个文档的随机子集,称为Reuters-10K。

•STL-10:STL-10数据集由96 x 96像素大小的彩色图像组成。有10个类别,每个类别有1300个示例。由于直接从高分辨率图像的原始像素进行聚类相当困难,因此我们通过ResNet-50 He等人提取了STL-10图像的特征。 [2016],然后将其用于测试VaDE和所有基准的性能。更具体地说,我们在ResNet-50的最后一个特征图上应用了3×3的平均池,特征的维数为2048。

实验装置

如前所述,VaDE采用与DEC相同的网络体系结构进行公平比较。具体来说,公式1和公式10中f和g的体系结构分别为10-2000-500-500-D和D-500-500-2000-10,其中D为输入维数。所有层均已完全连接。 Adam优化器Kingma和Ba [2015]用于最大化等式9的ELBO,最小批量大小为100。MNIST,HHAR,Reuters-10K和STL-10的学习率为0.002,并且每10个周期减少衰减率为0.9,路透社的学习率为0.0005,每个时期的衰减率为0.5。至于第3.1节中的生成过程,MNIST数据集使用多元伯努利分布,而其他则使用多元高斯分布。类似于DEC,每个数据集的类数固定为类数。我们将在4.6节中更改群集的数量。

与其他基于VAE的模型Kingma和Salimans [2016]相似; Sønderby等。 [2016],VaDE遭受的问题是,方程17中的重建项在训练开始时太弱了,以至于模型可能会卡在不良的局部极小值或鞍点中,因此很难逃脱。在这项工作中,可以使用预训练来避免此问题。具体来说,我们使用堆叠式自动编码器对网络f和g进行预训练。然后,所有数据点都通过预训练网络g投影到潜在空间z中,在该网络中,应用GMM初始化{π,μc,σc},c∈{1,…,K}的参数。在实践中,很少有预训练的时期足以提供VaDE的良好初始化。我们发现,VaDE对预训练后的超参数不敏感。因此,我们没有花费很多精力来调整它们。

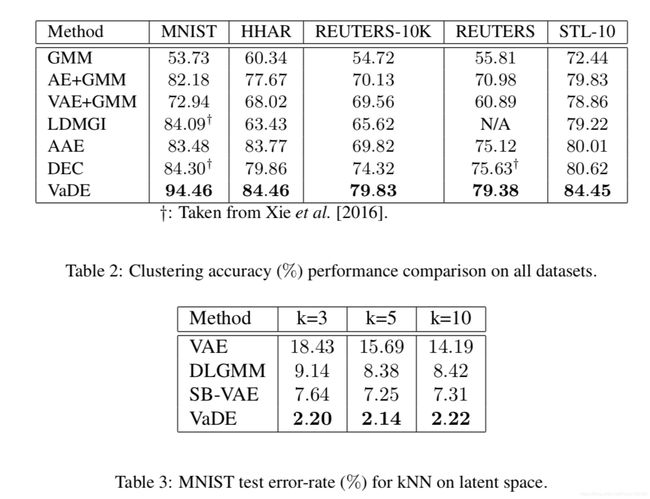

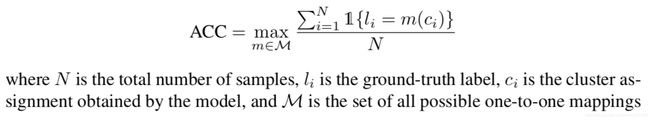

定量比较

在DEC之后,VaDE的性能由无监督聚类精度(ACC)来衡量,其定义为:

其中N是样本总数,li是真实标签,ci是模型获得的聚类分配,M是聚类分配和标签之间所有可能的一对一映射的集合。可以通过使用KuhnMunkres算法Munkres [1957]获得最佳映射。与DEC相似,我们在初始化所有聚类模型时执行10次随机重启,并选择具有最佳目标值的结果。至于LDMGI,AAE和DEC,我们使用与其原始论文相同的配置。表2比较了所有数据集中VaDE与其他基准的性能。可以看出,VaDE在所有数据集上的表现都优于所有这些基线。具体来说,在MNIST,HHAR,Reuters-10K,Reuters和STL-10数据集上,VaDE的ACC分别为94.46%,84.46%,79.83%,79.38%和84.45%,相对DEC的表现要好,相对增长率为12.05%,5.76 %,7.41%,4.96%和4.75%。

我们还将VaDE与SB-VAE Nalisnick和Smyth [2016]和DLGMM Nalisnick等进行了比较。 [2016]关于潜在表示的区分能力,因为这两个基准不能完成聚类任务。在SB-VAE之后,通过在MNIST的潜在表示上运行k最近邻居分类器(kNN)来评估模型的潜在表示的区别力。表3显示了潜在表示形式下kNN分类器的错误率。可以看出,VaDE的性能明显优于SB-VAE和DLGMM5。

请注意,尽管VaDE可以学习样本的判别式表示,但是VaDE的训练是完全不受监督的。因此,我们没有将VaDE与其他监督模型进行比较。

通过VaDE生成样本

VaDE比DEC Xie等人的一大优势。 [2016]认为它本质上是一个生成聚类模型,可以为任何指定的聚类(类)生成高度逼真的样本。 在本节中,我们将对VaDE,GMM,VAE和最新的生成方法InfoGAN Gan等人的生成样本进行定性比较。 [2016]。

图4分别说明了GMM,VAE,InfoGAN和VaDE为MNIST的0至9类生成的样本。 可以看出,VaDE生成的数字是平滑且多样化的。 请注意,无法指定来自VAE的样本类别。 我们还可以看到,VaDE的性能与InfoGAN相当。

图4:由GMM,VAE,InfoGAN和VaDE生成的数字。除(b)以外,同一行中的数字来自同一集群。

可视化学习的嵌入

在本节中,我们将MNIST数据集上的VAE,DEC和VaDE的学习表示形式可视化。为此,我们使用t-SNE Maaten和Hinton [2008]将潜在表示z的维数从10减小到2,并在图5中绘制2000个随机采样的数字。图5的第一行说明了地面-每个数字的真实标签,其中不同的颜色表示不同的标签。图5的第二行演示了聚类结果,其中正确聚类的样本以绿色着色,而错误聚类的样本以红色着色。

从图5中可以看到,使用单个高斯先验的原始VAE在聚类任务中表现不佳。还可以观察到,由于不正确聚类的样本数量较少,VaDE所学习的嵌入要比VAE和DEC更好。此外,通过VaDE错误地聚类的样本大多位于每个聚类的边界,通常会在其中出现令人困惑的样本。相反,许多错误地聚类的DEC样本出现在聚类的内部,这表明DEC无法保留数据的固有结构。图5中还标出了DEC和VaDE的一些错误。

图5:分别由VAE,DEC和VaDE在MNIST上学习的嵌入的可视化。第一行显示了每个数字的真实标签,其中不同的颜色表示不同的标签。第二行展示了聚类结果,正确聚类的样本用绿色上色,不正确的样本用红色上色。 GT:4表示数字的真实标签为4,DEC:4表示DEC将数字分配给4的簇,而VaDE:4表示通过VaDE进行的分配为4,依此类推。最好以彩色查看图形。

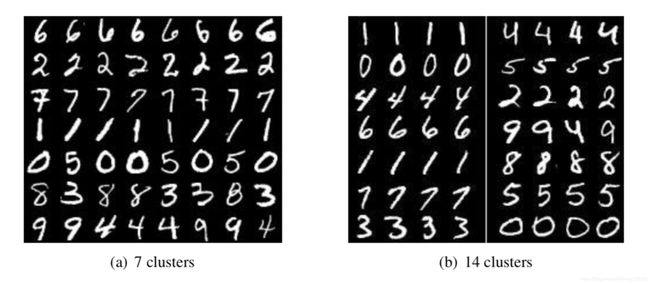

The Impact of the Number of Clusters

到目前为止,VaDE的聚类数设置为每个数据集的类数,这是一个先验知识。 为了演示VaDE作为无监督聚类模型的表示能力,我们特意选择了不同数量的聚类K。图6中的每一行说明了在MNIST数据集上由VaDE分组的聚类的样本,其中K设置为图7和14。 分别参见图6(a)和图6(b)。 我们可以看到,如果K小于类的数目,则具有相似外观的数字将聚在一起,例如图6(a)中的9和4、3和8。 另一方面,如果K大于类别数,则某些数字将被VaDE划分为子类别,例如图6(b)中的0较粗的数字和0较细的数字,以及1和斜线1。

图6:具有不同数量集群的MNIST集群。 我们按行说明属于每个群集的样本。