大数据技术原理与应用 第四章 分布式数据库HBase

厦门大学林子雨老师课程 —— 大数据技术原理与应用 学习笔记

参考资料:

http://dblab.xmu.edu.cn/post/bigdata-online-course/#lesson0

https://www.ibm.com/developerworks/cn/analytics/library/ba-cn-bigdata-hbase/index.html

1. HBase与HDFS、MapReduce、Hive之间的关系

Hadoop HDFS为HBase提供了高可靠性的底层存储支持,Hadoop MapReduce为HBase提供了高性能的计算能力,Zookeeper为HBase提供了稳定服务和failover机制。Pig和Hive还为HBase提供了高层语言支持,使得在HBase上进行数据统计处理变的非常简单。 Sqoop则为HBase提供了方便的RDBMS(关系型数据库)数据导入功能,使得传统数据库数据向HBase中迁移变的非常方便。

2. HBase与传统关系型数据库之间的区别

3. HBase的数据模型

表:HBase采用表来组织数据,表由行和列组成,列划分为若干个列族行:每个HBase表都由若干行组成,每个行由行键(row key)来标识。

列族:一个HBase表被分组成许多“列族”(Column Family)的集合,它是基本的访问控制单元

列限定符:列族里的数据通过列限定符(或列)来定位

单元格:在HBase表中,通过行、列族和列限定符确定一个“单元格”(cell),单元格中存储的数据没有数据类型,总被视为字节数组byte[]

时间戳:每个单元格都保存着同一份数据的多个版本,这些版本采用时间戳进行索引

HBase中需要根据行键、列族、列限定符和时间戳来确定一个单元格,因此,可以视为一个“四维坐标”,即[行键, 列族, 列限定符, 时间戳]HBase的概念视图

HBase的物理视图

列族contents

列族anchor

4. HBase的实现原理

HBase的实现包括三个主要的功能组件:

(1)库函数:链接到每个客户端(2)一个Master主服务器

(3)许多个Region服务器

主服务器Master负责管理和维护HBase表的分区信息,维护Region服务器列表,分配Region,负载均衡

Region服务器负责存储和维护分配给自己的Region,处理来自客户端的读写请求,一个region服务器上存储10-1000个region

客户端并不是直接从Master主服务器上读取数据,而是在获得Region的存储位置信息后,直接从Region服务器上读取数据

客户端并不依赖Master,而是通过Zookeeper来获得Region位置信息,大多数客户端甚至从来不和Master通信,这种设计方式使得Master负载很小

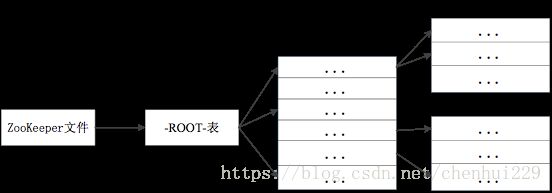

5. Region的定位

| 层次 | 名称 | 作用 |

| 第一层 | Zookeeper文件 | 记录了ROOT表的位置信息 |

| 第二层 | ROOT表 | 记录了META表的region位置信息 ROOT表只有一个region,通过ROOT表,就可以访问MEAT表的数据 |

| 第三层 | META表 | 记录了用户数据表的region位置信息,META表可以有多个region,保存了HBase中所有用户数据表的region位置信息 |

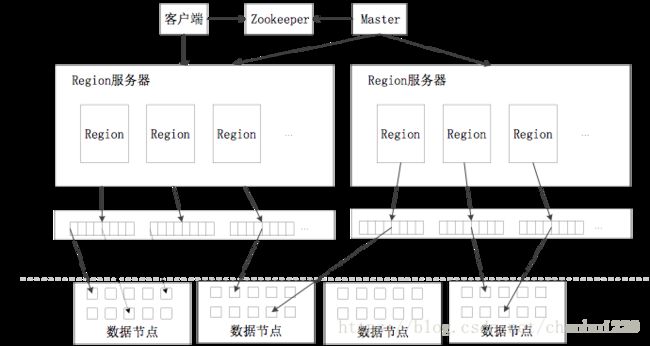

6. HBase的运行机制

HBase的系统架构

客户端

客户端包含访问HBase的接口,同时在缓存中维护着已经访问过的Region位置信息,用来加快后续数据访问过程

Zookeeper服务器

Zookeeper可以帮助选举出一个Master作为集群的总管,并保证在任何时刻总有唯一一个Master在运行,这就避免了Master的“单点失效”问题

Master服务器

主服务器Master主要负责表和Region的管理工作:

管理用户对表的增加、删除、修改、查询等操作实现不同Region服务器之间的负载均衡

在Region分裂或合并后,负责重新调整Region的分布

对发生故障失效的Region服务器上的Region进行迁移

Region服务器

Region服务器是HBase中最核心的模块,负责维护分配给自己的Region,并响应用户的读写请求

Region服务器的工作原理

(1)用户读写数据过程

用户写入数据时,被分配到相应Region服务器去执行用户数据首先被写入到MemStore和Hlog中

只有当操作写入Hlog之后,commit()调用才会将其返回给客户端

当用户读取数据时,Region服务器会首先访问MemStore缓存,如果找不到,再去磁盘上面的StoreFile中寻找

(2)缓存的刷新

系统会周期性地把MemStore缓存里的内容刷写到磁盘的StoreFile文件中,清空缓存,并在Hlog里面写入一个标记

每次刷写都生成一个新的StoreFile文件,因此,每个Store包含多个StoreFile文件

每个Region服务器都有一个自己的HLog 文件,每次启动都检查该文件,确认最近一次执行缓存刷新操作之后是否发生新的写入操作;如果发现更新,则先写入MemStore,再刷写到StoreFile,最后删除旧的Hlog文件,开始为用户提供服务

(3)Storefile的合并

每次刷写都生成一个新的StoreFile,数量太多,影响查找速度调用Store.compact()把多个合并成一个

合并操作比较耗费资源,只有数量达到一个阈值才启动合并

Hlog的工作原理

分布式环境必须要考虑系统出错。HBase采用HLog保证系统恢复

HBase系统为每个Region服务器配置了一个HLog文件,它是一种预写式日志(Write Ahead Log)用户更新数据必须首先写入日志后,才能写入MemStore缓存,并且,直到MemStore缓存内容对应的日志已经写入磁盘,该缓存内容才能被刷写到磁盘

Zookeeper会实时监测每个Region服务器的状态,当某个Region服务器发生故障时,Zookeeper会通知Master。Master首先会处理该故障Region服务器上面遗留的HLog文件,这个遗留的HLog文件中包含了来自多个Region对象的日志记录。系统会根据每条日志记录所属的Region对象对HLog数据进行拆分,分别放到相应Region对象的目录下,然后,再将失效的Region重新分配到可用的Region服务器中,并把与该Region对象相关的HLog日志记录也发送给相应的Region服务器。Region服务器领取到分配给自己的Region对象以及与之相关的HLog日志记录以后,会重新做一遍日志记录中的各种操作,把日志记录中的数据写入到MemStore缓存中,然后,刷新到磁盘的StoreFile文件中,完成数据恢复

共用日志优点:提高对表的写操作性能;缺点:恢复时需要分拆日志