NIPS2018深度学习(8)|亮点:实证深度学习、贝叶斯、半监督众包聚类

[1] Evidential Deep Learning to Quantify Classification Uncertainty

Murat Sensoy, Lance Kaplan, Melih Kandemir

Ozyegin University, Adelphi, Robert-Bosch-Campus

https://papers.nips.cc/paper/7580-evidential-deep-learning-to-quantify-classification-uncertainty.pdf

确定性神经网络在很多机器学习任务中都能学到效果不错的预测器。然而,由于标准方法是训练网络使得预测误差最小,这种情况下得到的模型忽略了预测的置信度。贝叶斯神经网络通过权值的不确定性来间接地推理预测的不确定性,基于此,作者们提出利用主观逻辑理论得到精确模型。

在类别概率上赋予Dirichlet分布,将神经网络的预测看做主观观点,并且从数据中利用确定性神经网络来学习某种函数,该函数用来收集得到这些观点的证据。在多类别分类问题中,该方法得到的预测器服从Dirichlet分布,该分布的参数由神经网络的连续输出来设置。这种新颖的损失函数可以提升不确定性估计。这种方法在异常查询检测中取得的效果超奇的好,并且对对抗性干扰的鲁棒性较好。

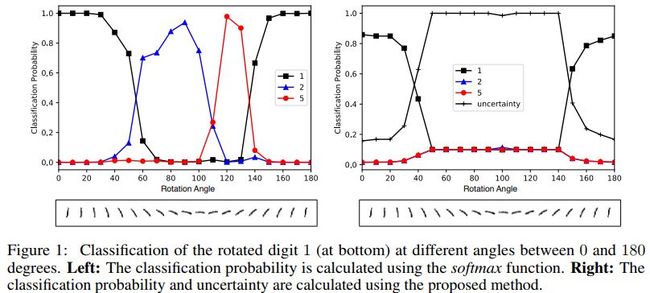

本文所提方法跟softmax效果对比如下

不同阈值在不同数据集上的影响如下

几种方法在两个数据集上的效果对比如下

其中 L2是标准的确定性神经网络,加入了softmax输出层和权重衰减

Dropout对应的论文为

Bayesian convolutional neural networks with bernoulli approximate variational inference, ICLR 2016

代码地址

https://github.com/yaringal/DropoutUncertaintyCaffeModels

Deep Ensemble对应的论文为

Simple and scalable predictive uncertainty estimation using deep ensembles, NIPS 2017

代码地址

https://github.com/muupan/deep-ensemble-uncertainty

FFG 对应的论文为

Variational dropout and the local reparameterization trick, NIPS 2015

代码地址

https://github.com/gngdb/variational-dropout

https://github.com/kefirski/variational_dropout

Variational dropout sparsifies deep neural networks, ICML 2017

代码地址

https://github.com/senya-ashukha/variational-dropout-sparsifies-dnn

MNFG对应的论文为

Multiplicative normalizing flows for variational bayesian neural networks, ICML 2017

代码地址

https://github.com/AMLab-Amsterdam/MNF_VBNN

上面几种算法的准确率和熵相对对抗干扰因子变化的对比如下

代码地址

https://muratsensoy.github.io/uncertainty.html

![]() 我是分割线

我是分割线![]()

[2] Parsimonious Bayesian deep networks

Mingyuan Zhou

The University of Texas at Austin

https://papers.nips.cc/paper/7581-parsimonious-bayesian-deep-networks.pdf

这篇文章将贝叶斯非参数方法与前向模型选择策略结合,提出了简约贝叶斯深层网络 (PBDNs)。这种网络能够从数据中推断出网络结构,不需要交叉验证,训练模型时也不需要微调。

PBDN中有两个重要组成部分,其一为无限宽的只有一个隐含层的神经网络,该网络中激活隐层单元的个数可以从数据中推断得到。另外一个重要组成部分即为贪婪式逐层学习算法,利用前向模型选择标准决定何时停止添加更多的隐含层。

作者们基于Gibbs采样和随机梯度下降构建了最大化后验推理方法,不仅准确率较高,而且计算复杂度低。

几种方法的效果对比如下

代码地址

https://github.com/mingyuanzhou/PBDN

![]() 我是分割线

我是分割线![]()

[3] Semi-crowdsourced Clustering with Deep Generative Models

Yucen Luo, Tian Tian, Jiaxin Shi, Jun Zhu , Bo Zhang

Tsinghua University

https://papers.nips.cc/paper/7583-semi-crowdsourced-clustering-with-deep-generative-models.pdf

这篇文章主要讨论半监督聚类问题,场景为数据的小子集(这里的小子集即为同一个聚类)中样本对之间做对比时,众包会带来一些噪声信息。

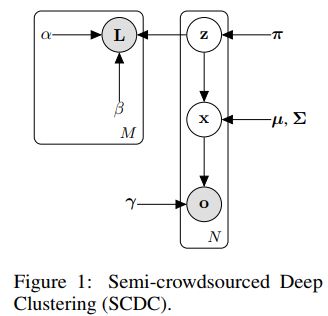

作者们提出一种新的方法,该方法包含了深层生成式模型(DGM),用来表征源数据中的低层特征,还包含了一个统计关系模型,用于对聚类子集得到噪声成对注释。这两个部分共享隐含变量。

为了使得模型能够在复杂度和对数据的拟合度之间自动的进行折中,作者还提出了完全贝叶斯化的变体模型。推理过程中的挑战性利用快速(自然梯度)随机变分推理算法来解决,在统一框架下将关系部分的变分信息传递和DGM的平摊学习有效地结合起来。

半众包深层聚类结构如下

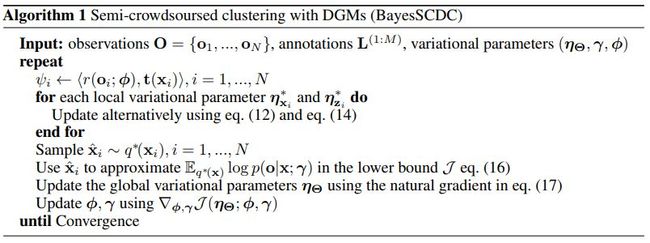

算法流程伪代码如下

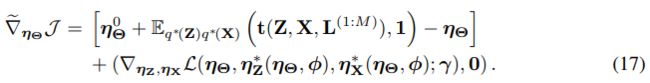

其中式(12) (14) (16) (17)分别为

![]()

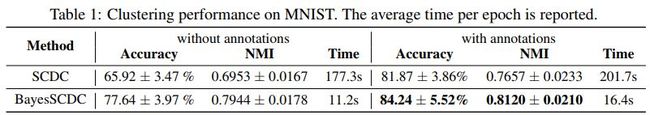

几种方法的效果对比如下

其中Multiple Clustering Views from the Crowd (MCVC) 对应的论文为

Multiple clustering views from multiple uncertain experts, ICML 2017

Information-Theoretic Metric Learning (ITML) 对应的论文为

Information-theoretic metric learning, ICML 2007

代码地址

http://www.cs.utexas.edu/users/pjain/itml/download/itml-1.2.tar.gz

Cluster-based Similarity Partitioning Algorithm (CSPA) 对应的论文为

Cluster ensembles—a knowledge reuse framework for combining multiple partitions. JMLR 2002

SemiCrowd对应的论文为

Semi-crowdsourced clustering: Generalizing crowd labeling by robust distance metric learning. NIPS 2012

Metric Pairwise Constrained KMeans (MPCKMeans)对应的论文为

Integrating constraints and metric learning in semi-supervised clustering. ICML 2004

贝叶斯的影响如下

代码地址

https://github.com/xinmei9322/semicrowd

![]() 我是分割线

我是分割线![]()

您可能感兴趣