win10+vs2015+OpenVINO安装使用

OpenVINO是英特尔基于自身现有的硬件平台开发的一种可以加快高性能计算机视觉和深度学习视觉应用开发速度工具套件,支持各种英特尔平台的硬件加速器上进行深度学习,并且允许直接异构执行。 支持在Windows与Linux系统,Python/C++语言。

主要特点:

1)在Intel平台上提升计算机视觉相关深度学习性能达19倍以上

2)解除CNN-based的网络在边缘设备的性能瓶颈

3)对OpenCV,OpenXV*视觉库的传统API实现加速与优化

4)基于通用API接口在CPU、GPU、FPGA等设备上运行加上

OpenVINO工具包(ToolKit)主要包括两个核心组件,模型优化器(Model Optimizer)和推断引擎(Inference Engine)。

1)模型优化器支持的深度学习框架:

ONNX

TensorFlow

Caffe

MXNet

Kaldi

2)推断引擎(Inference Engine)

推断引擎(Inference Engine)支持硬件指令集层面的深度学习模型加速运行,同时对传统的OpenCV图像处理库也进行了指令集优化,有显著的性能与速度提升。

支持的硬件设备:

CPU

GPU

FPGA

VPU

1、OpenVINO安装

1)下载Intel® OpenVINO™ Toolkit:

网址:https://software.intel.com/en-us/openvino-toolkit/choose-download

注意需要注册一下。

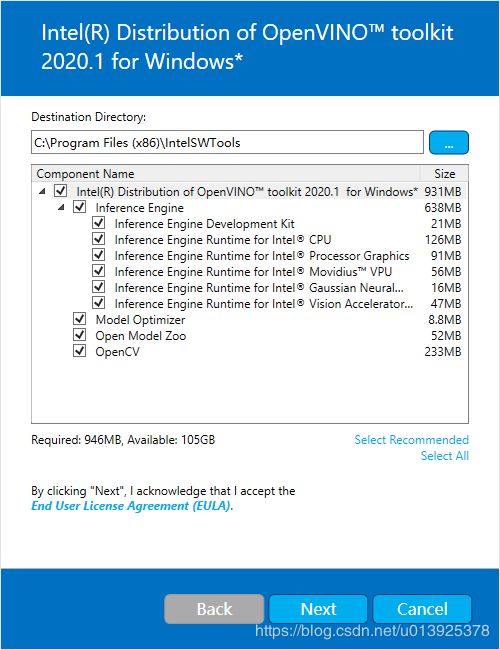

2)安装【最好安装在默认路径下】

双击:w_openvino_toolkit_p_2020.1.033.exe

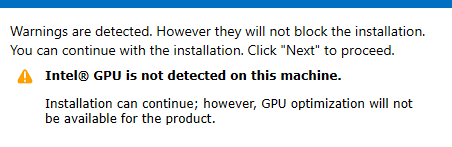

如果缺少外部依赖项,则会看到警告屏幕。记下缺少的依赖项。此时不需要采取任何其他行动。安装英特尔®分布式OpenVINO™工具包核心组件后,将提供安装缺少的依赖项的说明。下面的屏幕示例表明缺少一个依赖项:

继续点击“Next”,完成安装。

安装的第一部分完成后,最终屏幕会通知已安装核心组件并仍需要执行其他步骤:

点击“Finish”完成安装。

2 、环境配置

官方配置方法:

https://docs.openvinotoolkit.org/2020.1/_docs_install_guides_installing_openvino_windows.html#set-the-environment-variables

1)首先确保软件所依赖的其他条件都满足:

2)设置环境变量

打开命令窗口,进入目录:cd C:\Program Files (x86)\IntelSWTools\openvino\bin\

执行:setupvars.bat

这种设置只是在当前cmd窗口有效,一旦关闭cmd就失效了,下次需要重复这样的操作。永久有效的方式是添加到环境变量Path。

“此电脑”->“右键属性”->“高级系统设置”->“环境变量”->“系统变量”->“Path”中配置:

PYTHONPATH=C:\Program Files (x86)\IntelSWTools\openvino_2020.1.033\deployment_tools\open_model_zoo\tools\accuracy_checker;C:\Program Files (x86)\IntelSWTools\openvino_2020.1.033\python\python3.7;C:\Program Files (x86)\IntelSWTools\openvino_2020.1.033\python\python3;C:\Program Files (x86)\IntelSWTools\openvino_2020.1.033\deployment_tools\model_optimizer;

3)配置模型优化器(Model Optimizer)

模型优化器是OpenVINO英特尔发行版的关键组件™ 工具箱。如果不通过模型优化器运行模型,则无法对经过训练的模型进行推断。可以一次为所有受支持的框架配置模型优化程序,也可以一次为一个框架配置模型优化程序。选择最适合需求的选项。如果看到错误消息,请确保已安装所有依赖项。

注意:成功执行以下步骤需要Internet访问权限。如果您只能通过代理服务器访问Internet,请确保在的环境中配置了Internet。

3.1)同时为所有支持的框架配置Model Optimizer:

运行:

C:\Program Files (x86)\IntelSWTools \openvino\deployment_tools\model_optimizer\install_prerequisites\install_prerequisites_onnx.bat

报错如下:

解决:已安装python3.4版本以上的,就不需要重新安装。在安装的python的python\scripts文件中查看是否有以下文件:pip.exe、pip3.6.exe,有则表明pip已经在安装python的时候已经自带。

将该路径配置环境变量中。

将install_prerequisites.bat中的pip3改为pip。

3.2)分别为每个框架配置模型优化器:

转到Model Optimizer先决条件目录:

cd C:\Program Files (x86)\IntelSWTools\openvino_2020.1.033\deployment_tools\model_optimizer\install_prerequisites

对于Caffe:

install_prerequisites_caffe.bat

对于TensorFlow:

install_prerequisites_tf.bat

对于MXNet:

install_prerequisites_mxnet.bat

对于ONNX:

install_prerequisites_onnx.bat

对于Kaldi:

install_prerequisites_kaldi.bat

注意,如果安装失败,则修改对应的requirements_xxx.txt,添加下载源:

如将requirements_onnx.txt修改为如下,添加清华下载源:

onnx==1.6.0 -i https://pypi.tuna.tsinghua.edu.cn/simple

networkx==2.4 -i https://pypi.tuna.tsinghua.edu.cn/simple

numpy==1.18.0 -i https://pypi.tuna.tsinghua.edu.cn/simple

defusedxml==0.6.0 -i https://pypi.tuna.tsinghua.edu.cn/simple

如果还是失败,则单独运行下列命令来安装。

pip install onnx==1.6.0 -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install networkx==2.4 -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install numpy==1.18.0 -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install defusedxml==0.6.0 -i https://pypi.tuna.tsinghua.edu.cn/simple

3、例子编译测试

进入C:\Program Files (x86)\IntelSWTools\openvino_2020.1.033\inference_engine\demos,发现有CMakeLists.txt文件,直接使用cmake进行编译,即可正确生成工程。

如测试人体姿态部分,将Demo中,human_pose_estimation_demo设置为启动项,配置参数进行运行。

参数:-m /pose_model.xml -i /video/1.avi