- LeetCode 题目 49:字母异位词分组 5种算法实现与典型应用案例【python】

数据分析螺丝钉

LeetCode刷题与模拟面试算法leetcodepython数据结构职场和发展

作者介绍:10年大厂数据\经营分析经验,现任大厂数据部门负责人。会一些的技术:数据分析、算法、SQL、大数据相关、python欢迎加入社区:码上找工作作者专栏每日更新:LeetCode解锁1000题:打怪升级之旅python数据分析可视化:企业实战案例备注说明:方便大家阅读,统一使用python,带必要注释,公众号数据分析螺丝钉一起打怪升级题目描述首先,字母异位词是指由相同字母以不同顺序组成的单词

- 数据挖掘与数据分析两者的区别

中琛源科技

随着大数据爆发式增长,市场上对大数据相关人才的需求与日俱增,导致大数据行业人才需求紧缺,引发了关于大数据的学习浪潮,在这个过程中,人们也会不时将数据分析与数据挖掘的关系混淆,什么是数据挖掘?与数据分析有什么联系吗?又或者说数据挖掘与数据分析有什么区别呢?让我们带着这些问题,一起往下解惑吧。数据分析简单的说,就是对数据进行分析,比较专业的说法是,数据分析是指用适当的统计分析方法对收集来的大量数据进行

- 大数据相关开源项目汇总

万里浮云

大数据

调度与管理服务Azkaban是一款基于Java编写的任务调度系统任务调度,来自LinkedIn公司,用于管理他们的Hadoop批处理工作流。Azkaban根据工作的依赖性进行排序,提供友好的Web用户界面来维护和跟踪用户的工作流程。YARN是一种新的Hadoop资源管理器,它是一个通用资源管理系统,可为上层应用提供统一的资源管理和调度,解决了旧MapReduce框架的性能瓶颈。它的基本思想是把资源

- 大数据相关职位介绍之三(数据挖掘,数据安全 ,数据合规师,首席数据官,数据科学家 )

小Tomkk

大数据大数据数据挖掘首席数据官数据合规师数据安全数据科学家

大数据相关职位介绍之三(数据挖掘,数据安全,数据合规师,首席数据官,数据科学家)文章目录大数据相关职位介绍之三(数据挖掘,数据安全,数据合规师,首席数据官,数据科学家)1.数据挖掘工程师(DataMiningEngineer)2.数据安全工程师(DataSecurityEngineer)3.数据合规师(DataComplianceOfficer)4.首席数据官(CDO-ChiefDataOffic

- 大数据相关职位介绍之二(数据治理,数据库管理员, 数据资产管理师,数据质量专员)

小Tomkk

大数据大数据数据治理数据库管理员数据资产管理师数据质量专员

大数据相关职位介绍之二(数据治理,数据库管理员,数据资产管理师,数据质量专员)文章目录大数据相关职位介绍之二(数据治理,数据库管理员,数据资产管理师,数据质量专员)数据治理工程师/专家(DataGovernanceEngineer/Expert)1.元数据管理师(MetadataManager)2.主数据管理师(MasterDataManager)数据库管理员(DBA-DatabaseAdmini

- Lambda架构

leveretz

大数据lambda

原文地址:https://www.cnblogs.com/xiaodf/p/11642555.html首先我们来看一个典型的互联网大数据平台的架构,如下图所示:在这张架构图中,大数据平台里面向用户的在线业务处理组件用褐色标示出来,这部分是属于互联网在线应用的部分,其他蓝色的部分属于大数据相关组件,使用开源大数据产品或者自己开发相关大数据组件。你可以看到,大数据平台由上到下,可分为三个部分:数据采集

- 有史以来最全的异常类讲解没有之一!第二部分爆肝2万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第二部分

长风清留扬

最新Python入门基础合集python笔记学习异常处理改行学it异常BUG

本文是第二部分,第一部分请看:有史以来最全的异常类讲解没有之一!爆肝3万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第一部分博客主页:长风清留扬-CSDN博客系列专栏:Python基础专栏每天更新大数据相关方面的技术,分享自己的实战工作经验和学习总结,尽量帮助大家解决更多问题和学习更多新知识,欢迎评论区分享自己的看法感谢大家点赞收藏⭐评论异常类型IndexError

- 有史以来最全的异常类讲解没有之一!第三部分爆肝4万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第三部分

长风清留扬

最新Python入门基础合集python面试异常处理BUG异常类型职场和发展改行学it

本文是第三部分,第一第二部分请看:有史以来最全的异常类讲解没有之一!爆肝3万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第一部分有史以来最全的异常类讲解没有之一!第二部分爆肝2万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第二部分博客主页:长风清留扬-CSDN博客系列专栏:Python基础专栏每天更新大数据相关方面的技术,分享自己的实

- 还在为Python“运算符”中遇到的BUG而发愁吗?,变量相关的问题和解决办法看这篇文章就够了!

长风清留扬

androidpythonbug运算符

博客主页:长风清留扬-CSDN博客系列专栏:Python疑难杂症百科-BUG编年史每天更新大数据相关方面的技术,分享自己的实战工作经验和学习总结,尽量帮助大家解决更多问题和学习更多新知识,欢迎评论区分享自己的看法感谢大家点赞收藏⭐评论关于运算符中常见的问题和解决方法在Python编程的浩瀚宇宙中,变量如同星辰般璀璨,它们承载着数据,驱动着程序的运行。然而,即便是这些看似简单的构建块,也时常隐藏着令

- 动态规划详解-最小路径和问题【python】

数据分析螺丝钉

LeetCode刷题与模拟面试动态规划算法leetcodepython数据结构

作者介绍:10年大厂数据\经营分析经验,现任大厂数据部门负责人。会一些的技术:数据分析、算法、SQL、大数据相关、python欢迎加入社区:码上找工作作者专栏每日更新:LeetCode解锁1000题:打怪升级之旅python数据分析可视化:企业实战案例备注说明:方便大家阅读,统一使用python,带必要注释,公众号数据分析螺丝钉一起打怪升级1.问题介绍和应用场景最小路径和问题是一个常见的动态规划问

- 软考信安26~大数据安全需求分析与安全保护工程

jnprlxc

软考~信息安全工程师需求分析安全运维笔记

1、大数据安全威胁与需求分析1.1、大数据相关概念发展大数据是指非传统的数据处理工具的数据集,具有海量的数据规模、快速的数据流转、多样的数据类型和价值密度低等特征。大数据的种类和来源非常多,包括结构化、半结构化和非结构化数据。1.2、大数据安全威胁分析(1)“数据集“安全边界日渐模糊,安全保护难度提升(2)敏感数据泄露安全风险增大(3)数据失真与大数据污染安全风险(4)大数据处理平台业务连续性与拒

- 大数据分析与安全分析

Zh&&Li

网络安全运维数据分析安全数据挖掘运维数据库

大数据分析一、大数据安全威胁与需求分析1.1大数据相关概念发展大数据:是指非传统的数据处理工具的数据集大数据特征:海量的数据规模、快速的数据流转、多样的数据类型和价值密度低等大数据的种类和来源非常多,包括结构化、半结构化和非结构化数据有关大数据的新兴网络信息技术应用不断出现,主要包括大规模数据分析处理、数据挖掘、分布式文件系统、分布式数据库、云计算平台、互联网和存储系统1.2大数据安全威胁分析“数

- pyflink 滚动窗口实例

菜鸟社长

菜鸟的大数据进阶之路大数据进阶之路kafkabigdatapythonflink

写在前头:更多大数据相关精彩内容请进我的知识星球,每周定期更新正篇技术路线:模拟kafka生产者发送数据——>flink对kafka数据实时计算处理——>处理后的数据发送到kafka1、模拟客流数据的生产者,参考https://blog.csdn.net/qq_22611181/article/details/1199002502、flink聚合操作原理介绍,参考https://blog.csdn

- Python自动化:Python操作Excel的多种方式Pandas+openpyxl+xlrd

长风清留扬

Pythonexcelpythonpandas自动化Python办公自动化数据分析开发语言

在Python中,操作Excel数据通常可以通过几个流行的库来实现,比如pandas、openpyxl、xlrd等。下面会分别介绍这三个流行库来实现对Excel的操作。博客主页:长风清留扬-CSDN博客每天更新大数据相关方面的技术,分享自己的实战工作经验和学习总结,尽量帮助大家解决更多问题和学习更多新知识,欢迎评论区分享自己的看法感谢大家点赞收藏⭐评论推荐阅读:Python入门最全基础Python

- 高校为什么需要AIGC大数据实验室?

泰迪智能科技01

AIGCAIGC大数据

AIGC大数据实验室是一个专注于人工智能生成内容(AIGC)和大数据相关技术研究、开发与应用的创新实验平台。AIGC主要研究方向包括:AIGC技术创新、大数据处理与分析、AIGC与大数据融合应用。AIGC技术创新:探索如何利用人工智能算法,如深度学习中的生成对抗网络(GAN)、变分自编码器(VAE)、基于Transformer架构的语言模型(如GPT系列)等,来高效地生成高质量的文本、图像、音频、

- php案例分析百度云_基于阿里云平台的大数据教学案例 —— B站弹幕数据分析

weixin_39892311

php案例分析百度云

简介:实验基于所学的大数据处理知识,结合阿里云大数据相关产品,分组完成一个大数据分析项目,数据集可以使用开源数据集或自行爬取,最终完成一个完整的实验报告:1、能够使用阿里云大数据相关产品完成数据分析、数据建模与模型优化2、能够基于分析结构构建可视化门户或可视化大屏,分析和呈现不少于5个3、分析案例有实用价值并能够形成有效结论4、能够将开源技术与阿里云产品结合,综合利用提升开发效率,降低成本5、能够

- Hbase集群搭建超详细教程

笑看风云路

集群搭建系列hbasehbasehadoop大数据

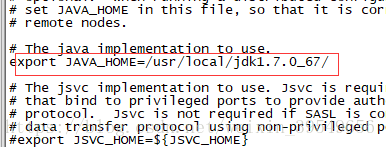

Hbase集群搭建前言详细步骤1、下载安装包2、解压3、修改配置文件3.1修改hbase-env.sh文件3.2修改hbase-site.xml3.3修改regionservers文件4、分发hbase目录5、启动HBase集群6、查看HBaseWebUI大家好,我是风云,欢迎大家关注我的博客,在未来的日子里我们一起来学习大数据相关的技术,一起努力奋斗,遇见更好的自己!前言HBase是一个开源的、

- 魔法王国的故事——档案馆的危机

健鑫.

数据仓库大数据hadoop

❝这是一个连续的专栏,在这里,我将用一个奇幻的魔法王国的故事,来向你介绍大数据相关内容,希望在这里可以帮助你学到有用的知识第一章:档案馆的危机在一个遥远的魔法王国,有一个叫做档案馆的地方,那里存放着王国的所有重要的文件,比如法律、历史、魔法、地理等等。这些文件是王国的智慧之源,也是王国的秘密之宝,它们记录着王国的过去、现在和未来。档案馆由一位叫做档案大臣的人负责管理,他是王国最聪明也最忙碌的人之一

- 西安-腾讯云-Python面试经验--一面凉经

jiet07

腾讯云面试

自我介绍手撕链表排序操作系统a.线程和进程区别b.线程安全c.如何保证线程安全d.线程崩溃,会不会影响所在的进程e.什么是守护进程,僵尸进程,孤儿进程f.如何产生一个守护进程g.如何避免僵尸进程或者孤儿进程redisa.持久化方式有哪些,区别是什么b.redis集群有了解么c.rediszset()—底层如何实现(哈希表+跳跃表)和大数据相关的操作a.请求有多少,数据有多少b.Gbp/s负载均衡a

- 报表任务治理计划

liujianhuiouc

背景介绍近些年来,大数据技术得到了很广的应用,支撑了业务的快速发展。作为大数据的平台部门,提供了大数据相关的基础能力,业务同学借助于大数据的底层赋能完成更偏向业务的需求开发。报表是大数据支撑最早最广的功能形态。先给大家介绍我们我们公司的报表产出组件图:报表产出图底层平台由HDFS、Yarn分别提供存储和计算支持在这之上我们提供了一套支持MR、Spark任务开发、依赖执行的调度系统BI业务同学利用调

- 大数据相关技术

ssttIsme

1数据获取方式爬虫:分布式爬虫java的jsoup(操作方式基于选择器),pythoon,八爪鱼日志收集:log4j(可以控制级别和放置的位置)(可以输出数据到flume)(可以输出到mq),flume(分布式日志收集系统)(收集用户ip,访问了哪个方法)(例如三大运营商的日志分析能根据用户71个字段,拿到谁在什么时间什么地点用什么手机什么浏览器哪个版本访问了什么网站访问了多长时间网站内容是什么)

- 大数据从何学起?大数据脑图+学习路线清晰的告诉你!

yoku酱

近些年,大数据的火热可谓是技术人都知道啊,很多人呢,也想学习大数据相关,但是又不知道从何下手,所以今天柠檬这里分享几个大数据脑图,希望可以让你清楚明白从哪里入门大数据,知道该学习以及掌握哪些知识点;当然还有自学教程分享哦!【大数据开发学习资料领取方式】:加入大数据技术学习交流扣扣群458345782,点击加入群聊,私信管理员即可免费领取第一阶段linux+搜索+hadoop体系Linux基础→sh

- 想学大数据?先看完这几本书再说

yoku酱

真正的数据爱好者有很多需要阅读的内容:大数据,机器学习,数据科学,数据挖掘等。除了这些技术领域,还有一些特定的技术和语言需要你继续研究:Hadoop,Spark,Python,和R等等,还有无数实现自动化的工具等等,这些工具几乎每天都会用到,这就需要你不断的学习。幸运的是,以上提到的这些都不缺关于它们的书籍。本文首先帮大家盘点几本大数据相关的书籍,这些书都是亚马逊上的畅销排行榜上的:关于大数据1、

- 2019-03-07

bigtian

早七点半起床。今天写了大量代码,最近一周的编码状态越来越好,代码也写得越来越顺手,今天把我的数据服务写了一个客户端调用程序,感觉质量还是比较满意的。公司做数据,但是我一个架构师对大数据相关技术却了解很浅,实在是惭愧。以后需要大力加强这一块的技能。对同事要善良,今天同事工作不开心闹了情绪,我主动将活揽过来,做好之后再跟他解释一遍我的思路,感觉这样他会更容易理解也更好的成长,只要一个人是积极向上的,就

- 做大数据需要学习哪些东西啊

kuntoria

文章来源:科多大数据做大数据需要学习哪些东西啊,相信不少对大数据职位感兴趣的人都会有这样的疑问。科多大数据老师结合同学们的疑问,为大家整理了做大数据需要学习哪些东西,下面随着科多大数据老师一起来看看吧,希望可以帮助到大家。Linux:因为大数据相关软件都是在Linux上运行的,所以Linux要学习的扎实一些,学好Linux对你快速掌握大数据相关技术会有很大的帮助,能让你更好的理解hadoop、hi

- 大数据技术之Hadoop

我走之後

大数据hadoop分布式

相关导论大数据相关导论首先我们要知道一切皆数据数据的作用从海量数据中提取出有效的价值信息,实现数据的商业化,价值化,给企业的决策者或者运营人员提供数据支持或者分析性报告.更好的了解事与物的运行规律,给生活赋能.什么是大数据数据的体量比较大,2000年全球互联的概念提出及普及后,数据量开始快速增长....数据单位:bit,byte,kb,mb,gb,tb,pb,eb,zb,yb,bb,nb,db大数

- 从 Greenplum 到 Databend,万全网络数据库平台架构演进

Databend

网络数据库架构

作者:代城万全网络高级工程师,负责万全网络数据平台整体架构研发工作,拥有超过7年的大数据相关技术研发经验,一直关注着开源和云技术的发展。万全网络科技有限公司是一家专注于B端电商物流供应链的公司。致力于为客户提供全面的供应链解决方案,涵盖从产品采购到最终配送的全程服务。公司的服务包括但不限于:供应链管理,仓储与配送,信息技术支持。迁移背景在不断发展的科技环境中,企业往往需要不断调整和优化其技术基础设

- 程序人生系列1-2021年通过私活累积收益1.5w

只是甲

程序人生程序员接单私活留学生课程作业

博主在B站更新了接私活的视频,感兴趣的可以移步到我的B站:博主私活记录一.个人介绍 2011年毕业,计算机专业科班出身,10年及以上金融信贷、通信行业数据库运维管理、数据仓库及大数据相关工作经验,持有OracleOCP和LinuxRHCE认证证书。 毕业第一份工作很幸运的成为了一个OracleDBA,刚毕业就开始维护TB级的数据。在知道自身实力不足的情况下,报名培训机构,相继考了OracleO

- 面试整理

qq_20962187

数据分析/hadoop/机器学习面试题集锦,可能是最全的了…发表于:2017-09-2115:17阅读:178评论:0无论你是想从事大数据相关职位的职场小白,还是准备往高处走的牛牛。小白有了这些在校招中过关斩将,牛牛们温故知新跨过业务壁垒。B格高的HR,或者想要个助理的大数据工作者也可以了解下同行是怎么筛选人。非主流的可以拿来撩HR妹纸,折腾面试的小鲜肉…………………………数据分析1、提前想好答案

- 高校科研管理系统源代码_教育领域各大高校如何建设智慧校园?你的学校够数字化吗?...

weixin_39714835

高校科研管理系统源代码

11月26日,作为数据分析&BI领域领导企业的永洪科技与知名高校东北财经大学数据科学与人工智能学院在北京举行了战略合作签约仪式,共建大数据教学、科研、管理模式顶层设计方案,服务智慧校园建设。双方以教学和科研为中心,以产业为导向,实现与大数据发展实际接轨的发展方向,共同服务高校大数据相关技术与应用的发展。这是永洪科技在教育领域校企合作的又一标杆案例。国务院印发的《促进大数据发展行动纲要》指出,要加强

- 如何用ruby来写hadoop的mapreduce并生成jar包

wudixiaotie

mapreduce

ruby来写hadoop的mapreduce,我用的方法是rubydoop。怎么配置环境呢:

1.安装rvm:

不说了 网上有

2.安装ruby:

由于我以前是做ruby的,所以习惯性的先安装了ruby,起码调试起来比jruby快多了。

3.安装jruby:

rvm install jruby然后等待安

- java编程思想 -- 访问控制权限

百合不是茶

java访问控制权限单例模式

访问权限是java中一个比较中要的知识点,它规定者什么方法可以访问,什么不可以访问

一:包访问权限;

自定义包:

package com.wj.control;

//包

public class Demo {

//定义一个无参的方法

public void DemoPackage(){

System.out.println("调用

- [生物与医学]请审慎食用小龙虾

comsci

生物

现在的餐馆里面出售的小龙虾,有一些是在野外捕捉的,这些小龙虾身体里面可能带有某些病毒和细菌,人食用以后可能会导致一些疾病,严重的甚至会死亡.....

所以,参加聚餐的时候,最好不要点小龙虾...就吃养殖的猪肉,牛肉,羊肉和鱼,等动物蛋白质

- org.apache.jasper.JasperException: Unable to compile class for JSP:

商人shang

maven2.2jdk1.8

环境: jdk1.8 maven tomcat7-maven-plugin 2.0

原因: tomcat7-maven-plugin 2.0 不知吃 jdk 1.8,换成 tomcat7-maven-plugin 2.2就行,即

<plugin>

- 你的垃圾你处理掉了吗?GC

oloz

GC

前序:本人菜鸟,此文研究学习来自网络,各位牛牛多指教

1.垃圾收集算法的核心思想

Java语言建立了垃圾收集机制,用以跟踪正在使用的对象和发现并回收不再使用(引用)的对象。该机制可以有效防范动态内存分配中可能发生的两个危险:因内存垃圾过多而引发的内存耗尽,以及不恰当的内存释放所造成的内存非法引用。

垃圾收集算法的核心思想是:对虚拟机可用内存空间,即堆空间中的对象进行识别

- shiro 和 SESSSION

杨白白

shiro

shiro 在web项目里默认使用的是web容器提供的session,也就是说shiro使用的session是web容器产生的,并不是自己产生的,在用于非web环境时可用其他来源代替。在web工程启动的时候它就和容器绑定在了一起,这是通过web.xml里面的shiroFilter实现的。通过session.getSession()方法会在浏览器cokkice产生JESSIONID,当关闭浏览器,此

- 移动互联网终端 淘宝客如何实现盈利

小桔子

移動客戶端淘客淘寶App

2012年淘宝联盟平台为站长和淘宝客带来的分成收入突破30亿元,同比增长100%。而来自移动端的分成达1亿元,其中美丽说、蘑菇街、果库、口袋购物等App运营商分成近5000万元。 可以看出,虽然目前阶段PC端对于淘客而言仍旧是盈利的大头,但移动端已经呈现出爆发之势。而且这个势头将随着智能终端(手机,平板)的加速普及而更加迅猛

- wordpress小工具制作

aichenglong

wordpress小工具

wordpress 使用侧边栏的小工具,很方便调整页面结构

小工具的制作过程

1 在自己的主题文件中新建一个文件夹(如widget),在文件夹中创建一个php(AWP_posts-category.php)

小工具是一个类,想侧边栏一样,还得使用代码注册,他才可以再后台使用,基本的代码一层不变

<?php

class AWP_Post_Category extends WP_Wi

- JS微信分享

AILIKES

js

// 所有功能必须包含在 WeixinApi.ready 中进行

WeixinApi.ready(function(Api) {

// 微信分享的数据

var wxData = {

&nb

- 封装探讨

百合不是茶

JAVA面向对象 封装

//封装 属性 方法 将某些东西包装在一起,通过创建对象或使用静态的方法来调用,称为封装;封装其实就是有选择性地公开或隐藏某些信息,它解决了数据的安全性问题,增加代码的可读性和可维护性

在 Aname类中申明三个属性,将其封装在一个类中:通过对象来调用

例如 1:

//属性 将其设为私有

姓名 name 可以公开

- jquery radio/checkbox change事件不能触发的问题

bijian1013

JavaScriptjquery

我想让radio来控制当前我选择的是机动车还是特种车,如下所示:

<html>

<head>

<script src="http://ajax.googleapis.com/ajax/libs/jquery/1.7.1/jquery.min.js" type="text/javascript"><

- AngularJS中安全性措施

bijian1013

JavaScriptAngularJS安全性XSRFJSON漏洞

在使用web应用中,安全性是应该首要考虑的一个问题。AngularJS提供了一些辅助机制,用来防护来自两个常见攻击方向的网络攻击。

一.JSON漏洞

当使用一个GET请求获取JSON数组信息的时候(尤其是当这一信息非常敏感,

- [Maven学习笔记九]Maven发布web项目

bit1129

maven

基于Maven的web项目的标准项目结构

user-project

user-core

user-service

user-web

src

- 【Hive七】Hive用户自定义聚合函数(UDAF)

bit1129

hive

用户自定义聚合函数,用户提供的多个入参通过聚合计算(求和、求最大值、求最小值)得到一个聚合计算结果的函数。

问题:UDF也可以提供输入多个参数然后输出一个结果的运算,比如加法运算add(3,5),add这个UDF需要实现UDF的evaluate方法,那么UDF和UDAF的实质分别究竟是什么?

Double evaluate(Double a, Double b)

- 通过 nginx-lua 给 Nginx 增加 OAuth 支持

ronin47

前言:我们使用Nginx的Lua中间件建立了OAuth2认证和授权层。如果你也有此打算,阅读下面的文档,实现自动化并获得收益。SeatGeek 在过去几年中取得了发展,我们已经积累了不少针对各种任务的不同管理接口。我们通常为新的展示需求创建新模块,比如我们自己的博客、图表等。我们还定期开发内部工具来处理诸如部署、可视化操作及事件处理等事务。在处理这些事务中,我们使用了几个不同的接口来认证:

&n

- 利用tomcat-redis-session-manager做session同步时自定义类对象属性保存不上的解决方法

bsr1983

session

在利用tomcat-redis-session-manager做session同步时,遇到了在session保存一个自定义对象时,修改该对象中的某个属性,session未进行序列化,属性没有被存储到redis中。 在 tomcat-redis-session-manager的github上有如下说明: Session Change Tracking

As noted in the &qu

- 《代码大全》表驱动法-Table Driven Approach-1

bylijinnan

java算法

关于Table Driven Approach的一篇非常好的文章:

http://www.codeproject.com/Articles/42732/Table-driven-Approach

package com.ljn.base;

import java.util.Random;

public class TableDriven {

public

- Sybase封锁原理

chicony

Sybase

昨天在操作Sybase IQ12.7时意外操作造成了数据库表锁定,不能删除被锁定表数据也不能往其中写入数据。由于着急往该表抽入数据,因此立马着手解决该表的解锁问题。 无奈此前没有接触过Sybase IQ12.7这套数据库产品,加之当时已属于下班时间无法求助于支持人员支持,因此只有借助搜索引擎强大的

- java异常处理机制

CrazyMizzz

java

java异常关键字有以下几个,分别为 try catch final throw throws

他们的定义分别为

try: Opening exception-handling statement.

catch: Captures the exception.

finally: Runs its code before terminating

- hive 数据插入DML语法汇总

daizj

hiveDML数据插入

Hive的数据插入DML语法汇总1、Loading files into tables语法:1) LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE] INTO TABLE tablename [PARTITION (partcol1=val1, partcol2=val2 ...)]解释:1)、上面命令执行环境为hive客户端环境下: hive>l

- 工厂设计模式

dcj3sjt126com

设计模式

使用设计模式是促进最佳实践和良好设计的好办法。设计模式可以提供针对常见的编程问题的灵活的解决方案。 工厂模式

工厂模式(Factory)允许你在代码执行时实例化对象。它之所以被称为工厂模式是因为它负责“生产”对象。工厂方法的参数是你要生成的对象对应的类名称。

Example #1 调用工厂方法(带参数)

<?phpclass Example{

- mysql字符串查找函数

dcj3sjt126com

mysql

FIND_IN_SET(str,strlist)

假如字符串str 在由N 子链组成的字符串列表strlist 中,则返回值的范围在1到 N 之间。一个字符串列表就是一个由一些被‘,’符号分开的自链组成的字符串。如果第一个参数是一个常数字符串,而第二个是type SET列,则 FIND_IN_SET() 函数被优化,使用比特计算。如果str不在strlist 或st

- jvm内存管理

easterfly

jvm

一、JVM堆内存的划分

分为年轻代和年老代。年轻代又分为三部分:一个eden,两个survivor。

工作过程是这样的:e区空间满了后,执行minor gc,存活下来的对象放入s0, 对s0仍会进行minor gc,存活下来的的对象放入s1中,对s1同样执行minor gc,依旧存活的对象就放入年老代中;

年老代满了之后会执行major gc,这个是stop the word模式,执行

- CentOS-6.3安装配置JDK-8

gengzg

centos

JAVA_HOME=/usr/java/jdk1.8.0_45

JRE_HOME=/usr/java/jdk1.8.0_45/jre

PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

export JAVA_HOME

- 【转】关于web路径的获取方法

huangyc1210

Web路径

假定你的web application 名称为news,你在浏览器中输入请求路径: http://localhost:8080/news/main/list.jsp 则执行下面向行代码后打印出如下结果: 1、 System.out.println(request.getContextPath()); //可返回站点的根路径。也就是项

- php里获取第一个中文首字母并排序

远去的渡口

数据结构PHP

很久没来更新博客了,还是觉得工作需要多总结的好。今天来更新一个自己认为比较有成就的问题吧。 最近在做储值结算,需求里结算首页需要按门店的首字母A-Z排序。我的数据结构原本是这样的:

Array

(

[0] => Array

(

[sid] => 2885842

[recetcstoredpay] =&g

- java内部类

hm4123660

java内部类匿名内部类成员内部类方法内部类

在Java中,可以将一个类定义在另一个类里面或者一个方法里面,这样的类称为内部类。内部类仍然是一个独立的类,在编译之后内部类会被编译成独立的.class文件,但是前面冠以外部类的类名和$符号。内部类可以间接解决多继承问题,可以使用内部类继承一个类,外部类继承一个类,实现多继承。

&nb

- Caused by: java.lang.IncompatibleClassChangeError: class org.hibernate.cfg.Exten

zhb8015

maven pom.xml关于hibernate的配置和异常信息如下,查了好多资料,问题还是没有解决。只知道是包冲突,就是不知道是哪个包....遇到这个问题的分享下是怎么解决的。。

maven pom:

<dependency>

<groupId>org.hibernate</groupId>

<ar

- Spark 性能相关参数配置详解-任务调度篇

Stark_Summer

sparkcachecpu任务调度yarn

随着Spark的逐渐成熟完善, 越来越多的可配置参数被添加到Spark中来, 本文试图通过阐述这其中部分参数的工作原理和配置思路, 和大家一起探讨一下如何根据实际场合对Spark进行配置优化。

由于篇幅较长,所以在这里分篇组织,如果要看最新完整的网页版内容,可以戳这里:http://spark-config.readthedocs.org/,主要是便

- css3滤镜

wangkeheng

htmlcss

经常看到一些网站的底部有一些灰色的图标,鼠标移入的时候会变亮,开始以为是js操作src或者bg呢,搜索了一下,发现了一个更好的方法:通过css3的滤镜方法。

html代码:

<a href='' class='icon'><img src='utv.jpg' /></a>

css代码:

.icon{-webkit-filter: graysc