Beyond Part Models: Person Retrieval with Refined Part Pooling

Beyond Part Models: Person Retrieval with Refined Part Pooling)

- Abstract

- 1.Introduction

- 2.Related work

- 3. PCB: A Strong Convolutional Baseline(强卷积基线)

- 3.1. Structure of PCB

- 3.2. Important Parameters.

- 3.3. Potential Alternative Structures(潜在的替代结构)

- 4. Refined Part Pooling

- 4.1. Within-Part Inconsistency

- 4.2. Relocating Outliers

- 4.3. Induced Training for Part Classifier(零件分类器的诱导训练)

- 4.4. Discussions on Refined Part Pooling

- 5. Experiments

- 5.1. Datasets and Settings

- 5.2. Implementation details

- 5.3 Performance evaluation

- 5.4. Parameters Analysis

- 5.5. Induction and Attention Mechanism

- 6. Conclusion

论文地址

Abstract

\quad 使用部分级特征进行行人图像描述可提供细粒度的信息(fine-grained information),并且在最近的文献中已被证明对人检索有利。分区发现的前提是每一部分都应该在适当的位置。不使用外部提示(例如姿势估计) 直接定位零件,而是着重于每个零件内的内容一致 (content consistency)。

\quad 具体来说,其目标是学习具有 区分性的部分信息特征(discriminative part-informed features) 来进行人员检索,并作出两个贡献:(1)基于部分卷积基线网络(PCB):给定图像输入,它输出由几个部分级特征组成的卷积描述符。采用统一分区策略(a uniform partition strategy),PCB使用最先进的(state-of-the-art)方法获得了竞争性结果,证明了本身是检索人员的强大卷积基线。(2)改进的零件合并方法(RPP)。统一的分区不可避免地会在每个部分中产生离群值(outliers),而这些异常实际上更类似于其他部分。RPP将这些离群值重新分配(re-assigns)给它们最接近的分区,从而产生具有增强的 分区内部一致性(within-part consistency) 的精致零件。实验证明,RPP可以使PCB获得另一轮性能提升(performance boost)。比如,在Market-1501数据集上, 实现了(77.4+4.2)% mAP和 (92.3+1.5)% rank-1准确度,很大程度超越当时先进技术。

1.Introduction

\quad 人检索,也称为人再识别(re-ID),目的是在一个大型数据库中检索指定行人的图像,给定一个感兴趣的查询人。 目前,深度学习方法主导着这个社区,与手工制作的竞争对手(hand-crafted competitors)相比具有令人信服的优势。深入学习的表示提供了很高的判别能力,特别是当聚合从深入学习的部分特征。 Re-ID基准的最新技术是通过部分信息的深层特征实现的。

\quad 学习判别的零件特征的一必要前提是零件应准确定位。 最近,最先进的方法在其划分策略(partition strategies) 上各不相同,可以分为相应地分为两组。 第一组利用外部线索,例如,从人体姿势估计的最新进展中获得帮助。 姿势估计和人物检索之间的基础数据集偏差(underlying datasets bias)仍然是妨碍人物图像上理想语义划分的障碍。 另一组从语义部分放弃线索,他们不需要零件标签,却可以与第一组保持竞争优势。

\quad 一些分区策略在上图中进行了比较。 在学习零件级深度特征的进展的背景下,我们重新思考了如何使零件保持一致的问题。 语义划分 (Semantic partitions)这可能提供稳定的线索,以良好的对齐,但容易受到有噪声的姿态检测。 本文从另一个角度强调了各部分的一致性(the consistency within each part),我们认为这是对空间对齐(spatial alignment)至关重要的。然后我们得出动机,即给定粗糙划分的零件,我们的目标是完善它们以加强内部分区的一致性。具体来说,主要有一下两个贡献:

\quad \quad (1) 首先,提出了一个名为基于部分的卷积基线(PCB)的网络,它在Conv层上进行统一的划分,用于学习部分级特征。 它没有显示地划分图像。 PCB以一个完整的图像作为输入,输出一个卷积特征。 作为一个分类网络,PCB的体系结构简洁,对骨干网络进行了轻微的修改。 训练程序是标准的,不需要花里胡哨的东西。作者证明了卷积描述符比常用的全连接(FC)描述符具有更高的判别能力。 例如,在Market-1501数据集上,性能从85.3%的rank1精度和68.5%的mAP提高到92.3%(7.0%)的rank1精度和77.4%(+8.9%)的mAP,在很大程度上超过了许多最先进的 方法。

\quad \quad (2) 其次,我们提出了一种自适应池法(adaptive pooling method)来重新细化统一分区 。我们考虑的动机是在每个部分内,内容应该是一致。 我们观察到在统一分区下,每个部分都存在离群值。实际上,这些异常值与其他部分的内容更接近,这意味着分区内部存在不一致。 因此,我们通过将这些异常值重新定位到它们最接近的部分来改进统一分区,从而增强内部一致性。 精化部分的一个例子如上图(e)所示。 与提议的细化零件库(RPP),Market-1501的性能进一步提高到93.8%(+1.5%)rank1精度和81.6%(+4.2%)mAP。 在第三节和第四节中,我们分别描述了PCB和细化零件库。

在第五节中,我们将这两种方法结合起来,达到了人员检索的新境界。 重要的是,我们实验证明,重要的是,我们通过实验证明了拟议的改进部分优于注意部分,即通过注意力机制学习的部分。

2.Related work

人员检索的手工提取部分特征。 在深度学习主导re-ID领域之前, 手工制作的算法已经开发出学习部分或局部特征的方法。Gray和Tao将行人分成水平条纹来提取颜色和纹理特征。许多工程中采取类似的分区。其他一些工程采用了更复杂的策略。 Gheissari等人将行人分成几个三角形进行部分特征提取。 Cheng等人用图案结构来表示 把行人分成语义部分。 Das等人在头部、躯干和腿部应用HSV直方图来捕获空间信息。

深度学习的部分特征。 目前,大多数人检索数据集上的最新进展是通过深度学习方法来维持的。 当学习re-ID零件特征时,深度学习相对于手工算法的优点是两方面的。首先,深层特征普遍获得较强的鉴别能力。 其次,深度学习为分析行人提供了更好的工具,这进一步有利于零件特征。 特别是,人体姿态估计和特征点检测(landmark detection)取得了令人印象深刻的进展。 最近在re-ID方面的一些工作采用了这些行人分割的工具并且发表的提高。 然而,当以现成的方式直接利用这些姿势估计方法时,用于姿势估计和人检索的数据集之间的潜在差距仍然是一个问题。 其他人则放弃了分割的语义线索。 姚等将最大激活的坐标聚集在特征图上,以定位多个感兴趣的区域。 刘都等和Zhao等将注意力机制嵌入网络中,允许模型自行决定将注意力集中在哪里。

具有注意力机制的深度学习分区。本文的主要贡献是精炼分区合并(refined part pooling)。 我们将其与Zhao等人的最新工作PAR在详细上进行比较。 两项工作都采用了部分分类器来对行人图像进行“软”划分,如图1所示。 两部作品的优点是不需要为学习区分性零件而贴上零件标签。 但是,这两种方法的动机,训练方法,机制和最终效果都大不相同,下面将详细介绍。

动机(Motivation):PAR旨在直接学习对齐的零件,而RPP则旨在改进预先分区的零件。 工作机制(Working mechanism):使用注意力方法,PAR以无监督的方式训练零件分类器,而RPP的训练可以看作是半监督的过程。 训练过程(Training process):RPP首先训练具有统一划分的身份分类模型,然后利用学到的知识进行零件分类器的训练。 绩效(Performance):稍微复杂一些的训练程序过程会给RPP带来更好的解释和显著更高的绩效。 例如在Market-1501上,PAR,PCB合作注意机制和建议的RPP所实现的mAP分别为63.4%,74.6%和81.6%。 另外,RPP具有与各种分区策略合作的潜力。

3. PCB: A Strong Convolutional Baseline(强卷积基线)

3.1. Structure of PCB

骨干网。PCB可以采用任何网络,而无需隐藏设计用于图像分类的全连接层作为骨干,例如Google Inception和ResNet。本文主要使用ResNet50,并考虑其竞争性能以及相对简洁的体系结构。

从骨干到PCB。如上图所示,我们通过稍作修改将骨干网络重塑为PCB。原始全局平均池(GAP)层之前的结构与骨干模型完全相同。区别在于删除了GAP层及其后续层。当图像经历从骨干网络继承的所有层时,它将成为激活的3D张量T。在本文中,我们将沿通道轴查看的激活向量定义为列向量。然后,使用常规的平均池化,PCB将T划分为p个水平条纹,并将同一条带中的所有列向量平均为单个零件级列向量gi(i = 1、2,…,p,除非必要,否则将省略下标)。之后,PCB使用卷积层来减小g的尺寸。根据我们的初步实验,将降维的列向量h设置为256维。最后,将每个h输入到**分类器(classifier)**中,该分类器通过完全连接(FC)层和随后的Softmax函数实现,以预测输入的标识(ID)。

\quad 在训练期间,通过在p个ID预测中最小化交叉熵损失的总和来优化PCB。在测试期间,将p个g或h连接起来以形成最终的描述符G或H,即G = [g1,g2,…,gp]或H = [h1,h2,…,hp] 。正如我们在实验中观察到的,使用G可以达到更高的精度,但是计算成本更高,这与[28]中的观察结果一致。

3.2. Important Parameters.

\quad PCB从细粒度的空间集成中受益。几个关键参数,即输入图像大小(即[H,W]),张量T的空间大小(即[M,N])和合并列向量的数量(即p)对于PCB的性能是重要的。请注意,[M,N]是由给定固定大小输入的骨干模型的空间下采样率确定的。一些深层对象检测方法,例如SSD [21]和R-FCN [5],表明降低骨干网的下采样率可以有效地丰富特征的粒度。 PCB通过消除骨干网中最后的空间下采样操作来增加T的大小,从而获得了成功。这种操作大大增加了人员检索的准确性,只增加了很少的计算成本。可以在5.4节中访问详细信息,该节也提供了一些见解来解释将张量T划分为太多条纹(大p)会损害所学习特征的判别能力的现象。

通过我们的实验,PCB的优化参数设置为:

- 输入图像尺寸调整为384×128,高宽比为3:1。

- T的空间大小设置为24×8。

- T平均分为6个水平条纹

3.3. Potential Alternative Structures(潜在的替代结构)

给定一个相同的骨干网络,有几个潜在的替代结构来学习部分级特征。 我们列举了两种结构与PCB进行比较。

- 变体1。不是基于每个hi(i =1、2,…,p)进行ID预测,而是将所有hi平均为一个向量 h ˉ \bar{h} hˉ,然后将其完全连接到ID预测向量。在测试过程中,它还会将g或h连接起来以形成最终的描述符。 变体1的特征是在一次损失下学习卷积描述符。

- 变体2。它采用与上图中的PCB完全相同的结构。但是,变体2中FC分类器的所有分支共享相同的参数集。

两种变体均经过实验验证,劣于PCB。 PCB相对于变体1的优越性表明,不仅卷积描述符本身,而且每个零件的相应监督对于学习区分零件级特征都是至关重要的。 PCB相对于变型2的优越性表明,为分类器共享权重,同时降低过度拟合的风险,却损害了所学零件级特征的判别能力。 实验细节将在5.3节中查看。

4. Refined Part Pooling

PCB的均匀分区简单,有效,但有待改进。 本节首先解释了均匀分隔所伴随的不一致现象,然后提出了改进的零件合并作为加强零件内部一致性的补救措施(remedy)。

4.1. Within-Part Inconsistency

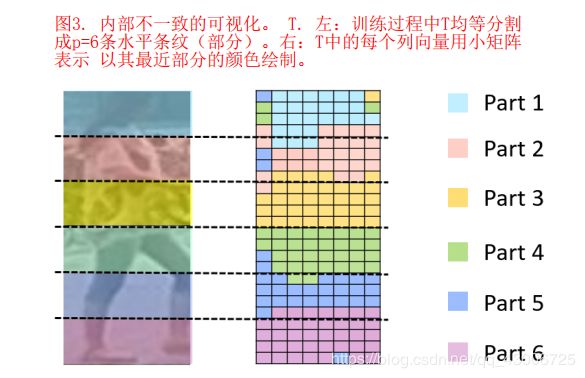

着眼于要在空间上划分的张量 T T T,我们对部分内不一致的直觉是: T T T的相同部分中的列向量 f f f应该彼此相似,并且与其他部分中的列向量不相似; 否则会出现零件内部不一致的现象,这意味着零件分配不当。

在训练PCB收敛后,我们通过测量余弦距离,比较了每个 f f f和g_{i}(i=1,2,·,p)之间的相似性,即每个条纹的平均化列向量。 如果是 f f f最接近 g i g_{i} gi, f f f被推断为最接近第 i i i部分,相应地。 通过这样做,我们找到了与每个 f f f最接近的部分,如上图所示。 每个列向量用一个小矩形表示 并以其最近部分的颜色绘制。

观察到两种现象。首先,同一水平条带中的大多数列向量聚集在一起(尽管对此效果没有明确的限制)。 其次,存在许多异常值 在训练过程中被指定为特定的水平条纹(部分),这与另一部分更相似。 这些异常值的存在表明,它们本质上与另一部分的列向量更一致。

4.2. Relocating Outliers

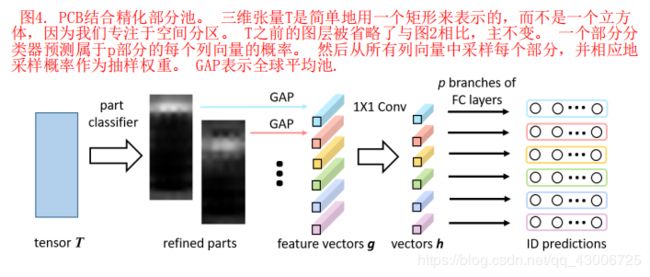

\quad 我们提出了改进的部分池( the refined part pooling),以纠正内部不一致。 我们的目标是根据每个部分的相似性分配所有列向量,以便将异常值重新定位。

\quad 为此,我们需要对 T T T中所有列向量 f f f进行分类。 基于已经学习的 T T T,我们使用一个线性层,然后是Softmax激活作为部分分类如下:

P ( P i ∣ f ) = s o f t m a x ( W i T f ) = e x p ( W i T f ) ∑ j = 1 e x p ( W j T f ) (1) P(P_{i}|f)=softmax(W_{i}^Tf)=\cfrac{exp(W_{i}^Tf)}{\sum\limits_{j=1}^exp(W_{j}^Tf)}\tag{1} P(Pi∣f)=softmax(WiTf)=j=1∑exp(WjTf)exp(WiTf)(1)

其中 P ( P i ∣ f ) P(P_{i}|f) P(Pi∣f)是 f f f属于 P i P_{i} Pi部分的预测概率,p是预定义部件的数目(即PCB中的p=6),W是部件分类器的可训练权重矩阵, 其训练程序将在第4.3节中详细说明。

\quad 给定 T T T中的列向量f和f属于部分 P i P_{i} Pi的预测概率,我们将f赋给部分 P i P_{i} Pi以 P ( P i ∣ f ) P(P_{i}|f) P(Pi∣f)为置信度。相应地,每个部分 P i = 1 , 2 , . . . , p ) Pi=1,2,...,p) Pi=1,2,...,p)从所有列向量 f f f中采样, P ( P i ∣ f ) P(P_{i}|f) P(Pi∣f)作为采样权重,即,

P i = { P ( P i ∣ f ) × f , ∀ f ∈ F } (2) P_{i}=\{ P(P_{i}|f)\times f,\forall f \in F\} \tag{2} Pi={P(Pi∣f)×f,∀f∈F}(2)

其中F是张量T中列向量的全集,{·}表示形成集合的采样操作。

通过这样做,所提出的细化部分池(the refined part pooling)进行了一个“软”和自适应分区,以细化原始的“硬”和均匀分区,而来源于均匀分区的异常值要被重新安置。 结合上述的细化部分池,PCB被进一步重塑为图4所示。改进的部件池,即部件分类器以及以下采样操作,将替换原来的平均池。 所有其他层的结构与图中完全相同。

改进的零件池,即零件分类器以及以下采样操作,将替换原始的平均池。 所有其他层的结构与图2完全相同。

4.3. Induced Training for Part Classifier(零件分类器的诱导训练)

\quad 在等式1中缺少用于学习零件分类器的W的明确监督信息。我们设计了诱导训练程序。 如Alg.1所示。

- 首先,对标准PCB模型进行训练,使其与 T T T同等分割收敛。

- 其次,我们删除了 T T T后的原始平均池化层,并在 T T T上附加了一个p类零件分类器。根据零件分类器的预测,从 T T T中采样新零件, 详见章节4.2。

- 第三,我们将PCB中所有已经学习的层都设置为固定的,只留下可训练的部件分类器。 然后我们在训练集上重新训练模型。 在这种情况下,模型仍然期望张量 T T T被平均分割,否则它将预测训练图像的身份不正确。因此,第3步会对零件分类器进行惩罚,直到它进行的划分接近原始均匀分区为止,而零件分类器则倾向于将固有相似的列向量分类为同一零件。 步骤3的结果将达到平衡状态。

- 最后,所有的层都允许更新。 对整个网络,即PCB和零件分类器进行了微调,以进行整体优化。

\quad 在上述训练过程中,步骤1中训练的PCB模型诱导了零件分类器的训练。 步骤3和步骤4收敛非常快,总共需要10多个epoch。

4.4. Discussions on Refined Part Pooling

在Alg.1 (下图)中第一步跳过,训练也可以收敛。在这种情况下,训练将类似于PAR,它采用注意机制来对齐零件,如第2节所介绍的。我们比较两种方法,

训练部分分类器是否有步骤1,在实验中发现诱导程序很重要。 如果没有所提出的诱导,性能就会明显降低。 为Market-1501上的例子,当应用诱导时,PCB与精化部分池相结合达到80.9%的AP。 当去除诱导时,mAP下降到74.6%。 这意味着所提出的诱导训练优于PCB上的注意机制。 详情可参阅第5.5节。

5. Experiments

5.1. Datasets and Settings

数据集。 本文使用三个数据集进行评估,即Market-1501,DukeMTMC-reID ]和CUHK03 [18]。 Market-1501数据集包含在6个摄影机视点下观察到的1,501个身份,19,732个画廊图像和DPM检测到的12,936个训练图像0。 DukeMTMC-reID数据集包含1,404个身份,16,522个训练图像,2,228个查询和17,661个图库图像。 8台摄像机捕获了如此多的图像,DukeMTMC-reID成为迄今最具挑战性的re-ID数据集之一。 CUHK03数据集包含1,164个身份的13,164张图像。每个身份由2台摄像机观察。 CUHK03提供了手工标记的边界框和DPM可检测的边界框,在本文中我们将使用后者。 CUHK03最初采用20个随机训练/测试分组,这对于深度学习而言非常耗时。因此,我们采用了[44]中提出的新的训练/测试协议。对于Market-1501和DukeMTMC-reID,我们分别使用[39]和[43]提供的评估包。所有实验都会评估单查询设置。此外,为简单起见,我们不使用可显着改善mAP的重新排序算法[44]。我们的结果与没有重新排名的报告结果进行了比较。

5.2. Implementation details

实现IDE进行比较。 我们注意到[40]中指定的IDE模型是深度re-ID系统[40、38、33、10、28、42、43、45]的常用基准。与拟议的PCB相反,IDE模型学习全局描述符。为了进行比较,我们在相同的骨干网(即ResNet50)上实现IDE模型,并在[40]中的原始模型上进行了一些优化,如下所示。 1)在ResNet50的“ pool5”层之后,我们附加一个完全连接的层,然后是批处理规范化和ReLU。附加的FC层的输出尺寸设置为256-dim。 2)我们在“ pool5”层上应用dropout。尽管“ pool5”层中没有可训练的参数,但有证据表明,在其上应用Dropout(输出2048d的高维特征向量)可有效避免过度拟合并获得可观的改进[42,43]。我们根据经验将辍学率设置为0.5。在Market-1501上,我们实现的IDE达到了85.3%的等级1精度和68.5%的mAP,这比[45]中的实现要高一些。

训练。 训练图像通过水平翻转和归一化来增强。 我们将批处理大小设置为64,并将模型训练为60个周期,基本学习率初始化为0.1,并在40个时代之后衰减到0.01。 骨干模型在Image Net上进行预训练[7]… 所有预训练层的学习率设置为基础学习率的0.1×。 使用精制零件池时为了促进,我们附加了另一个10个epoch,学习率设置为0.01。 以两个NVIDIA TITANXP GPU和Pytorch为平台,在Market-1501上培训IDE模型和标准PCB(12936张训练图片)分别消耗约40分钟和50分钟。 增加的PCB训练时间主要是由于取消了Conv5层的最后一次空间下采样操作,使张量T增大了4×。

5.3 Performance evaluation

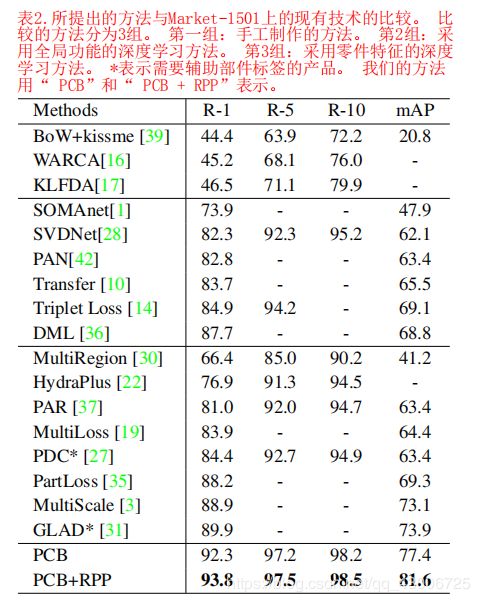

我们在三个数据集上评估我们的方法,结果如表1所示。 测试了均匀分区(PCB)和细化部件池(PCB+RPP)

PCB是一个很强的基线。 比较PCB和IDE,这是许多工作中常用的基线[40,38,33,10,28,42,43,45], 我们清楚地观察到PCB的显著优势:三个数据集的mAP分别从68.5%、52.8%和38.9%增加到77.4%(+8.9%)、66.1%(+13.3%)和54.2%(+15.3%)。 这表明,整合零件信息可以提高特征的判别能力。PCB的结构和IDE一样简洁,训练PCB只需要训练一个规范的分类网络。 我们希望它能成为人们的基准 检索任务。

改进的部分池(RPP)提高了PCB,特别是在mAP中。 从表1可以看出,虽然PCB已经具有很高的精度,但RPP给它带来了进一步的改进。 在三个数据集上,排名1的改进准确度分别为+1.5%、+1.6%和+3.1%;mAP的改善率分别为+4.2%、+3.1%和+3.5%。 在mAP中的改进大于rank1精度。 实际上,rank1的准确性表征在摄像机网络中检索最简单匹配的能力,而mAP表示查找所有匹配的能力。结果表明,RPP在寻找更具挑战性的匹配中特别有益。

使用p损的好处。 以验证图2中损失的p分支的使用。 我们将我们的方法与变式1进行了比较,后者在单个分类损失下学习卷积描述符。 表1表明,变式1比PCB的精度低得多,这意味着对每个部分使用各自的损失对于学习鉴别部分特征至关重要。

身份分类器之间不共享参数的好处。 在图中2。 在Softmax损失之前,PCB将每列向量h输入到FC层。 我们将我们的建议(不共享FC层参数)与变式2(共享FC层参数)进行了比较。 从表1中,PCB在三个数据集上高于变式2为2.4%、3.3%和7.4%。 这表明最终FC层之间的共享参数较差。

与最新技术进行比较。 我们将PCB和PCB + RPP与最新技术进行了比较。 Market-1501的比较在表2中进行了详细说明。比较的方法分为三类,即手工制作方法,具有全局特征的深度学习方法和具有零件特征的深度学习方法。 仅依靠单一形式的分区,PCB超越了所有先前的方法,包括[27,31],后者需要辅助部件标签以故意对准部件。 提议的改进零件池进一步扩大了性能领先地位。

表3总结了DukeMTMC-reID和CUHK03(新训练/测试协议)的比较。在比较的方法中,两个数据集的PCB的mAP分别比[3]高 5.5%和17.2%。 PCB + RPP(精制零件池)进一步超过了DukeMTMC-reID的+ 8.6%mAP和CUHK03的+ 20.5%mAP。 PCB + RPP比“ TriNet + Era”和“ SVDNet + Era” [45]具有更高的精度,后者通过额外的数据增强功能得以增强。

在本文中,我们报告了Market-1501,Duke和CUHK03的mAP分别为81.6%,69.2%,57.5%和Rank-1 = 93.8%,83.3%和63.7%, 这在三个数据集上都设置了新的技术水平 。 所有结果都是在单查询模式下实现的,无需重新排序。 重新排序方法将进一步提高性能,尤其是mAP。 例如,当“ PCB + RPP”与[44]中的方法结合使用时,Market-1501上的mAP和Rank-1准确性分别提高到91.9%和95.1%。

我们分析了Market-1501第3.2节中介绍的PCB(和RPP)的一些重要参数。 一旦优化,所有三个数据集都使用相同的参数。

5.4. Parameters Analysis

我们分析了Market-1501中第3.2节中介绍的PCB(和RPP)的一些重要参数。 一旦优化,所有三个数据集都使用相同的参数。

图像和张量T的大小。我们将图像大小从192×64变化到576×192,使用96×32作为间隔。 测试两个下采样速率,即原始速率和减半速率(较大的T)。 我们在PCB上对所有这些模型进行了详尽的训练,并在图5中报告了它们的性能。观察到两种现象。

首先,更大的图像大小有利于学习的部分特征。 随着图像大小的增加,mAP和rank1精度都会增加,直到达到稳定的性能。

第二,较小的下采样率,即较大的张量T的空间大小会增强性能,尤其是在使用相对较小的图像作为输入时。在图5中,使用384×128输入和减半采样率的PCB与使用576×192输入和原始采样率的PCB几乎达到了相同的性能。 我们建议在考虑到计算效率的情况下,操纵下采样率减半。

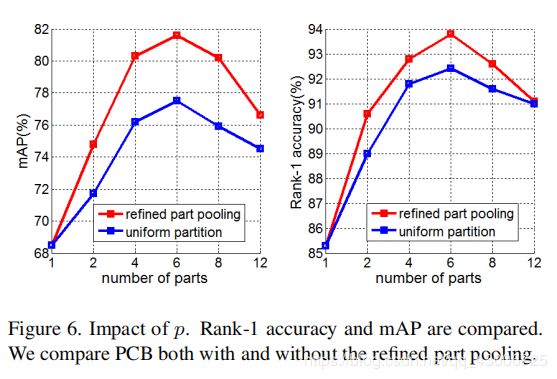

零件数p。直观地,p确定零件特征的粒度。当p = 1时,学习的特征是全局特征。随着p的增加,检索精度首先提高。但是,如图6所示,精度并不总是随p的增加而提高。当p = 8或12时,无论使用精制零件池,性能都会急剧下降。精制零件的可视化提供了对该现象的见解,如图7所示。当p增加到8或12时,某些精制零件与其他零件非常相似,而某些可能会塌陷为空零件。结果,p的过度增加实际上损害了零件特征的判别能力。在实际应用中,我们建议使用p = 6的零件。

5.5. Induction and Attention Mechanism

在这项工作中,当训练Alg1中的零件分类器时。需要预先训练并具有均匀分区的PCB。在均匀分配下学习的知识会引发零件分类器的后续训练。没有PCB预训练,网络将在无归纳的情况下学习对T进行分区,并且变得类似于由注意力机制驱动的方法。我们在Market-1501和DukeMTMC-reID上进行了消融实验,以比较这两种方法。结果列于表4,从中可以得出三个观察结果。

\quad 首先,无论在PCB中采用哪种分区策略,它都明显优于PAR [37],后者是通过注意力机制学习分区的。其次,注意力机制也基于PCB的结构。在“ RPP(不带归纳)”设置下,网络通过注意力机制学习专注于多个部分,并且相对于学习全局描述符的IDE有了实质性的改进。第三,诱导程序(PCB训练)至关重要。与“ PCB + RPP”所实现的性能相比,在不进行归纳训练的情况下训练零件分类器时,检索性能将急剧下降。这意味着通过归纳学习的精炼部分要优于通过注意力机制学习的部分。具有归纳和注意机制的分区结果如图1所示。

6. Conclusion

本文为解决行人检索问题做出了两点贡献。首先,我们提出了一种基于零件的卷积基线(PCB),用于学习零件信息特征。 PCB采用简单的统一分区策略,并将部分知情的特征组装到卷积描述符中。 PCB将现有技术提升到一个新的水平,证明自己是学习零件信息功能的强大基准。尽管具有均匀分隔的PCB既简单又有效,但仍有待改进。我们提出改进的零件池,以增强每个零件的零件内部一致性。细化后,相似的列向量被归纳为同一部分,从而使每个部分在内部更加一致。精制的零件池不需要零件标签信息,并大大改善了PCB。