对抗样本(论文解读八):Towards More Robust Adversarial Attack Against Real World Object Detectors

准备写一个论文学习专栏,先以对抗样本相关为主,后期可能会涉及到目标检测相关领域。

内容不是纯翻译,包括自己的一些注解和总结,论文的结构、组织及相关描述,以及一些英语句子和相关工作的摘抄(可以用于相关领域论文的写作及扩展)。

平时只是阅读论文,有很多知识意识不到,当你真正去着手写的时候,发现写完之后可能只有自己明白做了个啥。包括从组织、结构、描述上等等很多方面都具有很多问题。另一个是对于专业术语、修饰、语言等相关的使用,也有很多需要注意和借鉴的地方。

本专栏希望在学习总结论文核心方法、思想的同时,期望也可以学习和掌握到更多论文本身上的内容,不论是为自己还有大家,尽可能提供更多可以学习的东西。

当然,对于只是关心论文核心思想、方法的,可以只关注摘要、方法及加粗部分内容,或者留言共同学习。

Seeing isn’t Believing: Towards More Robust Adversarial Attack Against Real World Object Detectors

YueZhao1,2,HongZhu1,2,RuigangLiang1,2,QintaoShen1,2,ShengzhiZhang3,KaiChen1,2*

1SKLOIS,InstituteofInformationEngineering,ChineseAcademyofSciences,China

2SchoolofCyberSecurity,UniversityofChineseAcademyofSciences,China

3DepartmentofComputerScience,MetropolitanCollege,BostonUniversity,USA

{zhaoyue,zhuhong,liangruigang,shenqintao}@iie.ac.cn,[email protected],[email protected]

发表于 ACM Conference on Computer and Communications Security(ACM CCS 2019)

Abstract

Recently Adversarial Examples (AEs) that deceive deep learning models have been a topic of intense research interest. Compared with the AEs in the digital space, the physical adversarial attack is considered as a more severe threat to the applications like face recognitionin authentication, objection detection in autonomous driving cars,etc. Existing works attacking object detectors are still very limited in various scenarios,e.g., varying distance and angles,etc. 描述及引子

对于隐藏攻击(HA),我们提出了特征-干扰增强(FIR)方法和增强现实约束生成(ERG)来增强AEs鲁棒性;对于目标攻击(AA),我们提出了nested-AE,它结合两个AEs来攻击长、短距离的目标检测器。同样设计了不同风格的AEs。实验结果表明我们的AEs能够攻击YOLO V3及faster-RCNN成功率达92.4%,在1m到25m及-60度到60度之间的所有范围以内。且具有高可转移性,可攻击其他三个黑盒模型。

1 Introduction

目标检测及其实际应用----对抗样本----引入物理世界

Compared to the image classifiers,攻击目标检测器具有更大的挑战:不仅需要误导标签预测还要误导目标是否存在的预测。更重要的是,分类器总是工作于静态环境,而目标检测器下的环境中目标通常是相对移动的。同时移动将导致距离和视角的变换,以及背景环境的变化。所有这些对于目标检测物理攻击的AEs提出了更高的鲁棒性要求。

Until very recently, there are a few studies,他们提高AEs鲁棒的方法主要是通过图像变换(图像大小、不同距离),然而他们的距离和角度是有效限。实际中自动驾驶识别范围为20平方米及30度的角度。并且之前的工作对于光照、背景研究是有限的,(晴到阴,车道到草坪)。.Unfortunately, to the best of our knowledge,现存对抗攻击离实际场景应用还要很大距离。

In this paper,we aim to更鲁棒、尤其是长距离、大角度、不同实际场景。.To better demonstrate the improvement over existing studies(e.g.,[15]),we consider two existing types of AEs:隐藏/出现攻击(HA/AA).

Particularly, for HA, we propose two novel techniques to improve robustness:特征-干扰增强(FIR)方法和增强现实约束生成(ERG).

不仅是优化DNN的最后一个预测层,而且同时影响其隐藏层。在分类过程中的早期阶段就隐藏特征,对于物理背景的变换是非常鲁棒的。

基于目标检测器能够记住目标背景的发现,使用ERG去生成合理的背景。利用目标的语义在网络上寻找合理的背景,并终合利用图像变化。从而生成更加鲁棒的AEs。

For AA, we propose nested-AE, which decouples the task of the varying-distance attack into two pieces:对于长/短距离攻击分别产生不同的AEs。然后以一种嵌套的方式结合为一种AE,可用于同时长短距离。最后并设计了不同风格的AEs以及使用批变换加速生成的收敛。

We evaluated the AEs generated by our solutions against multiple state-of-the-art object detectors in different physical environments systematically3.他们能够攻击不同模型(YOLO V3及Faster-RCNN)、不同距离(1m-25m)、不同角度(-60 - 60)及不同场景(多云和晴天)。Compared to previous state-of-the-art studies, the attack distance increases 52% and the angle increase 75%.并测试了其可转移性,对于其他黑盒模型的攻击性能(SSD、RFCN、Mask RCNN)

Contributions. Our contributions are outlined as follows:

1.New techniques for generating robust AEs against object detectors. We提出了FIR和ERG用于生成鲁棒的AEs,分别利用DNN的隐藏层及目标的语义信息。

2.Nested AE. 结合两个子任务目标攻击(长段距离攻击)的AEs产生一种AE,用于同时攻击不同距离。

3.We evaluated our AEs generated against multiple state-of-the-art object detectors in different physical environments systematically. Results show that 鲁棒、可转移。

2 Background

In this section, we first overview the existing object detectors, especially the break through in this field due to deep learning. Then we summarize the physical adversarial attacks against image classifiers that are closely related to our attack and the limitations of existing adversarial attacks against the object detectors. 引

2.1 Object Detection

Great progress has been made in recent years on object detection due to convolutional neural networks(CNNs).

For YOLO, a one-stage region-based framework,

Faster RCNN, a two-stage detection framework,

2.2 Physical Adversarial Examples

Many researches have explored the adversarial attacks against the image classifiers. … These works raised serious safety and security concerns especially for the safety critical systems.

对物体探测器的实际对抗性攻击应该让对抗性样本在大部分(如果不是全部的话)帧上工作.最近的针对目标检测的物理攻击[].然而他们受限于距离、角度和场景。

3 Attack Approach

Building robust AEs,图1展示了真实场景下的对抗攻击。相对移动造成的距离、角度、尺寸、形状及光照等变化对于AEs的鲁棒性提出了更高的要求。

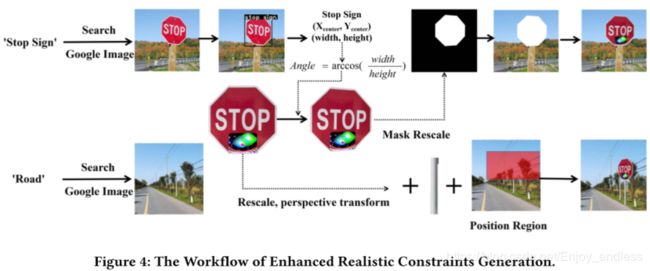

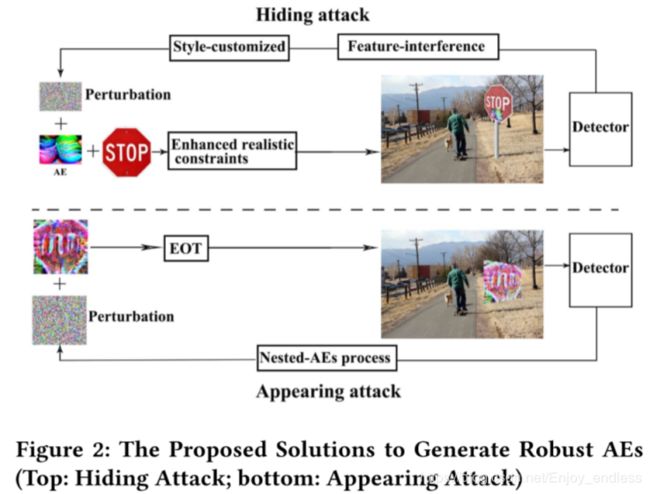

To generate robust and practical AEs, we proposed 了适当的方法针对于HA和AA。如图2所示,对于HA,提出了FIR和EGR;对于AA,提出了nested-AE。最后风格定制及批变换。

Threat Model. In this paper, we focus on the white-box adversarial attack,同时通过黑盒模型测试其可转移性。

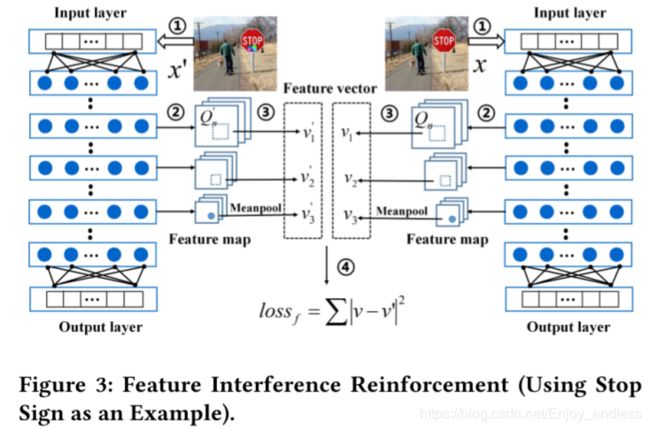

3.1Feature-interference Reinforcement

To generate AEs, most of the existing studies设计目标函数或损失函数来最小化模型预测值及期望值之间的不同。AEs可以通过扰动目标早期隐藏层的特征来增强攻击性。

Figure3 shows展示了特征干扰增强攻击的原理和过程。

In Step 1, 输入原图像x及对抗图像x’, Then in Step 2,提取相同层的隐藏特征。在这里只关注于图像中目标的特征,因为CNN提取特征过程是与原图像保持几何位置的,所以我们可以根据label来确定提取特征图当中目标所对应的特征。 (目标的具体对应特征)

In Step 3, 池化后得到特征向量v及v’。例如,对于某一层得到的特征图为33256,33为特征图大小,256表示卷积核个数,一般一个卷积核代表一种特定的特征。使用平均池化由33变为一个数,最终为大小为256的tensor,然后再标准化最终获得这一层的特征向量v/v’.(卷积核----平均池化----标准化)

**In Step 4,**使用损失函数测量特征间距离。

![]()

最终,损失函数为:

C为框置信度、N为预测索引、p为类别概率分布、y为预测、s为类别概率空间;

为了实现攻击目标:最小化置信度及目标类别概率,同时最大化与原图像特征差距。

To reduce the complexity of the object function, instead of all hidden layers, we select a few hidden layers to optimize the third item of Equation1.选取了了部分隐藏层,提取特征部分一般包括好多层CNN,但是可以根据他们提取后特征的大小,进行分组。不同组的特征图大小是不一样的,然后取每一组的最后一层特征图进行loss计算。(选特征层取loss)

3.2Enhanced Realistic Constraints Generation

In the prior studies, Expectation over Transformations (EOTs) are applied to build an adversarial attack in the physical world.EOT添加随机扰动、图像变换,在真实场景中是不足够的。

我们发现,目标检测器对于目标的背景及其语义之间具有一定的知识。这种“知识”使得检测器对对象与不同背景的关系以及对象的语义完整性非常敏感。更确切地说,前者是指该对象是否处于合理的环境中,该对象是否处于合理的位置,后者是指该对象是否呈现出合理的整体性。

We can leverage these sensitivities to expose,,ERG is proposed to generate more realistic constraints (reasonable background and reasonable object semantic integrity) in a systematic way。我们通过搜索引擎利用两种方法来获得必要背景:1使用名字搜索(如’stop sign’),2使用目标的相关语义词(如’road’).

For the background images containing the target,

For the background images without the target, but with related semantics,

Besides the realistic constraints generation, we also consider the color saturation constraint to over come the printer chromatic aberration.

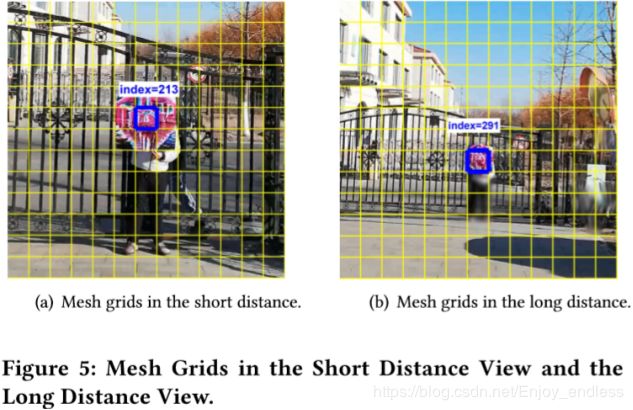

3.3Nested AEs

最近的目标检测器,如YOLO V3使用多尺度来测量目标的范围(大中小尺度)。

根据上面的观察,我们总是在不同的距离上瞄准模型,因为这样更容易被欺骗。将中心区域(用于短距离攻击)整合为整个区域(用于远程攻击)的子区域在本文中称为嵌套的AE。

Xi表示通过随机噪声产生的AE,J为求梯度,Clip为标准化到[0,255],Sp为AE的尺寸,如果其小于一定阈值表示为长距离攻击,则更新AE的整体;相似的,如果为短距离攻击,则AE较大,只更新AE的中心部分。通过分别长/短攻击后再嵌套结合产生鲁棒的距离AE。

未完,待续。