信息论基础(学习笔记整理)

信源:产生消息或消息序列的来源。

信宿:消息传送的终点(人或机器)。

信道:信号由发送端传输到接收端的媒介。

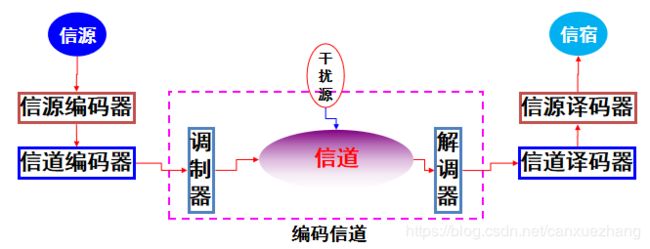

通信系统理论模型

如何提高信息系统的可靠性、有效性、保密性、认证性

信息论是将通信技术、概率论、随机过程、数理统计等学科相结合逐步发展而形成的一门新兴科学。

奠基人:美国数学家香农 (C. E. Shannon),1948年发表了著名的论文 “通信的数学理论” ,为信息论奠定了理论基础。

半个世纪以来,以通信理论为核心的经典信息论,以“信息技术”为物化手段向高精尖方向发展,神奇般的把人类推向信息时代,已经超越了狭义的通信工程的范畴,进入了信息科学这一更广阔、更新兴的领域。

在香农信息论的指导下,人们在信源编码和信道编码两个领域进行了卓有成效的研究,在提高通信系统信息传输的有效性和可靠性上取得了丰硕成果。

作为科学术语,最早是哈特莱(R. V. Hartley)在1928年发表的《信息传输》一文中提出:“发信者所发出的信息,就是他在通信符号表中选择符号的具体方式”。定义不涉及到信息的价值和具体内容,只考虑选择的方式,但没有考虑各种可能选择方法的统计特性。

1948年,维纳 (N. Wiener)首次将信息与物质、能量相提并论。信息就是信息,不是物质也不是能量。将“信息”上升到“最基本概念”的位置。

从维纳的观点,物质、能量和信息是相互有区别的,是人类社会赖以生存、发展的三大基础:世界由物质组成,能量是一切物质运动的动力,信息是人类了解自然及人类社会的凭据。

信息的一般概念

信息是信息论中最基本、最重要的概念,既抽象又复杂。而在日常生活中,信息常常被认为是“消息”、“知识”、“情报”等。

“信息”不同于情报

情报是人们对于某个特定对象所见、所闻、所理解而产生的知识,其含义比“信息”窄的多。情报 (intelligence) 与信息(information) 有着严格的区别,情报是指经过慎密分析得到的特殊的信息,可作为决策的依据,它只是一类特定的信息,不是信息的全体。

“信息”不同于知识

知识是人们根据需要,从自然界收集得来的数据中提取得到的有价值的信息,它们是对客观事物规律性的概括,是一种具有普遍性和概括性的高层次的信息。

信息的一般概念

区分消息、信号、信息

消息

信号

信息

信息、消息和信号

- 消息是信息的载体,不同的消息可以包含相同的信息。同一信息,可以采用不同的消息形式(比如文字、语言、图象等)来载荷。例如球赛进展情况可用电视图像、广播语言、报纸文字等不同消息来表述。

- 信号携带着消息,它是消息的运载工具。同一信号形式,比如“0”与“1”,可以表达不同形式的信息,如无与有、断与通、低与高(电平)等等。

- 信息是由具体的物理信号、数学描述的消息的内涵。可理解为消息中包含的有意义的内容。

信息量化

香农信息定义:

信息是事物运动状态或存在方式的不确定性的描述。

分析

通信的过程是传输消息,消息的传递过程具有不确定性:

收信者在收到消息之前,并不知道消息的具体内容;

收信者在收到消息之后,由于干扰的存在,并不一定能确定所收到的消息是否正确与可靠。

通信过程是一种消除上述不确定性的过程。

原先的不确定性全部被消除了,就获得了全部的信息;若原先的不确定性没有任何消除,就没有获得任何信息。

如果不确定性的大小能够度量,那么信息也是可以测度的。

通信系统的模型——信息论的研究对象

- 各种通信系统的本质都是信息传输系统。将他们具有共同特性的部分抽取出来,概括成一个统一的理论模型,通常称为通信系统模型。

- 通信系统模型正是信息论的研究对象。通过对系统中消息的传输和处理来研究信息传输和处理过程的共同规律,以提高信息传输的可靠性、有效性、保密性和认证性。

编码器

把消息变换成信号

信源编码器

将信源的输出进行适当的变换,以提高信息传输的有效性。

信道编码器

对信源编码器的输出进行变换,用增加冗余度的方法提高信道的抗干扰能力,以提高信息传输的可靠性。

信道

信号由发送端传输到接收端的媒介。典型的传输信道有明线、电缆、高频无线信道、微波通道和光纤通道等;典型的存储媒介有磁芯、磁鼓、磁盘、磁带等。

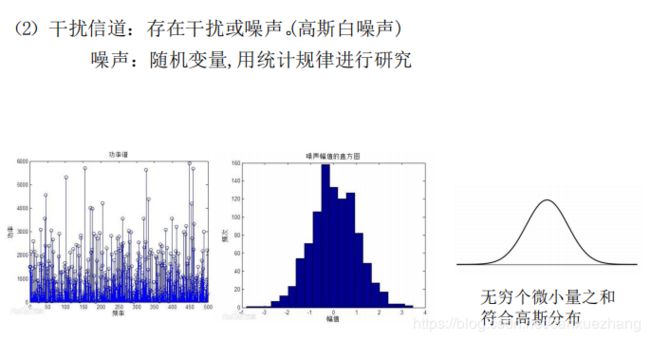

干扰源

对传输信道或存储媒介构成干扰的来源的总称。干扰或噪声往往具有随机性,所以信道的特征也可以用概率空间来描述;而噪声源的统计特性又是划分信道的依据。

加性干扰:它是由外界原因产生的随机干扰,它与信道中传送的信号的统计特性无关,因而信道的输出是输入和干扰的叠加;

乘性干扰:信道的输出信号可看成输入信号和一个时变参量相乘的结果。

调制器

将信道编码器输出的数字序列变换为振幅、频率或相位受到调制控制的形式,以适合在信道中进行较长距离的传输。

解调器

从载波中提取信号,是调制的逆过程。

信道译码器

利用信道编码时所提供的冗余度,检查或纠正数字序列中的错误。

信源译码器

把经过信道译码器核对过的信息序列转换成适合接收者接收的信息形式。转换过程与信源编码方式相关。

通信的结果

通信的结果是消除或部分消除传递过程中的不确定性,从而获得准确的信息。

数学期望

在概率论和统计学中,数学期望(mean)(或均值,亦简称期望)是试验中每次可能结果的概率乘以其结果的总和,是最基本的数学特征之一。它反映随机变量平均取值的大小。

E[码元]=1×1/2 +2×1/4 +3×1/8×2=1+3/4

信息论研究目的

找到信息传输过程的共同规律,提高信息传输的可靠性、有效性、保密性和认证性,以达到信息传输系统的最优化。

可靠性

使信源发出的消息经过信道传输以后,尽可能准确地、不失真地再现于接收端。

有效性

用尽可能短的时间和尽可能少的设备来传送一定数量的信息。

保密性

隐蔽和保护通信系统中传送的消息,使它只能被授权接收者获取,而不能被未授权者接收和理解。

认证性

接收者能正确判断所接收的消息的正确性,验证消息的完整性,而不是伪造的和被窜改的。

研究内容

狭义信息论

(经典信息论):主要研究信息的测度、信道容量、信源编码和信道编码等问题。这部分内容是信息论的基础理论,又称为香农信息论。

一般信息论

(工程信息论): 主要研究信息传输和处理问题,除了香农理论外,还包括编码理论、噪声理论、信号滤波和预测、统计检测和估计理论、调制理论、信息处理理论、保密理论等。

广义信息论

是现代信息科学理论,它是一门新兴的综合性学科,不仅包括上述两方面的内容,而且包括所有与信息有关的领域,如模式识别、计算机翻译、心理学、遗传学、生物学、神经生理学、语言学、语义学等,甚至包括了社会、人文、经济等学科中有关信息的问题。

本课程主要研究香农信息理论。

信息的度量(测度)

样本空间、概率空间 、先验概率 、后验概率 、自信息 、互信息等。

样本空间

某事物所有可能选择的消息的集合(即该事物所有可能出现的不同状态)构成该事物的样本空间。每个可能选择的消息(或称一个事件)是这个空间的一个元素。

概率测度

对于一个离散的消息空间,为其中每一个可能选择的消息指定一个概率,构成这个样本空间的一个概率测度。

概率空间

一个样本空间和它的概率测度称为一个概率空间。

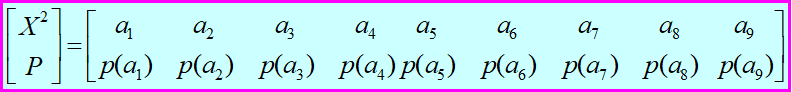

一个样本空间 X={a1, a2, …, aq} 和它的概率测度P(X)={P(a1), P(a2), …, P(aq)}统称为一个概率空间,可用 [X, P] 来表示:

![]()

先验概率

选择符号 ai 作为消息的概率 P(ai) 称为先验概率。

后验概率

接收端收到的消息(符号)为 bj ,而发送端发的是 ai 的概率 P(ai | bj) 称为后验概率。后验概率反映了在接收端收到的消息(符号)为 bj 后,对于发送端发送的是 ai ,尚存在不确定性。类似地,这种不确定性描述为:

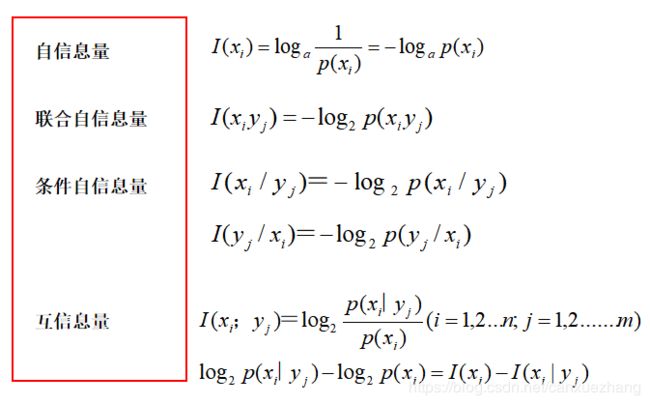

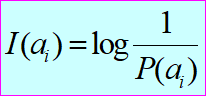

自信息

在接收端,选择 ai 作为消息(猜测事件 ai 发生)的不确定性(与 ai 作为消息的先验概率成反比),表示为 :

称为 ai 的自信息。自信息描述了 ai 本身携带的信息量,与接收端无关。

互信息

收信者收到消息(符号) bj 后,将事件 ai 先验的不确定性(自信息)减去尚存在的不确定性定义为互信息:

互信息被认为是此时收信者获得的信息量。

离散信源及信息熵

离散信源

数学表示

P(x,y)= P(x) P(y|x)

数学表示:

P(x,y)= P(x) P(y|x)

联合概率 条件概率:在x的前提下,y的概率。

无记忆

P(x,y)=P(x) P(y)

若记忆长度为m+1,则称这种有记忆信源为m阶马尔可夫信源。

若记忆长度为m+1,则称这种有记忆信源为m阶马尔可夫信源。

![]()

自信息、自信息量

自信息量的度量方法

消息ai 发生所含有的信息量称为消息ai 的自信息量。

![]()

![]()

自信息量相减——确定的部分——获得的信息量

不确定度 、自信息量,具有相同的量纲

获得的信息量=之前—之后的不确定度

![]()

假设一条电线上串联8个灯泡,这8个灯泡损坏的可能性是等概率的,现假设这8个灯泡有一个且只有1个已经损坏,让我们检查判断哪一个灯泡损坏并分析信息获取的过程。

![]()

用万用表进行检查判断(二分法)

第一次获得的信息量

第二次获得的信息量

第三次获得的信息量

结论

收到某消息获得的信息量

=不确定性减少的量

=(收到消息前某事件发生的不确定性)

-(收到消息后关于该事件的不确定性)

自信息是指某一消息所含有的信息量,消息不同,所含有的信息量也不同,不能用它作为整个信源的信息测度。

几种概率

贝叶斯公式

互信息量

收到yi,获得xi的信息量是多少?

互信息量的性质

对称性

值域为实数

不大于其中任一事件的自信息量

信息熵

单位:比特/符号。(底数不同,单位不同)

信源的信息熵H考虑的是整个信源的统计特性。它是从平均意义上来表征信源的总体信息测度。

对于某特定的信源(概率空间给定),其信息熵是个确定的数值。

不同的信源因统计特性不同,其熵也不同。

信源熵的物理意义

- 信源熵H(X)表示信源输出后,每个消息(或符号)所提供的平均信息量。

- 信源熵H(X)表示信源输出前,信源的平均不确定性。

- 信源熵H(X)反映了变量X的随机性。

重要公式

联合自信息量

条件自信息量

信息熵

信源发出的消息可能有很多个,每个消息的自信息不一样,因此,我们对整个信源进行度量的时候,需要进行统计平均。这个统计平均的过程,也就是求离散消息自信息量的数学期望,——信源的平均自信息量,也就是信息熵

单位:比特/符号。(底数不同,单位不同)

信源的信息熵H考虑的是整个信源的统计特性。它是从平均意义上来表征信源的总体信息测度。

考虑的不是单个符号,而是信源的整体测度,是表示该信源每输出一个符号,平均给出多少信息量,不考虑具体输出哪个符号。

信源平均每个符号或者每个消息含有多少信息量。

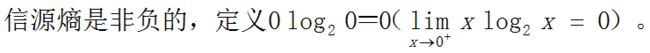

联合熵

定义:联合离散符号集XY上的每个元素对 xiyj的联合自信息量的数学期望,用H(XY)表示。

两个随机变量X和Y既可以表示两个单符号离散信源的输出,也可以表示一个离散信源输出的两个符号,还可以表示信道输入和信道输出(信源、信宿)。

![]()

意义:表示联合离散符号集XY上的每个元素对平均提供的信息量或平均不确定性,单位为比特/符号对。

信源熵(信源的平均自信息量):信源每个消息(或符号)所提供的平均信息量,或者信源的平均不确定性(度)。

条件熵

条件熵 H(X|Y)、H(Y|X)

(1) 事件和集合的条件熵(先对X取平均)

推导:

2) 集合和集合的条件熵(再对Y取平均)![]()

两个随机变量X和Y既可以表示两个单符号离散信源的输出,也可以表示一个离散信源输出的两个符号,还可以表示信道输入和信道输出(信源、信宿)。

物理意义

在Y已知条件下,符号X提供的平均信息量;

在Y已知条件下,仍然对X存在的平均不确定性;

信宿Y平均每收到一个消息,对信源X的平均不确定度(由传输失真造成)。

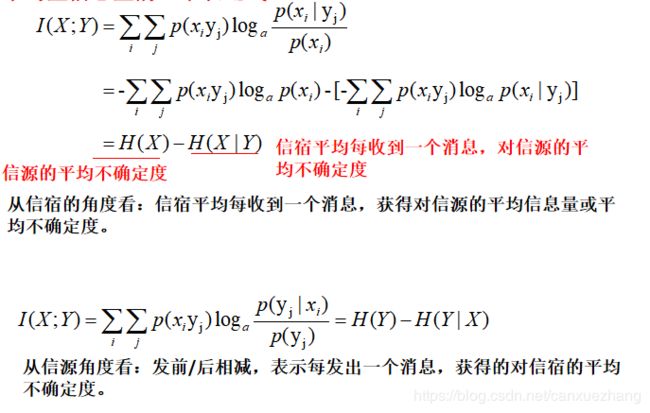

信道提供的平均信息量

各类熵之间的关系

1. 条件熵不大于无条件熵

已知Y时X的不确定性应小于或等于对于Y一无所知时X的不确定性。

如果X和Y有关联性,从Y得到了一些关于X的信息,从而使X的不确定性降低;

如果X和Y相互独立,则等号成立。

2. 可加性

![]()

![]()

![]()

联合熵永远小于或等于信源熵+信宿熵, X和Y相互独立时相等。

平均互信息量的三个表达式:

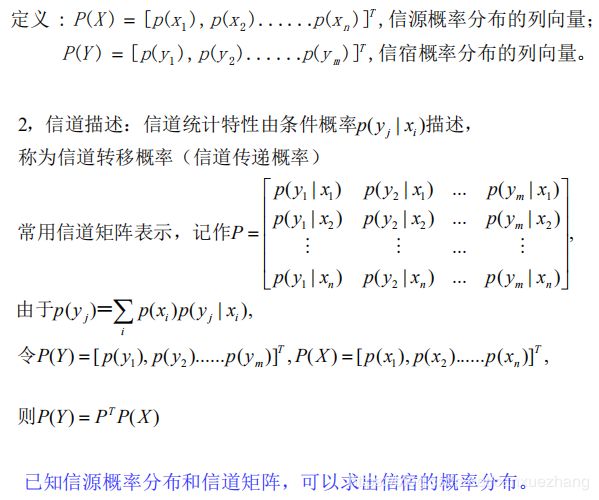

转移概率

一般通信模型:

由于信道中存在噪声干扰,因此符号在传输中会产生错误,这种信道干扰对传输信号的影响可用条件概率来描述。这个条件概率就集中体现了信道对符号的传递作用。

(信道的)转移概率(m×n个):

P(xi)概率分布 反映信源的特性

转移概率分布反映信道的特性

为方便记录,用转移矩阵表示一般信道的转移概率:

(信道的)转移概率:

1. 已知信源概率和转移概率

2. 已知联合概率

从Y中获得的关于X的信息量,与从X中获得的关于Y的信息量,二者是相等的。

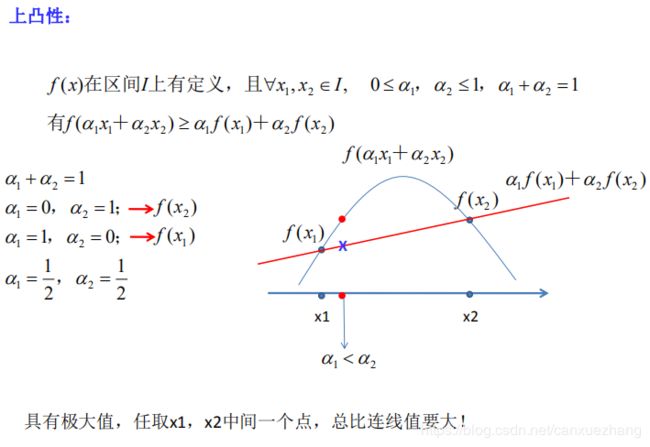

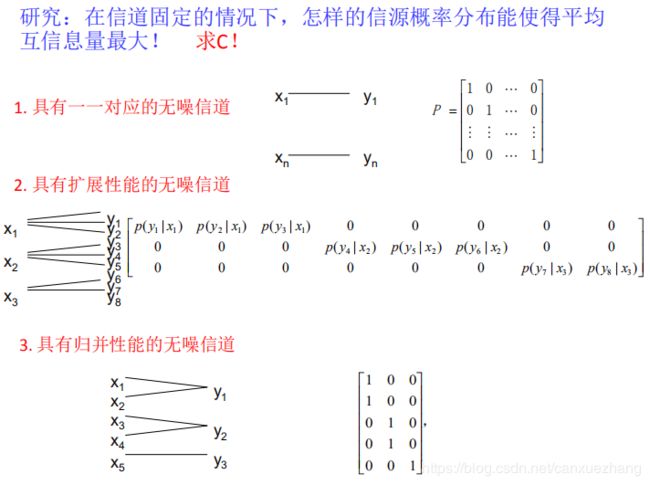

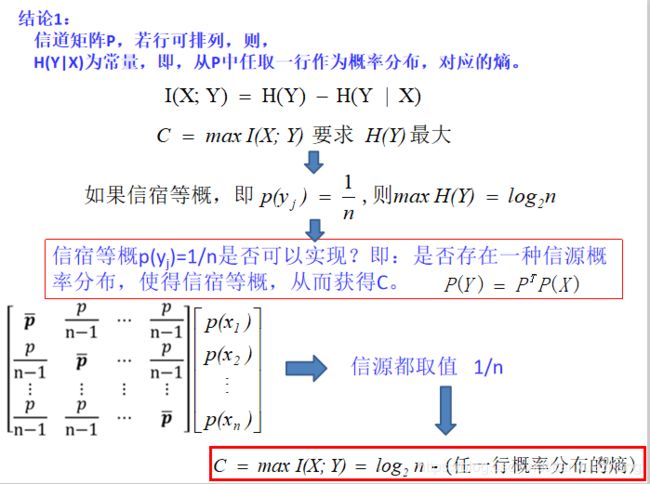

上凸性表明:

当固定某信道时,选择不同概率分布的信源与信道连接,在信道输出端接收到每个符号后,获得的信息量是信源概率分布的上凸函数。

转移概率固定,即p(yj|xi)固定

即:有一个信源分布,就对应一个平均互信息量

因此,

平均信息量存在极大值。

对于每一个固定信道,一定存在某种概率分布的信源,使得输出端获得的平均信息量最大!

也就是说,对于固定的信道,在传输信息时信道能否提供其最大的传输能力,取决于信源的概率分布。

N重扩展信源 (第二章 )

离散无记忆信源

离散有记忆信源

离散信源的信源编码(第五章 )

信息传输速率、编码效率、单义可译定理

一、 发出单符号消息的离散无记忆信源

二、离散无记忆信源的扩展信源

1、二次(重)扩展信源

2、三次扩展信源

3、N 次扩展信源

4、任意 n 进制离散无记忆信源的N次扩展信源

二次(重)扩展信源的熵 (无记忆)

N次(重)扩展信源的熵 (前提:无记忆)

三、离散有记忆信源的扩展信源

第三章 离散信源的信源编码(无失真信源编码)

通信的实质是信息的传输。 高效率、高质量地传送信息却又是信息传输的基本问题! 这就需要解决两个问题:

第一,在不失真或允许一定失真的条件下,如何用尽可能少的符号来传送信源信息;

第二,在信道受干扰的情况下,如何增加信号的抗干扰能力,同时又使得信息传输率最大。

为了解决这两个问题,就要引入信源编码和信道编码。

信源编码的主要任务就是减少冗余,提高编码效率。

![]()

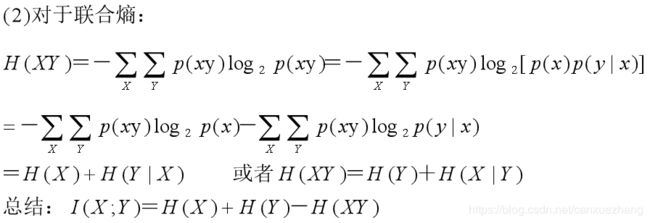

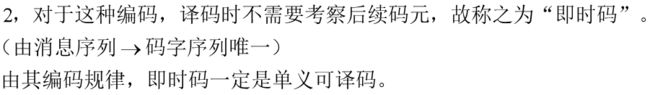

单义可译定理

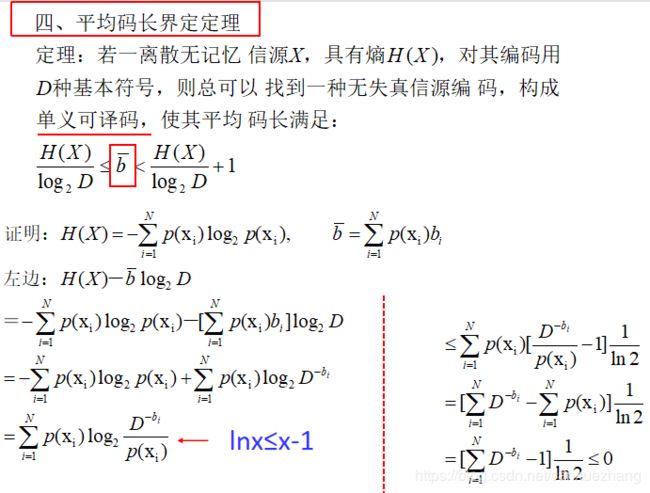

平均码长界定定理

无失真信源编码定理(香农第一定理)

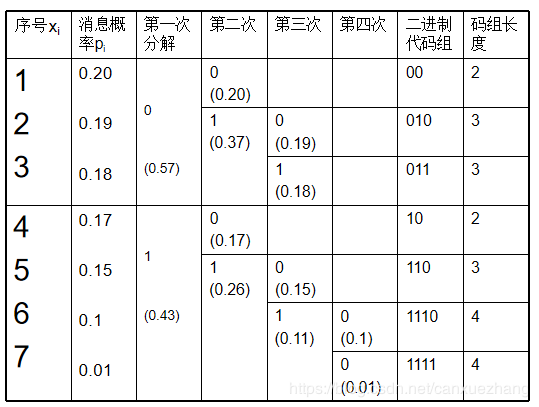

编码:霍夫曼编码、费诺编码

如果在接收端收到一个完整的码字后,就能立即进行译码,这样的码叫做即时码;

而在接收端收到一个完整的码字后,还需等下一个码字接收后才能判断是否可以译码,这样的码叫做非即时码。