Hadoop2.7.1---hdfs-over-ftp

Hadoop2.7.1---hdfs-over-ftp

软件下载地址:http://yunpan.cn/cHaQvV4UdLxX3 访问密码 f09f

第一步:安装Maven和Java,并配置相应环境变量。

第二步:修改pom.xml中相应Hadoop的版本

<dependency>

<groupId>org.apache.hadoopgroupId>

<artifactId>hadoop-commonartifactId>

<version>2.7.1version>

dependency>

<dependency>

<groupId>org.apache.hadoopgroupId>

<artifactId>hadoop-hdfsartifactId>

<version>2.7.1version>

dependency>

其他不用修改

第三步:设置用户(firstuser,hanyan),密码:123456(以下是md5加密的结果)可以将以上的用户替换成自己的用户。

ftpserver.user.firstuser.userpassword=e10adc3949ba59abbe56e057f20f883e

ftpserver.user.firstuser.homedirectory=/

ftpserver.user.firstuser.enableflag=true

ftpserver.user.firstuser.writepermission=true

ftpserver.user.firstuser.maxloginnumber=0

ftpserver.user.firstuser.maxloginperip=0

ftpserver.user.firstuser.idletime=0

ftpserver.user.firstuser.uploadrate=0

ftpserver.user.firstuser.downloadrate=0

ftpserver.user.firstuser.groups=firstuser,users

ftpserver.user.hanyan.userpassword=e10adc3949ba59abbe56e057f20f883e

ftpserver.user.hanyan.homedirectory=/

ftpserver.user.hanyan.enableflag=true

ftpserver.user.hanyan.writepermission=true

ftpserver.user.hanyan.maxloginnumber=0

ftpserver.user.hanyan.maxloginperip=0

ftpserver.user.hanyan.idletime=0

ftpserver.user.hanyan.uploadrate=0

ftpserver.user.hanyan.downloadrate=0

ftpserver.user.hanyan.groups=hanyan,users

第四步:设置ftp端口和HDFS-URI

#运行ftp端口和数据端口

port = 2222

data-ports = 2223

# hdfs uri

#注意修改成自己hadoop的namenode的地址和端口

hdfs-uri = hdfs://192.168.157.130:9000

# 指定超级用户

superuser = hanyan

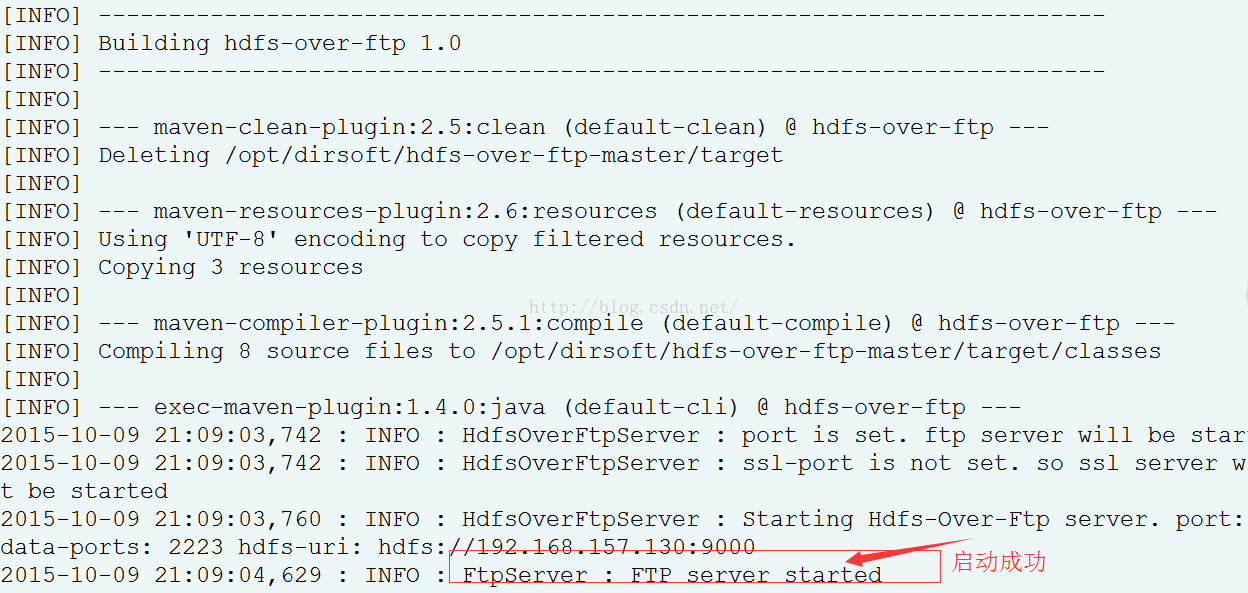

第五步:启动程序保证Maven和Java可用

sh./hdfs-over-ftp.sh 或 ./hdfs-over-ftp.sh

可以在浏览器中访问了

ftp://ip:2222 --》 输入用户名和密码即可。