- 《从传统到智能:大模型交换机的变革之路》

烁月_o9

数据库服务器运维web安全安全

大模型交换机是一种专门为大规模人工智能模型提供网络和计算资源调度的硬件设备。以下是关于它的详细介绍:特点高带宽和低延迟:大模型的训练和推理通常需要处理大量的数据,高带宽可以确保数据在各个计算节点之间快速传输,低延迟则能减少数据传输过程中可能出现的瓶颈,提高训练和推理的效率。智能路由与数据调度:基于AI算法的调度机制,能够动态地调整数据传输路径,以应对不同网络条件和负载的变化,避免某些节点的拥塞,确

- 如何在 Ubuntu 20.04 或 22.04 上安装 Python 3

百川Cs

计算机基础ubuntupythonlinuxpipconda

以下是关于如何在Ubuntu20.04或22.04上安装Python3的详细步骤。Python是一种广泛使用的编程语言,适用于自动化、数据分析、机器学习等领域。Ubuntu系统通常预装了Python3,但如果需要安装或升级到最新版本,可以按照以下方法操作。检查系统是否已安装Python3打开终端(快捷键:Ctrl+Alt+T)。输入以下命令检查是否已安装Python3:python3--versi

- 探秘FreeMovie:一个开源的电影推荐系统

孟振优Harvester

探秘FreeMovie:一个开源的电影推荐系统去发现同类优质开源项目:https://gitcode.com/项目简介是一个基于深度学习的开源电影推荐系统,由pojiezhiyuanjun开发并维护。该项目的目标是为用户提供个性化的电影推荐服务,通过机器学习算法理解用户的观影偏好,并据此进行智能推荐。技术分析FreeMovie的核心架构包括以下关键组件:数据处理-项目采用Hadoop进行大数据预处

- 『大模型笔记』AI自动化编程工具汇总[持续更新ING]!

AI大模型前沿研究

大模型笔记大模型AI自动化工具bolt.newCursorV0

『大模型笔记』AI自动化编程工具汇总!文章目录一.Bolt.new(开源AI驱动全栈Web开发工具)1.1.Bolt.new介绍1.2.编程小白如何打造自己的导航网站二.Cursor(人工智能代码编辑器)2.1.Cursor入门教程2.2.Cursor左侧布局设置和VSCode一样2.3.Cursor效率之道:Agent模式+7大高级技巧详解三.Windsurf(颠覆Cursor的全新工具)3.1

- 龙珠训练营机器学习task04

a_little_pig_

python

学习笔记为阿里云天池龙珠计划机器学习训练营的学习内容,学习链接为:https://tianchi.aliyun.com/competition/entrance/231702/introduction?spm=5176.20222472.J_3678908510.8.8f5e67c2RKrT98总体思路:分别使用LightGBM,xgboost,gbdt,catboost建立多个个体学习器(加入b

- Topaz Video AI——视频修复

爱研究的小牛

AIGC—视频AIGC

一、TopazVideoAI介绍及使用TopazVideoAI是一款基于人工智能的视频增强和修复软件,主要用于提升视频质量、去噪、插帧和分辨率提升。它利用深度学习技术对视频进行智能化处理,使得视频看起来更加清晰和流畅。TopazVideoAI特别适合那些需要修复旧视频、提升低分辨率视频质量的用户。二、TopazVideoAI的主要功能视频去噪:通过AI模型去除视频中的噪点,使画面更加干净。分辨率提

- RPA真的是人工智能吗?

微刻时光

RPA加油站rpa人工智能

1.RPA与AI的定义与区别1.1RPA的定义与特点机器人流程自动化(RoboticProcessAutomation,简称RPA)是一种软件技术,它通过模拟人类用户的操作行为来自动执行重复性、基于规则的任务。RPA的核心特点包括:非侵入性:RPA作为外挂工具部署在客户现有系统上,不影响原有IT基础架构。基于规则的操作:RPA流程必须有明确的、可被数字化的触发指令和输入,不允许出现无法提前定义的例

- 机器学习与分布式机器学习_经理人的机器学习–您需要知道的

cumian8165

算法神经网络大数据编程语言python

机器学习与分布式机器学习Ifyouaremanagingatechteamasaproductorprojectmanager,hereiswhatyouneedtoknowaboutmachinelearning.如果您要以产品或项目经理的身份管理技术团队,这是您需要了解的有关机器学习的知识。Machinelearninganddeeplearninghavebeenpopularbuzzwor

- 影刀 RPA:企业数字化转型的强大引擎

RPA李老师

rpa

一、影刀RPA是什么影刀RPA是一种基于机器学习和人工智能技术的自动化工具,它在当今数字化时代发挥着重要作用。影刀RPA是一款软件机器人,能模拟人的各种操作,在任何应用程式上进行鼠标点击、键盘输入、读取信息等自动化操作,释放人非主观决策、逻辑性高、规则性强的工作。在了解影刀RPA之前,我们先来认识一下RPA。RPA是RoboticProcessAutomation(机器人流程自动化)的简称,201

- 浅析AI大模型现状及其应用,零基础入门到精通,收藏这篇就够了

程序员_大白

互联网程序员大模型人工智能数据挖掘大模型

随着人工智能技术的迅猛发展,AI大模型已经成为全球科技竞争的焦点,展现出巨大的发展潜力和广阔的应用前景。AI大模型的应用落地正引发行业关注,技术进步正促使AI大模型的应用逐步从云端向终端设备延伸,从通用模型向针对特定行业的定制化解决方案转变,其商业潜力和对行业的影响不断增强。与此同时,国内外企业在大模型领域的竞争日趋激烈。AI大模型蓬勃发展AI大模型主要特征AI大模型具有泛化性(知识迁移到新领域)

- 【Python篇】从零到精通:全面分析Scikit-Learn在机器学习中的绝妙应用

半截诗

Pythonpython机器学习scikit-learn人工智能深度学习数据分析随机森林

文章目录从零到精通:全面揭秘Scikit-Learn在机器学习中的绝妙应用前言第一部分:深入了解Scikit-Learn的基础知识1.什么是Scikit-Learn?2.安装Scikit-Learn3.Scikit-Learn中的基本构件4.数据集的加载与探索5.数据预处理标准化数据6.构建和训练机器学习模型构建逻辑回归模型7.模型评估与验证混淆矩阵第二部分:深入理解Scikit-Learn的高级

- 【自然语言处理(NLP)】jieba分词的使用(分词模式、关键词提取)

道友老李

自然语言处理(NLP)自然语言处理人工智能

文章目录介绍jieba分词的使用1.安装2.jieba分词模式2.1精确模式2.2全模式2.3搜索引擎模式2.4词性标注2.5加载自己的分词文件3.查看词频4.关键词提取个人主页:道友老李欢迎加入社区:道友老李的学习社区介绍**自然语言处理(NaturalLanguageProcessing,NLP)**是计算机科学领域与人工智能领域中的一个重要方向。它研究的是人类(自然)语言与计算机之间的交互。

- 【2025优质学术推荐】征稿控制科学、仪器、智能系统、通信、计算机、电子信息、人工智能、大数据、机器学习、软件工程、网络安全方向

努力学习的大大

学术会议推荐人工智能大数据深度学习神经网络

【2025优质学术推荐】征稿控制科学、仪器、智能系统、通信、计算机、电子信息、人工智能、大数据、机器学习、软件工程、网络安全方向【2025优质学术推荐】征稿控制科学、仪器、智能系统、通信、计算机、电子信息、人工智能、大数据、机器学习、软件工程、网络安全方向文章目录【2025优质学术推荐】征稿控制科学、仪器、智能系统、通信、计算机、电子信息、人工智能、大数据、机器学习、软件工程、网络安全方向2025

- Python数据分析案例教程

kkchenjj

数据挖掘python数据分析信息可视化

Python数据分析案例教程Python在数据分析中的应用Python因其简洁的语法、强大的库支持以及广泛的社区资源,已成为数据分析领域的首选语言。它能够处理从数据清洗、数据可视化到机器学习模型构建的整个数据科学流程。本节将深入探讨Python在数据分析中的具体应用,包括但不限于数据清洗、数据探索、统计分析和预测建模。数据清洗数据清洗是数据分析的首要步骤,涉及处理缺失值、异常值、重复数据以及数据类

- 2025年新出炉的MySQL面试题

长风清留扬

150道MySQL高频面试题mysql数据库面试sql

作者简介:CSDN\阿里云\腾讯云\华为云开发社区优质创作者,专注分享大数据、Python、数据库、人工智能等领域的优质内容个人主页:长风清留杨的博客形式准则:无论成就大小,都保持一颗谦逊的心,尊重他人,虚心学习。✨推荐专栏:Python入门到入魔,Mysql入门到入魔,Python入门基础大全,Flink入门到实战若缘分至此,无法再续相逢,愿你朝朝暮暮,皆有安好,晨曦微露道早安,日中炽热说午安,

- 精选了几道MySQL的大厂面试题,被提问的几率很高!

长风清留扬

150道MySQL高频面试题mysqlandroid数据库面试学习MySQL面试

作者简介:CSDN\阿里云\腾讯云\华为云开发社区优质创作者,专注分享大数据、Python、数据库、人工智能等领域的优质内容个人主页:长风清留杨的博客形式准则:无论成就大小,都保持一颗谦逊的心,尊重他人,虚心学习。✨推荐专栏:Python入门到入魔,Mysql入门到入魔,Python入门基础大全,Flink入门到实战若缘分至此,无法再续相逢,愿你朝朝暮暮,皆有安好,晨曦微露道早安,日中炽热说午安,

- 2025数学建模美赛B题完整建模思路——管理可持续旅游业

鹿鹿数模

数学建模

2025MCM问题B:管理可持续旅游业以下是我们对该题目的赛题分析,由于完整内容过长,因此在此处放出部分内容,欢迎从文末小卡片处加群获取。赛题分析以下内容包括三个主要部分:(1)题目的中文翻译(2)对题目的整体分析与思路综述(3)对题目要求的逐项详细分析与求解思路。本文的撰写将综合运用多元的数学模型、算法以及机器学习/深度学习的方法,并在必要时给出题外假设与可行的创新性思路,以期为参赛者提供较为系

- 智能运维分析决策系统:赋能数字化转型的智慧引擎

我的运维人生

运维运维开发技术共享

智能运维分析决策系统:赋能数字化转型的智慧引擎在数字化转型的大潮中,企业运维管理正经历着从传统手动运维向智能化、自动化运维的深刻转变。智能运维分析决策系统(AIOps,ArtificialIntelligenceforITOperations)作为这一转变的核心驱动力,通过融合大数据、机器学习、人工智能等先进技术,实现了对运维数据的深度洞察与智能决策,极大地提升了运维效率与质量,为企业数字业务的连

- Kmeans与KMedoids聚类对比以及python实现

呵呵爱吃菜

kmeans聚类python

在机器学习领域,聚类算法是一种常用的无监督学习方法,用于将数据集中的样本划分为若干个簇,使得同一簇内的样本尽可能相似,而不同簇之间的样本尽可能不同。K-Means和K-Medoids是两种经典的聚类算法,它们都基于划分的思想,但在具体实现和应用场景上存在一些差异。一、算法原理1.K-Means:中心点选择:K-Means算法通过计算簇内所有样本的均值来确定中心点(centroid)。距离度量:通常

- ChatGPT是强人工智能吗?

呵呵爱吃菜

chatgpt人工智能

ChatGPT是强人工智能吗?本文从人工智能发展的三个阶段的角度,分析当前强大的AI大模型所处的阶段,并通过对比各阶段的定义,明确各阶段的特点和未来发展方向;NarrowAI(弱人工智能)、AGI(人工通用智能)和ASI(人工超级智能)代表了人工智能发展的三个不同阶段,它们在智能水平、任务范围和应用场景上存在显著差异。以下是它们的总结与对比:1.定义与特点类型NarrowAI(弱人工智能)AGI(

- 网络安全态势感知:企业数字化转型的 “安全密钥”

知白守黑V

安全运营网络安全态势感知网络

在数字经济飞速发展的当下,网络安全已经成为企业平稳运营的关键所在。从大型企业的数据泄露事故,到中小企业遭遇的各类网络攻击,网络安全威胁无处不在。而网络安全态势感知产品,作为应对复杂网络威胁的关键技术,正逐渐成为企业守护数字资产的“智慧大脑”。一、态势感知:全景掌控,精准防御你可以把网络安全态势感知想象成企业网络的“超级侦察兵”。它借助大数据分析、机器学习这些先进技术,就像是拥有了超级强大的“洞察力

- python机器学习

方安乐

pythonpython机器学习人工智能

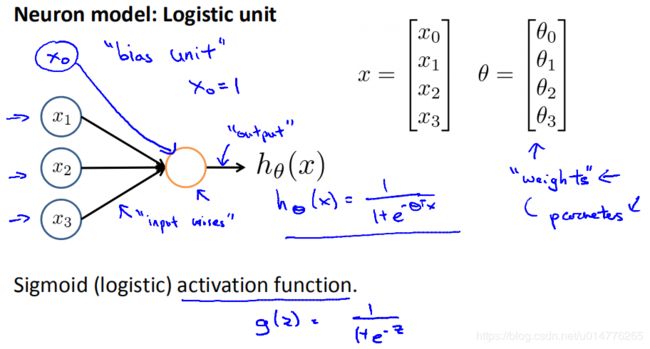

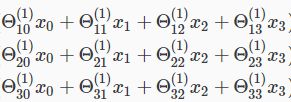

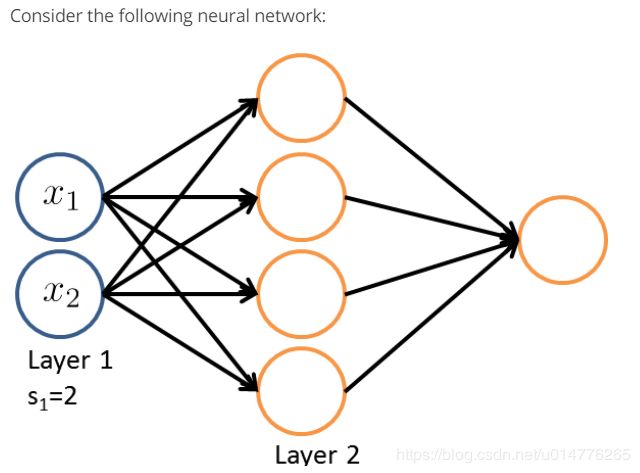

Python机器学习是当前最为热门的机器学习领域之一,其简洁、易用、高效的特点,让越来越多的开发者开始探索其应用。本文将从以下几个方面介绍Python机器学习的基础知识和实践案例,帮助读者更好地理解和应用机器学习技术。前提Python机器学习的应用领域A.图像识别和计算机视觉B.自然语言处理和文本分析C.数据挖掘和推荐系统深度学习A.神经网络的基本原理B.常用的深度学习框架和算法C.深度学习在图像

- 情感分析常见算法与模型及实现步骤

计算机软件程序设计

知识科普算法情感分析机器学习

【1】常见算法与模型情感分析(SentimentAnalysis)是一种自然语言处理(NLP)技术,用于识别和提取文本中的主观信息,如情绪、态度和意见。常见的算法和模型包括以下几种:传统机器学习方法朴素贝叶斯(NaiveBayes)基于贝叶斯定理,假设特征之间相互独立。计算简单,适用于大规模数据集。常用于文本分类任务。支持向量机(SVM)通过寻找最优超平面来划分不同的类别。在高维空间中表现良好,适

- 2025-1-21-sklearn学习(43) 使用 scikit-learn 介绍机器学习 楼上阑干横斗柄,寒露人远鸡相应。

汤姆和佩琦

sklearn机器学习sklearn学习python人工智能scikit-learn

文章目录sklearn学习(43)使用scikit-learn介绍机器学习43.1机器学习:问题设置43.2加载示例数据集43.3学习和预测43.4模型持久化43.4规定43.4.1类型转换43.4.2再次训练和更新参数43.4.3多分类与多标签拟合sklearn学习(43)使用scikit-learn介绍机器学习文章参考网站:https://sklearn.apachecn.org/和https

- 通过Python编程语言实现“机器学习”小项目教程案例

胡萝卜不甜

机器学习python机器学习开发语言

1.Python与机器学习概述1.1Python语言特点Python是一种广泛使用的高级编程语言,具有简洁、易读、易学的特点,这使得它成为初学者和专业人士的首选语言之一。简洁性:Python的语法简洁明了,减少了代码量,提高了开发效率。例如,与其他语言相比,Python可以用更少的代码实现相同的功能,这使得代码更容易编写和维护。易读性:Python的代码风格类似于英语,易于理解和阅读。这种易读性使

- GPT-4、GPT-4O 和 GPT-4O-mini 的区别与联系

surfirst

LLMai语言模型chatgpt

简介近年来,人工智能技术飞速发展,特别是在自然语言处理领域。GPT-4是OpenAI推出的新一代大模型,而GPT-4O和GPT-4O-mini是其优化版本,专门为不同应用场景和计算资源需求进行调整。在这篇文章中,我们将详细比较GPT-4、GPT-4O和GPT-4O-mini的区别与联系,帮助开发者更好地选择适合的模型。GPT-4是OpenAI发布的第四代通用预训练模型,具备强大的生成和理解能力,适

- 讯飞绘镜(ai生成视频)技术浅析(一)

爱研究的小牛

AIGC—视频AIGC—技术综述人工智能AIGC深度学习

讯飞绘镜(也称为星火绘镜)是科大讯飞推出的一款基于人工智能技术的短视频创作平台,旨在通过先进的AI技术简化视频创作流程,让用户能够轻松将创意转化为高质量的视频内容。以下是对讯飞绘镜相关技术、工作原理及具体实现的详细介绍:一、核心技术讯飞绘镜的核心技术主要依托于科大讯飞的星火大模型,并结合了多种先进的AI技术,包括:1.大模型技术:基于讯飞星火大模型,为脚本生成、分镜生成等提供基础能力支持。该模型能

- 第72期 | GPTSecurity周报

云起无垠

GPTSecurity人工智能安全

GPTSecurity是一个涵盖了前沿学术研究和实践经验分享的社区,集成了生成预训练Transformer(GPT)、人工智能生成内容(AIGC)以及大语言模型(LLM)等安全领域应用的知识。在这里,您可以找到关于GPT/AIGC/LLM最新的研究论文、博客文章、实用的工具和预设指令(Prompts)。现为了更好地知悉近一周的贡献内容,现总结如下。SecurityPapers1.从孤立指令到互动鼓

- 开发基于WebRTC和OpenAI实时API的AI语音助手框架:技术解析与最佳实践

花生糖@

AIGC学习资料库webrtc人工智能

随着人工智能(AI)和实时通信技术的发展,构建一个能够提供即时响应、多语言支持以及个性化用户体验的AI语音助手变得越来越重要。本文将深入探讨如何使用现代Web技术和先进的AI工具开发这样一个语音助手框架,具体来说,我们将基于Next.js、WebRTC和OpenAIAPI创建一个高效且用户友好的解决方案。技术架构主框架-Next.js选择Next.js作为主框架不仅因为它提供的服务端渲染(SSR)

- 国外各领域专家学者的一些谏言:如何使AI代理架构变得成功

强哥之神

人工智能语言模型AI代理智能体大模型Agent

最近在研究AI代理架构为什么比较难落地,看到有一篇文章是关于各领域专家学者对AI代理架构的一些看法,值得关注。我将其整理成了中文,大家可一起细品各家观点,全文如下。代理型人工智能被寄予厚望,其潜力在于能够独立完成复杂任务。然而,目前该领域的炒作热潮远超实际成功案例,背后原因复杂多样。“2024年,AI代理已成为众多供应商的营销热词。但对于用户组织而言,代理技术还处于早期探索阶段,充满好奇心与实验性

- 统一思想认识

永夜-极光

思想

1.统一思想认识的基础,才能有的放矢

原因:

总有一种描述事物的方式最贴近本质,最容易让人理解.

如何让教育更轻松,在于找到最适合学生的方式.

难点在于,如何模拟对方的思维基础选择合适的方式. &

- Joda Time使用笔记

bylijinnan

javajoda time

Joda Time的介绍可以参考这篇文章:

http://www.ibm.com/developerworks/cn/java/j-jodatime.html

工作中也常常用到Joda Time,为了避免每次使用都查API,记录一下常用的用法:

/**

* DateTime变化(增减)

*/

@Tes

- FileUtils API

eksliang

FileUtilsFileUtils API

转载请出自出处:http://eksliang.iteye.com/blog/2217374 一、概述

这是一个Java操作文件的常用库,是Apache对java的IO包的封装,这里面有两个非常核心的类FilenameUtils跟FileUtils,其中FilenameUtils是对文件名操作的封装;FileUtils是文件封装,开发中对文件的操作,几乎都可以在这个框架里面找到。 非常的好用。

- 各种新兴技术

不懂事的小屁孩

技术

1:gradle Gradle 是以 Groovy 语言为基础,面向Java应用为主。基于DSL(领域特定语言)语法的自动化构建工具。

现在构建系统常用到maven工具,现在有更容易上手的gradle,

搭建java环境:

http://www.ibm.com/developerworks/cn/opensource/os-cn-gradle/

搭建android环境:

http://m

- tomcat6的https双向认证

酷的飞上天空

tomcat6

1.生成服务器端证书

keytool -genkey -keyalg RSA -dname "cn=localhost,ou=sango,o=none,l=china,st=beijing,c=cn" -alias server -keypass password -keystore server.jks -storepass password -validity 36

- 托管虚拟桌面市场势不可挡

蓝儿唯美

用户还需要冗余的数据中心,dinCloud的高级副总裁兼首席营销官Ali Din指出。该公司转售一个MSP可以让用户登录并管理和提供服务的用于DaaS的云自动化控制台,提供服务或者MSP也可以自己来控制。

在某些情况下,MSP会在dinCloud的云服务上进行服务分层,如监控和补丁管理。

MSP的利润空间将根据其参与的程度而有所不同,Din说。

“我们有一些合作伙伴负责将我们推荐给客户作为个

- spring学习——xml文件的配置

a-john

spring

在Spring的学习中,对于其xml文件的配置是必不可少的。在Spring的多种装配Bean的方式中,采用XML配置也是最常见的。以下是一个简单的XML配置文件:

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.or

- HDU 4342 History repeat itself 模拟

aijuans

模拟

来源:http://acm.hdu.edu.cn/showproblem.php?pid=4342

题意:首先让求第几个非平方数,然后求从1到该数之间的每个sqrt(i)的下取整的和。

思路:一个简单的模拟题目,但是由于数据范围大,需要用__int64。我们可以首先把平方数筛选出来,假如让求第n个非平方数的话,看n前面有多少个平方数,假设有x个,则第n个非平方数就是n+x。注意两种特殊情况,即

- java中最常用jar包的用途

asia007

java

java中最常用jar包的用途

jar包用途axis.jarSOAP引擎包commons-discovery-0.2.jar用来发现、查找和实现可插入式接口,提供一些一般类实例化、单件的生命周期管理的常用方法.jaxrpc.jarAxis运行所需要的组件包saaj.jar创建到端点的点到点连接的方法、创建并处理SOAP消息和附件的方法,以及接收和处理SOAP错误的方法. w

- ajax获取Struts框架中的json编码异常和Struts中的主控制器异常的解决办法

百合不是茶

jsjson编码返回异常

一:ajax获取自定义Struts框架中的json编码 出现以下 问题:

1,强制flush输出 json编码打印在首页

2, 不强制flush js会解析json 打印出来的是错误的jsp页面 却没有跳转到错误页面

3, ajax中的dataType的json 改为text 会

- JUnit使用的设计模式

bijian1013

java设计模式JUnit

JUnit源代码涉及使用了大量设计模式

1、模板方法模式(Template Method)

定义一个操作中的算法骨架,而将一些步骤延伸到子类中去,使得子类可以不改变一个算法的结构,即可重新定义该算法的某些特定步骤。这里需要复用的是算法的结构,也就是步骤,而步骤的实现可以在子类中完成。

- Linux常用命令(摘录)

sunjing

crondchkconfig

chkconfig --list 查看linux所有服务

chkconfig --add servicename 添加linux服务

netstat -apn | grep 8080 查看端口占用

env 查看所有环境变量

echo $JAVA_HOME 查看JAVA_HOME环境变量

安装编译器

yum install -y gcc

- 【Hadoop一】Hadoop伪集群环境搭建

bit1129

hadoop

结合网上多份文档,不断反复的修正hadoop启动和运行过程中出现的问题,终于把Hadoop2.5.2伪分布式安装起来,跑通了wordcount例子。Hadoop的安装复杂性的体现之一是,Hadoop的安装文档非常多,但是能一个文档走下来的少之又少,尤其是Hadoop不同版本的配置差异非常的大。Hadoop2.5.2于前两天发布,但是它的配置跟2.5.0,2.5.1没有分别。 &nb

- Anychart图表系列五之事件监听

白糖_

chart

创建图表事件监听非常简单:首先是通过addEventListener('监听类型',js监听方法)添加事件监听,然后在js监听方法中定义具体监听逻辑。

以钻取操作为例,当用户点击图表某一个point的时候弹出point的name和value,代码如下:

<script>

//创建AnyChart

var chart = new AnyChart();

//添加钻取操作&quo

- Web前端相关段子

braveCS

web前端

Web标准:结构、样式和行为分离

使用语义化标签

0)标签的语义:使用有良好语义的标签,能够很好地实现自我解释,方便搜索引擎理解网页结构,抓取重要内容。去样式后也会根据浏览器的默认样式很好的组织网页内容,具有很好的可读性,从而实现对特殊终端的兼容。

1)div和span是没有语义的:只是分别用作块级元素和行内元素的区域分隔符。当页面内标签无法满足设计需求时,才会适当添加div

- 编程之美-24点游戏

bylijinnan

编程之美

import java.util.ArrayList;

import java.util.Arrays;

import java.util.HashSet;

import java.util.List;

import java.util.Random;

import java.util.Set;

public class PointGame {

/**编程之美

- 主页面子页面传值总结

chengxuyuancsdn

总结

1、showModalDialog

returnValue是javascript中html的window对象的属性,目的是返回窗口值,当用window.showModalDialog函数打开一个IE的模式窗口时,用于返回窗口的值

主界面

var sonValue=window.showModalDialog("son.jsp");

子界面

window.retu

- [网络与经济]互联网+的含义

comsci

互联网+

互联网+后面是一个人的名字 = 网络控制系统

互联网+你的名字 = 网络个人数据库

每日提示:如果人觉得不舒服,千万不要外出到处走动,就呆在床上,玩玩手游,更不能够去开车,现在交通状况不

- oracle 创建视图 with check option

daizj

视图vieworalce

我们来看下面的例子:

create or replace view testview

as

select empno,ename from emp where ename like ‘M%’

with check option;

这里我们创建了一个视图,并使用了with check option来限制了视图。 然后我们来看一下视图包含的结果:

select * from testv

- ToastPlugin插件在cordova3.3下使用

dibov

Cordova

自己开发的Todos应用,想实现“

再按一次返回键退出程序 ”的功能,采用网上的ToastPlugins插件,发现代码或文章基本都是老版本,运行问题比较多。折腾了好久才弄好。下面吧基于cordova3.3下的ToastPlugins相关代码共享。

ToastPlugin.java

package&nbs

- C语言22个系统函数

dcj3sjt126com

cfunction

C语言系统函数一、数学函数下列函数存放在math.h头文件中Double floor(double num) 求出不大于num的最大数。Double fmod(x, y) 求整数x/y的余数。Double frexp(num, exp); double num; int *exp; 将num分为数字部分(尾数)x和 以2位的指数部分n,即num=x*2n,指数n存放在exp指向的变量中,返回x。D

- 开发一个类的流程

dcj3sjt126com

开发

本人近日根据自己的开发经验总结了一个类的开发流程。这个流程适用于单独开发的构件,并不适用于对一个项目中的系统对象开发。开发出的类可以存入私人类库,供以后复用。

以下是开发流程:

1. 明确类的功能,抽象出类的大概结构

2. 初步设想类的接口

3. 类名设计(驼峰式命名)

4. 属性设置(权限设置)

判断某些变量是否有必要作为成员属

- java 并发

shuizhaosi888

java 并发

能够写出高伸缩性的并发是一门艺术

在JAVA SE5中新增了3个包

java.util.concurrent

java.util.concurrent.atomic

java.util.concurrent.locks

在java的内存模型中,类的实例字段、静态字段和构成数组的对象元素都会被多个线程所共享,局部变量与方法参数都是线程私有的,不会被共享。

- Spring Security(11)——匿名认证

234390216

Spring SecurityROLE_ANNOYMOUS匿名

匿名认证

目录

1.1 配置

1.2 AuthenticationTrustResolver

对于匿名访问的用户,Spring Security支持为其建立一个匿名的AnonymousAuthenticat

- NODEJS项目实践0.2[ express,ajax通信...]

逐行分析JS源代码

Ajaxnodejsexpress

一、前言

通过上节学习,我们已经 ubuntu系统搭建了一个可以访问的nodejs系统,并做了nginx转发。本节原要做web端服务 及 mongodb的存取,但写着写着,web端就

- 在Struts2 的Action中怎样获取表单提交上来的多个checkbox的值

lhbthanks

javahtmlstrutscheckbox

第一种方法:获取结果String类型

在 Action 中获得的是一个 String 型数据,每一个被选中的 checkbox 的 value 被拼接在一起,每个值之间以逗号隔开(,)。

所以在 Action 中定义一个跟 checkbox 的 name 同名的属性来接收这些被选中的 checkbox 的 value 即可。

以下是实现的代码:

前台 HTML 代码:

- 003.Kafka基本概念

nweiren

hadoopkafka

Kafka基本概念:Topic、Partition、Message、Producer、Broker、Consumer。 Topic: 消息源(Message)的分类。 Partition: Topic物理上的分组,一

- Linux环境下安装JDK

roadrunners

jdklinux

1、准备工作

创建JDK的安装目录:

mkdir -p /usr/java/

下载JDK,找到适合自己系统的JDK版本进行下载:

http://www.oracle.com/technetwork/java/javase/downloads/index.html

把JDK安装包下载到/usr/java/目录,然后进行解压:

tar -zxvf jre-7

- Linux忘记root密码的解决思路

tomcat_oracle

linux

1:使用同版本的linux启动系统,chroot到忘记密码的根分区passwd改密码 2:grub启动菜单中加入init=/bin/bash进入系统,不过这时挂载的是只读分区。根据系统的分区情况进一步判断. 3: grub启动菜单中加入 single以单用户进入系统. 4:用以上方法mount到根分区把/etc/passwd中的root密码去除 例如: ro

- 跨浏览器 HTML5 postMessage 方法以及 message 事件模拟实现

xueyou

jsonpjquery框架UIhtml5

postMessage 是 HTML5 新方法,它可以实现跨域窗口之间通讯。到目前为止,只有 IE8+, Firefox 3, Opera 9, Chrome 3和 Safari 4 支持,而本篇文章主要讲述 postMessage 方法与 message 事件跨浏览器实现。postMessage 方法 JSONP 技术不一样,前者是前端擅长跨域文档数据即时通讯,后者擅长针对跨域服务端数据通讯,p

![]()

![]()