世界模型【论文】

Agent可以在自己的梦境中学习吗?

概述

我们探索建立支撑流行强化学习环境的生成型神经网络模型,我们的世界模型可以以无监督的方式快速训练,以学习针对环境的压缩时空表示。通过使用从世界模型中提取的特征作为agent的输入,我们可以训练一个非常紧凑和简单的策略,可以解决所要求的任务,甚至可以完全在其世界模型生成的梦境中训练agent,并将此策略迁移到实际环境。

介绍

人类以有限的感知能力并基于他们能够感知的东西来建立世界的心理模型,我们做出的决策和行动都是基于这种内部模型。系统动力之父Jay Wright Forrester将心理模型描述为:

“ 在我们脑海中对身边的世界的形象,只是一种模型,没有人会想象到整个世界、政府或国家。他只选择了概念和它们之间的关系,并用它们来代表真实的系统。” [3]

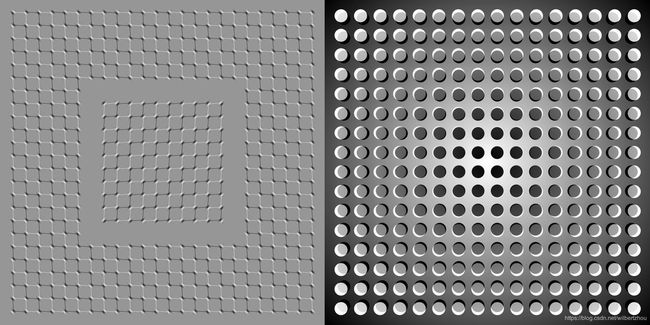

为了处理流经我们日常生活的大量信息,我们的大脑学习了这种信息的空间和时间方面的抽象表示,我们能够观察一个场景并记住它的抽象描述[4,5]。证据还表明,我们在任何特定时刻感知到的东西,是由我们的大脑根据我们的内部模型预测未来所决定的[6,7]。

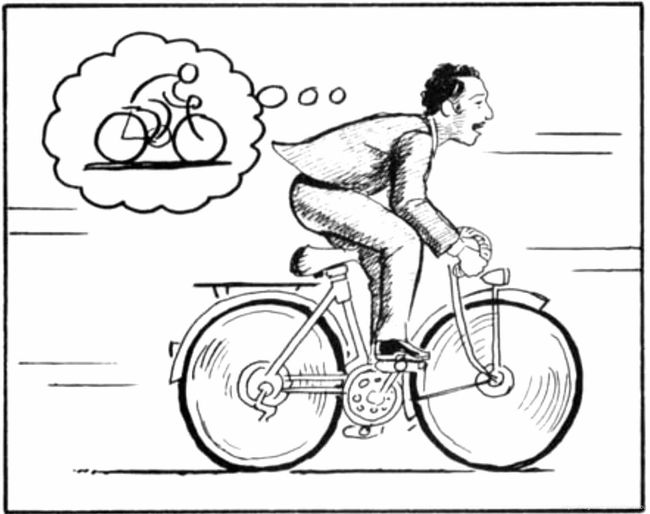

了解我们大脑内部预测模型的一种方法是,它不仅仅是预测未来,而是能根据我们当前的运动动作预测未来的感官数据 [11,12]。当我们面临危险时,我们能够本能地对这个预测模型采取行动并执行快速反射行为[13],无需有意识地制定行动方案。

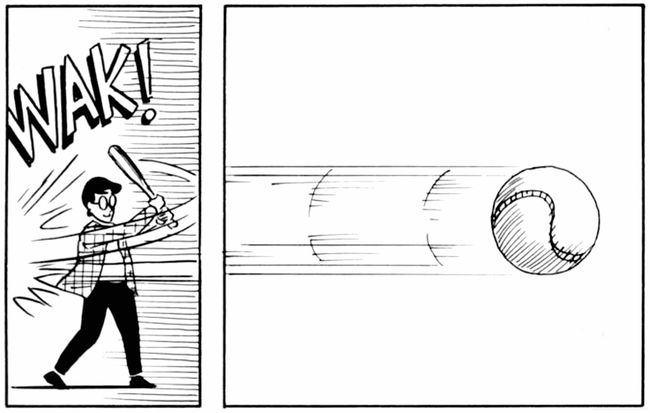

以棒球为例。一个棒球击球手有几毫秒来决定他们应该如何摆动球棒 - 比我们的眼睛到达我们大脑的视觉信号所需的时间短。我们能够击中100英里/小时快球的原因是我们能够本能地预测球何时到达何地,对于职业球员来说,这一切都是在潜意识里发生的,他们的肌肉在适当的时间和位置反射性地摆动球棒,与内部模型的预测一致[7],他们可以快速基于对未来的预测采取行动,而无需有意识地设想可能的未来情景来制定计划[14]。

在许多强化学习(RL)问题中 [15,16,17]一个人工智能体(agent)也可以从过去和现在状态的良好表现,以及未来的良好预测模型中受益 [18,19],最好是在通用计算机上实现的强大的预测模型,例如递归神经网络(RNN) [20,21,22]。

大型RNN是高度可表达的模型,可以学习丰富的数据空间和时间表示。然而,文献中的许多无模型 RL方法通常仅使用具有少量参数的小型神经网络,信用分配问题1经常是RL算法的瓶颈,这使得传统的RL算法难以学习数百万个大型模型的权重,因此在实践中,使用较小的网络,因为它们在训练期间更快地迭代以得到良好的策略。

理想情况下,我们希望能够有效地训练基于大型RNN的agent,反向传播算法[23,24,25]可以用来有效地训练大型神经网络。在这项工作中,我们将研究一个大型神经网络2通过将agent划分为大型世界模型和小型控制器模型来解决RL任务。我们首先以无监督的方式训练一个大型神经网络来学习agent的世界模型,然后训练较小的控制器模型以学习使用这个世界模型来执行任务。小型控制器使训练算法专注于小型搜索空间上的信用分配问题,同时不会通过更大的世界模型牺牲容量和表现力。我们通过世界模型的视角来训练agent,说明它可以学习一个高度紧凑的策略来执行其任务。

在本文中,我们从1990年至2015年的一系列关于RNN的世界模型和控制器 [20,21,22,26,27]论文中总结了若干关键概念,论文中使用概率建模的最新工具,提供一种简化的方法来测试现代RL环境中的一些关键概念 [28]。实验表明,我们的方法可用于使用像素解决以前使用传统方法尚未解决的具有挑战性的赛车导航的任务。

大多数现有的基于模型的 RL[29,30]方法学习RL环境的模型,但仍然在实际环境上进行训练。在这里,我们探索用生成的RL环境完全替换实际RL环境,仅在其自己的内部世界模型生成的环境内训练agent控制器,并将此策略迁移回实际环境。

为了克服agent利用(exploiting)所生成环境的缺陷的问题,我们调整内部世界模型的温度参数以控制所生成环境的不确定性的量。我们在其生成环境的更嘈杂且不确定的版本中训练agent的控制器,并证明这种方法有助于防止agent利用其内部世界模型的缺陷。我们还将讨论基于模型的RL文献中的其他相关工作,这些工作共享类似的学习动力学模型和使用该模型训练agent的想法。

Agent模型

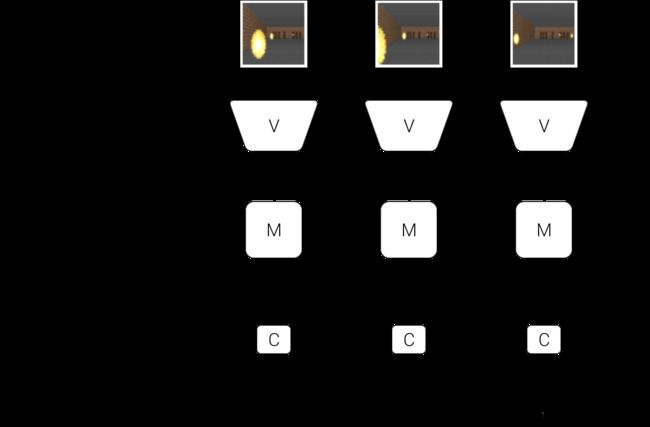

我们提出了一个受我们自己认知系统启发的简单模型,在这个模型中, agent有一个视觉感官组件,可以将它看到的内容压缩成一个小的表示编码,它还有一个内存组件,可根据历史信息预测未来的编码, agent最后还有一个决策组件,它仅根据其视觉和内存组件创建的表示来决定要采取的动作。

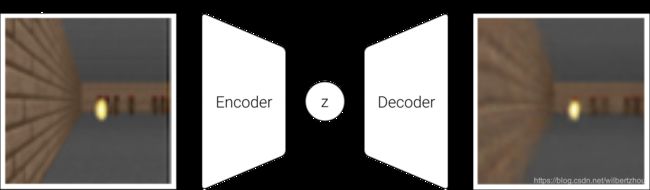

VAE(V)模型

环境为agent在每个时间步提供高维输入观察,该输入通常是2D图像帧,它是视频序列的一部分。V模型的作用是学习每个观察到的输入帧的抽象压缩表示。

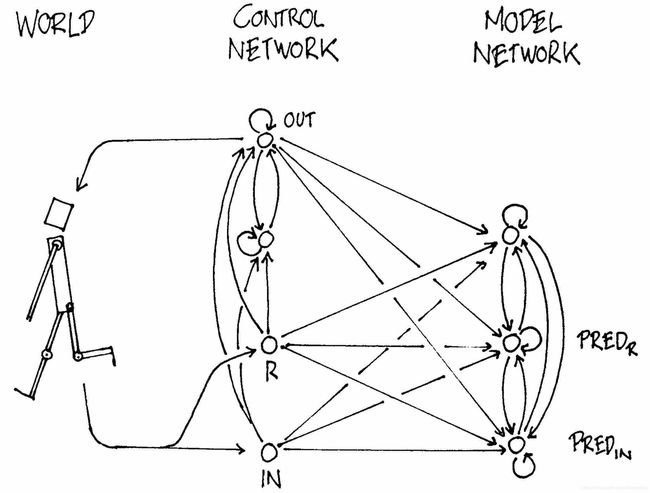

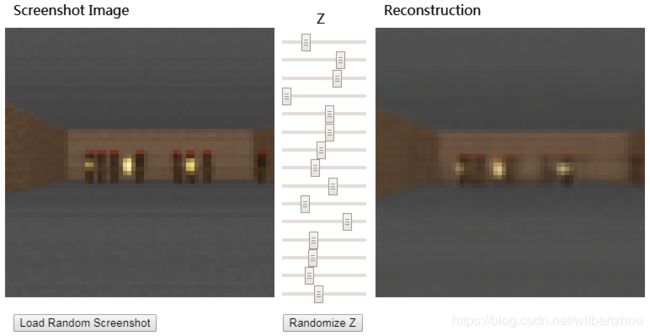

使用变分自动编码器(VAE) [31,32]作为我们实验中的V模型。在下面的演示中,我们将展示V模型如何把它在时间步t接收的每个帧压缩成低维潜向量![]() ,该压缩表示可用于重建原始图像。

,该压缩表示可用于重建原始图像。

标VAE接受了从VizDoom[33,34]获得的屏幕截图的训练环境。您可以加载随机选择的屏幕截图,将其编码为一个小的潜向量z,用于重建原始屏幕截图,您还可以尝试使用滑块调整z矢量值来查看它如何影响重建,或随机化z观察VAE学习的屏幕截图的空间

标VAE接受了从VizDoom[33,34]获得的屏幕截图的训练环境。您可以加载随机选择的屏幕截图,将其编码为一个小的潜向量z,用于重建原始屏幕截图,您还可以尝试使用滑块调整z矢量值来查看它如何影响重建,或随机化z观察VAE学习的屏幕截图的空间

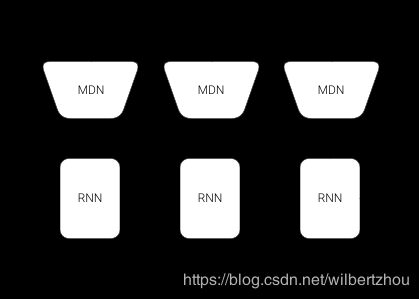

MDN-RNN(M)模型

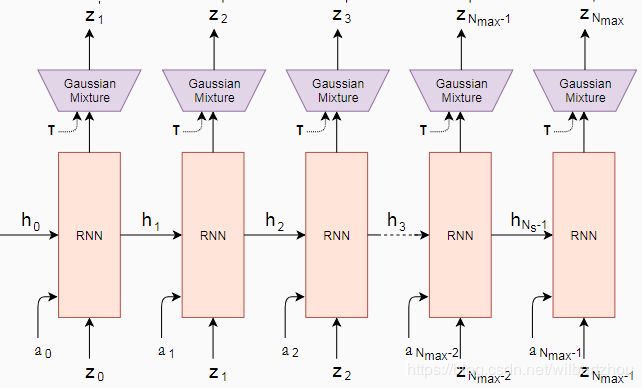

虽然V模型的作用是压缩agent在每个时间帧看到的内容,但我们也希望压缩随时间发生的事情,为此,M模型的作用是预测未来,M模型作为V期望将产生的未来z向量的预测模型。由于许多复杂环境本质上是随机的,我们训练RNN输出概率密度函数p(z)而不是z的确定性预测。

在我们的方法中,我们近似p(z)作为高斯分布的混合,并且向它提供当前和过去的信息以训练RNN输出下一个潜向量![]() 的概率分布。

的概率分布。

更具体地说,RNN将进行建模 ![]() ,在这里at是在t时间采取的动作,

,在这里at是在t时间采取的动作,![]() 是在t时间RNN的隐藏状态。在采样过程中,我们可以调整温度参数τ来控制模型的不确定性,如同在[35]中那样 - 我们以后会说明调整

是在t时间RNN的隐藏状态。在采样过程中,我们可以调整温度参数τ来控制模型的不确定性,如同在[35]中那样 - 我们以后会说明调整 ![]() 对训练控制器非常有用。

对训练控制器非常有用。

这种方法称为结合RNN(MDN-RNN) [39,40]的混合密度网络 [37,38] ,并且已成功用于序列生成问题,例如生成手写字[39,41] 和草图 [35]。

控制器(C)模型

控制器(C)模型负责确定要采取的行动的过程,以便在环境的rollout过程中最大化agent的预期累积奖励。在我们的实验中,我们故意使C尽可能简单和小,并且与V和M分开训练,因此agent的大部分复杂性都存在于世界模型(V和M)中。

C是在每个时间步直接映射zt和ht到动作at的简单单层线性模型:

![]()

在这个线性模型中, ![]() 和

和![]() 是权重矩阵和偏置向量,映射级联输入向量

是权重矩阵和偏置向量,映射级联输入向量![]() 到输出动作

到输出动作![]() 。3

。3

把一切都放在一起

以下流程图说明了V、M和C如何与环境交互:

Agent模型的流程图。在每个时间步t首先由V处理原始观察生成zt,在每个时间步输入到C中的是这个潜向量z级联M的隐藏状态ht,然后C将输出一个动作向量at用于行动控制,之后M将获取当前zt和动作at作为输入来更新其自己的隐藏状态,以便在时间t+1时产生ht+1

Agent模型的流程图。在每个时间步t首先由V处理原始观察生成zt,在每个时间步输入到C中的是这个潜向量z级联M的隐藏状态ht,然后C将输出一个动作向量at用于行动控制,之后M将获取当前zt和动作at作为输入来更新其自己的隐藏状态,以便在时间t+1时产生ht+1

下面是agent模型用于OpenAI Gym环境中的伪代码 [28]。在给定的控制器C 上运行此函数将在环境的rollout过程中返回累积奖励。

def rollout(controller):

''' env, rnn, vae are '''

''' global variables '''

obs = env.reset()

h = rnn.initial_state()

done = False

cumulative_reward = 0

while not done:

z = vae.encode(obs)

a = controller.action([z, h])

obs, reward, done = env.step(a)

cumulative_reward += reward

h = rnn.forward([a, z, h])

return cumulative_rewardC的这种最小设计也带来了重要的实际好处。深度学习的进步为我们提供了有效训练大型复杂模型的工具,前提是我们可以定义一个表现良好且可微的损失函数。我们的V和M模型设计可使用现代GPU加速器基于反向传播算法进行高效地训练,因此我们希望模型的大部分复杂性和模型参数驻留在V和M中。使用线性模型,C的参数数量相比之下是最小的,这个选择使我们能够探索更多非传统的方法来训练C - 例如,甚至使用进化策略(ES)[42,43,44] 应对更具挑战性的RL任务以解决信用分配的难题。

为了优化C的参数,我们选择了协方差矩阵自适应进化策略(CMA-ES) [45,46,44]作为我们的优化算法,因为已知它可以很好地适用于高达几千个参数的解空间。我们在一台多CPU核心并行运行多个rollout环境的机器上进化C的参数。

有关我们实验中使用的模型、训练过程和环境的更多具体信息,请参阅附录。

赛车实验:世界模型的特征提取

一个预测性的世界模型可以帮助我们提取有用的空间和时间表示。通过使用这些特征作为控制器的输入,我们可以训练一个紧凑且最小的控制器来执行一系列连续控制任务,例如学习从像素输入驱动自上而下的赛车环境[47]。在本节中,我们将描述如何训练前面描述的agent模型来解决赛车任务。据我所知,我们的agent是第一个达到解决此任务所需分数的已知解决方案。4

在这种环境中,每个试验都会随机生成跑道,agent会在最短的时间内尽可能多地跑过赛道。Agent控制三个连续动作:左/右转向,加速和制动。

为了训练我们的V模型,我们首先收集10,000个环境的随机场景的数据集。首先有一个agent随机行动,多次探索环境,并记录随机采取的动作at及从环境中得到的观察结果5。我们使用这个数据集训练V来学习每个帧观察到的潜空间,通过最小化给定帧与解码z产生的帧的重建版本之间的差异,训练VAE将每帧编码成低维潜向量z。以下演示显示了训练后的VAE结果:

现在可以使用我们训练的V模型来预处理每个时间t的帧输出zt用于训练我们的M模型。使用此预处理数据以及记录采用的随机动作![]() , MDN-RNN现在可以训练出作为一个高斯混合的模型

, MDN-RNN现在可以训练出作为一个高斯混合的模型![]() 。6

。6

在该实验中,世界模型(V和M)不知道来自环境的实际奖励信号,它的任务是简单地压缩和预测观察到的图像帧序列,只有控制器(C)模型可以访问来自环境的奖励信息。由于线性控制器模型中仅有867个参数,因此诸如CMA-ES之类的进化算法非常适合此优化任务。

下图比较了实际给予agent的观察结果和世界模型所捕获的观察结果。我们可以在每个时间步基于VAE使用z重建每个帧用以可视化一个rollout中agent实际看到的信息质量:

过程

总结赛车实验,下面是过程的步骤:

- 从随机策略中收集10,000个rollout。

- 训练VAE (V)编码每个帧为一个潜向量

。

。 - 训练MDN-RNN (M)输出

。

。 - 为每个rollout进化控制器(C)以最大化预期累积奖励。

| 模型 |

参数数量 |

| VAE |

4,348,547 |

| MDN-RNN |

422,368 |

| Controller |

867 |

赛车实验结果

仅V模型

如果我们对观察有良好的表现,那么训练agent开车并不是一项艰巨的任务。以前的工作[48,49,50]已经证明,通过一系列经观察的人工特征信息,如激光雷达信息、角度、位置和速度,人们可以轻松训练一个小型前馈网络,以采取这种人工特征输入并输出令人满意的导航策略。出于这个原因,我们首先想要通过设置C来测试agent只能访问V但不能访问M,所以我们将控制器定义为![]() 。

。

虽然agent仍然可以在此设置中导航赛道,但我们注意到它在左右摆动并且错过了弯度很小的赛道,这个有缺陷的agent在跑过100个随机跑道后平均得分为632 ± 251分,与OpenAI Gym排行榜上采用传统的Deep RL方法的其他agent的表现一致[47] ,如A3C [51,52]。向C的策略网络添加隐藏层有助于将结果提高到788 ± 141,但还不足以完美解决这个环境。

完整世界模型(V和M)

只在某一时刻捕获表示的V模型提供的zt表示,没有多少太大的预测能力,相比之下,M训练后预测![]() 做得很好。由于M 对

做得很好。由于M 对![]() 的预测是在t时刻从RNN的隐藏状态ht产生的,此向量是我们可以为agent提供的一组学习特征的良好候选者。结合zt与ht提供给控制器C当前的观察和未来期望的一个很好的表示。

的预测是在t时刻从RNN的隐藏状态ht产生的,此向量是我们可以为agent提供的一组学习特征的良好候选者。结合zt与ht提供给控制器C当前的观察和未来期望的一个很好的表示。

实际上,我们看到允许agent访问zt和ht大大提高了其驾驭的能力,驾驶更稳定,并且agent能够有效地跑过弯道。此外,我们看到,在汽车比赛中做出这些快速反应驾驶决策时,agent不需要提前计划并推进未来的假设情景。由于ht包含有关未来的概率分布信息,agent可以直接查询RNN本能地对其行动做出决定,像经验丰富的一级方程式赛车手或前面讨论的棒球运动员一样,agent可以本能地预测何时何地在当前环境中飞驰。

| 方法 |

跑完100个随机跑道后的平均分数 |

| DQN [53] |

343 ± 18 |

| A3C (连续) [52] |

591 ± 45 |

| A3C (离散) [51] |

652 ± 10 |

| Ceobillionaire算法 (未发布) [47] |

838 ± 11 |

| 仅V模型,输入z |

632 ± 251 |

| 仅V模型,输入z,具有一个隐藏层 |

788 ± 141 |

| 完整世界模型,z 和h |

906 ± 21 |

跑完100个随机跑道后我们的Agent得分可达到906 ± 21分,有效解决了任务,并获得了前所未有的成绩。以前的尝试[51,52] 使用传统的Deep RL方法获得平均分数为591-652的范围,在排行榜上获得最佳的解决方案 [47]的是,在经过100个随机连续跑道后获得了838 ± 11的平均分。传统的Deep RL方法通常需要对每个帧进行预处理,例如采用边缘检测[52],除此之外在输入中堆叠几个最近的帧 [51,52]。相比之下,我们的世界模型采用原始RGB图像像素流并直接学习空间 - 时间表示。据我所知,我们的方法是第一个声称解决此任务的解决方案。

赛车梦想

由于我们的世界模型能够为未来建模,它自己也能够构造出假设的赛车场景。我们可以让它产生给定的当前状态![]() 的概率分布,采样一个

的概率分布,采样一个![]() 并使用该样本作为真正的观察。我们可以将训练好的C重新置于由M生成的梦境中,以下演示展示了我们的世界模型如何用于生成赛车环境:

并使用该样本作为真正的观察。我们可以将训练好的C重新置于由M生成的梦境中,以下演示展示了我们的世界模型如何用于生成赛车环境:

Agent在自己的梦想世界里开车。在这里,我们将训练好的策略部署到由MDN-RNN生成的虚拟环境中,并使用VAE的解码器进行渲染。您可以通过点击屏幕的左侧或右侧,或通过按箭头键(左/右转向,上/下加速或制动)来取代agent的操作,也可以通过滑动右下方的滑块改变τ值来调整环境的不确定性水平

Agent在自己的梦想世界里开车。在这里,我们将训练好的策略部署到由MDN-RNN生成的虚拟环境中,并使用VAE的解码器进行渲染。您可以通过点击屏幕的左侧或右侧,或通过按箭头键(左/右转向,上/下加速或制动)来取代agent的操作,也可以通过滑动右下方的滑块改变τ值来调整环境的不确定性水平

我们刚刚看到,在真实环境中学到的策略似乎在梦境中起到作用。这就引出了一个问题 - 我们能否训练agent在自己的梦境中学习,并将这一策略迁移到实际环境?

VizDoom实验:在梦境中学习

如果我们的世界模型对于其目标足够准确,并且足够完美地解决手头的问题,我们应该能够用这个世界模型替换实际环境,毕竟,agent不直接观察现实世界,而只看到世界模型让它看到的东西。在这个实验中,我们在梦想环境中训练一个agent,该agent由其训练的世界模型生成,以模仿VizDoom[33] 环境。

Agent必须学会躲避从房间另一侧的怪物射击的火球,火球唯一目的是杀死agent。在此环境中没有明确的奖励,因此为了模仿自然选择,累积奖励可以定义为agent在前进中保持活着的时间步数。环境中的每个rollout最多运行2100个时间步长(〜 60秒),并且如果超过100个连续的rollout的平均存活时间大于750的时间步(~ 20秒)[34],则视为该任务完成。

过程

除了一些关键的差异,VizDoom实验的设置与赛车任务大致相同,在赛车任务中,M仅仅被训练为下一个![]() 建模。由于我们想要构建一个其中可以训练agent的世界模型,因此这里M模型将预测agent是否在下一帧中死亡(作为二元事件donet,或简称

建模。由于我们想要构建一个其中可以训练agent的世界模型,因此这里M模型将预测agent是否在下一帧中死亡(作为二元事件donet,或简称![]() ),除了下一帧

),除了下一帧![]() 。

。

由于M模型可以预测除了下一个可观察的done状态,我们现在有了一个完整的RL环境所需的要素。如果有一个真正的Gym环境,我们首先通过包装一个gym.Env [28] 接口在M模型之上构建一个OpenAI Gym环境,然后在这个虚拟环境内训练agent,而不是使用实际环境。

在此模拟中,我们不需要V模型在幻想过程中编码任何真实像素帧,因此agent将完全仅在潜空间环境中训练,这具有许多优点,将在后面讨论。

此虚拟环境具有与真实环境相同的接口,因此在agent在虚拟环境中学到满意的策略后,我们可以轻松地将此策略部署回实际环境,以查看策略迁移的情况。

总结Take Cover实验,下面是采取的步骤:

- 从随机策略中收集10,000个rollout。

- 训练VAE(V)将每帧编码成潜向量

,并使用V把由式(1)所收集的图像转换成潜空间表示。

,并使用V把由式(1)所收集的图像转换成潜空间表示。 - 训练MDN-RNN(M)建模

。

。 - 进化控制器(C)最大化虚拟环境中的预期生存时间。

- 使用(4)中学到的策略应用到实际的Gym环境。

| 模型 |

参数数量 |

| VAE |

4,446,915 |

| MDN-RNN |

1,678,785 |

| Controller |

1,088 |

在梦境中训练

经过一些训练后,控制器学会在梦境中导航,并躲避由M模型生成的怪物发起的致命火球。Agent在这个虚拟环境中取得了〜 900时间步的成绩。

下面的demo展示了agent如何在自己的梦境中导航。M模型学会生成向agent方向射击火球的怪物,而C模型发现躲避这些火球的策略。这里,V模型仅用于解码潜向量![]() ,其由M制作成一个我们可以观察到的像素图像序列:

,其由M制作成一个我们可以观察到的像素图像序列:

在这里,我们基于RNN的世界模型经过训练,可以模仿程序员设计的完整游戏环境。仅仅通过从随机剧集中收集的原始图像数据中学习,它可以学会如何模拟游戏的基本方面 - 例如游戏逻辑、敌人行为、物理以及3D图形渲染。

例如,如果agent选择左侧动作,则M模型学习将agent移动到左侧并相应地调整其游戏状态的内部表示。如果agent试图向任一方向移动太远,它还学会阻止agent移动到关卡两侧的墙壁之外。偶尔,M模型需要跟踪从几个不同的怪物射击的多个火球,并沿着预定的方向连贯地移动它们,同时它还必须检测agent是否已被其中一个火球杀死。

然而,与实际游戏环境不同,我们注意到可能会在虚拟环境中增加额外的不确定性,从而使游戏在梦境中更具挑战性。如在[35]中完成的一样,在![]() 采样过程中,我们可以通过提高温度τ参数来做到这一点。通过增加不确定性,与实际环境相比,我们的梦想环境变得更加困难,火球可以在更不可预测的路径中随机移动。有时候,agent甚至可能因为纯粹的不幸而死亡,没有任何解释。

采样过程中,我们可以通过提高温度τ参数来做到这一点。通过增加不确定性,与实际环境相比,我们的梦想环境变得更加困难,火球可以在更不可预测的路径中随机移动。有时候,agent甚至可能因为纯粹的不幸而死亡,没有任何解释。

我们发现在较高温度设置下表现良好的agent通常在正常设置下表现更好。事实上,增加τ有助于防止控制器利用世界模型的缺陷 - 我们将在稍后更深入地讨论这个问题。

将策略迁移到实际环境

我们在虚拟环境中对agent进行了训练,并在原始VizDoom方案中测试了其性能。超过100个随机连续试验的得分是~ 1100个时间步,远远超过750个时间步的所需分数,也远高于在更困难的虚拟环境中获得的分数。7

我们看到即使V模型无法正确捕获每个帧的所有细节,例如,正确数量的怪物,agent仍然能够使用学习的策略在真实环境中导航。由于虚拟环境甚至无法跟踪怪物的确切数量,因此能够在嘈杂且不确定的虚拟构想环境中生存的agent,在原始、纯净的环境中将更加健壮。

欺骗世界模型

在童年时代,我们可能已经遇到过以原始游戏设计者意想不到的方式玩视频游戏 [54],玩家会发现收集无限生命或健康的方法,并且通过利用这些漏洞,他们可以轻松完成一场难以驾驭的游戏。然而,在这样做的过程中,他们可能丧失了学习游戏设计者所预期的掌握游戏所需技能的机会。在我们最初的实验中,我们注意到我们的agent发现了一种对抗策略,以这种方式移动,以便在M管理的虚拟环境中的怪物在某些对局期间从不射击任何火球。即使有火球形成的迹象,agent也会以扑灭火球的方式移动。

因为M只是环境的近似概率模型,所以它偶尔会产生不遵循实际环境规律的轨迹。正如我们之前所指出的那样,即使在实际环境中房间另一侧的怪物数量也没有被M完全复制,因此,我们的世界模型将被C利用,即使这些漏洞不存在于实际环境。

由于使用M为agent生成虚拟环境,我们还让控制器访问M的所有隐藏状态。这实质上是授予我们的agent访问游戏引擎的所有内部状态和内存的权限,而不仅仅是玩家可以看到的游戏场面。因此,agent可以有效地探索直接操纵游戏引擎的隐藏状态的方法,以最大化其预期的累积奖励。在学习动力学模型中学习策略的这种方法的弱点在于agent可以轻松找到可以欺骗动力学模型的对抗策略 - 它会在我们的动力学模型中找到一个看起来很好的策略,但是会在实际环境中失效,通常因为它访问了造成模型错误的状态,因为它远离了训练分布。

这个弱点可能是许多以前研究RL环境动力学模型的工作中,实际上并没有使用这些模型来完全取代实际环境的原因 [55,56]。就像在M中提出的模型一样[20,21,22],动力学模型是确定性的,如果它不完美,它就很容易被agent利用。使用贝叶斯模型,如PILCO[57],有助于在一定程度上用不确定性估计来应对这个问题,然而,它们并没有完全解决问题。最近的工作[58] 通过首先使用学习策略初始化策略网络,将基于模型的方法与传统的无模型RL训练相结合,但必须随后依靠无模型方法在实际环境中微调此策略。

为了使我们的C更难以利用M的缺陷,我们选择使用MDN-RNN作为实际环境中可能产生的结果分布的动力学模型,而不是仅仅预测确定性的未来。即使实际环境是确定性的,MDN-RNN实际上也将其近似为随机环境。这样做的好处是可以让我们在任何环境的更随机版本中训练C - 我们可以简单地调整温度参数τ控制M中的随机性,从而控制现实主义和可利用性之间的权衡。

考虑到用VAE模型编码的潜空间只是单个对角高斯分布,使用高斯模型的混合可能看起来有点过度。然而,混合密度模型中的离散模式对于具有随机离散事件的环境是有用的,例如怪物是否决定射击火球或保持原地不动。虽然单个对角高斯可能足以编码单个帧,但具有混合密度输出层的RNN使得更容易在具有离散随机状态的更复杂环境下建模逻辑。

例如,如果我们将温度参数设置为非常低的值![]() ,使用与确定性LSTM几乎相同的M有效地训练C,由于模式失效,这个生成的环境中无论agent做什么,怪物都无法射击火球。在形成和射击火球的高斯混合模型中,M不能转换到另一种模式。无论在这个产生的环境中学到什么策略,大部分时间都会达到2100的完美分数,但是当应用到实际世界的残酷现实中时,显然会失败,甚至在随机策略中也表现不佳。

,使用与确定性LSTM几乎相同的M有效地训练C,由于模式失效,这个生成的环境中无论agent做什么,怪物都无法射击火球。在形成和射击火球的高斯混合模型中,M不能转换到另一种模式。无论在这个产生的环境中学到什么策略,大部分时间都会达到2100的完美分数,但是当应用到实际世界的残酷现实中时,显然会失败,甚至在随机策略中也表现不佳。

在下面的演示中,我们展示了即使是![]() 的低值,仍会使MDN-RNN难以产生火球:

的低值,仍会使MDN-RNN难以产生火球:

通过把温度![]() 作为M的可调参数,我们可以看到C在具有不同不确定性水平的虚拟环境中的训练效果,并看看它们如何迁移到实际环境中。我们尝试试验不同τ参数的虚拟环境,在此虚拟环境中训练agent,并在实际环境中观察其性能。

作为M的可调参数,我们可以看到C在具有不同不确定性水平的虚拟环境中的训练效果,并看看它们如何迁移到实际环境中。我们尝试试验不同τ参数的虚拟环境,在此虚拟环境中训练agent,并在实际环境中观察其性能。

| 温度 |

在虚拟环境中的分数 |

在实际环境中的分数 |

| 0.10 |

2086 ± 140 |

193 ± 58 |

| 0.50 |

2060 ± 277 |

196 ± 50 |

| 1.00 |

1145 ± 690 |

868 ± 511 |

| 1.15 |

918 ± 546 |

1092 ± 556 |

| 1.30 |

732 ± 269 |

753 ± 139 |

| 随机策略基准 |

N/A |

210 ± 108 |

| Gym排行榜[34] |

N/A |

820 ± 58 |

在上表中,虽然我们看到增加 M的![]() 参数使得C更难以找到对抗性策略,但增加太多会使虚拟环境难以让agent学习任何东西,因此在实践中它是我们可以调整的超参数。温度也会影响agent发现的策略类型,例如,尽管

参数使得C更难以找到对抗性策略,但增加太多会使虚拟环境难以让agent学习任何东西,因此在实践中它是我们可以调整的超参数。温度也会影响agent发现的策略类型,例如,尽管![]() 获得了最佳分数1092± 556,增加τ到1.30时导致较低的分数,但同时风险较小的策略具有较低的回报方差。相比之下,报告中得分最好[34]的是820± 58。

获得了最佳分数1092± 556,增加τ到1.30时导致较低的分数,但同时风险较小的策略具有较低的回报方差。相比之下,报告中得分最好[34]的是820± 58。

迭代训练过程

在我们的实验中,任务相对简单,因此可以使用从随机策略收集的数据集来训练合理的世界模型。但是,如果我们的环境变得更加复杂呢?在任何困难的环境中,只有在了解了如何航行于世界的策略之后,才能使得agent探索世界的某个区域。

对于更复杂的任务,需要迭代训练过程。我们需要agent能够探索它的世界,并不断收集新的观察结果,以便随着时间的推移改进和完善其世界模型。一个迭代的训练过程,是一个不断适应学习如何思考 [27] 的过程:

- 使用随机模型参数初始化M,C。

- 在实际环境rollout N次,agent可以在rollout 期间学习,并保存所有操作at和观察xt到存储设备。

- 训练M输出模型

,训练C优化预期的M内部奖励

,训练C优化预期的M内部奖励 - 如果任务尚未完成,请返回(2)。

我们已经证明,这个训练循环一次迭代足以解决简单的任务。对于更复杂的任务,我们需要步骤2中的控制器积极探索环境区域,这有利于改善其世界模型。一个令人兴奋的研究方向是研究如何在agent中结合人类好奇心、内在动机[59,60,61,62,63] 和信息搜索能力 [64,65] ,以鼓励创新的探索能力 [66]。特别是,我们可以基于压缩质量方面的改进来增强奖励功能[59,60,61,27]。

来自像素的Swing-up Pendulum:在第一次迭代后生成的rollout。由于从初始随机策略收集的数据接近下半部分的稳定状态,因此M难以预测摆动杆的状态,尽管如此,当M部署在M内部时,C仍然学会向上摆动杆

来自像素的Swing-up Pendulum:在第一次迭代后生成的rollout。由于从初始随机策略收集的数据接近下半部分的稳定状态,因此M难以预测摆动杆的状态,尽管如此,当M部署在M内部时,C仍然学会向上摆动杆

来自像素的Swing-up Pendulum:在20次迭代后生成的rollout。部署在实际环境中向上摆动杆的策略收集了更多数据,这些数据记录了杆处于上半部分,使得M更准确地建模环境,并且C在M内部学习到更好的策略

来自像素的Swing-up Pendulum:在20次迭代后生成的rollout。部署在实际环境中向上摆动杆的策略收集了更多数据,这些数据记录了杆处于上半部分,使得M更准确地建模环境,并且C在M内部学习到更好的策略

在本方法中,由于M是MDN-RNN,其建模下一帧的概率分布,如果它做得不好,则意味着agent已经遇到了它不熟悉的世界的部分。因此,我们可以调整和重用M的训练损失函数来鼓励好奇心。通过在实际环境中转变M的损失函数的符号,将鼓励agent探索不熟悉的世界部分,它收集的新数据可能会改善世界模型。

迭代训练过程要求M模型不仅预测下一个观察x和done,也预测用于下一时间步的动作和奖励,这可能是更复杂的任务所必需的。例如,如果agent需要学习复杂的运动技能来探索其环境,世界模型将学习模仿自己已经学会走路的C模型。在艰难的运动技能(例如步行)被吸收到具有大容量的大型世界模型之后,较小的C模型可以依赖于已经被世界模型吸收的运动技能并且专注于学习更高级技能,以使用它已经学会了的运动技能来导航。8

与神经科学文献有趣的联系是关于海马重播(hippocampal replay)的工作,该研究探讨了当动物休息或睡觉时大脑如何重现最近的经历,重现最近的经历在记忆巩固中起着重要作用[68] - 海马依赖的记忆在一段时间内独立于海马体 [67]。正如福斯特[68]所说,重播“不像做梦,更像是思考”。我们推荐读者阅读Replay Comes of Age [68],它从神经科学的角度详细阐述了重播,并与理论强化学习相关联。

迭代训练可以让C-M模型开发出一种自然的分层学习方式。最近有关RL中自我游戏(self-play)的作品[69,70,71] ,及PowerPlay [72,73] 探索了导致自然课程学习(natural curriculum learning)的方法 [74],我们认为这是强化学习中更令人兴奋的研究领域之一。

相关工作

有大量关于学习动力学模型的文献,并使用该模型来训练策略。20世纪80年代首次探索了许多概念用于前馈神经网络(FNN)[18,75,76,77,78] 并在20世纪90年代用于RNN [20,21,22,26],为学习思考奠定了一些基础 [27]。最近的PILCO[57,79,80]是一种基于概率模型的搜索策略方法,旨在解决困难的控制问题。使用从环境中收集的数据,PILCO使用高斯过程(GP)模型来学习系统动力学模型,然后使用该模型对许多轨迹进行采样,以训练控制器执行所需的任务,例如摆动摆锤,或乘坐独轮车。

虽然高斯过程适用于一小组低维数据,但是它们的计算复杂性使得它们难以扩展以模拟高维观察的大量历史数据。最近的其他作品[81,82]使用贝叶斯神经网络代替GP来学习动力学模型,这些方法已经在具有挑战性的控制任务[83]中崭露头角,其中状态是已知的并且定义明确,并且观察的维度相对较低。在这里,我们感兴趣的是从高维视觉数据观察到的动力学模型,其中我们的输入是原始像素帧序列。

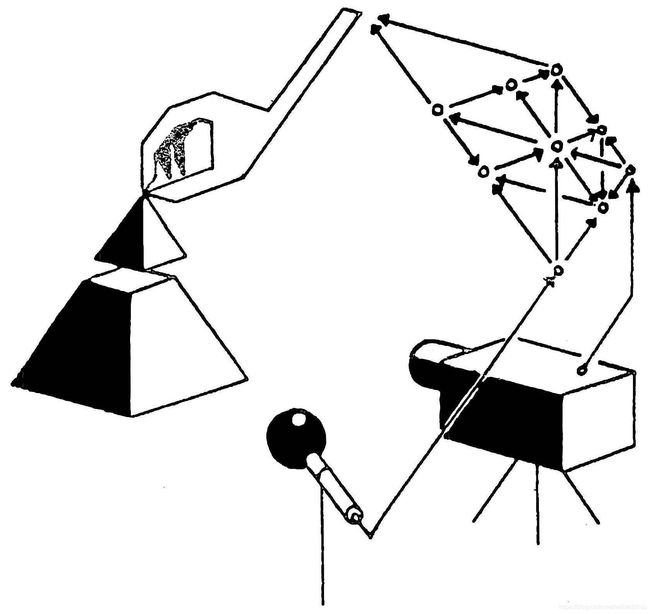

在机器人控制应用中,通过仅观察基于摄像机的视频输入来学习系统动态的能力是一个具有挑战性但重要的课题。关于主动视觉的RL的早期工作内容是训练FNN,其采用视频序列的当前图像帧来预测下一帧[84],并使用这个预测模型来训练中央凹转移(fovea-shifting)控制网络,试图在视觉场景中找到目标。为了解决训练动力学模型以直接从高维像素图像学习的困难,研究人员探索了使用神经网络来首先学习视频帧的压缩表示。最近的工作沿着这些方向[85,86]能够使用自动编码器的瓶颈隐藏层(bottleneck hidden layer)作为低维特征向量来训练控制器,以控制来自像素输入的钟摆,从压缩的潜空间学习动力学模型使RL算法更加有效[87,88,89]。我们推荐读者观看Finn关于基于模型的RL的讲座[89] 了解更多相关内容。

作为新想法的试验平台,视频游戏环境在基于模型的RL研究中也很受欢迎。Guzdial等[90]使用前馈卷积神经网络(CNN)来学习视频游戏的前向仿真模型,学习预测不同行为如何影响环境中的未来状态并且对于玩游戏的agent是有用的,因为如果我们的agent能够根据其当前状态和动作预测将来会发生什么,它可以简单地选择适合其目标的最佳动作。这不仅在早期工作中得到证实[78,84] (当时计算比现在贵一百万倍),而且最近在几个有竞争力的VizDoom [33] 环境上的研究 [91]也得到有力说明。

上述作品使用FNN来预测下一个视频帧。我们可能希望使用可以捕获更长期的时间依赖性的模型,RNN是适用于序列建模的强大模型[39]。在一个名为Hallucination with RNNs的演讲中 [92],Graves展示了RNN学习Atari游戏环境概率模型的能力,他训练了RNN来学习这种游戏的结构,然后表明他们可以自己产生类似游戏等级的幻觉。

早在1990年,一篇名为“ 让世界变得与众不同”的论文[20]就探索了使用RNN来开发内部模型以推断未来,然后在作品[21,22,26]中得到了进一步研究。最近的一篇名为“ 学习思考”的论文 [27]提出了一个统一的框架,用于构建基于RNN的一般问题解决方案,该解决方案可以学习其环境的世界模型,并学习使用该模型推断未来。后续工作使用基于RNN的模型在未来生成许多帧[56,55,93],其作为推理未来的内部模型 [94,95,96]。

在这项工作中,我们使用进化策略(ES)来训练控制器,因为它提供了许多益处。例如,我们只需要为优化器提供最终的累积奖励,而不是整个历史记录;ES也很容易并行化 - 我们在很多worker中可以启动许多具有不同解决方案的rollout实例,并快速并行地计算一组累积奖励。最近的作品[97,98,99,100] 已经证实,ES是许多强基准任务中传统深度RL方法的可行替代方案。

在深度RL方法普及之前 [101]基于进化的算法已被证明可有效地找到RL任务的解决方案 [102,103,104,105,106,107],基于进化的算法甚至能够从高维像素输入中解决困难的RL任务[108,109,110]。最近的作品[111] 还结合了VAE和ES,这与我们的方法类似。

讨论

我们已经证明了训练agent完全可在其模拟的潜空间世界中执行任务的可能性。这种方法提供了许多实际好处,例如,视频游戏引擎通常需要大量计算资源来将游戏状态渲染成图像帧,或者计算与游戏不直接相关的物理模型。我们可能不想在实际环境中浪费循环训练agent的时间,而是在模拟环境中多次训练agent,不断地训练以模拟真实环境的agent可以证明对于将策略迁移回真实世界是有用的,我们的方法可以补充以前作品中讲述的sim2real方法[112,113]。

此外,我们可以利用深度学习框架,在分布式环境中使用GPU加速我们的世界模型的模拟。将世界模型作为完全可微分的递归计算图实现的好处也意味着我们可以使用反向传播算法直接在梦境中训练agent,以微调其策略用于最大化目标函数[20,21,22]。

将V作为VAE实施并将其作为独立模型进行训练的选择也有其局限性,因为它可能编码与任务无关的部分观测值。毕竟,根据定义,无监督学习不能知道什么对手头的任务有用。例如,我们的VAE在Doom环境中的侧壁上复制了不重要的详细砖瓦图案,但未能在赛车环境中重现与道路相关的任务相关图块。通过与预测奖励的M一起训练,VAE可以学习专注于图像的任务相关区域,但是这里的权衡是我们可能无法在不进行再训练的情况下有效地重用VAE用于新任务。学习任务相关的特征也与神经科学有关[114],当接收到奖励时,初级感觉神经元从抑制中被释放,这表明它们通常学习任务相关的特征,而非任何其它特征,至少在成年期[114]是这样。

另一个问题是我们的世界模型的能力有限。虽然现代存储设备可以存储迭代训练过程中生成的大量历史数据,但基于LSTM[115,116]的世界模型可能无法将所有记录的信息存储在其权重连接中。虽然人类的大脑可以在几十年甚至几百年的记忆中保持一定的记忆[117],但我们用反向传播训练的神经网络却具有有限的能力,并遭受诸如灾难性遗忘等问题 [118,119,120]的困扰。如果我们希望agent学习探索更复杂的世界,未来的工作将探索用更高容量的模型取代VAE和MDN-RNN[121,122,123,124,125],或包含外部存储器模块 [126]。

像早期基于RNN的C-M系统一样 [20,21,22,26],我们逐个时间步地模拟可能的未来,而不会从类似人的层次规划或抽象推理中获利,这往往忽略了无关的时空细节。但是,更通用的学习思考 [27]方法不仅限于这种相当原始的方法,相反,它允许循环C学习解决循环M的“子程序”,并以任意可计算的方式重用它们以解决问题,例如,通过分层规划或其它利用M类似程序的权重矩阵部分的方法。最近的One Big Net [127] C-M方法的扩展将C和M叠加成一个网络,并使用类似PowerPlay的方法 [72,73] 进行行为重放(将教师网的行为压缩成学生网 [128]),在学习新知识时避免忘记旧的预测和控制技能,这些更通用的方法的实验留待将来解决。

如果您想讨论任何问题或提供反馈,请访问此页面的GitHub存储库以获取更多信息。

致谢

我们要感谢Blake Richards,Kory Mathewson,Kyle McDonald,Kai Arulkumaran,Ankur Handa,Denny Britz,Elwin Ha和Natasha Jaques对本文的深思熟虑的反馈,并从他们的专业领域提供宝贵的观点和见解。

本文中的交互式演示都是使用p5.js构建的,使用deeplearn.js可以在Web浏览器中部署所有这些机器学习模型,基于一个由Google的People + AI Research Initiative(PAIR)团队开发的用于浏览器的硬件加速机器学习框架。特别感谢Nikhil Thorat和Daniel Smilkov的支持。

我们要感谢Chris Olah和Distill编辑团队的其他成员提供的宝贵意见和慷慨的编辑支持,以及使用他们的distill.pub技术及支持。

我们要感谢Alex Graves,Douglas Eck,Mike Schuster,Rajat Monga,Vincent Vanhoucke,Jeff Dean和Google Brain团队提供有用的反馈,并鼓励我们探索这一研究领域。

这里的任何错误都是我们自己的,并非因为我们的校对员和同事的意见,如果您发现错误或想要建议更改,请随时通过参与本文的讨论论坛来提供反馈。

本文中的实验是在使用TensorFlow和OpenAI Gym的Google Cloud Platform提供的P100 GPU和64核CPU Ubuntu Linux虚拟机上进行的。

引文

对于学术背景下的归属,请如下引用此作品

Ha和Schmidhuber,“循环世界模式促进策略进化”,2018年。BibTeX引用

@incollection{ha2018worldmodels,

title = {Recurrent World Models Facilitate Policy Evolution},

author = {Ha, David and Schmidhuber, J{\"u}rgen},

booktitle = {Advances in Neural Information Processing Systems 31},

pages = {2451--2463},

year = {2018},

publisher = {Curran Associates, Inc.},

url = {https://papers.nips.cc/paper/7512-recurrent-world-models-facilitate-policy-evolution},

note = "\url{https://worldmodels.github.io}",

}开源代码

此处提供了此论文中实验的说明。

重用

除非另有说明,否则图表和文本均在知识共享署名CC-BY 4.0下获得许可,其源代码可在GitHub上获得。从其他来源重复使用的数字不属于本license,可以通过其标题中的引用来识别。

附录

在本节中,我们将更详细地描述本论文中使用的模型和训练方法。

变分自动编码器

我们训练了一个卷积变分自动编码器(ConvVAE)模型作为agent的V,与香草自动编码器不同,在潜向量上强制执行高斯先验![]() ,同时也限制了用于压缩每个帧的信息容量的数量,但这种高斯先验也使得世界模型相对于由M产生的不切实际的

,同时也限制了用于压缩每个帧的信息容量的数量,但这种高斯先验也使得世界模型相对于由M产生的不切实际的![]() 向量更稳健

向量更稳健

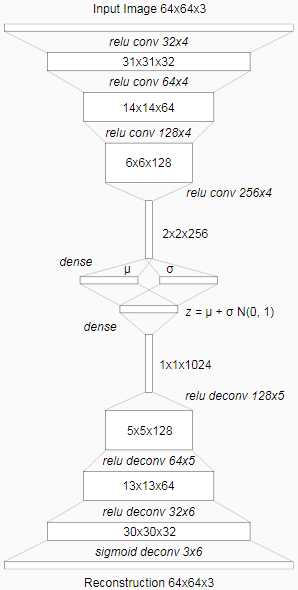

在下图中,我们描述了ConvVAE每层的张量形状,并描述了每层的细节:

潜向量zt从具有均值![]() 和对角线方差

和对角线方差![]() 的因式高斯分布

的因式高斯分布![]() 中采样的,当环境提供给我们高维像素图像时,我们首先缩放图像到64x64像素,并把缩放后的图像作为V的观察,每个像素保存为介于0到1表示一个RGB通道的三个浮点值。ConvVAE获得64x64x3的输入张量,经过4个卷积层然后编码为低维向量μt和σt。在赛车任务中Nz是32,而对于Doom任务Nz是64。潜向量zt通过4个反卷积层用于解码和重建图像。

中采样的,当环境提供给我们高维像素图像时,我们首先缩放图像到64x64像素,并把缩放后的图像作为V的观察,每个像素保存为介于0到1表示一个RGB通道的三个浮点值。ConvVAE获得64x64x3的输入张量,经过4个卷积层然后编码为低维向量μt和σt。在赛车任务中Nz是32,而对于Doom任务Nz是64。潜向量zt通过4个反卷积层用于解码和重建图像。

每个卷积和反卷积层步长为2,这些层在图中以斜体表示作为激活类型输出通道x滤波器大小。除了输出层所有卷积和反卷积层都使用relu激活,因为我们需要输出在0和1之间。我们使用随机策略收集的数据训练模型1个epoch,使用输入图像和重建图像之间的L2距离来量化重建优化的损失,而非KL损失。

混合密度网络+递归神经网络

对于M模型,我们结合 LSTM [115] 递归神经网络与混合密度网络 [37,38]作为输出层,在下一个时间步中使用这个网络来模拟下一个z的概率分布作为高斯分布混合。在无条件手写生成部分以及SketchRNN的仅解码器部分[35]这种方法与Graves的RNN生成序列非常相似 [39],使用的方法的唯一区别是我们不是建模每个元素z之间的相关参数,而是使用MDN-RNN输出一个因式高斯分布的对角协方差矩阵。

为了实现M,我们结合LSTM [115] 递归神经网络与混合密度网络[37,38]作为输出层,如下图所示:

我们使用这个网络来建模zt的概率分布作为高斯分布混合,在无条件手写生成部分以及SketchRNN的仅解码器部分 [35]这种方法与以前的作品[39]非常相似,唯一的区别是我们不是对每个![]() 元素之间的相关参数进行建模,而是使用MDN-RNN输出一个因式高斯分布的对角协方差矩阵。

元素之间的相关参数进行建模,而是使用MDN-RNN输出一个因式高斯分布的对角协方差矩阵。

与手写和草图生成的工作不同,我们不是使用MDN-RNN来模拟下一笔笔划的概率密度函数(pdf),而是模拟下一个潜向量zt的pdf,我们在每个时间步从此pdf中进行采样以生成环境。在Doom任务中,我们还使用MDN-RNN来预测agent是否在此帧中死亡的概率,如果该概率高于50%,那么我们将在虚拟环境中设置done为True。鉴于死亡是每个时间步的低概率事件,我们发现cutoff方法与伯努利分布的采样相比更稳定。

MDN-RNN使用从随机策略agent中收集的数据进行了20个epoch的训练。在赛车任务中,LSTM使用256个隐藏单位,在Doom任务使用512隐藏单位。在这两项任务中,我们使用了5种高斯混合,不像[39,35],我们没有对相关参数进行建模,而zt是从高斯分布的因式混合中采样的。

当从记录的数据使用teacher forcing 方法训练MDN-RNN时,我们存储预先计算的一组针对每个帧的![]() 和

和![]() ,在每一时间步从

,在每一时间步从![]() 的输入中采样并形成一个训练批次,以防止MDN-RNN对特定

的输入中采样并形成一个训练批次,以防止MDN-RNN对特定![]() 采样的过拟合。

采样的过拟合。

控制器

对于这两种环境,我们应用tanh非线性剪切动作空间将其限制到适当的范围。例如,在赛车任务中,方向盘的范围从-1.0到1.0,加速踏板从0.0到1.0,制动器从0.0到1.0。在Doom环境中,我们将离散动作转换为-1.0到1.0之间的连续动作空间,并将此范围划分为三分之一,以指示agent是向左移动,保持原样还是向右移动。我们给C一个特征向量作为它的输入,它由![]() 和MDN-RNN的隐藏状态组成。在赛车任务中,此隐藏状态是LSTM的输出向量

和MDN-RNN的隐藏状态组成。在赛车任务中,此隐藏状态是LSTM的输出向量![]() ,而对于Doom任务它既是细胞向量

,而对于Doom任务它既是细胞向量![]() 和LSTM的输出向量

和LSTM的输出向量![]() 。

。

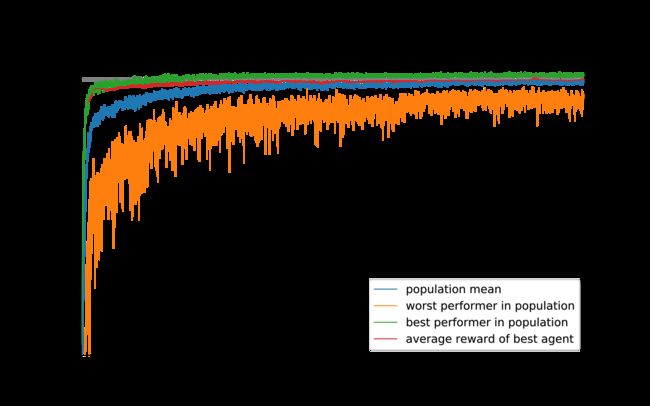

进化策略

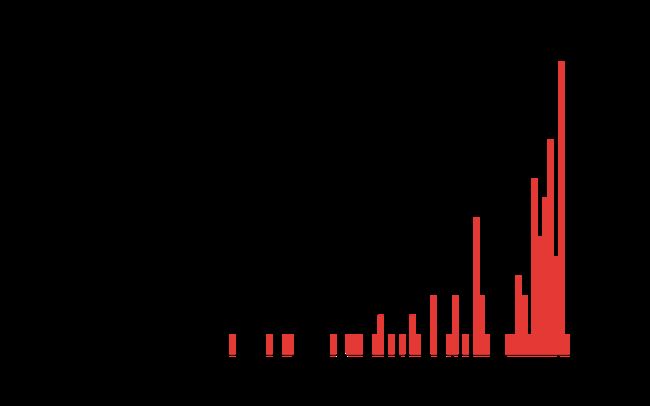

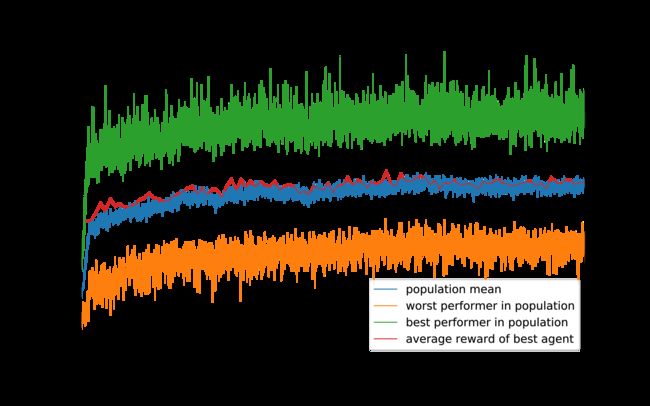

我们用了协方差矩阵自适应进化策略(CMA-ES)[45]演进C的权重,按照稳定策略[99]中描述的方法,我们使用64的种群大小,让每个agent用不同的初始随机种子执行16次任务,agent的适合度值是16次随机rollout的平均累积奖励。下图列出了64个agent的每一代中表现最佳及最差的种群的平均适应度:

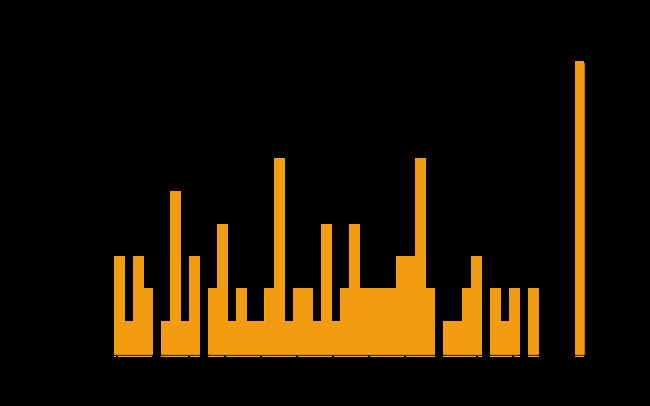

由于此环境的要求是让agent在100次随机rollout中达到平均得分900以上,我们在每25代结束时采用性能最佳的agent,并在1024个随机rollout方案中对其进行测试,红线表示此平均值。经过1800代,agent在1024次随机rollout后的平均得分为900.46。我们使用1024个随机rollout而不是100个,因为64核心机器的每个进程已经配置为运行16次,每25代后有效地使用完整代计算来评估最佳agent 1024次。在下图中,我们绘制了评估超过100次rollout的同一个agent的结果:

我们还尝试了一个只能访问来自VAE的![]() 向量而不是RNN的隐藏状态的agent。我们尝试了两种变体,在第一种变体中,C直接映射zt到动作空间

向量而不是RNN的隐藏状态的agent。我们尝试了两种变体,在第一种变体中,C直接映射zt到动作空间![]() ,在第二个变体中,我们尝试在zt和at之间添加了一个带有40个tanh激活单元的隐藏层,增加的C模型参数的数目达到1443,使其与原始设置更具有可比性。这些结果显示在下面的两个图中:

,在第二个变体中,我们尝试在zt和at之间添加了一个带有40个tanh激活单元的隐藏层,增加的C模型参数的数目达到1443,使其与原始设置更具有可比性。这些结果显示在下面的两个图中:

DoomRNN

我们在生成的Doom环境中进行了类似的实验,我们称之为DoomRNN。请注意,我们并未尝试在实际的VizDoom环境中训练agent,而是仅基于VizDoom使用随机策略来收集训练数据。DoomRNN相比VizDoom计算效率更高,因为它只在潜空间运行,而不需要在每个时间步来渲染图像,我们并不需要运行实际的Doom游戏引擎。

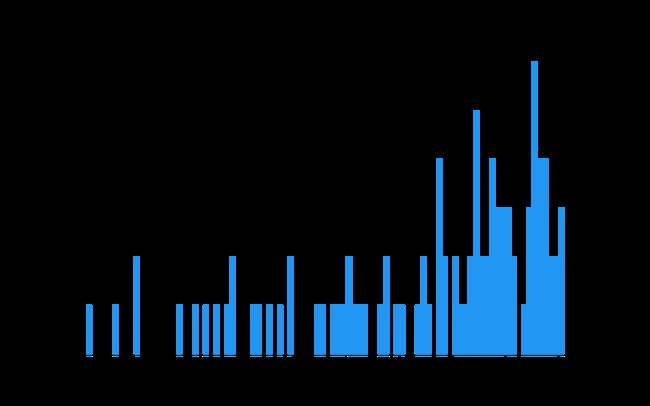

在我们的虚拟DoomRNN环境中,我们稍微提高了温度使用![]() 让agent在更具挑战性的环境中学习。最佳agent设法在1024次随机rollout中获得959的平均分数。下图中红线标示了最高分:

让agent在更具挑战性的环境中学习。最佳agent设法在1024次随机rollout中获得959的平均分数。下图中红线标示了最高分:

到部署到实际的DoomTakeCover-v0 [34]环境中,在100次随机rollout后相同的agent获得了1092 ± 556的平均分,如下图所示:

脚注

- 在许多RL问题中,反馈(正面或负面奖励)在一系列步骤结束时给出。信用分配问题解决了确定哪些步骤导致产生的反馈的问题 - 哪些步骤应该得到信用或惩罚的最终结果?

- 典型的无模型RL模型具有103至106模型参数,我们观察到训练模型具有107个参数,这相比最先进的具有108至109个参数的深度学习模型来说仍然较少。原则上,如果我们想要使用它们,可以参考本文中描述的更大的网络。

- 要明确,如果我们想采样

进行预测,

进行预测, 的预测不直接送入控制器C – 而是隐藏状态

的预测不直接送入控制器C – 而是隐藏状态 和

和 ,这是因为ht具有产生高斯分布混合的参数所需的所有信息。

,这是因为ht具有产生高斯分布混合的参数所需的所有信息。 - 我们发现这项任务很有意思,因为尽管训练agent在随机生成的轨道上随机前行并获得一个普通的分数并不困难,但CarRacing-v0将“解决”定义为在100次连续试验中获得900的平均奖励,这意味着agent只能有很少的驾驶错误。

- 我们在稍后将讨论随机策略不足的更复杂环境的迭代训练过程。

- 虽然原则上我们可以以端到端的方式将V和M一起训练,但我们发现分别训练每个则更实用,达到了令人满意的结果,并且不需要详尽的超参数调整。由于图像不需要自己训练M,我们甚至可以训练大批量的长序列潜向量用于编码一个episode的整个1000帧,以捕获单个GPU上的长期依赖性。

- 我们将讨论此分数与其他模型的比较。

- 另一个相关的联系是肌肉记忆,例如,当你学习做钢琴演奏之类的事情时,你不再需要耗费工作内存容量来将单个音符翻译成手指动作 - 这一切都会在潜意识层面进行编码。

参考

- Understanding Comics: The Invisible Art [link]

McCloud, S., 1993. Tundra Publishing. - More thoughts from Understanding Comics by Scott McCloud [link]

E, M., 2012. Tumblr. - Counterintuitive behavior of social systems [link]

Forrester, J.W., 1971. Technology Review. - The Code for Facial Identity in the Primate Brain [link]

Cheang, L. and Tsao, D., 2017. Cell. DOI: 10.1016/j.cell.2017.05.011 - Invariant visual representation by single neurons in the human brain [HTML]

Quiroga, R., Reddy, L., Kreiman, G., Koch, C. and Fried, I., 2005. Nature. DOI: 10.1038/nature03687 - Primary Visual Cortex Represents the Difference Between Past and Present [link]

Nortmann, N., Rekauzke, S., Onat, S., König, P. and Jancke, D., 2015. Cerebral Cortex, Vol 25(6), pp. 1427-1440. DOI: 10.1093/cercor/bht318 - Motion-Dependent Representation of Space in Area MT+ [link]

Gerrit, M., Fischer, J. and Whitney, D., 2013. Neuron. DOI: 10.1016/j.neuron.2013.03.010 - Akiyoshi’s Illusion Pages [HTML]

Kitaoka, A., 2002. Kanzen. - Peripheral drift illusion [link]

Authors, W., 2017. Wikipedia. - Illusory Motion Reproduced by Deep Neural Networks Trained for Prediction [link]

Watanabe, E., Kitaoka, A., Sakamoto, K., Yasugi, M. and Tanaka, K., 2018. Frontiers in Psychology, Vol 9, pp. 345. DOI: 10.3389/fpsyg.2018.00345 - Sensorimotor Mismatch Signals in Primary Visual Cortex of the Behaving Mouse [link]

Keller, G., Bonhoeffer, T. and Hübener, M., 2012. Neuron, Vol 74(5), pp. 809 - 815. DOI: https://doi.org/10.1016/j.neuron.2012.03.040 - A Sensorimotor Circuit in Mouse Cortex for Visual Flow Predictions [link]

Leinweber, M., Ward, D.R., Sobczak, J.M., Attinger, A. and Keller, G.B., 2017. Neuron, Vol 95(6), pp. 1420 - 1432.e5. DOI: https://doi.org/10.1016/j.neuron.2017.08.036 - The ecology of human fear: survival optimization and the nervous system. [link]

Mobbs, D., Hagan, C.C., Dalgleish, T., Silston, B. and Prévost, C., 2015. Frontiers in Neuroscience. DOI: 10.3389/fnins.2015.00055 - Tracking Fastballs [link]

Hirshon, B., 2013. Science Update Interview. - Reinforcement learning: a survey

Kaelbling, L.P., Littman, M.L. and Moore, A.W., 1996. Journal of AI research, Vol 4, pp. 237—285. - Introduction to Reinforcement Learning [PDF]

Sutton, R.S. and Barto, A.G., 1998. MIT Press. - Reinforcement Learning

Wiering, M. and van Otterlo, M., 2012. Springer. - Learning How the World Works: Specifications for Predictive Networks in Robots and Brains

Werbos, P.J., 1987. Proceedings of IEEE International Conference on Systems, Man and Cybernetics, N.Y.. - David Silver’s Lecture on Integrating Learning and Planning [PDF]

Silver, D., 2017. - Making the World Differentiable: On Using Self-Supervised Fully Recurrent Neural Networks for Dynamic Reinforcement Learning and Planning in Non-Stationary Environments [PDF]

Schmidhuber, J., 1990. - An on-line algorithm for dynamic reinforcement learning and planning in reactive environments [link]

Schmidhuber, J., 1990. 1990 IJCNN International Joint Conference on Neural Networks, pp. 253-258 vol.2. DOI: 10.1109/IJCNN.1990.137723 - Reinforcement Learning in Markovian and Non-Markovian Environments [PDF]

Schmidhuber, J., 1991. Advances in Neural Information Processing Systems 3, pp. 500—506. Morgan-Kaufmann. - The representation of the cumulative rounding error of an algorithm as a Taylor expansion of the local rounding errors

Linnainmaa, S., 1970. - Gradient Theory of Optimal Flight Paths

Kelley, H.J., 1960. ARS Journal, Vol 30(10), pp. 947-954. - Applications of advances in nonlinear sensitivity analysis

Werbos, P.J., 1982. System modeling and optimization, pp. 762—770. Springer. - A Possibility for Implementing Curiosity and Boredom in Model-building Neural Controllers [PDF]

Schmidhuber, J., 1990. Proceedings of the First International Conference on Simulation of Adaptive Behavior on From Animals to Animats, pp. 222—227. MIT Press. - On Learning to Think: Algorithmic Information Theory for Novel Combinations of Reinforcement Learning Controllers and Recurrent Neural World Models [PDF]

Schmidhuber, J., 2015. ArXiv preprint. - OpenAI Gym [PDF]

Brockman, G., Cheung, V., Pettersson, L., Schneider, J., Schulman, J., Tang, J. and Zaremba, W., 2016. ArXiv preprint. - Deep Reinforcement Learning: A Brief Survey [PDF]

Arulkumaran, K., Deisenroth, M.P., Brundage, M. and Bharath, A.A., 2017. IEEE Signal Processing Magazine, Vol 34(6), pp. 26-38. DOI: 10.1109/MSP.2017.2743240 - Deep Learning in Neural Networks: An Overview

Schmidhuber, J., 2015. Neural Networks, Vol 61, pp. 85-117. DOI: 10.1016/j.neunet.2014.09.003 - Auto-Encoding Variational Bayes [PDF]

Kingma, D. and Welling, M., 2013. ArXiv preprint. - Stochastic Backpropagation and Approximate Inference in Deep Generative Models [PDF]

Jimenez Rezende, D., Mohamed, S. and Wierstra, D., 2014. ArXiv preprint. - ViZDoom: A Doom-based AI Research Platform for Visual Reinforcement Learning [PDF]

Kempka, M., Wydmuch, M., Runc, G., Toczek, J. and Jaskowski, W., 2016. IEEE Conference on Computational Intelligence and Games, pp. 341—348. IEEE. - DoomTakeCover-v0 [link]

Paquette, P., 2016. - A Neural Representation of Sketch Drawings [link]

Ha, D. and Eck, D., 2017. ArXiv preprint. - Draw Together with a Neural Network [link]

Ha, D., Jongejan, J. and Johnson, I., 2017. Google AI Experiments. - Mixture density networks [link]

Bishop, C.M., 1994. Technical Report. Aston University. - Mixture Density Networks with TensorFlow [link]

Ha, D., 2015. blog.otoro.net. - Generating sequences with recurrent neural networks [PDF]

Graves, A., 2013. ArXiv preprint. - Recurrent Neural Network Tutorial for Artists [link]

Ha, D., 2017. blog.otoro.net. - Experiments in Handwriting with a Neural Network [link]

Carter, S., Ha, D., Johnson, I. and Olah, C., 2016. Distill. DOI: 10.23915/distill.00004 - Evolutionsstrategie: optimierung technischer systeme nach prinzipien der biologischen evolution [link]

Rechenberg, I., 1973. Frommann-Holzboog. - Numerical Optimization of Computer Models [link]

Schwefel, H., 1977. John Wiley and Sons, Inc. - A Visual Guide to Evolution Strategies [link]

Ha, D., 2017. blog.otoro.net. - The CMA Evolution Strategy: A Tutorial [PDF]

Hansen, N., 2016. ArXiv preprint. - Completely Derandomized Self-Adaptation in Evolution Strategies [PDF]

Hansen, N. and Ostermeier, A., 2001. Evolutionary Computation, Vol 9(2), pp. 159—195. MIT Press. DOI: 10.1162/106365601750190398 - CarRacing-v0 [link]

Klimov, O., 2016. - Self-driving cars in the browser [link]

Hünermann, J., 2017. - Mar I/O Kart [link]

Bling, S., 2015. - Using Keras and Deep Deterministic Policy Gradient to play TORCS [HTML]

Lau, B., 2016. - Car Racing using Reinforcement Learning [PDF]

Khan, M. and Elibol, O., 2016. - Reinforcement Car Racing with A3C [link]

Jang, S., Min, J. and Lee, C., 2017. - Deep-Q Learning for Box2D Racecar RL problem. [link]

Prieur, L., 2017. “GitHub”. - Video Game Exploits [link]

Wikipedia, A., 2017. Wikipedia. - Action-Conditional Video Prediction using Deep Networks in Atari Games [PDF]

Oh, J., Guo, X., Lee, H., Lewis, R. and Singh, S., 2015. ArXiv preprint. - Recurrent Environment Simulators [PDF]

Chiappa, S., Racaniere, S., Wierstra, D. and Mohamed, S., 2017. ArXiv preprint. - PILCO: A Model-Based and Data-Efficient Approach to Policy Search [PDF]

Deisenroth, M. and Rasmussen, C., 2011. In Proceedings of the International Conference on Machine Learning. - Neural Network Dynamics for Model-Based Deep Reinforcement Learning with Model-Free Fine-Tuning [PDF]

Nagabandi, A., Kahn, G., Fearing, R. and Levine, S., 2017. ArXiv preprint. - Formal Theory of Creativity, Fun, and Intrinsic Motivation (1990-2010). [HTML]

Schmidhuber, J., 2010. IEEE Trans. Autonomous Mental Development. - Developmental Robotics, Optimal Artificial Curiosity, Creativity, Music, and the Fine Arts

Schmidhuber, J., 2006. Connection Science, Vol 18(2), pp. 173—187. - Curious Model-Building Control Systems

Schmidhuber, J., 1991. In Proc. International Joint Conference on Neural Networks, Singapore, pp. 1458—1463. IEEE. - Curiosity-driven Exploration by Self-supervised Prediction [link]

Pathak, D., Agrawal, P., A., E. and Darrell, T., 2017. ArXiv preprint. - Intrinsic Motivation Systems for Autonomous Mental Development [PDF]

Oudeyer, P., Kaplan, F. and Hafner, V., 2007. Trans. Evol. Comp. IEEE Press. DOI: 10.1109/TEVC.2006.890271 - Reinforcement driven information acquisition in nondeterministic environments

Schmidhuber, J., Storck, J. and Hochreiter, S., 1994. - Information-seeking, curiosity, and attention: computational and neural mechanisms [PDF]

Gottlieb, J., Oudeyer, P., Lopes, M. and Baranes, A., 2013. Cell. DOI: 10.1016/j.tics.2013.09.001 - Abandoning objectives: Evolution through the search for novelty alone [link]

Lehman, J. and Stanley, K., 2011. Evolutionary Computation, Vol 19(2), pp. 189—223. M I T Press. - Memory Consolidation [link]

Authors, W., 2017. Wikipedia. - Replay Comes of Age [link]

Foster, D.J., 2017. Annual Review of Neuroscience, Vol 40(1), pp. 581-602. DOI: 10.1146/annurev-neuro-072116-031538 - Intrinsic Motivation and Automatic Curricula via Asymmetric Self-Play [PDF]

Sukhbaatar, S., Lin, Z., Kostrikov, I., Synnaeve, G., Szlam, A. and Fergus, R., 2017. ArXiv preprint. - Emergent Complexity via Multi-Agent Competition [PDF]

Bansal, T., Pachocki, J., Sidor, S., Sutskever, I. and Mordatch, I., 2017. ArXiv preprint. - Continuous Adaptation via Meta-Learning in Nonstationary and Competitive Environments [PDF]

Al-Shedivat, M., Bansal, T., Burda, Y., Sutskever, I., Mordatch, I. and Abbeel, P., 2017. ArXiv preprint. - PowerPlay: Training an Increasingly General Problem Solver by Continually Searching for the Simplest Still Unsolvable Problem [link]

Schmidhuber, J., 2013. Frontiers in Psychology, Vol 4, pp. 313. DOI: 10.3389/fpsyg.2013.00313 - First Experiments with PowerPlay [PDF]

Srivastava, R., Steunebrink, B. and Schmidhuber, J., 2012. ArXiv preprint. - Optimal Ordered Problem Solver [PDF]

Schmidhuber, J., 2002. ArXiv preprint. - A Dual Back-Propagation Scheme for Scalar Reinforcement Learning

Munro, P.W., 1987. Proceedings of the Ninth Annual Conference of the Cognitive Science Society, Seattle, WA, pp. 165-176. - Dynamic Reinforcement Driven Error Propagation Networks with Application to Game Playing

Robinson, T. and Fallside, F., 1989. CogSci 89. - Neural Networks for Control and System Identification

Werbos, P.J., 1989. Proceedings of IEEE/CDC Tampa, Florida. - The truck backer-upper: An example of self learning in neural networks

Nguyen, N. and Widrow, B., 1989. Proceedings of the International Joint Conference on Neural Networks, pp. 357-363. IEEE Press. - Lecture Slides on PILCO [PDF]

Duvenaud, D., 2016. CSC 2541 Course at University of Toronto. - Data-Efficient Reinforcement Learning in Continuous-State POMDPs [PDF]

McAllister, R. and Rasmussen, C., 2016. ArXiv preprint. - Improving PILCO with Bayesian Neural Network Dynamics Models [PDF]

Gal, Y., McAllister, R. and Rasmussen, C., 2016. ICML Workshop on Data-Efficient Machine Learning. - Learning and Policy Search in Stochastic Dynamical Systems with Bayesian Neural Networks [PDF]

Depeweg, S., Hernandez-Lobato, J., Doshi-Velez, F. and Udluft, S., 2016. ArXiv preprint. - A Benchmark Environment Motivated by Industrial Control Problems [PDF]

Hein, D., Depeweg, S., Tokic, M., Udluft, S., Hentschel, A., Runkler, T. and Sterzing, V., 2017. ArXiv preprint. - Learning to Generate Artificial Fovea Trajectories for Target Detection [PDF]

Schmidhuber, J. and Huber, R., 1991. International Journal of Neural Systems, Vol 2(1-2), pp. 125—134.DOI: 10.1142/S012906579100011X - Learning deep dynamical models from image pixels [PDF]

Wahlström, N., Schön, T. and Deisenroth, M., 2014. ArXiv preprint. - From Pixels to Torques: Policy Learning with Deep Dynamical Models [PDF]

Wahlström, N., Schön, T. and Deisenroth, M., 2015. ArXiv preprint. - Deep Spatial Autoencoders for Visuomotor Learning [PDF]

Finn, C., Tan, X., Duan, Y., Darrell, T., Levine, S. and Abbeel, P., 2015. ArXiv preprint. - Embed to Control: A Locally Linear Latent Dynamics Model for Control from Raw Images [PDF]

Watter, M., Springenberg, J., Boedecker, J. and Riedmiller, M., 2015. ArXiv preprint. - Model-Based RL Lecture at Deep RL Bootcamp 2017 [link]

Finn, C., 2017. - Game Engine Learning from Video [link]

Matthew Guzdial, B.L., 2017. Proceedings of the Twenty-Sixth International Joint Conference on Artificial Intelligence, IJCAI-17, pp. 3707—3713. DOI: 10.24963/ijcai.2017/518 - Learning to Act by Predicting the Future [PDF]

Dosovitskiy, A. and Koltun, V., 2016. ArXiv preprint. - Hallucination with Recurrent Neural Networks [link]

Graves, A., 2015. - Unsupervised Learning of Disentangled Representations from Video [PDF]

Denton, E. and Birodkar, V., 2017. ArXiv preprint. - The Predictron: End-To-End Learning and Planning [PDF]

Silver, D., van Hasselt, H., Hessel, M., Schaul, T., Guez, A., Harley, T., Dulac-Arnold, G., Reichert, D., Rabinowitz, N., Barreto, A. and Degris, T., 2016. ArXiv preprint. - Imagination-Augmented Agents for Deep Reinforcement Learning [PDF]

Weber, T., Racanière, S., Reichert, D., Buesing, L., Guez, A., Rezende, D., Badia, A., Vinyals, O., Heess, N., Li, Y., Pascanu, R., Battaglia, P., Silver, D. and Wierstra, D., 2017. ArXiv preprint. - Visual Interaction Networks [PDF]

Watters, N., Tacchetti, A., Weber, T., Pascanu, R., Battaglia, P. and Zoran, D., 2017. ArXiv preprint. - PathNet: Evolution Channels Gradient Descent in Super Neural Networks [PDF]

Fernando, C., Banarse, D., Blundell, C., Zwols, Y., Ha, D., Rusu, A., Pritzel, A. and Wierstra, D., 2017. ArXiv preprint. - Evolution Strategies as a Scalable Alternative to Reinforcement Learning [PDF]

Salimans, T., Ho, J., Chen, X., Sidor, S. and Sutskever, I., 2017. ArXiv preprint. - Evolving Stable Strategies [link]

Ha, D., 2017. blog.otoro.net. - Welcoming the Era of Deep Neuroevolution [link]

Stanley, K. and Clune, J., 2017. Uber AI Research. - Playing Atari with Deep Reinforcement Learning [PDF]

Mnih, V., Kavukcuoglu, K., Silver, D., Graves, A., Antonoglou, I., Wierstra, D. and Riedmiller, M., 2013. ArXiv preprint. - Evolving Neural Networks Through Augmenting Topologies [link]

Stanley, K.O. and Miikkulainen, R., 2002. Evolutionary Computation, Vol 10(2), pp. 99-127. - Accelerated Neural Evolution Through Cooperatively Coevolved Synapses [PDF]

Gomez, F., Schmidhuber, J. and Miikkulainen, R., 2008. Journal of Machine Learning Research, Vol 9, pp. 937—965. JMLR.org. - Co-evolving Recurrent Neurons Learn Deep Memory POMDPs [PDF]

Gomez, F. and Schmidhuber, J., 2005. Proceedings of the 7th Annual Conference on Genetic and Evolutionary Computation, pp. 491—498. ACM. DOI: 10.1145/1068009.1068092 - Autonomous Evolution of Topographic Regularities in Artificial Neural Networks [PDF]

Gauci, J. and Stanley, K.O., 2010. Neural Computation, Vol 22(7), pp. 1860—1898. MIT Press. DOI: 10.1162/neco.2010.06-09-1042 - Parameter-exploring policy gradients [link]

Sehnke, F., Osendorfer, C., Ruckstieb, T., Graves, A., Peters, J. and Schmidhuber, J., 2010. Neural Networks, Vol 23(4), pp. 551—559. DOI: 10.1016/j.neunet.2009.12.004 - Evolving Neural Networks [PDF]

Miikkulainen, R., 2013. IJCNN. - Evolving Large-scale Neural Networks for Vision-based Reinforcement Learning [HTML]

Koutnik, J., Cuccu, G., Schmidhuber, J. and Gomez, F., 2013. Proceedings of the 15th Annual Conference on Genetic and Evolutionary Computation, pp. 1061—1068. ACM. DOI: 10.1145/2463372.2463509 - A Neuroevolution Approach to General Atari Game Playing [link]

Hausknecht, M., Lehman, J., Miikkulainen, R. and Stone, P., 2013. IEEE Transactions on Computational Intelligence and AI in Games. - Neuro-Visual Control in the Quake II Environment [PDF]

Parker, M. and Bryant, B., 2012. IEEE Transactions on Computational Intelligence and AI in Games. - Autoencoder-augmented Neuroevolution for Visual Doom Playing [PDF]

Alvernaz, S. and Togelius, J., 2017. ArXiv preprint. - Using Simulation and Domain Adaptation to Improve Efficiency of Deep Robotic Grasping [PDF]

Bousmalis, K., Irpan, A., Wohlhart, P., Bai, Y., Kelcey, M., Kalakrishnan, M., Downs, L., Ibarz, J., Pastor, P., Konolige, K., Levine, S. and Vanhoucke, V., 2017. ArXiv e-prints. - DARLA: Improving Zero-Shot Transfer in Reinforcement Learning [PDF]

Higgins, I., Pal, A., Rusu, A., Matthey, L., Burgess, C., Pritzel, A., Botvinick, M., Blundell, C. and Lerchner, A., 2017. ArXiv e-prints. - Cortical interneurons that specialize in disinhibitory control [link]

Pi, H., Hangya, B., Kvitsiani, D., Sanders, J., Huang, Z. and Kepecs, A., 2013. Nature. DOI: 10.1038/nature12676 - Long short-term memory [PDF]

Hochreiter, S. and Schmidhuber, J., 1997. Neural Computation. MIT Press. - Learning to Forget: Continual Prediction with LSTM [PDF]

Gers, F., Schmidhuber, J. and Cummins, F., 2000. Neural Computation, Vol 12(10), pp. 2451—2471. MIT Press. DOI: 10.1162/089976600300015015 - Nanoconnectomic upper bound on the variability of synaptic plasticity [link]

Bartol, T.M., Bromer, C., Kinney, J., Chirillo, M.A., Bourne, J.N., Harris, K.M. and Sejnowski, T.J., 2015. eLife Sciences Publications, Ltd. DOI: 10.7554/eLife.10778 - Connectionist models of recognition memory: constraints imposed by learning and forgetting functions.

Ratcliff, R.M., 1990. Psychological review, Vol 97 2, pp. 285-308. - Catastrophic interference in connectionist networks: Can It Be predicted, can It be prevented? [PDF]

French, R.M., 1994. Advances in Neural Information Processing Systems 6, pp. 1176—1177. Morgan-Kaufmann. - Overcoming catastrophic forgetting in neural networks [PDF]

Kirkpatrick, J., Pascanu, R., Rabinowitz, N., Veness, J., Desjardins, G., Rusu, A.M., Quan, J., Ramalho, T., Grabska-Barwinska, A., Hassabis, D., Clopath, C., Kumaran, D. and Hadsell, R., 2016. ArXiv preprint. - Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer [PDF]

Shazeer, N., Mirhoseini, A., Maziarz, K., Davis, A., Le, Q., Hinton, G. and Dean, J., 2017. ArXiv preprint. - HyperNetworks [PDF]

Ha, D., Dai, A. and Le, Q., 2016. ArXiv preprint. - Language Modeling with Recurrent Highway Hypernetworks [PDF]

Suarez, J., 2017. Advances in Neural Information Processing Systems 30, pp. 3269—3278. Curran Associates, Inc. - WaveNet: A Generative Model for Raw Audio [PDF]

van den Oord, A., Dieleman, S., Zen, H., Simonyan, K., Vinyals, O., Graves, A., Kalchbrenner, N., Senior, A. and Kavukcuoglu, K., 2016. ArXiv preprint. - Attention Is All You Need [PDF]

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A., Kaiser, L. and Polosukhin, I., 2017. ArXiv preprint. - Generative Temporal Models with Memory [PDF]

Gemici, M., Hung, C., Santoro, A., Wayne, G., Mohamed, S., Rezende, D., Amos, D. and Lillicrap, T., 2017. ArXiv preprint. - One Big Net For Everything [PDF]

Schmidhuber, J., 2018. Preprint arXiv:1802.08864 [cs.AI]. - Learning Complex, Extended Sequences Using the Principle of History Compression

Schmidhuber, J., 1992. Neural Computation, Vol 4(2), pp. 234-242.