第4章 精通pandas变形操作(使用pandas进行数据分析,从小白逆袭大神,你会了吗?)

文章目录

- 第4章 变形

- 一、透视表

- 1. pivot

- 2. pivot_table

- 3. crosstab(交叉表)

- 二、其他变形方法

- 1. melt

- 2. 压缩与展开

- 三、哑变量与因子化

- 1. Dummy Variable(哑变量)

- 2. factorize方法

Python火了,作为一门万能语言,Python迷人之处在于非常高效。在日常工作中,很多琐事都是要重复操作的,重复的工作会将你留个自己思考进步的时间都会占用,从而成为一个职场螺丝钉。而Python自动化办公,可以轻松将工作中繁杂且重复的内容通过简短的代码让计算机自动完成。

而且,Python真的很容易上手,还很简单,同一个程序原来使用Java要编10行的代码,在Python里可能是需要3-5行即可完成,大大减少了程序员的工作量。

所以送大家一本电子书:python操作word,excel,pdf

链接:https://pan.baidu.com/s/10KTz_CPln20SK1z3h9nxng

提取码:7w6s

第4章 变形

import numpy as np

import pandas as pd

df = pd.read_csv('data/table.csv')

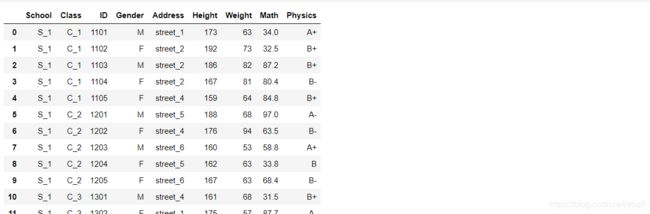

df

一、透视表

1. pivot

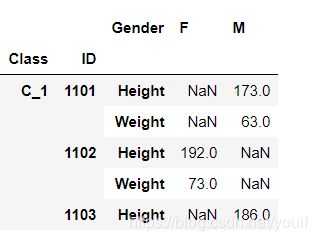

一般状态下,数据在DataFrame会以压缩(stacked)状态存放,例如上面的Gender,两个类别被叠在一列中,pivot函数可将某一列作为新的cols:

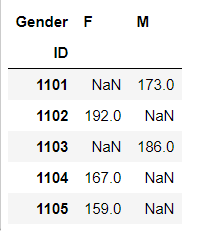

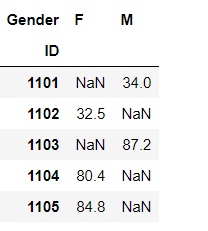

df.pivot(index='ID',columns='Gender',values='Height').head()

然而pivot函数具有很强的局限性,除了功能上较少之外,还不允许values中出现重复的行列索引对(pair),例如下面的语句就会报错:

# df.pivot(index='School',columns='Gender',values='Height').head()

因此,更多的时候会选择使用强大的pivot_table函数

2. pivot_table

首先,再现上面的操作:

pd.pivot_table(df,index='ID',columns='Gender',values='Height').head()

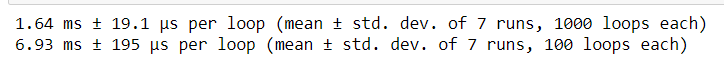

%timeit df.pivot(index='ID',columns='Gender',values='Height')

%timeit pd.pivot_table(df,index='ID',columns='Gender',values='Height')

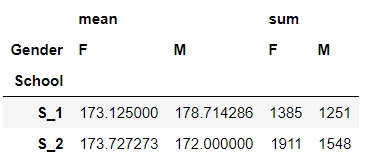

① aggfunc:对组内进行聚合统计,可传入各类函数,默认为’mean’

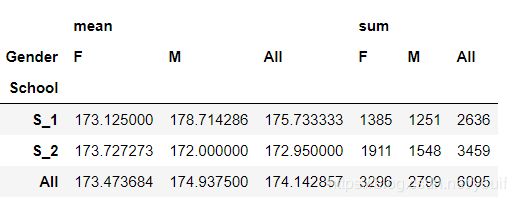

pd.pivot_table(df,index='School',columns='Gender',values='Height',aggfunc=['mean','sum']).head()

pd.pivot_table(df,index='School',columns='Gender',values='Height',aggfunc=['mean','sum'],margins=True).head()

#margins_name可以设置名字,默认为'All

③ 行、列、值都可以为多级

pd.pivot_table(df,index=['School','Class'],

columns=['Gender','Address'],

values=['Height','Weight'])

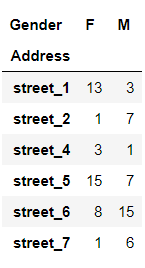

3. crosstab(交叉表)

交叉表是一种特殊的透视表,典型的用途如分组统计,如现在想要统计关于街道和性别分组的频数:

pd.crosstab(index=df['Address'],columns=df['Gender'])

交叉表的功能也很强大(但目前还不支持多级分组),下面说明一些重要参数:

① values和aggfunc:分组对某些数据进行聚合操作,这两个参数必须成对出现

pd.crosstab(index=df['Address'],columns=df['Gender'],

values=np.random.randint(1,20,df.shape[0]),aggfunc='min')

#默认参数等于如下方法:

#pd.crosstab(index=df['Address'],columns=df['Gender'],values=1,aggfunc='count')

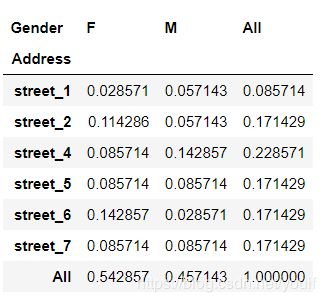

② 除了边际参数margins外,还引入了normalize参数,可选’all’,‘index’,'columns’参数值

pd.crosstab(index=df['Address'],columns=df['Gender'],normalize='all',margins=True)

二、其他变形方法

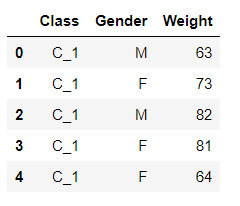

1. melt

melt函数可以认为是pivot函数的逆操作,将unstacked状态的数据,压缩成stacked,使“宽”的DataFrame变“窄”

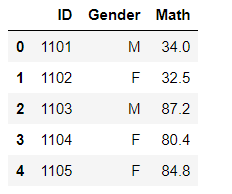

df_m = df[['ID','Gender','Math']]

df_m.head()

df.pivot(index='ID',columns='Gender',values='Math').head()

melt函数中的id_vars表示需要保留的列,value_vars表示需要stack的一组列

pivoted = df.pivot(index='ID',columns='Gender',values='Math')

result = pivoted.reset_index().melt(id_vars=['ID'],value_vars=['F','M'],value_name='Math')\

.dropna().set_index('ID').sort_index()

#检验是否与展开前的df相同,可以分别将这些链式方法的中间步骤展开,看看是什么结果

result.equals(df_m.set_index('ID'))

# result

2. 压缩与展开

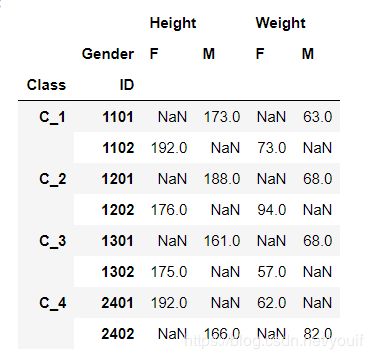

(1)stack:这是最基础的变形函数,总共只有两个参数:level和dropna

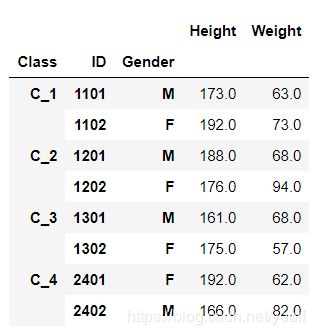

df_s = pd.pivot_table(df,index=['Class','ID'],columns='Gender',values=['Height','Weight'])

df_s.groupby('Class').head(2)

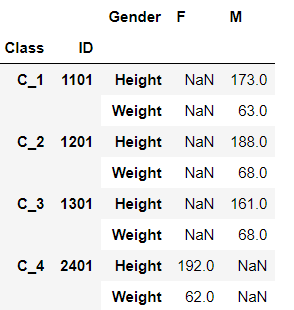

df_stacked = df_s.stack()

df_stacked.groupby('Class').head(2)

stack函数可以看做将横向的索引放到纵向,因此功能类似与melt,参数level可指定变化的列索引是哪一层(或哪几层,需要列表)

df_stacked = df_s.stack(0)

df_stacked.groupby('Class').head(2)

(2) unstack:stack的逆函数,功能上类似于pivot_table

df_stacked.head()

result = df_stacked.unstack().swaplevel(1,0,axis=1).sort_index(axis=1)

result.equals(df_s)

#同样在unstack中可以指定level参数

三、哑变量与因子化

1. Dummy Variable(哑变量)

这里主要介绍get_dummies函数,其功能主要是进行one-hot编码:

df_d = df[['Class','Gender','Weight']]

df_d.head()

pd.get_dummies(df_d[['Class','Gender']]).join(df_d['Weight']).head()

#可选prefix参数添加前缀,prefix_sep添加分隔符

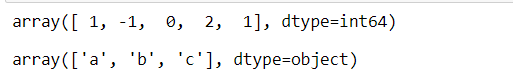

2. factorize方法

该方法主要用于自然数编码,并且缺失值会被记做-1,其中sort参数表示是否排序后赋值

codes, uniques = pd.factorize(['b', None, 'a', 'c', 'b'], sort=True)

display(codes)

display(uniques)

另外博主收藏这些年来看过或者听过的一些不错的常用的上千本书籍,没准你想找的书就在这里呢,包含了互联网行业大多数书籍和面试经验题目等等。有人工智能系列(常用深度学习框架TensorFlow、pytorch、keras。NLP、机器学习,深度学习等等),大数据系列(Spark,Hadoop,Scala,kafka等),程序员必修系列(C、C++、java、数据结构、linux,设计模式、数据库等等)以下是部分截图

关注我的原创微信公众号「五角钱的程序员」,我们一起成长,一起学习。一直纯真着,善良着,温情地热爱生活。关注回复【电子书】即可领取哦。

![]()

![]()

所有巧合的是要么是上天注定要么是一个人偷偷的在努力。

有收获?希望老铁们来个三连击,给更多的人看到这篇文章

1、给俺点个赞呗,可以让更多的人看到这篇文章,谢谢各位亲。

2、亲们,关注我的原创微信公众号「五角钱的程序员」,我们一起成长,一起学习。一直纯真着,善良着,温情地热爱生活。关注回复【电子书】有很多资源哦。

给大家推荐一个Github,上面非常非常多的干货:https://github.com/XiangLinPro/IT_book

All the burdens of life will become a gift and all the suffering can illuminate the future.

人生所有的负担都将会变成礼物,所受的苦都能照亮未来迷茫的路。

2020.5.14于城口