Linux --- Zookeeper集群搭建

一、Zookeeper集群简介

大部分分布式应用需要一个主控、协调器或者控制器来管理物理分布的子进程。目前,大多数都要开发私有的协调程序,缺乏一个通用机制,协调程序的反复编写浪费,且难以形成通用、伸缩性好的协调器,zookeeper提供通用的分布式锁服务,用以协调分布式应用。所以说zookeeper是分布式应用的协作服务。

zookeeper作为注册中心,服务器和客户端都要访问,如果有大量的并发,肯定会有等待。所以可以通过zookeeper集群解决。

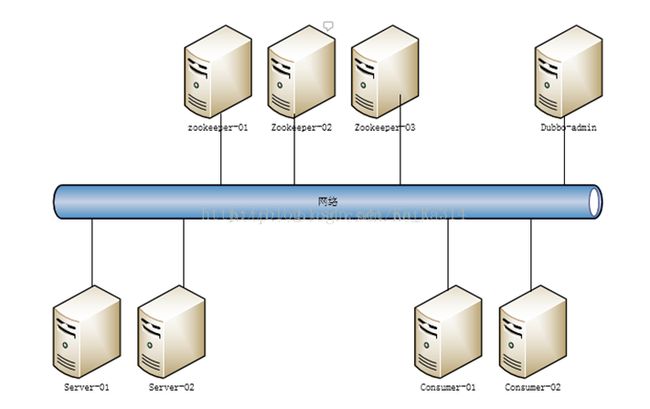

下面是zookeeper集群部署结构图:

二、Zookeeper的Leader选举方式

Zookeeper的启动过程中leader选举是非常重要而且最复杂的一个环节。那么什么是leader选举呢?zookeeper为什么需要leader选举呢?zookeeper的leader选举的过程又是什么样子的?

首先我们来看看什么是leader选举。其实这个很好理解,leader选举就像总统选举一样,每人一票,获得多数票的人就当选为总统了。在zookeeper集群中也是一样,每个节点都会投票,如果某个节点获得超过半数以上的节点的投票,则该节点就是leader节点了。

以一个简单的例子来说明整个选举的过程:

假设有五台服务器组成的zookeeper集群,它们的id从1-5,同时它们都是最新启动的,也就是没有历史数据,在存放数据量这一点上,都是一样的.假设这些服务器依序启动,来看看会发生什么 。

1、服务器1启动,此时只有它一台服务器启动了,它发出去的报没有任何响应,所以它的选举状态一直是LOOKING状态

2、服务器2启动,它与最开始启动的服务器1进行通信,互相交换自己的选举结果,由于两者都没有历史数据,所以id值较大的服务器2胜出,但是由于没有达到超过半数以上的服务器都同意选举它(这个例子中的半数以上是3),所以服务器1,2还是继续保持LOOKING状态.

3、服务器3启动,根据前面的理论分析,服务器3成为服务器1,2,3中的老大,而与上面不同的是,此时有三台服务器选举了它,所以它成为了这次选举的leader.

4、服务器4启动,根据前面的分析,理论上服务器4应该是服务器1,2,3,4中最大的,但是由于前面已经有半数以上的服务器选举了服务器3,所以它只能接收当小弟的命了.

5、服务器5启动,同4一样,当小弟

三、Zookeeper集群搭建步骤 --- 环境VM CentOS7

(1) 安装JDK --- 此处略过

(2) 准备3台服务器

(3) 将Zookeeper压缩包上传到3台服务器中,一下步骤3台服务器都要执行

(4) 将Zookeeper压缩包解压

tar -xzvf zookeeper-3.4.6.tar.gz(5) 进入zookeeper目录创建data和logs文件夹

mkdir data

mkdir logs(6) 进入zookeeper的conf目录,复制zoo_sample.cfg文件,并改名成zoo.cfg

cp zoo_sample.cfg zoo.cfg(7) 进入vim编辑zoo.cfg,如下:

# The number of milliseconds of each tick

tickTime=2000

# The number of ticks that the initial

# synchronization phase can take

initLimit=10

# The number of ticks that can pass between

# sending a request and getting an acknowledgement

syncLimit=5

# the directory where the snapshot is stored.

# do not use /tmp for storage, /tmp here is just

# example sakes.

dataDir=/root/zookeeper-3.4.6/data

dataLogDir=/root/zookeeper-3.4.6/logs

# the port at which the clients will connect

clientPort=2181

# the maximum number of client connections.

# increase this if you need to handle more clients

#maxClientCnxns=60

#

# Be sure to read the maintenance section of the

# administrator guide before turning on autopurge.

#

# http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance

#

# The number of snapshots to retain in dataDir

#autopurge.snapRetainCount=3

# Purge task interval in hours

# Set to "0" to disable auto purge feature

#autopurge.purgeInterval=1

server.1=192.168.1.103:2888:3888

server.2=192.168.1.104:2888:3888

server.3=192.168.1.105:2888:3888

(8) 进入创建的data目录,创建myid文件

- 192.168.1.103中创建myid并写入1

- 192.168.1.104中创建myid并写入2

- 192.168.1.105中创建myid并写入3

echo 1>myid注意:记得查看内容是否已经写入myid文件中,如果没有写入,则无法启动zookeeper服务,报如下错误:

Error contacting service. It is probably not running实际错误是:查看日志 --- 可以在bin目录中查看zookeeper.out文件,或者查看logs中日志

Caused by: java.lang.IllegalArgumentException: serverid null is not a number (9) 检查防火墙是否拦截设置的端口

(10) 启动集群,进入zookeeper的bin目录中执行启动命令

./zkServer.sh start查看服务启动状态:

./zkServer.sh status此时如果只启动一台服务器,会看到服务并没有启动成功,因为服务集群有Leader选举机制,此时只有一台服务器,并不能够完成选举,所以启动失败

启动另外2台zookeeper服务

正确启动后查看服务启动状态,如下

(1) 192.168.1.104

[root@localhost bin]# ./zkServer.sh status

JMX enabled by default

Using config: /root/zookeeper-3.4.6/bin/../conf/zoo.cfg

Mode: leader

(2) 192.168.1.103

[root@localhost bin]# ./zkServer.sh status

JMX enabled by default

Using config: /root/zookeeper-3.4.6/bin/../conf/zoo.cfg

Mode: follower

(3) 192.168.1.105

[root@localhost bin]# ./zkServer.sh status

JMX enabled by default

Using config: /root/zookeeper-3.4.6/bin/../conf/zoo.cfg

Mode: follower

四、Dubbox连接zookeeper集群

修改服务提供者和服务调用者的spring 配置文件