每天一篇论文342/365 Self-Supervised Deep Pose Corrections for Robust Visual Odometry

Self-Supervised Deep Pose Corrections for Robust Visual Odometry

Code

摘要

提出了一种自监督的深度位姿校正(DPC)网络,该网络将位姿校正应用于视觉里程计估计器以提高其精度。我们没有直接回归帧间姿态变化,而是在先前工作的基础上,使用数据驱动的学习来回归姿态修正,该修正解释了由于违反建模假设而导致的系统误差。我们的自监督公式消除了对六自由度地面真实性的任何要求,与预期相反,与监督方法相比,通常提高了总体导航精度。通过大量的实验,我们证明了我们的自监督DPC网络能够显著地提高经典单目和立体里程估计器的性能,并且大大优于目前最先进的仅学习的方法。

贡献

1) 一个深层位姿校正网络,可以以自我监督的方式进行训练,从而消除了地面真实位姿标签的需要,

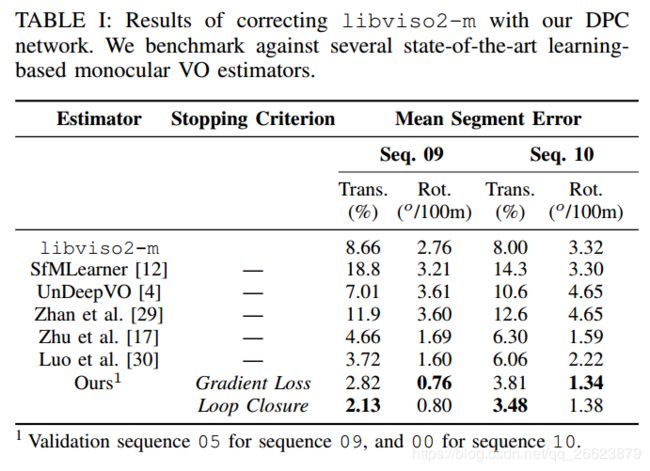

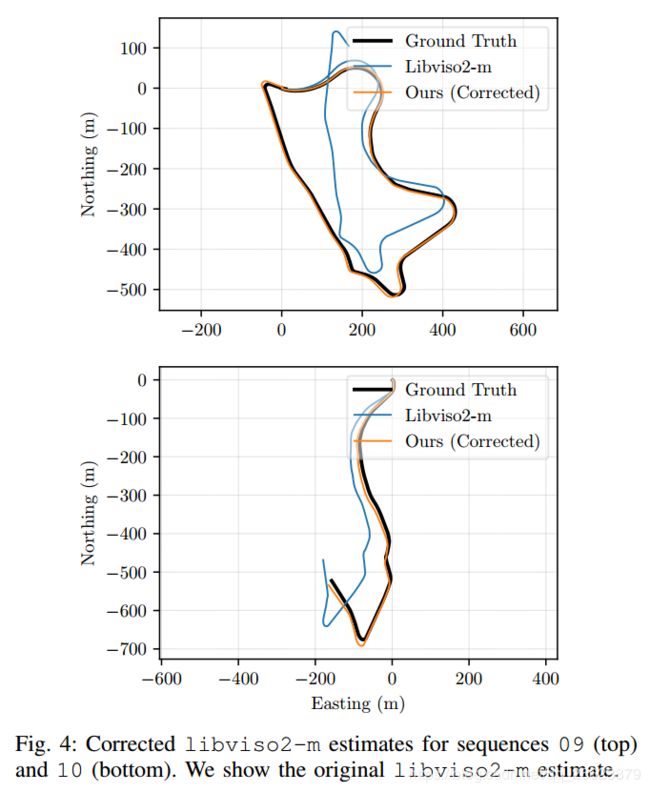

2) 在KITTI数据集上对我们的方法进行了大量的实验验证,表明我们的方法达到了最先进的精度

3) 在PyTorch[9]中发布了我们方法的开源实现。

方法

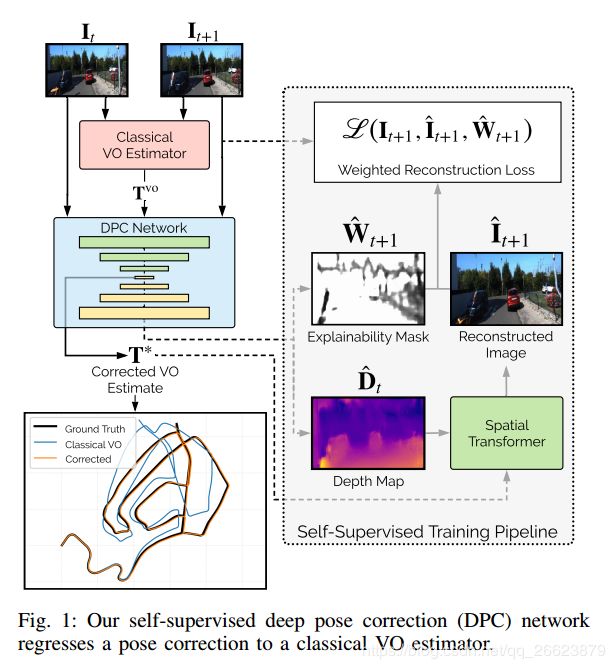

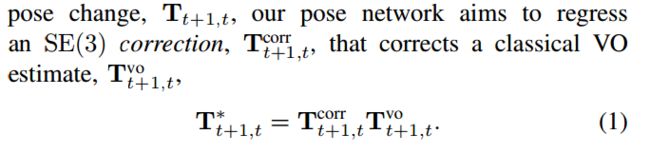

本文DPC网的监督损失替换为不需要任何外部地面真位姿信息的光度重建损失,但仍然可以产生精确的位姿校正。与其他自监督方法类似,我们的网络输出一个预测帧间姿势变化和一个深度图,然而,我们的预测帧间姿势变化是由一个经典的VO估计器的ego-motion预先“初始化”的。这一点与我们的姿势网络产生的修正复合起来。利用深度图和校正后的帧间姿态,我们将源图像扭曲成目标图像,并评估光度重建损失。自监督测光损失使用受监督的姿态损失,因此需要SE(3)标签进行训练,因此我们的自监督测光损失避免了这种类型的6-DoF地面真实性的需要,这通常是很难获得的。

本文网络可以与任何经典的VO估计器配对,然后训练产生特定于该估计器的姿势校正;对于训练数据集中的每对帧,从VO估计器获取帧间姿势变化,然后用于训练网络回归姿态校正,从而将光度重建损失最小化。

我们使用单目和立体VO估计器(分别为libviso2-m和libviso2-s)对系统进行训练,结果表明我们的方法提高了两种估计器的定位精度。我们对libviso2-m和libviso2-s应用单目校正(DPC网络仅从单个相机获取输入图像),因为我们的损耗公式没有强制任何立体图像约束;将这种可能性留作将来的工作。