单节点Hadoop搭建完整流程

一、环境介绍

1.Linux版本是CentOS 6.5

2.JDK版本1.8

3.Hadoop版本是hadoop2.6.5

二、开始搭建

1 配置网络,使环境可以上网

执行ifconfig

红色框是设备名,所以我们要更改的文件名是ifcfg-eth0,文件名的结尾一定与之对应,否则以红框里的名称为准,更改对应文件名称,接下来执行命令

vim /etc/sysconfig/network-scripts/ifcfg-eth0

可能每台机器显示会有所不同,下面只列出某些配置,其余配置可自行查阅相关文档

BOOTPROTO=static //设置成静态IP

ONBOOT=yes //系统启动时激活网卡

NAME=eth0

DEVICE=eth0 //网卡名称 必须和设备名一致

IPADDR=192.168.198.10 //IP地址 与网关前几位对应上

NETMASK=255.255.255.0 //子网掩码

GATEWAY=192.168.198.2 //网关 查看自己的网关,配置上

DNS1=192.168.43.1 //配置DNS

保存退出,执行命令重启网络

service network restart

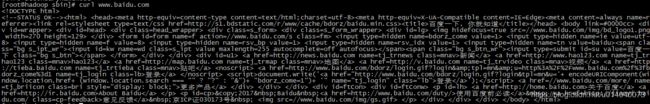

执行命令,查看是否可以上网

curl www.baidu.com

2 配置hostname 方便开发

首先编辑hosts文件

vim /etc/hosts

添加如下配置,注意名字是自己定的,这里的名字是hadoop,IP地址是上面配置的静态地址

编辑network文件 hostname改成hadoop(hadoop是上边定义的名字)

vim /etc/sysconfig/network

然后执行hostname hadoop生效,再使用hostname查看当前机器的hostname是什么

如果是hadoop,则配置成功

3 配置SSH

依次执行如下命令就可以了

$ ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

$ chmod 0600 ~/.ssh/authorized_keys

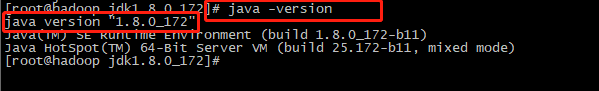

4 安装JDK

tar -zxvf jdk-8u172-linux-x64.tar.gz -C ../app/

配置JAVA_HOME

vim ~/.bashrc

编辑.bashrc文件 添加如下内容

![]()

保存并退出,并执行命令bash或source ~/.bashrc 使配置生效

查看java版本,如果如下图所示,则安装完成

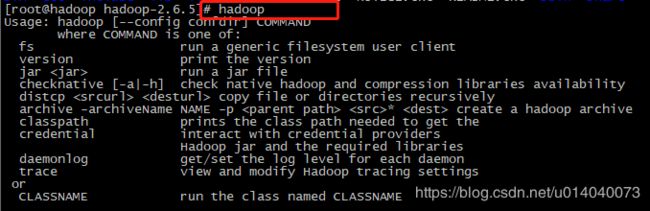

5 安装hadoop

依旧把hadoop压缩包解压到指定文件夹

tar -zxvf hadoop-2.6.5.tar.gz -C ../app/

进入hadoop根目录,编辑文件etc/hadoop/hadoop-env.sh配置JAVA_HOME

![]()

配置HADOOP_HOME 和配置JAVA_HOME的方法一样

执行命令hadoop

编辑etc/hadoop/core-site.xml文件,添加配置

fs.defaultFS

hdfs://hadoop:9000

//指定tmp目录的位置 tmp目录提前创建好

hadoop.tmp.dir

/root/app/hadoop-2.6.5/tmp

编辑etc/hadoop/hdfs-site.xml文件,添加配置

dfs.replication

1

格式化hdfs

bin/hdfs namenode -format

启动hads

$ sbin/start-dfs.sh

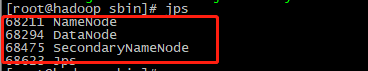

查看是否启动成功

如上图所示,出现这三个进程,则证明启动成功

接下来就是yarn的配置了

编辑文件etc/hadoop/mapred-site.xml,添加如下配置

mapreduce.framework.name

yarn

编辑文件etc/hadoop/yarn-site.xml,添加如下配置

yarn.nodemanager.aux-services

mapreduce_shuffle

启动yarn

$ sbin/start-yarn.sh

检查是否启动成功

出现这两个进程证明启动成功

至此,hadoop单节点搭建完成

三、最后

本文的hdfs和yarn 的配置都是按照官网配置的,除了那个hdfs的临时文件目录是我自己添加的,更复杂的配置需要继续查看官方的文档根据自己的需求进行配置,这里只是简单的配置,可以启动成功就可以了,希望对大家有帮助