基于Hadoop2.7.2分布式环境,安装HBase

安装HBase集群之前,请先参考以前的博文,安装好Hadoop分布式集群:Ubuntu16.04安装hadoop2.7.2分布式集群

1. 下载HBase并解压缩

① 到官网下载HBase,下载链接HBase官网下载 ,1.4.8版本是stable版本,可以选择下载该版本,本人下载的是hbase-1.4.6-bin.tar.gz 。也有镜像下载地址:HBase镜像下载

② 解压缩HBase

$ sudo tar -zxvf hbase-1.4.6-bin.tar.gz

$ sudo chmod -R 0777 hbase-1.4.6 #设置文件权限

$ sudo cp -rf hbase-1.4.6 /home/cephlee # 移动到相应的目录下

2. 配置HBase分布式环境

注意:每个步骤后面的节点提示,表示该步骤应该在哪个节点上进行操作!

① 设置系统环境变量(master节点)

使用gedit 命令在~/.bashrc文件中添加HBase的系统环境变量

$ sudo gedit ~/.bashrc

添加如下内容:

export HBASE_HOME=/home/cephlee/hbase-1.4.6

export PATH=$PATH:$HBASE_HOME/bin

使用source命令使环境变量生效,并查看系统环境变量是否配置成功:

$ source ~/.bashrc

$ hbase version

显示的HBase信息如下:

② 配置hbase-1.4.6/conf/hbase-env.sh文件(master节点)

在相应位置配置JAVA_HOME、HBASE_CLASSPATH:

# The java implementation to use. Java 1.7+ required.

export JAVA_HOME=/usr/local/jdk17

# Extra Java CLASSPATH elements. Optional.

export HBASE_CLASSPATH=${HADOOP_HOME}/etc/hadoop/

去掉# export HBASE_MANAGES_ZK=true之前的#号,表示使用HBASE自带的zookeeper管理集群。

③ 配置hbase-1.4.6/conf/hbase-site.xml文件(master节点)

在文件中添加以下内容:

hbase.cluster.distributed

true

hbase.rootdir

hdfs://adminserver:8020/hbase

hbase.zookeeper.quorum

adminserver,monserver,osdserver1,osdserver2,osdserver3

hbase.zookeeper.property.dataDir

/home/cephlee/zookeeper

④ 配置hbase-1.4.6/conf/regionservers文件(master节点)

去掉文件中的内容,将配置好的Hadoop集群中的slaves节点名添加在该文件中:

monserver

osdserver1

osdserver2

osdserver3

⑤ 按照同样的方法,添加slaves节点的系统环境变量(slaves节点)

ssh到所有的slaves节点,重复步骤① ,在~/.bashrc文件中添加HBase的系统环境变量。

⑥ 拷贝HBase文件到slaves节点(master节点)

使用scp命令,将HBase文件拷贝到slaves节点:

$ scp -r hbase-1.4.6 monserver:/home/cephlee

$ scp -r hbase-1.4.6 osdserver1:/home/cephlee

$ scp -r hbase-1.4.6 osdserver2:/home/cephlee

$ scp -r hbase-1.4.6 osdserver3:/home/cephlee

可在slaves节点上,使用hbase version命令验证系统环境变量是否配置正确!

3. 启动HBase

注意:每个步骤后面的节点提示,表示该步骤应该在哪个节点上进行操作!

① 启动Hadoop集群(master节点)

$ start-dfs.sh

$ start-yarn.sh

$ mr-jobhistory-daemon.sh start historyserver

② 启动HBase集群(master节点)

$ start-hbase.sh

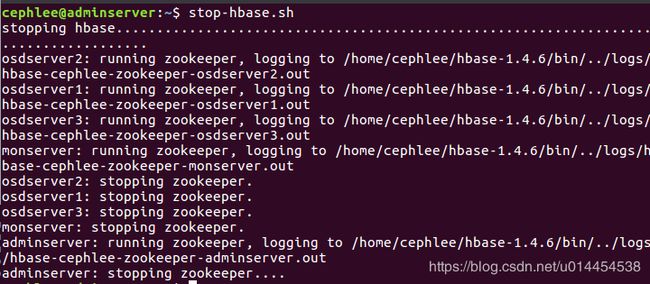

$ stop-hbase.sh

关闭信息如下:

② 使用jps命令查看hbase相关进程启动情况(所有节点)

若master节点上出现HMaster、HQuormPeer,slaves节点上出现HRegionServer、HQuorumPeer,就是启动成功!

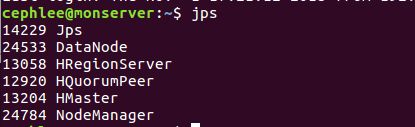

$ jps

在master节点上有以下进程,包括hadoop的进程:

在salves节点上有以下进程,包括hadoop的进程:

其中我的名为master的slaves节点被系统选做备用主节点,进程会与其他slaves节点不同,多出一个HMaster进程:

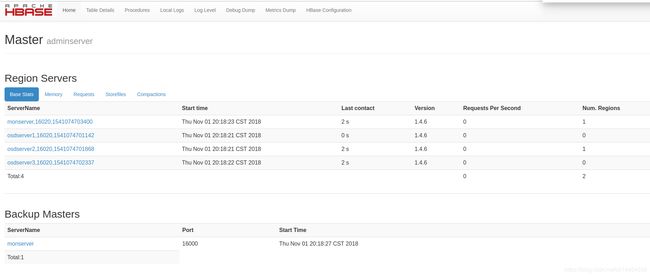

③ 通过web页面访问集群信息(所有节点)

在浏览器中输入http://192.168.202.34:16010 ,查看集群配置。其中,192.168.202.34是master节点的IP地址。

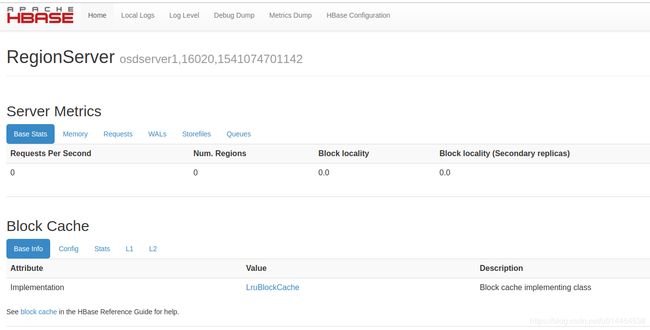

在浏览器中输入http://192.168.202.31:16030 ,查看slaves节点状态。其中,192.168.202.31是slaves节点的ip地址。

④ 通过hbase shell 命令,进入hbase命令模式(master节点)

$ hbase shell

$ status # 查看所有的节点启动信息