- HDFS 伪分布模式搭建与使用全攻略(适合初学者 & 开发测试环境)

huihui450

hdfshadoop大数据

HDFS(HadoopDistributedFileSystem)作为Hadoop生态系统的核心组件,广泛应用于海量数据的分布式存储场景。对于开发者而言,伪分布模式提供了一种低成本、高还原度的学习与测试方式。本文将详细介绍如何在本地搭建并使用HDFS的伪分布模式,包括环境准备、配置过程、常用命令及常见问题排查,帮助你快速入门Hadoop分布式文件系统的实践操作。一、什么是伪分布模式?Hadoop有

- MapReduce学习笔记

1.MapReduce做什么Mapper负责“分”,即把复杂的任务分解为若干个“简单的任务”来处理。Reducer负责对map阶段的结果进行汇总。2.MapReduce工作机制实体一:客户端,用来提交MapReduce作业。实体二:JobTracker,用来协调作业的运行。实体三:TaskTracker,用来处理作业划分后的任务。实体四:HDFS,用来在其它实体间共享作业文件。3.编写MapRed

- Hadoop核心组件最全介绍

Cachel wood

大数据开发hadoop大数据分布式spark数据库计算机网络

文章目录一、Hadoop核心组件1.HDFS(HadoopDistributedFileSystem)2.YARN(YetAnotherResourceNegotiator)3.MapReduce二、数据存储与管理1.HBase2.Hive3.HCatalog4.Phoenix三、数据处理与计算1.Spark2.Flink3.Tez4.Storm5.Presto6.Impala四、资源调度与集群管

- 数据仓库技术及应用(Hive 产生背景与架构设计,存储模型与数据类型)

娟恋无暇

数据仓库笔记hive

1.Hive产生背景传统Hadoop架构存在的一些问题:MapReduce编程必须掌握Java,门槛较高传统数据库开发、DBA、运维人员学习门槛高HDFS上没有Schema的概念,仅仅是一个纯文本文件Hive的产生:为了让用户从一个现有数据基础架构转移到Hadoop上现有数据基础架构大多基于关系型数据库和SQL查询Facebook诞生了Hive2.Hive是什么官网:https://hive.ap

- 大数据 ETL 工具 Sqoop 深度解析与实战指南

一、Sqoop核心理论与应用场景1.1设计思想与技术定位Sqoop是Apache旗下的开源数据传输工具,核心设计基于MapReduce分布式计算框架,通过并行化的Map任务实现高效的数据批量迁移。其特点包括:批处理特性:基于MapReduce作业实现导入/导出,适合大规模离线数据迁移,不支持实时数据同步。异构数据源连接:支持关系型数据库(如MySQL、Oracle)与Hadoop生态(HDFS、H

- Hadoop之HDFS

只年

大数据HadoopHDFShadoophdfs大数据

Hadoop之HDFSHDFS的Shell操作启动Hadoop集群(方便后续测试)[atguigu@hadoop102~]$sbin/start-dfs.sh[atguigu@hadoop102~]$sbin/start-yarn.sh-help:输出这个命令参数[atguigu@hadoop102~]$hadoopfs-helprm-ls:显示目录信息[atguigu@hadoop102~]$h

- HDFS中fsimage和edits究竟是什么

清平乐的技术博客

大数据运维hdfshadoop大数据

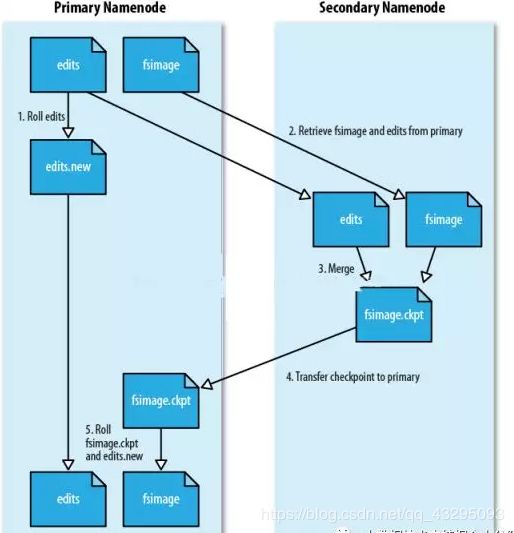

fsimage和edits是HadoopHDFS(Hadoop分布式文件系统)中的两个关键组件,用于存储文件系统的元数据,以确保文件系统的持久性和一致性。在理解它们的作用之前,我们先了解一下HDFS的基本工作原理。HDFS采用了一种分布式文件系统的架构,其中数据被划分成块并分布在不同的数据节点上,而元数据(文件和目录的信息)则由单独的组件进行管理。元数据的持久性和一致性非常重要,因为文件系统的正确

- 【Hadoop】Hadoop车辆数据存储

db_hjx_2066

javahadoop

Hadoop车辆数据存储本作业旨在实现将车辆数据按天存储到Hadoop分布式文件系统(HDFS)中,并根据数据文件大小分割成多个文件进行存储。数据格式为JSON。作业要求车辆数据按天存储,每天的数据存储在一个文件夹下。数据文件以JSON格式存储。如果数据文件大于100M,则另起一个文件存储。每天的数据总量不少于300M。实现方法1.代码说明以下是用Java编写的实现代码:1.导入类//导入必要的类

- HDFS与HBase有什么关系?

lucky_syq

hdfshbasehadoop

1、HDFS文件存储系统和HBase分布式数据库HDFS是Hadoop分布式文件系统。HBase的数据通常存储在HDFS上。HDFS为HBase提供了高可靠性的底层存储支持。Hbase是Hadoopdatabase,即Hadoop数据库。它是一个适合于非结构化数据存储的数据库,HBase基于列的而不是基于行的模式。

- Hbase和关系型数据库、HDFS、Hive的区别

别这么骄傲

hivehbase数据库

目录1.Hbase和关系型数据库的区别2.Hbase和HDFS的区别3.Hbase和Hive的区别1.Hbase和关系型数据库的区别关系型数据库Hbase存储适合结构化数据,单机存储适合结构化和半结构数据的松散数据,分布式存储功能(1)支持ACID(2)支持join(3)使用主键PK(4)数据类型:int、varchar等(1)仅支持单行事务(2)不支持join,把数据糅合到一张大表(3)行键ro

- 大数据基础知识-Hadoop、HBase、Hive一篇搞定

原来是猪猪呀

hadoop大数据分布式

HadoopHadoop是一个由Apache基金会所开发的分布式系统基础架构,其核心设计包括分布式文件系统(HDFS)和MapReduce编程模型;Hadoop是一个开源的分布式计算框架,旨在帮助用户在不了解分布式底层细节的情况下,开发分布式程序。它通过利用集群的力量,提供高速运算和存储能力,特别适合处理超大数据集的应用程序。Hadoop生态圈Hadoop生态圈是一个由多个基于Hadoop开发的相

- Hadoop、HDFS、Hive、Hbase区别及联系

静心观复

大数据hadoophdfshive

Hadoop、HDFS、Hive和HBase是大数据生态系统中的关键组件,它们都是由Apache软件基金会管理的开源项目。下面将深入解析它们之间的区别和联系。HadoopHadoop是一个开源的分布式计算框架,它允许用户在普通硬件上构建可靠、可伸缩的分布式系统。Hadoop通常指的是整个生态系统,包括HadoopCommon(共享库和工具)、HadoopDistributedFileSystem(

- 大数据(1)-hdfs&hbase

viperrrrrrr

大数据hdfshbase

hbase&hdfs一、体系结构HDFS是一个标准的主从(Master/Slave)体系结构的分布式系统;HDFS集群包含一个或多个NameNode(NameNodeHA会有多个NameNode)和多个DataNode(根据节点情况规划),用户可以通过HDFS客户端同NameNode和DataNode进行交互以访问文件系统。HDFS公开文件系统名称空间,并允许将用户数据存储在文件中。在内部,一个文

- Hadoop入门案例

'Wu'

学习日常大数据hadoophdfs大数据

Hadoop的运行流程:客户端向HDFS请求文件存储或使用MapReduce计算。NameNode负责管理整个HDFS系统中的所有数据块和元数据信息;DataNode则实际存储和管理数据块。客户端通过NameNode查找需要访问或处理的文件所在的DataNode,并将操作请求发送到相应的DataNode上。当客户端上传一个新文件时(比如输入某些日志),它会被分成固定大小(默认64MB)并进行数据复

- Hadoop、Spark、Flink 三大大数据处理框架的能力与应用场景

一、技术能力与应用场景对比产品能力特点应用场景Hadoop-基于MapReduce的批处理框架-HDFS分布式存储-容错性强、适合离线分析-作业调度使用YARN-日志离线分析-数据仓库存储-T+1报表分析-海量数据处理Spark-基于内存计算,速度快-支持批处理、流处理(StructuredStreaming)-支持SQL、ML、图计算等-支持多语言(Scala、Java、Python)-近实时处

- 使用datax进行mysql的表恢复

是桃萌萌鸭~

mysql数据库

DataXDataX是阿里巴巴集团内被广泛使用的离线数据同步工具/平台,实现包括MySQL、SQLServer、Oracle、PostgreSQL、HDFS、Hive、HBase、OTS、ODPS等各种异构数据源之间高效的数据同步功能。FeaturesDataX本身作为数据同步框架,将不同数据源的同步抽象为从源头数据源读取数据的Reader插件,以及向目标端写入数据的Writer插件,理论上Dat

- 【头歌】MapReduce基础实战 答案

Seven_Two2

头歌大数据实验答案c#开发语言

本专栏已收集大数据所有答案第1关:成绩统计编程要求使用MapReduce计算班级每个学生的最好成绩,输入文件路径为/user/test/input,请将计算后的结果输出到/user/test/output/目录下。答案:需要先在命令行启动HDFS#命令行start-dfs.sh再在代码文件中写入以下代码#代码文件importjava.io.IOException;importjava.util.S

- HDFS(Hadoop分布式文件系统)总结

Cachel wood

大数据开发hadoophdfs大数据散列表算法哈希算法spark

文章目录一、HDFS概述1.定义与定位2.核心特点二、HDFS架构核心组件1.NameNode(名称节点)2.DataNode(数据节点)3.Client(客户端)4.SecondaryNameNode(辅助名称节点)三、数据存储机制1.数据块(Block)设计2.复制策略(默认复制因子=3)3.数据完整性校验四、文件读写流程1.写入流程2.读取流程五、高可用性(HA)机制1.单点故障解决方案2.

- Hadoop的部分用法

覃炳文20230322027

hadoophive大数据分布式

前言Hadoop是一个由Apache基金会开发的开源框架,它允许跨多个机器使用分布式处理大数据集。Hadoop的核心是HDFS(HadoopDistributedFileSystem)和MapReduce编程模型。1.Hadoop环境搭建在开始使用Hadoop之前,你需要搭建Hadoop环境。这通常包括安装Java、配置Hadoop环境变量、配置Hadoop的配置文件等步骤。1.1环境准备在开始安

- Hadoop 版本进化论:从 1.0 到 2.0,架构革命全解析

拾光师

大数据后端

Hadoop版本hadoop1.x版本由三部分组成Common(辅助工具)HDFS(数据存储)MapReduce(计算和资源调度)存在的问题JobTracker同时具备了资源管理和作业控制两个功能,成为了系统的最大瓶颈采用了master/slave结构,master存在单点问题,一旦master出现故障,会导致整个集群不可用采用了基于槽位的资源分配模型,将槽位分为了Mapslot和Reducesl

- 合并小文件汇总(Hive/Spark)

有数的编程笔记

Spark/Hivehivesparkhadoop

合并小文件的原因:过多的小文件会导致HDFS上元数据负载增加。并且小文件也会导致计算性能下降。1.使用hive时1.1.使用hive.merge参数,开启文件合并--控制在map阶段结束后合并输出的小文件,默认值为trueSEThive.merge.mapfiles=true;--控制在reduce阶段结束后合并输出小文件,默认值为falseSEThive.merge.mapredfiles=tr

- 基于pyspark的北京历史天气数据分析及可视化_离线

大数据CLUB

spark数据分析可视化数据分析数据挖掘hadoop大数据spark

基于pyspark的北京历史天气数据分析及可视化项目概况[]点这里,查看所有项目[]数据类型北京历史天气数据开发环境centos7软件版本python3.8.18、hadoop3.2.0、spark3.1.2、mysql5.7.38、scala2.12.18、jdk8开发语言python开发流程数据上传(hdfs)->数据分析(spark)->数据存储(mysql)->后端(flask)->前端(

- 探秘Flink Connector加载机制:连接外部世界的幕后引擎

Edingbrugh.南空

flink大数据flink大数据

在Flink的数据处理生态中,SourceFunction负责数据的输入源头,而真正架起Flink与各类外部存储、消息系统桥梁的,则是Connector。从Kafka消息队列到HDFS文件系统,从MySQL数据库到Elasticsearch搜索引擎,Flink通过Connector实现了与多样化外部系统的交互。而这一切交互的基础,都离不开背后强大且精巧的Connector加载机制。接下来,我们将深

- 基于pyspark的北京历史天气数据分析及可视化_实时

大数据CLUB

spark数据分析可视化数据分析数据挖掘sparkhadoop大数据

基于pyspark的北京历史天气数据分析及可视化项目概况[]点这里,查看所有项目[]数据类型北京历史天气数据开发环境centos7软件版本python3.8.18、hadoop3.2.0、spark3.1.2、mysql5.7.38、scala2.12.18、jdk8、kafka2.8.2开发语言python开发流程数据上传(hdfs)->数据分析(spark)->数据写kafka(python)

- 时序数据库IoTDB的架构、安装启动方法与数据模式总结

时序数据说

时序数据库iotdb数据库大数据物联网

一、IoTDB的架构IoTDB的架构主要分为三个部分:时序文件(Tsfile):专为时序数据设计的文件存储格式。支持高效的压缩和查询性能。可独立使用,并可通过TsFileSync工具同步至HDFS进行大数据处理。数据库引擎:负责数据的收集、写入、存储和查询等核心功能。分析引擎:可选的分析组件,用于数据处理和分析。二、IoTDB的安装启动方法1.使用环境:需要具备JDK>=1.8的运

- Hadoop等大数据处理框架的Java API

扬子鳄008

Javahadoopjava大数据

Hadoop是一个非常流行的大数据处理框架,主要用于存储和处理大规模数据集。Hadoop主要有两个核心组件:HDFS(HadoopDistributedFileSystem)和MapReduce。此外,还有许多其他组件,如YARN(YetAnotherResourceNegotiator)、HBase、Hive等。下面详细介绍Hadoop及其相关组件的JavaAPI及其使用方法。HadoopHad

- 手把手教你玩转 Sqoop:从数据库到大数据的「数据搬运工」

AAA建材批发王师傅

数据库sqoop大数据hivehdfs

一、Sqoop是什么?——数据界的「超级搬运工」兄弟们,今天咱们聊个大数据圈的「搬运小能手」——Sqoop!可能有人会问:这玩意儿跟Flume啥区别?简单来说:Flume是专门搬日志数据的「快递员」而Sqoop是搬数据库数据的「搬家公司」它的名字咋来的?SQL+Hadoop,直接告诉你核心技能:在关系型数据库(比如MySQL)和Hadoop家族(HDFS、Hive、HBase)之间疯狂倒腾数据!核

- 从 0 到 Offer!大数据核心面试题全解析,答案精准拿捏面试官(hadoop篇)

浅谈星痕

大数据

1.什么是Hadoop?Hadoop是一个开源的分布式系统基础架构,用于存储和处理大规模数据集。它主要包含HDFS(HadoopDistributedFileSystem)分布式文件系统、MapReduce分布式计算框架以及YARN(YetAnotherResourceNegotiator)资源管理器。HDFS负责数据的分布式存储,将大文件分割成多个数据块存储在不同节点上;MapReduce用于分

- 大数据学习(141)-分布式数据库

viperrrrrrr

大数据学习分布式clickhousehdfshbase

在分布式数据库中主要有hdfs、hbase、clickhouse三种。HDFS(HadoopDistributedFileSystem)、HBase和ClickHouse都是处理大数据的分布式系统,但它们的设计目标、架构和适用场景有所不同。一、HDFS(HadoopDistributedFileSystem)HDFS是Hadoop生态系统的一部分,是一个高度容错的系统,适合存储大量数据。它被设计为

- HDFS Federation(联邦) 架构YARN的Capacity Scheduler调度策略 ResourceManager的共享存储具体实现方式

2401_8554978

hdfs架构java

HDFSFederation(联邦)架构什么是HDFSFederation?随着数据量的增长,单一的NameNode成为了HDFS的瓶颈,因为它需要管理整个文件系统的命名空间和所有文件块的位置信息。为了克服这个限制,Hadoop引入了Federation机制,允许一个集群中有多个NameNode/NameSpace,每个NameNode管理一部分文件系统,从而分散负载。优点:提高扩展性:通过增加N

- [星球大战]阿纳金的背叛

comsci

本来杰迪圣殿的长老是不同意让阿纳金接受训练的.........

但是由于政治原因,长老会妥协了...这给邪恶的力量带来了机会

所以......现代的地球联邦接受了这个教训...绝对不让某些年轻人进入学院

- 看懂它,你就可以任性的玩耍了!

aijuans

JavaScript

javascript作为前端开发的标配技能,如果不掌握好它的三大特点:1.原型 2.作用域 3. 闭包 ,又怎么可以说你学好了这门语言呢?如果标配的技能都没有撑握好,怎么可以任性的玩耍呢?怎么验证自己学好了以上三个基本点呢,我找到一段不错的代码,稍加改动,如果能够读懂它,那么你就可以任性了。

function jClass(b

- Java常用工具包 Jodd

Kai_Ge

javajodd

Jodd 是一个开源的 Java 工具集, 包含一些实用的工具类和小型框架。简单,却很强大! 写道 Jodd = Tools + IoC + MVC + DB + AOP + TX + JSON + HTML < 1.5 Mb

Jodd 被分成众多模块,按需选择,其中

工具类模块有:

jodd-core &nb

- SpringMvc下载

120153216

springMVC

@RequestMapping(value = WebUrlConstant.DOWNLOAD)

public void download(HttpServletRequest request,HttpServletResponse response,String fileName) {

OutputStream os = null;

InputStream is = null;

- Python 标准异常总结

2002wmj

python

Python标准异常总结

AssertionError 断言语句(assert)失败 AttributeError 尝试访问未知的对象属性 EOFError 用户输入文件末尾标志EOF(Ctrl+d) FloatingPointError 浮点计算错误 GeneratorExit generator.close()方法被调用的时候 ImportError 导入模块失

- SQL函数返回临时表结构的数据用于查询

357029540

SQL Server

这两天在做一个查询的SQL,这个SQL的一个条件是通过游标实现另外两张表查询出一个多条数据,这些数据都是INT类型,然后用IN条件进行查询,并且查询这两张表需要通过外部传入参数才能查询出所需数据,于是想到了用SQL函数返回值,并且也这样做了,由于是返回多条数据,所以把查询出来的INT类型值都拼接为了字符串,这时就遇到问题了,在查询SQL中因为条件是INT值,SQL函数的CAST和CONVERST都

- java 时间格式化 | 比较大小| 时区 个人笔记

7454103

javaeclipsetomcatcMyEclipse

个人总结! 不当之处多多包含!

引用 1.0 如何设置 tomcat 的时区:

位置:(catalina.bat---JAVA_OPTS 下面加上)

set JAVA_OPT

- 时间获取Clander的用法

adminjun

Clander时间

/**

* 得到几天前的时间

* @param d

* @param day

* @return

*/

public static Date getDateBefore(Date d,int day){

Calend

- JVM初探与设置

aijuans

java

JVM是Java Virtual Machine(Java虚拟机)的缩写,JVM是一种用于计算设备的规范,它是一个虚构出来的计算机,是通过在实际的计算机上仿真模拟各种计算机功能来实现的。Java虚拟机包括一套字节码指令集、一组寄存器、一个栈、一个垃圾回收堆和一个存储方法域。 JVM屏蔽了与具体操作系统平台相关的信息,使Java程序只需生成在Java虚拟机上运行的目标代码(字节码),就可以在多种平台

- SQL中ON和WHERE的区别

avords

SQL中ON和WHERE的区别

数据库在通过连接两张或多张表来返回记录时,都会生成一张中间的临时表,然后再将这张临时表返回给用户。 www.2cto.com 在使用left jion时,on和where条件的区别如下: 1、 on条件是在生成临时表时使用的条件,它不管on中的条件是否为真,都会返回左边表中的记录。

- 说说自信

houxinyou

工作生活

自信的来源分为两种,一种是源于实力,一种源于头脑.实力是一个综合的评定,有自身的能力,能利用的资源等.比如我想去月亮上,要身体素质过硬,还要有飞船等等一系列的东西.这些都属于实力的一部分.而头脑不同,只要你头脑够简单就可以了!同样要上月亮上,你想,我一跳,1米,我多跳几下,跳个几年,应该就到了!什么?你说我会往下掉?你笨呀你!找个东西踩一下不就行了吗?

无论工作还

- WEBLOGIC事务超时设置

bijian1013

weblogicjta事务超时

系统中统计数据,由于调用统计过程,执行时间超过了weblogic设置的时间,提示如下错误:

统计数据出错!

原因:The transaction is no longer active - status: 'Rolling Back. [Reason=weblogic.transaction.internal

- 两年已过去,再看该如何快速融入新团队

bingyingao

java互联网融入架构新团队

偶得的空闲,翻到了两年前的帖子

该如何快速融入一个新团队,有所感触,就记下来,为下一个两年后的今天做参考。

时隔两年半之后的今天,再来看当初的这个博客,别有一番滋味。而我已经于今年三月份离开了当初所在的团队,加入另外的一个项目组,2011年的这篇博客之后的时光,我很好的融入了那个团队,而直到现在和同事们关系都特别好。大家在短短一年半的时间离一起经历了一

- 【Spark七十七】Spark分析Nginx和Apache的access.log

bit1129

apache

Spark分析Nginx和Apache的access.log,第一个问题是要对Nginx和Apache的access.log文件进行按行解析,按行解析就的方法是正则表达式:

Nginx的access.log解析正则表达式

val PATTERN = """([^ ]*) ([^ ]*) ([^ ]*) (\\[.*\\]) (\&q

- Erlang patch

bookjovi

erlang

Totally five patchs committed to erlang otp, just small patchs.

IMO, erlang really is a interesting programming language, I really like its concurrency feature.

but the functional programming style

- log4j日志路径中加入日期

bro_feng

javalog4j

要用log4j使用记录日志,日志路径有每日的日期,文件大小5M新增文件。

实现方式

log4j:

<appender name="serviceLog"

class="org.apache.log4j.RollingFileAppender">

<param name="Encoding" v

- 读《研磨设计模式》-代码笔记-桥接模式

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

/**

* 个人觉得关于桥接模式的例子,蜡笔和毛笔这个例子是最贴切的:http://www.cnblogs.com/zhenyulu/articles/67016.html

* 笔和颜色是可分离的,蜡笔把两者耦合在一起了:一支蜡笔只有一种

- windows7下SVN和Eclipse插件安装

chenyu19891124

eclipse插件

今天花了一天时间弄SVN和Eclipse插件的安装,今天弄好了。svn插件和Eclipse整合有两种方式,一种是直接下载插件包,二种是通过Eclipse在线更新。由于之前Eclipse版本和svn插件版本有差别,始终是没装上。最后在网上找到了适合的版本。所用的环境系统:windows7JDK:1.7svn插件包版本:1.8.16Eclipse:3.7.2工具下载地址:Eclipse下在地址:htt

- [转帖]工作流引擎设计思路

comsci

设计模式工作应用服务器workflow企业应用

作为国内的同行,我非常希望在流程设计方面和大家交流,刚发现篇好文(那么好的文章,现在才发现,可惜),关于流程设计的一些原理,个人觉得本文站得高,看得远,比俺的文章有深度,转载如下

=================================================================================

自开博以来不断有朋友来探讨工作流引擎该如何

- Linux 查看内存,CPU及硬盘大小的方法

daizj

linuxcpu内存硬盘大小

一、查看CPU信息的命令

[root@R4 ~]# cat /proc/cpuinfo |grep "model name" && cat /proc/cpuinfo |grep "physical id"

model name : Intel(R) Xeon(R) CPU X5450 @ 3.00GHz

model name :

- linux 踢出在线用户

dongwei_6688

linux

两个步骤:

1.用w命令找到要踢出的用户,比如下面:

[root@localhost ~]# w

18:16:55 up 39 days, 8:27, 3 users, load average: 0.03, 0.03, 0.00

USER TTY FROM LOGIN@ IDLE JCPU PCPU WHAT

- 放手吧,就像不曾拥有过一样

dcj3sjt126com

内容提要:

静悠悠编著的《放手吧就像不曾拥有过一样》集结“全球华语世界最舒缓心灵”的精华故事,触碰生命最深层次的感动,献给全世界亿万读者。《放手吧就像不曾拥有过一样》的作者衷心地祝愿每一位读者都给自己一个重新出发的理由,将那些令你痛苦的、扛起的、背负的,一并都放下吧!把憔悴的面容换做一种清淡的微笑,把沉重的步伐调节成春天五线谱上的音符,让自己踏着轻快的节奏,在人生的海面上悠然漂荡,享受宁静与

- php二进制安全的含义

dcj3sjt126com

PHP

PHP里,有string的概念。

string里,每个字符的大小为byte(与PHP相比,Java的每个字符为Character,是UTF8字符,C语言的每个字符可以在编译时选择)。

byte里,有ASCII代码的字符,例如ABC,123,abc,也有一些特殊字符,例如回车,退格之类的。

特殊字符很多是不能显示的。或者说,他们的显示方式没有标准,例如编码65到哪儿都是字母A,编码97到哪儿都是字符

- Linux下禁用T440s,X240的一体化触摸板(touchpad)

gashero

linuxThinkPad触摸板

自打1月买了Thinkpad T440s就一直很火大,其中最让人恼火的莫过于触摸板。

Thinkpad的经典就包括用了小红点(TrackPoint)。但是小红点只能定位,还是需要鼠标的左右键的。但是自打T440s等开始启用了一体化触摸板,不再有实体的按键了。问题是要是好用也行。

实际使用中,触摸板一堆问题,比如定位有抖动,以及按键时会有飘逸。这就导致了单击经常就

- graph_dfs

hcx2013

Graph

package edu.xidian.graph;

class MyStack {

private final int SIZE = 20;

private int[] st;

private int top;

public MyStack() {

st = new int[SIZE];

top = -1;

}

public void push(i

- Spring4.1新特性——Spring核心部分及其他

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- 配置HiveServer2的安全策略之自定义用户名密码验证

liyonghui160com

具体从网上看

http://doc.mapr.com/display/MapR/Using+HiveServer2#UsingHiveServer2-ConfiguringCustomAuthentication

LDAP Authentication using OpenLDAP

Setting

- 一位30多的程序员生涯经验总结

pda158

编程工作生活咨询

1.客户在接触到产品之后,才会真正明白自己的需求。

这是我在我的第一份工作上面学来的。只有当我们给客户展示产品的时候,他们才会意识到哪些是必须的。给出一个功能性原型设计远远比一张长长的文字表格要好。 2.只要有充足的时间,所有安全防御系统都将失败。

安全防御现如今是全世界都在关注的大课题、大挑战。我们必须时时刻刻积极完善它,因为黑客只要有一次成功,就可以彻底打败你。 3.

- 分布式web服务架构的演变

自由的奴隶

linuxWeb应用服务器互联网

最开始,由于某些想法,于是在互联网上搭建了一个网站,这个时候甚至有可能主机都是租借的,但由于这篇文章我们只关注架构的演变历程,因此就假设这个时候已经是托管了一台主机,并且有一定的带宽了,这个时候由于网站具备了一定的特色,吸引了部分人访问,逐渐你发现系统的压力越来越高,响应速度越来越慢,而这个时候比较明显的是数据库和应用互相影响,应用出问题了,数据库也很容易出现问题,而数据库出问题的时候,应用也容易

- 初探Druid连接池之二——慢SQL日志记录

xingsan_zhang

日志连接池druid慢SQL

由于工作原因,这里先不说连接数据库部分的配置,后面会补上,直接进入慢SQL日志记录。

1.applicationContext.xml中增加如下配置:

<bean abstract="true" id="mysql_database" class="com.alibaba.druid.pool.DruidDataSourc